วันนี้เรารู้สึกตื่นเต้นที่จะประกาศว่าโมเดลรากฐาน Code Llama ที่พัฒนาโดย Meta พร้อมให้ใช้งานสำหรับลูกค้าผ่านทาง Amazon SageMaker JumpStart เพื่อปรับใช้ด้วยการคลิกเพียงครั้งเดียวสำหรับการอนุมาน Code Llama เป็นโมเดลภาษาขนาดใหญ่ (LLM) ที่ล้ำสมัยที่สามารถสร้างโค้ดและภาษาธรรมชาติเกี่ยวกับโค้ดจากทั้งโค้ดและภาษาธรรมชาติ คุณสามารถลองใช้โมเดลนี้กับ SageMaker JumpStart ซึ่งเป็นฮับแมชชีนเลิร์นนิง (ML) ที่ให้การเข้าถึงอัลกอริทึม โมเดล และโซลูชัน ML เพื่อให้คุณสามารถเริ่มต้นใช้งาน ML ได้อย่างรวดเร็ว ในโพสต์นี้ เราจะอธิบายวิธีการค้นหาและปรับใช้โมเดล Code Llama ผ่าน SageMaker JumpStart

โค๊ดลามะ

Code Llama เป็นโมเดลที่ออกโดย Meta ที่สร้างขึ้นบน Llama 2 โมเดลล้ำสมัยนี้ได้รับการออกแบบมาเพื่อปรับปรุงประสิทธิภาพการทำงานสำหรับงานการเขียนโปรแกรมสำหรับนักพัฒนา โดยช่วยให้พวกเขาสร้างโค้ดคุณภาพสูงและมีเอกสารประกอบอย่างดี โมเดลเหล่านี้เก่งใน Python, C++, Java, PHP, C#, TypeScript และ Bash และมีศักยภาพในการประหยัดเวลาของนักพัฒนาและทำให้เวิร์กโฟลว์ซอฟต์แวร์มีประสิทธิภาพมากขึ้น

มีสามรูปแบบที่ออกแบบมาเพื่อให้ครอบคลุมการใช้งานที่หลากหลาย: โมเดลพื้นฐาน (Code Llama), โมเดลเฉพาะทาง Python (Code Llama Python) และโมเดลตามคำสั่งสำหรับการทำความเข้าใจคำสั่งภาษาธรรมชาติ (Code Llama Instruct) Code Llama ทุกรูปแบบมีสี่ขนาด: พารามิเตอร์ 7B, 13B, 34B และ 70B ตัวแปรฐานและคำสั่ง 7B และ 13B รองรับการเติมตามเนื้อหาโดยรอบ ทำให้เหมาะสำหรับการใช้งานผู้ช่วยโค้ด แบบจำลองได้รับการออกแบบโดยใช้ Llama 2 เป็นฐาน จากนั้นฝึกอบรมเกี่ยวกับข้อมูลโค้ดโทเค็นจำนวน 500 พันล้านโทเค็น โดยเวอร์ชันพิเศษของ Python จะได้รับการฝึกอบรมเกี่ยวกับโทเค็นส่วนเพิ่ม 100 พันล้านโทเค็น โมเดล Code Llama มอบการสร้างที่เสถียรด้วยโทเค็นบริบทมากถึง 100,000 โทเค็น ทุกรุ่นได้รับการฝึกอบรมเกี่ยวกับลำดับโทเค็น 16,000 รายการ และแสดงการปรับปรุงอินพุตที่มีโทเค็นสูงสุด 100,000 รายการ

ซึ่งรุ่นนี้ก็ได้จัดทำขึ้นภายใต้ชื่อเดียวกัน ใบอนุญาตชุมชนเป็น Llama 2

โมเดลพื้นฐานใน SageMaker

SageMaker JumpStart ให้การเข้าถึงโมเดลต่างๆ จากฮับโมเดลยอดนิยม รวมถึง Hugging Face, PyTorch Hub และ TensorFlow Hub ซึ่งคุณสามารถใช้ภายในเวิร์กโฟลว์การพัฒนา ML ของคุณใน SageMaker ความก้าวหน้าล่าสุดใน ML ได้ก่อให้เกิดคลาสของโมเดลใหม่ที่เรียกว่า โมเดลรองพื้นซึ่งโดยทั่วไปแล้วจะได้รับการฝึกอบรมเกี่ยวกับพารามิเตอร์นับพันล้านรายการ และสามารถปรับให้เข้ากับกรณีการใช้งานประเภทต่างๆ มากมาย เช่น การสรุปข้อความ การสร้างงานศิลปะดิจิทัล และการแปลภาษา เนื่องจากโมเดลเหล่านี้มีราคาแพงในการฝึก ลูกค้าจึงต้องการใช้โมเดลพื้นฐานที่ได้รับการฝึกล่วงหน้าที่มีอยู่แล้ว และปรับแต่งตามความจำเป็น แทนที่จะฝึกโมเดลเหล่านี้ด้วยตนเอง SageMaker มีรายการโมเดลที่คัดสรรมาอย่างดีซึ่งคุณสามารถเลือกได้บนคอนโซล SageMaker

คุณสามารถค้นหาโมเดลพื้นฐานจากผู้ให้บริการโมเดลต่างๆ ภายใน SageMaker JumpStart ซึ่งช่วยให้คุณเริ่มต้นใช้งานโมเดลพื้นฐานได้อย่างรวดเร็ว คุณสามารถค้นหาโมเดลพื้นฐานตามงานหรือผู้ให้บริการโมเดลต่างๆ และตรวจสอบคุณลักษณะของโมเดลและเงื่อนไขการใช้งานได้อย่างง่ายดาย คุณยังสามารถลองใช้โมเดลเหล่านี้ได้โดยใช้วิดเจ็ต UI ทดสอบ เมื่อคุณต้องการใช้โมเดลพื้นฐานในวงกว้าง คุณสามารถทำได้โดยไม่ต้องออกจาก SageMaker โดยใช้สมุดบันทึกที่สร้างไว้ล่วงหน้าจากผู้ให้บริการโมเดล เนื่องจากโมเดลดังกล่าวโฮสต์และปรับใช้บน AWS คุณจึงมั่นใจได้ว่าข้อมูลของคุณ ไม่ว่าจะใช้สำหรับการประเมินหรือใช้โมเดลในวงกว้าง จะไม่ถูกแชร์กับบุคคลที่สาม

ค้นพบโมเดล Code Llama ใน SageMaker JumpStart

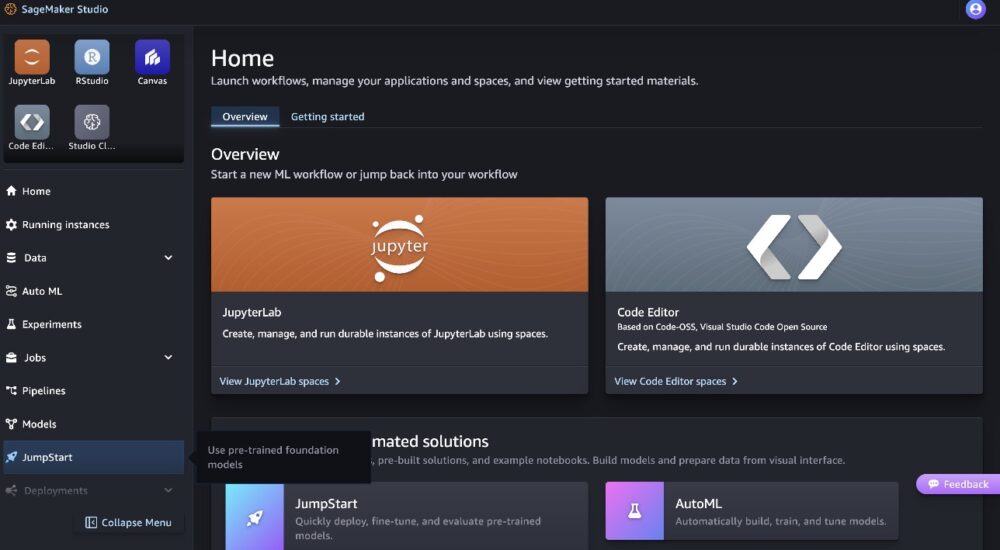

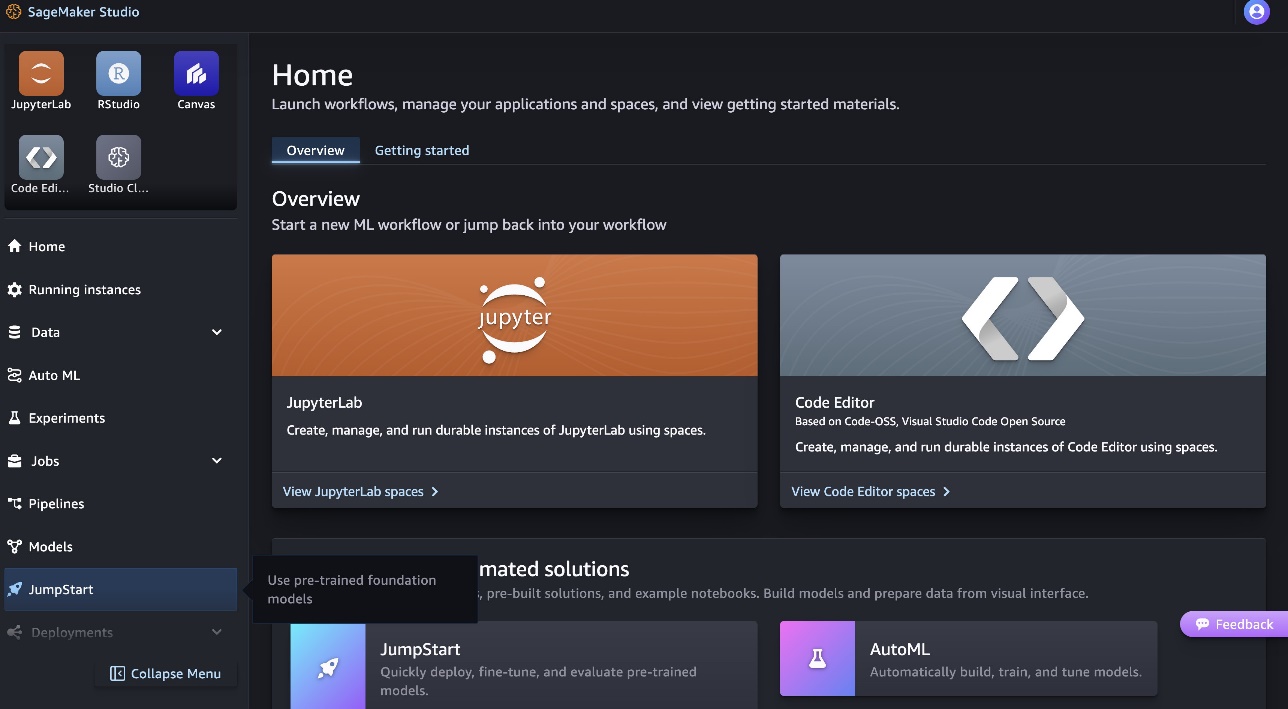

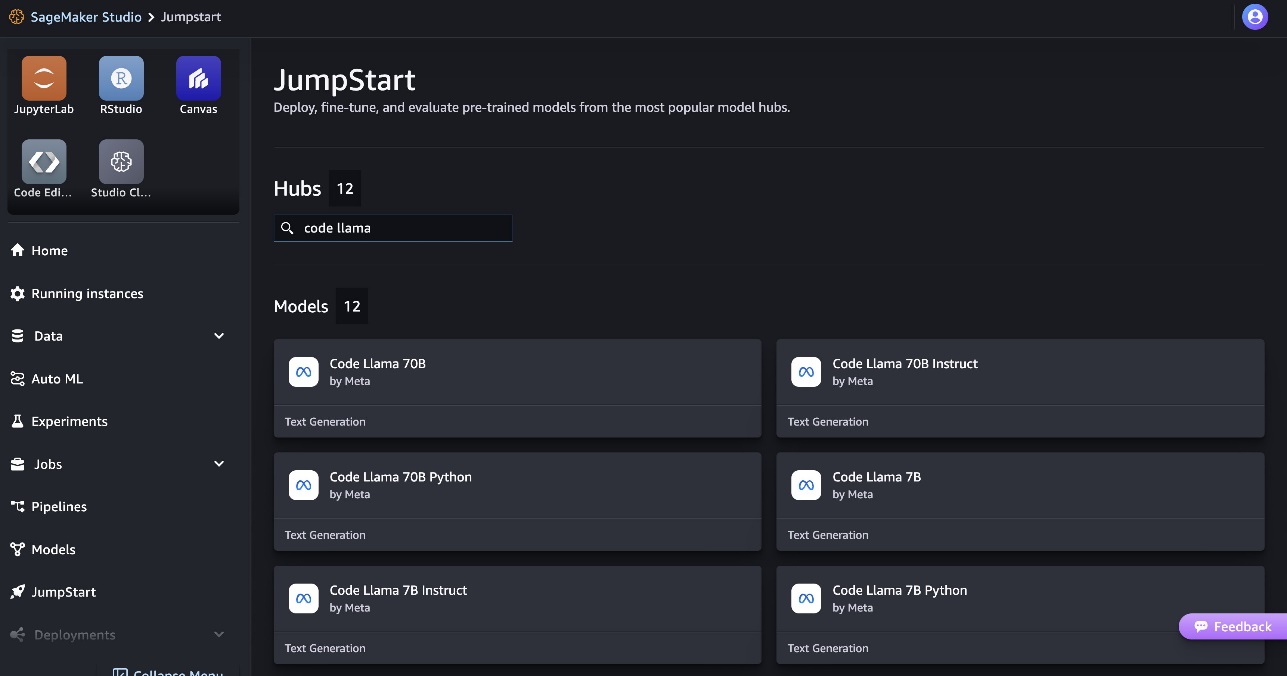

หากต้องการปรับใช้โมเดล Code Llama 70B ให้ทำตามขั้นตอนต่อไปนี้ใน สตูดิโอ Amazon SageMaker:

- บนหน้าแรกของ SageMaker Studio ให้เลือก เริ่มกระโดด ในบานหน้าต่างนำทาง

- ค้นหารุ่น Code Llama และเลือกรุ่น Code Llama 70B จากรายการรุ่นที่แสดง

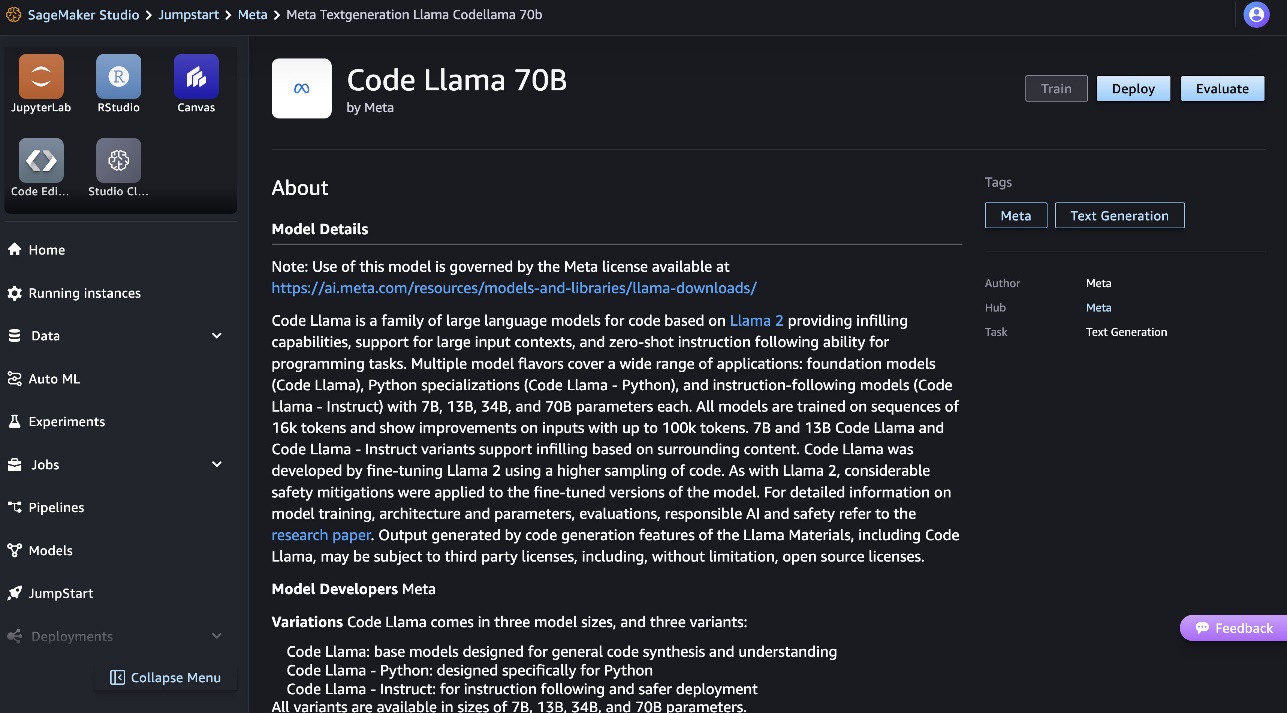

คุณสามารถดูข้อมูลเพิ่มเติมเกี่ยวกับโมเดลนี้ได้บนการ์ดโมเดล Code Llama 70B

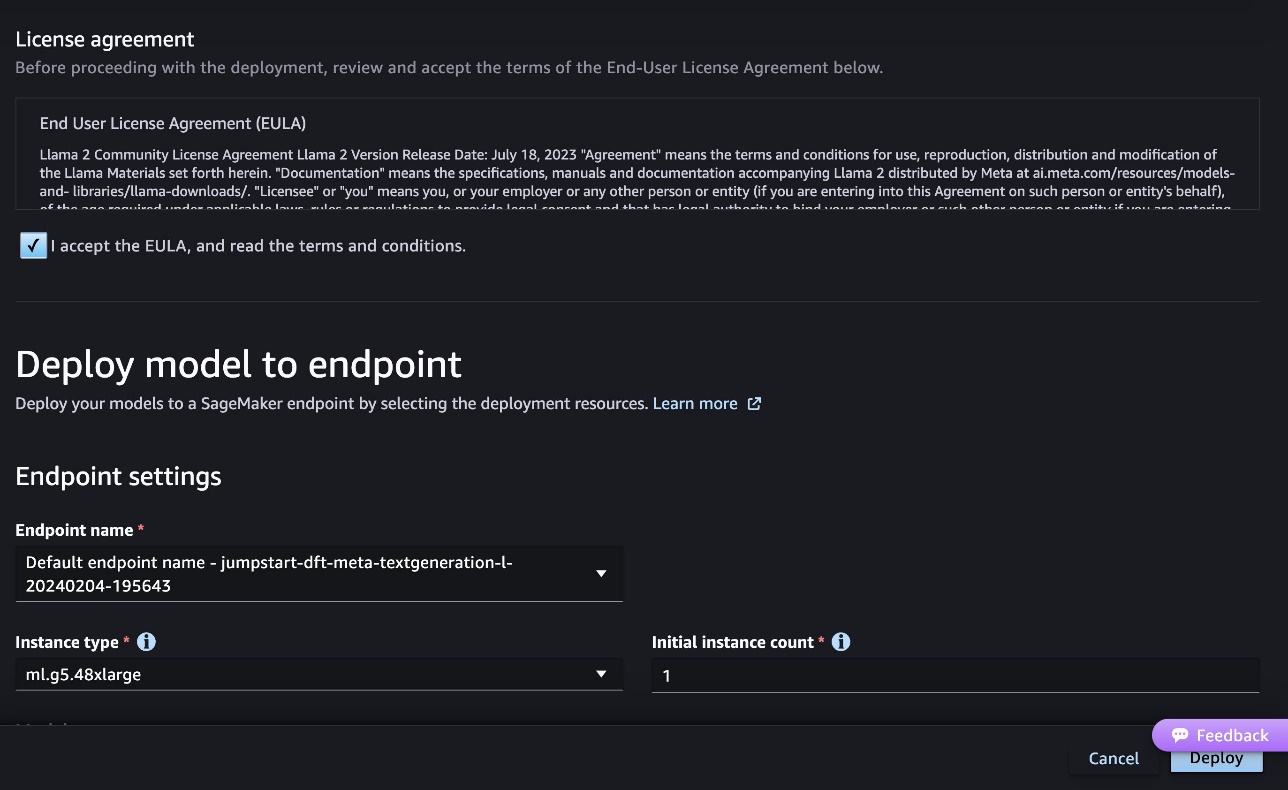

ภาพหน้าจอต่อไปนี้แสดงการตั้งค่าตำแหน่งข้อมูล คุณสามารถเปลี่ยนตัวเลือกหรือใช้ตัวเลือกเริ่มต้นได้

- ยอมรับข้อตกลงสิทธิ์การใช้งานสำหรับผู้ใช้ปลายทาง (EULA) และเลือก ปรับใช้.

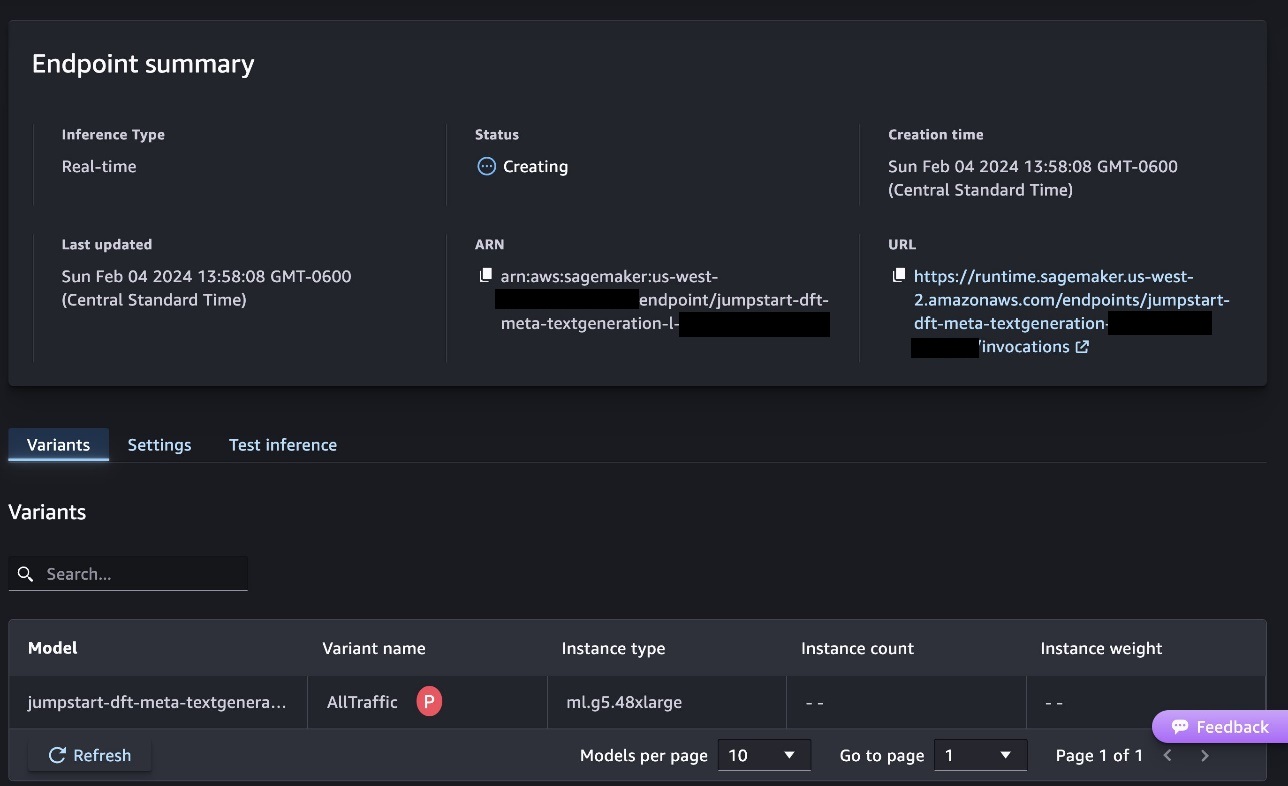

นี่จะเป็นการเริ่มกระบวนการปรับใช้ตำแหน่งข้อมูล ดังที่แสดงในภาพหน้าจอต่อไปนี้

ปรับใช้โมเดลด้วย SageMaker Python SDK

หรือคุณสามารถปรับใช้ผ่านสมุดบันทึกตัวอย่างโดยเลือก เปิดสมุดบันทึก ในหน้ารายละเอียดโมเดลของ Classic Studio สมุดบันทึกตัวอย่างให้คำแนะนำตั้งแต่ต้นจนจบเกี่ยวกับวิธีการปรับใช้แบบจำลองสำหรับการอนุมานและล้างข้อมูลทรัพยากร

หากต้องการปรับใช้โดยใช้โน้ตบุ๊ก เราเริ่มต้นด้วยการเลือกรุ่นที่เหมาะสมซึ่งระบุโดย model_id. คุณสามารถปรับใช้โมเดลที่เลือกใดๆ บน SageMaker ด้วยรหัสต่อไปนี้:

ซึ่งปรับใช้โมเดลบน SageMaker ด้วยการกำหนดค่าเริ่มต้น รวมถึงประเภทอินสแตนซ์เริ่มต้นและการกำหนดค่า VPC เริ่มต้น คุณสามารถเปลี่ยนการกำหนดค่าเหล่านี้ได้โดยการระบุค่าที่ไม่ใช่ค่าเริ่มต้นใน JumpStartโมเดล. โปรดทราบว่าโดยค่าเริ่มต้น accept_eula ถูกตั้งค่าเป็น False. คุณต้องตั้งค่า accept_eula=True เพื่อปรับใช้ปลายทางได้สำเร็จ การทำเช่นนี้แสดงว่าคุณยอมรับข้อตกลงสิทธิ์การใช้งานของผู้ใช้และนโยบายการใช้งานที่ยอมรับได้ดังที่กล่าวไว้ข้างต้น นอกจากนี้คุณยังสามารถ ดาวน์โหลด ข้อตกลงใบอนุญาต

เรียกใช้ตำแหน่งข้อมูล SageMaker

หลังจากปรับใช้ตำแหน่งข้อมูลแล้ว คุณสามารถดำเนินการอนุมานได้โดยใช้ Boto3 หรือ SageMaker Python SDK ในโค้ดต่อไปนี้ เราใช้ SageMaker Python SDK เพื่อเรียกโมเดลสำหรับการอนุมานและพิมพ์การตอบกลับ:

ฟังก์ชั่น print_response รับเพย์โหลดที่ประกอบด้วยเพย์โหลดและการตอบสนองของโมเดล แล้วพิมพ์เอาต์พุต Code Llama รองรับพารามิเตอร์มากมายในขณะที่ทำการอนุมาน:

- สูงสุด_ความยาว – โมเดลสร้างข้อความจนกระทั่งถึงความยาวของเอาต์พุต (ซึ่งรวมถึงความยาวบริบทอินพุต)

max_length. หากระบุ จะต้องเป็นจำนวนเต็มบวก - max_new_tokens – โมเดลจะสร้างข้อความจนกระทั่งถึงความยาวเอาต์พุต (ไม่รวมความยาวบริบทอินพุต)

max_new_tokens. หากระบุ จะต้องเป็นจำนวนเต็มบวก - num_beams – ระบุจำนวนคานที่ใช้ในการค้นหาโลภ หากระบุไว้ จะต้องเป็นจำนวนเต็มที่มากกว่าหรือเท่ากับ

num_return_sequences. - no_repeat_ngram_size – ตัวแบบช่วยให้แน่ใจว่าลำดับของคำของ

no_repeat_ngram_sizeไม่ซ้ำในลำดับเอาต์พุต หากระบุ จะต้องเป็นจำนวนเต็มบวกที่มากกว่า 1 - อุณหภูมิ – สิ่งนี้จะควบคุมการสุ่มในเอาต์พุต สูงกว่า

temperatureผลลัพธ์ที่ได้คือลำดับเอาต์พุตที่มีคำที่มีโอกาสต่ำและต่ำกว่าtemperatureผลลัพธ์ที่ได้คือลำดับเอาต์พุตที่มีคำที่น่าจะเป็นไปได้สูง ถ้าtemperatureเป็น 0 ส่งผลให้มีการถอดรหัสอย่างละโมบ หากระบุไว้จะต้องเป็นค่าทศนิยมที่เป็นบวก - ต้น_หยุด - ถ้า

Trueการสร้างข้อความจะเสร็จสิ้นเมื่อสมมติฐานบีมทั้งหมดถึงจุดสิ้นสุดของโทเค็นประโยค หากระบุไว้ จะต้องเป็นบูลีน - ทำ_ตัวอย่าง - ถ้า

Trueโมเดลจะสุ่มตัวอย่างคำถัดไปตามความน่าจะเป็น หากระบุไว้ จะต้องเป็นบูลีน - ท็อป_เค – ในแต่ละขั้นตอนของการสร้างข้อความ โมเดลจะสุ่มตัวอย่างจากเฉพาะ

top_kคำที่เป็นไปได้มากที่สุด หากระบุ จะต้องเป็นจำนวนเต็มบวก - ท็อป_พี – ในแต่ละขั้นตอนของการสร้างข้อความ โมเดลจะสุ่มตัวอย่างจากชุดคำที่เล็กที่สุดเท่าที่จะเป็นไปได้ด้วยความน่าจะเป็นสะสม

top_p. หากระบุไว้ จะต้องเป็นแบบทศนิยมระหว่าง 0 ถึง 1 - return_full_text - ถ้า

Trueข้อความที่ป้อนจะเป็นส่วนหนึ่งของข้อความที่สร้างเอาต์พุต หากระบุไว้ จะต้องเป็นบูลีน ค่าเริ่มต้นสำหรับมันคือFalse. - หยุด – หากระบุจะต้องเป็นรายการสตริง การสร้างข้อความจะหยุดลงหากมีการสร้างสตริงที่ระบุอย่างใดอย่างหนึ่ง

คุณสามารถระบุชุดย่อยของพารามิเตอร์เหล่านี้ได้ในขณะที่เรียกใช้ตำแหน่งข้อมูล ต่อไป เราจะแสดงตัวอย่างวิธีเรียกใช้จุดสิ้นสุดด้วยอาร์กิวเมนต์เหล่านี้

การเติมโค้ดให้สมบูรณ์

ตัวอย่างต่อไปนี้สาธิตวิธีการเติมโค้ดให้สมบูรณ์โดยที่การตอบสนองปลายทางที่คาดหวังคือความต่อเนื่องตามธรรมชาติของพร้อมท์

ก่อนอื่นเราจะรันโค้ดต่อไปนี้:

เราได้รับผลลัพธ์ต่อไปนี้:

สำหรับตัวอย่างถัดไป เราใช้โค้ดต่อไปนี้:

เราได้รับผลลัพธ์ต่อไปนี้:

การสร้างรหัส

ตัวอย่างต่อไปนี้แสดงการสร้างโค้ด Python โดยใช้ Code Llama

ก่อนอื่นเราจะรันโค้ดต่อไปนี้:

เราได้รับผลลัพธ์ต่อไปนี้:

สำหรับตัวอย่างถัดไป เราใช้โค้ดต่อไปนี้:

เราได้รับผลลัพธ์ต่อไปนี้:

นี่คือตัวอย่างบางส่วนของงานที่เกี่ยวข้องกับโค้ดโดยใช้ Code Llama 70B คุณสามารถใช้โมเดลเพื่อสร้างโค้ดที่ซับซ้อนยิ่งขึ้นได้ เราขอแนะนำให้คุณลองใช้กรณีการใช้งานและตัวอย่างที่เกี่ยวข้องกับโค้ดของคุณเอง!

ทำความสะอาด

หลังจากที่คุณทดสอบตำแหน่งข้อมูลแล้ว ตรวจสอบให้แน่ใจว่าคุณได้ลบตำแหน่งข้อมูลปลายทางการอนุมานของ SageMaker และโมเดลแล้ว เพื่อหลีกเลี่ยงไม่ให้มีค่าใช้จ่ายเกิดขึ้น ใช้รหัสต่อไปนี้:

สรุป

ในโพสต์นี้ เราได้แนะนำ Code Llama 70B บน SageMaker JumpStart Code Llama 70B เป็นโมเดลที่ล้ำสมัยสำหรับการสร้างโค้ดจากคำสั่งภาษาธรรมชาติและโค้ด คุณสามารถปรับใช้โมเดลด้วยขั้นตอนง่ายๆ เพียงไม่กี่ขั้นตอนใน SageMaker JumpStart จากนั้นใช้เพื่อดำเนินงานที่เกี่ยวข้องกับโค้ด เช่น การสร้างโค้ดและการเติมโค้ด ในขั้นตอนถัดไป ให้ลองใช้โมเดลกับกรณีการใช้งานและข้อมูลที่เกี่ยวข้องกับโค้ดของคุณเอง

เกี่ยวกับผู้แต่ง

ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart งานวิจัยที่เขาสนใจ ได้แก่ อัลกอริธึมแมชชีนเลิร์นนิงที่ปรับขนาดได้ คอมพิวเตอร์วิทัศน์ อนุกรมเวลา เบส์ที่ไม่ใช่พารามิเตอร์ และกระบวนการเกาส์เซียน ปริญญาเอกของเขามาจาก Duke University และเขาได้ตีพิมพ์บทความใน NeurIPS, Cell และ Neuron

ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart งานวิจัยที่เขาสนใจ ได้แก่ อัลกอริธึมแมชชีนเลิร์นนิงที่ปรับขนาดได้ คอมพิวเตอร์วิทัศน์ อนุกรมเวลา เบส์ที่ไม่ใช่พารามิเตอร์ และกระบวนการเกาส์เซียน ปริญญาเอกของเขามาจาก Duke University และเขาได้ตีพิมพ์บทความใน NeurIPS, Cell และ Neuron

ดร.ฟารุค ซาบีร์ เป็นสถาปนิกอาวุโสด้านปัญญาประดิษฐ์และผู้เชี่ยวชาญด้านการเรียนรู้ของเครื่องที่ AWS เขาสำเร็จการศึกษาระดับปริญญาเอกและปริญญาโทสาขาวิศวกรรมไฟฟ้าจากมหาวิทยาลัยเทกซัสออสติน และปริญญาโทสาขาวิทยาการคอมพิวเตอร์จากสถาบันเทคโนโลยีจอร์เจีย เขามีประสบการณ์การทำงานมากกว่า 15 ปี และยังชอบสอนและให้คำปรึกษาแก่นักศึกษาอีกด้วย ที่ AWS เขาช่วยลูกค้ากำหนดและแก้ปัญหาทางธุรกิจในด้านวิทยาศาสตร์ข้อมูล การเรียนรู้ของเครื่อง คอมพิวเตอร์วิทัศน์ ปัญญาประดิษฐ์ การเพิ่มประสิทธิภาพเชิงตัวเลข และโดเมนที่เกี่ยวข้อง เขาและครอบครัวอาศัยอยู่ในเมืองดัลลัส รัฐเท็กซัส รักการเดินทางและเดินทางไกล

ดร.ฟารุค ซาบีร์ เป็นสถาปนิกอาวุโสด้านปัญญาประดิษฐ์และผู้เชี่ยวชาญด้านการเรียนรู้ของเครื่องที่ AWS เขาสำเร็จการศึกษาระดับปริญญาเอกและปริญญาโทสาขาวิศวกรรมไฟฟ้าจากมหาวิทยาลัยเทกซัสออสติน และปริญญาโทสาขาวิทยาการคอมพิวเตอร์จากสถาบันเทคโนโลยีจอร์เจีย เขามีประสบการณ์การทำงานมากกว่า 15 ปี และยังชอบสอนและให้คำปรึกษาแก่นักศึกษาอีกด้วย ที่ AWS เขาช่วยลูกค้ากำหนดและแก้ปัญหาทางธุรกิจในด้านวิทยาศาสตร์ข้อมูล การเรียนรู้ของเครื่อง คอมพิวเตอร์วิทัศน์ ปัญญาประดิษฐ์ การเพิ่มประสิทธิภาพเชิงตัวเลข และโดเมนที่เกี่ยวข้อง เขาและครอบครัวอาศัยอยู่ในเมืองดัลลัส รัฐเท็กซัส รักการเดินทางและเดินทางไกล

จูน วอน เป็นผู้จัดการผลิตภัณฑ์ของ SageMaker JumpStart เขามุ่งเน้นที่การสร้างแบบจำลองพื้นฐานที่ค้นพบได้ง่ายและใช้งานได้ เพื่อช่วยลูกค้าสร้างแอปพลิเคชัน AI เชิงกำเนิด ประสบการณ์ของเขาที่ Amazon ยังรวมถึงแอปพลิเคชันการช็อปปิ้งบนมือถือและการจัดส่งในระยะทางสุดท้าย

จูน วอน เป็นผู้จัดการผลิตภัณฑ์ของ SageMaker JumpStart เขามุ่งเน้นที่การสร้างแบบจำลองพื้นฐานที่ค้นพบได้ง่ายและใช้งานได้ เพื่อช่วยลูกค้าสร้างแอปพลิเคชัน AI เชิงกำเนิด ประสบการณ์ของเขาที่ Amazon ยังรวมถึงแอปพลิเคชันการช็อปปิ้งบนมือถือและการจัดส่งในระยะทางสุดท้าย

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- เกี่ยวกับเรา

- ยอมรับ

- ยอมรับได้

- การยอมรับ

- เข้า

- ความก้าวหน้า

- ข้อตกลง

- AI

- อัลกอริทึม

- ทั้งหมด

- ด้วย

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- และ

- ประกาศ

- ใด

- การใช้งาน

- การใช้งาน

- ประยุกต์

- เหมาะสม

- เป็น

- ข้อโต้แย้ง

- ศิลปะ

- เทียม

- ปัญญาประดิษฐ์

- ปัญญาประดิษฐ์และการเรียนรู้ด้วยเครื่อง

- AS

- ผู้ช่วย

- มั่นใจ

- At

- ออสติน

- ใช้ได้

- หลีกเลี่ยง

- AWS

- ฐาน

- ตาม

- ทุบตี

- เบย์เซียน

- BE

- คาน

- เพราะ

- ระหว่าง

- พันล้าน

- พันล้านโทเค็น

- พันล้าน

- ทั้งสอง

- ฟองสบู่

- สร้าง

- สร้าง

- ธุรกิจ

- by

- C + +

- โทรศัพท์

- CAN

- สามารถ

- บัตร

- พกพา

- กรณี

- หมวดหมู่

- เซลล์

- เปลี่ยนแปลง

- ลักษณะ

- โหลด

- Choose

- เลือก

- ชั้น

- คลาสสิก

- ปลาเดยส์

- คลิก

- รหัส

- วิทยาลัย

- อย่างไร

- มา

- สมบูรณ์

- เสร็จสิ้น

- ซับซ้อน

- คอมพิวเตอร์

- วิทยาการคอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- ประกอบด้วย

- ปลอบใจ

- เนื้อหา

- สิ่งแวดล้อม

- ความต่อเนื่อง

- การควบคุม

- หน้าปก

- สร้าง

- curated

- ลูกค้า

- ดัลลัส

- ข้อมูล

- วิทยาศาสตร์ข้อมูล

- ถอดรหัส

- ค่าเริ่มต้น

- การจัดส่ง

- สาธิต

- ปรับใช้

- นำไปใช้

- การใช้งาน

- Deploys

- ได้รับการออกแบบ

- รายละเอียด

- พัฒนา

- นักพัฒนา

- พัฒนาการ

- ต่าง

- ดิจิตอล

- ศิลปะดิจิตอล

- ค้นพบ

- do

- การทำ

- โดเมน

- ดยุค

- มหาวิทยาลัยดุ๊ก

- แต่ละ

- ก่อน

- อย่างง่ายดาย

- ที่มีประสิทธิภาพ

- การเปิดใช้งาน

- ส่งเสริม

- ปลาย

- จบสิ้น

- ปลายทาง

- วิศวกรรม

- ชั้นเยี่ยม

- เพื่อให้แน่ใจ

- เท่ากัน

- ความผิดพลาด

- การประเมินการ

- แม้

- ตัวอย่าง

- ตัวอย่าง

- Excel

- ยกเว้น

- ตื่นเต้น

- ไม่รวม

- ที่มีอยู่

- ที่คาดหวัง

- แพง

- ประสบการณ์

- ที่ชี้แจง

- ใบหน้า

- ครอบครัว

- สองสาม

- หา

- ชื่อจริง

- ลอย

- มุ่งเน้นไปที่

- ดังต่อไปนี้

- สำหรับ

- รากฐาน

- พื้นฐาน

- สี่

- ราคาเริ่มต้นที่

- ฟังก์ชัน

- สร้าง

- สร้าง

- สร้าง

- การสร้าง

- รุ่น

- ชั่วอายุคน

- กำเนิด

- กำเนิด AI

- จอร์เจีย

- ได้รับ

- กำหนด

- Go

- มากขึ้น

- โลภ

- คำแนะนำ

- มี

- he

- ช่วย

- การช่วยเหลือ

- จะช่วยให้

- ที่มีคุณภาพสูง

- สูงกว่า

- ของเขา

- ถือ

- หน้าแรก

- เจ้าภาพ

- เป็นเจ้าภาพ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTTPS

- Hub

- ฮับ

- i

- ในอุดมคติ

- if

- นำเข้า

- ปรับปรุง

- การปรับปรุง

- in

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- ที่เพิ่มขึ้น

- ข้อมูล

- อินพุต

- ปัจจัยการผลิต

- ตัวอย่าง

- สถาบัน

- คำแนะนำการใช้

- Intelligence

- ผลประโยชน์

- แนะนำ

- IT

- ชวา

- jpg

- ที่รู้จักกัน

- Kyle

- ภาษา

- ใหญ่

- ชื่อสกุล

- การเรียนรู้

- การออกจาก

- ความยาว

- License

- ความเป็นไปได้

- น่าจะ

- ยอดไลก์

- รายการ

- ดูรายละเอียด

- LLM

- นาน

- ความรัก

- ลด

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- ทำ

- การทำ

- ผู้จัดการ

- หลาย

- กล่าวถึง

- ที่ปรึกษา

- Meta

- ไมล์

- ML

- โทรศัพท์มือถือ

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มีประสิทธิภาพมากขึ้น

- มากที่สุด

- MS

- ต้อง

- โดยธรรมชาติ

- การเดินเรือ

- จำเป็นต้อง

- จำเป็น

- ไม่เคย

- ใหม่

- ถัดไป

- หมายเหตุ

- สมุดบันทึก

- ตอนนี้

- จำนวน

- of

- on

- ONE

- คน

- เพียง

- การเพิ่มประสิทธิภาพ

- Options

- or

- ของเรา

- ออก

- เอาท์พุต

- เกิน

- ของตนเอง

- หน้า

- บานหน้าต่าง

- เอกสาร

- พารามิเตอร์

- ส่วนหนึ่ง

- คู่กรณี

- ต่อ

- ดำเนินการ

- ที่มีประสิทธิภาพ

- phd

- PHP

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- นโยบาย

- ยอดนิยม

- บวก

- เป็นไปได้

- โพสต์

- ที่มีศักยภาพ

- Predictor

- พิมพ์

- พิมพ์

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- กระบวนการ

- ผลิตภัณฑ์

- ผู้จัดการผลิตภัณฑ์

- ผลผลิต

- การเขียนโปรแกรม

- แจ้ง

- ให้

- ผู้ให้บริการ

- ให้

- การตีพิมพ์

- หลาม

- ไฟฉาย

- อย่างรวดเร็ว

- สุ่ม

- พิสัย

- ค่อนข้าง

- มาถึง

- ต้นน้ำ

- เมื่อเร็ว ๆ นี้

- ที่เกี่ยวข้อง

- การเผยแพร่

- ซ้ำแล้วซ้ำอีก

- การวิจัย

- แหล่งข้อมูล

- คำตอบ

- REST

- ผลสอบ

- กลับ

- ย้อนกลับ

- ทบทวน

- ขึ้น

- ถนน

- วิ่ง

- วิ่ง

- sagemaker

- การอนุมาน SageMaker

- เดียวกัน

- ลด

- ที่ปรับขนาดได้

- ขนาด

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- SDK

- ค้นหา

- เลือก

- การเลือก

- ระดับอาวุโส

- ประโยค

- ลำดับ

- ชุด

- บริการ

- ชุด

- การตั้งค่า

- ที่ใช้ร่วมกัน

- ช้อปปิ้ง

- โชว์

- แสดง

- แสดงให้เห็นว่า

- ง่าย

- ขนาด

- So

- ซอฟต์แวร์

- โซลูชัน

- แก้

- บาง

- ผู้เชี่ยวชาญ

- เฉพาะ

- ที่ระบุไว้

- ระบุ

- มั่นคง

- เริ่มต้น

- ข้อความที่เริ่ม

- รัฐของศิลปะ

- ขั้นตอน

- ขั้นตอน

- หยุด

- เชือก

- นักเรียน

- สตูดิโอ

- ประสบความสำเร็จ

- อย่างเช่น

- สนับสนุน

- รองรับ

- แน่ใจ

- ที่ล้อมรอบ

- ใช้เวลา

- งาน

- ทีม

- เทคโนโลยี

- tensorflow

- เงื่อนไขการใช้บริการ

- ทดสอบ

- การทดสอบ

- เท็กซัส

- ข้อความ

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- ตัวเอง

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- ที่สาม

- บุคคลที่สาม

- นี้

- สาม

- ตลอด

- เวลา

- อนุกรมเวลา

- ไปยัง

- โทเค็น

- ราชสกุล

- ด้านบน

- รถไฟ

- ผ่านการฝึกอบรม

- การแปลภาษา

- การเดินทาง

- สำรวจ

- จริง

- ลอง

- ชนิด

- ประเภท

- เป็นปกติ

- ui

- ภายใต้

- ความเข้าใจ

- มหาวิทยาลัย

- จนกระทั่ง

- ใช้ได้

- การใช้

- ใช้

- มือสอง

- ผู้ใช้งาน

- การใช้

- ความคุ้มค่า

- ความคุ้มค่า

- ความหลากหลาย

- รุ่น

- ผ่านทาง

- วิสัยทัศน์

- เดิน

- ต้องการ

- we

- เว็บ

- บริการเว็บ

- ดี

- คือ

- เมื่อ

- ว่า

- ที่

- ในขณะที่

- กว้าง

- วิดเจ็ต

- จะ

- กับ

- ภายใน

- ไม่มี

- คำ

- คำ

- งาน

- เวิร์กโฟลว์

- ขั้นตอนการทำงาน

- เขียน

- ปี

- คุณ

- ของคุณ

- ลมทะเล