บล็อกนี้เขียนร่วมกันโดย Sarah Jane Hong CSO, Darryl Barnhart CTO และ Ian Thompson CEO ของ Latent Space และ Prem Ranga จาก AWS

พื้นที่แฝงเป็นตัวแทนที่ซ่อนอยู่ของแนวคิดนามธรรมที่แบบจำลองการเรียนรู้ของเครื่อง (ML) เรียนรู้ ตัวอย่างเช่น "สุนัข" "ดอกไม้" หรือ "ประตู" เป็นแนวคิดหรือสถานที่ในพื้นที่แฝง ที่ อวกาศแฝงเรากำลังพัฒนาเอ็นจิ้นที่ให้คุณจัดการและสำรวจพื้นที่นี้ด้วยข้อความแจ้งทางภาษาและภาพ ทีมงาน Latent Space มาจากสองสาขาที่มีการทับซ้อนกันน้อย: กราฟิกและการประมวลผลภาษาธรรมชาติ (NLP) ตามเนื้อผ้า รูปแบบต่างๆ ของรูปภาพและข้อความจะได้รับการจัดการแยกจากกัน โดยแต่ละรูปแบบมีประวัติด้านวิศวกรรมคุณลักษณะที่ซับซ้อน มีราคาแพง และเปราะบางของตนเอง งาน NLP เช่น ความเข้าใจในเอกสาร หรือการตอบคำถาม มักจะไม่ค่อยเหมือนกันกับงานด้านการมองเห็น เช่น การทำความเข้าใจหรือการแสดงฉาก และโดยปกติเราจะใช้วิธีการและแบบจำลองที่แตกต่างกันมากสำหรับแต่ละงาน แต่สิ่งนี้กำลังเปลี่ยนแปลงอย่างรวดเร็ว

การผสมผสานของรูปแบบต่างๆ ในพื้นที่แฝงที่ใช้ร่วมกันเพียงแห่งเดียวจะปลดล็อกแอปพลิเคชันที่สร้างสรรค์และเชิงพาณิชย์รุ่นใหม่ ตั้งแต่การเล่นเกมไปจนถึงการทำความเข้าใจในเอกสาร แต่การปลดล็อกแอปพลิเคชันใหม่เหล่านี้ในรูปแบบเดียวทำให้เกิดความท้าทายในการปรับขนาดใหม่ ดังที่เน้นไว้ใน "บทเรียนอันขมขื่น" โดย Richard Sutton และงานที่น่าตื่นเต้นในช่วงไม่กี่ปีที่ผ่านมาเกี่ยวกับกฎหมายมาตราส่วน เพื่อทำให้สิ่งนี้เป็นไปได้ Latent Space กำลังทำงานในการวิจัยที่ล้ำสมัยเพื่อหลอมรวมรูปแบบเหล่านี้ไว้ในแบบจำลองเดียว แต่ยังรวมถึงการปรับขนาดและดำเนินการอย่างมีประสิทธิภาพ นี่คือที่มาของโมเดลคู่ขนาน

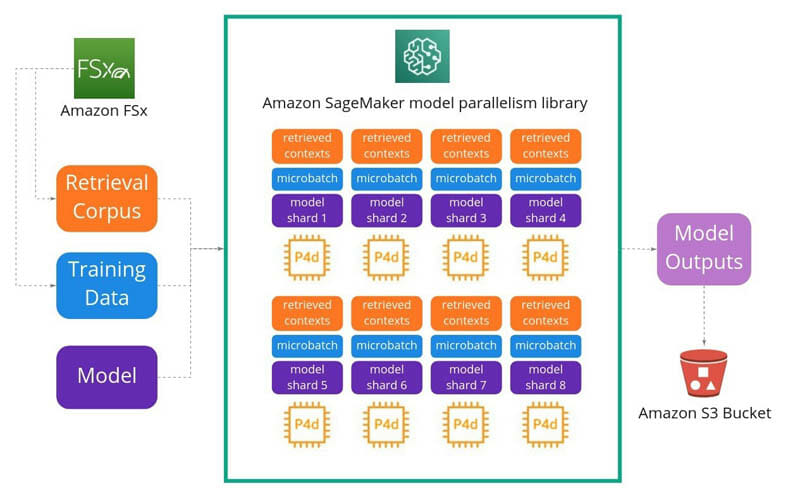

อเมซอน SageMakerการแบ่งพาร์ติชันแบบจำลองอัตโนมัติที่เป็นเอกลักษณ์เฉพาะของและวิธีการวางท่อที่มีประสิทธิภาพทำให้การนำแบบจำลองขนานของเราไปใช้เป็นไปได้ด้วยความพยายามทางวิศวกรรมเพียงเล็กน้อย และเราปรับขนาดการฝึกอบรมแบบจำลองของเราเกินกว่า 1 พันล้านพารามิเตอร์ (เราใช้ p4d.24xlarge A100 อินสแตนซ์) ซึ่งเป็นข้อกำหนดที่สำคัญสำหรับเรา นอกจากนี้ เราสังเกตเห็นว่าเมื่อทำการฝึกด้วย 16 โหนด การตั้งค่าการฝึก GPU แปดตัวด้วยไลบรารีการขนานแบบจำลอง SageMaker เราบันทึกการปรับปรุงประสิทธิภาพ 38% เมื่อเทียบกับการฝึกครั้งก่อนของเรา

ความท้าทายในการฝึกหม้อแปลงขนาดใหญ่

ที่ Latent Space เรากำลังหลอมรวมภาษาและวิสัยทัศน์ในโมเดลหม้อแปลงไฟฟ้าด้วยพารามิเตอร์หลายพันล้านตัวเพื่อรองรับกรณีการใช้งานที่ "ไม่อยู่ในการแจกจ่าย" จากจินตนาการของผู้ใช้หรือที่จะเกิดขึ้นในโลกแห่งความเป็นจริง แต่ไม่ใช่ในข้อมูลการฝึกอบรมของเรา เรากำลังจัดการกับความท้าทายที่มีอยู่ในการปรับขนาดเป็นพันล้านพารามิเตอร์และอื่น ๆ ด้วยสองวิธีที่แตกต่างกัน:

เทคนิคการดึงข้อมูลเป็นองค์ประกอบสำคัญของเสิร์ชเอ็นจิ้นและงาน QA มานานแล้ว เมื่อเร็ว ๆ นี้ มีความก้าวหน้าอันน่าตื่นเต้นที่ผสมผสานเทคนิค IR แบบคลาสสิกกับหม้อแปลงสมัยใหม่ โดยเฉพาะสำหรับงานตอบคำถาม โดยที่แบบจำลองได้รับการฝึกอบรมร่วมกับตัวดึงข้อมูลประสาทที่เรียนรู้การดึงเอกสารที่เกี่ยวข้องเพื่อช่วยตอบคำถาม สำหรับภาพรวม ดูงานล่าสุดจาก FAIR ใน Retrieval Augmented Generation: ปรับปรุงการสร้างแบบจำลองการประมวลผลภาษาธรรมชาติที่ชาญฉลาด และ ฟิวชั่นในตัวถอดรหัส, Google Brain's REALMและ Nvidia's ประสาทรีทรีฟเวอร์ สำหรับการตอบคำถาม

แม้ว่าเทคนิคการดึงข้อมูลเสริมจะช่วยในด้านต้นทุนและประสิทธิภาพ แต่เราก็ยังไม่สามารถใส่โมเดลลงใน GPU ตัวเดียวสำหรับรุ่นที่ใหญ่ที่สุดของเราได้ ซึ่งหมายความว่าเราจำเป็นต้องใช้แบบจำลองขนานในการฝึก อย่างไรก็ตาม เนื่องจากธรรมชาติของสถาปัตยกรรมการดึงข้อมูลของเรา การออกแบบการแยกแบบจำลองของเราจึงเป็นเรื่องที่ท้าทายเนื่องจากการพึ่งพาอาศัยกันระหว่างบริบทที่ดึงมาผ่านอินพุตการฝึกอบรม นอกจากนี้ แม้ว่าเราจะกำหนดวิธีที่เราแยกแบบจำลองของเรา การแนะนำแบบจำลองคู่ขนานเป็นงานวิศวกรรมที่สำคัญสำหรับเราที่จะทำด้วยตนเองตลอดวงจรชีวิตการวิจัยและพัฒนาของเรา

ไลบรารีการขนานแบบจำลอง SageMaker

โมเดลคู่ขนานคือกระบวนการแบ่งโมเดลระหว่างอุปกรณ์หรือโหนดหลายตัว (เช่น อินสแตนซ์ที่ติดตั้ง GPU) และสร้างไปป์ไลน์ที่มีประสิทธิภาพเพื่อฝึกโมเดลในอุปกรณ์เหล่านี้เพื่อเพิ่มการใช้งาน GPU ให้เกิดประโยชน์สูงสุด ดิ ห้องสมุดคู่ขนานแบบจำลอง ใน SageMaker ทำให้โมเดลคู่ขนานสามารถเข้าถึงได้มากขึ้นโดยจัดให้มีการแยกโมเดลอัตโนมัติ หรือที่เรียกว่า การแบ่งโมเดลอัตโนมัติ และการจัดกำหนดการเรียกใช้ไปป์ไลน์ที่ซับซ้อน อัลกอริธึมการแยกแบบจำลองสามารถปรับให้เหมาะสมสำหรับความเร็วหรือการใช้หน่วยความจำ ไลบรารีใช้อัลกอริธึมการแบ่งพาร์ติชันที่ทำให้หน่วยความจำสมดุล ลดการสื่อสารระหว่างอุปกรณ์ และเพิ่มประสิทธิภาพการทำงาน

การแบ่งส่วนแบบจำลองอัตโนมัติ

สำหรับกรณีการใช้งาน PyTorch ไลบรารี่แบบขนานของโมเดลจะรันขั้นตอนการติดตาม (ในขั้นตอนการฝึกแรก) ที่สร้างกราฟแบบจำลองและกำหนดรูปร่างเทนเซอร์และพารามิเตอร์ แล้วสร้างต้นไม้ซึ่งประกอบด้วยรัง nn.Module ออบเจ็กต์ในโมเดล ตลอดจนข้อมูลเพิ่มเติมที่รวบรวมจากการติดตาม เช่น จำนวนที่จัดเก็บ nn.Parametersและรันไทม์สำหรับแต่ละ nn.Module.

จากนั้นไลบรารีจะข้ามต้นไม้นี้จากรูทและเรียกใช้อัลกอริธึมการแบ่งพาร์ติชั่นที่ทำให้โหลดการคำนวณและการใช้หน่วยความจำสมดุล และลดการสื่อสารระหว่างอินสแตนซ์ให้เหลือน้อยที่สุด หาก nn.Modules หลายตัวใช้ nn.Parameter เดียวกัน โมดูลเหล่านี้จะถูกวางไว้บนอุปกรณ์เดียวกันเพื่อหลีกเลี่ยงการรักษาพารามิเตอร์เดียวกันไว้หลายเวอร์ชัน หลังจากตัดสินใจแบ่งพาร์ติชันแล้ว โมดูลและน้ำหนักที่กำหนดจะถูกโหลดไปยังอุปกรณ์ของพวกเขา

กำหนดการรันไปป์ไลน์

คุณสมบัติหลักอีกประการของ SageMaker แบบกระจายไลบรารีแบบขนานคือ ไปป์ไลน์ซึ่งกำหนดลำดับในการคำนวณและประมวลผลข้อมูลในอุปกรณ์ต่างๆ ระหว่างการฝึกโมเดล การวางไปป์ไลน์ขึ้นอยู่กับการแยกมินิแบทช์ออกเป็นไมโครแบทช์ ซึ่งจะป้อนเข้าสู่ไปป์ไลน์การฝึกทีละรายการและทำตามกำหนดการรันที่กำหนดโดยรันไทม์ของไลบรารี

ไปป์ไลน์ microbatch ช่วยให้มั่นใจได้ว่า GPU ทั้งหมดจะถูกใช้งานอย่างเต็มที่ ซึ่งเป็นสิ่งที่เราจะต้องสร้างขึ้นเอง แต่ด้วยไลบรารีแบบขนานของโมเดล สิ่งนี้จะเกิดขึ้นเบื้องหลังอย่างเรียบร้อย สุดท้ายนี้ เราสามารถใช้ อเมซอน FSxซึ่งเป็นสิ่งสำคัญเพื่อให้แน่ใจว่าความเร็วในการอ่านของเรานั้นรวดเร็ว เมื่อพิจารณาจากจำนวนไฟล์ที่อ่านระหว่างการฝึกโมเดลต่อเนื่องหลายรูปแบบพร้อมการดึงข้อมูล

สถาปัตยกรรมการฝึกอบรม

ไดอะแกรมต่อไปนี้แสดงวิธีที่เราตั้งค่าสถาปัตยกรรมการฝึกอบรมของเรา วัตถุประสงค์หลักของเราคือการปรับปรุงความเร็วในการฝึกอบรมและลดต้นทุน ตัวแปลงภาพและภาษาที่เรากำลังฝึกอบรมนั้นซับซ้อนมาก โดยมีเลเยอร์และน้ำหนักจำนวนมากอยู่ภายใน รันถึงพารามิเตอร์หลายพันล้านตัว ทั้งหมดนี้ทำให้ไม่สามารถใส่ลงในหน่วยความจำของโหนดเดียวได้ แต่ละโหนดมีชุดย่อยของโมเดล โดยที่ข้อมูลไหลและการแปลงจะถูกแบ่งปันและคอมไพล์ เราตั้งค่า16 p4d.24xlarge อินสแตนซ์แต่ละตัวมี GPU แปดตัวโดยใช้การแสดงสถาปัตยกรรมต่อไปนี้:

เมื่อเราขยายโมเดลของเรา แนวโน้มทั่วไปก็คือการเก็บทุกอย่างไว้ในน้ำหนักของเครือข่าย อย่างไรก็ตาม เพื่อวัตถุประสงค์ในทางปฏิบัติ เราต้องการเสริมโมเดลของเราเพื่อเรียนรู้วิธีค้นหาบริบทที่เกี่ยวข้องเพื่อช่วยในงานแสดงผล ซึ่งช่วยให้เราสามารถลดต้นทุนการให้บริการได้โดยไม่กระทบต่อคุณภาพของภาพ เราใช้โมเดล NLP ที่ใช้หม้อแปลงไฟฟ้าขนาดใหญ่ และดังที่ได้กล่าวไว้ก่อนหน้านี้ เราสังเกตเห็นว่าประสิทธิภาพการฝึกเพิ่มขึ้น 38% ด้วยไลบรารี Parallelism ของแบบจำลอง SageMaker ดังที่แสดงดังต่อไปนี้:

- เราต้องการ allreduce สำหรับการคำนวณทุกครั้ง ในกรณีของความขนานระดับเทนเซอร์ การดำเนินการนี้ใช้ขั้นตอนแบบขนาน O(log_2 n) นั่นคือ n เครื่องที่ทำตามขั้นตอน O(n) สำหรับการดำเนินการทั้งหมด O(n log_2 n)

- สำหรับไปป์ไลน์ที่ขนานกัน เราต้องการขั้นตอนคู่ขนาน O(1) เพื่อส่งข้อมูลลงไปป์ไลน์

- จากเครื่อง 16 เครื่องที่มี GPU แปดตัว เรามีค่าใช้จ่าย O(1) สำหรับไปป์ไลน์แบบขนาน และต้นทุน O(log_2(8)) = O(3) สำหรับโมเดลเชิงลึกแบบขนาน

- ในกรณีนี้ เราจะเห็นว่าค่าใช้จ่ายเครือข่ายลดลงเหลือ 1 ใน 3 โดยการเปลี่ยนเป็นไปป์ไลน์แบบขนานที่เราใช้กับโมเดล SageMaker แบบขนาน และค่าใช้จ่ายในการฝึกอบรมโดยรวมลดลงเหลือ 1/2 + 1/2 * 1/log_2(16) ) = 0.625 ของต้นทุนเดิมซึ่งนำไปสู่การปรับปรุงประสิทธิภาพที่สอดคล้องกัน

โดยทั่วไป เมื่อความต้องการรับประกันการฝึกอบรมแบบกระจาย (ปัญหาเกี่ยวกับขนาดโมเดลการปรับขนาดหรือข้อมูลการฝึกอบรม) เราสามารถปฏิบัติตามชุดแนวทางปฏิบัติที่ดีที่สุดเพื่อพิจารณาว่าแนวทางใดทำงานได้ดีที่สุด

แนวทางปฏิบัติที่ดีที่สุดสำหรับการฝึกอบรมแบบกระจาย

จากประสบการณ์ของเรา เราแนะนำให้เริ่มต้นด้วยแนวทางคู่ขนานข้อมูลแบบกระจาย ความเท่าเทียมกันของข้อมูลแบบกระจายเช่น SageMaker กระจายไลบรารีข้อมูลแบบคู่ขนาน แก้ไขปัญหาระบบเครือข่ายส่วนใหญ่ด้วยการจำลองแบบจำลอง ดังนั้นคุณควรปรับรุ่นให้เป็นจำนวนโหนดที่น้อยที่สุด จากนั้นทำซ้ำตามขนาดแบทช์ตามความจำเป็น

หากหน่วยความจำไม่เพียงพอระหว่างการฝึก เช่นเดียวกับที่เราทำในสถานการณ์นี้ คุณอาจต้องการเปลี่ยนไปใช้วิธีการแบบขนานแบบจำลอง อย่างไรก็ตาม ให้พิจารณาทางเลือกเหล่านี้ก่อนที่จะลองใช้การฝึกโมเดลแบบขนาน:

- บนฮาร์ดแวร์ที่ติดตั้ง NVIDIA Tensor Core ให้ใช้ การฝึกอบรมแบบผสมความแม่นยำ เพื่อสร้างความเร็วและลดการใช้หน่วยความจำ

- ลดขนาดแบทช์ (หรือลดความละเอียดของภาพหรือความยาวลำดับ NLP ถ้าเป็นไปได้)

นอกจากนี้ เราชอบการออกแบบแบบจำลองที่ไม่มีแบทช์นอร์มัลไลเซชันตามที่อธิบายไว้ใน การจดจำภาพขนาดใหญ่ที่มีประสิทธิภาพสูงโดยไม่ต้องทำให้เป็นมาตรฐาน. หากไม่สามารถหลีกเลี่ยงได้ ให้ตรวจสอบให้แน่ใจว่าแบทช์นอร์มัลไลซ์เซชันถูกซิงค์ระหว่างอุปกรณ์ต่างๆ เมื่อคุณใช้การฝึกอบรมแบบกระจาย แบทช์ของคุณจะถูกแบ่งตาม GPU ดังนั้นสถิติของแบทช์ที่แม่นยำจึงต้องมีการซิงโครไนซ์ในอุปกรณ์ทั้งหมด หากไม่มีสิ่งนี้ การทำให้เป็นมาตรฐานจะมีข้อผิดพลาดเพิ่มขึ้นและทำให้การบรรจบกันบกพร่อง

เริ่มต้นด้วยการฝึกแบบจำลองขนานเมื่อคุณมีข้อจำกัดดังต่อไปนี้:

- โมเดลของคุณไม่พอดีกับอุปกรณ์เครื่องเดียว

- เนื่องจากขนาดรุ่นของคุณ คุณกำลังเผชิญกับข้อจำกัดในการเลือกขนาดแบทช์ที่ใหญ่ขึ้น เช่น หากน้ำหนักรุ่นของคุณใช้หน่วยความจำ GPU ส่วนใหญ่ และคุณถูกบังคับให้เลือกขนาดแบทช์ที่เล็กลงและด้อยประสิทธิภาพ

เมื่อปรับให้เหมาะสมเพื่อประสิทธิภาพ ให้ทำดังต่อไปนี้:

- ใช้การวางท่อสำหรับการสื่อสารระหว่างโหนดเพื่อลดเวลาแฝงและเพิ่มปริมาณงาน

- วางท่อให้สั้นที่สุดเพื่อลดฟองอากาศ ควรปรับจำนวนไมโครแบตช์ให้สมดุลระหว่างประสิทธิภาพในการคำนวณกับขนาดฟอง และอย่างน้อยต้องมีความยาวไปป์ไลน์ หากจำเป็น คุณสามารถสร้างไมโครแบตช์ที่ระดับโทเค็นตามที่อธิบายไว้ใน TeraPipe: Token Level Pipeline Parallelism สำหรับการฝึกโมเดลภาษาขนาดใหญ่

เมื่อปรับค่าใช้จ่ายให้เหมาะสม ให้ใช้อินสแตนซ์ Spot ที่มีการจัดการของ SageMaker สำหรับการฝึกอบรม สิ่งนี้สามารถเพิ่มประสิทธิภาพต้นทุนของโมเดลการฝึกอบรมได้มากถึง 90% เมื่อเทียบกับอินสแตนซ์ตามความต้องการ SageMaker จัดการการหยุดชะงักของ Spot ในนามของคุณ

ปัจจัยอื่น ๆ ที่ต้องพิจารณา:

- ภายในโหนดเมื่อมีการเชื่อมต่อระหว่างกันที่รวดเร็ว จะมีความเหมาะสมยิ่งขึ้น หากเครือข่ายภายในโหนดมีความจุเพียงพอ การสับเปลี่ยนข้อมูลเพื่อการประมวลผลที่เหมาะสมยิ่งขึ้นอาจแสดงให้เห็นประโยชน์

- หากการเปิดใช้งานมีขนาดใหญ่กว่าเมตริกซ์น้ำหนักมาก เครื่องมือเพิ่มประสิทธิภาพการแบ่งส่วนข้อมูลอาจช่วยได้เช่นกัน โปรดดูที่ ศูนย์ .

ตารางต่อไปนี้แสดงสถานการณ์จำลองการฝึกอบรมทั่วไปและวิธีกำหนดค่าบน AWS

| สถานการณ์ | ใช้เมื่อไหร่? | Solution |

| ปรับขนาดจาก GPU เดียวเป็น GPU หลายตัว | เมื่อปริมาณข้อมูลการฝึกหรือขนาดของแบบจำลองใหญ่เกินไป | เปลี่ยนเป็นอินสแตนซ์ GPU หลายตัว เช่น p3.16xlarge ซึ่งมี GPU แปดตัว โดยที่ข้อมูลและการประมวลผลจะแบ่งออกเป็น XNUMX GPU และสร้างความเร็วแบบเกือบเชิงเส้นในเวลาที่ใช้ในการฝึกโมเดลของคุณ |

| ปรับขนาดจากอินสแตนซ์เดียวเป็นหลายอินสแตนซ์ | เมื่อความต้องการปรับขนาดขยายออกไปมากกว่าการเปลี่ยนขนาดอินสแตนซ์ | ปรับขนาดจำนวนอินสแตนซ์ด้วยฟังก์ชันตัวประมาณของ SageMaker Python SDK โดยการตั้งค่า instance_type ของคุณเป็น p3.16xlarge และ instance_count เป็น 2 แทนที่จะเป็น GPU แปดตัวใน p3.16xlarge เดียว คุณมี 16 GPU ในสองอินสแตนซ์ที่เหมือนกัน พิจารณาใช้ SageMaker กระจายไลบรารีข้อมูลแบบคู่ขนาน. |

| การเลือกแนวทางแบบขนานสำหรับการฝึกอบรม | เมื่อพบข้อผิดพลาดหน่วยความจำไม่เพียงพอระหว่างการฝึก | เปลี่ยนไปใช้วิธีการแบบขนานแบบจำลองโดยใช้ SageMaker แจกจ่ายไลบรารีแบบขนานของโมเดล. |

| ประสิทธิภาพเครือข่ายสำหรับการสื่อสารระหว่างโหนด | สำหรับการฝึกอบรมแบบกระจายที่มีหลายอินสแตนซ์ (เช่น การสื่อสารระหว่างโหนดในคลัสเตอร์เมื่อดำเนินการ AllReduce) | อินสแตนซ์ของคุณต้องอยู่ในภูมิภาคเดียวกันและโซนความพร้อมใช้งานเดียวกัน เมื่อคุณใช้ SageMaker Python SDK สิ่งนี้จะได้รับการจัดการสำหรับคุณ ข้อมูลการฝึกอบรมของคุณควรอยู่ใน Availability Zone เดียวกัน พิจารณาใช้ SageMaker กระจายไลบรารีข้อมูลแบบคู่ขนาน. |

| เพิ่มประสิทธิภาพ GPU เครือข่าย และพื้นที่เก็บข้อมูล | สำหรับความต้องการการฝึกอบรมแบบกระจายขนาดใหญ่ | ประเภทอินสแตนซ์ p4d.24xlarge ได้รับการออกแบบมาเพื่อพื้นที่จัดเก็บในเครื่องที่รวดเร็วและแบ็คเพลนเครือข่ายที่รวดเร็วซึ่งมีมากถึง 400 กิกะบิต และเราขอแนะนำอย่างยิ่งให้เป็นตัวเลือกที่มีประสิทธิภาพที่สุดสำหรับการฝึกอบรมแบบกระจาย |

สรุป

ด้วยไลบรารีแบบขนานโมเดลใน SageMaker เราได้รับประโยชน์มากมายตั้งแต่แกะกล่อง เช่น การแบ่งพาร์ติชันโมเดลอัตโนมัติและการวางท่อที่มีประสิทธิภาพ ในโพสต์นี้ เราแชร์ความท้าทายกับกรณีการใช้งาน ML ข้อควรพิจารณาเกี่ยวกับแนวทางการฝึกอบรมต่างๆ และวิธีที่เราใช้ไลบรารีการขนานโมเดล Amazon SageMaker เพื่อเพิ่มความเร็วในการฝึกอบรม เหนือสิ่งอื่นใด ขณะนี้อาจใช้เวลาเพียงไม่กี่ชั่วโมงในการนำแนวทางปฏิบัติที่ดีที่สุดมาใช้สำหรับโมเดลคู่ขนานและการปรับปรุงประสิทธิภาพตามที่อธิบายไว้ที่นี่ หากโพสต์นี้ช่วยคุณหรือเป็นแรงบันดาลใจให้คุณแก้ปัญหา เราก็ยินดีรับฟัง! กรุณาแบ่งปันความคิดเห็นและข้อเสนอแนะของคุณ

อ้างอิง

สำหรับข้อมูลเพิ่มเติม โปรดดูต่อไปนี้:

เกี่ยวกับผู้เขียน

เปรม รังสิต เป็น Enterprise Solutions Architect ซึ่งตั้งอยู่ในเมืองแอตแลนตา รัฐจอร์เจีย เขาเป็นส่วนหนึ่งของชุมชนด้านเทคนิคของแมชชีนเลิร์นนิ่งและชอบที่จะทำงานร่วมกับลูกค้าในเส้นทาง ML และ AI เปรมหลงใหลเกี่ยวกับวิทยาการหุ่นยนต์ เป็นนักวิจัยด้านยานยนต์อัตโนมัติ และสร้าง Beer Pours ที่ควบคุมโดย Alexa ในฮูสตันและสถานที่อื่นๆ

เปรม รังสิต เป็น Enterprise Solutions Architect ซึ่งตั้งอยู่ในเมืองแอตแลนตา รัฐจอร์เจีย เขาเป็นส่วนหนึ่งของชุมชนด้านเทคนิคของแมชชีนเลิร์นนิ่งและชอบที่จะทำงานร่วมกับลูกค้าในเส้นทาง ML และ AI เปรมหลงใหลเกี่ยวกับวิทยาการหุ่นยนต์ เป็นนักวิจัยด้านยานยนต์อัตโนมัติ และสร้าง Beer Pours ที่ควบคุมโดย Alexa ในฮูสตันและสถานที่อื่นๆ

ซาราห์ เจน ฮง เป็นผู้ร่วมก่อตั้งและประธานเจ้าหน้าที่ฝ่ายวิทยาศาสตร์ของ Latent Space พื้นหลังของเธออยู่ที่จุดตัดของการปฏิสัมพันธ์ระหว่างมนุษย์กับคอมพิวเตอร์และการเรียนรู้ของเครื่อง ก่อนหน้านี้เธอเป็นผู้นำการวิจัย NLP ที่ Sonar (ซื้อกิจการโดย Marchex) ซึ่งให้บริการธุรกิจในพื้นที่ AI แบบสนทนา เธอยังเป็นนักพัฒนา AR/VR ที่ได้รับการยกย่องอีกด้วย โดยได้รับรางวัลและทุนจาก Oculus, Mozilla Mixed Reality และ Microsoft Hololens

ซาราห์ เจน ฮง เป็นผู้ร่วมก่อตั้งและประธานเจ้าหน้าที่ฝ่ายวิทยาศาสตร์ของ Latent Space พื้นหลังของเธออยู่ที่จุดตัดของการปฏิสัมพันธ์ระหว่างมนุษย์กับคอมพิวเตอร์และการเรียนรู้ของเครื่อง ก่อนหน้านี้เธอเป็นผู้นำการวิจัย NLP ที่ Sonar (ซื้อกิจการโดย Marchex) ซึ่งให้บริการธุรกิจในพื้นที่ AI แบบสนทนา เธอยังเป็นนักพัฒนา AR/VR ที่ได้รับการยกย่องอีกด้วย โดยได้รับรางวัลและทุนจาก Oculus, Mozilla Mixed Reality และ Microsoft Hololens

ดาร์ริล บาร์นฮาร์ท เป็นผู้ร่วมก่อตั้งและประธานเจ้าหน้าที่ฝ่ายเทคโนโลยีของ Latent Space เขาเป็นนักพัฒนาที่มีประสบการณ์มากประสบการณ์ในการเร่งความเร็ว GPU, คอมพิวเตอร์กราฟิก, ข้อมูลขนาดใหญ่ และการเรียนรู้ของเครื่อง ความสนใจอื่นๆ ได้แก่ คณิตศาสตร์ การพัฒนาเกม และการศึกษาข้อมูล

ดาร์ริล บาร์นฮาร์ท เป็นผู้ร่วมก่อตั้งและประธานเจ้าหน้าที่ฝ่ายเทคโนโลยีของ Latent Space เขาเป็นนักพัฒนาที่มีประสบการณ์มากประสบการณ์ในการเร่งความเร็ว GPU, คอมพิวเตอร์กราฟิก, ข้อมูลขนาดใหญ่ และการเรียนรู้ของเครื่อง ความสนใจอื่นๆ ได้แก่ คณิตศาสตร์ การพัฒนาเกม และการศึกษาข้อมูล

เอียน ทอมป์สัน เป็นผู้ก่อตั้งและซีอีโอของ Latent Space เอียนเป็นวิศวกรและนักวิจัยที่ได้รับแรงบันดาลใจจาก "ความเป็นไปได้ที่อยู่ติดกัน" ซึ่งเป็นเทคโนโลยีที่มีผลกระทบอย่างมากต่อชีวิตของเรา ปัจจุบันมุ่งเน้นไปที่การลดความซับซ้อนและการปรับขนาดการเรียนรู้ของตัวแทนหลายรูปแบบเพื่อช่วยสร้าง AI ที่ปลอดภัยและสร้างสรรค์ ก่อนหน้านี้เขาเคยช่วยสร้างบริษัทในด้านกราฟิก/เสมือนจริง (AltspaceVR ที่ Microsoft ซื้อกิจการ) และการศึกษา/NLP (HSE)

เอียน ทอมป์สัน เป็นผู้ก่อตั้งและซีอีโอของ Latent Space เอียนเป็นวิศวกรและนักวิจัยที่ได้รับแรงบันดาลใจจาก "ความเป็นไปได้ที่อยู่ติดกัน" ซึ่งเป็นเทคโนโลยีที่มีผลกระทบอย่างมากต่อชีวิตของเรา ปัจจุบันมุ่งเน้นไปที่การลดความซับซ้อนและการปรับขนาดการเรียนรู้ของตัวแทนหลายรูปแบบเพื่อช่วยสร้าง AI ที่ปลอดภัยและสร้างสรรค์ ก่อนหน้านี้เขาเคยช่วยสร้างบริษัทในด้านกราฟิก/เสมือนจริง (AltspaceVR ที่ Microsoft ซื้อกิจการ) และการศึกษา/NLP (HSE)