การเปิดตัว ChatGPT และความนิยมที่เพิ่มขึ้นของ generative AI ได้ดึงดูดจินตนาการของลูกค้าที่สงสัยว่าพวกเขาสามารถใช้เทคโนโลยีนี้เพื่อสร้างผลิตภัณฑ์และบริการใหม่บน AWS ได้อย่างไร เช่น แชทบอทระดับองค์กรซึ่งมีการสนทนามากกว่า โพสต์นี้แสดงให้คุณเห็นว่าคุณสามารถสร้าง UI ของเว็บซึ่งเราเรียกว่า Chat Studio ได้อย่างไร เพื่อเริ่มการสนทนาและโต้ตอบกับโมเดลพื้นฐานที่มีอยู่ใน Amazon SageMaker JumpStart เช่น Llama 2, Stable Diffusion และรุ่นอื่นๆ ที่มีใน อเมซอน SageMaker. หลังจากที่คุณปรับใช้โซลูชันนี้ ผู้ใช้สามารถเริ่มต้นได้อย่างรวดเร็วและสัมผัสกับความสามารถของโมเดลพื้นฐานหลายตัวใน AI เชิงสนทนาผ่านอินเทอร์เฟซเว็บ

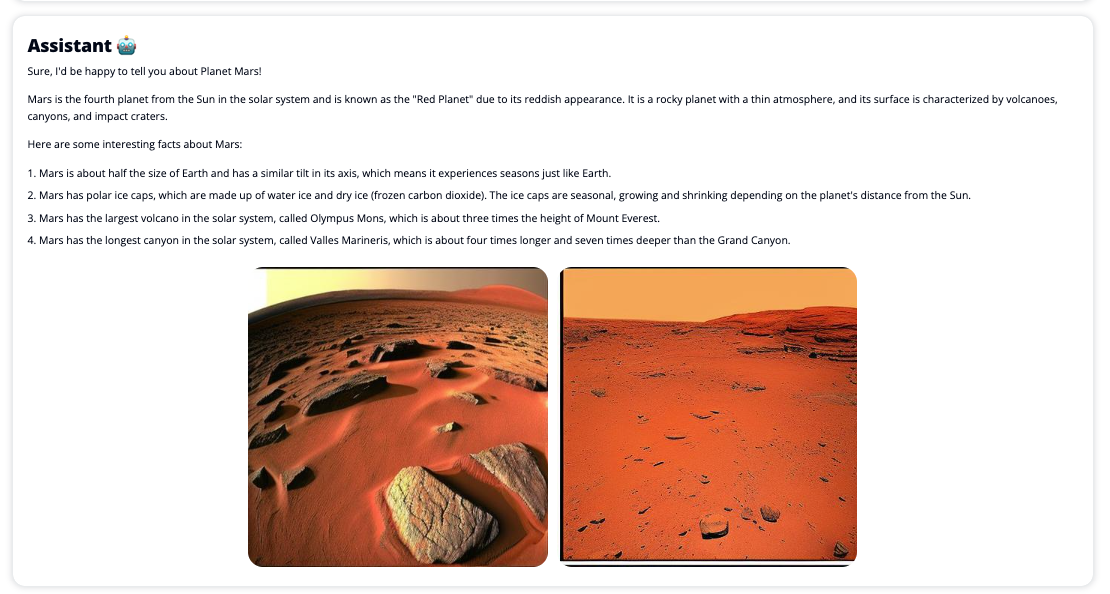

Chat Studio ยังสามารถเลือกเรียกใช้จุดสิ้นสุดของโมเดล Stable Diffusion เพื่อส่งคืนภาพต่อกันของรูปภาพและวิดีโอที่เกี่ยวข้องได้ หากผู้ใช้ร้องขอให้แสดงสื่อ คุณลักษณะนี้สามารถช่วยเพิ่มประสบการณ์ผู้ใช้ด้วยการใช้สื่อเป็นทรัพย์สินที่มาพร้อมกับการตอบสนอง นี่เป็นเพียงตัวอย่างหนึ่งของวิธีที่คุณสามารถเพิ่มคุณค่าให้กับ Chat Studio ด้วยการผสานรวมเพิ่มเติมเพื่อให้บรรลุเป้าหมายของคุณ

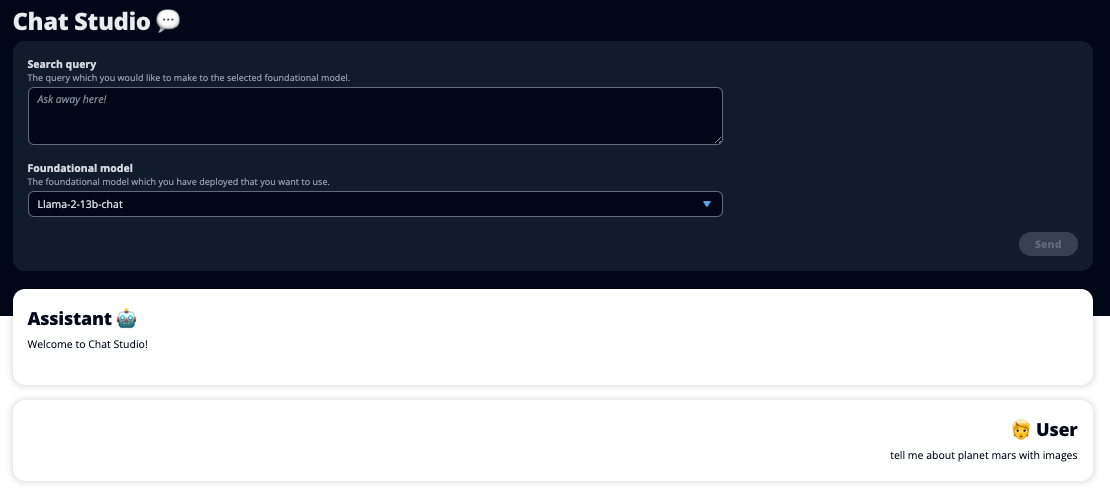

ภาพหน้าจอต่อไปนี้แสดงตัวอย่างลักษณะของข้อความค้นหาและการตอบกลับของผู้ใช้

โมเดลภาษาขนาดใหญ่

แชทบอท AI ทั่วไป เช่น ChatGPT ขับเคลื่อนโดยโมเดลภาษาขนาดใหญ่ (LLM) ซึ่งใช้โครงข่ายประสาทเทียมการเรียนรู้เชิงลึก ซึ่งสามารถฝึกกับข้อความที่ไม่มีป้ายกำกับจำนวนมากได้ การใช้ LLM ช่วยให้ได้รับประสบการณ์การสนทนาที่ดีขึ้น ซึ่งคล้ายกับปฏิสัมพันธ์กับมนุษย์อย่างใกล้ชิด ส่งเสริมความรู้สึกของการเชื่อมโยงและความพึงพอใจของผู้ใช้ที่ดีขึ้น

โมเดลพื้นฐาน SageMaker

ในปี 2021 สถาบัน Stanford Institute for Human-Centered Artificial Intelligence เรียก LLM บางแห่งว่า โมเดลรองพื้น. โมเดลพื้นฐานได้รับการฝึกอบรมล่วงหน้าเกี่ยวกับชุดข้อมูลทั่วไปขนาดใหญ่และกว้าง และมีจุดมุ่งหมายเพื่อใช้เป็นพื้นฐานสำหรับการปรับปรุงประสิทธิภาพเพิ่มเติมในกรณีการใช้งานที่หลากหลาย ตั้งแต่การสร้างงานศิลปะดิจิทัลไปจนถึงการจัดหมวดหมู่ข้อความหลายภาษา โมเดลพื้นฐานเหล่านี้ได้รับความนิยมจากลูกค้า เนื่องจากการฝึกโมเดลใหม่ตั้งแต่เริ่มต้นต้องใช้เวลาและอาจมีราคาแพง SageMaker JumpStart ให้การเข้าถึงโมเดลพื้นฐานหลายร้อยโมเดลที่ดูแลโดยโอเพ่นซอร์สบุคคลที่สามและผู้ให้บริการที่เป็นกรรมสิทธิ์

ภาพรวมโซลูชัน

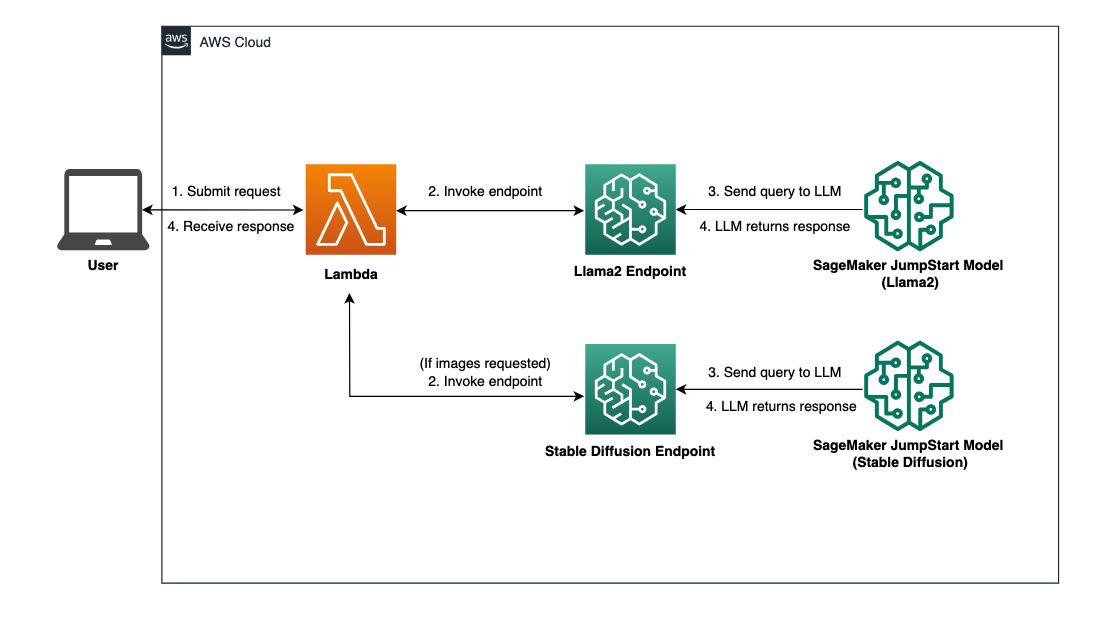

โพสต์นี้จะอธิบายขั้นตอนการทำงานที่ใช้โค้ดน้อยสำหรับการปรับใช้ LLM ที่ได้รับการฝึกอบรมล่วงหน้าและแบบกำหนดเองผ่าน SageMaker และสร้าง UI บนเว็บเพื่อเชื่อมต่อกับโมเดลที่ใช้งาน เราครอบคลุมขั้นตอนต่อไปนี้:

- ปรับใช้โมเดลพื้นฐาน SageMaker

- ปรับใช้ AWS แลมบ์ดา และ AWS Identity และการจัดการการเข้าถึง (IAM) สิทธิ์ที่ใช้ การก่อตัวของ AWS Cloud.

- ตั้งค่าและเรียกใช้อินเทอร์เฟซผู้ใช้

- คุณสามารถเลือกเพิ่มโมเดลพื้นฐาน SageMaker อื่นๆ ได้ ขั้นตอนนี้จะขยายความสามารถของ Chat Studio ในการโต้ตอบกับโมเดลพื้นฐานเพิ่มเติม

- หรือปรับใช้แอปพลิเคชันโดยใช้ AWS ขยาย. ขั้นตอนนี้จะปรับใช้ Chat Studio กับเว็บ

โปรดดูแผนภาพต่อไปนี้สำหรับภาพรวมของสถาปัตยกรรมโซลูชัน

เบื้องต้น

ในการดำเนินการแก้ไขปัญหา คุณต้องมีข้อกำหนดเบื้องต้นต่อไปนี้:

- An บัญชี AWS ด้วยสิทธิ์ผู้ใช้ IAM ที่เพียงพอ

npmติดตั้งในสภาพแวดล้อมท้องถิ่นของคุณ สำหรับคำแนะนำในการติดตั้งnpm, เอ่ยถึง การดาวน์โหลดและติดตั้ง Node.js และ npm.- โควต้าบริการ 1 สำหรับตำแหน่งข้อมูล SageMaker ที่เกี่ยวข้อง สำหรับ Llama 2 13b Chat เราใช้อินสแตนซ์ ml.g5.48xlarge และสำหรับ Stable Diffusion 2.1 เราใช้อินสแตนซ์ ml.p3.2xlarge

หากต้องการขอเพิ่มโควต้าบริการได้ที่ คอนโซลโควต้าบริการ AWS, นำทางไปยัง บริการของ AWS, SageMakerและคำขอโควต้าบริการจะเพิ่มเป็น 1 สำหรับ ml.g5.48xlarge สำหรับการใช้งานตำแหน่งข้อมูล และ ml.p3.2xlarge สำหรับการใช้งานตำแหน่งข้อมูล

คำขอโควต้าบริการอาจใช้เวลาสองสามชั่วโมงในการอนุมัติ ขึ้นอยู่กับความพร้อมใช้งานของประเภทอินสแตนซ์

ปรับใช้โมเดลพื้นฐาน SageMaker

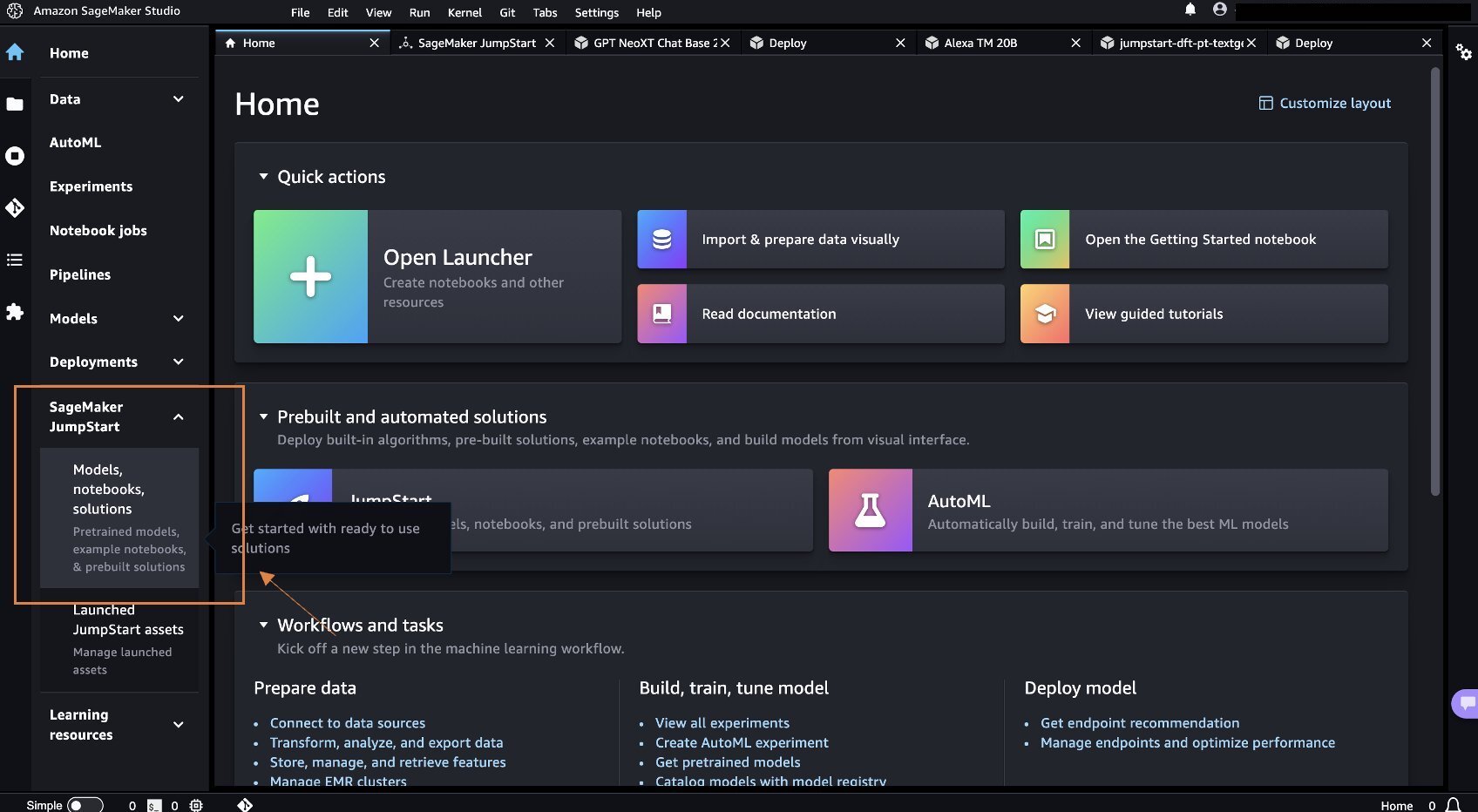

SageMaker เป็นบริการ Machine Learning (ML) ที่มีการจัดการเต็มรูปแบบสำหรับนักพัฒนาเพื่อสร้างและฝึกฝนโมเดล ML ได้อย่างรวดเร็วอย่างง่ายดาย ทำตามขั้นตอนต่อไปนี้เพื่อปรับใช้โมเดลพื้นฐาน Llama 2 13b Chat และ Stable Diffusion 2.1 โดยใช้ สตูดิโอ Amazon SageMaker:

- สร้างโดเมน SageMaker สำหรับคำแนะนำ โปรดดูที่ เริ่มต้นใช้งานโดเมน Amazon SageMaker โดยใช้การตั้งค่าด่วน.

โดเมนจะตั้งค่าพื้นที่เก็บข้อมูลทั้งหมดและอนุญาตให้คุณเพิ่มผู้ใช้เพื่อเข้าถึง SageMaker

- บนคอนโซล SageMaker ให้เลือก สตูดิโอ ในบานหน้าต่างนำทาง จากนั้นเลือก เปิด Studio.

- เมื่อเปิดตัว Studio ภายใต้ SageMaker JumpStart ในบานหน้าต่างนำทาง ให้เลือก โมเดล โน๊ตบุ๊ค โซลูชั่น.

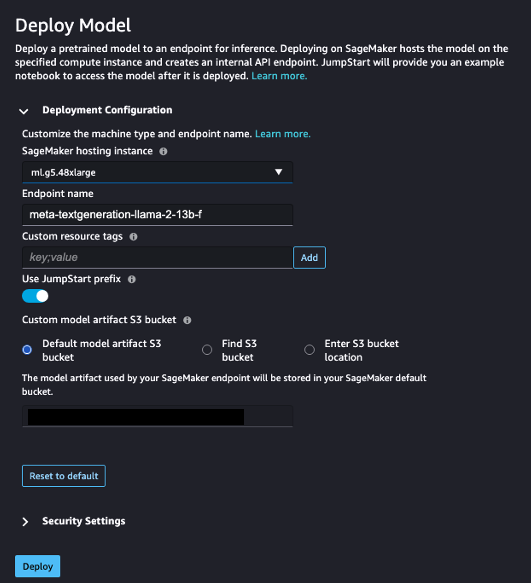

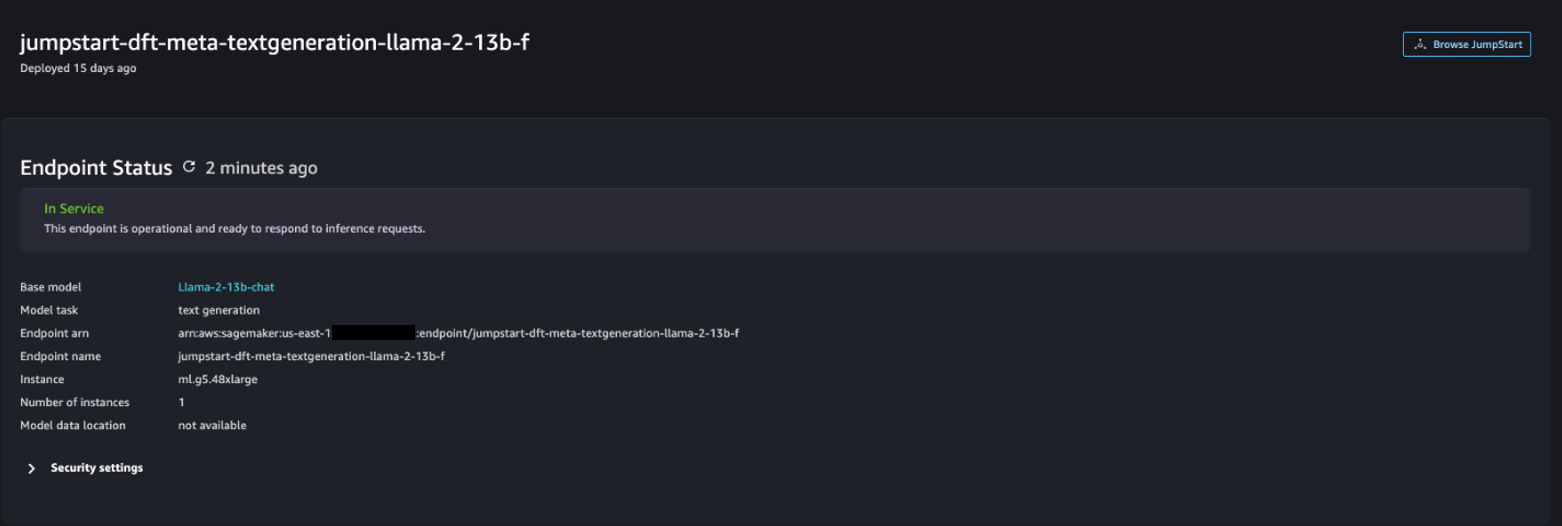

- ในแถบค้นหา ให้ค้นหา Llama 2 13b Chat

- ภายใต้ การกำหนดค่าการปรับใช้สำหรับ อินสแตนซ์การโฮสต์ SageMakerเลือก มล.g5.48xlarge และสำหรับ ชื่อปลายทางป้อน

meta-textgeneration-llama-2-13b-f. - Choose ปรับใช้

หลังจากการปรับใช้สำเร็จ คุณควรจะเห็น In Service สถานะ

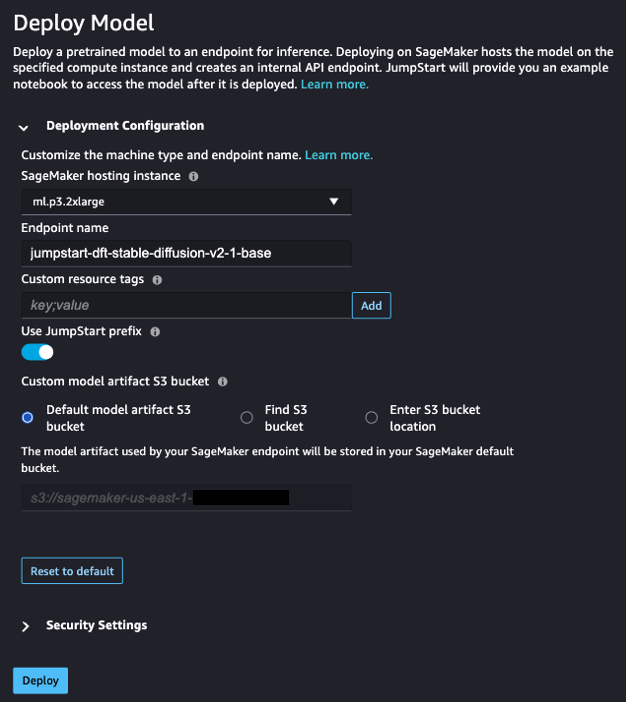

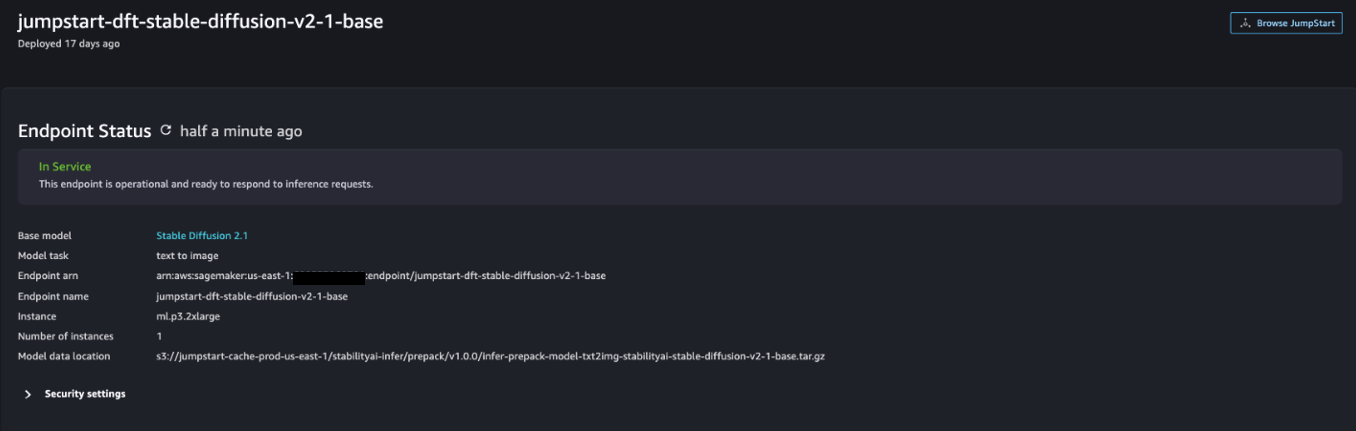

- เกี่ยวกับ โมเดล โน๊ตบุ๊ค โซลูชั่น หน้า ค้นหา Stable Diffusion 2.1

- ภายใต้ การกำหนดค่าการปรับใช้สำหรับ อินสแตนซ์การโฮสต์ SageMakerเลือก ml.p3.2xlarge และสำหรับ ชื่อปลายทางป้อน

jumpstart-dft-stable-diffusion-v2-1-base. - Choose ปรับใช้.

หลังจากการปรับใช้สำเร็จ คุณควรจะเห็น In Service สถานะ

ปรับใช้สิทธิ์ Lambda และ IAM โดยใช้ AWS CloudFormation

ส่วนนี้อธิบายวิธีที่คุณสามารถเปิดใช้สแตก CloudFormation ที่ปรับใช้ฟังก์ชัน Lambda ที่ประมวลผลคำขอผู้ใช้ของคุณและเรียกตำแหน่งข้อมูล SageMaker ที่คุณปรับใช้ และปรับใช้สิทธิ์ IAM ที่จำเป็นทั้งหมด ทำตามขั้นตอนต่อไปนี้:

- ไปที่ พื้นที่เก็บข้อมูล GitHub และดาวน์โหลดเทมเพลต CloudFormation (

lambda.cfn.yaml) ไปยังเครื่องท้องถิ่นของคุณ - บนคอนโซล CloudFormation ให้เลือก สร้าง stack เมนูแบบเลื่อนลงแล้วเลือก ด้วยทรัพยากรใหม่ (มาตรฐาน).

- เกี่ยวกับ ระบุแม่แบบ ใหเลือก อัปโหลดไฟล์เทมเพลต และ เลือกไฟล์.

- เลือก

lambda.cfn.yamlไฟล์ที่คุณดาวน์โหลดมา จากนั้นเลือก ถัดไป. - เกี่ยวกับ ระบุรายละเอียดกอง ป้อนชื่อสแต็กและคีย์ API ที่คุณได้รับในข้อกำหนดเบื้องต้น จากนั้นเลือก ถัดไป.

- เกี่ยวกับ กำหนดค่าตัวเลือกสแต็ก หน้าให้เลือก ถัดไป.

- ตรวจสอบและรับทราบการเปลี่ยนแปลงและเลือก ส่ง.

ตั้งค่า UI ของเว็บ

ส่วนนี้จะอธิบายขั้นตอนในการเรียกใช้ UI ของเว็บ (สร้างขึ้นโดยใช้ ระบบออกแบบ Cloudscape) บนเครื่องท้องถิ่นของคุณ:

- บนคอนโซล IAM ให้นำทางไปยังผู้ใช้

functionUrl. - เกี่ยวกับ ข้อมูลรับรองความปลอดภัย เลือกแท็บ สร้างคีย์การเข้าถึง.

- เกี่ยวกับ เข้าถึงแนวทางปฏิบัติที่ดีที่สุดและทางเลือกที่สำคัญ ใหเลือก อินเตอร์เฟสบรรทัดคำสั่ง (CLI) และเลือก ถัดไป.

- เกี่ยวกับ ตั้งแท็กคำอธิบาย หน้าให้เลือก สร้างคีย์การเข้าถึง.

- คัดลอกคีย์การเข้าถึงและคีย์การเข้าถึงที่เป็นความลับ

- Choose เสร็จสิ้น.

- ไปที่ พื้นที่เก็บข้อมูล GitHub และดาวน์โหลด

react-llm-chat-studioรหัส. - เปิดโฟลเดอร์ใน IDE ที่คุณต้องการและเปิดเทอร์มินัล

- นำทางไปยัง

src/configs/aws.jsonและป้อนรหัสการเข้าถึงและรหัสการเข้าถึงลับที่คุณได้รับ - ป้อนคำสั่งต่อไปนี้ในเทอร์มินัล:

- จุดเปิด http://localhost:3000 ในเบราว์เซอร์ของคุณและเริ่มโต้ตอบกับโมเดลของคุณ!

หากต้องการใช้ Chat Studio ให้เลือกโมเดลพื้นฐานในเมนูแบบเลื่อนลงแล้วป้อนคำถามของคุณในกล่องข้อความ หากต้องการรับรูปภาพที่สร้างโดย AI พร้อมกับการตอบกลับ ให้เพิ่มวลี “พร้อมรูปภาพ” ต่อท้ายข้อความค้นหาของคุณ

เพิ่มโมเดลพื้นฐาน SageMaker อื่นๆ

คุณสามารถขยายขีดความสามารถของโซลูชันนี้เพิ่มเติมเพื่อรวมโมเดลพื้นฐาน SageMaker เพิ่มเติมได้ เนื่องจากทุกรุ่นคาดหวังรูปแบบอินพุตและเอาต์พุตที่แตกต่างกันเมื่อเรียกใช้ตำแหน่งข้อมูล SageMaker คุณจะต้องเขียนโค้ดการแปลงบางส่วนในฟังก์ชัน callSageMakerEndpoints Lambda เพื่อเชื่อมต่อกับโมเดล

ส่วนนี้จะอธิบายขั้นตอนทั่วไปและการเปลี่ยนแปลงโค้ดที่จำเป็นสำหรับการนำโมเดลเพิ่มเติมที่คุณเลือกไปใช้ โปรดทราบว่าจำเป็นต้องมีความรู้พื้นฐานเกี่ยวกับภาษา Python สำหรับขั้นตอนที่ 6–8

- ใน SageMaker Studio ให้ปรับใช้โมเดลพื้นฐาน SageMaker ที่คุณเลือก

- Choose SageMaker JumpStart และ เปิดตัวสินทรัพย์ JumpStart.

- เลือกตำแหน่งข้อมูลโมเดลที่เพิ่งปรับใช้แล้วเลือก เปิดสมุดบันทึก.

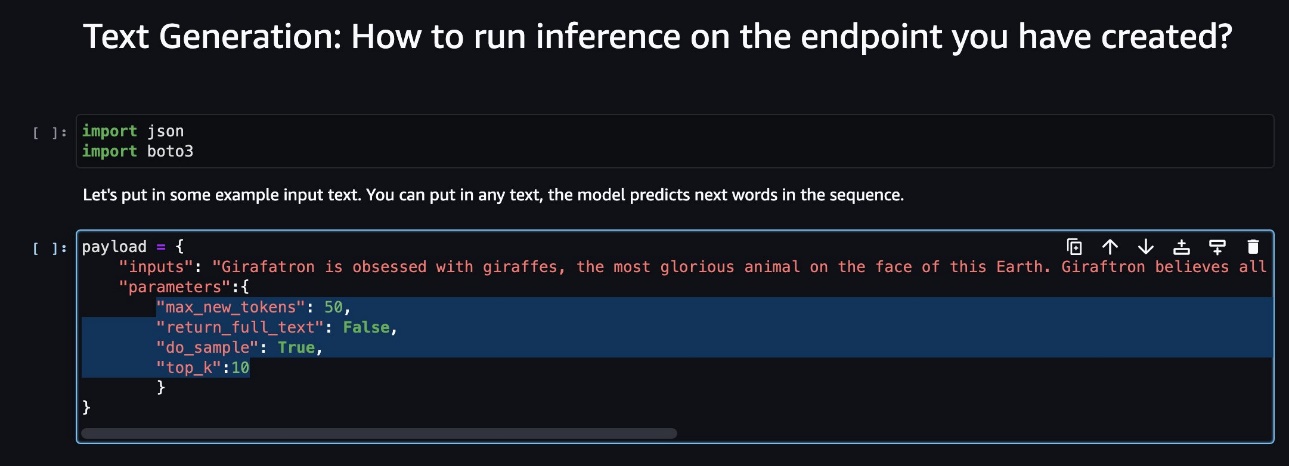

- บนคอนโซลโน้ตบุ๊ก ให้ค้นหาพารามิเตอร์เพย์โหลด

ช่องเหล่านี้เป็นช่องที่โมเดลใหม่คาดหวังเมื่อเรียกใช้ตำแหน่งข้อมูล SageMaker ภาพหน้าจอต่อไปนี้แสดงตัวอย่าง

- บนคอนโซล Lambda ให้นำทางไปที่

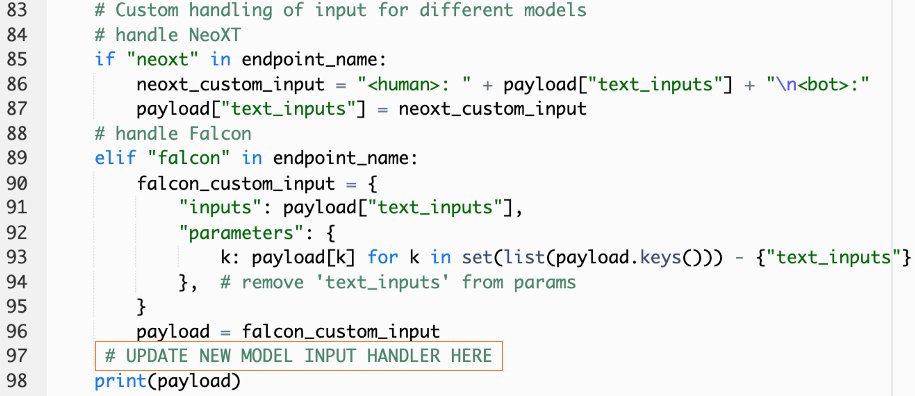

callSageMakerEndpoints. - เพิ่มตัวจัดการอินพุตที่กำหนดเองสำหรับโมเดลใหม่ของคุณ

ในภาพหน้าจอต่อไปนี้ เราได้แปลงอินพุตสำหรับ Falcon 40B Instruct BF16 และ GPT NeoXT Chat Base 20B FP16 คุณสามารถแทรกตรรกะพารามิเตอร์ที่กำหนดเองตามที่ระบุไว้เพื่อเพิ่มตรรกะการแปลงอินพุตโดยอ้างอิงกับพารามิเตอร์เพย์โหลดที่คุณคัดลอก

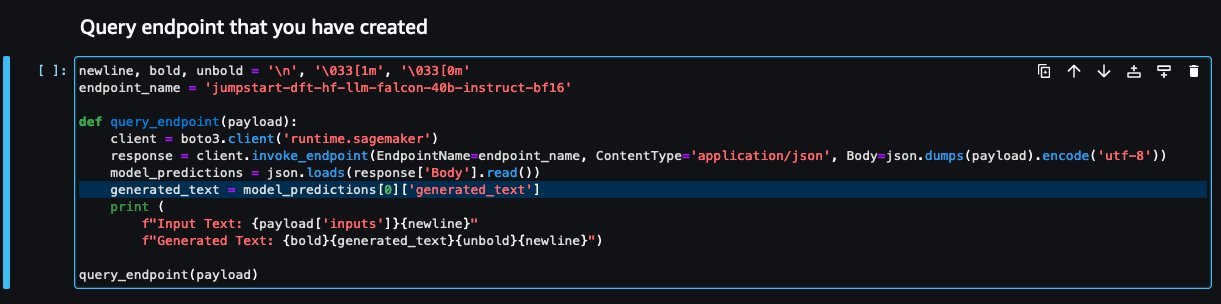

- กลับไปที่คอนโซลโน้ตบุ๊กแล้วค้นหา

query_endpoint.

ฟังก์ชันนี้ช่วยให้คุณทราบวิธีแปลงเอาต์พุตของโมเดลเพื่อแยกการตอบกลับข้อความสุดท้าย

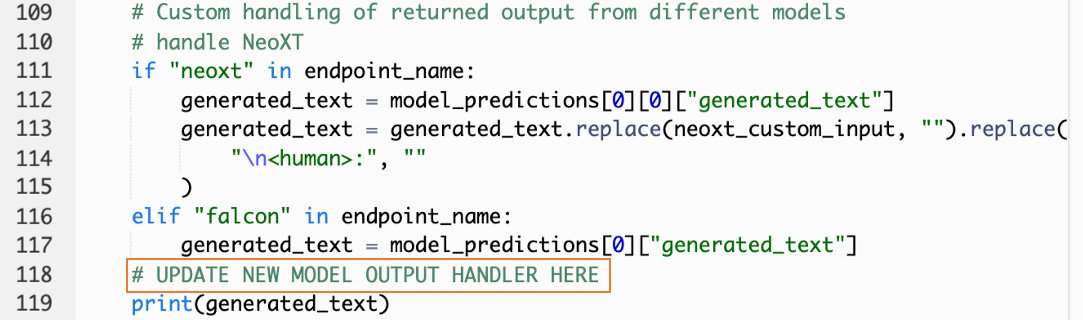

- โดยมีการอ้างอิงถึงรหัสใน

query_endpointให้เพิ่มตัวจัดการเอาต์พุตแบบกำหนดเองสำหรับโมเดลใหม่ของคุณ

- Choose ปรับใช้

- เปิด IDE ของคุณ เปิดไฟล์

react-llm-chat-studioรหัสและนำทางไปที่src/configs/models.json. - เพิ่มชื่อโมเดลและจุดสิ้นสุดของโมเดล แล้วป้อนพารามิเตอร์เพย์โหลดจากขั้นตอนที่ 4 ด้านล่าง

payloadโดยใช้รูปแบบต่อไปนี้: - รีเฟรชเบราว์เซอร์ของคุณเพื่อเริ่มโต้ตอบกับโมเดลใหม่ของคุณ!

ปรับใช้แอปพลิเคชันโดยใช้ Amplify

Amplify เป็นโซลูชันครบวงจรที่ช่วยให้คุณสามารถปรับใช้แอปพลิเคชันของคุณได้อย่างรวดเร็วและมีประสิทธิภาพ ส่วนนี้อธิบายขั้นตอนในการปรับใช้ Chat Studio กับ Amazon CloudFront การกระจายโดยใช้ Amplify หากคุณต้องการแชร์แอปพลิเคชันของคุณกับผู้ใช้รายอื่น

- ไปที่

react-llm-chat-studioโฟลเดอร์รหัสที่คุณสร้างไว้ก่อนหน้านี้ - ป้อนคำสั่งต่อไปนี้ในเทอร์มินัลแล้วปฏิบัติตามคำแนะนำในการตั้งค่า:

- เตรียมใช้งานโปรเจ็กต์ Amplify ใหม่โดยใช้คำสั่งต่อไปนี้ ระบุชื่อโปรเจ็กต์ ยอมรับการกำหนดค่าเริ่มต้น และเลือก คีย์การเข้าถึง AWS เมื่อได้รับแจ้งให้เลือกวิธีการรับรองความถูกต้อง

- โฮสต์โปรเจ็กต์ Amplify โดยใช้คำสั่งต่อไปนี้ เลือก Amazon CloudFront และ S3 เมื่อได้รับแจ้งให้เลือกโหมดปลั๊กอิน

- สุดท้าย สร้างและปรับใช้โปรเจ็กต์ด้วยคำสั่งต่อไปนี้:

- หลังจากการปรับใช้สำเร็จ ให้เปิด URL ที่ให้ไว้ในเบราว์เซอร์ของคุณ และเริ่มโต้ตอบกับโมเดลของคุณ!

ทำความสะอาด

เพื่อหลีกเลี่ยงค่าใช้จ่ายในอนาคต ให้ทำตามขั้นตอนต่อไปนี้:

- ลบสแต็ก CloudFormation สำหรับคำแนะนำ โปรดดูที่ การลบสแต็กบนคอนโซล AWS CloudFormation.

- ลบตำแหน่งข้อมูล SageMaker JumpStart สำหรับคำแนะนำ โปรดดูที่ ลบปลายทางและทรัพยากร.

- ลบโดเมน SageMaker สำหรับคำแนะนำ โปรดดูที่ ลบโดเมน Amazon SageMaker.

สรุป

ในโพสต์นี้ เราได้อธิบายวิธีสร้าง UI ของเว็บสำหรับการเชื่อมต่อกับ LLM ที่ใช้งานบน AWS

ด้วยโซลูชันนี้ คุณสามารถโต้ตอบกับ LLM ของคุณและจัดการสนทนาในลักษณะที่เป็นมิตรต่อผู้ใช้เพื่อทดสอบหรือถามคำถาม LLM และรับภาพต่อกันและวิดีโอหากจำเป็น

คุณสามารถขยายโซลูชันนี้ได้หลายวิธี เช่น การบูรณาการโมเดลพื้นฐานเพิ่มเติม ผสานรวมกับ Amazon Kendra เพื่อเปิดใช้งานการค้นหาอัจฉริยะที่ขับเคลื่อนด้วย ML เพื่อทำความเข้าใจเนื้อหาระดับองค์กร และอื่นๆ อีกมากมาย!

เราขอเชิญคุณมาทดลองกับ LLM ที่ได้รับการฝึกอบรมล่วงหน้าต่างๆ พร้อมใช้งานบน AWSหรือต่อยอดหรือสร้าง LLM ของคุณเองใน SageMaker แจ้งให้เราทราบคำถามและสิ่งที่คุณค้นพบในความคิดเห็น และสนุก!

เกี่ยวกับผู้แต่ง

จาร์เรตต์ โหยวซาน เว่ย เป็น Associate Cloud Architect ใน AWS Professional Services ซึ่งครอบคลุมภาครัฐทั่วอาเซียน และเป็นผู้สนับสนุนในการช่วยให้ลูกค้าปรับให้ทันสมัยและย้ายเข้าสู่ระบบคลาวด์ เขาได้รับใบรับรอง AWS ห้าใบ และยังตีพิมพ์ผลงานวิจัยเกี่ยวกับชุดเครื่องเร่งการไล่ระดับสีในการประชุมนานาชาติครั้งที่ 8 เรื่อง AI ในเวลาว่าง Jarrett มุ่งเน้นและมีส่วนร่วมในฉาก AI เชิงสร้างสรรค์ที่ AWS

จาร์เรตต์ โหยวซาน เว่ย เป็น Associate Cloud Architect ใน AWS Professional Services ซึ่งครอบคลุมภาครัฐทั่วอาเซียน และเป็นผู้สนับสนุนในการช่วยให้ลูกค้าปรับให้ทันสมัยและย้ายเข้าสู่ระบบคลาวด์ เขาได้รับใบรับรอง AWS ห้าใบ และยังตีพิมพ์ผลงานวิจัยเกี่ยวกับชุดเครื่องเร่งการไล่ระดับสีในการประชุมนานาชาติครั้งที่ 8 เรื่อง AI ในเวลาว่าง Jarrett มุ่งเน้นและมีส่วนร่วมในฉาก AI เชิงสร้างสรรค์ที่ AWS

แทมมี่ ลิม ลี ซิน เป็น Associate Cloud Architect ที่ AWS เธอใช้เทคโนโลยีเพื่อช่วยให้ลูกค้าส่งมอบผลลัพธ์ที่ต้องการในเส้นทางการนำระบบคลาวด์มาใช้ และมีความหลงใหลเกี่ยวกับ AI/ML นอกเหนือจากงาน เธอชอบท่องเที่ยว เดินป่า และใช้เวลาร่วมกับครอบครัวและเพื่อนๆ

แทมมี่ ลิม ลี ซิน เป็น Associate Cloud Architect ที่ AWS เธอใช้เทคโนโลยีเพื่อช่วยให้ลูกค้าส่งมอบผลลัพธ์ที่ต้องการในเส้นทางการนำระบบคลาวด์มาใช้ และมีความหลงใหลเกี่ยวกับ AI/ML นอกเหนือจากงาน เธอชอบท่องเที่ยว เดินป่า และใช้เวลาร่วมกับครอบครัวและเพื่อนๆ

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- $ ขึ้น

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8th

- a

- สามารถ

- เกี่ยวกับเรา

- ยอมรับ

- เข้า

- รับทราบ

- ข้าม

- เพิ่ม

- เพิ่มเติม

- การนำมาใช้

- ผู้สนับสนุน

- หลังจาก

- AI

- AI / ML

- ทั้งหมด

- ช่วยให้

- ตาม

- ด้วย

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- ขยาย

- an

- และ

- API

- การใช้งาน

- ได้รับการอนุมัติ

- สถาปัตยกรรม

- เป็น

- ศิลปะ

- เทียม

- ปัญญาประดิษฐ์

- AS

- อาเซียน

- ถาม

- สินทรัพย์

- ภาคี

- At

- บรรลุ

- การยืนยันตัวตน

- ความพร้อมใช้งาน

- ใช้ได้

- หลีกเลี่ยง

- AWS

- การก่อตัวของ AWS Cloud

- บริการระดับมืออาชีพของ AWS

- บาร์

- ฐาน

- ตาม

- ขั้นพื้นฐาน

- BE

- เพราะ

- ที่ดีที่สุด

- ปฏิบัติที่ดีที่สุด

- ดีกว่า

- การส่งเสริม

- กล่อง

- กว้าง

- เบราว์เซอร์

- สร้าง

- by

- โทรศัพท์

- โทร

- CAN

- สามารถรับ

- ความสามารถในการ

- ความสามารถ

- ถูกจับกุม

- กรณี

- การรับรอง

- การเปลี่ยนแปลง

- โหลด

- chatbots

- ChatGPT

- ทางเลือก

- Choose

- การจัดหมวดหมู่

- อย่างใกล้ชิด

- เมฆ

- การยอมรับระบบคลาวด์

- รหัส

- ความคิดเห็น

- สมบูรณ์

- การประชุม

- องค์ประกอบ

- การเชื่อมต่อ

- ปลอบใจ

- เนื้อหา

- ก่อ

- การสนทนา

- การสนทนา

- AI สนทนา

- ตรงกัน

- หน้าปก

- ครอบคลุม

- สร้าง

- ที่สร้างขึ้น

- การสร้าง

- อยากรู้อยากเห็น

- ประเพณี

- ลูกค้า

- ข้อมูล

- ลึก

- การเรียนรู้ลึก ๆ

- ค่าเริ่มต้น

- ส่งมอบ

- ทั้งนี้ขึ้นอยู่กับ

- ปรับใช้

- นำไปใช้

- ปรับใช้

- การใช้งาน

- Deploys

- ลักษณะ

- ออกแบบ

- ที่ต้องการ

- รายละเอียด

- นักพัฒนา

- ต่าง

- การจัดจำหน่าย

- ดิจิตอล

- ศิลปะดิจิตอล

- แสดง

- การกระจาย

- โดเมน

- ดาวน์โหลด

- ก่อน

- ความสะดวก

- อย่างมีประสิทธิภาพ

- ทำให้สามารถ

- ปลาย

- ปลายทาง

- เสริม

- ประเทือง

- เข้าสู่

- Enterprise

- สิ่งแวดล้อม

- แม้

- ทุกๆ

- ตัวอย่าง

- ตัวอย่าง

- คาดว่า

- แพง

- ประสบการณ์

- การทดลอง

- อธิบาย

- ขยายออก

- ขยาย

- สารสกัด

- ครอบครัว

- ลักษณะ

- สองสาม

- สาขา

- เนื้อไม่มีมัน

- สุดท้าย

- หา

- ผลการวิจัย

- ห้า

- มุ่งเน้นไปที่

- ปฏิบัติตาม

- ดังต่อไปนี้

- สำหรับ

- รูป

- อุปถัมภ์

- รากฐาน

- พื้นฐาน

- ฟรี

- เพื่อน

- ราคาเริ่มต้นที่

- อย่างเต็มที่

- ฟังก์ชัน

- ต่อไป

- อนาคต

- General

- ข้อมูลร่วม

- การสร้าง

- กำเนิด

- กำเนิด AI

- ได้รับ

- จะช่วยให้

- เป้าหมาย

- มี

- he

- ช่วย

- การช่วยเหลือ

- ของเขา

- ถือ

- โฮสติ้ง

- ชั่วโมง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- ที่ http

- HTTPS

- มนุษย์

- ร้อย

- ความคิด

- เอกลักษณ์

- if

- ภาพ

- จินตนาการ

- การดำเนินการ

- การปรับปรุง

- in

- ประกอบด้วย

- เพิ่ม

- แสดงว่า

- อินพุต

- ติดตั้ง

- การติดตั้ง

- การติดตั้ง

- ตัวอย่าง

- สถาบัน

- คำแนะนำการใช้

- รวบรวม

- การผสานรวม

- Intelligence

- ฉลาด

- โต้ตอบ

- การมีปฏิสัมพันธ์

- ปฏิสัมพันธ์

- อินเตอร์เฟซ

- International

- เข้าไป

- เชิญ

- ITS

- การเดินทาง

- jpg

- เพียงแค่

- แค่หนึ่ง

- คีย์

- ทราบ

- ความรู้

- ภาษา

- ใหญ่

- เปิดตัว

- การเปิดตัว

- การเรียนรู้

- Lee

- ให้

- กดไลก์

- Line

- ดูรายละเอียด

- LLM

- ในประเทศ

- ตรรกะ

- ดู

- ดูเหมือน

- รัก

- เครื่อง

- เรียนรู้เครื่อง

- การจัดการ

- ลักษณะ

- อาจ..

- หมายความว่า

- ภาพบรรยากาศ

- พบ

- เมนู

- วิธี

- อพยพ

- ML

- โหมด

- แบบ

- โมเดล

- ทันสมัย

- ข้อมูลเพิ่มเติม

- หลาย

- ต้อง

- ชื่อ

- นำทาง

- การเดินเรือ

- จำเป็น

- จำเป็นต้อง

- เครือข่าย

- เกี่ยวกับประสาท

- เครือข่ายประสาท

- ใหม่

- ผลิตภัณฑ์ใหม่

- ใหม่

- ปม

- Node.js

- หมายเหตุ

- สมุดบันทึก

- ที่ได้รับ

- of

- on

- ONE

- เปิด

- โอเพนซอร์ส

- Options

- or

- อื่นๆ

- ผลลัพธ์

- เอาท์พุต

- ด้านนอก

- ภาพรวม

- ของตนเอง

- หน้า

- บานหน้าต่าง

- กระดาษ

- พารามิเตอร์

- พารามิเตอร์

- หลงใหล

- สิทธิ์

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เสียบเข้าไป

- ยอดนิยม

- ความนิยม

- โพสต์

- ขับเคลื่อน

- การปฏิบัติ

- ที่ต้องการ

- ข้อกำหนดเบื้องต้น

- สิทธิ์

- กระบวนการ

- ผลิตภัณฑ์

- มืออาชีพ

- โครงการ

- เป็นเจ้าของ

- ให้

- ให้

- ผู้ให้บริการ

- ให้

- สาธารณะ

- การตีพิมพ์

- หลาม

- คำถาม

- รวดเร็ว

- อย่างรวดเร็ว

- ยก

- พิสัย

- จริง

- อ้างอิง

- การอ้างอิง

- ตรงประเด็น

- ขอ

- การร้องขอ

- จำเป็นต้องใช้

- การวิจัย

- คล้าย

- แหล่งข้อมูล

- คำตอบ

- กลับ

- ขึ้น

- วิ่ง

- sagemaker

- ความพอใจ

- ฉาก

- รอยขีดข่วน

- ภาพหน้าจอ

- ค้นหา

- ลับ

- Section

- ภาค

- เห็น

- เลือก

- ความรู้สึก

- ให้บริการ

- บริการ

- บริการ

- ชุด

- ชุดอุปกรณ์

- การติดตั้ง

- Share

- เธอ

- น่า

- โชว์

- แสดงให้เห็นว่า

- เศษเล็กเศษน้อย

- ทางออก

- บาง

- แหล่ง

- การใช้จ่าย

- มั่นคง

- กอง

- มาตรฐาน

- Stanford

- เริ่มต้น

- ข้อความที่เริ่ม

- Status

- ขั้นตอน

- ขั้นตอน

- การเก็บรักษา

- สตูดิโอ

- อย่างเช่น

- เพียงพอ

- เอา

- ใช้เวลา

- เทคโนโลยี

- เทมเพลต

- สถานีปลายทาง

- ทดสอบ

- ข้อความ

- การจัดประเภทข้อความ

- ที่

- พื้นที่

- ของพวกเขา

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- ของบุคคลที่สาม

- นี้

- แต่?

- ตลอด

- เวลา

- ไปยัง

- ด้านบน

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- แปลง

- การแปลง

- เปลี่ยน

- ชนิด

- ui

- ภายใต้

- ความเข้าใจ

- URL

- us

- การใช้

- ใช้

- ผู้ใช้งาน

- ประสบการณ์ของผู้ใช้

- ส่วนติดต่อผู้ใช้

- ที่ใช้งานง่าย

- ผู้ใช้

- ใช้

- การใช้

- ความคุ้มค่า

- ต่างๆ

- วิดีโอ

- เดิน

- เดิน

- วิธี

- we

- เว็บ

- บริการเว็บ

- อะไร

- เมื่อ

- ที่

- WHO

- กว้าง

- ช่วงกว้าง

- จะ

- ต้องการ

- กับ

- งาน

- เวิร์กโฟลว์

- เขียน

- Yeo

- คุณ

- ของคุณ

- ลมทะเล