การตรวจจับอคติในผลลัพธ์ของข้อมูลและแบบจำลองเป็นข้อกำหนดพื้นฐานสำหรับการสร้างปัญญาประดิษฐ์ (AI) และโมเดลการเรียนรู้ของเครื่อง (ML) ที่มีความรับผิดชอบ น่าเสียดายที่การตรวจจับอคติไม่ใช่เรื่องง่ายสำหรับผู้ปฏิบัติงานส่วนใหญ่ เนื่องจากมีวิธีการมากมายที่สามารถวัดผลได้และปัจจัยต่างๆ ที่สามารถนำไปสู่ผลลัพธ์ที่มีอคติได้ ตัวอย่างเช่น การสุ่มตัวอย่างข้อมูลการฝึกอบรมที่ไม่สมดุลอาจส่งผลให้แบบจำลองมีความแม่นยำน้อยลงสำหรับข้อมูลบางส่วน อัลกอริธึม ML อาจแนะนำอคติได้ แม้จะมีชุดข้อมูลการฝึกอบรมที่สมดุล ผลลัพธ์ก็อาจเป็นประโยชน์กับชุดย่อยของข้อมูลบางชุดเมื่อเทียบกับชุดข้อมูลอื่นๆ

ในการตรวจจับอคติ คุณต้องมีความเข้าใจอย่างถ่องแท้เกี่ยวกับอคติประเภทต่างๆ และอคติที่เกี่ยวข้อง ตัวชี้วัดอคติ. ตัวอย่างเช่น ในขณะที่เขียนบทความนี้ Amazon SageMaker ชี้แจง มีเมตริกให้เลือกถึง 21 เมตริก

ในโพสต์นี้ เราใช้กรณีการใช้งานการคาดการณ์รายได้ (คาดการณ์รายได้ของผู้ใช้จากคุณสมบัติอินพุต เช่น การศึกษาและจำนวนชั่วโมงทำงานต่อสัปดาห์) เพื่อแสดงอคติประเภทต่างๆ และเมตริกที่เกี่ยวข้องใน SageMaker Clarify เรายังพัฒนากรอบงานเพื่อช่วยคุณตัดสินใจว่าตัวชี้วัดใดมีความสำคัญสำหรับแอปพลิเคชันของคุณ

ข้อมูลเบื้องต้นเกี่ยวกับ SageMaker Clarify

มีการใช้แบบจำลอง ML มากขึ้นเรื่อยๆ เพื่อช่วยในการตัดสินใจในขอบเขตต่างๆ เช่น บริการทางการเงิน การดูแลสุขภาพ การศึกษา และทรัพยากรบุคคล ในหลาย ๆ สถานการณ์ สิ่งสำคัญคือต้องทำความเข้าใจว่าเหตุใดโมเดล ML จึงคาดการณ์เฉพาะและดูว่าการคาดการณ์ได้รับผลกระทบจากอคติหรือไม่

SageMaker Clarify มีเครื่องมือสำหรับความต้องการทั้งสองนี้ แต่ในโพสต์นี้ เราเน้นที่ฟังก์ชันการตรวจจับอคติเท่านั้น หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับการอธิบายได้ โปรดดูที่ อธิบายข้อมูลการแข่งขันบุนเดสลีกา xGoals โดยใช้ Amazon SageMaker Clarify.

SageMaker Clarify เป็นส่วนหนึ่งของ อเมซอน SageMakerซึ่งเป็นบริการที่มีการจัดการเต็มรูปแบบเพื่อสร้าง ฝึกฝน และปรับใช้โมเดล ML

ตัวอย่างคำถามเกี่ยวกับอคติ

เพื่อเป็นพื้นฐานในการอภิปราย ต่อไปนี้คือคำถามตัวอย่างบางส่วนที่ผู้สร้าง ML และผู้มีส่วนได้ส่วนเสียอาจมีเกี่ยวกับอคติ รายการนี้ประกอบด้วยคำถามทั่วไปที่อาจเกี่ยวข้องกับแอปพลิเคชัน ML หลายรายการ รวมถึงคำถามเกี่ยวกับแอปพลิเคชันเฉพาะ เช่น การดึงเอกสาร

คุณอาจถามในกลุ่มที่สนใจในข้อมูลการฝึกอบรม (เช่น ผู้ชายกับผู้หญิง) ฉันควรใช้เมตริกใดเพื่อตอบคำถามต่อไปนี้

- การแสดงกลุ่มในข้อมูลการฝึกอบรมสะท้อนถึงโลกแห่งความเป็นจริงหรือไม่?

- ป้ายกำกับเป้าหมายในข้อมูลการฝึกชอบกลุ่มหนึ่งมากกว่ากลุ่มอื่นโดยกำหนดป้ายกำกับเชิงบวกมากกว่าหรือไม่

- โมเดลมีความแม่นยำต่างกันสำหรับกลุ่มต่างๆ หรือไม่?

- ในรูปแบบที่มีจุดประสงค์เพื่อระบุผู้สมัครที่มีคุณสมบัติเหมาะสมสำหรับการจ้างงาน โมเดลนั้นมีความแม่นยำเหมือนกันสำหรับกลุ่มต่างๆ หรือไม่?

- ในตัวแบบที่มีจุดประสงค์เพื่อดึงเอกสารที่เกี่ยวข้องกับการสืบค้นข้อมูล ตัวแบบดึงเอกสารที่เกี่ยวข้องจากกลุ่มต่างๆ ในสัดส่วนที่เท่ากันหรือไม่

ในส่วนที่เหลือของโพสต์นี้ เราพัฒนากรอบการทำงานสำหรับการพิจารณาตอบคำถามเหล่านี้และอื่นๆ ผ่านเมตริกที่มีอยู่ใน SageMaker Clarify

ใช้กรณีและบริบท

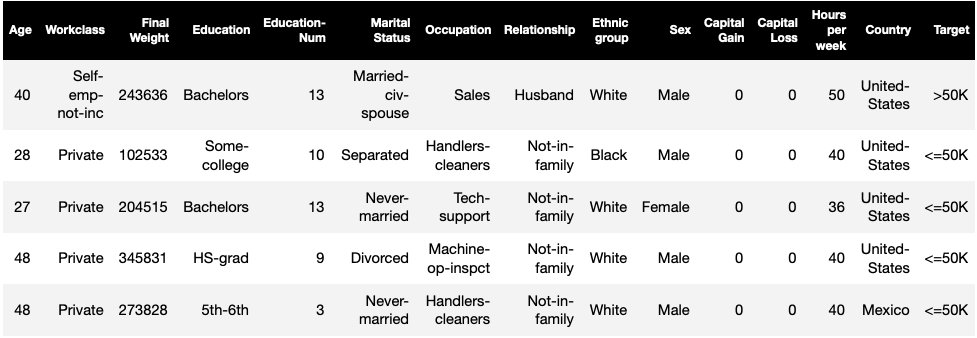

โพสต์นี้ใช้ตัวอย่างที่มีอยู่ของงาน SageMaker Clarify จาก ความเป็นธรรมและการอธิบายได้ด้วยโน้ตบุ๊ค SageMaker Clarify และอธิบายค่าเมตริกอคติที่สร้างขึ้น โน้ตบุ๊กฝึกโมเดล XGBoost บน UCI ชุดข้อมูลสำหรับผู้ใหญ่ (Dua, D. และ Graff, C. (2019). พื้นที่เก็บข้อมูลการเรียนรู้ของเครื่อง UCI. Irvine, CA: University of California, School of Information and Computer Science)

งาน ML ในชุดข้อมูลนี้คือการคาดการณ์ว่าบุคคลมีรายได้ต่อปีมากกว่าหรือน้อยกว่า 50,000 ดอลลาร์หรือไม่ ตารางต่อไปนี้แสดงบางอินสแตนซ์พร้อมกับคุณลักษณะ การวัดอคติในการคาดการณ์รายได้มีความสำคัญ เนื่องจากเราสามารถใช้การคาดการณ์เหล่านี้เพื่อแจ้งการตัดสินใจ เช่น ข้อเสนอส่วนลดและการตลาดที่ตรงเป้าหมาย

คำศัพท์อคติ

ก่อนดำดิ่งลึก เรามาทบทวนคำศัพท์ที่จำเป็นกันก่อน สำหรับรายการคำศัพท์ทั้งหมด โปรดดูที่ Amazon SageMaker ชี้แจงข้อกำหนดสำหรับอคติและความเป็นธรรม.

- ฉลาก – คุณลักษณะเป้าหมายที่โมเดล ML ได้รับการฝึกฝนให้คาดการณ์ หนึ่ง สังเกตฉลาก หมายถึงค่าฉลากที่สังเกตพบในข้อมูลที่ใช้ในการฝึกหรือทดสอบแบบจำลอง อา ป้ายคาดคะเน คือค่าที่คาดการณ์โดยโมเดล ML ป้ายกำกับอาจเป็นเลขฐานสอง และมักเข้ารหัสเป็น 0 และ 1 เราถือว่า 1 หมายถึงป้ายกำกับที่ดีหรือเป็นบวก (เช่น รายได้มากกว่าหรือเท่ากับ 50,000 ดอลลาร์) และ 0 เพื่อแสดงถึงป้ายกำกับที่ไม่เอื้ออำนวยหรือเชิงลบ ป้ายกำกับอาจประกอบด้วยค่ามากกว่าสองค่า แม้แต่ในกรณีเหล่านี้ ค่าหนึ่งค่าหรือมากกว่านั้นถือเป็นป้ายกำกับที่ดี เพื่อความเรียบง่าย โพสต์นี้จะพิจารณาเฉพาะป้ายกำกับไบนารีเท่านั้น สำหรับรายละเอียดเกี่ยวกับการจัดการฉลากที่มีค่ามากกว่าสองค่า และฉลากที่มีค่าต่อเนื่อง (เช่น ในการถดถอย) โปรดดูที่ เอกสารรายงานความเป็นธรรมและอธิบายได้ของ Amazon AI.

- ด้าน – คอลัมน์หรือคุณลักษณะที่เกี่ยวข้องกับการวัดอคติ ในตัวอย่างของเรา ด้านคือ

sexและรับสองค่า:womanและman, เข้ารหัสเป็นfemaleและmaleในข้อมูล (ข้อมูลนี้ดึงมาจากการสำรวจสำมะโนประชากรปี 1994 และบังคับใช้ตัวเลือกไบนารี) แม้ว่าโพสต์จะพิจารณาด้านเดียวที่มีค่าเพียงสองค่า สำหรับกรณีที่ซับซ้อนมากขึ้นซึ่งเกี่ยวข้องกับหลายแง่มุมหรือแง่มุมที่มีค่ามากกว่าสองค่า โปรดดู เอกสารรายงานความเป็นธรรมและอธิบายได้ของ Amazon AI. - อคติ – ความไม่สมดุลอย่างมีนัยสำคัญในข้อมูลที่ป้อนเข้าหรือการทำนายแบบจำลองในค่าด้านต่างๆ สิ่งที่ถือว่า "สำคัญ" ขึ้นอยู่กับการสมัครของคุณ สำหรับเมตริกส่วนใหญ่ ค่า 0 หมายถึงไม่มีความไม่สมดุล ตัวชี้วัดอคติใน SageMaker Clarify แบ่งออกเป็นสองประเภท:

- การเตรียมการ – เมื่อมีอคติก่อนการฝึกอบรมบ่งชี้ความไม่สมดุลในข้อมูลเท่านั้น

- หลังการฝึก – ความเอนเอียงหลังการฝึกจะพิจารณาการคาดคะเนของแบบจำลองเพิ่มเติมด้วย

ลองตรวจสอบแต่ละหมวดหมู่แยกกัน

อคติก่อนการฝึกอบรม

การเตรียมเมตริกอคติล่วงหน้าใน SageMaker Clarify ตอบคำถามต่อไปนี้: ค่าของแง่มุมทั้งหมดมีการแทนค่าเท่ากัน (หรือคล้ายกัน) ในข้อมูลหรือไม่ การตรวจสอบข้อมูลสำหรับอคติก่อนการฝึกอบรมเป็นสิ่งสำคัญ เนื่องจากอาจแปลเป็นอคติหลังการฝึกในการทำนายแบบจำลอง ตัวอย่างเช่น แบบจำลองที่ได้รับการฝึกฝนเกี่ยวกับข้อมูลที่ไม่สมดุล โดยที่ค่าของ facet หนึ่งปรากฏน้อยมาก จะแสดงความแม่นยำที่แย่กว่านั้นอย่างมากสำหรับค่าของ facet นั้น การแทนค่าที่เท่ากันสามารถคำนวณได้ดังต่อไปนี้:

- ข้อมูลการฝึกอบรมทั้งหมดโดยไม่คำนึงถึงฉลาก

- ชุดย่อยของข้อมูลการฝึกที่มีป้ายกำกับเชิงบวกเท่านั้น

- แต่ละป้ายแยกกัน

รูปภาพต่อไปนี้แสดงข้อมูลสรุปว่าแต่ละเมตริกเหมาะกับแต่ละหมวดหมู่อย่างไร

บางหมวดหมู่ประกอบด้วยมากกว่าหนึ่งเมตริก ตัวชี้วัดพื้นฐาน (กล่องสีเทา) ตอบคำถามเกี่ยวกับอคติในหมวดหมู่นั้นในรูปแบบที่ง่ายที่สุด เมตริกในกล่องสีขาวยังครอบคลุมกรณีพิเศษ (เช่น ความขัดแย้งของซิมป์สัน) และความชอบของผู้ใช้ (เช่น การเน้นที่บางส่วนของประชากรเมื่อคำนวณประสิทธิภาพการคาดการณ์)

การแสดงมูลค่าด้านโดยไม่คำนึงถึงฉลาก

เมตริกเดียวในหมวดหมู่นี้คือ Class Imbalance (CI) เป้าหมายของการวัดนี้คือการวัดว่าค่าของ facet ทั้งหมดมีการแทนค่าเท่ากันในข้อมูลหรือไม่

CI คือผลต่างในเศษส่วนของข้อมูลที่ประกอบด้วยค่าด้านสองค่า ในชุดข้อมูลตัวอย่างของเรา สำหรับ facet sexการแจกแจง (แสดงในแผนภูมิวงกลม) แสดงให้เห็นว่าผู้หญิงคิดเป็น 32.4% ของข้อมูลการฝึก ในขณะที่ผู้ชายคิดเป็น 67.6% ผลที่ตามมา:

CI = 0.676 - 0.324 = 0.352

ความไม่สมดุลระดับสูงอย่างร้ายแรงอาจนำไปสู่ประสิทธิภาพการคาดการณ์ที่แย่ลงสำหรับค่า facet ด้วยการแสดงที่น้อยกว่า

การแสดงมูลค่าของแฟ็กต์ที่ระดับของป้ายกำกับเชิงบวกเท่านั้น

อีกวิธีหนึ่งในการวัดค่าการแทนค่าที่เท่ากันคือตรวจสอบว่าค่าของ facet ทั้งหมดมีเศษส่วนของตัวอย่างที่คล้ายคลึงกันซึ่งมีฉลากที่สังเกตพบเป็นบวกหรือไม่ ป้ายกำกับเชิงบวกประกอบด้วยผลลัพธ์ที่น่าพอใจ (เช่น อนุมัติเงินกู้ เลือกสำหรับงาน) ดังนั้นการวิเคราะห์ป้ายกำกับเชิงบวกแยกกันจะช่วยประเมินว่าการตัดสินใจที่น่าพอใจมีการกระจายอย่างเท่าเทียมกันหรือไม่

ในชุดข้อมูลตัวอย่างของเรา ป้ายกำกับที่สังเกตพบจะแบ่งออกเป็นค่าบวกและค่าลบ ดังแสดงในรูปต่อไปนี้

11.4% ของผู้หญิงทั้งหมดและ 31.4% ของผู้ชายทั้งหมดมีป้ายกำกับในเชิงบวก (บริเวณสีเทาเข้มในแถบด้านซ้ายและขวา) The Difference in Positive Proportions in Labels (DPL) วัดความแตกต่างนี้

DPL = 0.314 - 0.114 = 0.20

เมตริกขั้นสูงในหมวดหมู่นี้ Conditional Demographic Disparity in Labels (CDDL) จะวัดความแตกต่างในป้ายกำกับเชิงบวก แต่จะแบ่งชั้นตามตัวแปรอื่น เมตริกนี้ช่วยควบคุม for ความขัดแย้งของซิมป์สันกรณีที่มีการคำนวณข้อมูลทั้งหมดแสดงความลำเอียง แต่ความลำเอียงจะหายไปเมื่อจัดกลุ่มข้อมูลโดยคำนึงถึงข้อมูลข้างเคียงบางอย่าง

พื้นที่ 1973 การศึกษาการรับเข้าเรียนของ UC Berkeley ให้ตัวอย่าง จากข้อมูลพบว่าผู้ชายเข้ารับการรักษาในอัตราที่สูงกว่าผู้หญิง อย่างไรก็ตาม เมื่อสอบในระดับหน่วยงานของมหาวิทยาลัยแต่ละแห่ง ผู้หญิงก็เข้ารับการรักษาในอัตราที่ใกล้เคียงกันหรือสูงกว่าในแต่ละแผนก ข้อสังเกตนี้สามารถอธิบายได้ด้วยความขัดแย้งของซิมป์สัน ซึ่งเกิดขึ้นที่นี่เพราะผู้หญิงสมัครเข้าเรียนในโรงเรียนที่มีการแข่งขันสูงกว่า ด้วยเหตุนี้ ผู้หญิงจึงเข้ารับการรักษาโดยรวมน้อยลงเมื่อเทียบกับผู้ชาย แม้ว่าโรงเรียนจะรับเข้าเรียนในอัตราที่ใกล้เคียงกันหรือสูงกว่าก็ตาม

สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีการคำนวณ CDDL โปรดดูที่ เอกสารรายงานความเป็นธรรมและอธิบายได้ของ Amazon AI.

การแสดงค่า facet ที่ระดับของแต่ละป้ายแยกกัน

นอกจากนี้ยังสามารถวัดความเท่าเทียมกันในการแสดงสำหรับป้ายกำกับแต่ละรายการ ไม่ใช่แค่ป้ายกำกับเชิงบวกเท่านั้น

เมตริกในหมวดหมู่นี้คำนวณความแตกต่างในการกระจายป้ายกำกับของค่าด้านต่างๆ การกระจายฉลากสำหรับค่า facet จะประกอบด้วยค่าฉลากที่สังเกตได้ทั้งหมด พร้อมด้วยเศษส่วนของตัวอย่างที่มีค่าของฉลากนั้น ตัวอย่างเช่น ในรูปที่แสดงการแจกแจงฉลาก ผู้หญิง 88.6% มีการสังเกตฉลากเป็นลบ และ 11.4% มีการสังเกตฉลากเป็นบวก ดังนั้นการแจกแจงฉลากสำหรับผู้หญิงคือ [0.886, 0.114] และสำหรับผู้ชายคือ [0.686, 0.314]

ตัวชี้วัดพื้นฐานในหมวดหมู่นี้ Kullback-Leibler divergence (KL) วัดความแตกต่างนี้เป็น:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

ตัววัดขั้นสูงในหมวดหมู่นี้ Jensen-Shannon divergence (JS), Lp-norm (LP), Total Variation Distance (TVD) และ Kolmogorov-Smirnov (KS) ยังวัดความแตกต่างระหว่างการแจกแจงแต่มีคุณสมบัติทางคณิตศาสตร์ต่างกัน ยกเว้นกรณีพิเศษ พวกเขาจะให้ข้อมูลเชิงลึกที่คล้ายกับ KL ตัวอย่างเช่น แม้ว่าค่า KL สามารถเป็นอนันต์ได้เมื่อค่า facet ไม่มีตัวอย่างที่มีป้ายกำกับที่แน่นอน (เช่น ไม่มีผู้ชายที่มีป้ายกำกับเชิงลบ) JS จะหลีกเลี่ยงค่าอนันต์เหล่านี้ สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับความแตกต่างเหล่านี้ โปรดดูที่ เอกสารรายงานความเป็นธรรมและอธิบายได้ของ Amazon AI.

ความสัมพันธ์ระหว่าง DPL (หมวด 2) และการวัดตามการแจกจ่ายของ KL/JS/LP/TVD/KS (หมวด 3)

เมตริกตามการแจกจ่ายจะใช้ได้กับป้ายกำกับที่ไม่ใช่ไบนารีอย่างเป็นธรรมชาติมากขึ้น สำหรับป้ายกำกับไบนารี เนื่องจากความไม่สมดุลในป้ายกำกับเชิงบวกสามารถใช้ในการคำนวณความไม่สมดุลในป้ายกำกับเชิงลบ เมตริกการแจกจ่ายจึงให้ข้อมูลเชิงลึกเช่นเดียวกับ DPL ดังนั้น คุณสามารถใช้ DPL ในกรณีดังกล่าวได้

อคติหลังการฝึก

การวัดอคติหลังการฝึกใน SageMaker Clarify ช่วยให้เราตอบคำถามสำคัญสองข้อ:

- ค่าของ facet ทั้งหมดแสดงในอัตราที่ใกล้เคียงกันในการทำนายแบบจำลองเชิงบวก (ดี) หรือไม่?

- โมเดลมีประสิทธิภาพการคาดการณ์ที่คล้ายคลึงกันสำหรับค่า facet ทั้งหมดหรือไม่

รูปภาพต่อไปนี้แสดงให้เห็นว่าเมตริกจับคู่กับคำถามแต่ละข้ออย่างไร คำถามที่สองสามารถแบ่งย่อยเพิ่มเติมได้ขึ้นอยู่กับป้ายกำกับที่วัดประสิทธิภาพด้วยความเคารพ

การเป็นตัวแทนที่เท่าเทียมกันในการทำนายแบบจำลองเชิงบวก

เมตริกในหมวดหมู่นี้จะตรวจสอบว่าค่าของ facet ทั้งหมดมีเศษส่วนที่คล้ายกันของตัวอย่างที่มีป้ายกำกับที่คาดการณ์ในเชิงบวกโดยโมเดลหรือไม่ เมตริกคลาสนี้คล้ายกับเมตริกก่อนการฝึกของ DPL และ CDDL มาก ข้อแตกต่างเพียงอย่างเดียวคือหมวดหมู่นี้พิจารณาป้ายกำกับที่คาดคะเนแทนที่จะเป็นป้ายกำกับที่สังเกต

ในชุดข้อมูลตัวอย่างของเรา 4.5% ของผู้หญิงทั้งหมดได้รับป้ายกำกับเชิงบวกโดยนางแบบ และ 13.7% ของผู้ชายทั้งหมดได้รับป้ายกำกับเชิงบวก

เมตริกพื้นฐานในหมวดหมู่นี้ ความแตกต่างในสัดส่วนเชิงบวกในป้ายกำกับที่คาดการณ์ (DPPL) จะวัดความแตกต่างในการมอบหมายคลาสเชิงบวก

DPPL = 0.137 - 0.045 = 0.092

สังเกตว่าในข้อมูลการฝึกอบรม ผู้ชายที่สูงขึ้นมีป้ายกำกับที่สังเกตได้ในเชิงบวกอย่างไร ในทำนองเดียวกัน ผู้ชายจำนวนมากขึ้นจะได้รับป้ายกำกับที่คาดการณ์ในเชิงบวก

การย้ายไปยังเมตริกขั้นสูงในหมวดหมู่นี้ Disparate Impact (DI) จะวัดความเหลื่อมล้ำเดียวกันในการมอบหมายคลาสเชิงบวก แต่แทนที่จะคำนวณความแตกต่าง จะคำนวณอัตราส่วน:

DI = 0.045 / 0.137 = 0.328

ทั้ง DI และ DPPL ให้ข้อมูลเชิงลึกที่คล้ายคลึงกันในเชิงคุณภาพ แต่แตกต่างกันในบางกรณี ตัวอย่างเช่น อัตราส่วนมีแนวโน้มที่จะระเบิดเป็นจำนวนที่มากถ้าตัวส่วนมีขนาดเล็ก ยกตัวอย่างตัวเลข 0.1 และ 0.0001 อัตราส่วนคือ 0.1/0.0001 = 10,000 ในขณะที่ความแตกต่างคือ 0.1 – 0.0001 ≈ 0.1 ไม่เหมือนกับเมตริกอื่นๆ ที่ค่า 0 หมายถึงไม่มีอคติ สำหรับ DI ไม่มีอคติที่สอดคล้องกับค่า 1

Conditional Demographic Disparity in Predicted Labels (CDDPL) จะวัดความเหลื่อมล้ำในการแทนค่า facet ใน label ที่เป็นค่าบวก แต่เช่นเดียวกับเมตริก pretraining ของ CDDL ก็ควบคุมสำหรับ Paradox ของ Simpson ด้วย

Counterfactual Fliptest (FT) จะวัดว่าตัวอย่างที่คล้ายกันจากค่าสองด้านได้รับการตัดสินใจที่คล้ายคลึงกันจากแบบจำลองหรือไม่ แบบจำลองที่กำหนดการตัดสินใจที่แตกต่างกันให้กับตัวอย่างสองตัวอย่างที่เหมือนกันแต่ต่างกันในค่าด้านอาจถือว่ามีความเอนเอียงกับค่าด้านที่กำหนดป้ายกำกับที่ไม่เอื้ออำนวย (เชิงลบ) เมื่อพิจารณาจากมูลค่าด้านแรก (ผู้หญิง) จะประเมินว่าสมาชิกที่คล้ายคลึงกันซึ่งมีมูลค่าด้านอื่น (ผู้ชาย) มีการทำนายแบบจำลองที่แตกต่างกันหรือไม่ สมาชิกที่คล้ายกันจะถูกเลือกตามอัลกอริทึมเพื่อนบ้านที่ใกล้ที่สุด k

ประสิทธิภาพที่เท่าเทียมกัน

การคาดคะเนแบบจำลองอาจมีการแสดงที่คล้ายกันในป้ายกำกับเชิงบวกจากค่าด้านที่ต่างกัน แต่ประสิทธิภาพของแบบจำลองในกลุ่มเหล่านี้อาจแตกต่างกันอย่างมีนัยสำคัญ ในหลาย ๆ แอปพลิเคชัน การมีประสิทธิภาพการคาดการณ์ที่คล้ายคลึงกันในค่าด้านต่างๆ เป็นสิ่งที่พึงปรารถนา เมตริกในหมวดหมู่นี้วัดความแตกต่างในประสิทธิภาพการคาดการณ์ในค่าด้านต่างๆ

เนื่องจากข้อมูลสามารถแบ่งได้หลายวิธีตามป้ายกำกับที่สังเกตหรือคาดการณ์ จึงมีหลายวิธีในการวัดประสิทธิภาพการคาดการณ์

ประสิทธิภาพการทำนายที่เท่าเทียมกันโดยไม่คำนึงถึงฉลาก

คุณสามารถพิจารณาประสิทธิภาพของแบบจำลองในข้อมูลทั้งหมด โดยไม่คำนึงถึงฉลากที่สังเกตได้หรือที่คาดการณ์ไว้ นั่นคือความแม่นยำโดยรวม

รูปต่อไปนี้แสดงวิธีที่โมเดลจำแนกอินพุตจากค่าสองด้านในชุดข้อมูลตัวอย่างของเรา True negatives (TN) คือกรณีที่ทั้งป้ายกำกับที่สังเกตและคาดการณ์ไว้เป็น 0 ผลบวกที่ผิดพลาด (FP) คือการจัดประเภทที่ไม่ถูกต้องโดยที่ป้ายกำกับที่สังเกตพบคือ 0 แต่ป้ายกำกับที่คาดการณ์ไว้คือ 1 ค่าบวกที่แท้จริง (TP) และค่าลบเท็จ (FN) ถูกกำหนด ในทำนองเดียวกัน

|

|

สำหรับแต่ละค่าของ facet ประสิทธิภาพของแบบจำลองโดยรวม กล่าวคือ ความถูกต้องสำหรับค่า facet นั้นคือ:

ความถูกต้อง = (TN + TP🇧🇷TN + FP + FN + TP)

ด้วยสูตรนี้ ความแม่นยำสำหรับผู้หญิงคือ 0.930 และสำหรับผู้ชายคือ 0.815 สิ่งนี้นำไปสู่ตัวชี้วัดเดียวในหมวดหมู่นี้ ความแตกต่างของความแม่นยำ (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 หมายความว่า ความแม่นยำของทั้งสองกลุ่มเท่ากัน ค่าที่มากขึ้น (บวกหรือลบ) บ่งบอกถึงความแตกต่างที่มากขึ้นในด้านความแม่นยำ

ประสิทธิภาพที่เท่าเทียมกันบนฉลากเชิงบวกเท่านั้น

คุณสามารถจำกัดการวิเคราะห์ประสิทธิภาพของแบบจำลองได้เฉพาะป้ายกำกับเชิงบวกเท่านั้น ตัวอย่างเช่น หากแอปพลิเคชันเกี่ยวกับการตรวจจับข้อบกพร่องในสายการประกอบ ขอแนะนำให้ตรวจสอบว่าชิ้นส่วนที่ไม่มีข้อบกพร่อง (ฉลากบวก) ประเภทต่างๆ (ค่าด้าน) ได้รับการจัดประเภทว่าไม่มีข้อบกพร่องในอัตราเดียวกัน ปริมาณนี้เรียกว่าการเรียกคืนหรืออัตราบวกที่แท้จริง:

จำ = TP / (TP + FN)

ในชุดข้อมูลตัวอย่างของเรา การเรียกคืนสำหรับผู้หญิงคือ 0.389 และการเรียกคืนสำหรับผู้ชายคือ 0.425 สิ่งนี้นำไปสู่ตัวชี้วัดพื้นฐานในหมวดหมู่นี้ ความแตกต่างของการเรียกคืน (RD):

RD = 0.425 - 0.389 = 0.036

ตอนนี้ มาพิจารณาเมตริกขั้นสูงสามรายการในหมวดหมู่นี้ ดูว่าผู้ใช้เข้ารหัสกำหนดการตั้งค่าใด และแตกต่างจากเมตริกพื้นฐานของ RD อย่างไร

อันดับแรก แทนที่จะวัดประสิทธิภาพบนฉลากที่สังเกตพบในเชิงบวก คุณสามารถวัดบนฉลากที่คาดการณ์ในเชิงบวกได้ เมื่อพิจารณาจากมูลค่าด้าน เช่น ผู้หญิง และกลุ่มตัวอย่างทั้งหมดที่มีค่าด้านนั้นที่คาดการณ์ว่าเป็นค่าบวกโดยแบบจำลอง มีกี่กลุ่มที่จัดประเภทเป็นค่าบวกได้อย่างถูกต้อง ปริมาณนี้เรียกว่าอัตราการยอมรับ (AR) หรือความแม่นยำ:

AR = TP / (TP + FP)

ในตัวอย่างของเรา AR สำหรับผู้หญิงคือ 0.977 และ AR สำหรับผู้ชายคือ 0.970 สิ่งนี้นำไปสู่ความแตกต่างในอัตราการยอมรับ (DAR):

DAR = 0.970 - 0.977 = -0.007

อีกวิธีหนึ่งในการวัดอคติคือการรวมเมตริกสองรายการก่อนหน้านี้และวัดจำนวนการคาดการณ์เชิงบวกที่แบบจำลองกำหนดให้กับค่าด้านเมื่อเปรียบเทียบกับป้ายกำกับเชิงบวกที่สังเกตพบ SageMaker Clarify วัดความได้เปรียบนี้โดยแบบจำลองเป็นอัตราส่วนระหว่างจำนวนของป้ายกำกับเชิงบวกที่สังเกตพบสำหรับค่าด้านนั้น กับจำนวนป้ายกำกับเชิงบวกที่คาดการณ์ และอ้างถึงเป็นการยอมรับตามเงื่อนไข (CA):

CA = (TP + FN🇧🇷TP + FP)

ในตัวอย่างของเรา CA สำหรับผู้หญิงคือ 2.510 และสำหรับผู้ชายคือ 2.283 ความแตกต่างใน CA นำไปสู่ตัวชี้วัดสุดท้ายในหมวดหมู่นี้ ความแตกต่างในการยอมรับแบบมีเงื่อนไข (DCA):

DCA = 2.283 - 2.510 = -0.227

ประสิทธิภาพเท่ากันกับฉลากติดลบเท่านั้น

ในลักษณะที่คล้ายกับเลเบลเชิงบวก สามารถคำนวณอคติเป็นความแตกต่างของประสิทธิภาพบนเลเบลเชิงลบ การพิจารณาฉลากติดลบแยกจากกันอาจมีความสำคัญในบางแอปพลิเคชัน ตัวอย่างเช่น ในตัวอย่างการตรวจจับข้อบกพร่อง เราอาจต้องการตรวจจับชิ้นส่วนที่บกพร่อง (ฉลากติดลบ) ประเภทต่างๆ (ค่าด้าน) ในอัตราเดียวกัน

เมตริกพื้นฐานในหมวดหมู่นี้ ความจำเพาะ คล้ายคลึงกับเมตริกการเรียกคืน (อัตราการบวกที่แท้จริง) ความจำเพาะจะคำนวณความถูกต้องของแบบจำลองบนตัวอย่างด้วยค่าด้านนี้มีฉลากติดลบที่สังเกตพบ:

ความจำเพาะ = TN / (TN + FP)

ในตัวอย่างของเรา (ดูตารางความสับสน) ความจำเพาะสำหรับผู้หญิงและผู้ชายคือ 0.999 และ 0.994 ตามลำดับ ดังนั้น ความแตกต่างของความจำเพาะ (SD) คือ:

SD = 0.994 - 0.999 = -0.005

ก้าวต่อไป เช่นเดียวกับเมตริกอัตราการยอมรับ ปริมาณที่คล้ายคลึงกันสำหรับป้ายกำกับเชิงลบ—อัตราการปฏิเสธ (RR)—คือ:

RR = TN / (TN + FN)

RR สำหรับผู้หญิงคือ 0.927 และสำหรับผู้ชายคือ 0.791 ซึ่งนำไปสู่ตัวชี้วัดความแตกต่างของอัตราการปฏิเสธ (DRR):

DRR = 0.927 - 0.791 = -0.136

สุดท้าย อะนาล็อกฉลากเชิงลบของการยอมรับตามเงื่อนไข การปฏิเสธตามเงื่อนไข (CR) คืออัตราส่วนระหว่างจำนวนของป้ายกำกับเชิงลบที่สังเกตพบสำหรับค่าด้านนั้น และจำนวนของป้ายกำกับเชิงลบที่คาดการณ์ไว้:

CR = (TN + FP🇧🇷TN + FN)

CR สำหรับผู้หญิงคือ 0.928 และสำหรับผู้ชายคือ 0.796 ตัวชี้วัดสุดท้ายในหมวดหมู่นี้คือส่วนต่างในการปฏิเสธตามเงื่อนไข (DCR):

DCR = 0.796 - 0.928 = 0.132

ประสิทธิภาพที่เท่าเทียมกันบนฉลากบวกกับฉลากติดลบ

SageMaker Clarify รวมสองหมวดหมู่ก่อนหน้านี้โดยพิจารณาจากอัตราส่วนประสิทธิภาพของแบบจำลองบนฉลากด้านบวกและด้านลบ โดยเฉพาะอย่างยิ่ง สำหรับแต่ละค่าด้าน SageMaker Clarify จะคำนวณการปันส่วนระหว่างผลลบลวง (FN) และผลบวกลวง (FP) ในตัวอย่างของเรา อัตราส่วน FN/FP สำหรับผู้หญิงคือ 679/10 = 67.9 และสำหรับผู้ชายคือ 3678/84 = 43.786 สิ่งนี้นำไปสู่ตัวชี้วัดความเท่าเทียมกันในการบำบัด (TE) ซึ่งวัดความแตกต่างระหว่างอัตราส่วน FP/FN:

TE = 67.9 - 43.786 = 24.114

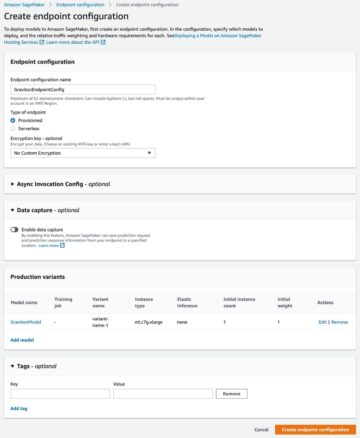

ภาพหน้าจอต่อไปนี้แสดงวิธีใช้ SageMaker Clarify ด้วย สตูดิโอ Amazon SageMaker เพื่อแสดงค่าตลอดจนช่วงและคำอธิบายสั้นๆ ของเมตริกอคติต่างๆ

คำถามเกี่ยวกับอคติ: เมตริกใดที่จะเริ่มต้นด้วย

จำคำถามตัวอย่างเกี่ยวกับอคติในตอนต้นของโพสต์นี้ เมื่อผ่านเมตริกจากหมวดหมู่ต่างๆ แล้ว ให้พิจารณาคำถามอีกครั้ง ในการตอบคำถามแรก ซึ่งเกี่ยวข้องกับการเป็นตัวแทนของกลุ่มต่างๆ ในข้อมูลการฝึกอบรม คุณสามารถเริ่มต้นด้วยเมตริก Class Imbalance (CI) ในทำนองเดียวกัน สำหรับคำถามที่เหลือ คุณสามารถเริ่มต้นด้วยการดูส่วนต่างในสัดส่วนเชิงบวกในป้ายกำกับ (DPL) ความแตกต่างของความแม่นยำ (AD) ส่วนต่างในอัตราการยอมรับ (DAR) และส่วนต่างการเรียกคืน (RD) ตามลำดับ

อคติที่ไม่มีค่าด้าน

เพื่อความสะดวกในการอธิบาย คำอธิบายเมตริกหลังการฝึกนี้ไม่รวมเมตริก Generalized Entropy Index (GE) เมตริกนี้จะวัดความเอนเอียงโดยไม่พิจารณามูลค่าด้าน และมีประโยชน์ในการประเมินวิธีกระจายข้อผิดพลาดของแบบจำลอง ดูรายละเอียดได้ที่ เอนโทรปีทั่วไป (GE).

สรุป

ในโพสต์นี้ คุณจะเห็นว่าเมตริกที่แตกต่างกัน 21 รายการใน SageMaker Clarify วัดความเอนเอียงที่ขั้นตอนต่างๆ ของไปป์ไลน์ ML ได้อย่างไร คุณได้เรียนรู้เกี่ยวกับเมตริกต่างๆ ผ่านกรณีการใช้งานการคาดการณ์รายได้ วิธีเลือกเมตริกสำหรับกรณีการใช้งานของคุณ และเมตริกใดบ้างที่คุณสามารถเริ่มต้นได้

เริ่มต้นกับเส้นทาง AI ที่รับผิดชอบโดยการประเมินอคติในแบบจำลอง ML ของคุณโดยใช้สมุดบันทึกสาธิต ความเป็นธรรมและการอธิบายด้วย SageMaker Clarify. คุณสามารถค้นหาเอกสารโดยละเอียดสำหรับ SageMaker Clarify รวมถึงคำจำกัดความอย่างเป็นทางการของตัวชี้วัดได้ที่ ความเป็นธรรมและความสามารถในการอธิบายแบบจำลองสำหรับการคาดการณ์ของแมชชีนเลิร์นนิงคืออะไร. สำหรับการใช้งานโอเพนซอร์สของเมตริกอคติ โปรดดูที่ aws-sagemaker- ชี้แจงที่เก็บ GitHub. สำหรับการอภิปรายโดยละเอียดรวมถึงข้อจำกัด โปรดดูที่ เอกสารรายงานความเป็นธรรมและอธิบายได้ของ Amazon AI.

เกี่ยวกับผู้แต่ง

บิลัล ซาฟาร์ เป็นนักวิทยาศาสตร์ประยุกต์ที่ AWS ซึ่งทำงานเกี่ยวกับความเป็นธรรม คำอธิบาย และความปลอดภัยในการเรียนรู้ของเครื่อง

บิลัล ซาฟาร์ เป็นนักวิทยาศาสตร์ประยุกต์ที่ AWS ซึ่งทำงานเกี่ยวกับความเป็นธรรม คำอธิบาย และความปลอดภัยในการเรียนรู้ของเครื่อง

เดนิส วี. บาตาลอฟ เป็นสถาปนิกโซลูชันสำหรับ AWS ซึ่งเชี่ยวชาญด้านการเรียนรู้ของเครื่อง เขาทำงานกับอเมซอนมาตั้งแต่ปี 2005 เดนิสสำเร็จการศึกษาระดับปริญญาเอกด้าน AI ติดตามเขาบน Twitter: @dbatalov

มิเชล โดนินี่ เป็น Sr Applied Scientist ที่ AWS เขาเป็นผู้นำทีมนักวิทยาศาสตร์ที่ทำงานเกี่ยวกับ Responsible AI และความสนใจในการวิจัยของเขาคือความเป็นธรรมเกี่ยวกับอัลกอริทึมและการเรียนรู้ของเครื่องที่อธิบายได้

มิเชล โดนินี่ เป็น Sr Applied Scientist ที่ AWS เขาเป็นผู้นำทีมนักวิทยาศาสตร์ที่ทำงานเกี่ยวกับ Responsible AI และความสนใจในการวิจัยของเขาคือความเป็นธรรมเกี่ยวกับอัลกอริทึมและการเรียนรู้ของเครื่องที่อธิบายได้

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- อเมซอน SageMaker

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- AWS Machine Learning AWS

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลมทะเล