วันนี้เรารู้สึกตื่นเต้นที่จะประกาศว่าโมเดลรองพื้น Llama 2 ที่พัฒนาโดย Meta พร้อมให้ลูกค้าใช้งานผ่าน Amazon SageMaker JumpStart. ตระกูล Llama 2 ของโมเดลภาษาขนาดใหญ่ (LLMs) คือชุดของโมเดลข้อความกำเนิดที่ผ่านการฝึกอบรมและปรับแต่งมาอย่างดี ซึ่งมีตั้งแต่ขนาด 7 พันล้านถึง 70 พันล้านพารามิเตอร์ LLM ที่ได้รับการปรับแต่งอย่างละเอียดเรียกว่า Llama-2-chat ได้รับการปรับให้เหมาะสมสำหรับกรณีการใช้งานบทสนทนา คุณสามารถลองใช้โมเดลเหล่านี้ได้อย่างง่ายดายและใช้กับ SageMaker JumpStart ซึ่งเป็นฮับการเรียนรู้ของเครื่อง (ML) ที่ให้การเข้าถึงอัลกอริทึม โมเดล และโซลูชัน ML เพื่อให้คุณสามารถเริ่มต้นใช้งาน ML ได้อย่างรวดเร็ว

ในโพสต์นี้ เราจะแนะนำวิธีใช้โมเดลลามะ 2 ผ่าน SageMaker JumpStart

ลามะ 2 คืออะไร

Llama 2 เป็นโมเดลภาษาถอยหลังอัตโนมัติที่ใช้สถาปัตยกรรมหม้อแปลงที่ปรับให้เหมาะสม Llama 2 มีไว้สำหรับใช้ในเชิงพาณิชย์และการวิจัยเป็นภาษาอังกฤษ มีขนาดพารามิเตอร์หลายขนาด ได้แก่ 7 พันล้าน 13 พันล้าน และ 70 พันล้าน ตลอดจนรูปแบบต่างๆ ที่ผ่านการฝึกอบรมและปรับแต่งอย่างละเอียด จากข้อมูลของ Meta เวอร์ชันที่ปรับแต่งจะใช้การปรับแบบละเอียดภายใต้การดูแล (SFT) และการเรียนรู้แบบเสริมแรงด้วยคำติชมของมนุษย์ (RLHF) เพื่อให้สอดคล้องกับความชอบของมนุษย์ในด้านความช่วยเหลือและความปลอดภัย Llama 2 ได้รับการฝึกอบรมล่วงหน้าโดยใช้ข้อมูล 2 ล้านล้านโทเค็นจากแหล่งข้อมูลสาธารณะ โมเดลที่ได้รับการปรับแต่งมีไว้สำหรับการแชทแบบผู้ช่วย ในขณะที่โมเดลที่ผ่านการฝึกอบรมล่วงหน้าสามารถปรับให้เหมาะกับงานสร้างภาษาธรรมชาติที่หลากหลาย ไม่ว่านักพัฒนาจะใช้โมเดลรุ่นใดก็ตาม คู่มือการใช้งานอย่างรับผิดชอบจาก Meta สามารถช่วยแนะนำการปรับละเอียดเพิ่มเติมที่อาจจำเป็นในการปรับแต่งและเพิ่มประสิทธิภาพโมเดลด้วยการบรรเทาความปลอดภัยที่เหมาะสม

SageMaker JumpStart คืออะไร

ด้วย SageMaker JumpStart ผู้ปฏิบัติงานด้าน ML สามารถเลือกโมเดลพื้นฐานของโอเพ่นซอร์สที่มีให้เลือกมากมาย ผู้ปฏิบัติงาน ML สามารถนำโมเดลพื้นฐานไปปรับใช้ได้ อเมซอน SageMaker อินสแตนซ์จากสภาพแวดล้อมแบบแยกเครือข่ายและปรับแต่งโมเดลโดยใช้ SageMaker สำหรับการฝึกโมเดลและการปรับใช้

ตอนนี้คุณสามารถค้นหาและใช้งาน Llama 2 ได้ด้วยการคลิกเพียงไม่กี่ครั้ง สตูดิโอ Amazon SageMaker หรือทางโปรแกรมผ่าน SageMaker Python SDK ทำให้คุณได้รับประสิทธิภาพของแบบจำลองและการควบคุม MLOps ด้วยคุณลักษณะของ SageMaker เช่น ท่อส่ง Amazon SageMaker, ดีบักเกอร์ Amazon SageMakerหรือบันทึกคอนเทนเนอร์ มีการปรับใช้โมเดลในสภาพแวดล้อมที่ปลอดภัยของ AWS และภายใต้การควบคุม VPC ของคุณ ซึ่งช่วยรับประกันความปลอดภัยของข้อมูล โมเดล Llama 2 มีวางจำหน่ายแล้ววันนี้ใน Amazon SageMaker Studio โดยเริ่มต้นใน us-east 1 และ us-west 2 ภูมิภาค

ค้นพบแบบจำลอง

คุณสามารถเข้าถึงโมเดลพื้นฐานผ่าน SageMaker JumpStart ใน SageMaker Studio UI และ SageMaker Python SDK ในส่วนนี้ เราจะพูดถึงวิธีค้นหาโมเดลใน SageMaker Studio

SageMaker Studio เป็นสภาพแวดล้อมการพัฒนาแบบผสานรวม (IDE) ที่มีอินเทอร์เฟซภาพบนเว็บเดียว ซึ่งคุณสามารถเข้าถึงเครื่องมือที่สร้างขึ้นตามวัตถุประสงค์เพื่อดำเนินการตามขั้นตอนการพัฒนา ML ทั้งหมด ตั้งแต่การเตรียมข้อมูลไปจนถึงการสร้าง การฝึกอบรม และนำโมเดล ML ของคุณไปใช้จริง สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีเริ่มต้นใช้งานและตั้งค่า SageMaker Studio โปรดดูที่ สตูดิโอ Amazon SageMaker.

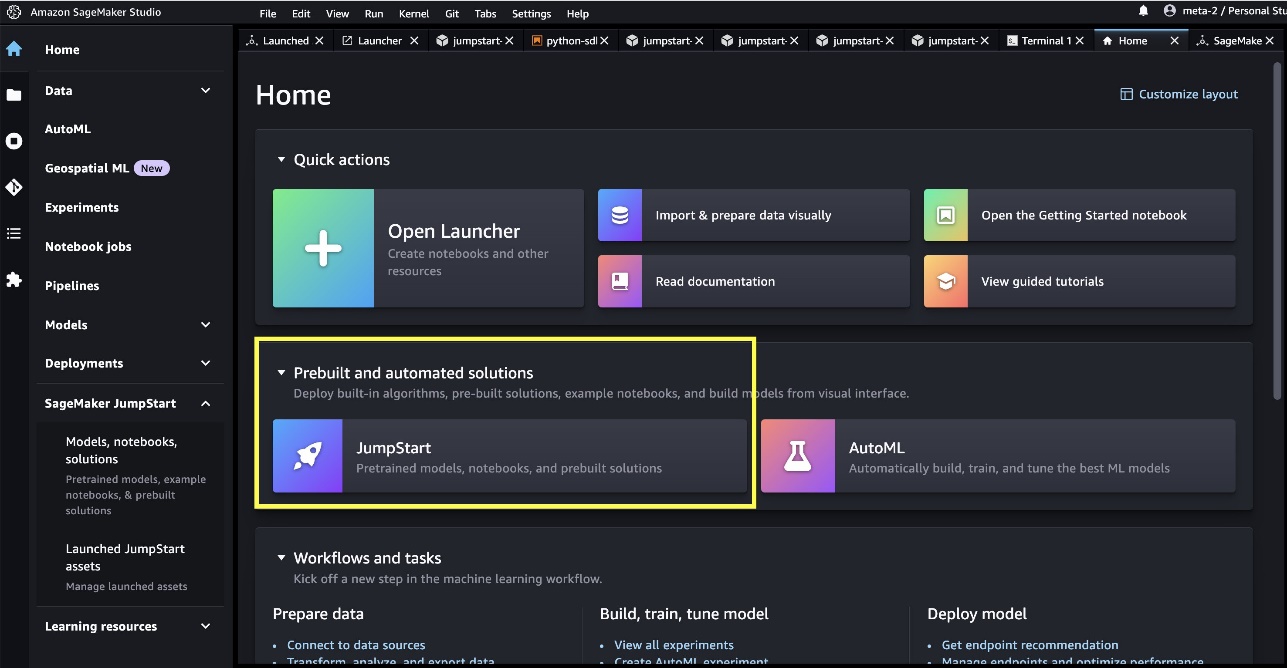

เมื่อคุณอยู่ใน SageMaker Studio แล้ว คุณสามารถเข้าถึง SageMaker JumpStart ซึ่งมีโมเดลที่ฝึกไว้ล่วงหน้า โน้ตบุ๊ก และโซลูชันที่สร้างไว้ล่วงหน้าภายใต้ โซลูชันที่สร้างไว้ล่วงหน้าและอัตโนมัติ.

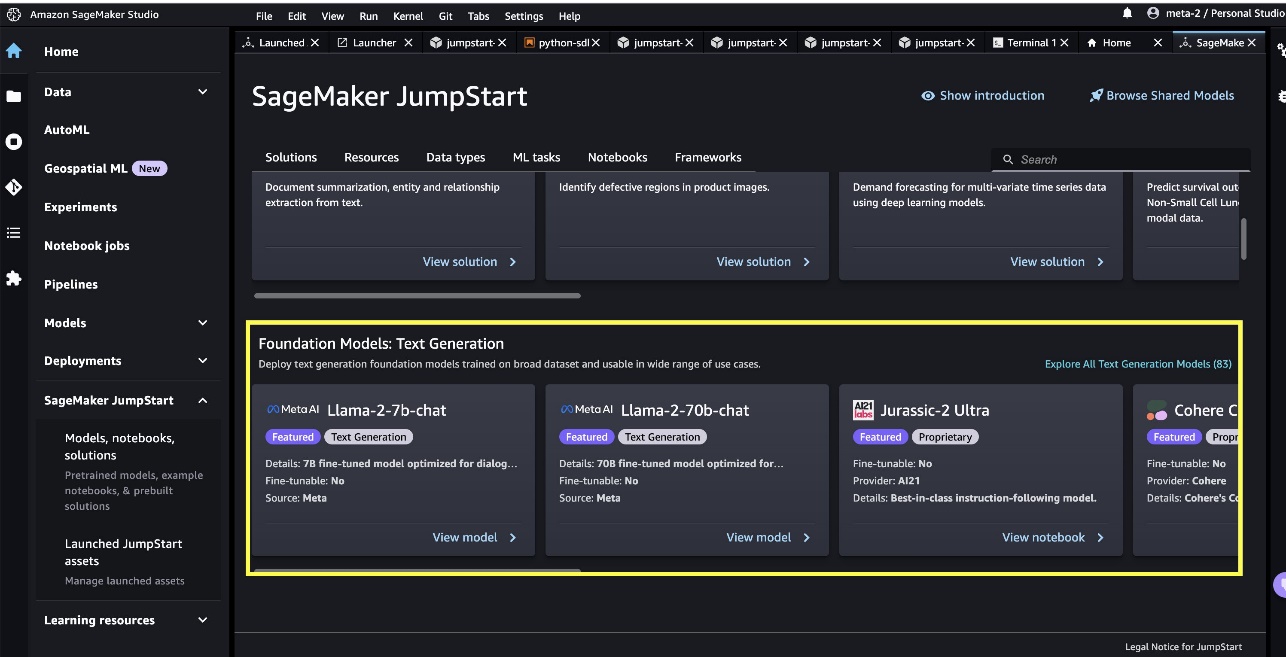

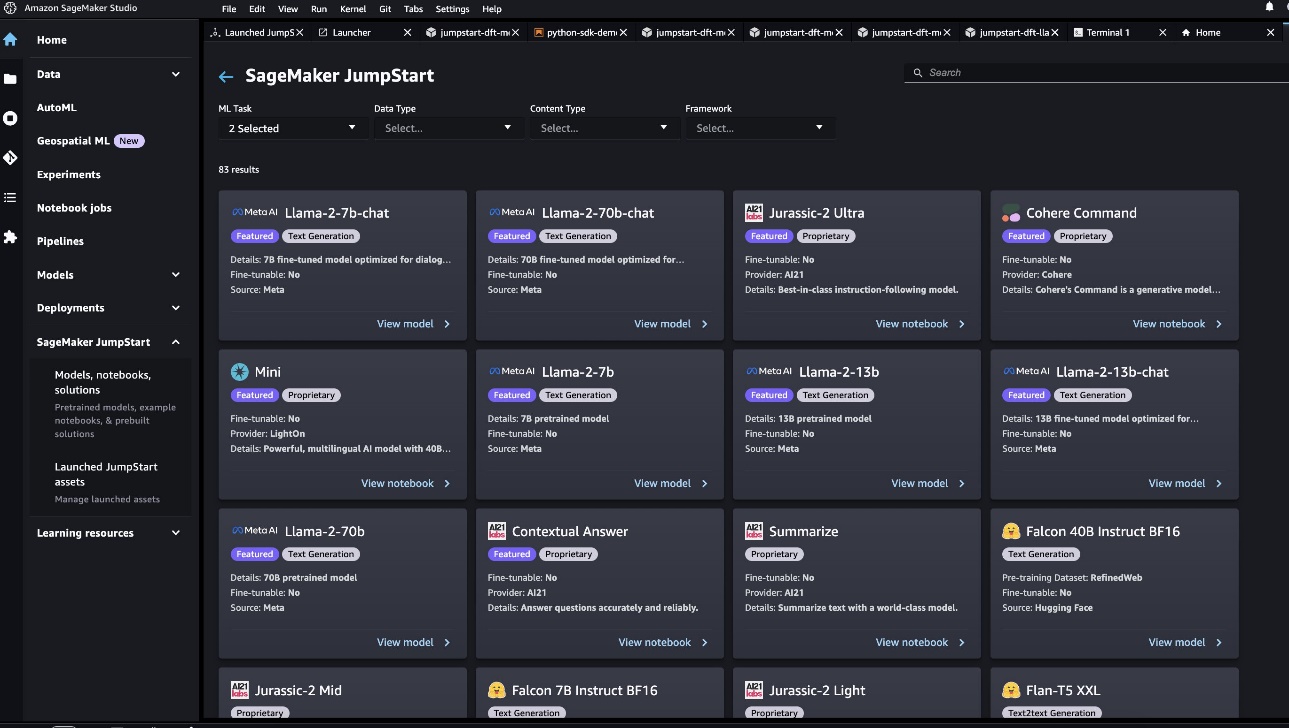

จากหน้า Landing Page ของ SageMaker JumpStart คุณสามารถเรียกดูโซลูชัน รุ่น โน้ตบุ๊ก และแหล่งข้อมูลอื่นๆ คุณสามารถค้นหา Llama 2 รุ่นเรือธงทั้งสองรุ่นได้ใน โมเดลพื้นฐาน: การสร้างข้อความ ม้าหมุน หากคุณไม่เห็นโมเดล Llama 2 ให้อัปเดตเวอร์ชัน SageMaker Studio ของคุณโดยปิดเครื่องและรีสตาร์ท สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการอัปเดตเวอร์ชัน โปรดดูที่ ปิดและอัปเดตแอป Studio.

คุณยังสามารถค้นหารูปแบบรุ่นอื่นๆ อีกสี่รุ่นได้โดยเลือก สำรวจโมเดลการสร้างข้อความทั้งหมด หรือค้นหา llama ในช่องค้นหา

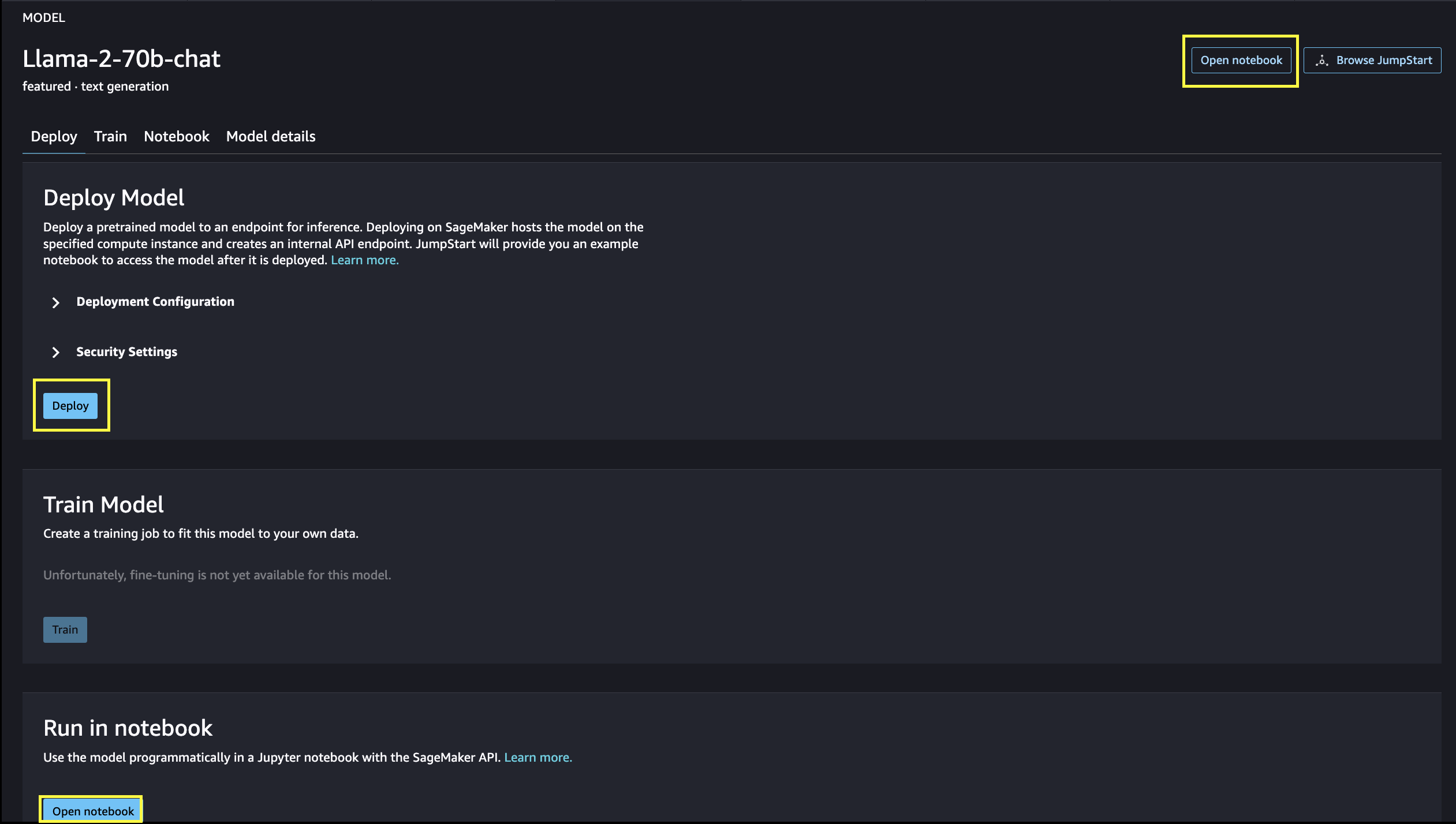

คุณสามารถเลือกการ์ดรุ่นเพื่อดูรายละเอียดเกี่ยวกับรุ่น เช่น ใบอนุญาต ข้อมูลที่ใช้ในการฝึก และวิธีการใช้งาน คุณยังสามารถค้นหาปุ่มสองปุ่ม ปรับใช้ และ เปิดสมุดบันทึกซึ่งช่วยให้คุณใช้โมเดลได้

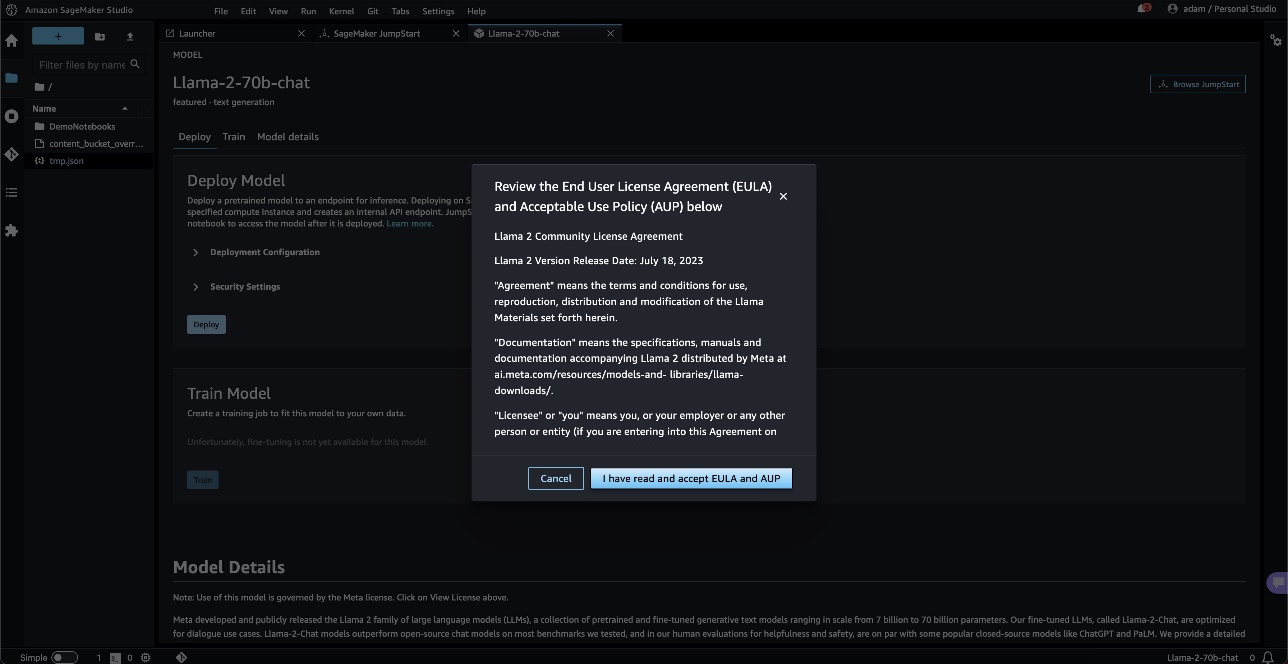

เมื่อคุณเลือกปุ่มใดปุ่มหนึ่ง ป๊อปอัปจะแสดงข้อตกลงสิทธิ์การใช้งานของผู้ใช้ปลายทางและนโยบายการใช้งานที่ยอมรับได้เพื่อให้คุณรับทราบ

เมื่อรับทราบ คุณจะไปยังขั้นตอนต่อไปเพื่อใช้โมเดล

ปรับใช้โมเดล

เมื่อคุณเลือก ปรับใช้ และรับทราบเงื่อนไข การปรับใช้แบบจำลองจะเริ่มขึ้น หรือคุณสามารถปรับใช้ผ่านสมุดบันทึกตัวอย่างที่แสดงขึ้นโดยเลือก เปิดสมุดบันทึก. สมุดบันทึกตัวอย่างให้คำแนะนำแบบ end-to-end เกี่ยวกับวิธีปรับใช้แบบจำลองสำหรับการอนุมานและล้างข้อมูลทรัพยากร

ในการปรับใช้โดยใช้โน้ตบุ๊ก เราเริ่มต้นด้วยการเลือกรุ่นที่เหมาะสมซึ่งระบุโดย model_id. คุณสามารถปรับใช้โมเดลที่เลือกใดๆ บน SageMaker ด้วยรหัสต่อไปนี้:

ซึ่งปรับใช้โมเดลบน SageMaker ด้วยการกำหนดค่าเริ่มต้น รวมถึงประเภทอินสแตนซ์เริ่มต้นและการกำหนดค่า VPC เริ่มต้น คุณสามารถเปลี่ยนการกำหนดค่าเหล่านี้ได้โดยการระบุค่าที่ไม่ใช่ค่าเริ่มต้นใน JumpStartโมเดล. หลังจากปรับใช้แล้ว คุณสามารถเรียกใช้การอนุมานเทียบกับจุดสิ้นสุดที่ปรับใช้ผ่านตัวทำนาย SageMaker:

รูปแบบการแชทที่ปรับแต่งมาอย่างดี (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) ยอมรับประวัติการแชทระหว่างผู้ใช้และผู้ช่วยแชท และสร้างการแชทที่ตามมา โมเดลที่ผ่านการฝึกอบรมล่วงหน้า (Llama-2-7b, Llama-2-13b, Llama-2-70b) ต้องใช้ข้อความพร้อมต์และดำเนินการเติมข้อความในข้อความแจ้งที่ให้มา ดูรหัสต่อไปนี้:

โปรดทราบว่าโดยค่าเริ่มต้น accept_eula ถูกตั้งค่าเป็นเท็จ คุณต้องตั้งค่า accept_eula=true เพื่อเรียกใช้จุดสิ้นสุดได้สำเร็จ การดำเนินการดังกล่าวแสดงว่าคุณยอมรับข้อตกลงใบอนุญาตผู้ใช้และนโยบายการใช้งานที่ยอมรับได้ตามที่กล่าวไว้ก่อนหน้านี้ นอกจากนี้คุณยังสามารถ ดาวน์โหลด ข้อตกลงใบอนุญาต

Custom_attributes ใช้เพื่อผ่าน EULA คือคู่คีย์/ค่า คีย์และค่าจะถูกคั่นด้วย = และคู่ที่คั่นด้วย ;. ถ้าผู้ใช้ส่งคีย์เดียวกันมากกว่าหนึ่งครั้ง ค่าสุดท้ายจะถูกเก็บไว้และส่งผ่านไปยังตัวจัดการสคริปต์ (เช่น ในกรณีนี้ ใช้สำหรับตรรกะแบบมีเงื่อนไข) ตัวอย่างเช่น ถ้า accept_eula=false; accept_eula=true จะถูกส่งต่อไปยังเซิร์ฟเวอร์แล้ว accept_eula=true ถูกเก็บไว้และส่งต่อไปยังตัวจัดการสคริปต์

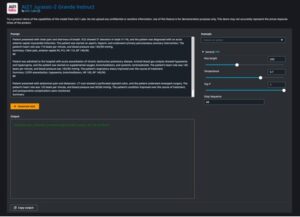

พารามิเตอร์การอนุมานจะควบคุมกระบวนการสร้างข้อความที่จุดสิ้นสุด การควบคุมโทเค็นใหม่สูงสุดหมายถึงขนาดของเอาต์พุตที่สร้างโดยโมเดล โปรดทราบว่านี่ไม่เหมือนกับจำนวนคำ เนื่องจากคำศัพท์ของแบบจำลองนั้นไม่เหมือนกับคำศัพท์ภาษาอังกฤษ และแต่ละโทเค็นอาจไม่ใช่คำในภาษาอังกฤษ อุณหภูมิควบคุมความสุ่มในเอาต์พุต อุณหภูมิที่สูงขึ้นส่งผลให้เกิดผลงานที่สร้างสรรค์และหลอนประสาทมากขึ้น พารามิเตอร์การอนุมานทั้งหมดเป็นทางเลือก

ตารางต่อไปนี้แสดงโมเดลลามะทั้งหมดที่มีอยู่ใน SageMaker JumpStart พร้อมกับ model_idsประเภทอินสแตนซ์เริ่มต้น และจำนวนสูงสุดของโทเค็นทั้งหมด (ผลรวมของจำนวนโทเค็นอินพุตและจำนวนโทเค็นที่สร้างขึ้น) ที่รองรับสำหรับแต่ละโมเดลเหล่านี้

| ชื่อรุ่น | รหัสรุ่น | โทเค็นทั้งหมดสูงสุด | ประเภทอินสแตนซ์เริ่มต้น |

| ลามะ-2-7b | เมตา-ข้อความรุ่น-llama-2-7b | 4096 | มล.g5.2xlarge |

| ลามะ-2-7b-แชท | meta-textgeneration-ลามะ-2-7b-f | 4096 | มล.g5.2xlarge |

| ลามะ-2-13b | เมตา-ข้อความรุ่น-llama-2-13b | 4096 | มล.g5.12xlarge |

| ลามะ-2-13b-แชท | meta-textgeneration-ลามะ-2-13b-f | 4096 | มล.g5.12xlarge |

| ลามะ-2-70b | เมตา-ข้อความรุ่น-llama-2-70b | 4096 | มล.g5.48xlarge |

| ลามะ-2-70b-แชท | meta-textgeneration-ลามะ-2-70b-f | 4096 | มล.g5.48xlarge |

โปรดทราบว่าตำแหน่งข้อมูล SageMaker มีขีดจำกัดการหมดเวลาอยู่ที่ 60 วินาที ดังนั้น แม้ว่าโมเดลอาจสามารถสร้างโทเค็นได้ 4096 รายการ แต่ถ้าการสร้างข้อความใช้เวลามากกว่า 60 วินาที คำขอจะล้มเหลว สำหรับรุ่น 7B, 13B และ 70B เราแนะนำให้ตั้งค่า max_new_tokens ไม่เกิน 1500, 1000 และ 500 ตามลำดับ ในขณะที่รักษาจำนวนโทเค็นทั้งหมดน้อยกว่า 4K

การอนุมานและตัวอย่างแจ้งสำหรับ Llama-2-70b

คุณสามารถใช้โมเดลลามะเพื่อเติมข้อความสำหรับข้อความส่วนใดก็ได้ ด้วยการสร้างข้อความ คุณสามารถทำงานต่างๆ ได้ เช่น การตอบคำถาม การแปลภาษา การวิเคราะห์ความรู้สึก และอื่นๆ อีกมากมาย เพย์โหลดที่ป้อนไปยังจุดสิ้นสุดมีลักษณะเหมือนรหัสต่อไปนี้:

ต่อไปนี้คือข้อความแจ้งตัวอย่างบางส่วนและข้อความที่สร้างขึ้นโดยโมเดล เอาต์พุตทั้งหมดถูกสร้างขึ้นด้วยพารามิเตอร์อนุมาน {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

ในตัวอย่างถัดไป เราจะแสดงวิธีใช้โมเดลลามะด้วยการเรียนรู้ในบริบทแบบไม่กี่ช็อต ซึ่งเราได้ให้ตัวอย่างการฝึกอบรมสำหรับโมเดล โปรดทราบว่าเราจะอนุมานเฉพาะโมเดลที่นำไปใช้งานเท่านั้น และในระหว่างกระบวนการนี้ น้ำหนักของโมเดลจะไม่เปลี่ยนแปลง

การอนุมานและตัวอย่างแจ้งสำหรับ Llama-2-70b-chat

ด้วยโมเดล Llama-2-Chat ซึ่งปรับให้เหมาะกับกรณีการใช้งานการสนทนา การป้อนข้อมูลไปยังจุดสิ้นสุดของโมเดลการแชทคือประวัติก่อนหน้าระหว่างผู้ช่วยแชทและผู้ใช้ คุณสามารถถามคำถามตามบริบทของการสนทนาที่เกิดขึ้นจนถึงตอนนี้ คุณยังสามารถระบุการกำหนดค่าระบบ เช่น บุคลิกที่กำหนดพฤติกรรมของผู้ช่วยแชท เพย์โหลดอินพุตไปยังจุดสิ้นสุดมีลักษณะเหมือนรหัสต่อไปนี้:

ต่อไปนี้คือข้อความแจ้งตัวอย่างบางส่วนและข้อความที่สร้างขึ้นโดยโมเดล เอาต์พุตทั้งหมดถูกสร้างขึ้นด้วยพารามิเตอร์การอนุมาน {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

ในตัวอย่างต่อไปนี้ ผู้ใช้ได้สนทนากับผู้ช่วยเกี่ยวกับสถานที่ท่องเที่ยวในปารีส ถัดไป ผู้ใช้กำลังสอบถามเกี่ยวกับตัวเลือกแรกที่ผู้ช่วยแชทแนะนำ

ในตัวอย่างต่อไปนี้ เราตั้งค่าคอนฟิกของระบบ:

ทำความสะอาด

หลังจากที่คุณเรียกใช้สมุดบันทึกเสร็จแล้ว อย่าลืมลบทรัพยากรทั้งหมด เพื่อให้ทรัพยากรทั้งหมดที่คุณสร้างในกระบวนการถูกลบและการเรียกเก็บเงินของคุณจะหยุดลง:

สรุป

ในโพสต์นี้ เราได้แสดงวิธีเริ่มต้นใช้งานโมเดลลามะ 2 ใน SageMaker Studio ด้วยสิ่งนี้ คุณจะสามารถเข้าถึงโมเดลรองพื้น Llama 2 หกรุ่นที่มีพารามิเตอร์หลายพันล้านตัว เนื่องจากโมเดลพื้นฐานได้รับการฝึกอบรมล่วงหน้า จึงสามารถช่วยลดต้นทุนการฝึกอบรมและโครงสร้างพื้นฐาน และเปิดใช้งานการปรับแต่งสำหรับกรณีการใช้งานของคุณ หากต้องการเริ่มต้นใช้งาน SageMaker JumpStart โปรดไปที่แหล่งข้อมูลต่อไปนี้:

เกี่ยวกับผู้แต่ง

จูน วอน เป็นผู้จัดการผลิตภัณฑ์ของ SageMaker JumpStart เขามุ่งเน้นที่การสร้างแบบจำลองพื้นฐานที่ค้นพบได้ง่ายและใช้งานได้ เพื่อช่วยลูกค้าสร้างแอปพลิเคชัน AI เชิงกำเนิด ประสบการณ์ของเขาที่ Amazon ยังรวมถึงแอปพลิเคชันการช็อปปิ้งบนมือถือและการจัดส่งในระยะทางสุดท้าย

จูน วอน เป็นผู้จัดการผลิตภัณฑ์ของ SageMaker JumpStart เขามุ่งเน้นที่การสร้างแบบจำลองพื้นฐานที่ค้นพบได้ง่ายและใช้งานได้ เพื่อช่วยลูกค้าสร้างแอปพลิเคชัน AI เชิงกำเนิด ประสบการณ์ของเขาที่ Amazon ยังรวมถึงแอปพลิเคชันการช็อปปิ้งบนมือถือและการจัดส่งในระยะทางสุดท้าย

ดร.วิเวก มะดัน เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart เขาสำเร็จการศึกษาระดับปริญญาเอกจากมหาวิทยาลัยอิลลินอยส์ Urbana-Champaign และเป็นนักวิจัยหลังปริญญาเอกที่ Georgia Tech เขาเป็นนักวิจัยเชิงรุกด้านการเรียนรู้ของเครื่องและการออกแบบอัลกอริธึม และได้ตีพิมพ์เอกสารในการประชุม EMNLP, ICLR, COLT, FOCS และ SODA

ดร.วิเวก มะดัน เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart เขาสำเร็จการศึกษาระดับปริญญาเอกจากมหาวิทยาลัยอิลลินอยส์ Urbana-Champaign และเป็นนักวิจัยหลังปริญญาเอกที่ Georgia Tech เขาเป็นนักวิจัยเชิงรุกด้านการเรียนรู้ของเครื่องและการออกแบบอัลกอริธึม และได้ตีพิมพ์เอกสารในการประชุม EMNLP, ICLR, COLT, FOCS และ SODA  ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart งานวิจัยที่เขาสนใจ ได้แก่ อัลกอริธึมแมชชีนเลิร์นนิงที่ปรับขนาดได้ คอมพิวเตอร์วิทัศน์ อนุกรมเวลา เบส์ที่ไม่ใช่พารามิเตอร์ และกระบวนการเกาส์เซียน ปริญญาเอกของเขามาจาก Duke University และเขาได้ตีพิมพ์บทความใน NeurIPS, Cell และ Neuron

ดร.ไคล์ อูลริช เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart งานวิจัยที่เขาสนใจ ได้แก่ อัลกอริธึมแมชชีนเลิร์นนิงที่ปรับขนาดได้ คอมพิวเตอร์วิทัศน์ อนุกรมเวลา เบส์ที่ไม่ใช่พารามิเตอร์ และกระบวนการเกาส์เซียน ปริญญาเอกของเขามาจาก Duke University และเขาได้ตีพิมพ์บทความใน NeurIPS, Cell และ Neuron  ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสของ Amazon SageMaker JumpStart และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสของ Amazon SageMaker JumpStart และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP  ซุนดาร์ รังคนาธาน เป็นหัวหน้าระดับโลกของผู้เชี่ยวชาญ GenAI/Frameworks GTM ที่ AWS เขามุ่งเน้นไปที่การพัฒนากลยุทธ์ GTM สำหรับโมเดลภาษาขนาดใหญ่ GenAI และปริมาณงาน ML ขนาดใหญ่ในบริการต่างๆ ของ AWS เช่น Amazon EC2, EKS, EFA, AWS Batch และ Amazon SageMaker ประสบการณ์ของเขารวมถึงบทบาทความเป็นผู้นำในการจัดการผลิตภัณฑ์และการพัฒนาผลิตภัณฑ์ที่ NetApp, Micron Technology, Qualcomm และ Mentor Graphics

ซุนดาร์ รังคนาธาน เป็นหัวหน้าระดับโลกของผู้เชี่ยวชาญ GenAI/Frameworks GTM ที่ AWS เขามุ่งเน้นไปที่การพัฒนากลยุทธ์ GTM สำหรับโมเดลภาษาขนาดใหญ่ GenAI และปริมาณงาน ML ขนาดใหญ่ในบริการต่างๆ ของ AWS เช่น Amazon EC2, EKS, EFA, AWS Batch และ Amazon SageMaker ประสบการณ์ของเขารวมถึงบทบาทความเป็นผู้นำในการจัดการผลิตภัณฑ์และการพัฒนาผลิตภัณฑ์ที่ NetApp, Micron Technology, Qualcomm และ Mentor Graphics

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360 องศา

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- สามารถ

- เกี่ยวกับเรา

- ยอมรับ

- ยอมรับได้

- เข้า

- การเข้าถึง

- สามารถเข้าถึงได้

- ตาม

- รับทราบ

- ข้าม

- คล่องแคล่ว

- เพิ่ม

- เพิ่ม

- เพิ่มเติม

- ที่อยู่

- หลังจาก

- อีกครั้ง

- กับ

- ข้อตกลง

- AI

- ขั้นตอนวิธี

- อัลกอริทึม

- จัดแนว

- ทั้งหมด

- อนุญาต

- ตาม

- ด้วย

- เสมอ

- am

- อเมซอน

- Amazon EC2

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- สตูดิโอ Amazon SageMaker

- Amazon Web Services

- อเมริกัน

- an

- การวิเคราะห์

- และ

- และโครงสร้างพื้นฐาน

- ประกาศ

- อื่น

- คำตอบ

- ใด

- ทุกคน

- การใช้งาน

- การใช้งาน

- ประยุกต์

- ขอขอบคุณ

- เหมาะสม

- เส้นโค้ง

- สถาปัตยกรรม

- เป็น

- ศิลปะ

- AS

- ช่วยเหลือ

- ผู้ช่วย

- At

- บรรยากาศ

- สถานที่น่าสนใจ

- อัตโนมัติ

- ใช้ได้

- AWS

- กล้วย

- ขั้นพื้นฐาน

- การต่อสู้

- เบย์เซียน

- BE

- สวยงาม

- ร้านเสริมสวยเกาหลี

- กลายเป็น

- เพราะ

- กลายเป็น

- รับ

- เบียร์

- ก่อน

- พฤติกรรม

- ปักกิ่ง

- เชื่อ

- เชื่อว่า

- ที่ดีที่สุด

- ระหว่าง

- การเรียกเก็บเงิน

- พันล้าน

- พันล้าน

- Black

- กล่อง

- ทำลาย

- น่าทึ่ง

- กว้าง

- สร้าง

- การก่อสร้าง

- สร้าง

- แต่

- ปุ่ม

- by

- ที่เรียกว่า

- CAN

- เมืองหลวง

- รถ

- บัตร

- ม้าหมุน

- กรณี

- กรณี

- แมว

- เปลี่ยนแปลง

- ช็อคโกแลต

- Choose

- เลือก

- เมือง

- คลาสสิก

- รหัส

- ชุด

- รวม

- รวม

- มา

- มา

- เชิงพาณิชย์

- บริษัท

- เสร็จสิ้น

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- การประชุม

- มั่นใจ

- องค์ประกอบ

- ถือว่า

- คงที่

- การก่อสร้าง

- บรรจุ

- ภาชนะ

- มี

- เนื้อหา

- ตามบริบท

- ต่อ

- อย่างต่อเนื่อง

- ควบคุม

- การควบคุม

- สะดวกสบาย

- การสนทนา

- ค่าใช้จ่าย

- ประเทศ

- ความกล้าหาญ

- หน้าปก

- สร้าง

- ที่สร้างขึ้น

- ความคิดสร้างสรรค์

- ด้านวัฒนธรรม

- วัฒนธรรม

- ถ้วย

- ลูกค้า

- การปรับแต่ง

- ปรับแต่ง

- ข้อมูล

- ความปลอดภัยของข้อมูล

- ทุ่มเท

- การอุทิศ

- ค่าเริ่มต้น

- กำหนด

- การจัดส่ง

- ปรับใช้

- นำไปใช้

- ปรับใช้

- การใช้งาน

- Deploys

- ออกแบบ

- ได้รับการออกแบบ

- ที่ต้องการ

- ปลายทาง

- สถานที่ท่องเที่ยว

- รายละเอียด

- พัฒนา

- พัฒนา

- ผู้พัฒนา

- ที่กำลังพัฒนา

- พัฒนาการ

- บทสนทนา

- ความแตกต่าง

- ต่าง

- ยาก

- ค้นพบ

- เด่น

- do

- สารคดี

- การทำ

- ทำ

- Dont

- สองเท่า

- ลง

- ดยุค

- มหาวิทยาลัยดุ๊ก

- ในระหว่าง

- e

- แต่ละ

- ก่อน

- อย่างง่ายดาย

- ง่าย

- เอ็ดเวิร์ด

- Einstein

- ทั้ง

- อีเมล

- ทำให้สามารถ

- การเปิดใช้งาน

- ปลาย

- จบสิ้น

- ปลายทาง

- ชั้นเยี่ยม

- ภาษาอังกฤษ

- เพลิดเพลิน

- พอ

- ทำให้มั่นใจ

- สิ่งแวดล้อม

- อุปกรณ์

- อีเทอร์

- แม้

- เหตุการณ์

- ทุกคน

- ตัวอย่าง

- ตัวอย่าง

- ตื่นเต้น

- ประสบการณ์

- การทดลอง

- การทดลอง

- ด่วน

- ล้มเหลว

- ล้มเหลว

- ธรรม

- เท็จ

- ครอบครัว

- มีชื่อเสียง

- ไกล

- ความสำเร็จ

- ที่โดดเด่น

- คุณสมบัติ

- ข้อเสนอแนะ

- ฟุต

- สองสาม

- ภาพยนตร์

- สุดท้าย

- ในที่สุด

- หา

- ชื่อจริง

- เรือธง

- ลอย

- กระแส

- มุ่งเน้นไปที่

- ดังต่อไปนี้

- สำหรับ

- ข้างหน้า

- พบ

- รากฐาน

- สี่

- ฝรั่งเศส

- ภาษาฝรั่งเศส

- ราคาเริ่มต้นที่

- อย่างเต็มที่

- ต่อไป

- อนาคต

- General

- สร้าง

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- จอร์เจีย

- ได้รับ

- ให้

- กระจก

- เหตุการณ์ที่

- Go

- ไป

- กราฟิก

- ยิ่งใหญ่

- มากขึ้น

- แหวกแนว

- ขึ้น

- คำแนะนำ

- ให้คำแนะนำ

- มี

- จัดการ

- ที่เกิดขึ้น

- มีความสุข

- ยาก

- การทำงานอย่างหนัก

- มี

- มี

- he

- หัว

- ช่วย

- การช่วยเหลือ

- จะช่วยให้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- hi

- จุดสูง

- สูงกว่า

- ของเขา

- ทางประวัติศาสตร์

- ประวัติ

- การเคหะ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- HTTPS

- Hub

- เป็นมนุษย์

- i

- สัญลักษณ์

- ความคิด

- if

- ii

- อิลลินอยส์

- ส่งผลกระทบ

- นำเข้า

- สำคัญ

- ประทับใจ

- in

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- Incorporated

- ข้อมูล

- โครงสร้างพื้นฐาน

- ในขั้นต้น

- อินพุต

- แรงบันดาลใจ

- ที่เร้าใจ

- ตัวอย่าง

- ทันที

- คำแนะนำการใช้

- แบบบูรณาการ

- ตั้งใจว่า

- ผลประโยชน์

- อินเตอร์เฟซ

- เข้าไป

- เปลี่ยว

- IT

- ITS

- การเดินทาง

- jpg

- เพียงแค่

- การเก็บรักษา

- เก็บไว้

- คีย์

- ชนิด

- ทราบ

- ที่รู้จักกัน

- เชื่อมโยงไปถึง

- สถานที่สำคัญ

- ภาษา

- ใหญ่

- ขนาดใหญ่

- ใหญ่ที่สุด

- ชื่อสกุล

- ปลาย

- เปิดตัว

- กฎหมาย

- ความเป็นผู้นำ

- เรียนรู้

- เรียนรู้และเติบโต

- การเรียนรู้

- น้อยที่สุด

- น้อยลง

- ระดับ

- License

- ชีวิต

- เบา

- กดไลก์

- LIMIT

- รายการ

- วรรณคดี

- ll

- ดูรายละเอียด

- ตรรกะ

- นาน

- เวลานาน

- ที่ต้องการหา

- LOOKS

- ความรัก

- รัก

- ลด

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- ทำ

- ทำให้

- การทำ

- การจัดการ

- ผู้จัดการ

- หลาย

- ประหลาดใจ

- เรื่อง

- สูงสุด

- อาจ..

- ความหมาย

- วัด

- ภาพบรรยากาศ

- กลาง

- กล่าวถึง

- ข่าวสาร

- Meta

- ไมครอน

- นาที

- นาที

- สารผสม

- ML

- ม.ป.ป

- โทรศัพท์มือถือ

- แบบ

- โมเดล

- ขณะ

- เดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- เป็นที่นิยม

- การเคลื่อนไหว

- หนัง

- มาก

- พิพิธภัณฑ์

- พิพิธภัณฑ์

- ดนตรี

- ชื่อ

- โดยธรรมชาติ

- จำเป็น

- จำเป็นต้อง

- จำเป็น

- เครือข่าย

- ใหม่

- นิวยอร์ก

- ถัดไป

- ไม่

- สมุดบันทึก

- ตอนนี้

- จำนวน

- มากมาย

- NY

- of

- เสนอ

- การเสนอ

- เสนอ

- น้ำมัน

- on

- ครั้งเดียว

- ONE

- เพียง

- เปิด

- โอเพนซอร์ส

- เพิ่มประสิทธิภาพ

- การปรับให้เหมาะสม

- ตัวเลือกเสริม (Option)

- or

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- มิฉะนั้น

- ของเรา

- ออก

- เอาท์พุต

- เกิน

- ทั้งหมด

- หน้า

- คู่

- กระดาษ

- เอกสาร

- พารามิเตอร์

- พารามิเตอร์

- ปารีส

- ส่วนหนึ่ง

- ส่ง

- ผ่าน

- ผ่าน

- อดีต

- ความสงบ

- ดำเนินการ

- การปฏิบัติ

- ถาวร

- โทรศัพท์

- ภาพ

- ฟิสิกส์

- ชิ้น

- พิซซ่า

- พลาสติก

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เล่น

- นโยบาย

- ป๊อปอัพ

- ยอดนิยม

- โพสต์

- ไปรษณีย์

- Predictor

- การตั้งค่า

- การเตรียมความพร้อม

- นำเสนอ

- ก่อน

- กระบวนการ

- กระบวนการ

- ผลิตภัณฑ์

- การพัฒนาผลิตภัณฑ์

- การจัดการผลิตภัณฑ์

- ผู้จัดการผลิตภัณฑ์

- ข้อเสนอ

- ภูมิใจ

- ให้

- ให้

- ให้

- การให้

- สาธารณะ

- ขนส่งมวลชน

- สาธารณชน

- การตีพิมพ์

- วัตถุประสงค์

- ใส่

- หลาม

- วอลคอมม์

- คำถาม

- รวดเร็ว

- อย่างรวดเร็ว

- ทางลาด

- สุ่ม

- พิสัย

- ตั้งแต่

- พร้อม

- เหตุผล

- รับ

- สูตร

- แนะนำ

- แนะนำ

- หมายถึง

- ไม่คำนึงถึง

- ภูมิภาค

- ญาติ

- ความสัมพันธ์

- ซ้ำแล้วซ้ำอีก

- แสดง

- ขอ

- ต้อง

- การวิจัย

- นักวิจัย

- แหล่งข้อมูล

- ตามลำดับ

- ตอบสนอง

- REST

- ผล

- ผลสอบ

- แม่น้ำ

- บทบาท

- บทบาท

- วิ่ง

- วิ่ง

- s

- ความปลอดภัย

- sagemaker

- เกลือ

- เดียวกัน

- ที่ปรับขนาดได้

- ขนาด

- นักวิทยาศาสตร์

- นักวิทยาศาสตร์

- SDK

- เอเชียตะวันออกเฉียงใต้

- ค้นหา

- ค้นหา

- Section

- ปลอดภัย

- ความปลอดภัย

- เห็น

- เห็น

- ดูเหมือน

- เลือก

- การเลือก

- การเลือก

- ส่ง

- ระดับอาวุโส

- ความรู้สึก

- ชุด

- บริการ

- การให้บริการ

- ชุด

- การตั้งค่า

- รูปร่าง

- ปลาฉลาม

- ช้อปปิ้ง

- น่า

- โชว์

- แสดงให้เห็นว่า

- แสดงให้เห็นว่า

- ปิด

- ความสำคัญ

- สำคัญ

- ง่าย

- ง่ายดาย

- เดียว

- เว็บไซต์

- สถานที่ทำวิจัย

- หก

- ขนาด

- ช้า

- เล็ก

- So

- จนถึงตอนนี้

- สังคม

- โซเชียลมีเดีย

- โซลูชัน

- บาง

- แหล่ง

- แหล่งที่มา

- พิเศษ

- ผู้เชี่ยวชาญ

- ที่ระบุไว้

- ความเร็ว

- ยืน

- เริ่มต้น

- ข้อความที่เริ่ม

- สถานะ

- สหรัฐอเมริกา

- ทางสถิติ

- ขั้นตอน

- ขั้นตอน

- หยุด

- กลยุทธ์

- เชือก

- โครงสร้าง

- สตูดิโอ

- ทำให้งงงวย

- หรือ

- ภายหลัง

- ความสำเร็จ

- ประสบความสำเร็จ

- อย่างเช่น

- ที่สนับสนุน

- แน่ใจ

- เครื่องหมาย

- ระบบ

- ตาราง

- เอา

- ใช้เวลา

- งาน

- ลิ้มรส

- ทีม

- เทคโนโลยี

- เทคโนโลยี

- ชั่วคราว

- เงื่อนไขการใช้บริการ

- กว่า

- ขอบคุณ

- ที่

- พื้นที่

- เมืองหลวง

- ก้าวสู่อนาคต

- ที่มา

- โลก

- ของพวกเขา

- พวกเขา

- ทฤษฎี

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- คิด

- นี้

- แต่?

- ตลอด

- เสือ

- เวลา

- อนุกรมเวลา

- ครั้ง

- ชื่อหนังสือ

- ไปยัง

- ในวันนี้

- ร่วมกัน

- โทเค็น

- ราชสกุล

- เครื่องมือ

- ด้านบน

- รวม

- หอคอย

- รถไฟ

- การฝึกอบรม

- หม้อแปลงไฟฟ้า

- แปลความ

- การแปลภาษา

- การขนส่ง

- ล้านล้าน

- ลอง

- สอง

- ชนิด

- ชนิด

- ui

- ภายใต้

- ที่น่าจดจำ

- เป็นเอกลักษณ์

- มหาวิทยาลัย

- จนกระทั่ง

- บันทึก

- การปรับปรุง

- ใช้ได้

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ผู้ใช้

- ใช้

- การใช้

- ความคุ้มค่า

- ความคุ้มค่า

- ความหลากหลาย

- รุ่น

- รุ่น

- มาก

- ผ่านทาง

- รายละเอียด

- ยอดวิว

- วิสัยทัศน์

- เยี่ยมชมร้านค้า

- ผู้เข้าชม

- ปริมาณ

- อยาก

- สงคราม

- คือ

- we

- เว็บ

- บริการเว็บ

- web-based

- Website

- ดี

- วาฬ

- อะไร

- ความหมายของ

- เมื่อ

- แต่ทว่า

- ที่

- ในขณะที่

- ทำไม

- จะ

- หน้าต่าง

- กับ

- คำ

- คำ

- งาน

- โรงงาน

- โลก

- มีชื่อเสียงระดับโลก

- ห่อ

- ปี

- นิวยอร์ก

- คุณ

- ของคุณ

- ด้วยตัวคุณเอง

- ลมทะเล

- รหัสไปรษณีย์