สามารถใช้แบบจำลองภาษาขนาดใหญ่ (LLM) เพื่อวิเคราะห์เอกสารที่ซับซ้อนและให้ข้อมูลสรุปและคำตอบสำหรับคำถาม โพสต์ การปรับให้เข้ากับโดเมน การปรับแต่งโมเดลพื้นฐานอย่างละเอียดใน Amazon SageMaker JumpStart บนข้อมูลทางการเงิน อธิบายวิธีปรับแต่ง LLM โดยใช้ชุดข้อมูลของคุณเอง เมื่อคุณมี LLM ที่มั่นคงแล้ว คุณจะต้องเปิดเผย LLM นั้นแก่ผู้ใช้ทางธุรกิจเพื่อดำเนินการเอกสารใหม่ ซึ่งอาจมีความยาวหลายร้อยหน้า ในโพสต์นี้ เราจะสาธิตวิธีสร้างส่วนต่อประสานผู้ใช้แบบเรียลไทม์เพื่อให้ผู้ใช้ทางธุรกิจประมวลผลเอกสาร PDF ที่มีความยาวตามอำเภอใจ เมื่อประมวลผลไฟล์แล้ว คุณสามารถสรุปเอกสารหรือถามคำถามเกี่ยวกับเนื้อหาได้ โซลูชันตัวอย่างที่อธิบายไว้ในโพสต์นี้มีอยู่ใน GitHub.

ทำงานกับเอกสารทางการเงิน

งบการเงิน เช่น รายงานรายได้ประจำไตรมาสและรายงานประจำปีสำหรับผู้ถือหุ้นมักจะมีความยาวหลายสิบหรือหลายร้อยหน้า เอกสารเหล่านี้มีภาษาสำเร็จรูปจำนวนมาก เช่น ข้อความปฏิเสธความรับผิดชอบและภาษากฎหมาย หากคุณต้องการแยกจุดข้อมูลสำคัญออกจากหนึ่งในเอกสารเหล่านี้ คุณต้องใช้เวลาและความคุ้นเคยกับภาษาสำเร็จรูปเพื่อระบุข้อเท็จจริงที่น่าสนใจ และแน่นอน คุณไม่สามารถถามคำถาม LLM เกี่ยวกับเอกสารที่ไม่เคยเห็นมาก่อน

LLM ที่ใช้สำหรับการสรุปมีข้อจำกัดเกี่ยวกับจำนวนโทเค็น (อักขระ) ที่ส่งผ่านไปยังโมเดล และด้วยข้อยกเว้นบางประการ โดยปกติแล้ว โทเค็นเหล่านี้จะมีจำนวนไม่เกินสองสามพันโทเค็น ซึ่งโดยปกติจะขัดขวางความสามารถในการสรุปเอกสารที่ยาวขึ้น

โซลูชันของเราจัดการเอกสารที่เกินความยาวลำดับโทเค็นสูงสุดของ LLM และทำให้เอกสารนั้นพร้อมใช้งานสำหรับ LLM สำหรับการตอบคำถาม

ภาพรวมโซลูชัน

การออกแบบของเรามีสามส่วนสำคัญ:

- มีเว็บแอปพลิเคชันแบบโต้ตอบสำหรับผู้ใช้ทางธุรกิจในการอัปโหลดและประมวลผล PDF

- มันใช้ไลบรารี langchain เพื่อแยก PDF ขนาดใหญ่ออกเป็นชิ้น ๆ ที่จัดการได้มากขึ้น

- ใช้เทคนิคการดึงข้อมูลการสร้างเสริมเพื่อให้ผู้ใช้ถามคำถามเกี่ยวกับข้อมูลใหม่ที่ LLM ไม่เคยเห็นมาก่อน

ดังที่แสดงในไดอะแกรมต่อไปนี้ เราใช้ส่วนหน้าที่ใช้งานกับ React JavaScript ที่โฮสต์ใน บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) ที่ฝากข้อมูลอยู่ข้างหน้า Amazon CloudFront. แอปพลิเคชันส่วนหน้าช่วยให้ผู้ใช้อัปโหลดเอกสาร PDF ไปยัง Amazon S3 ได้ หลังจากอัปโหลดเสร็จแล้ว คุณสามารถทริกเกอร์งานแยกข้อความที่ขับเคลื่อนโดย Amazon Text. เป็นส่วนหนึ่งของกระบวนการหลังการประมวลผล AWS แลมบ์ดา ฟังก์ชันแทรกเครื่องหมายพิเศษลงในข้อความที่ระบุขอบเขตของหน้า เมื่องานนั้นเสร็จสิ้น คุณสามารถเรียกใช้ API ที่สรุปข้อความหรือตอบคำถามเกี่ยวกับมันได้

เนื่องจากบางขั้นตอนเหล่านี้อาจใช้เวลาพอสมควร สถาปัตยกรรมจึงใช้วิธีแบบอะซิงโครนัสแบบแยกส่วน ตัวอย่างเช่น การเรียกใช้เพื่อสรุปเอกสารจะเรียกใช้ฟังก์ชัน Lambda ที่โพสต์ข้อความไปยัง บริการ Amazon Simple Queue (Amazon SQS) คิว อีกฟังก์ชันของ Lambda จะรับข้อความนั้นและเริ่มต้น บริการ Amazon Elastic Container (อเมซอน อีซีเอส) AWS ฟาร์เกต งาน. งาน Fargate เรียกใช้ อเมซอน SageMaker จุดสิ้นสุดการอนุมาน เราใช้งาน Fargate ที่นี่ เนื่องจากการสรุป PDF ที่ยาวมากอาจใช้เวลาและหน่วยความจำมากกว่าที่ฟังก์ชัน Lambda มีอยู่ เมื่อการสรุปเสร็จสิ้น แอปพลิเคชันส่วนหน้าสามารถรับผลลัพธ์จาก อเมซอน ไดนาโมดีบี ตาราง

สำหรับการสรุป เราใช้โมเดล Summarize ของ AI21 ซึ่งเป็นหนึ่งในโมเดลพื้นฐานที่มีอยู่ Amazon SageMaker JumpStart. แม้ว่ารุ่นนี้จะจัดการเอกสารได้สูงสุด 10,000 คำ (ประมาณ 40 หน้า) เราใช้ตัวแยกข้อความของ langchain เพื่อให้แน่ใจว่าการเรียกสรุปไปยัง LLM แต่ละครั้งมีความยาวไม่เกิน 10,000 คำ สำหรับการสร้างข้อความ เราใช้โมเดลขนาดกลางของ Cohere และเราใช้ GPT-J สำหรับการฝัง ทั้งผ่าน JumpStart

การประมวลผลสรุป

เมื่อต้องจัดการเอกสารขนาดใหญ่ เราจำเป็นต้องกำหนดวิธีการแยกเอกสารออกเป็นส่วนย่อยๆ เมื่อเราได้รับผลการแยกข้อความจาก Amazon Textract เราจะใส่เครื่องหมายสำหรับข้อความจำนวนมาก (จำนวนหน้าที่กำหนดค่าได้) แต่ละหน้า และตัวแบ่งบรรทัด Langchain จะแยกตามเครื่องหมายเหล่านั้นและรวบรวมเอกสารขนาดเล็กที่อยู่ภายใต้ขีดจำกัดของโทเค็น ดูรหัสต่อไปนี้:

LLM ในห่วงโซ่การสรุปคือสิ่งห่อหุ้มรอบตำแหน่งข้อมูล SageMaker ของเรา:

ตอบคำถาม

ในวิธีการสร้างแบบเสริมการดึงข้อมูล อันดับแรก เราจะแบ่งเอกสารออกเป็นส่วนย่อยๆ เราสร้างการฝังสำหรับแต่ละส่วนและจัดเก็บไว้ในฐานข้อมูลเวกเตอร์ Chroma แบบโอเพ่นซอร์สผ่านอินเทอร์เฟซของ langchain เราบันทึกฐานข้อมูลในรูปแบบ ระบบไฟล์ Amazon Elastic ระบบไฟล์ (Amazon EFS) เพื่อใช้ในภายหลัง ดูรหัสต่อไปนี้:

เมื่อการฝังพร้อม ผู้ใช้สามารถถามคำถามได้ เราค้นหาฐานข้อมูลเวกเตอร์สำหรับกลุ่มข้อความที่ตรงกับคำถามมากที่สุด:

เราใช้ส่วนที่ใกล้เคียงที่สุดและใช้เป็นบริบทสำหรับโมเดลการสร้างข้อความเพื่อตอบคำถาม:

ประสบการณ์ของผู้ใช้

แม้ว่า LLM จะเป็นตัวแทนของวิทยาการข้อมูลขั้นสูง แต่กรณีการใช้งานส่วนใหญ่สำหรับ LLM นั้นเกี่ยวข้องกับการโต้ตอบกับผู้ใช้ที่ไม่ใช่ด้านเทคนิค เว็บแอปพลิเคชันตัวอย่างของเราจัดการกรณีการใช้งานเชิงโต้ตอบที่ผู้ใช้ทางธุรกิจสามารถอัปโหลดและประมวลผลเอกสาร PDF ใหม่ได้

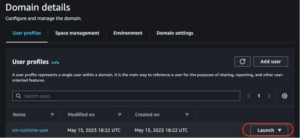

แผนภาพต่อไปนี้แสดงอินเทอร์เฟซผู้ใช้ ผู้ใช้เริ่มต้นด้วยการอัปโหลด PDF หลังจากจัดเก็บเอกสารใน Amazon S3 แล้ว ผู้ใช้สามารถเริ่มงานแยกข้อความได้ เมื่อดำเนินการเสร็จสิ้น ผู้ใช้สามารถเรียกใช้งานการสรุปหรือถามคำถามได้ อินเทอร์เฟซผู้ใช้แสดงตัวเลือกขั้นสูงบางอย่าง เช่น ขนาดก้อนและก้อนซ้อนทับกัน ซึ่งจะเป็นประโยชน์สำหรับผู้ใช้ขั้นสูงที่กำลังทดสอบแอปพลิเคชันในเอกสารใหม่

ขั้นตอนถัดไป

LLM ให้ความสามารถในการดึงข้อมูลใหม่ที่สำคัญ ผู้ใช้ทางธุรกิจจำเป็นต้องเข้าถึงความสามารถเหล่านี้ได้อย่างสะดวก มีสองทิศทางสำหรับการทำงานในอนาคตที่ต้องพิจารณา:

- ใช้ประโยชน์จาก LLM อันทรงพลังที่มีอยู่แล้วในโมเดลพื้นฐานของ Jumpstart ด้วยโค้ดเพียงไม่กี่บรรทัด แอปพลิเคชันตัวอย่างของเราสามารถปรับใช้และใช้ประโยชน์จาก LLM ขั้นสูงจาก AI21 และ Cohere สำหรับการสรุปและสร้างข้อความ

- ทำให้ความสามารถเหล่านี้เข้าถึงได้สำหรับผู้ใช้ที่ไม่ใช่ด้านเทคนิค ข้อกำหนดเบื้องต้นในการประมวลผลเอกสาร PDF คือการแยกข้อความออกจากเอกสาร และงานการสรุปอาจใช้เวลาหลายนาทีในการทำงาน ซึ่งต้องการส่วนต่อประสานผู้ใช้ที่เรียบง่ายพร้อมความสามารถในการประมวลผลแบ็คเอนด์แบบอะซิงโครนัส ซึ่งออกแบบได้ง่ายโดยใช้บริการแบบเนทีฟบนคลาวด์ เช่น Lambda และ Fargate

เราทราบด้วยว่าเอกสาร PDF เป็นข้อมูลกึ่งโครงสร้าง สัญญาณสำคัญ เช่น ส่วนหัวของส่วนนั้นยากที่จะระบุโดยทางโปรแกรม เนื่องจากต้องใช้ขนาดฟอนต์และสัญลักษณ์แสดงภาพอื่นๆ การระบุโครงสร้างพื้นฐานของข้อมูลช่วยให้ LLM ประมวลผลข้อมูลได้แม่นยำยิ่งขึ้น อย่างน้อยก็จนกว่าจะถึงเวลาที่ LLM สามารถจัดการกับอินพุตที่มีความยาวไม่จำกัดได้

สรุป

ในโพสต์นี้ เราได้แสดงวิธีสร้างเว็บแอปพลิเคชันเชิงโต้ตอบที่ให้ผู้ใช้ทางธุรกิจอัปโหลดและประมวลผลเอกสาร PDF สำหรับการสรุปและตอบคำถาม เราได้เห็นวิธีใช้ประโยชน์จากโมเดลพื้นฐาน Jumpstart เพื่อเข้าถึง LLM ขั้นสูง และใช้เทคนิคการแยกข้อความและดึงข้อมูลการสร้างเสริมเพื่อประมวลผลเอกสารที่ยาวขึ้นและทำให้พร้อมใช้งานเป็นข้อมูลสำหรับ LLM

ณ จุดนี้ ไม่มีเหตุผลที่จะไม่ทำให้ความสามารถอันทรงพลังเหล่านี้พร้อมใช้งานสำหรับผู้ใช้ของคุณ เราขอแนะนำให้คุณเริ่มใช้ โมเดลพื้นฐาน Jumpstart ในวันนี้

เกี่ยวกับผู้เขียน

แรนดี เดอโฟว์ เป็นสถาปนิกอาวุโสด้านโซลูชันหลักที่ AWS เขาจบ MSEE จาก University of Michigan ที่ซึ่งเขาทำงานด้านคอมพิวเตอร์วิทัศน์สำหรับยานยนต์ไร้คนขับ เขายังสำเร็จการศึกษา MBA จาก Colorado State University Randy ดำรงตำแหน่งหลากหลายตำแหน่งในแวดวงเทคโนโลยี ตั้งแต่วิศวกรรมซอฟต์แวร์ไปจนถึงการจัดการผลิตภัณฑ์ เข้ามาในพื้นที่ข้อมูลขนาดใหญ่ในปี 2013 และยังคงสำรวจพื้นที่นั้น เขากำลังทำงานอย่างแข็งขันในโครงการในพื้นที่ ML และได้นำเสนอในการประชุมมากมายรวมถึง Strata และ GlueCon

แรนดี เดอโฟว์ เป็นสถาปนิกอาวุโสด้านโซลูชันหลักที่ AWS เขาจบ MSEE จาก University of Michigan ที่ซึ่งเขาทำงานด้านคอมพิวเตอร์วิทัศน์สำหรับยานยนต์ไร้คนขับ เขายังสำเร็จการศึกษา MBA จาก Colorado State University Randy ดำรงตำแหน่งหลากหลายตำแหน่งในแวดวงเทคโนโลยี ตั้งแต่วิศวกรรมซอฟต์แวร์ไปจนถึงการจัดการผลิตภัณฑ์ เข้ามาในพื้นที่ข้อมูลขนาดใหญ่ในปี 2013 และยังคงสำรวจพื้นที่นั้น เขากำลังทำงานอย่างแข็งขันในโครงการในพื้นที่ ML และได้นำเสนอในการประชุมมากมายรวมถึง Strata และ GlueCon

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/use-a-generative-ai-foundation-model-for-summarization-and-question-answering-using-your-own-data/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 10

- 100

- 13

- 14

- 15%

- 2013

- 25

- 40

- 500

- 7

- a

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- เกี่ยวกับมัน

- เข้า

- สามารถเข้าถึงได้

- แม่นยำ

- อย่างกระตือรือร้น

- สูง

- ความได้เปรียบ

- หลังจาก

- AI

- แล้ว

- ด้วย

- แม้ว่า

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Text

- Amazon Web Services

- an

- วิเคราะห์

- และ

- ประจำปี

- อื่น

- คำตอบ

- คำตอบ

- API

- การใช้งาน

- เข้าใกล้

- ประมาณ

- สถาปัตยกรรม

- เป็น

- AREA

- รอบ

- AS

- At

- เติม

- ผู้เขียน

- อิสระ

- ยานพาหนะอิสระ

- ใช้ได้

- AWS

- กลับ

- แบ็กเอนด์

- ตาม

- BE

- เพราะ

- ใหญ่

- ข้อมูลขนาดใหญ่

- ทั้งสอง

- เขตแดน

- แบ่ง

- สร้าง

- ธุรกิจ

- by

- โทรศัพท์

- โทร

- CAN

- ความสามารถในการ

- กรณี

- กรณี

- โซ่

- อักขระ

- อย่างใกล้ชิด

- รหัส

- โคโลราโด

- สมบูรณ์

- ซับซ้อน

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- การประชุม

- พิจารณา

- สร้าง

- บรรจุ

- ภาชนะ

- เนื้อหา

- สิ่งแวดล้อม

- อย่างต่อเนื่อง

- สะดวกสบาย

- ได้

- คอร์ส

- สร้าง

- ข้อมูล

- จุดข้อมูล

- วิทยาศาสตร์ข้อมูล

- ฐานข้อมูล

- หลุดพ้น

- กำหนด

- สาธิต

- ปรับใช้

- อธิบาย

- ออกแบบ

- ยาก

- เอกสาร

- เอกสาร

- ทำ

- แต่ละ

- รายได้

- ง่าย

- ส่งเสริม

- ปลาย

- ปลายทาง

- ชั้นเยี่ยม

- เข้า

- ตัวอย่าง

- เกินกว่า

- สำรวจ

- สารสกัด

- ข้อเท็จจริง

- ความคุ้นเคย

- สองสาม

- เนื้อไม่มีมัน

- ทางการเงิน

- ชื่อจริง

- ดังต่อไปนี้

- สำหรับ

- รากฐาน

- ราคาเริ่มต้นที่

- ด้านหน้า

- ปลายด้านหน้า

- ฟังก์ชัน

- อนาคต

- รุ่น

- กำเนิด

- กำเนิด AI

- ได้รับ

- จัดการ

- จัดการ

- การจัดการ

- มี

- he

- จัดขึ้น

- จะช่วยให้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- ถือ

- เป็นเจ้าภาพ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- ที่ http

- HTTPS

- ร้อย

- แยกแยะ

- ระบุ

- if

- การดำเนินการ

- สำคัญ

- in

- รวมทั้ง

- ตัวชี้วัด

- เป็นรายบุคคล

- ข้อมูล

- อินพุต

- แทรก

- ปฏิสัมพันธ์

- การโต้ตอบ

- น่าสนใจ

- อินเตอร์เฟซ

- เข้าไป

- จะเรียก

- รวมถึง

- IT

- JavaScript

- การสัมภาษณ์

- งาน

- jpg

- เพียงแค่

- คีย์

- ภาษา

- ใหญ่

- ที่มีขนาดใหญ่

- ต่อมา

- น้อยที่สุด

- กฎหมาย

- ความยาว

- ให้

- ช่วยให้

- ห้องสมุด

- กดไลก์

- LIMIT

- Line

- เส้น

- LLM

- loader

- นาน

- อีกต่อไป

- Lot

- ทำ

- จัดการได้

- การจัดการ

- การจับคู่

- การจับคู่

- สูงสุด

- อาจ..

- กลาง

- หน่วยความจำ

- ข่าวสาร

- วิธี

- มิชิแกน

- นาที

- ML

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มากที่สุด

- จำเป็นต้อง

- ไม่เคย

- ใหม่

- ไม่

- ไม่ใช่เทคนิค

- ปกติ

- จำนวน

- มากมาย

- of

- มักจะ

- on

- ครั้งเดียว

- ONE

- โอเพนซอร์ส

- Options

- or

- อื่นๆ

- ของเรา

- ของตนเอง

- หน้า

- หน้า

- ส่วนหนึ่ง

- ผ่าน

- รูปแบบไฟล์ PDF

- เลือก

- คัดสรร

- ภาพ

- ชิ้น

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- จุด

- ตำแหน่ง

- โพสต์

- โพสต์

- ขับเคลื่อน

- ที่มีประสิทธิภาพ

- นำเสนอ

- หลัก

- กระบวนการ

- แปรรูปแล้ว

- การประมวลผล

- ผลิตภัณฑ์

- การจัดการผลิตภัณฑ์

- โครงการ

- ให้

- คำถาม

- คำถาม

- ตั้งแต่

- เกิดปฏิกิริยา

- พร้อม

- เรียลไทม์

- เหตุผล

- วางใจ

- รายงาน

- แสดง

- คำตอบ

- การตอบสนอง

- ผลสอบ

- กลับ

- วิ่ง

- sagemaker

- ลด

- เห็น

- วิทยาศาสตร์

- ค้นหา

- Section

- เห็น

- เห็น

- ส่วน

- กลุ่ม

- ตนเอง

- ระดับอาวุโส

- ลำดับ

- บริการ

- หลาย

- ผู้ถือหุ้น

- แสดงให้เห็นว่า

- แสดง

- แสดงให้เห็นว่า

- สำคัญ

- ง่าย

- ขนาด

- ขนาด

- มีขนาดเล็กกว่า

- So

- ซอฟต์แวร์

- วิศวกรรมซอฟต์แวร์

- ของแข็ง

- ทางออก

- โซลูชัน

- บาง

- ช่องว่าง

- พิเศษ

- แยก

- แยก

- เริ่มต้น

- เริ่มต้น

- สถานะ

- งบ

- ขั้นตอน

- หยุด

- การเก็บรักษา

- จัดเก็บ

- เก็บไว้

- โครงสร้าง

- อย่างเช่น

- สรุป

- สรุป

- แน่ใจ

- ระบบ

- ตาราง

- เอา

- งาน

- เทคนิค

- เทคโนโลยี

- เมตริกซ์

- การทดสอบ

- กว่า

- ที่

- พื้นที่

- พวกเขา

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- เหล่านั้น

- สาม

- ตลอด

- เวลา

- ไปยัง

- ในวันนี้

- โทเค็น

- ราชสกุล

- เรียก

- สอง

- เป็นปกติ

- ในที่สุด

- ภายใต้

- พื้นฐาน

- มหาวิทยาลัย

- จนกระทั่ง

- อัปโหลด

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ส่วนติดต่อผู้ใช้

- ผู้ใช้

- ใช้

- การใช้

- ความหลากหลาย

- ยานพาหนะ

- มาก

- ผ่านทาง

- วิสัยทัศน์

- ต้องการ

- we

- เว็บ

- โปรแกรมประยุกต์บนเว็บ

- บริการเว็บ

- เมื่อ

- ที่

- WHO

- จะ

- กับ

- คำ

- งาน

- ทำงาน

- การทำงาน

- จะ

- คุณ

- ของคุณ

- ลมทะเล