เมื่อวันอังคาร Google และ Intel ได้เปิดตัวชิป AI ของตัวเองเพื่อท้าทาย Nvidia เนื่องจากการแข่งขันเพื่อผลิตเซมิคอนดักเตอร์ขั้นสูงเพื่อขับเคลื่อนโมเดล AI ที่สร้างพลังงานเช่น ChatGPT หรือ Gemini เข้มข้นขึ้น

Google เปิดตัว Cloud TPU v5p และ Intel เปิดตัวโปรเซสเซอร์ Gaudi 3 AI ชิปดังกล่าวได้รับการออกแบบมาเพื่อเพิ่มประสิทธิภาพในการฝึกอบรมระบบ AI ตลอดจน 'การรันซอฟต์แวร์ที่เสร็จสมบูรณ์'

อ่านเพิ่มเติม: Quake ของไต้หวันรบกวนศูนย์กลางชิป AI หลัก คุกคามอุปทานทั่วโลก

ฝึกอบรม LLM ด้วยความเร็วที่มากขึ้น

Google ได้ประกาศเปิดตัว TPU หรือหน่วยประมวลผลเทนเซอร์ใหม่เป็นครั้งแรกในเดือนธันวาคมพร้อมกับ Gemini โดยกล่าวว่า TPU v5p ซึ่งขณะนี้เปิดให้นักพัฒนาใช้งานได้แล้ว ถือเป็นโปรเซสเซอร์ AI ที่ “ทรงพลังและปรับขนาดได้” มากที่สุดเท่าที่เคยมีมา

บริษัทอ้างว่าชิปที่อัปเดตสามารถฝึกโมเดลภาษาขนาดใหญ่ (LLM) ซึ่งเป็นเทคโนโลยีที่อยู่เบื้องหลังแชทบอท AI เมถุน และ ChatGPTเร็วกว่า Google TPU v4 รุ่นก่อนถึงสามเท่า กล่าวว่าชิป AI ให้ปริมาณงานมากกว่าเวอร์ชันเก่าถึง 12 เท่า

“ตอนนี้อยู่ในรุ่นที่ห้าแล้ว ความก้าวหน้าเหล่านี้ [สำหรับ TPU ของ Google] ได้ช่วยให้ลูกค้าฝึกฝนและให้บริการโมเดลภาษาที่ล้ำสมัย” Sundar Pichai ซีอีโอของ Google กล่าวในงานของบริษัทในลาสเวกัส ตาม ให้กับสื่ออุตสาหกรรม

[เนื้อหาฝัง]

ในขณะที่เป้าหมายคือการท้าทาย Nvidia บริษัทสหรัฐฯ ที่ผลิตชิป AI มากถึง 90% ที่เรียกว่าหน่วยประมวลผลกราฟิกหรือ GPU แต่ Google แสดงให้เห็นว่ายังคงขึ้นอยู่กับ Nvidia

ในแบบเดียวกัน โพสต์บล็อก Google ประกาศเปิดตัว TPU ล่าสุด โดยกล่าวว่ากำลังอัปเกรดซูเปอร์คอมพิวเตอร์ A3 ซึ่งขับเคลื่อนโดย เอ็นวิเดีย H100 หน่วยประมวลผลกราฟิก บริษัทยังเปิดเผยว่ากำลังใช้ GPU ล่าสุดของ Nvidia Blackwellในไฮเปอร์คอมพิวเตอร์ AI

Google ยังได้เปิดตัว Axion ซึ่งเป็นหน่วยประมวลผลกลาง (CPU) แบบกำหนดเองใหม่สำหรับศูนย์ข้อมูลที่สร้างขึ้นโดยใช้เทคโนโลยีของ Arm บริษัท สหราชอาณาจักร โดยกล่าวว่า Axion ซึ่งเป็นคู่แข่งกับ CPU จาก Microsoft, Amazon และ Meta สามารถจัดการงานต่างๆ ได้ รวมถึงการค้นหาของ Google และการทำงานของ AI

จากข้อมูลของ Google Axion ให้ “ประสิทธิภาพที่ดีกว่าอินสแตนซ์แบบ Arm สำหรับการใช้งานทั่วไปที่เร็วที่สุดถึง 30% ที่มีอยู่ในระบบคลาวด์ในปัจจุบัน” และ “ประสิทธิภาพที่ดีขึ้นสูงสุดถึง 50% และประสิทธิภาพการใช้พลังงานที่ดีขึ้นสูงสุดถึง 60%” เมื่อเทียบกับ Arm วัตถุประสงค์ทั่วไปอื่นๆ ชิป.

Intel: AI ทุกที่

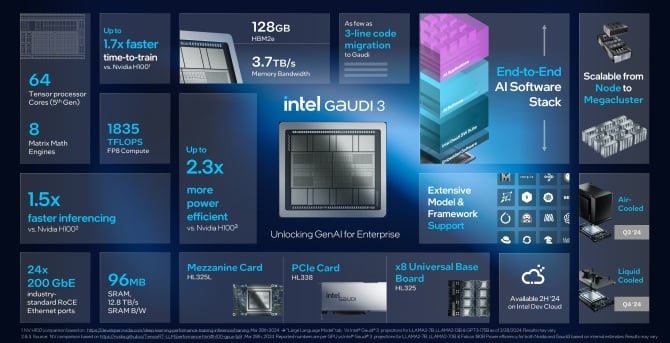

เมื่อวันอังคารที่ผ่านมา Intel ยังประกาศเปิดตัวโปรเซสเซอร์ปัญญาประดิษฐ์รุ่นใหม่ Gaudi 3 โดยบริษัทกล่าวว่าชิป Gaudi 3 ประหยัดพลังงานมากกว่าสองเท่าของ H100 GPU ของ Nvidia และสามารถเรียกใช้โมเดล AI ได้เพียงครั้งเดียว เร็วขึ้นครึ่งเท่า

“นวัตกรรมกำลังก้าวหน้าอย่างรวดเร็วอย่างที่ไม่เคยมีมาก่อน ซึ่งทั้งหมดนี้ขับเคลื่อนด้วยซิลิคอน และทุกบริษัทก็กำลังกลายเป็นบริษัท AI อย่างรวดเร็ว” Pat Gelsinger ซีอีโอของ Intel กล่าวใน คำสั่ง- “Intel นำ AI ไปทุกที่ทั่วทั้งองค์กร ตั้งแต่พีซีไปจนถึงศูนย์ข้อมูลไปจนถึง Edge

🔎

__

********– มุนเดีย ไบรอัน (@Mundia_Brian_) April 9, 2024

Gelsinger ไม่ได้ระบุว่า Gaudi 3 จะมีราคาเท่าไร Bloomberg รายงานแต่กล่าวว่าสิ่งที่เรียกว่าชิปเร่งความเร็วของบริษัทของเขาจะ "ต่ำกว่ามาก" ในราคาของชิปปัจจุบันและอนาคตของ Nvidia พวกเขาจะเสนอต้นทุนรวมในการเป็นเจ้าของที่ "ดีมาก" เขากล่าวเสริม

Intel อ้างว่าชิปล่าสุดจะมอบ "การก้าวกระโดดครั้งสำคัญ" ในการฝึกอบรมและการอนุมาน AI สำหรับหน่วยงานที่ทำงานเกี่ยวกับ AI แบบกำเนิด บริษัทที่ฝึกอบรมระบบ AI ต้องการให้พวกเขาสามารถคาดการณ์เพื่อตอบคำถามจริง ซึ่งเรียกว่าการอนุมาน

จากข้อมูลของ Intel Gaudi 3 จะเร็วกว่าและประหยัดพลังงานมากกว่า H100 และโมเดลภาษาขนาดใหญ่ทั้งหมดที่ฝึกฝนโดยใช้ GPU เช่น Meta's Llama หรือ Falcon ที่พูดได้หลายภาษาของ Abu Dhabì กล่าวว่าชิปสามารถช่วยฝึกโมเดลต่างๆ เช่น Stable Diffusion หรือ Whisper จาก OpenAI เพื่อการรู้จำเสียง

บริษัทกล่าวว่าในการฝึกอบรมประเภทนี้ Gaudi 3 เร็วขึ้น 1.7 เท่า และรันซอฟต์แวร์ได้ดีกว่า 1.5 เท่า ประสิทธิภาพของชิป AI นั้นเทียบได้กับ B200 ใหม่ของ Nvidia Intel กล่าว ซึ่งทำได้ดีเยี่ยมในบางพื้นที่และตามหลังในด้านอื่นๆ

Intel กล่าวว่าชิป Gaudi 3 ใหม่จะวางจำหน่ายให้กับลูกค้าในไตรมาสที่สาม และบริษัทต่างๆ รวมถึง Supermicro, Dell และ HP จะสร้างระบบด้วยตัวเร่ง AI

NVIDIA ที่ท้าทาย

บริษัทต่างๆ ที่กำลังสร้างระบบ generative AI กำลังมองหาวิธีลดต้นทุนโดยเลิกพึ่งพา GPU ของ Nvidia ซึ่งมีราคาแพง

ในปี 2023 Amazon ใช้เงินประมาณ 65 ล้านดอลลาร์ในการฝึกอบรมครั้งเดียว ตามที่วิศวกรซอฟต์แวร์ James Hamilton กล่าว เขาคาดว่าตัวเลขดังกล่าวจะทะลุ 1 พันล้านดอลลาร์ในเร็วๆ นี้

สัปดาห์ที่แล้ว OpenAI และ Microsoft เปิดเผย วางแผนที่จะสร้างศูนย์ข้อมูลมูลค่า 100 พันล้านดอลลาร์สำหรับการฝึกอบรม AI ที่มีชื่อว่า 'Stargate' และในเดือนมกราคม Mark Zuckerberg ซีอีโอของ Meta กล่าวว่าบริษัทของเขาวางแผนที่จะใช้จ่าย 9 พันล้านดอลลาร์กับ Nvidia GPU เพียงอย่างเดียว

บริษัทเทคโนโลยีรายใหญ่ทุกแห่งซื้อชิปจาก Nvidia แต่พวกเขาก็เริ่มสร้างชิปของตัวเองหรือซื้อจาก AMD ซึ่งเปิดตัว GPU สำหรับศูนย์ข้อมูลตัวใหม่ที่เรียกว่า MI300X เมื่อปีที่แล้ว AMD วางแผนที่จะขยายและขายชิปปัญญาประดิษฐ์เพิ่มเติมให้กับเซิร์ฟเวอร์ในปีนี้

คู่แข่งของ Google Microsoft, Meta [ทั้งลูกค้า AMD] และ Amazon ต่างก็พัฒนาชิป AI ของตัวเองเช่นกัน อย่างไรก็ตาม มันไม่ใช่เรื่องง่าย เมื่อต้นปีที่ผ่านมา Nvidia ได้เปิดตัว GPU B100 และ B200 ซึ่งเป็นรุ่นต่อจาก H100 ซึ่งมีแนวโน้มว่าจะมีประสิทธิภาพเพิ่มขึ้น ชิปดังกล่าวคาดว่าจะเริ่มจัดส่งได้ภายในปี 2024

AI boom และ H100 ช่วยได้สองเท่า รายได้ของ Nvidia และยกระดับมูลค่าตลาดเป็นมากกว่า 2 ล้านล้านดอลลาร์ ทำให้เป็นหนึ่งในบริษัทที่ประสบความสำเร็จมากที่สุดในวอลล์สตรีท

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :เป็น

- :ไม่

- $ 1 พันล้าน

- $ 65 ล้าน

- $ 9 พันล้าน

- $ ขึ้น

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- สามารถ

- คันเร่ง

- ตาม

- ข้าม

- ที่เพิ่ม

- สูง

- ความก้าวหน้า

- advancing

- มาแล้ว

- AI

- โมเดล AI

- ระบบ AI

- การฝึกอบรม AI

- จุดมุ่งหมาย

- ทั้งหมด

- คนเดียว

- คู่ขนาน

- ด้วย

- อเมซอน

- เอเอ็มดี

- an

- และ

- ประกาศ

- ประกาศ

- เป็น

- พื้นที่

- ARM

- รอบ

- เทียม

- ปัญญาประดิษฐ์

- AS

- At

- ใช้ได้

- BE

- สมควร

- หลัง

- เบื้องหลัง

- ดีกว่า

- พันล้าน

- บลูมเบิร์ก

- ความเจริญ

- เพิ่ม

- ทั้งสอง

- ไบรอัน

- นำมาซึ่ง

- การนำ

- สร้าง

- การก่อสร้าง

- สร้าง

- แต่

- ซื้อ

- by

- ที่เรียกว่า

- CAN

- ศูนย์

- ศูนย์

- ส่วนกลาง

- ผู้บริหารสูงสุด

- ท้าทาย

- chatbots

- ChatGPT

- ชิป

- ชิป

- การเรียกร้อง

- เมฆ

- บริษัท

- บริษัท

- บริษัท

- เทียบเคียง

- คู่แข่ง

- เนื้อหา

- ราคา

- ค่าใช้จ่าย

- ปัจจุบัน

- ประเพณี

- ลูกค้า

- ตัด

- ข้อมูล

- ศูนย์ข้อมูล

- ศูนย์ข้อมูล

- ศูนย์ข้อมูล

- ธันวาคม

- ส่งมอบ

- มอบ

- Dell

- ขึ้นอยู่กับ

- ได้รับการออกแบบ

- พัฒนา

- นักพัฒนา

- DID

- การจัดจำหน่าย

- ถ่วง

- สอง

- ลง

- ขนานนามว่า

- ก่อน

- ง่าย

- ขอบ

- ที่ฝัง

- เปิดการใช้งาน

- วิศวกร

- Enterprise

- หน่วยงาน

- เหตุการณ์

- ทุกๆ

- ทุกที่

- แสดง

- ที่คาดหวัง

- คาดว่า

- แพง

- เร็วขึ้น

- ที่เร็วที่สุด

- รูป

- บริษัท

- บริษัท

- ชื่อจริง

- สำหรับ

- ราคาเริ่มต้นที่

- อนาคต

- กําไร

- เมถุน

- General

- จุดประสงค์ทั่วไป

- รุ่น

- กำเนิด

- กำเนิด AI

- เหตุการณ์ที่

- ไป

- Google Cloud

- ของ Google

- GPU

- GPUs

- กราฟิก

- แฮมิลตัน

- จัดการ

- มี

- he

- ช่วย

- ช่วย

- จุดสูง

- ของเขา

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- อย่างไรก็ตาม

- HTTPS

- Hub

- in

- รวมทั้ง

- อุตสาหกรรม

- อินเทล

- Intelligence

- ทวีความรุนแรง

- แนะนำ

- IT

- ITS

- เจมส์

- มกราคม

- jpg

- เพียงแค่

- ที่รู้จักกัน

- ภาษา

- ใหญ่

- LAS

- ลาสเวกัส

- ชื่อสกุล

- ปีที่แล้ว

- ต่อมา

- ล่าสุด

- เปิดตัว

- เปิดตัว

- กดไลก์

- ดูรายละเอียด

- ที่ต้องการหา

- Lot

- สำคัญ

- ทำ

- การทำ

- เครื่องหมาย

- zuckerberg ทำเครื่องหมาย

- ตลาด

- ความกว้างสูงสุด

- ภาพบรรยากาศ

- Meta

- ไมโครซอฟท์

- ล้าน

- โมเดล

- ข้อมูลเพิ่มเติม

- มากที่สุด

- มาก

- จำเป็นต้อง

- ใหม่

- ตอนนี้

- Nvidia

- of

- เสนอ

- เก่า

- on

- ONE

- OpenAI

- การดำเนินการ

- or

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- เกิน

- ของตนเอง

- การเป็นเจ้าของ

- ก้าว

- PC

- การปฏิบัติ

- แผน

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- อำนาจ

- ขับเคลื่อน

- บรรพบุรุษ

- การคาดการณ์

- การประมวลผล

- หน่วยประมวลผล

- แวว

- ให้

- วัตถุประสงค์

- สั่นสะเทือน

- หนึ่งในสี่

- คำถาม

- อย่างรวดเร็ว

- เชื่อชาติ

- มาถึง

- อ่าน

- จริง

- การรับรู้

- การเผยแพร่

- อาศัย

- คำตอบ

- เปิดเผย

- การแข่งขัน

- คู่แข่ง

- วิ่ง

- วิ่ง

- กล่าวว่า

- เดียวกัน

- พูดว่า

- ฉาก

- ค้นหา

- ขาย

- อุปกรณ์กึ่งตัวนำ

- ให้บริการ

- เซิร์ฟเวอร์

- การส่งสินค้า

- แสดงให้เห็นว่า

- สำคัญ

- ซิลิคอน

- เดียว

- ซอฟต์แวร์

- วิศวกรซอฟต์แวร์

- บาง

- ในไม่ช้า

- การพูด

- การรู้จำเสียง

- ใช้จ่าย

- การใช้จ่าย

- มั่นคง

- เริ่มต้น

- ข้อความที่เริ่ม

- สถานะ

- ยังคง

- ถนน

- ที่ประสบความสำเร็จ

- อย่างเช่น

- Sundar พิชัย

- ซูเปอร์คอมพิวเตอร์

- วัสดุสิ้นเปลือง

- ระบบ

- งาน

- เทคโนโลยี

- เทคโนโลยี

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- ตัวเอง

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- ที่สาม

- นี้

- ในปีนี้

- สาม

- ปริมาณงาน

- ครั้ง

- ไปยัง

- รวม

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- การฝึกอบรม

- ล้านล้าน

- จริง

- อังคาร

- สองครั้ง

- ชนิด

- Uk

- หน่วย

- หน่วย

- เป็นประวัติการณ์

- เปิดตัว

- ให้กับคุณ

- us

- การใช้

- การประเมินค่า

- ต่างๆ

- สเวกัส

- รุ่น

- ผนัง

- Wall Street

- สัปดาห์

- ดี

- ที่

- กระซิบ

- จะ

- กับ

- การทำงาน

- จะ

- ปี

- ยัง

- YouTube

- ลมทะเล

- Zuckerberg