นับตั้งแต่ที่ ChatGPT แพร่หลายเข้าสู่แวดวงเทคโนโลยีในเดือนพฤศจิกายนปีที่แล้ว ก็ช่วยให้ผู้คนเขียนเนื้อหาทุกประเภท สร้างโค้ด และค้นหาข้อมูลได้ บริษัทและแบบจำลองภาษาขนาดใหญ่ (LLM) อื่นๆ ได้ช่วยอำนวยความสะดวกตั้งแต่การโทรหาฝ่ายบริการลูกค้าไปจนถึงการรับคำสั่งอาหารจานด่วน เมื่อพิจารณาว่า LLM มีประโยชน์ต่อมนุษย์มากน้อยเพียงใดในช่วงเวลาสั้นๆ ที่พวกเขาอยู่รอบๆ ChatGPT สำหรับหุ่นยนต์อาจส่งผลต่อความสามารถในการเรียนรู้และทำสิ่งใหม่ๆ อย่างไร นักวิจัยที่ Google DeepMind ตัดสินใจค้นหาและเผยแพร่การค้นพบของพวกเขาใน โพสต์บล็อก และเอกสารเผยแพร่เมื่อสัปดาห์ที่แล้ว

พวกเขาเรียกระบบของพวกเขาว่า RT-2 ย่อมาจาก Robotics Transformer 2 และเป็นตัวต่อจาก หุ่นยนต์ทรานฟอร์เมอร์1ซึ่งบริษัทเปิดตัวเมื่อปลายปีที่แล้ว RT-1 มีพื้นฐานมาจากโปรแกรมภาษาและการมองเห็นขนาดเล็ก และได้รับการฝึกฝนมาโดยเฉพาะเพื่อให้ทำงานหลายอย่าง ซอฟต์แวร์นี้ใช้ใน Alphabet X's หุ่นยนต์ประจำวันทำให้พวกเขาทำงานต่างๆ ได้มากกว่า 700 งานด้วยอัตราความสำเร็จ 97 เปอร์เซ็นต์ แต่เมื่อได้รับคำสั่งให้ทำงานใหม่ที่พวกเขาไม่ได้รับการฝึก หุ่นยนต์ที่ใช้ RT-1 กลับประสบความสำเร็จเพียง 32 เปอร์เซ็นต์เท่านั้น

RT-2 เพิ่มอัตรานี้เกือบสองเท่า โดยทำงานใหม่สำเร็จ 62 เปอร์เซ็นต์ของเวลาที่ได้รับคำสั่ง นักวิจัยเรียก RT-2 ว่าโมเดลวิชั่นภาษาแอคชั่น (VLA) ใช้ข้อความและรูปภาพที่เห็นทางออนไลน์เพื่อเรียนรู้ทักษะใหม่ๆ มันไม่ง่ายอย่างที่คิด ซอฟต์แวร์จำเป็นต้อง "เข้าใจ" แนวคิดก่อน จากนั้นจึงใช้ความเข้าใจนั้นกับคำสั่งหรือชุดคำสั่ง จากนั้นจึงดำเนินการตามคำสั่งเหล่านั้น

ตัวอย่างหนึ่งที่ผู้เขียนเสนอคือการกำจัดขยะ ในรุ่นก่อนหน้านี้ ซอฟต์แวร์ของหุ่นยนต์จะต้องได้รับการฝึกอบรมก่อนจึงจะระบุถังขยะได้ ตัวอย่างเช่น หากมีกล้วยที่ปอกแล้วบนโต๊ะโดยมีเปลือกอยู่ข้างๆ บอตจะแสดงว่าเปลือกเป็นขยะในขณะที่กล้วยนั้นไม่ใช่ จากนั้นจะสอนวิธีการหยิบเปลือก ย้ายไปยังถังขยะ และฝากไว้ที่นั่น

แม้ว่า RT-2 จะทำงานแตกต่างกันเล็กน้อย เนื่องจากโมเดลได้รับการฝึกฝนเกี่ยวกับข้อมูลและข้อมูลจากอินเทอร์เน็ตจำนวนมาก จึงมีความเข้าใจโดยทั่วไปว่าขยะคืออะไร และแม้ว่าจะไม่ได้รับการฝึกให้ทิ้งขยะ แต่ก็สามารถรวมขั้นตอนต่างๆ เข้าด้วยกันเพื่อทำภารกิจนี้ให้สำเร็จได้

LLM ที่นักวิจัยใช้ในการฝึก RT-2 คือ PaLI-X (การมองเห็นและโมเดลภาษาที่มีพารามิเตอร์ 55 พันล้านพารามิเตอร์) และ ปาล์ม-อี (สิ่งที่ Google เรียกว่าโมเดลภาษาหลายรูปแบบที่เป็นตัวเป็นตน ซึ่งพัฒนาขึ้นสำหรับหุ่นยนต์โดยเฉพาะ โดยมีพารามิเตอร์ 12 พันล้านพารามิเตอร์) “พารามิเตอร์” หมายถึงแอตทริบิวต์ที่โมเดลแมชชีนเลิร์นนิงกำหนดตามข้อมูลการฝึกอบรม ในกรณีของ LLM พวกเขาจำลองความสัมพันธ์ระหว่างคำในประโยคและชั่งน้ำหนักว่าคำหนึ่งๆ จะนำหน้าหรือตามด้วยคำอื่นมากน้อยเพียงใด

การค้นหาความสัมพันธ์และรูปแบบระหว่างคำในชุดข้อมูลขนาดยักษ์ แบบจำลองจะเรียนรู้จากการอนุมานของตนเอง ในที่สุดพวกเขาสามารถเข้าใจได้ว่าแนวคิดที่แตกต่างกันเกี่ยวข้องกันอย่างไรและแยกแยะบริบทได้ ในกรณีของ RT-2 จะแปลความรู้นั้นเป็นคำสั่งทั่วไปสำหรับการกระทำของหุ่นยนต์

การกระทำเหล่านั้นจะแสดงแทนโทเค็นสำหรับหุ่นยนต์ ซึ่งโดยปกติจะใช้เพื่อแสดงข้อความภาษาธรรมชาติในรูปแบบของเศษคำ ในกรณีนี้ โทเค็นเป็นส่วนหนึ่งของการกระทำ และซอฟต์แวร์จะรวมโทเค็นหลายตัวเข้าด้วยกันเพื่อดำเนินการ โครงสร้างนี้ยังช่วยให้ซอฟต์แวร์ดำเนินการให้เหตุผลแบบห่วงโซ่แห่งความคิด ซึ่งหมายความว่าสามารถตอบสนองต่อคำถามหรือการแจ้งเตือนที่ต้องใช้เหตุผลในระดับหนึ่ง

ตัวอย่างที่ทีมให้ ได้แก่ การเลือกวัตถุเพื่อใช้เป็นค้อนเมื่อไม่มีค้อน (หุ่นยนต์เลือกหิน) และการเลือกเครื่องดื่มที่ดีที่สุดสำหรับคนที่เหนื่อยล้า (หุ่นยนต์เลือกเครื่องดื่มชูกำลัง)

“RT-2 แสดงความสามารถในการสรุปทั่วไปที่ดีขึ้นและความเข้าใจความหมายและภาพนอกเหนือจากข้อมูลหุ่นยนต์ที่เปิดเผย” นักวิจัยเขียนใน Google โพสต์บล็อก. “ซึ่งรวมถึงการตีความคำสั่งใหม่และการตอบสนองต่อคำสั่งของผู้ใช้โดยการใช้เหตุผลเบื้องต้น เช่น การให้เหตุผลเกี่ยวกับหมวดหมู่วัตถุหรือคำอธิบายระดับสูง”

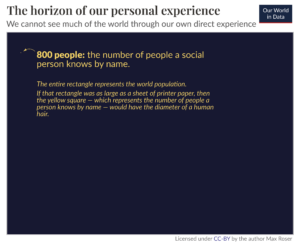

ความฝันของ หุ่นยนต์อเนกประสงค์ ที่สามารถช่วยเหลือมนุษย์ในทุกสิ่งที่อาจเกิดขึ้นได้ ไม่ว่าจะเป็นในบ้าน สถานที่เชิงพาณิชย์ หรือในโรงงานอุตสาหกรรม จะไม่สามารถทำได้จนกว่าหุ่นยนต์จะเรียนรู้ได้จากทุกที่ สิ่งที่ดูเหมือนสัญชาตญาณพื้นฐานที่สุดสำหรับเราคือสำหรับหุ่นยนต์ การผสมผสานที่ซับซ้อนของการทำความเข้าใจบริบท ความสามารถในการให้เหตุผลผ่านมัน และการดำเนินการเพื่อแก้ปัญหาที่ไม่ได้คาดว่าจะปรากฏขึ้น การเขียนโปรแกรมให้พวกมันตอบสนองอย่างเหมาะสมกับสถานการณ์ที่ไม่ได้วางแผนไว้นั้นเป็นไปไม่ได้ ดังนั้นพวกมันจึงต้องสามารถสรุปและเรียนรู้จากประสบการณ์ได้เช่นเดียวกับมนุษย์

RT-2 เป็นขั้นตอนในทิศทางนี้ นักวิจัยรับทราบว่า แม้ว่า RT-2 สามารถสรุปแนวคิดเชิงความหมายและภาพได้ แต่ยังไม่สามารถเรียนรู้การกระทำใหม่ ๆ ได้ด้วยตัวมันเอง แต่จะใช้การกระทำที่รู้อยู่แล้วกับสถานการณ์ใหม่ บางที RT-3 หรือ 4 จะสามารถยกระดับทักษะเหล่านี้ไปอีกระดับ ในขณะเดียวกันในขณะที่ทีมสรุปใน โพสต์บล็อก“ในขณะที่ยังมีงานอีกมากที่ต้องทำเพื่อให้หุ่นยนต์ที่เป็นประโยชน์ในสภาพแวดล้อมที่มีมนุษย์เป็นศูนย์กลาง RT-2 แสดงให้เราเห็นถึงอนาคตที่น่าตื่นเต้นสำหรับวิทยาการหุ่นยนต์ที่อยู่แค่เอื้อม”

เครดิตภาพ: Google DeepMind

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- :มี

- :เป็น

- :ไม่

- $ ขึ้น

- 12

- 32

- 700

- a

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- รับทราบ

- การกระทำ

- การปฏิบัติ

- ทั้งหมด

- Alphabet

- แล้ว

- ด้วย

- จำนวน

- an

- และ

- อื่น

- ที่คาดว่าจะ

- ใช้

- อย่างเหมาะสม

- เป็น

- รอบ

- AS

- At

- ผู้เขียน

- ใช้ได้

- ไป

- กล้วย

- ตาม

- ขั้นพื้นฐาน

- BE

- รับ

- กำลัง

- ที่ดีที่สุด

- ระหว่าง

- เกิน

- พันล้าน

- ธ ปท

- ของเล่นเพิ่มพัฒนาสมอง

- แต่

- by

- โทรศัพท์

- โทร

- CAN

- ความสามารถในการ

- พกพา

- กรณี

- หมวดหมู่

- ChatGPT

- เลือก

- รหัส

- การผสมผสาน

- อย่างไร

- เชิงพาณิชย์

- บริษัท

- สมบูรณ์

- ซับซ้อน

- แนวคิด

- แนวความคิด

- สิ่งแวดล้อม

- เครดิต

- ลูกค้า

- บริการลูกค้า

- ข้อมูล

- ตัดสินใจ

- Deepmind

- กำหนด

- องศา

- ฝากเงิน

- พัฒนา

- ต่าง

- ทิศทาง

- do

- ทำ

- คู่ผสม

- ฝัน

- ดื่ม

- แต่ละ

- ทำให้สามารถ

- ช่วยให้

- การเปิดใช้งาน

- ปลาย

- พลังงาน

- สภาพแวดล้อม

- ในที่สุด

- ตัวอย่าง

- น่าตื่นเต้น

- ประสบการณ์

- ที่เปิดเผย

- การอำนวยความสะดวก

- FAST

- รูป

- หา

- หา

- ผลการวิจัย

- ชื่อจริง

- ตาม

- อาหาร

- สำหรับ

- ฟอร์ม

- ราคาเริ่มต้นที่

- อนาคต

- General

- สร้าง

- ยักษ์

- ให้

- กำหนด

- จะช่วยให้

- Go

- เข้าใจ

- ค้อน

- มี

- ช่วย

- เป็นประโยชน์

- การช่วยเหลือ

- ระดับสูง

- หน้าแรก

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- HTTPS

- มนุษย์

- แยกแยะ

- if

- ภาพ

- ส่งผลกระทบ

- เป็นไปไม่ได้

- การปรับปรุง

- in

- ประกอบด้วย

- รวมถึง

- อุตสาหกรรม

- ข้อมูล

- คำแนะนำการใช้

- อินเทอร์เน็ต

- เข้าไป

- IT

- ITS

- jpg

- เพียงแค่

- ความรู้

- ภาษา

- ใหญ่

- ชื่อสกุล

- ปีที่แล้ว

- เรียนรู้

- การเรียนรู้

- ช่วยให้

- ชั้น

- กดไลก์

- น่าจะ

- น้อย

- โหลด

- เครื่อง

- เรียนรู้เครื่อง

- หลาย

- วัสดุ

- ความกว้างสูงสุด

- อาจ..

- ความหมาย

- ขณะ

- อาจ

- แบบ

- โมเดล

- มากที่สุด

- ย้าย

- หลาย

- โดยธรรมชาติ

- จำเป็นต้อง

- ใหม่

- ถัดไป

- ไม่

- พฤศจิกายน

- วัตถุ

- of

- on

- ออนไลน์

- เพียง

- ไปยัง

- or

- คำสั่งซื้อ

- อื่นๆ

- ออก

- เกิน

- ของตนเอง

- กระดาษ

- พารามิเตอร์

- ส่วน

- รูปแบบ

- คน

- เปอร์เซ็นต์

- ดำเนินการ

- ที่มีประสิทธิภาพ

- บางที

- คน

- เลือก

- ชิ้น

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- ป๊อป

- ก่อน

- ปัญหาที่เกิดขึ้น

- โครงการ

- การเขียนโปรแกรม

- การตีพิมพ์

- คำถาม

- คะแนน

- ค่อนข้าง

- เกิดปฏิกิริยา

- เหตุผล

- หมายถึง

- ความสัมพันธ์

- การเผยแพร่

- แสดง

- เป็นตัวแทนของ

- ต้องการ

- ต้อง

- นักวิจัย

- ตอบสนอง

- การตอบสนอง

- หุ่นยนต์

- หุ่นยนต์

- หุ่นยนต์

- หิน

- s

- สถานการณ์

- ฉาก

- ดูเหมือนว่า

- เห็น

- ประโยค

- บริการ

- ชุด

- การตั้งค่า

- สั้น

- แสดง

- แสดงให้เห็นว่า

- ง่าย

- ตั้งแต่

- ทักษะ

- เล็ก

- So

- ซอฟต์แวร์

- แก้

- บาง

- เฉพาะ

- ขั้นตอน

- ขั้นตอน

- ยังคง

- โครงสร้าง

- ความสำเร็จ

- ที่ประสบความสำเร็จ

- ประสบความสำเร็จ

- อย่างเช่น

- ระบบ

- ตาราง

- เอา

- การ

- งาน

- งาน

- สอน

- ทีม

- เทคโนโลยี

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- แล้วก็

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- นี้

- เหล่านั้น

- แต่?

- ตลอด

- เวลา

- เหนื่อย

- ไปยัง

- ร่วมกัน

- ราชสกุล

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- หม้อแปลงไฟฟ้า

- มหึมา

- ความเข้าใจ

- จนกระทั่ง

- us

- ใช้

- มือสอง

- ผู้ใช้งาน

- ใช้

- การใช้

- มักจะ

- ความหลากหลาย

- วิสัยทัศน์

- คือ

- สัปดาห์

- ชั่งน้ำหนัก

- คือ

- อะไร

- อะไรก็ตาม

- เมื่อ

- ที่

- ในขณะที่

- จะ

- กับ

- ภายใน

- คำ

- คำ

- งาน

- โรงงาน

- จะ

- เขียน

- เขียน

- X's

- ปี

- ยัง

- ลมทะเล