GPU เป็นเครื่องมือที่ทรงพลังสำหรับเวิร์กโหลดการเรียนรู้ด้วยเครื่อง แม้ว่าไม่จำเป็นต้องเป็นเครื่องมือที่เหมาะสมสำหรับงาน AI ทุกงานก็ตาม Michael Bronstein หัวหน้าฝ่ายวิจัยการเรียนรู้กราฟของ Twitter กล่าว

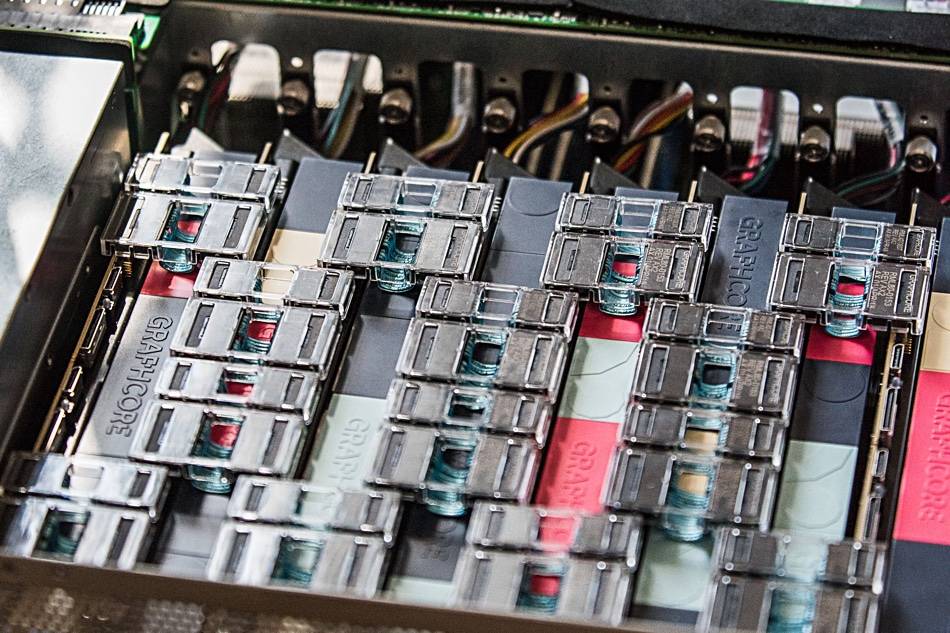

เมื่อเร็วๆ นี้ ทีมงานของเขาได้แสดงให้เห็นว่าฮาร์ดแวร์ AI ของ Graphcore เสนอ "ลำดับความสำคัญของการเร่งความเร็วเมื่อเปรียบเทียบโปรเซสเซอร์ IPU ตัวเดียวกับ GPU Nvidia A100" ในโมเดลเครือข่ายกราฟชั่วคราว (TGN)

"การเลือกฮาร์ดแวร์สำหรับการนำโมเดล Graph ML ไปใช้เป็นปัญหาสำคัญแต่มักถูกมองข้าม" a . กล่าว บทความร่วมกัน เขียนโดย Bronstein กับ Emanuele Rossi นักวิจัย ML ที่ Twitter และ Daniel Justus นักวิจัยที่ Graphcore

โครงข่ายกราฟนิวรัลเสนอวิธีการค้นหาลำดับในระบบที่ซับซ้อน และมักใช้ในเครือข่ายสังคมออนไลน์และระบบผู้แนะนำ อย่างไรก็ตาม ลักษณะแบบไดนามิกของสภาพแวดล้อมเหล่านี้ทำให้โมเดลเหล่านี้มีความท้าทายเป็นพิเศษในการฝึก ทั้งสามอธิบาย

กลุ่มนี้ตรวจสอบความสามารถในการทำงานของ IPU ของ Graphcore ในการจัดการโมเดล TGN หลายรุ่น การทดสอบเบื้องต้นดำเนินการกับโมเดล TGN ขนาดเล็กโดยอ้างอิงจาก โจดี้ ชุดข้อมูล Wikipedia ที่เชื่อมโยงผู้ใช้กับการแก้ไขที่ทำกับเพจ กราฟประกอบด้วยผู้ใช้ 8,227 ราย และบทความ 1,000 บทความ รวมเป็น 9,227 โหนด JODIE เป็นระบบการทำนายโอเพนซอร์สที่ออกแบบมาเพื่อให้เข้าใจถึงเครือข่ายปฏิสัมพันธ์ชั่วคราว

การทดลองของทั้งสามคนเปิดเผยว่าขนาดแบทช์ขนาดใหญ่ส่งผลให้การตรวจสอบความถูกต้องและความแม่นยำในการอนุมานลดลง เมื่อเทียบกับขนาดแบทช์ที่เล็กกว่า

"ทั้งหน่วยความจำของโหนดและการเชื่อมต่อของกราฟจะได้รับการอัปเดตหลังจากประมวลผลแบตช์ทั้งหมดแล้วเท่านั้น" ทั้งสามคนเขียน “ดังนั้น เหตุการณ์ภายหลังภายในชุดเดียวอาจใช้ข้อมูลที่ล้าสมัยเนื่องจากไม่ทราบเหตุการณ์ก่อนหน้า”

อย่างไรก็ตาม ด้วยการใช้ขนาดแบทช์ที่ 10 กลุ่มสามารถบรรลุการตรวจสอบความถูกต้องและการอนุมานได้อย่างเหมาะสมที่สุด แต่พวกเขาสังเกตเห็นว่าประสิทธิภาพบน IPU ยังคงเหนือกว่าของ GPU แม้ว่าจะใช้แบทช์ขนาดใหญ่ก็ตาม

“เมื่อใช้ด้านแบตช์ 10, TGN สามารถฝึกบน IPU ได้เร็วขึ้น 11 เท่า และถึงแม้จะมีขนาดแบทช์ใหญ่ถึง 200 ก็ตาม การฝึกบน IPU ก็ยังเร็วขึ้นสามเท่า” โพสต์ระบุ “ตลอดการดำเนินงานทั้งหมด IPU สามารถจัดการขนาดแบทช์ขนาดเล็กได้อย่างมีประสิทธิภาพมากขึ้น”

ทีมงานวางตัวว่าการเข้าถึงหน่วยความจำที่รวดเร็วและปริมาณงานสูงที่เสนอโดยแคช SRAM ในตัวประมวลผลขนาดใหญ่ของ Graphcore ทำให้ IPU ได้เปรียบ

ประสิทธิภาพการทำงานนี้ยังขยายไปถึงโมเดลกราฟที่เกินหน่วยความจำในโปรเซสเซอร์ของ IPU — IPU แต่ละตัวมีแคช SRAM ขนาด 1GB — ต้องใช้หน่วยความจำ DRAM ที่ช้ากว่าที่ต่อกับชิป

ทีมของ Bronstein พบว่าในการทดสอบแบบจำลองกราฟที่มีผู้ติดตาม 261 ล้านคนระหว่างผู้ใช้ Twitter 15.5 ล้านคน การใช้ DRAM สำหรับหน่วยความจำของโหนดนั้นลดปริมาณการรับส่งข้อมูลลงได้เพียง XNUMX เท่า

อย่างไรก็ตาม เมื่อสร้างกราฟย่อยหลายๆ กราฟโดยใช้ชุดข้อมูลสังเคราะห์ที่มีขนาดเป็น 10 เท่าของกราฟ Twitter ทีมงานพบว่าปริมาณงานได้รับการปรับขนาดโดยไม่ขึ้นกับขนาดกราฟ กล่าวอีกนัยหนึ่ง ประสิทธิภาพที่กระทบเป็นผลมาจากการใช้หน่วยความจำที่ช้าลง ไม่ใช่ผลของขนาดของโมเดล

“การใช้เทคนิคนี้บน IPU ทำให้ TGN สามารถนำไปใช้กับขนาดกราฟได้แทบทุกขนาด โดยถูกจำกัดด้วยจำนวนหน่วยความจำโฮสต์ที่มีอยู่ ในขณะที่ยังคงอัตราการส่งข้อมูลที่สูงมากระหว่างการฝึกและการอนุมาน” บทความกล่าว

ทีมงานสรุปว่าสถาปัตยกรรม IPU ของ Graphcore แสดงให้เห็นถึงข้อได้เปรียบเหนือ GPU ในเวิร์กโหลดที่การประมวลผลและการเข้าถึงหน่วยความจำต่างกัน

อย่างไรก็ตาม ประเด็นที่กว้างกว่านั้นก็คือ นักวิจัย ML ควรพิจารณาการเลือกฮาร์ดแวร์อย่างรอบคอบ และไม่ควรใช้ GPU เริ่มต้นโดยปริยาย

"ความพร้อมใช้งานของบริการคลาวด์คอมพิวติ้งที่แยกส่วนฮาร์ดแวร์พื้นฐานออกมาทำให้เกิดความเกียจคร้านในเรื่องนี้" ทั้งสามคนเขียน “เราหวังว่าการศึกษาของเราจะดึงความสนใจไปที่หัวข้อที่สำคัญนี้มากขึ้นและปูทางสำหรับอัลกอริธึมและสถาปัตยกรรมฮาร์ดแวร์ในอนาคตที่มีประสิทธิภาพมากขึ้นสำหรับแอปพลิเคชัน Graph ML” ®

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลงทะเบียน

- ลมทะเล