Son büyük dil modelleri (LLM'ler), doğal dil anlayışında muazzam ilerleme sağlamıştır. Bununla birlikte, kendinden emin ancak anlamsız açıklamalar üretmeye eğilimlidirler, bu da kullanıcılarla güven tesis etmenin önünde önemli bir engel teşkil eder. Bu yazıda, bu görevlerdeki performansı artırmak için çok sekmeli akıl yürütme için yanlış akıl yürütme zincirlerine insan geri bildiriminin nasıl dahil edileceğini gösteriyoruz. İnsanlara sorarak muhakeme zincirlerini sıfırdan toplamak yerine, LLM'lerin yönlendirme yeteneklerini kullanarak model tarafından üretilen muhakeme zincirlerine ilişkin zengin insan geri bildirimlerinden öğreniyoruz. StratejiQA ve Spor Anlayışı veri kümeleri için (düzeltme, açıklama, hata türü) biçiminde bu tür iki insan geri bildirimi veri kümesi topluyoruz ve bu tür geri bildirimlerden öğrenmek için birkaç yaygın algoritmayı değerlendiriyoruz. Önerdiğimiz yöntemler, temel Flan-T5'i kullanarak düşünce zinciri yönlendirmesinde rekabetçi bir performans sergiliyor ve bizimki, kendi cevabının doğruluğunu yargılamada daha iyi.

Çözüme genel bakış

Büyük dil modellerinin başlamasıyla birlikte, alan çeşitli doğal dil işleme (NLP) ölçütlerinde muazzam bir ilerleme kaydetti. Bunlar arasında, çok sekmeli soru yanıtlama gibi muhakeme gerektiren daha zor görevlerle karşılaştırıldığında, kısa bağlam veya olgusal soru yanıtlama gibi nispeten daha basit görevlerde ilerleme dikkat çekicidir. LLM'leri kullanan belirli görevlerin performansı, daha küçük ölçeklerde rastgele tahmin etmeye benzer olabilir, ancak daha büyük ölçeklerde önemli ölçüde iyileşir. Buna rağmen, LLM'lerin yönlendirme yetenekleri, soruyu cevaplamak için gereken bazı ilgili gerçekleri sağlama potansiyeline sahiptir.

Ancak, bu modeller güvenilir bir şekilde doğru muhakeme zincirlerini veya açıklamalarını üretmeyebilir. Bu kendinden emin ama anlamsız açıklamalar, LLM'ler, ödül hacklemenin meydana gelebileceği İnsan Geri Bildiriminden Takviyeli Öğrenim (RLHF) kullanılarak eğitildiğinde daha da yaygındır.

Bundan motive olarak, aşağıdaki araştırma sorusunu ele almaya çalışıyoruz: model tarafından üretilen muhakeme zincirleri hakkında insan geri bildirimlerinden öğrenerek LLM'lerin muhakemesini geliştirebilir miyiz? Aşağıdaki şekil, yaklaşımımıza genel bir bakış sunmaktadır: önce modeli çok sekmeli sorular için akıl yürütme zincirleri oluşturmaya yönlendiririz, ardından teşhis için bu zincirler hakkında çeşitli insan geri bildirimleri toplarız ve toplanan verilerden öğrenmek için eğitim algoritmaları öneririz.

BigBench'ten, iki çok sekmeli muhakeme veri seti, StrategyQA ve Sports Anlayışı hakkında çeşitli insan geri bildirimleri topluyoruz. Her soru ve model tarafından oluşturulan muhakeme zinciri için, doğru muhakeme zincirini, model tarafından oluşturulan muhakeme zincirindeki hatanın türünü ve sağlanan muhakeme zincirinde bu hatanın neden sunulduğuna dair bir açıklamayı (doğal dilde) topluyoruz. Nihai veri seti, StrategyQA'dan 1,565 örnek ve Spor Anlayışı için 796 örnek için geri bildirim içerir.

Toplanan geri bildirimlerden öğrenmek için birden fazla eğitim algoritması öneriyoruz. İlk olarak, geri bildirimden öğrenilebilen ağırlıklı bir varyantını göz önünde bulundurarak, düşünce zinciri yönlendirmesinde kendi kendine tutarlılığın bir varyantını öneriyoruz. İkinci olarak, model tarafından üretilen muhakeme zincirini doğru olana kadar yinelemeli olarak iyileştirdiğimiz yinelemeli iyileştirme öneriyoruz. Önerilen algoritmaları kullanarak bir LLM'ye, yani Flan-T5'e ince ayar yapmanın bağlam içi öğrenme temeli ile karşılaştırılabilir şekilde performans gösterdiğini iki veri kümesi üzerinde ampirik olarak gösteriyoruz. Daha da önemlisi, ince ayarlanmış modelin temel Flan-T5 modeline kıyasla kendi cevabının doğru olup olmadığına karar vermede daha iyi olduğunu gösteriyoruz.

Bilgi toplama

Bu bölümde, topladığımız geri bildirimlerin ayrıntılarını ve veri toplama sırasında izlenen açıklama protokolünü açıklıyoruz. İki muhakeme tabanlı veri setine dayalı olarak model nesilleri için geri bildirim topladık: BigBench'ten StratejiQA ve Spor Anlayışı. GPT-J'yi, StrategyQA'nın yanıtını oluşturmak için ve Flan-T5'i, Spor Anlayışı veri kümesinin yanıtını oluşturmak için kullandık. Her durumda, modele soru, cevap ve açıklama içeren k bağlam içi örnek ve ardından test sorusu verildi.

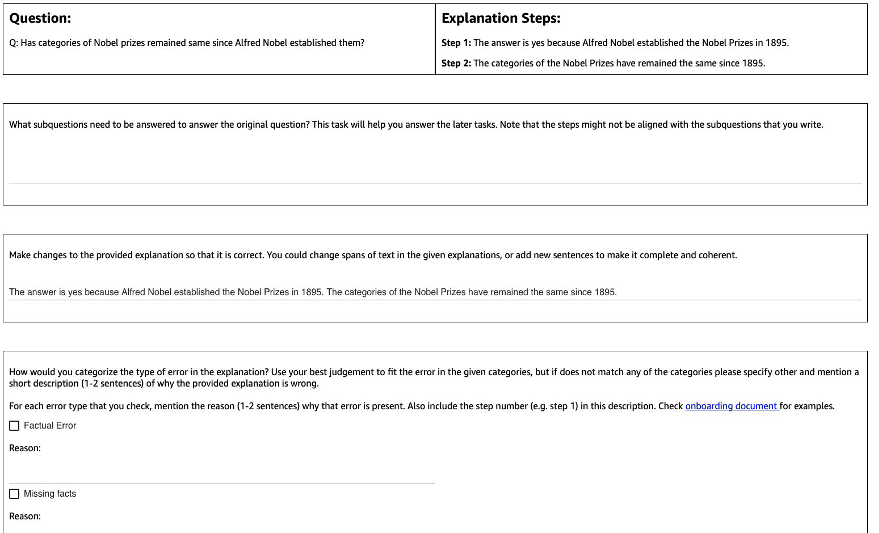

Aşağıdaki şekil kullandığımız arayüzü göstermektedir. Açıklayıcılara soru, model tarafından oluşturulan yanıt verilir ve açıklama adımlara bölünür.

Her soru için aşağıdaki geri bildirimleri topladık:

- alt sorular – Ek açıklamalar yapanlar, orijinal soruyu, orijinal soruyu cevaplamak için gerekli olan daha basit alt sorulara ayrıştırır. Bu görev, bu görevi eklemenin ek açıklama yapanları hazırlamaya ve diğer görevlerin kalitesini artırmaya yardımcı olduğunu bulduğumuz bir pilot uygulamadan sonra eklendi.

- Düzeltme – Ek açıklamalar yapanlara, model tarafından oluşturulan yanıt ve açıklama ile önceden doldurulmuş serbest biçimli bir metin kutusu sağlanır ve doğru yanıt ve açıklamayı elde etmek için düzenlemeleri istenir.

- Hata türü – Model nesillerinde bulduğumuz en yaygın hata türleri arasında (Olgusal Hata, Eksik Gerçekler, Alakasız Gerçekler ve Mantıksal Tutarsızlık), açıklama yapanlardan verilen cevap ve açıklama için geçerli olan bir veya daha fazla hata türünü seçmeleri istendi.

- Hata tanımlaması – Açıklayıcılara, yalnızca hataları sınıflandırmakla kalmayıp, aynı zamanda, hatanın oluştuğu tam adımı ve bunun verilen cevap ve açıklamaya nasıl uygulanacağını tam olarak belirtmek de dahil olmak üzere, kategorizasyonları için kapsamlı bir gerekçe sunmaları talimatı verildi.

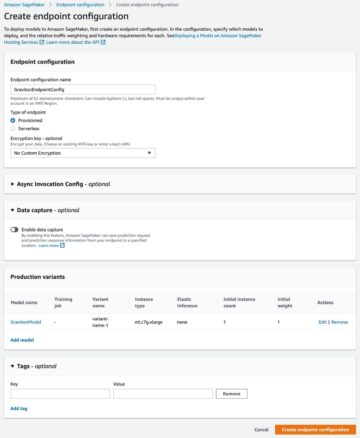

Kullandığımız Amazon SageMaker Temel Gerçek Artı veri koleksiyonumuzda. Veri toplama birden fazla turda gerçekleşti. İlk olarak sırasıyla 30 örnek ve 200 örnekten oluşan iki küçük pilot uygulama gerçekleştirdik, ardından açıklama ekibine ek açıklama hakkında ayrıntılı geri bildirim verildi. Daha sonra, StrategyQA için iki grup ve Spor Anlayışı için bir grup üzerinden veri toplama işlemini yürüttük ve baştan sona periyodik geri bildirimler verdik; toplam 10 açıklayıcı, 1 aya yakın bir süre boyunca görev üzerinde çalıştı.

StratejiQA için toplam 1,565 örnek ve Spor Anlayışı için 796 örnek hakkında geri bildirim topladık. Aşağıdaki tablo, model oluşturmada hatasız olan örneklerin yüzdesini ve belirli bir hata türü içeren örneklerin oranını göstermektedir. Bazı örneklerin birden fazla hata türüne sahip olabileceğini belirtmekte fayda var.

| Hata Tipi | StratejiQA | Spor Anlayışı |

| Hayır | İNDİRİM | İNDİRİM |

| Gerçek Hata | İNDİRİM | İNDİRİM |

| Eksik Gerçekler | İNDİRİM | İNDİRİM |

| Alakasız Gerçekler | İNDİRİM | İNDİRİM |

| Mantıksal Tutarsızlık | İNDİRİM | İNDİRİM |

Öğrenme algoritmaları

her soru için qve model tarafından oluşturulan yanıt ve açıklama m, şu geri bildirimleri topladık: doğru cevap ve açıklama c, mevcut hata türü m (ile gösterilir t) ve hata açıklaması d, önceki bölümde açıklandığı gibi.

Aşağıdaki yöntemleri kullandık:

- Çoklu görev öğrenme – Mevcut çeşitli geri bildirimlerden öğrenmek için basit bir temel, her birini ayrı bir görev olarak ele almaktır. Daha somut olarak, Flan-T5'i (metinden metne) hedefle ince ayar yapıyoruz maksimuma çıkarmak p(c|q) + p(t|q, m) + p(d|q, m). Amaçtaki her terim için, göreve uygun ayrı bir talimat kullanırız (örneğin, "Verilen cevaptaki hatayı tahmin et"). Kategorik değişkeni de dönüştürüyoruz t doğal bir dil cümlesi içine. Çıkarım sırasında, terim için talimatı kullanırız. p(c|q) (“Verilen soru için doğru cevabı tahmin edin”) test sorusunun cevabını oluşturmak için.

- Ağırlıklı öz tutarlılık – Düşünce zinciri yönlendirmesindeki kendi kendine tutarlılığın başarısından motive olarak, bunun ağırlıklı bir varyantını öneriyoruz. Modelden örneklenen her açıklamayı doğru kabul etmek ve toplam oyları dikkate almak yerine, önce açıklamanın doğru olup olmadığını değerlendirir ve ardından buna göre toplulaştırırız. İlk önce Flan-T5'i çoklu görev öğrenimiyle aynı hedefle ince ayarlıyoruz. Çıkarım sırasında, verilen bir test sorusu q, talimatıyla birden fazla olası yanıtı örnekliyoruz p(c|q)): a1, a2, .., an. Örneklenen her yanıt için ai, terim için talimatı kullanırız p(t|q, m) ("Verilen yanıttaki hatayı tahmin edin") hata içerip içermediğini belirlemek için ti = argmaks p(t|q, a_i). Her cevap ai doğruysa 1 ağırlık atanır, aksi takdirde 1'den küçük bir ağırlık atanır (ayarlanabilir hiperparametre). Nihai cevap, tüm cevaplar üzerinden ağırlıklı bir oylama dikkate alınarak elde edilir. a1 için an.

- Yinelemeli iyileştirme – Daha önce önerilen yöntemlerde, model doğrudan doğru cevabı üretir. c soruya bağlı q. Burada, model tarafından oluşturulan yanıtı iyileştirmeyi öneriyoruz m Belirli bir soru için doğru cevabı elde etmek için. Daha spesifik olarak, önce Flan-T5'te (amaçla metinden metne) ince ayar yaparız. maksimize p(t; c|q, m), Burada ; birleştirmeyi belirtir (hata türü t ardından doğru cevap c). Bu hedefi görmenin bir yolu, modelin önce verilen nesildeki hatayı tanımlamak için eğitilmesidir. mve sonra doğru cevabı almak için bu hatayı kaldırmak için c. Çıkarım sırasında, bir test sorusu verildiğinde doğru cevabı üretene kadar modeli yinelemeli olarak kullanabiliriz. q, önce ilk model neslini elde ederiz m (önceden eğitilmiş Flan-T5 kullanılarak). Daha sonra yinelemeli olarak hata türünü oluşturuyoruz ti ve potansiyel doğru cevap ci kadar ti = hata yok (uygulamada, bir hiperparametre için maksimum yineleme sayısını belirleriz), bu durumda nihai doğru cevap şu olacaktır: ci-1 (şuradan alındı p(ti ; ci | q, ci-1)).

Sonuçlar

Her iki veri seti için, önerilen tüm öğrenme algoritmalarını bağlam içi öğrenme temeli ile karşılaştırdık. Tüm modeller, StratejiQA ve Spor Anlayışı geliştirici setinde değerlendirilir. Aşağıdaki tablo sonuçları göstermektedir.

| Yöntem | StratejiQA | Spor Anlayışı |

| Flan-T5 4 atışlık Düşünce Zinciri Bağlam İçi Öğrenme | % 67.39 ± 2.6 | İNDİRİM |

| Çoklu Görev Öğrenimi | % 66.22 ± 0.7 | % 54.3 ± 2.1 |

| Ağırlıklı Öz Tutarlılık | % 61.13 ± 1.5 | % 51.3 ± 1.9 |

| Yinelemeli İyileştirme | % 61.85 ± 3.3 | % 57.0 ± 2.5 |

Gözlemlendiği gibi, bazı yöntemler, model çıktıları hakkında insanlardan sürekli geri bildirim toplama ve bunu dil modellerini geliştirmek için kullanma potansiyelini gösteren bağlam içi öğrenme temel çizgisiyle (StratejiQA için çoklu görev ve Spor Anlayışı için yinelemeli iyileştirme) karşılaştırılabilir performans gösterir. Bu, geri bildirimin kategorik ve genellikle ikili ile sınırlı olduğu RLHF gibi son çalışmalardan farklıdır.

Aşağıdaki tabloda gösterildiği gibi, muhakeme hatalarına ilişkin insan geri bildirimi ile uyarlanan modellerin kalibrasyonu veya kendinden emin yanlış açıklamaların farkındalığını iyileştirmeye nasıl yardımcı olabileceğini araştırıyoruz. Bu, modelin üretiminin herhangi bir hata içerip içermediğini tahmin etmesini isteyerek değerlendirilir.

| Yöntem | Hata Düzeltme | StratejiQA |

| Flan-T5 4 atışlık Düşünce Zinciri Bağlam İçi Öğrenme | Yok hayır | İNDİRİM |

| Çoklu Görev İnce Ayarlı Model | Evet | İNDİRİM |

Daha ayrıntılı olarak, dil modelini kendi ürettiği yanıt ve akıl yürütme zinciriyle (bunun için geri bildirim topladık) yönlendiririz ve ardından üretimdeki hatayı tahmin etmesi için tekrar yönlendiririz. Görev için uygun talimatı kullanıyoruz (“Yanıttaki hatayı tanımlayın”). Model, üretimde “hata yok” veya “doğru” öngörüyorsa, yorumlayıcılar örneği hatasız olarak etiketliyorsa veya üretimdeki hata türlerinden herhangi birini (“yanlış” veya “yanlış” ile birlikte) tahmin ediyorsa doğru olarak puanlanır. yanlış"), açıklayıcılar bunu bir hata olarak etiketlediğinde. Modelin hata türünü doğru bir şekilde belirleme yeteneğini değil, bir hata olup olmadığını değerlendirdiğimize dikkat edin. Değerlendirme, StratejiQA dev setinden toplanan ve ince ayar sırasında görülmeyen 173 ek örnekten oluşan bir set üzerinde yapılır. Bunlardan dördü dil modelini yönlendirmek için ayrılmıştır (önceki tabloda ilk satır).

Model yararlı yanıtlar oluşturamadığı için 0 atış temel sonucunu göstermediğimize dikkat edin. Muhakeme zincirlerinde hata düzeltme için insan geri bildirimi kullanmanın, modelin hata yapıp yapmadığına dair tahminini iyileştirebileceğini, bunun da yanlış açıklamaların farkındalığını veya kalibrasyonunu artırabileceğini gözlemliyoruz.

Sonuç

Bu yazıda, LLM'lerin muhakeme yeteneklerini geliştirmenin alternatif bir yolu olan ince taneli hata düzeltmeleriyle insan geri bildirim veri kümelerinin nasıl iyileştirileceğini gösterdik. Deneysel sonuçlar, muhakeme hatalarına ilişkin insan geri bildiriminin zorlu çok sekmeli sorularda performansı ve kalibrasyonu iyileştirebileceğini doğrulamaktadır.

Büyük dil modellerinizi geliştirmek için insan geri bildirimi arıyorsanız, şu adresi ziyaret edin: Amazon SageMaker Veri Etiketleme ve Ground Truth Plus konsolu.

Yazarlar Hakkında

erran li humain-in-the-loop hizmetlerinde, AWS AI, Amazon'da uygulamalı bilim yöneticisidir. Araştırma ilgi alanları, 3D derin öğrenme ve vizyon ve dil temsili öğrenmedir. Daha önce Alexa AI'da kıdemli bilim insanı, Scale AI'da makine öğrenimi başkanı ve Pony.ai'de baş bilim insanıydı. Bundan önce, otonom sürüş için makine öğrenimi, makine öğrenimi sistemleri ve yapay zekanın stratejik girişimleri üzerinde çalışan Uber ATG'deki algı ekibi ve Uber'deki makine öğrenimi platformu ekibiyle birlikteydi. Kariyerine Bell Laboratuarlarında başladı ve Columbia Üniversitesi'nde yardımcı profesördü. ICML'17 ve ICCV'19'da ortak eğitimler verdi ve NeurIPS, ICML, CVPR, ICCV'de otonom sürüş için makine öğrenimi, 3D görüş ve robotik, makine öğrenimi sistemleri ve çekişmeli makine öğrenimi üzerine birkaç çalıştayın eş düzenleyicisi oldu. Cornell Üniversitesi'nde bilgisayar bilimi alanında doktorası var. Kendisi bir ACM Üyesi ve IEEE Üyesidir.

erran li humain-in-the-loop hizmetlerinde, AWS AI, Amazon'da uygulamalı bilim yöneticisidir. Araştırma ilgi alanları, 3D derin öğrenme ve vizyon ve dil temsili öğrenmedir. Daha önce Alexa AI'da kıdemli bilim insanı, Scale AI'da makine öğrenimi başkanı ve Pony.ai'de baş bilim insanıydı. Bundan önce, otonom sürüş için makine öğrenimi, makine öğrenimi sistemleri ve yapay zekanın stratejik girişimleri üzerinde çalışan Uber ATG'deki algı ekibi ve Uber'deki makine öğrenimi platformu ekibiyle birlikteydi. Kariyerine Bell Laboratuarlarında başladı ve Columbia Üniversitesi'nde yardımcı profesördü. ICML'17 ve ICCV'19'da ortak eğitimler verdi ve NeurIPS, ICML, CVPR, ICCV'de otonom sürüş için makine öğrenimi, 3D görüş ve robotik, makine öğrenimi sistemleri ve çekişmeli makine öğrenimi üzerine birkaç çalıştayın eş düzenleyicisi oldu. Cornell Üniversitesi'nde bilgisayar bilimi alanında doktorası var. Kendisi bir ACM Üyesi ve IEEE Üyesidir.

Nitiş Joshi AWS AI, Amazon'da uygulamalı bilim stajyeriydi. New York Üniversitesi Courant Institute of Mathematical Sciences'ta bilgisayar bilimleri alanında Prof. He He'nin danışmanlığında doktora öğrencisidir. Makine Öğrenimi ve Doğal Dil İşleme üzerine çalışıyor ve Machine Learning for Language (ML2) araştırma grubuna üye. Sağlam dil anlayışıyla genel olarak ilgileniyordu: hem dağıtım değişimlerine dayanıklı modeller oluşturmakla (örn. döngüdeki insan veri artırma yoluyla) hem de modellerin sağlamlığını değerlendirmek/ölçmek için daha iyi yollar tasarlamakla. Ayrıca, bağlam içi öğrenme ve nasıl çalıştığını anlama konusundaki son gelişmeleri merak ediyor.

Nitiş Joshi AWS AI, Amazon'da uygulamalı bilim stajyeriydi. New York Üniversitesi Courant Institute of Mathematical Sciences'ta bilgisayar bilimleri alanında Prof. He He'nin danışmanlığında doktora öğrencisidir. Makine Öğrenimi ve Doğal Dil İşleme üzerine çalışıyor ve Machine Learning for Language (ML2) araştırma grubuna üye. Sağlam dil anlayışıyla genel olarak ilgileniyordu: hem dağıtım değişimlerine dayanıklı modeller oluşturmakla (örn. döngüdeki insan veri artırma yoluyla) hem de modellerin sağlamlığını değerlendirmek/ölçmek için daha iyi yollar tasarlamakla. Ayrıca, bağlam içi öğrenme ve nasıl çalıştığını anlama konusundaki son gelişmeleri merak ediyor.

Kumar Chellapilla Amazon Web Services'ta Genel Müdür ve Direktördür ve döngü içinde insan sistemleri, AI DevOps, Geospatial ML ve ADAS/Otonom Araç geliştirme gibi ML/AI Hizmetlerinin geliştirilmesine öncülük eder. AWS'den önce Kumar, Uber ATG ve Lyft Level 5'te Mühendislik Direktörüydü ve algılama ve haritalama gibi kendi kendine sürüş yetenekleri geliştirmek için makine öğrenimini kullanan ekiplere liderlik etti. Ayrıca LinkedIn, Twitter, Bing ve Microsoft Research'te aramayı, önerileri ve reklam ürünlerini iyileştirmek için makine öğrenimi tekniklerini uygulama konusunda çalıştı.

Kumar Chellapilla Amazon Web Services'ta Genel Müdür ve Direktördür ve döngü içinde insan sistemleri, AI DevOps, Geospatial ML ve ADAS/Otonom Araç geliştirme gibi ML/AI Hizmetlerinin geliştirilmesine öncülük eder. AWS'den önce Kumar, Uber ATG ve Lyft Level 5'te Mühendislik Direktörüydü ve algılama ve haritalama gibi kendi kendine sürüş yetenekleri geliştirmek için makine öğrenimini kullanan ekiplere liderlik etti. Ayrıca LinkedIn, Twitter, Bing ve Microsoft Research'te aramayı, önerileri ve reklam ürünlerini iyileştirmek için makine öğrenimi tekniklerini uygulama konusunda çalıştı.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Adryenn Ashley ile Geleceği Basmak. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- yeteneklerini

- kabiliyet

- Hakkımızda

- göre

- ACM

- katma

- ekleme

- Ek

- adres

- düşmanca

- reklâm

- Bağlı

- Sonra

- tekrar

- AI

- Alexa

- algoritmalar

- Türkiye

- boyunca

- Ayrıca

- alternatif

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- arasında

- an

- ve

- cevap

- cevaplar

- herhangi

- uygulamalı

- Tamam

- Uygulanması

- yaklaşım

- uygun

- ARE

- AS

- atanmış

- At

- özerk

- mevcut

- farkındalık

- AWS

- baz

- merkezli

- Temel

- BE

- Çünkü

- olmuştur

- önce

- Çan

- kriterler

- Daha iyi

- Bing

- her ikisi de

- kutu

- geniş

- bina

- bina modelleri

- fakat

- by

- CAN

- yetenekleri

- Kariyer

- dava

- belli

- zincir

- zincirler

- zor

- baş

- sınıflandırmak

- Kapanış

- toplamak

- Toplama

- Toplamak

- KOLOMBİYA

- ortak

- karşılaştırılabilir

- karşılaştırmak

- karşılaştırıldığında

- kapsamlı

- bilgisayar

- Bilgisayar Bilimleri

- yürütülen

- emin

- kendine güvenerek

- Düşünmek

- düşünen

- konsolos

- içeren

- bağlam

- dönüştürmek

- Cornell

- Düzeltmeler

- doğrulamak

- meraklı

- veri

- veri kümeleri

- derin

- derin öğrenme

- göstermek

- gösteriyor

- tanımlamak

- tarif edilen

- tanım

- tasarım

- Rağmen

- ayrıntı

- detaylı

- ayrıntılar

- dev

- geliştirmek

- gelişme

- gelişmeler

- farklı

- direkt olarak

- yönetmen

- dağıtım

- çeşitli

- do

- yapılmış

- Dont

- sürme

- sırasında

- e

- her

- etkin

- Mühendislik

- hata

- Hatalar

- kurulması

- değerlendirmek

- değerlendirilir

- değerlendirme

- Hatta

- örnek

- örnekler

- açıklama

- geribesleme

- adam

- alan

- şekil

- son

- Ad

- takip

- takip etme

- İçin

- Airdrop Formu

- bulundu

- dört

- itibaren

- toplama

- genel

- oluşturmak

- oluşturulan

- üretir

- üreten

- nesil

- nesiller

- Jeo-uzamsal makine öğrenimi

- Vermek

- verilmiş

- Verilmesi

- Zemin

- grup

- hack

- Var

- sahip olan

- he

- baş

- yardım et

- yardımcı olur

- okuyun

- onun

- Ne kadar

- Nasıl Yapılır

- Ancak

- HTTPS

- insan

- İnsanlar

- belirlemek

- IEEE

- if

- göstermektedir

- iyileştirmek

- in

- Dahil olmak üzere

- birleştirmek

- ilk

- girişimler

- yerine

- Enstitü

- ilgili

- ilgi alanları

- arayüzey

- içine

- araştırmak

- IT

- yineleme

- ONUN

- jpg

- Labs

- dil

- büyük

- büyük

- İlanlar

- ÖĞRENİN

- öğrendim

- öğrenme

- Led

- seviye

- Sınırlı

- Yüksek Lisans

- mantıksal

- bakıyor

- Lyft

- makine

- makine öğrenme

- YAPAR

- müdür

- haritalama

- matematiksel

- maksimum

- Mayıs..

- yöntemleri

- Microsoft

- eksik

- hata

- hataları

- ML

- ml2

- model

- modelleri

- Ay

- Daha

- çoğu

- motive

- çoklu

- yani

- Doğal (Madenden)

- Doğal Dil İşleme

- yeni

- New York

- nlp

- yok hayır

- numara

- nesnel

- gözlemek

- engel

- elde etmek

- elde

- oluştu

- of

- on

- ONE

- devam

- bir tek

- başlangıç

- or

- orijinal

- aksi takdirde

- bizim

- dışarı

- tekrar

- genel bakış

- kendi

- yüzde

- algı

- Yapmak

- performans

- gerçekleştirir

- dönem

- periyodik

- seçmek

- pilot

- yer

- platform

- Platon

- Plato Veri Zekası

- PlatoVeri

- artı

- pozlar

- mümkün

- Çivi

- potansiyel

- uygulama

- tahmin

- tahmin

- öngörür

- Hazırlamak

- mevcut

- sundu

- yaygın

- önceki

- Önceden

- Önceki

- işleme

- Ürünler

- profesör

- Ilerleme

- oran

- önermek

- önerilen

- protokol

- sağlamak

- sağlanan

- sağlar

- kalite

- soru

- Sorular

- rasgele

- daha doğrusu

- son

- tavsiyeler

- arıtmak

- Nispeten

- uygun

- Kaldır

- temsil

- gerektirir

- gereklidir

- araştırma

- ayrılmış

- sırasıyla

- DİNLENME

- sonuç

- Sonuçlar

- Ödüllendirmek

- Zengin

- robotik

- gürbüz

- sağlamlık

- mermi

- SIRA

- sagemaker

- aynı

- ölçek

- ölçek ai

- terazi

- Bilim

- BİLİMLERİ

- bilim adamı

- Ara

- İkinci

- Bölüm

- görüldü

- SELF

- Kendi kendine sürüş

- kıdemli

- cümle

- ayrı

- Hizmetler

- set

- birkaç

- Vardiyalar

- kısa

- şov

- gösterilen

- Gösteriler

- önemli

- önemli ölçüde

- benzer

- Basit

- küçük

- daha küçük

- biraz

- özel

- özellikle

- bölmek

- Spor

- başladı

- adım

- Basamaklar

- Stratejik

- Öğrenci

- başarı

- böyle

- Sistemler

- tablo

- Görev

- görevleri

- takım

- takım

- teknikleri

- test

- göre

- o

- The

- ve bazı Asya

- Onları

- sonra

- Bunlar

- onlar

- Re-Tweet

- Bu

- İçinden

- için

- Toplam

- eğitilmiş

- Eğitim

- tedavi etmek

- tedavi

- muazzam

- Güven

- Hakikat

- Öğreticiler

- iki

- tip

- türleri

- Uber

- anlayış

- üniversite

- kullanım

- Kullanılmış

- kullanıcılar

- kullanma

- genellikle

- Varyant

- çeşitli

- araç

- Görüntüle

- vizyonumuz

- Türkiye Dental Sosyal Medya Hesaplarından bizi takip edebilirsiniz.

- Oy

- oldu

- Yol..

- yolları

- we

- ağ

- web hizmetleri

- ağırlık

- vardı

- ne zaman

- olup olmadığını

- hangi

- neden

- irade

- ile

- İş

- işlenmiş

- çalışma

- çalışır

- Atölyeler

- değer

- Yanlış

- york

- zefirnet