Üretken yapay zeka uygulamalarının çok çeşitli sektörlerdeki başarısı, dünya çapında rakiplerinin başarılarını yeniden üretip aşmak veya yeni ve heyecan verici kullanım senaryolarını çözmek isteyen şirketlerin dikkatini ve ilgisini çekti. Bu müşteriler, üretken yapay zeka yeniliğine güç veren motorlar olarak TII Falcon, Stable Diffusion XL veya OpenAI'nin GPT-3.5'i gibi temel modellere bakıyor.

Temel modeller, üzerinde eğitildikleri büyük miktardaki yapılandırılmamış veriler sayesinde insan benzeri içerikleri anlama ve üretme kapasitesine sahip bir üretken yapay zeka modelleri sınıfıdır. Bu modeller, görüntü oluşturma, çeviri ve soru yanıtlama dahil olmak üzere çeşitli bilgisayarlı görme (CV) ve doğal dil işleme (NLP) görevlerinde devrim yarattı. Birçok yapay zeka uygulamasının yapı taşları olarak hizmet veriyorlar ve gelişmiş akıllı sistemlerin geliştirilmesinde çok önemli bir bileşen haline geldiler.

Ancak temel modellerin uygulamaya konulması, özellikle maliyet ve kaynak gereksinimleri açısından önemli zorlukları beraberinde getirebilir. Bu modeller, genellikle yüz milyonlarca parametreden milyarlarca parametreye kadar değişen boyutlarıyla bilinir. Büyük boyutları, güçlü donanım ve önemli bellek kapasitesi de dahil olmak üzere kapsamlı bilgi işlem kaynakları gerektirir. Aslında, temel modellerin dağıtılması, hesaplama yükünü verimli bir şekilde ele almak için genellikle en az bir (genellikle daha fazla) GPU gerektirir. Örneğin, TII Falcon-40B Instruct modelinin belleğe başarıyla yüklenmesi için en az bir ml.g5.12xlarge örneğinin olması gerekir, ancak daha büyük örneklerle en iyi performansı gösterir. Sonuç olarak, bu modellerin dağıtımı ve bakımının yatırım getirisi (ROI), özellikle geliştirme döngüleri sırasında veya ani iş yükleri sırasında iş değerini kanıtlamak için çok düşük olabilir. Bunun nedeni, uzun oturumlar için (potansiyel olarak 24/7) GPU destekli bulut sunucularına sahip olmanın işletme maliyetleridir.

Bu yılın başında duyurmuştuk Amazon Ana KayasıAmazon ve üretken yapay zeka ortaklarımızın temel modellerine erişim sağlayan sunucusuz bir API. Şu anda Özel Önizleme'de olmasına rağmen sunucusuz API'si, herhangi bir uç noktayı kendiniz dağıtmanıza gerek kalmadan Amazon, Anthropic, Stability AI ve AI21'in temel modellerini kullanmanıza olanak tanır. Ancak Hugging Face gibi toplulukların açık kaynaklı modelleri oldukça artıyor ve bunların hepsi Amazon Bedrock aracılığıyla kullanıma sunulmuyor.

Bu yazıda bu durumları hedefliyoruz ve büyük temel modellerini dağıtarak yüksek maliyetleri riske atma sorununu çözüyoruz. Amazon Adaçayı Yapıcı eşzamansız uç noktalar itibaren Amazon SageMaker Hızlı Başlangıç. Bu, mimarinin maliyetlerinin azaltılmasına yardımcı olabilir, uç noktanın yalnızca istekler kuyruktayken ve kısa bir yaşam süresi için çalışmasına olanak tanırken, hizmet verilmeyi bekleyen hiçbir istek olmadığında ölçeği sıfıra düşürür. Bu, pek çok kullanım durumu için kulağa harika geliyor; ancak sıfıra küçültülmüş bir uç nokta, çıkarımlarda bulunmadan önce soğuk bir başlangıç zamanı getirecektir.

Çözüme genel bakış

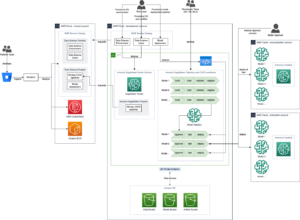

Aşağıdaki şema çözüm mimarimizi göstermektedir.

Kullandığımız mimari oldukça basittir:

- Kullanıcı arayüzü, Streamlit veya benzer teknoloji üzerine kurulu bir web kullanıcı arayüzü ile değiştirilebilen bir dizüstü bilgisayardır. Bizim durumumuzda defter bir Amazon SageMaker Stüdyosu PyTorch 5 Python 2.0 CPU çekirdeği ile ml.m3.10.large örneğinde çalışan dizüstü bilgisayar.

- Dizüstü bilgisayar uç noktayı üç şekilde sorgular: SageMaker Python SDK, Python için AWS SDK (Boto3) ve LangChain.

- Uç nokta, SageMaker'da eşzamansız olarak çalışıyor ve uç noktada Falcon-40B Instruct modelini konuşlandırıyoruz. Şu anda talimat modelleri açısından son teknoloji ürünüdür ve SageMaker JumpStart'ta mevcuttur. Tek bir API çağrısı, modeli uç noktaya dağıtmamıza olanak tanır.

SageMaker eşzamansız çıkarım nedir?

SageMaker eşzamansız çıkarım, gerçek zamanlı uç noktalar, toplu çıkarım ve sunucusuz çıkarımla birlikte SageMaker'daki dört dağıtım seçeneğinden biridir. Farklı dağıtım seçenekleri hakkında daha fazla bilgi edinmek için bkz. Çıkarım için modelleri dağıtma.

SageMaker eşzamansız çıkarım, gelen istekleri sıraya koyar ve bunları eşzamansız olarak işler; bu seçenek, 1 GB'a kadar büyük veri yükü boyutlarına, uzun işlem sürelerine ve neredeyse gerçek zamanlı gecikme gereksinimlerine sahip istekler için idealdir. Bununla birlikte, büyük temel modellerle uğraşırken, özellikle de kavram kanıtı (POC) veya geliştirme sırasında sağladığı temel avantaj, herhangi bir istek olmadığında sıfır örnek sayısına ölçeklendirmek için eşzamansız çıkarımı yapılandırma yeteneğidir. süreç, böylece maliyetten tasarruf sağlar. SageMaker eşzamansız çıkarımı hakkında daha fazla bilgi için bkz. asenkron çıkarım. Aşağıdaki diyagram bu mimariyi göstermektedir.

Eşzamansız bir çıkarım uç noktası dağıtmak için bir oluşturmanız gerekir. AsyncInferenceConfig nesne. Eğer yaratırsan AsyncInferenceConfig argümanlarını belirtmeden, varsayılan S3OutputPath olacak s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-outputs/{UNIQUE-JOB-NAME} ve S3FailurePath olacak s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-failures/{UNIQUE-JOB-NAME}.

SageMaker JumpStart nedir?

Modelimiz, önceden eğitilmiş modeller, çözüm şablonları ve örnek not defterleri sunarak makine öğrenimi (ML) yolculuğunu hızlandıran bir SageMaker özelliği olan SageMaker JumpStart'tan geliyor. Farklı sorun türleri için çok çeşitli önceden eğitilmiş modellere erişim sağlayarak makine öğrenimi görevlerinize sağlam bir temelle başlamanıza olanak tanır. SageMaker JumpStart ayrıca yaygın kullanım durumları için çözüm şablonları ve öğrenim için örnek not defterleri sunar. SageMaker JumpStart ile, tek tıklamayla çözüm lansmanları ve pratik makine öğrenimi deneyimi için kapsamlı kaynaklarla makine öğrenimi projelerinizi başlatmak için gereken zamanı ve çabayı azaltabilirsiniz.

Aşağıdaki ekran görüntüsü SageMaker JumpStart Kullanıcı Arayüzünde mevcut olan modellerden sadece bazılarının bir örneğini göstermektedir.

Modeli dağıtın

İlk adımımız modeli SageMaker'a dağıtmaktır. Bunu yapmak için, modeli eşzamansız uç noktaya dağıtmak için kullanabileceğimiz bir API sağlayan SageMaker JumpStart kullanıcı arayüzünü veya SageMaker Python SDK'yı kullanabiliriz:

Bu aramanın tamamlanması yaklaşık 10 dakika sürebilir. Bu süre zarfında uç nokta etkinleştirilir, kapsayıcı model yapılarıyla birlikte uç noktaya indirilir, model konfigürasyonu SageMaker JumpStart'tan yüklenir ve ardından eşzamansız uç nokta bir DNS uç noktası aracılığıyla kullanıma sunulur. Uç noktamızın sıfıra kadar ölçeklenebildiğinden emin olmak için Uygulama Otomatik Ölçeklendirmeyi kullanarak eşzamansız uç noktada otomatik ölçeklendirmeyi yapılandırmamız gerekir. Öncelikle uç nokta değişkeninizi Uygulama Otomatik Ölçeklendirme'ye kaydetmeniz, bir ölçeklendirme ilkesi tanımlamanız ve ardından ölçeklendirme ilkesini uygulamanız gerekir. Bu yapılandırmada özel bir metrik kullanıyoruz: CustomizedMetricSpecificationDenilen ApproximateBacklogSizePerInstance, aşağıdaki kodda gösterildiği gibi. Detaylı liste için Amazon Bulut İzleme eşzamansız çıkarım uç noktanızda kullanılabilen ölçümler için bkz. CloudWatch ile İzleme.

Bu politikanın başarıyla ayarlandığını SageMaker konsoluna gidip şu seçeneği belirleyerek doğrulayabilirsiniz: Uç noktalar altında sonuç Gezinti bölmesinde ve yeni konuşlandırdığımız uç noktayı arıyoruz.

Eşzamansız uç noktayı çağırma

Uç noktayı çağırmak için istek yükünü buraya yerleştirmeniz gerekir. Amazon Basit Depolama Hizmeti (Amazon S3) ve bu yükün bir parçası olarak bir işaretçi sağlayın. InvokeEndpointAsync rica etmek. Çağrı üzerine SageMaker, isteği işleme almak üzere kuyruğa alır ve yanıt olarak bir tanımlayıcı ve çıktı konumu döndürür. SageMaker, işlendikten sonra sonucu Amazon S3 konumuna yerleştirir. İsteğe bağlı olarak başarı veya hata bildirimlerini almayı seçebilirsiniz. Amazon Basit Bildirim Servisi (Amazon SNS'si).

SageMaker Python SDK'sı

Dağıtım tamamlandıktan sonra, bir geri dönecektir. AsyncPredictor nesne. Eşzamansız çıkarım gerçekleştirmek için verileri Amazon S3'e yüklemeniz ve predict_async() giriş olarak S3 URI'si olan yöntem. Bir geri dönecek AsyncInferenceResponse nesneyi kullanarak sonucu kontrol edebilirsiniz. get_response() yöntemi.

Alternatif olarak, bir sonucu periyodik olarak kontrol etmek ve oluşturulduktan sonra geri döndürmek istiyorsanız, predict() yöntem. Bu ikinci yöntemi aşağıdaki kodda kullanıyoruz:

Boto3

Şimdi keşfedelim invoke_endpoint_async Boto3'ün yöntemi sagemaker-runtime müşteri. Geliştiricilerin bir SageMaker uç noktasını eşzamansız olarak çağırmasına olanak tanıyarak ilerlemenin izlenmesi ve daha sonra yanıtın alınması için bir belirteç sağlar. Boto3, SageMaker Python SDK'sında olduğu gibi eşzamansız çıkarımın tamamlanmasını beklemek için bir yol sunmuyor get_result() operasyon. Bu nedenle Boto3'ün çıkarım çıktısını Amazon S3'te depolayacağı gerçeğinden yararlanıyoruz. response["OutputLocation"]. Çıkarım dosyasının Amazon S3'e yazılmasını beklemek için aşağıdaki işlevi kullanabiliriz:

Bu fonksiyonla artık uç noktayı sorgulayabiliriz:

Dil Zinciri

LangChain, Ekim 2022'de Harrison Chase tarafından başlatılan açık kaynaklı bir çerçevedir. Çeşitli sistem ve veri kaynaklarıyla entegrasyonlar sağlayarak, büyük dil modelleri (LLM) kullanan uygulamaların geliştirilmesini kolaylaştırır. LangChain belge analizi, özetleme, sohbet robotu oluşturma, kod analizi ve daha fazlasına olanak tanır. Yüzlerce geliştiricinin katkılarıyla ve girişim şirketlerinden gelen önemli fonlarla popülerlik kazandı. LangChain, LLM'lerin harici kaynaklarla bağlantısını sağlayarak dinamik, verilere duyarlı uygulamalar oluşturmayı mümkün kılar. Geliştirme sürecini kolaylaştırmak için kitaplıklar, API'ler ve belgeler sunar.

LangChain, çerçevesiyle birlikte SageMaker uç noktalarının kullanımına yönelik kütüphaneler ve örnekler sağlayarak SageMaker'da barındırılan ML modellerinin zincirin "beyni" olarak kullanılmasını kolaylaştırır. LangChain'in SageMaker ile nasıl entegre olduğu hakkında daha fazla bilgi edinmek için bkz. SageMaker Uç Noktası LangChain belgelerinde.

LangChain'in mevcut uygulamasının sınırlamalarından biri, eşzamansız uç noktaları yerel olarak desteklememesidir. LangChain'e eşzamansız bir uç nokta kullanmak için yeni bir sınıf tanımlamamız gerekir, SagemakerAsyncEndpoint, uzayan SagemakerEndpoint sınıfı LangChain'de zaten mevcuttur. Ek olarak aşağıdaki bilgileri sağlıyoruz:

- Eşzamansız çıkarımın girişleri (ve çıkışları) depolayacağı S3 grubu ve öneki

- Zaman aşımına uğramadan önce beklenecek maksimum saniye sayısı

- An

updated _call()uç noktayı sorgulama işleviinvoke_endpoint_async()yerineinvoke_endpoint() - Soğuk başlangıçtaysa eşzamansız uç noktayı uyandırmanın bir yolu (sıfıra küçültülmüş)

Yeni oluşturulanları incelemek için SagemakerAsyncEndpoint, Sen kontrol edebilirsiniz sagemaker_async_endpoint.py dosya GitHub'da mevcut.

Temizlemek

Uç noktadan çıkarımların oluşturulmasını test etmeyi tamamladığınızda, ek ücret ödemekten kaçınmak için uç noktayı silmeyi unutmayın:

Sonuç

TII Falcon gibi büyük temel modellerini devreye alırken maliyeti optimize etmek çok önemlidir. Bu modeller güçlü donanım ve önemli miktarda bellek kapasitesi gerektirir ve bu da yüksek altyapı maliyetlerine yol açar. İstekleri eşzamansız olarak işleyen bir dağıtım seçeneği olan SageMaker eşzamansız çıkarımı, bekleyen istek olmadığında örnek sayısını sıfıra ölçeklendirerek masrafları azaltır. Bu yazıda, büyük SageMaker JumpStart temel modellerinin SageMaker eşzamansız uç noktalarına nasıl dağıtılacağını gösterdik. Eşzamansız uç noktaları çağırmak ve sonuçları almak için farklı yöntemleri göstermek amacıyla SageMaker Python SDK, Boto3 ve LangChain'i kullanarak kod örnekleri sağladık. Bu teknikler, geliştiricilerin ve araştırmacıların, gelişmiş dil anlama sistemleri için temel modellerin yeteneklerini kullanırken maliyetleri optimize etmelerine olanak tanır.

Eşzamansız çıkarım ve SageMaker JumpStart hakkında daha fazla bilgi edinmek için aşağıdaki gönderilere göz atın:

Yazar hakkında

Davide Gallitelli EMEA bölgesinde AI/ML için Uzman Çözüm Mimarıdır. Merkezi Brüksel'dedir ve Benelüks genelindeki müşterilerle yakın işbirliği içinde çalışmaktadır. Çok küçük yaşlardan beri geliştiricidir, 7 yaşında kodlamaya başlar. Üniversitede AI/ML öğrenmeye başladı ve o zamandan beri ona aşık oldu.

Davide Gallitelli EMEA bölgesinde AI/ML için Uzman Çözüm Mimarıdır. Merkezi Brüksel'dedir ve Benelüks genelindeki müşterilerle yakın işbirliği içinde çalışmaktadır. Çok küçük yaşlardan beri geliştiricidir, 7 yaşında kodlamaya başlar. Üniversitede AI/ML öğrenmeye başladı ve o zamandan beri ona aşık oldu.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. Otomotiv / EV'ler, karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- ChartPrime. Ticaret Oyununuzu ChartPrime ile yükseltin. Buradan Erişin.

- Blok Ofsetleri. Çevre Dengeleme Sahipliğini Modernleştirme. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/optimize-deployment-cost-of-amazon-sagemaker-jumpstart-foundation-models-with-amazon-sagemaker-asynchronous-endpoints/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 100

- 12

- 13

- %15

- 1M

- 2022

- 25

- 7

- a

- Yapabilmek

- Hakkımızda

- hızlandırır

- Kabul eder

- erişim

- başarılar

- karşısında

- etkinlik

- Ayrıca

- ileri

- avantaj

- Sonra

- yaş

- AI

- AI modelleri

- AI / ML

- Izin

- veriyor

- zaten

- Ayrıca

- Rağmen

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon SageMaker Hızlı Başlangıç

- Amazon Web Servisleri

- miktar

- tutarları

- an

- analiz

- ve

- açıkladı

- Başka

- Antropik

- herhangi

- api

- API'ler

- Uygulama

- uygulamaları

- Tamam

- mimari

- ARE

- argümanlar

- Sanat

- AS

- At

- Dikkat

- çekti

- Oto

- mevcut

- ortalama

- önlemek

- AWS

- merkezli

- BE

- müşterimiz

- olmuştur

- önce

- olmak

- İYİ

- büyük

- milyarlarca

- Blokları

- vücut

- mola

- Brüksel

- bina

- yapılı

- iş

- fakat

- by

- çağrı

- denilen

- CAN

- yetenekleri

- kabiliyet

- yetenekli

- Kapasite

- dava

- durumlarda

- zincir

- zincirler

- zorluklar

- yükler

- kovalamak

- chatbot

- Kontrol

- Klinik

- seçme

- sınıf

- müşteri

- yakından

- kod

- soğuk

- nasıl

- geliyor

- ortak

- topluluklar

- Şirketler

- rakipler

- tamamlamak

- Tamamlandı

- Tamamladı

- bileşen

- kapsamlı

- bilgisayar

- Bilgisayar görüşü

- kavram

- yapılandırma

- bağ

- konsolos

- Konteyner

- içerik

- katkıları

- Ücret

- maliyetler

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- oluşturma

- çok önemli

- akım

- Şu anda

- görenek

- Müşteriler

- kesim

- Kesim maliyetleri

- döngüleri

- veri

- ilgili

- Varsayılan

- tanımlamak

- talepleri

- gösterdi

- dağıtmak

- konuşlandırılmış

- dağıtma

- açılma

- detaylı

- dev

- Geliştirici

- geliştiriciler

- gelişme

- DICT

- farklı

- Yayılma

- boyutlar

- özürlü

- dns

- do

- belge

- belgeleme

- Değil

- yapılmış

- aşağı

- gereken

- sırasında

- dinamik

- e

- kolay

- verimli biçimde

- çaba

- başka

- EMEA

- etkinleştirmek

- sağlar

- Son nokta

- Motorlar

- yeterli

- hata

- özellikle

- Her

- örnek

- örnekler

- Dışında

- istisna

- heyecan verici

- giderler

- deneyim

- keşfetmek

- maruz

- uzanır

- kapsamlı, geniş

- dış

- ekstra

- Yüz

- gerçek

- Düşmüş

- yanlış

- Özellikler(Hazırlık aşamasında)

- fileto

- firmalar

- Ad

- takip etme

- İçin

- vakıf

- dört

- iskelet

- itibaren

- işlev

- finansman

- kazandı

- oluşturulan

- üreten

- nesil

- üretken

- üretken yapay zeka

- GitHub

- Tercih Etmenizin

- GPU'lar

- harika

- Büyüyen

- sap

- donanım

- Var

- sahip olan

- he

- yardım et

- okuyun

- Yüksek

- ev sahipliği yaptı

- Ne kadar

- Nasıl Yapılır

- Ancak

- HTML

- http

- HTTPS

- Yüzlerce

- yüz milyonlarca

- ideal

- tanımlayıcı

- if

- göstermektedir

- görüntü

- uygulama

- ithalat

- in

- Dahil olmak üzere

- Gelen

- gösterir

- Endüstri

- bilgi

- Altyapı

- Yenilikçilik

- giriş

- girişler

- örnek

- yerine

- Entegre

- entegrasyonlar

- Akıllı

- faiz

- arayüzey

- içine

- tanıtmak

- yatırım

- IT

- ONUN

- seyahat

- jpg

- json

- sadece

- bilinen

- dil

- büyük

- Gecikme

- sonra

- başlattı

- başlattı

- önemli

- ÖĞRENİN

- öğrenme

- en az

- kütüphaneler

- sevmek

- sınırları

- Liste

- yük

- yer

- Uzun

- bakıyor

- Çok

- Aşk

- Düşük

- makine

- makine öğrenme

- yapılmış

- Ana

- Bakımı

- yapmak

- Yapımı

- çok

- maksimum

- maksimum

- Bellek

- yöntem

- yöntemleri

- metrik

- Metrikleri

- milyonlarca

- dakika

- ML

- model

- modelleri

- Daha

- isim

- Doğal (Madenden)

- Doğal Dil İşleme

- gezinme

- Navigasyon

- gerek

- yeni

- yeni

- sonraki

- nlp

- yok hayır

- defter

- tebliğ

- bildirimleri

- şimdi

- numara

- nesne

- Ekim

- of

- teklif

- teklif

- Teklifler

- sık sık

- on

- ONE

- bir tek

- açık kaynak

- operasyon

- optimize

- optimize

- seçenek

- Opsiyonlar

- or

- bizim

- dışarı

- çıktı

- bölmesi

- parametreler

- Bölüm

- özellikle

- ortaklar

- kadar

- Yapmak

- gerçekleştirir

- resim

- yer

- Yerler

- Platon

- Plato Veri Zekası

- PlatoVeri

- PoC

- politika

- popülerlik

- mümkün

- Çivi

- Mesajlar

- potansiyel

- güç kelimesini seçerim

- güçlü

- Pratik

- tahmin

- Predictor

- Önizleme

- özel

- Sorun

- süreç

- Süreçler

- işleme

- Ilerleme

- Projeler

- kanıt

- kavramın ispatı

- Kanıtlamak

- sağlamak

- sağlanan

- sağlar

- sağlama

- Python

- pytorch

- sorgular

- soru

- yükseltmek

- menzil

- değişen

- Okumak

- hazır

- gerçek zaman

- teslim almak

- azaltmak

- azaltır

- bölge

- kayıt olmak

- hatırlamak

- Kaldır

- yerine

- talep

- isteklerinizi

- gerektirir

- gereklidir

- Yer Alan Kurallar

- gerektirir

- Araştırmacılar

- kaynak

- Kaynaklar

- yanıt

- sonuç

- Sonuçlar

- dönüş

- İade

- yorum

- devrim

- riske

- ROI

- koşmak

- koşu

- sagemaker

- tasarruf

- ölçeklenebilir

- ölçek

- ölçekleme

- sdk

- İkinci

- saniye

- SELF

- hizmet vermek

- Serverless

- hizmet

- Hizmetler

- oturumları

- set

- kısa

- gösterilen

- Gösteriler

- önemli

- benzer

- Basit

- beri

- tek

- durumlar

- beden

- boyutları

- katı

- çözüm

- Çözümler

- ÇÖZMEK

- biraz

- kaynaklar

- uzman

- eğirilmiş

- istikrar

- kararlı

- başlama

- başladı

- XNUMX dakika içinde!

- Eyalet

- adım

- dur

- hafızası

- mağaza

- basit

- kolaylaştırmak

- önemli

- başarı

- Başarılı olarak

- böyle

- destek

- Destekler

- elbette

- aşmak

- Sistemler

- Bizi daha iyi tanımak için

- Hedef

- görevleri

- teknikleri

- Teknoloji

- şablonları

- şartlar

- Test yapmak

- Teşekkür

- o

- The

- Devlet

- ve bazı Asya

- Onları

- sonra

- Orada.

- böylece

- bu nedenle

- Bunlar

- onlar

- Re-Tweet

- Bu yıl

- üç

- İçinden

- boyunca

- zaman

- zamanlar

- zamanlama

- için

- birlikte

- simge

- çok

- Takip

- eğitilmiş

- Çeviri

- gerçek

- denemek

- türleri

- ui

- altında

- anlayış

- üniversite

- kadar

- üzerine

- us

- kullanım

- kullanıcı

- Kullanıcı Arayüzü

- kullanma

- genellikle

- değer

- Varyant

- çeşitli

- Geniş

- girişim

- doğrulamak

- çok

- üzerinden

- vizyonumuz

- beklemek

- Bekleyen

- Wake

- Uyanmak

- istemek

- oldu

- Yol..

- yolları

- we

- ağ

- web hizmetleri

- ne zaman

- olup olmadığını

- hangi

- süre

- DSÖ

- geniş

- Geniş ürün yelpazesi

- irade

- ile

- olmadan

- won

- çalışır

- Dünya çapında

- olur

- yazılı

- yıl

- Sen

- genç

- kendiniz

- zefirnet

- sıfır