Yapay zeka (AI) insanların farklı görevlere ve karmaşık sorunlara yaklaşma ve bunları çözme biçiminde devrim yaratma olasılığıyla son zamanlarda heyecan yarattı. Sağlık hizmetlerinden finansa kadar yapay zeka ve onunla ilişkili makine öğrenimi modelleri, karmaşık süreçleri kolaylaştırma, karar verme modellerini geliştirme ve değerli içgörüleri ortaya çıkarma potansiyelini ortaya koydu.

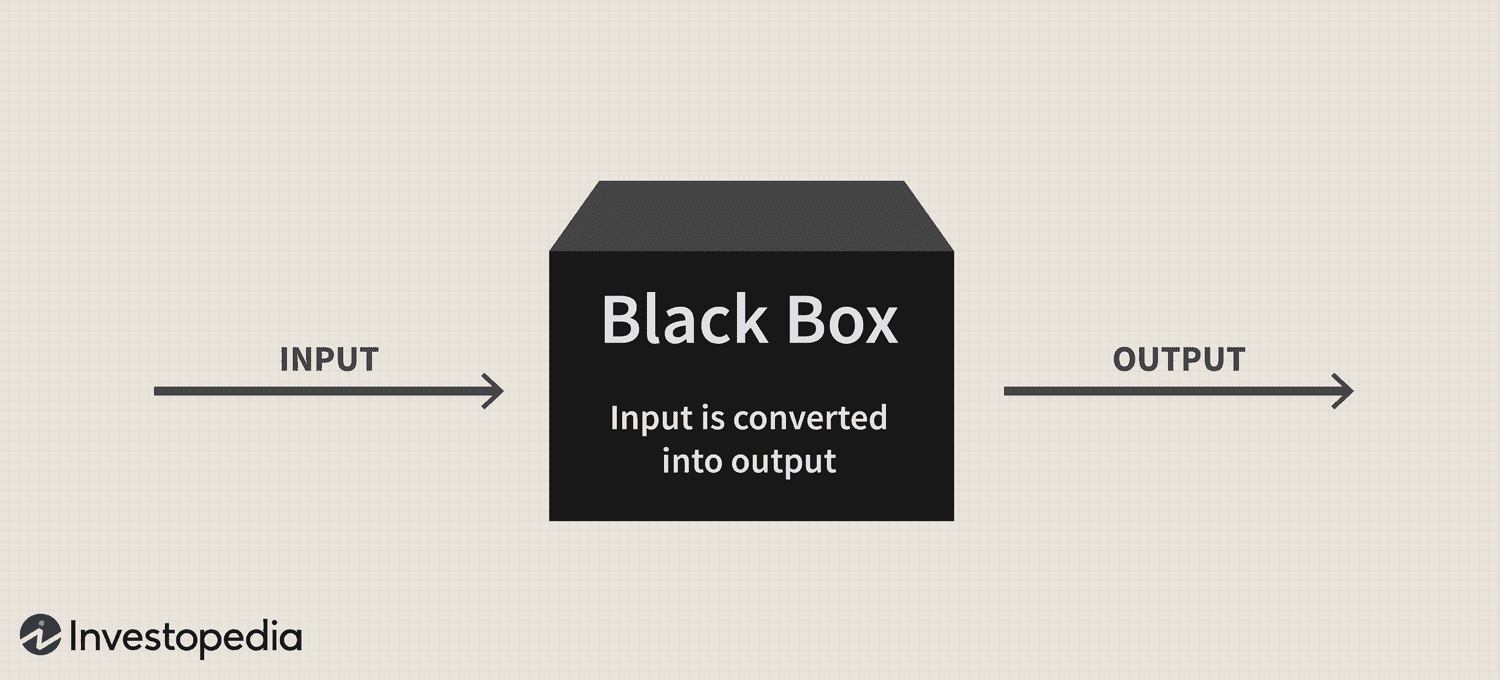

Bununla birlikte, teknolojinin muazzam potansiyeline rağmen, devam eden bir “kara kutu” sorunu, bu karmaşık sistemlerin şeffaflığı ve yorumlanabilirliği hakkında soruları gündeme getirerek, benimsenmesinde önemli bir zorluk oluşturmaya devam etmiştir.

Kısaca kara kutu sorunu, yapay zeka sistemlerinin ve makine öğrenimi modellerinin verileri nasıl işlediğini ve tahmin veya kararlar ürettiğini anlamanın zorluğundan kaynaklanıyor. Bu modeller genellikle insanlar tarafından kolayca anlaşılamayan karmaşık algoritmalara dayanır ve bu da hesap verebilirlik ve güven eksikliğine yol açar.

Bu nedenle, yapay zeka hayatımızın çeşitli yönlerine giderek daha fazla entegre olurken, bu sorunun ele alınması, bu güçlü teknolojinin sorumlu ve etik kullanımını sağlamak açısından hayati önem taşıyor.

Kara kutu: Genel bakış

"Kara kutu" metaforu, yapay zeka sistemlerinin ve makine öğrenimi modellerinin, tıpkı kapalı, opak bir kutunun içeriği gibi, insan anlayışından gizlenmiş bir şekilde çalıştığı fikrinden kaynaklanıyor. Bu sistemler, karar verme süreçlerini yönlendiren karmaşık ilişkiler ve modeller yaratan karmaşık matematiksel modeller ve yüksek boyutlu veri kümeleri üzerine kuruludur. Ancak bu iç mekanizmalar insanlar için kolayca erişilebilir veya anlaşılabilir değildir.

Pratik anlamda, yapay zeka kara kutu sorunu, bir yapay zeka sisteminin tahminlerinin veya kararlarının ardındaki mantığı deşifre etmenin zorluğudur. Bu sorun, özellikle birden fazla birbirine bağlı düğüm katmanının verileri hiyerarşik bir şekilde işlediği ve dönüştürdüğü sinir ağları gibi derin öğrenme modellerinde yaygındır. Bu modellerin karmaşıklığı ve gerçekleştirdikleri doğrusal olmayan dönüşümler, çıktılarının ardındaki mantığın izini sürmeyi son derece zorlaştırıyor.

AI tabanlı bir pazarlama analitiği kontrol paneli olan BR Group'un CEO'su Nikita Brudnov, Cointelegraph'a yaptığı açıklamada, AI modellerinin belirli kararlara ve tahminlere nasıl ulaştığı konusunda şeffaflık eksikliğinin, tıbbi teşhis, finansal karar verme ve yönetim gibi birçok bağlamda sorun yaratabileceğini söyledi. AI'nın benimsenmeye devam etmesini önemli ölçüde etkileyen yasal işlemler.

Dergi: Joe Lubin: ETH kurucularının bölünmesi ve 'Crypto Google' hakkındaki gerçek

"Son yıllarda, yapay zeka modelleri tarafından alınan kararları yorumlamak ve açıklamak için özellik önem puanları oluşturmak, karar sınırlarını görselleştirmek ve karşı olgusal varsayımsal açıklamaları belirlemek gibi tekniklerin geliştirilmesine büyük önem verildi" dedi ve ekledi:

"Ancak bu teknikler henüz başlangıç aşamasındadır ve her durumda etkili olacaklarının garantisi yoktur."

Brudnov ayrıca, daha fazla merkeziyetsizlikle birlikte düzenleyicilerin, etik geçerliliğini ve genel adaleti sağlamak için yapay zeka sistemleri tarafından alınan kararların daha şeffaf ve hesap verebilir olmasını gerektirebileceğine inanıyor. Ayrıca tüketicilerin, nasıl çalıştıklarını ve karar verme süreçlerini anlamamaları durumunda yapay zeka destekli ürün ve hizmetleri kullanmakta tereddüt edebileceklerini de öne sürdü.

Yapay zeka ile ilgili teknolojilere aktif olarak yatırım yapan bir yatırım şirketi olan DFG'nin kurucusu James Wo, kara kutu sorununun öngörülebilir gelecekte benimsenmeyi etkilemeyeceğine inanıyor. Wo'ya göre çoğu kullanıcı, mevcut yapay zeka modellerinin nasıl çalıştığını umursamıyor ve en azından şimdilik onlardan fayda elde etmekten mutluluk duyuyor.

“Orta vadede, bu platformların yeniliği sona erdiğinde, kara kutu metodolojisine dair şüpheler kesinlikle artacaktır. Yapay zeka kullanımı, finansal risklerin ve dikkate alınması gereken sonuçların olduğu kripto ve Web3'e girdikçe sorular da artacak" diye kabul etti.

Güven ve şeffaflık üzerindeki etkisi

Şeffaflığın yokluğunun güveni önemli ölçüde etkileyebileceği alanlardan biri de yapay zeka odaklı tıbbi teşhislerdir. Örneğin yapay zeka modelleri, teşhis veya tedavi önerileri oluşturmak için sağlık hizmetlerindeki karmaşık tıbbi verileri analiz edebilir. Ancak klinisyenler ve hastalar bu önerilerin ardındaki mantığı anlayamadıklarında bu içgörülerin güvenilirliğini ve geçerliliğini sorgulayabilirler. Bu şüphecilik, yapay zeka çözümlerinin benimsenmesinde daha fazla tereddüte yol açabilir ve potansiyel olarak hasta bakımı ve kişiselleştirilmiş tıptaki ilerlemeleri engelleyebilir.

Finansal alanda yapay zeka sistemleri kredi puanlama, dolandırıcılık tespiti ve risk değerlendirmesi için kullanılabilir. Ancak kara kutu sorunu, bu kredi puanlarının adilliği ve doğruluğu veya dolandırıcılık uyarılarının ardındaki mantık konusunda belirsizlik yaratarak teknolojinin sektörü dijitalleştirme yeteneğini sınırlayabilir.

Kripto endüstrisi de kara kutu sorununun yansımalarıyla karşı karşıya. Örneğin, dijital varlıklar ve blockchain teknolojisinin temelinde merkezi olmayan yönetim, açıklık ve doğrulanabilirlik yatmaktadır. Şeffaflık ve yorumlanabilirlikten yoksun yapay zeka sistemleri, kullanıcı beklentileri ile bu alandaki yapay zeka odaklı çözümlerin gerçekliği arasında bir kopukluk oluşturuyor.

Düzenleyici endişeler

Düzenleme açısından bakıldığında yapay zeka kara kutu sorunu benzersiz zorluklar sunuyor. Yeni başlayanlar için yapay zeka süreçlerinin şeffaf olmaması, düzenleyicilerin bu sistemlerin mevcut kural ve yönergelere uygunluğunu değerlendirmesini giderek zorlaştırabilir. Üstelik şeffaflığın olmayışı, düzenleyicilerin yapay zeka uygulamalarının ortaya çıkardığı riskleri ve zorlukları ele alabilecek yeni çerçeveler geliştirme yeteneğini zorlaştırabilir.

Kanun yapıcılar yapay zeka sistemlerinin adilliğini, önyargısını ve veri gizliliği uygulamalarını ve bunların tüketici hakları ve piyasa istikrarı üzerindeki potansiyel etkilerini değerlendirmekte zorlanabilir. Ek olarak, yapay zeka destekli sistemlerin karar verme süreçlerine ilişkin net bir anlayışa sahip olmayan düzenleyiciler, potansiyel güvenlik açıklarını belirlemede ve riskleri azaltmak için uygun önlemlerin alınmasını sağlamada zorluklarla karşılaşabilir.

Bu teknolojiyle ilgili dikkate değer düzenleyici gelişmelerden biri Avrupa Birliği'nin Yapay Zeka Yasası olmuştur. hangisi yaklaşıyor 27 Nisan'da geçici bir siyasi anlaşmaya varılmasının ardından bloğun tüzük kitabına dahil edilmesi.

Yapay Zeka Yasası özünde AB içinde yapay zeka gelişimi için güvenilir ve sorumlu bir ortam yaratmayı amaçlıyor. Kanun yapıcılar, farklı yapay zeka türlerini riske göre kategorize eden bir sınıflandırma sistemi benimsedi: kabul edilemez, yüksek, sınırlı ve minimum. Bu çerçeve, şeffaflık ve hesap verebilirlik ile ilgili konular da dahil olmak üzere yapay zeka kara kutu sorunuyla ilgili çeşitli endişeleri gidermek için tasarlanmıştır.

Yapay zeka sistemlerinin etkili bir şekilde izlenememesi ve düzenlenememesi, farklı endüstriler ve düzenleyici kurumlar arasındaki ilişkileri halihazırda gergin hale getirmiştir.

Geçtiğimiz ayın başlarında, popüler yapay zeka sohbet robotu ChatGPT, İtalya'da 29 gün süreyle yasak, öncelikle ülkenin veri koruma kurumu tarafından AB'nin Genel Veri Koruma Düzenlemelerinin (GDPR) ihlal edildiğinden şüphelenilen gizlilik endişeleri nedeniyle. Ancak CEO Sam Altman'ın kendisinin ve ekibinin, veri işleme uygulamalarının açıklanması ve yaş sınırı uygulamasının uygulanması da dahil olmak üzere düzenleyici kurumun taleplerine uymak için belirli adımlar attığını açıklamasının ardından platformun 29 Nisan'da hizmetlerine devam etmesine izin verildi. geçiş önlemleri.

Yapay zeka sistemlerinin yetersiz düzenlenmesi, kullanıcıların doğal önyargılar, yanlışlıklar ve etik sonuçlar konusunda giderek daha fazla endişe duyması nedeniyle halkın yapay zeka uygulamalarına olan güvenini azaltabilir.

Kara kutu sorununun çözümü

Yapay zeka kara kutu sorununu etkili bir şekilde çözmek için şeffaflığı, yorumlanabilirliği ve hesap verebilirliği teşvik eden yaklaşımların bir kombinasyonunun kullanılması esastır. Bu tür tamamlayıcı stratejilerden ikisi açıklanabilir yapay zeka (XAI) ve açık kaynak modelleridir.

XAI, yapay zeka sistemlerinin karmaşıklığı ile insan tarafından yorumlanabilirlik ihtiyacı arasındaki boşluğu doldurmaya adanmış bir araştırma alanıdır. XAI, yapay zeka odaklı kararlar için insanların anlayabileceği açıklamalar sunabilen teknikler ve algoritmalar geliştirmeye odaklanıyor ve bu seçimlerin ardındaki mantığa dair içgörüler sunuyor.

XAI'de sıklıkla kullanılan yöntemler arasında vekil modeller, özellik önemi analizi, duyarlılık analizi ve yerel olarak yorumlanabilir modelden bağımsız açıklamalar yer alır. XAI'nin endüstriler genelinde uygulanması, paydaşların yapay zeka odaklı süreçleri daha iyi anlamalarına yardımcı olabilir, teknolojiye olan güveni artırabilir ve düzenleyici gerekliliklere uyumu kolaylaştırabilir.

XAI ile birlikte açık kaynaklı yapay zeka modellerinin benimsenmesini teşvik etmek, kara kutu sorununu çözmek için etkili bir strateji olabilir. Açık kaynaklı modeller, yapay zeka sistemlerini yönlendiren algoritmalara ve verilere tam erişim sağlayarak kullanıcıların ve geliştiricilerin temel süreçleri inceleyip anlamalarını sağlar.

Bu artan şeffaflık, geliştiriciler, araştırmacılar ve kullanıcılar arasında güven oluşturulmasına ve işbirliğinin geliştirilmesine yardımcı olabilir. Ayrıca açık kaynak yaklaşımı daha sağlam, hesap verebilir ve etkili yapay zeka sistemleri oluşturabilir.

Kripto alanındaki kara kutu sorunu

Kara kutu sorununun, ticaret stratejileri, piyasa tahminleri, güvenlik önlemleri, tokenizasyon ve akıllı sözleşmeler dahil olmak üzere kripto alanının çeşitli yönleri üzerinde önemli sonuçları vardır.

Ticaret stratejileri ve piyasa tahminleri alanında, yatırımcılar algoritmik ticaretten yararlanmaya çalıştıkça yapay zeka odaklı modeller popülerlik kazanıyor. Ancak kara kutu sorunu, kullanıcıların bu modellerin nasıl çalıştığını anlamasını engelliyor ve bu modellerin etkinliğini ve potansiyel risklerini değerlendirmeyi zorlaştırıyor. Sonuç olarak, bu şeffaflık aynı zamanda yapay zeka odaklı yatırım kararlarına haksız güvene yol açabilir veya yatırımcıları otomatik sistemlere aşırı bağımlı hale getirebilir.

Yapay zeka, sahte işlemleri ve şüpheli faaliyetleri tespit ederek blockchain ekosistemindeki güvenlik önlemlerinin geliştirilmesinde önemli bir rol oynayacaktır. Bununla birlikte kara kutu sorunu, yapay zeka destekli bu güvenlik çözümlerinin doğrulama sürecini karmaşık hale getiriyor. Karar vermede şeffaflığın olmayışı, güvenlik sistemlerine olan güveni aşındırabilir ve bu sistemlerin kullanıcı varlıklarını ve bilgilerini koruma yeteneklerine ilişkin endişeleri artırabilir.

Son: Mutabakat 2023: İşletmeler, ABD'deki düzenleyici zorluklara rağmen Web3'e ilgi gösteriyor

Blockchain ekosisteminin iki hayati bileşeni olan tokenizasyon ve akıllı sözleşmeler de yapay zekanın artan entegrasyonuna tanık oluyor. Ancak kara kutu sorunu, yapay zeka tarafından oluşturulan tokenların veya akıllı sözleşmelerin yürütülmesinin arkasındaki mantığı gizleyebilir.

Yapay zeka çeşitli endüstrilerde devrim yarattıkça, kara kutu sorununun çözümü de giderek daha acil hale geliyor. Araştırmacılar, geliştiriciler, politika yapıcılar ve sektör paydaşları arasındaki işbirliğini teşvik ederek yapay zeka sistemlerinde şeffaflığı, hesap verebilirliği ve güveni teşvik edecek çözümler geliştirilebilir. Dolayısıyla bu yeni teknoloji paradigmasının nasıl gelişmeye devam ettiğini görmek ilginç olacak.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Adryenn Ashley ile Geleceği Basmak. Buradan Erişin.

- PREIPO® ile PRE-IPO Şirketlerinde Hisse Al ve Sat. Buradan Erişin.

- Kaynak: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- 2023

- 27

- a

- kabiliyet

- Hakkımızda

- erişim

- ulaşılabilir

- sorumluluk

- sorumlu

- doğruluk

- karşısında

- Hareket

- aktif

- faaliyetler

- ekleme

- Ayrıca

- adres

- adresleme

- benimsenen

- Benimsemek

- Benimseme

- gelişmeler

- etkiler

- Sonra

- ajans

- Bireysel Üyelik Sözleşmesi

- AI

- AI Yasası

- AI chatbot

- AI destekli

- Amaçları

- Uyarılar

- algoritmik

- algoritmik alım-satım

- algoritmalar

- Türkiye

- zaten

- Ayrıca

- arasında

- an

- analiz

- analytics

- çözümlemek

- ve

- açıkladı

- uygulamaları

- yaklaşım

- yaklaşımlar

- uygun

- Nisan

- ARE

- ALAN

- etrafında

- yapay

- yapay zeka

- AS

- yönleri

- değerlendirme

- Varlıklar

- ilişkili

- At

- Dikkat

- Otomatik

- BE

- müşterimiz

- olur

- olma

- olmuştur

- arkasında

- inanıyor

- Daha iyi

- arasında

- önyargı

- önyargıları

- Siyah

- blockchain

- blockchain ekosistemi

- blockchain teknoloji

- organları

- kitap

- sınırları

- kutu

- köprü

- inşa etmek

- güven oluşturmak

- yapılı

- işletmeler

- by

- CAN

- yapamam

- yararlanmak

- hangi

- durumlarda

- ceo

- belli

- meydan okuma

- zorluklar

- zor

- chatbot

- ChatGPT

- choices

- sınıflandırma

- sınıflandırma sistemi

- açık

- klinisyenler

- Cointelegraph

- işbirliği

- kombinasyon

- tamamlayıcı

- karmaşık

- karmaşıklık

- uyma

- bileşenler

- idrak

- ilgili

- Endişeler

- Sonuçları

- sonuç olarak

- Düşünmek

- tüketici

- Tüketici Hakları

- Tüketiciler

- içindekiler

- bağlamlar

- devam

- devam ediyor

- sözleşme

- sözleşmeleri

- çekirdek

- olabilir

- ülkenin

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- kredi

- çok önemli

- kripto

- Kripto Endüstrisi

- kripto alanı

- gösterge paneli

- veri

- veri gizliliği

- veri işleme

- veri koruma

- veri kümeleri

- Yerelleşme

- karar

- Karar verme

- kararlar

- adanmış

- derin

- derin öğrenme

- kesinlikle

- talepleri

- gösterdi

- tasarlanmış

- Rağmen

- Bulma

- geliştirmek

- gelişmiş

- geliştiriciler

- gelişen

- gelişme

- farklı

- zor

- zorluklar

- Zorluk

- dijital

- Dijital Varlıklar

- sayısallaştımak

- do

- domain

- Dont

- sürücü

- gereken

- kolayca

- ekosistem

- Etkili

- etkili bir şekilde

- etki

- istihdam

- etkinleştirme

- artırmak

- artırılması

- sağlamak

- sağlanması

- girer

- çevre

- gerekli

- ETH

- törel

- EU

- Avrupa

- değerlendirmek

- gelişmek

- örnek

- infaz

- mevcut

- beklentileri

- açıklayan

- Yüz

- yüzler

- kolaylaştırıcı

- adalet

- Özellikler(Hazırlık aşamasında)

- maliye

- mali

- Firma

- odaklanır

- İçin

- tahmin edilebilen

- Airdrop Formu

- Beslemek

- teşvik

- kurucu

- Kurucuları

- iskelet

- çerçeveler

- dolandırıcılık

- sahtekarlık tespiti

- sahte

- itibaren

- tam

- işlev

- daha fazla

- Ayrıca

- gelecek

- kazanma

- boşluk

- KVKK

- genel

- Genel veri

- oluşturmak

- üreten

- vermek

- grup

- garanti

- rehberlik

- kuralları yenileyerek

- vardı

- mutlu

- Var

- he

- sağlık

- yardım et

- Yüksek

- Engeller

- onun

- Ne kadar

- Ancak

- HTTPS

- insan

- İnsanlar

- belirlenmesi

- if

- muazzam

- darbe

- etkileyen

- uygulama

- uygulanması

- etkileri

- önem

- in

- yetersizlik

- dahil

- Dahil olmak üzere

- Artırmak

- artmış

- giderek

- Endüstri

- sanayi

- bilgi

- doğal

- anlayışlar

- entegre

- bütünleşme

- İstihbarat

- birbirine bağlı

- faiz

- ilginç

- içine

- yatırım

- Yatırımcılar

- yatırım

- konu

- sorunlar

- IT

- İtalya

- ONUN

- Eksiklik

- Soyad

- milletvekilleri

- katmanları

- öncülük etmek

- önemli

- öğrenme

- en az

- Yasal Şartlar

- yasal işlemler

- sevmek

- Sınırlı

- Yaşıyor

- yerel

- mantık

- makine

- makine öğrenme

- yapılmış

- yapmak

- Yapımı

- tavır

- çok

- pazar

- piyasa tahminleri

- Pazarlama

- matematiksel

- Mayıs..

- önlemler

- tıbbi

- tıbbi veri

- tıp

- metodoloji

- olabilir

- en az

- Azaltmak

- modelleri

- izlemek

- Ay

- Daha

- Dahası

- çoğu

- hareketli

- çok

- çoklu

- zorunlu olarak

- gerek

- ağlar

- nöral ağlar

- yine de

- yeni

- yok hayır

- düğümler

- dikkate değer

- kavram

- roman

- yenilik

- şimdi

- of

- kapalı

- teklif

- sık sık

- on

- bir Zamanlar

- opak

- açık kaynak

- Açıklık

- işletmek

- or

- bizim

- tüm

- ödenmiş

- paradigma

- Bölüm

- özellikle

- hasta

- hastalar

- desen

- İnsanlar

- Yapmak

- Kişiselleştirilmiş

- yer

- platform

- Platformlar

- Platon

- Plato Veri Zekası

- PlatoVeri

- OYNA

- politika

- siyasi

- Popüler

- popülerlik

- olasılık

- potansiyel

- potansiyel

- güçlü

- Pratik

- uygulamalar

- Tahminler

- mevcut

- hediyeler

- yaygın

- öncelikle

- gizlilik

- Sorun

- sorunlar

- kovuşturma

- süreç

- Süreçler

- işleme

- Ürünler

- desteklemek

- teşvik

- koruma

- sağlamak

- geçici

- halka açık

- halkın güveni

- soru

- Sorular

- yükseltilmiş

- kaldırma

- gerekçe

- uzanarak almak

- Gerçeklik

- alan

- son

- geçenlerde

- tavsiyeler

- ilişkin

- düzenlemek

- Değişiklik Yapıldı

- yönetmelik

- Denetleyiciler

- düzenleyici

- ilgili

- İlişkiler

- güvenilirlik

- güvenmek

- tepki

- gerektirir

- Yer Alan Kurallar

- araştırma

- Araştırmacılar

- sorumlu

- sonuç

- devam et

- devrim yapmak

- devrim yapar

- haklar

- Risk

- risk değerlendirmesi

- riskler

- gürbüz

- Rol

- kurallar

- güvenceler

- Adı geçen

- Sam

- Sam Altman

- puanlama

- güvenlik

- Güvenlik Önlemleri

- görmek

- Aramak

- Duyarlılık

- Hizmetler

- Setleri

- şov

- önemli

- önemli ölçüde

- sadece

- Şüphecilik

- akıllı

- akıllı sözleşme

- Akıllı Sözleşmeler

- Çözümler

- ÇÖZMEK

- sofistike

- Kaynak

- uzay

- özel

- bölmek

- istikrar

- paydaşlar

- durmak

- standları

- sapları

- Basamaklar

- Yine

- stratejileri

- Stratejileri

- kolaylaştırmak

- Çabalama

- böyle

- şüpheli

- sistem

- Sistemler

- Tandem

- görevleri

- takım

- teknoloji

- teknikleri

- Teknolojileri

- Teknoloji

- şartlar

- o

- The

- ve bazı Asya

- Onları

- Orada.

- Bunlar

- onlar

- Re-Tweet

- için

- dizgeciklere

- Jeton

- Iz

- Trading

- Ticaret Stratejileri

- işlemler

- Dönüştürmek

- dönüşümler

- Şeffaflık

- şeffaf

- tedavi

- Güven

- güvenilir

- Hakikat

- iki

- türleri

- Belirsizlik

- ortaya çıkarmak

- altında yatan

- anlamak

- anlaşılabilir

- anlayış

- benzersiz

- üzerine

- us

- kullanım

- kullanıcı

- kullanıcılar

- yarar

- Değerli

- çeşitli

- Doğrulama

- İhlaller

- hayati

- güvenlik açıkları

- oldu

- Web3

- ne zaman

- hangi

- irade

- ile

- içinde

- olmadan

- tanık

- wo

- İş

- kazı

- yıl

- zefirnet