Daha fazla kuruluş, sunum hazırlamak, hibe başvurularını tamamlamak ve yazmak için üretken yapay zeka teknolojilerini benimsedikçe Genelge kodu — güvenlik ekipleri yeni bir soruyu ele alma ihtiyacının farkına varıyor: Yapay zeka araçlarının güvenliğini nasıl sağlarsınız?

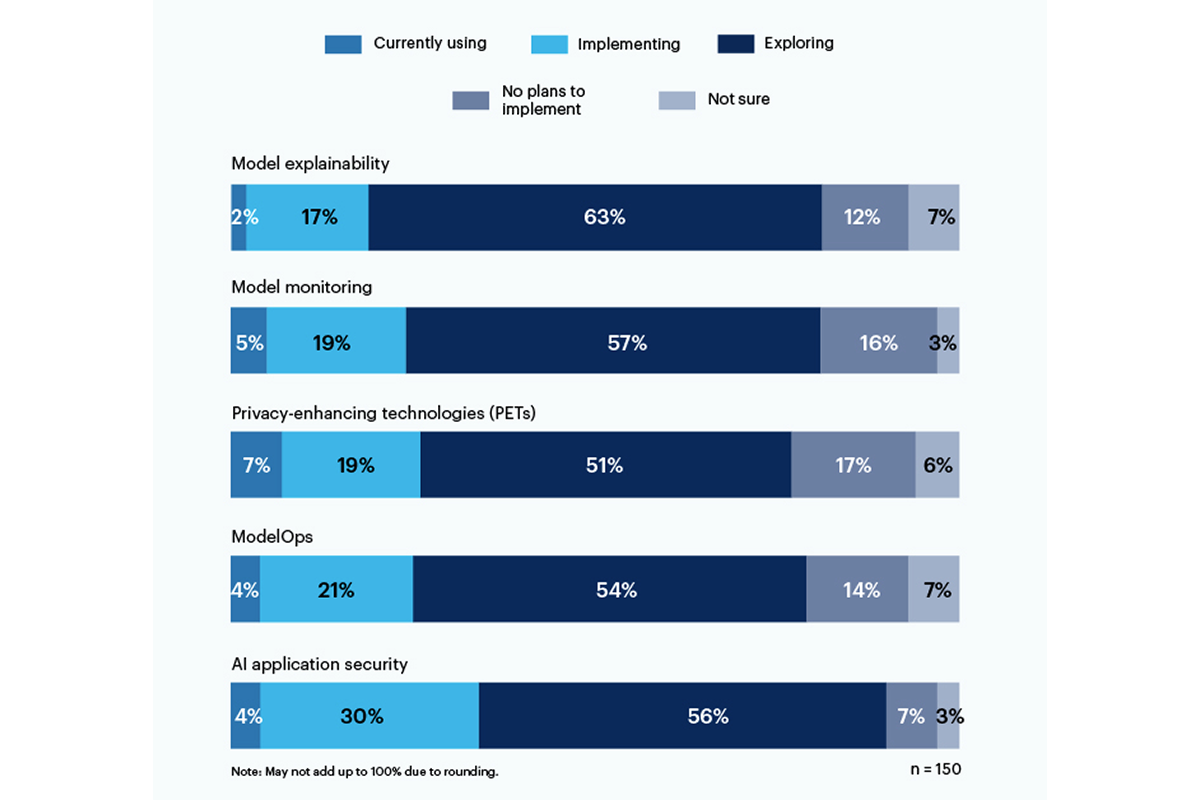

Gartner'ın yakın zamanda yaptığı bir ankete yanıt verenlerin üçte biri şunları bildirdi: Yapay zeka tabanlı uygulama güvenliği araçlarını kullanma veya uygulama Organizasyonlarında üretken yapay zeka kullanımının ortaya çıkardığı riskleri ele almak.

Gizliliği artıran teknolojiler (PET'ler), ankete katılanların %7'si ile mevcut en büyük kullanımı gösterdi; şirketlerin %19'u bu teknolojiyi uyguluyor; bu kategori, aşağıdakiler gibi kişisel verileri korumanın yollarını içerir: homomorfik şifreleme, AI tarafından oluşturulan sentetik veriler, güvenli çok taraflı hesaplama, federe öğrenme, ve farklı gizlilik. Ancak %17'lik bir kesimin PET'leri çevrelerine yayma planı yok.

Yalnızca %19'u model açıklanabilirliğine yönelik araçları kullanıyor veya uyguluyor, ancak katılımcılar arasında üretken yapay zeka riskini ele almak için bu araçları keşfetmeye ve anlamaya önemli bir ilgi (%56) var. Gartner'a göre açıklanabilirlik, model izleme ve yapay zeka uygulama güvenliği araçlarının tümü, kurumsal kullanıcıların ihtiyaç duyduğu güvenilirliği ve güvenilirliği sağlamak için açık kaynak veya özel modellerde kullanılabilir.

Ankete katılanların en çok endişe duyduğu riskler arasında yanlış veya önyargılı çıktılar (%58) ve yapay zeka tarafından oluşturulan koddaki güvenlik açıkları veya sızdırılmış sırlar (%57) yer alıyor. Önemli ölçüde, %43'ü yapay zeka tarafından oluşturulan içerikten kaynaklanan potansiyel telif hakkı veya lisans sorunlarının kuruluşları için en büyük riskler olduğunu belirtti.

Bir üst düzey yönetici, Gartner anketine yanıt olarak şunları yazdı: "Üzerinde eğitim verilen veri modelleri hakkında hâlâ şeffaflık yok; bu nedenle önyargı ve mahremiyetle ilişkili riskin anlaşılması ve tahmin edilmesi çok zor."

Haziran ayında Ulusal Standartlar ve Teknoloji Enstitüsü (NIST) bir kamu çalışma grubu kurdu Ocak ayından itibaren Yapay Zeka Risk Yönetimi Çerçevesini temel alarak bu sorunun yanıtlanmasına yardımcı olmak için. Gartner verilerinin gösterdiği gibi, şirketler beklemiyor NIST direktifleri için.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :dır-dir

- :olumsuzluk

- 7

- a

- Hakkımızda

- Göre

- Başarmak

- adres

- benimsemek

- AI

- Türkiye

- arasında

- ve

- Uygulama

- uygulama güvenliği

- uygulamaları

- ARE

- AS

- ilişkili

- At

- merkezli

- BE

- önyargı

- önyargılı

- fakat

- by

- C-suite

- CAN

- Kategoriler

- atıf

- kod

- Şirketler

- tamamlamak

- ilgili

- içerik

- telif hakkı

- zanaat

- akım

- veri

- zor

- direktifler

- do

- ya

- kuruluş

- çevre

- tahmin

- yürütme

- Keşfetmek

- İçin

- iskelet

- itibaren

- Gartner

- üretken

- üretken yapay zeka

- vermek

- En büyük

- Var

- yardım et

- Ne kadar

- Ancak

- HTTPS

- uygulanması

- in

- dahil

- içerir

- Enstitü

- faiz

- sorunlar

- IT

- ONUN

- Ocak

- Haziran

- başlattı

- ruhsat verme

- yönetim

- yöntemleri

- model

- modelleri

- izleme

- Daha

- çoğu

- çoklu

- ulusal

- gerek

- yeni

- NiST

- yok hayır

- of

- on

- açık

- açık kaynak

- or

- kuruluşlar

- organizasyonlar

- kişisel

- kişisel bilgi

- Evcil Hayvan

- sahalar

- ağladım

- Platon

- Plato Veri Zekası

- PlatoVeri

- ortaya

- potansiyel

- gizlilik

- özel

- korumak

- halka açık

- soru

- fark

- son

- güvenilirlik

- güvenmek

- Bildirilen

- katılımcıların

- yanıt

- Risk

- risk yönetimi

- riskler

- sırları

- güvenli

- güvenlik

- gösterdi

- Gösteriler

- önemli

- önemli ölçüde

- So

- katı

- Kaynak

- standartlar

- Yine

- böyle

- Anket

- sentetik

- takım

- Teknolojileri

- Teknoloji

- o

- The

- ve bazı Asya

- Orada.

- Bunlar

- Re-Tweet

- için

- araçlar

- üst

- Eğitim

- Şeffaflık

- güvenilirlik

- anlamak

- anlayış

- kullanım

- Kullanılmış

- kullanıcılar

- kullanma

- çok

- güvenlik açıkları

- yolları

- ile

- çalışma

- yazmak

- yazdı

- Sen

- zefirnet