Geçen hafta, Teknoloji İnovasyon Enstitüsü (TII) başlattı TSEV Falcon LLM, açık kaynaklı bir temel büyük dil modeli (LLM). 1 trilyon token üzerinde eğitildi Amazon Adaçayı YapıcıFalcon, birinci sınıf performansıyla övünüyor Sarılma Yüzü liderlik tablosu Lama-65B gibi diğer LLM'lere göre nispeten hafif ve barındırması daha ucuz olmasına rağmen bu yazının yazıldığı sırada). Bu yazıda, SageMaker'da büyük model çıkarımı derin öğrenme kapsayıcılarını kullanarak dil anlama ve otomatik yazma yardımı gibi uygulamalar için Falcon'un nasıl dağıtılacağını gösteriyoruz.

Falcon SageMaker'a indi

TII, Abu Dabi'deki uygulamalı araştırma kuruluşudur. İleri Teknoloji Araştırma Konseyi; bilim insanları, araştırmacılar ve mühendislerden oluşan ekibi, dönüştürücü teknolojilerin keşfedilmesine ve toplumumuzu geleceğe hazırlayacak bilimsel atılımların geliştirilmesine kendini adamıştır. Bu yılın başlarında, TSEV son teknolojiye sahip, açık kaynaklı bir LLM yetiştirmek üzere yola çıktı ve işi bitirmek için SageMaker'ın altyapısını, araçlarını ve uzmanlığını kullandı (bu modelin SageMaker'da nasıl eğitildiği hakkında daha fazla bilgi edinmek için) , bakın Teknoloji İnovasyon Enstitüsü, Amazon SageMaker'da son teknoloji ürünü Falcon LLM 40B temel modelini eğitiyor). Bu çabanın sonucu TSEV Falcon LLM.

1 trilyon token üzerinde eğitilen Falcon, rakiplere karşı birinci sınıf performansa sahip Eleuther AI Dil Modeli Değerlendirme Sistemi ve şu anda listede 1 numara Sarılma Yüzü liderlik tablosu doğruluk için. Model, Falcon-40B ve Falcon-7B olmak üzere iki farklı boyutta mevcuttur ve dil anlama, konuşma deneyimleri ve otomatik yazma yardımı gibi uygulamalarda en gelişmiş performans için kullanılabilir. Bu gönderi, bu tür alanlarda yüksek doğruluklu çıkarımlar için Falcon'u SageMaker'da dağıtmaya başlamanıza yardımcı olacaktır.

SageMaker büyük model çıkarım DLC'leri LLM barındırmayı basitleştirir

Falcon-40B ve Falcon-7B gibi Yüksek Lisans'lara ev sahipliği yapmak zor olabilir. Milyarlarca parametre içerdikleri için daha büyük modeller genellikle daha doğrudur, ancak boyutları aynı zamanda daha yavaş çıkarım gecikmesine veya daha kötü aktarım hızına da neden olabilir. Bir LLM'yi barındırmak, kabul edilebilir bir performans elde etmek için daha fazla GPU belleği ve optimize edilmiş çekirdekler gerektirebilir. İşleri daha da karmaşık hale getirmek için, Falcon-7B gibi daha küçük modeller genellikle AWS G10 bulut sunucusu türlerini destekleyen NVIDIA A5G bulut sunucusu gibi tek bir GPU'ya sığabilse de Falcon-40B gibi daha büyük modeller bunu yapamaz. Bu gerçekleştiğinde, daha büyük modeli birden fazla parçaya bölmek ve birden fazla GPU'nun belleğinden yararlanmak için tensör paralelliği gibi stratejilerin kullanılması gerekir. Daha küçük modeller için kullanılan eski barındırma çözümleri genellikle bu tür işlevsellik sunmuyor ve bu da zorluğu artırıyor.

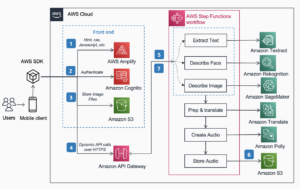

SageMaker büyük model çıkarımı (LMI) derin öğrenme kapsayıcıları (DLC'ler) yardımcı olabilir. LMI DLC'leri Falcon-40B gibi LLM'leri barındırmak için eksiksiz bir uçtan uca çözümdür. Ön uçta, verimi artırmak için bir bulut sunucusu içinde belirteç akışı ve otomatik model çoğaltma gibi özelliklerle büyük model çıkarımı için tasarlanmış yüksek performanslı bir model sunucusu (DJL Hizmeti) içerirler. Arka uçta, LMI DLC'leri ayrıca DeepSpeed ve FasterTransformer gibi birden fazla GPU'da model parametrelerini parçalayabilen ve yönetebilen çeşitli yüksek performanslı model paralel motorları içerir. Bu motorlar ayrıca popüler transformatör modelleri için, çıkarımı üç kata kadar daha hızlı hızlandırabilen optimize edilmiş çekirdekler içerir. LMI DLC'leri ile SageMaker'da LLM barındırma hizmetine başlamak için bir yapılandırma dosyası oluşturmanız yeterlidir. SageMaker LMI DLC'leri hakkında daha fazla bilgi edinmek için bkz. Model paralelliği ve büyük model çıkarımı ve mevcut görsellerin listesi. Ayrıca hosting ile ilgili önceki yazımıza da göz atabilirsiniz. SageMaker'da Bloom-175B LMI DLC'lerini kullanma.

Çözüme genel bakış

Bu gönderi, LMI DLC'lerini kullanarak SageMaker'da DeepSpeed kullanarak Falcon-40B'yi nasıl barındıracağınız konusunda size yol gösterir. Falcon-40B birden fazla A10 GPU kullanmamızı gerektirirken Falcon-7B yalnızca tek bir GPU gerektiriyor. Ayrıca Falcon-40B ve Falcon-7B'yi hem DeepSpeed hem de Accelerate kullanarak barındırmak için başvurabileceğiniz örnekler hazırladık. Kod örneklerimizi adresinde bulabilirsiniz. GitHub.

Bu örnek SageMaker not defteri örneklerinde çalıştırılabilir veya Amazon SageMaker Stüdyosu defterler. Falcon-40B'yi LMI ve DeepSpeed kullanarak barındırmak için ml.g5.24xlarge örneğini kullanmamız gerekiyor. Bu örnekler, her biri 4 GiB GPU belleğini destekleyen 10x NVIDIA A96G GPU sağlar. Ayrıca ana bilgisayar, 96 vCPU ve 384 GiB ana bilgisayar belleği sağlar. LMI kapsayıcısı, modelin indirilmesi ve model yapısının bölümlenmesi de dahil olmak üzere, LLM'lerin barındırılmasıyla ilişkili farklılaştırılmamış ağır yüklerin çoğunun ele alınmasına yardımcı olacak, böylece onu oluşturan parametreler birden fazla GPU'ya yayılabilecektir.

SageMaker makine öğrenimi (ML) örneklerine yönelik kotalar hesaplar arasında değişiklik gösterebilir. Bu gönderiyi takip ederken g5.24xlarge bulut sunucuları için kotanızı aştığınızı belirten bir hata alırsanız limiti şu adresten artırabilirsiniz: Hizmet Kotaları konsolu.

Dizüstü bilgisayar kılavuzu

Başlamak için örneğimiz için gerekli bağımlılıkları yükleyip içe aktararak başlıyoruz. Boto3 SDK'nın yanı sıra SageMaker SDK'yı da kullanıyoruz. Kullandığımızı unutmayın Amazon Basit Depolama Hizmeti (Amazon S3) SageMaker ve LMI'nin kullanması için ihtiyaç duyduğumuz model yapıtlarını depolamak için, buna göre bir S3 önek değişkeni ayarladık. Aşağıdaki koda bakın:

Daha sonra çalışma alanımızın model yapıtlarımızı depolaması için yerel bir klasör oluşturuyoruz:

ilk önce bir tane oluşturuyoruz serving.properties Oluşturduğumuz yerel dizindeki yapılandırma dosyası. Bu serving.properties dosyası, LMI kapsayıcısına ve ön uç DJL Hizmet kitaplığına hangi model paralelleştirme ve çıkarım optimizasyon motorunu kullanmak istediğimizi gösterir. Hem DeepSpeed hem de Hugging Face Accelerate için yapılandırma seçeneklerini şurada bulabilirsiniz: Yapılandırmalar ve ayarlar. Burada, ayarladığımızı unutmayın. option.model_id Hangi Hugging Face modelinin alınacağını tanımlayan parametre. SageMaker, Hugging Face modelleriyle çalışmayı basitleştirir ve ihtiyacınız olan tek şey bu tek çizgidir. Ayrıca, belirlediğimiz option.tensor_parallel_degree değerini 4'e çıkarıyoruz çünkü ml.g5.24xlarge örneğimizde dört GPU'muz var. Bu parametre, modelin kaç bölümünün oluşturulacağını ve dağıtılacağını tanımlar. Ml.g5.48xlarge gibi sekiz GPU'lu daha büyük bir örnek kullanmış olsaydık ve değeri hala 4 olarak ayarlasaydık, LMI'nın otomatik olarak modelin iki kopyasını (her biri dört GPU'ya yayılmış iki kopya) oluşturacağını unutmayın. Aşağıdaki koda bakın:

Ayrıca değiştirebilirsiniz tiiuae/falcon-40b ile tiiuae/falcon-40b-instruct ihtiyaçlarınızı daha iyi karşılıyorsa.

Ayrıca şunları da dahil ediyoruz: requirements.txt İhtiyacınız olan paketleri yüklemek için belirtebileceğiniz dosya:

İhtiyacımız olan son şey model.py modelinizle kullanılacak dosya:

Bu kadar! Bu noktada Falcon-40B'yi DeepSpeed ile konuşlandırmak için ihtiyaç duyacağınız tüm eserleri oluşturduk! Dizini bir *.tar.gz dosyasına paketleyip Amazon S3'e yüklüyoruz. Gerçek modelin bu dosyaya indirilmediğini veya paketlenmediğini unutmayın. LMI kapsayıcısı sizin için modeli doğrudan Hugging Face'ten indirecektir. Ayrıca, modelin kendi kopyasının indirilmesi daha performanslı olacak bir konumda olmasını istiyorsanız bir S3 klasörünü hedefleme seçeneğiniz de vardır. LMI ayrıca Amazon S3'ten yüksek performansla indirmeye yönelik optimizasyonu da içerir. Aşağıdaki koda bakın:

Bu noktada yapmamız gereken tek şey kullanmak istediğimiz konteyneri tanımlayıp bir model nesnesi oluşturmak:

Daha sonra bir uç nokta konfigürasyonu oluşturup uç noktayı oluşturuyoruz:

Başarılı barındırma için akılda tutulması gereken yapılandırma öğeleri

Büyük model barındırmada dikkate alınması gereken önemli bir husus, modelin Hugging Face'ten indirilmesi için yeterli zamanın olmasını sağlamaktır. Testlerimizde Falcon-40B'nin bulut sunucusuna indirilmesi yaklaşık 90 dakika sürdü. Buna izin verecek temel konfigürasyonlar şunlardır: ContainerStartupHealthCheckTimeoutInSeconds ve ModelDataDownloadTimeoutInSeconds. Bunların her biri için SageMaker uç nokta yapılandırmasının 3600 değerine sahip olduğundan emin olun. Ek olarak, model indirme süresini yaklaşık 3 dakikaya indiren S5cmd yardımcı programını kullanan LLMS için özel olarak tasarlanmış LMI kapsayıcılarını kullanarak orijinal model hayvanat bahçesi yerine Amazon S10'ten indirme yapmak çok daha kolaydır.

Çağrı yaparak uç noktanın durumunu izleyebilirsiniz. DescribeEndpoint, her şeyin ne zaman tamamlandığını size söyleyecektir. Uç noktanız artık çıkarım isteklerine yanıt vermeye hazır! LMI sizin için model bölümleme ve orkestrasyon işlemlerini gerçekleştirdiğinden, her istek ml.g4xlarge örneğimizde bulunan 5.12 GPU'nun tümü kullanılarak işlenecektir. Bu, Yüksek Lisans Derecelerini barındırmamıza ve GPU hızlandırıcılarını yatay olarak ölçeklendirirseniz performansı artırmamıza olanak tanır. Aşağıdaki koda bakın:

İşiniz bittiyse ve uç nokta yapılandırmasını, uç noktayı ve model nesnesini silmek istiyorsanız aşağıdaki komutları çalıştırabilirsiniz:

Bu yazıda referans verdiğimiz bu kodu tam olarak bulabilirsiniz. GitHub'daki not defteri.

Sonuç

SageMaker Hosting ve LMI DLC, Falcon-40B gibi Yüksek Lisans'lara ev sahipliği yapmanızı kolaylaştırır. Modelleri birden fazla GPU'da barındırmak için gerekenlerin düzenlenmesinde farklılaşmamış ağır yükü üstlenir ve ihtiyaçlarınıza uyacak şekilde yapılandırılabilir seçenekler sunar. Ayrıca Hugging Face modellerinin kullanımı, bu modellere yönelik yerleşik destek sayesinde çok kolay hale geliyor.

Bu yazımızda DeepSpeed kullanarak Falcon-40B modelini barındırmak için SageMaker'ı nasıl kullanabileceğinizi gösterdik. Ayrıca, örnekler de verdik. GitHub Falcon-40B'yi Accelerate kullanarak ve daha küçük Falcon-7B modellerini barındırmak için. Bunu LMI ile SageMaker'da denemenizi ve bugüne kadarki en iyi performansa sahip halka açık LLM'yi uygulamalı olarak denemenizi öneririz!

yazarlar hakkında

James Park Amazon Web Services'ta bir Çözüm Mimarıdır. AWS'de teknoloji çözümleri tasarlamak, oluşturmak ve dağıtmak için Amazon.com ile birlikte çalışıyor ve yapay zeka ve makine öğrenimine özel bir ilgisi var. Boş zamanlarında yeni kültürler, yeni deneyimler aramayı ve en son teknoloji trendlerini takip etmeyi seviyor.Onu şu adreste bulabilirsiniz: LinkedIn.

James Park Amazon Web Services'ta bir Çözüm Mimarıdır. AWS'de teknoloji çözümleri tasarlamak, oluşturmak ve dağıtmak için Amazon.com ile birlikte çalışıyor ve yapay zeka ve makine öğrenimine özel bir ilgisi var. Boş zamanlarında yeni kültürler, yeni deneyimler aramayı ve en son teknoloji trendlerini takip etmeyi seviyor.Onu şu adreste bulabilirsiniz: LinkedIn.

Abhi Shivaditya AWS'de Yapay Zeka, dağıtılmış bilgi işlem, ağ iletişimi ve depolama gibi alanlarda AWS hizmetlerinin benimsenmesini kolaylaştırmak için stratejik küresel kurumsal kuruluşlarla birlikte çalışan Kıdemli Çözüm Mimarıdır. Uzmanlığı, Doğal Dil İşleme (NLP) ve Bilgisayarla Görü alanlarındaki Derin Öğrenmede yatmaktadır. Abhi, müşterilerin AWS ekosisteminde yüksek performanslı makine öğrenimi modellerini verimli bir şekilde dağıtmalarına yardımcı olur.

Abhi Shivaditya AWS'de Yapay Zeka, dağıtılmış bilgi işlem, ağ iletişimi ve depolama gibi alanlarda AWS hizmetlerinin benimsenmesini kolaylaştırmak için stratejik küresel kurumsal kuruluşlarla birlikte çalışan Kıdemli Çözüm Mimarıdır. Uzmanlığı, Doğal Dil İşleme (NLP) ve Bilgisayarla Görü alanlarındaki Derin Öğrenmede yatmaktadır. Abhi, müşterilerin AWS ekosisteminde yüksek performanslı makine öğrenimi modellerini verimli bir şekilde dağıtmalarına yardımcı olur.

Robert Van Düsen Amazon SageMaker'da Kıdemli Ürün Yöneticisidir. Büyük model çıkarımı gibi uygulamalar için derin öğrenme modeli optimizasyonuna öncülük ediyor.

Robert Van Düsen Amazon SageMaker'da Kıdemli Ürün Yöneticisidir. Büyük model çıkarımı gibi uygulamalar için derin öğrenme modeli optimizasyonuna öncülük ediyor.

Evandro Franco Amazon Web Services üzerinde çalışan bir AI/ML Uzman Çözüm Mimarıdır. AWS müşterilerinin AWS'nin yanı sıra AI/ML ile ilgili iş zorluklarının üstesinden gelmesine yardımcı oluyor. Yazılım geliştirme, altyapı, sunucusuz çalışma ve makine öğrenimine kadar teknolojiyle ilgili 15 yılı aşkın süredir çalışıyor.

Evandro Franco Amazon Web Services üzerinde çalışan bir AI/ML Uzman Çözüm Mimarıdır. AWS müşterilerinin AWS'nin yanı sıra AI/ML ile ilgili iş zorluklarının üstesinden gelmesine yardımcı oluyor. Yazılım geliştirme, altyapı, sunucusuz çalışma ve makine öğrenimine kadar teknolojiyle ilgili 15 yılı aşkın süredir çalışıyor.

Qing Lan AWS'de Yazılım Geliştirme Mühendisidir. Amazon'da yüksek performanslı ML çıkarım çözümleri ve yüksek performanslı günlük kaydı sistemi dahil olmak üzere birçok zorlu ürün üzerinde çalışıyor. Qing'in ekibi, Amazon Advertising'de çok düşük gecikme süresi gerektiren ilk Milyar parametre modelini başarıyla başlattı. Qing, altyapı optimizasyonu ve Derin Öğrenme hızlandırması hakkında derinlemesine bilgi sahibidir.

Qing Lan AWS'de Yazılım Geliştirme Mühendisidir. Amazon'da yüksek performanslı ML çıkarım çözümleri ve yüksek performanslı günlük kaydı sistemi dahil olmak üzere birçok zorlu ürün üzerinde çalışıyor. Qing'in ekibi, Amazon Advertising'de çok düşük gecikme süresi gerektiren ilk Milyar parametre modelini başarıyla başlattı. Qing, altyapı optimizasyonu ve Derin Öğrenme hızlandırması hakkında derinlemesine bilgi sahibidir.

Frank Liu AWS Deep Learning için Yazılım Mühendisidir. Yazılım mühendisleri ve bilim adamları için yenilikçi derin öğrenme araçları oluşturmaya odaklanıyor. Boş zamanlarında arkadaşları ve ailesi ile yürüyüş yapmayı sever.

Frank Liu AWS Deep Learning için Yazılım Mühendisidir. Yazılım mühendisleri ve bilim adamları için yenilikçi derin öğrenme araçları oluşturmaya odaklanıyor. Boş zamanlarında arkadaşları ve ailesi ile yürüyüş yapmayı sever.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- EVM Finans. Merkezi Olmayan Finans için Birleşik Arayüz. Buradan Erişin.

- Kuantum Medya Grubu. IR/PR Güçlendirilmiş. Buradan Erişin.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/deploy-falcon-40b-with-large-model-inference-dlcs-on-amazon-sagemaker/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 100

- 13

- 14

- 15 yıl

- %15

- 20

- 22

- 27

- 7

- 8

- 9

- a

- Hakkımızda

- hızlandırmak

- hızlandırıcılar

- kabul edilebilir

- göre

- Hesaplar

- doğruluk

- doğru

- Başarmak

- karşısında

- gerçek

- ekleme

- ilave

- Ayrıca

- adres

- Benimseme

- avantaj

- reklâm

- karşı

- AI

- AI / ML

- Türkiye

- izin vermek

- veriyor

- Ayrıca

- Rağmen

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- Amazon.com

- an

- ve

- herhangi

- API'ler

- uygulamaları

- uygulamalı

- ARE

- alanlar

- etrafında

- yapay

- yapay zeka

- AS

- Yardım

- asist

- ilişkili

- At

- Oto

- Otomatik

- Otomatik

- otomatik olarak

- mevcut

- AWS

- Backend

- BE

- Çünkü

- olur

- olmuştur

- başlamak

- olmak

- Daha iyi

- arasında

- milyarlarca

- övünme

- vücut

- her ikisi de

- buluşların

- inşa etmek

- bina

- yerleşik

- iş

- fakat

- by

- çağrı

- çağrı

- CAN

- yapamam

- zorluklar

- zor

- Kontrol

- kod

- COM

- nispeten

- tamamlamak

- içeren

- bilgisayar

- Bilgisayar görüşü

- bilgisayar

- yapılandırma

- dikkate

- Konteyner

- Konteynerler

- konuşkan

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- Şu anda

- Müşteriler

- keser

- veri

- Tarih

- adanmış

- derin

- derin öğrenme

- tanımlar

- göstermek

- dağıtmak

- dağıtma

- Dizayn

- tasarlanmış

- gelişme

- DICT

- farklı

- Zorluk

- direkt olarak

- keşif

- dağıtmak

- dağıtıldı

- Dağıtılmış bilgi işlem

- do

- etki

- yapılmış

- Dont

- indir

- her

- Daha erken

- kolay

- kolay

- ekosistem

- verimli biçimde

- çaba

- teşvik etmek

- son

- son uca

- Son nokta

- Motor

- mühendis

- Mühendisler

- Motorlar

- sağlanması

- kuruluş

- hata

- değerlendirme

- her şey

- örnek

- örnekler

- aşıldı

- infaz

- pahalı

- Deneyimler

- Uzmanlık

- Yüz

- kolaylaştırmak

- aile

- Daha hızlı

- Özellikler

- fileto

- bulmak

- Ad

- uygun

- odaklanır

- takip etme

- İçin

- bulundu

- vakıf

- dört

- arkadaşlar

- itibaren

- ön

- Başlangıç aşaması

- işlevsellik

- daha fazla

- genellikle

- jeneratör

- almak

- Vermek

- Küresel

- Go

- GPU

- GPU'lar

- vardı

- Kolları

- hands-on

- olur

- Var

- he

- ağır

- ağırlık kaldırma

- yardım et

- yardımcı olur

- okuyun

- Yüksek

- yüksek performans

- onu

- onun

- yatay

- ev sahibi

- hosting

- ev

- Ne kadar

- Nasıl Yapılır

- HTML

- http

- HTTPS

- if

- görüntü

- ithalat

- önemli

- ithal

- in

- derinlemesine

- dahil

- içerir

- Dahil olmak üzere

- Artırmak

- gösterir

- Altyapı

- Yenilikçilik

- yenilikçi

- giriş

- girişler

- kurmak

- yükleme

- örnek

- yerine

- Enstitü

- İstihbarat

- etkileşim

- faiz

- içine

- IT

- ürün

- ONUN

- İş

- jpg

- json

- tutmak

- anahtar

- bilgi

- dil

- büyük

- büyük

- Soyad

- Gecikme

- son

- başlattı

- İlanlar

- ÖĞRENİN

- öğrenme

- sol

- miras

- az

- Kütüphane

- yalan

- hayat

- kaldırma

- hafif

- sevmek

- LİMİT

- çizgi

- Yüksek Lisans

- yerel

- yer

- günlüğü

- Düşük

- makine

- makine öğrenme

- yapmak

- YAPAR

- yönetmek

- müdür

- çok

- Bellek

- akla

- dakika

- ML

- model

- modelleri

- izlemek

- Daha

- çok

- çoklu

- şart

- Doğal (Madenden)

- Doğal Dil İşleme

- gerekli

- gerek

- ihtiyaçlar

- ağ

- yeni

- nlp

- defter

- şimdi

- Nvidia

- nesne

- of

- teklif

- sık sık

- on

- ONE

- bir tek

- açık kaynak

- optimizasyon

- optimize

- seçenek

- Opsiyonlar

- or

- orkestrasyon

- kuruluşlar

- organizasyonlar

- orijinal

- OS

- Diğer

- bizim

- dışarı

- çıktı

- Üstesinden gelmek

- kendi

- paket

- paketlenmiş

- paketler

- Paralel

- parametre

- parametreler

- belirli

- yol

- performans

- parçalar

- boru hattı

- Platon

- Plato Veri Zekası

- PlatoVeri

- Nokta

- Popüler

- Çivi

- güçler

- Predictor

- hazırlanmış

- önceki

- İşlenmiş

- işleme

- PLATFORM

- ürün müdürü

- Ürünler

- özellikleri

- sağlamak

- sağlanan

- sağlar

- alenen

- amaç

- hazır

- teslim almak

- bölge

- ilgili

- kopya

- talep

- gerektirir

- gereklidir

- gerektirir

- araştırma

- Araştırmacılar

- Yanıtlamak

- sonuç

- dönüş

- Rol

- koşmak

- sagemaker

- ölçek

- bilimsel

- bilim adamları

- sdk

- görmek

- arayan

- kıdemli

- Serverless

- Hizmetler

- servis

- Oturum

- set

- birkaç

- gösterdi

- Basit

- basitleştirmek

- sadece

- tek

- beden

- daha küçük

- So

- Toplum

- Yazılım

- yazılım geliştirme

- Yazılım Mühendisi

- çözüm

- Çözümler

- uzman

- özel olarak

- yayılma

- başlama

- başladı

- başlangıç

- state-of-the-art

- Durum

- Yine

- hafızası

- mağaza

- basit

- Stratejik

- stratejileri

- akış

- başarılı

- Başarılı olarak

- böyle

- Takım elbise

- destek

- takas

- sistem

- Bizi daha iyi tanımak için

- alır

- Hedef

- takım

- Teknolojileri

- Teknoloji

- söylemek

- testleri

- göre

- o

- The

- ve bazı Asya

- sonra

- Orada.

- Bunlar

- onlar

- şey

- işler

- Re-Tweet

- Bu yıl

- üç

- İçinden

- verim

- zaman

- zamanlar

- için

- simge

- Jeton

- aldı

- araçlar

- üst

- meşale

- Tren

- eğitilmiş

- trenler

- dönüştürücü

- transformatör

- transformatörler

- Trendler

- Trilyon

- denemek

- iki

- tip

- türleri

- tipik

- anlayış

- Yüklenen

- us

- kullanım

- Kullanılmış

- kullanma

- yarar

- değer

- çok

- vizyonumuz

- istemek

- oldu

- we

- ağ

- web hizmetleri

- hafta

- İYİ

- Ne

- Nedir

- ne zaman

- oysa

- hangi

- süre

- irade

- ile

- içinde

- çalışma

- çalışır

- kötü

- olur

- yazı yazıyor

- yıl

- yıl

- Sen

- zefirnet

- ZOO