Üretken yapay zeka, eğlence, reklamcılık ve grafik tasarım da dahil olmak üzere çeşitli sektörlerde yaratıcı süreci geliştirmek ve hızlandırmak için yaygın bir araç haline geldi. İzleyiciler için daha kişiselleştirilmiş deneyimler sağlar ve nihai ürünlerin genel kalitesini artırır.

Üretken yapay zekanın önemli faydalarından biri, kullanıcılar için benzersiz ve kişiselleştirilmiş deneyimler yaratmaktır. Örneğin, üretken yapay zeka, izleyici etkileşimini artırmak ve kullanıcının görüntüleme geçmişine ve tercihlerine göre başlıklar için görseller oluşturmak üzere kişiselleştirilmiş film başlıkları ve görseller oluşturmak amacıyla akış hizmetleri tarafından kullanılır. Sistem daha sonra bir başlığın çiziminin binlerce varyasyonunu oluşturur ve kullanıcının dikkatini en çok hangi sürümün çektiğini belirlemek için bunları test eder. Bazı durumlarda, TV dizileri için kişiselleştirilmiş sanat eserleri, kişiselleştirilmiş sanat eseri olmayan şovlarla karşılaştırıldığında tıklama oranlarını ve izlenme oranlarını önemli ölçüde artırdı.

Bu yazıda, kişiselleştirilmiş bir avatar çözümü oluşturmak için Stabil Difüzyon gibi üretken yapay zeka modellerini nasıl kullanabileceğinizi gösteriyoruz. Amazon Adaçayı Yapıcı ve aynı anda çok modelli uç noktalarla (MME'ler) çıkarım maliyetinden tasarruf edin. Çözüm, aşağıdaki ekran görüntülerinde gösterildiği gibi, kendinize ait 10-12 görsel yükleyerek, kişiselleştirilmiş bir modele nasıl ince ayar yapabileceğinizi ve ardından herhangi bir metin istemine dayalı olarak avatarlar oluşturabileceğinizi gösterir. Bu örnek kişiselleştirilmiş avatarlar oluştursa da, belirli nesnelere veya stillere ince ayar yaparak tekniği herhangi bir yaratıcı sanat nesline uygulayabilirsiniz.

Çözüme genel bakış

Aşağıdaki mimari diyagram, avatar oluşturucumuz için uçtan uca çözümü özetlemektedir.

![]()

Bu yazının kapsamı ve örnek GitHub kodu yalnızca model eğitimine ve çıkarım düzenlemesine (önceki diyagramdaki yeşil bölüm) odaklanıyoruz. Tam çözüm mimarisine başvurabilir ve sunduğumuz örneğin üzerine inşa edebilirsiniz.

Model eğitimi ve çıkarımı dört adıma ayrılabilir:

- Resimleri şuraya yükle: Amazon Basit Depolama Hizmeti (Amazon S3). Bu adımda sizden en az 10 adet yüksek çözünürlüklü görselinizi sağlamanızı rica ediyoruz. Ne kadar çok görüntü olursa sonuç o kadar iyi olur, ancak eğitim de o kadar uzun sürer.

- SageMaker eşzamansız çıkarımını kullanarak Stabil Difüzyon 2.1 temel modeline ince ayar yapın. Bu yazının ilerleyen kısımlarında eğitim için çıkarım uç noktası kullanmanın mantığını açıklayacağız. İnce ayar süreci, yüz kırpma, arka plan değişikliği ve model için yeniden boyutlandırma dahil olmak üzere görüntülerin hazırlanmasıyla başlar. Daha sonra modele ince ayar yapmak için büyük dil modelleri (LLM'ler) için parametre açısından verimli bir ince ayar tekniği olan Düşük Sıralı Uyarlama'yı (LoRA) kullanırız. Son olarak, son işlemlerde, ince ayarlanmış LoRA ağırlıklarını çıkarım komut dosyası ve yapılandırma dosyaları (tar.gz) ile paketliyoruz ve bunları SageMaker MME'ler için bir S3 klasör konumuna yüklüyoruz.

- GPU'lu SageMaker MME'leri kullanarak ince ayarlı modelleri barındırın. SageMaker, her modele gelen çıkarım trafiğine göre modeli dinamik olarak Amazon S3 konumundan yükleyecek ve önbelleğe alacaktır.

- Çıkarım için ince ayarlı modeli kullanın. Sonra Amazon Basit Bildirim Servisi (Amazon SNS) ince ayarın yapıldığını belirten bildirim gönderildiyse, o modeli hemen kullanabilirsiniz.

target_modelAvatarınızı oluşturmak için MME'yi çağırırken parametre.

Aşağıdaki bölümlerde her adımı daha ayrıntılı olarak açıklayacağız ve bazı örnek kod parçacıklarını inceleyeceğiz.

Görselleri hazırlayın

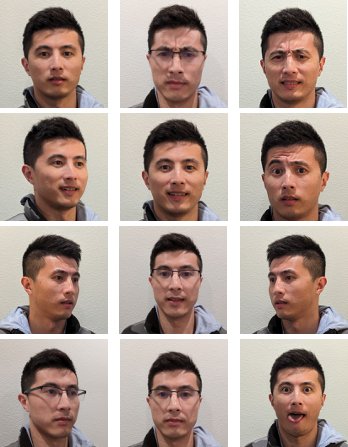

Kendi görüntülerinizi oluşturmak amacıyla Kararlı Dağılım'da ince ayar yaparak en iyi sonuçları elde etmek için, genellikle farklı açılardan, farklı ifadelerle ve farklı arka planlardan çekilmiş çok sayıda ve çeşitlilikte fotoğraf sağlamanız gerekir. Ancak uygulamamızla artık 10 kadar az girdi görüntüsüyle yüksek kaliteli bir sonuç elde edebilirsiniz. Yüzünüzü her fotoğraftan çıkarmak için otomatik ön işleme de ekledik. İhtiyacınız olan tek şey, birden fazla perspektiften net bir şekilde nasıl göründüğünüzün özünü yakalamaktır. Öne bakan bir fotoğraf, her iki taraftan çekilmiş bir profil fotoğrafı ve aradaki açılardan fotoğraflar ekleyin. Gülümseme, kaşlarını çatma, nötr ifade gibi farklı yüz ifadelerinin yer aldığı fotoğraflara da yer vermelisiniz. İfadelerin bir karışımına sahip olmak, modelin benzersiz yüz özelliklerinizi daha iyi yeniden üretmesine olanak tanır. Giriş görüntüleri, oluşturabileceğiniz avatarın kalitesini belirler. Bunun doğru şekilde yapıldığından emin olmak için, kullanıcıya görüntü yakalama ve yükleme sürecinde rehberlik edecek sezgisel bir ön uç kullanıcı arayüzü deneyimi öneriyoruz.

Aşağıda farklı yüz ifadelerine sahip, farklı açılardan örnek selfie görüntüleri yer almaktadır.

![]()

Kararlı Difüzyon modeline ince ayar yapın

Görüntüler Amazon S3'e yüklendikten sonra SageMaker eşzamansız çıkarım eğitim sürecimizi başlatmak için uç nokta. Eşzamansız uç noktalar, büyük yüklere (1 GB'a kadar) ve uzun işlem sürelerine (1 saate kadar) sahip çıkarım kullanım senaryolarına yöneliktir. Ayrıca SageMaker barındırmanın otomatik ölçeklendirme gibi diğer yerel özelliklerine ek olarak istekleri sıraya koymak için yerleşik bir sıraya alma mekanizması ve Amazon SNS aracılığıyla bir görev tamamlama bildirim mekanizması sağlar.

İnce ayar, çıkarım amaçlı bir kullanım durumu olmasa da, yerleşik sıraya alma ve bildirim mekanizmaları nedeniyle burada SageMaker eğitim işleri yerine onu kullanmayı seçtik. yönetilen otomatik ölçeklendirmeHizmet kullanılmadığında ölçeği 0 örneğe düşürme yeteneği de dahil. Bu, ince ayar hizmetini çok sayıda eşzamanlı kullanıcıya kolayca ölçeklendirmemize olanak tanır ve ek bileşenleri uygulama ve yönetme ihtiyacını ortadan kaldırır. Ancak, 1 GB veri kapasitesi ve 1 saatlik maksimum işlem süresi gibi dezavantajları da beraberinde getiriyor. Testlerimizde, bir ml.g20xlarge örneğinde yaklaşık 10 giriş görüntüsüyle oldukça iyi sonuçlar elde etmek için 5.2 dakikanın yeterli bir süre olduğunu bulduk. Ancak SageMaker eğitimi, daha büyük ölçekli ince ayar işleri için önerilen yaklaşım olacaktır.

Eşzamansız uç noktayı barındırmak için birkaç adımı tamamlamamız gerekir. İlki model sunucumuzu tanımlamaktır. Bu yazı için şunu kullanıyoruz: Büyük Model Çıkarım Kabı (LMI). LMI, yüksek performanslı, programlama dilinden bağımsız bir model hizmet çözümü olan DJL Serving tarafından desteklenmektedir. Bu seçeneği seçtik çünkü SageMaker yönetilen çıkarım kapsayıcısında Hugging Face gibi ihtiyaç duyduğumuz birçok eğitim kütüphanesi zaten mevcut difüzörler ve Hızlandırmak. Bu, konteyneri ince ayar işimize göre özelleştirmek için gereken iş miktarını büyük ölçüde azaltır.

Aşağıdaki kod parçacığı, örneğimizde kullandığımız LMI kapsayıcısının sürümünü gösterir:

Buna ek olarak bir de sahip olmamız gerekiyor. serving.properties Kullanılacak çıkarım motoru, model yapısının konumu ve dinamik toplu işlem de dahil olmak üzere sunum özelliklerini yapılandıran dosya. Son olarak, bir şeye sahip olmalıyız model.py Modeli çıkarım motoruna yükleyen ve modelden veri giriş ve çıkışını hazırlayan dosya. Örneğimizde, şunu kullanıyoruz: model.py Daha sonraki bir bölümde daha ayrıntılı olarak açıklayacağımız ince ayar işini başlatmak için dosyayı kullanın. İkisi de serving.properties ve model.py dosyalar şurada verilmiştir training_service klasör.

Model sunucumuzu tanımladıktan sonraki adım, asenkron çıkarımımızın nasıl sunulacağını tanımlayan bir uç nokta konfigürasyonu oluşturmaktır. Örneğimiz için, yalnızca maksimum eşzamanlı çağrı sınırını ve çıkış S3 konumunu tanımlıyoruz. İle ml.g5.2xlarge Örneğin, bellek yetersiz (OOM) istisnasıyla karşılaşmadan aynı anda iki modele kadar ince ayar yapabildiğimizi bulduk ve bu nedenle max_concurrent_invocations_per_instance 2'ye kadar. Farklı bir ayarlama parametreleri kümesi veya daha küçük bir bulut sunucusu türü kullanıyorsak bu sayının ayarlanması gerekebilir. Başlangıçta bunu 1'e ayarlamanızı ve GPU bellek kullanımını izlemenizi öneririz. Amazon Bulut İzleme.

Son olarak konteyner bilgilerini, model dosyalarını ve paketlerini paketleyen bir SageMaker modeli oluşturuyoruz. AWS Kimlik ve Erişim Yönetimi (IAM) rolünü tek bir nesneye dönüştürün. Model, daha önce tanımladığımız uç nokta yapılandırması kullanılarak dağıtılır:

Uç nokta hazır olduğunda, eşzamansız uç noktayı çağırmak ve ince ayar işlemini başlatmak için aşağıdaki örnek kodu kullanırız:

SageMaker'daki LMI hakkında daha fazla ayrıntı için bkz. DJLServing ve DeepSpeed model paralel çıkarımını kullanarak büyük modelleri Amazon SageMaker'da dağıtın.

Çağrımdan sonra, eşzamansız uç nokta ince ayar işimizi sıraya koymaya başlar. Her iş şu adımlardan geçer: görüntüleri hazırlayın, Dreambooth ve LoRA ince ayarını yapın ve model yapıtlarını hazırlayın. İnce ayar sürecine daha derinlemesine bakalım.

Görselleri hazırlayın

Daha önce de belirttiğimiz gibi girdi görüntülerinin kalitesi, ince ayar yapılan modelin kalitesini doğrudan etkiler. Avatar kullanım durumu için modelin yüz özelliklerine odaklanmasını istiyoruz. Kullanıcıların tam boyut ve içerikte özenle seçilmiş görseller sağlamasını zorunlu kılmak yerine, bu yükü hafifletmek için bilgisayarla görme tekniklerini kullanarak bir ön işleme adımı uyguluyoruz. Ön işleme adımında öncelikle her görüntüdeki en büyük yüzü izole etmek için bir yüz algılama modeli kullanıyoruz. Daha sonra görüntüyü modelimiz için gereken 512 x 512 piksel boyutuna kırpıp dolduruyoruz. Son olarak, yüzü arka plandan bölümlere ayırıyoruz ve rastgele arka plan varyasyonları ekliyoruz. Bu, yüz özelliklerinin vurgulanmasına yardımcı olarak modelimizin arka plan yerine yüzün kendisinden öğrenmesine olanak tanır. Aşağıdaki resimler bu süreçteki üç adımı göstermektedir.

| 1 Adım: Bilgisayarla görme kullanarak yüz algılama | 2 Adım: Görüntüyü 512 x 512 piksele kadar kırpın ve doldurun | Adım 3 (İsteğe Bağlı): Arka plan varyasyonunu segmentlere ayırın ve ekleyin |

Dreambooth ve LoRA'da ince ayar

İnce ayar için Dreambooth ve LoRA tekniklerini birleştirdik. Dreambooth, benzersiz bir tanımlayıcı kullanarak bir nesneyi modelin çıktı alanına yerleştirerek ve modelin dil görüş sözlüğünü genişleterek Kararlı Difüzyon modelinizi kişiselleştirmenize olanak tanır. Adı verilen bir yöntemi kullanır ön koruma modelin konunun sınıfına (bu durumda bir kişiye) ilişkin anlamsal bilgisini korumak ve son görüntü çıktısını iyileştirmek için sınıftaki diğer nesneleri kullanmak. Dreambooth, konunun yalnızca birkaç girdi görüntüsüyle yüksek kaliteli sonuçları bu şekilde elde edebilir.

Aşağıdaki kod parçacığı bizim girdilerimizi gösterir. trainer.py avatar çözümümüz için sınıf. Seçtiğimize dikkat edin <<TOK>> benzersiz tanımlayıcı olarak. Bu, modelin sözlüğünde zaten bulunabilecek bir adın seçilmesini önlemek için bilerek yapılır. Ad zaten mevcutsa, modelin konuyu öğrenmesi ve ardından yeniden öğrenmesi gerekir; bu da zayıf ince ayar sonuçlarına yol açabilir. Konu sınıfı şu şekilde ayarlandı: “a photo of person”Bu, ince ayar süreci sırasında ek girdi olarak öncelikle insanların fotoğraflarını oluşturarak önceden korumayı mümkün kılar. Bu, model, önceki koruma yöntemini kullanarak bir kişinin önceki bilgisini korumaya çalıştığı için aşırı uyumun azaltılmasına yardımcı olacaktır.

Yapılandırmada bir dizi bellek tasarrufu seçeneği etkinleştirilmiştir; bunlar arasında fp16, use_8bit_adamve gradyan birikimi. Bu, bellek alanını 12 GB'nin altına düşürür; bu da aynı anda iki modele kadar ince ayar yapılmasına olanak tanır. ml.g5.2xlarge örneği.

LoRA, ağırlıkların çoğunu donduran ve önceden eğitilmiş LLM'nin belirli katmanlarına küçük bir adaptör ağı bağlayarak, daha hızlı eğitime ve optimize edilmiş depolamaya olanak tanıyan LLM'ler için etkili bir ince ayar tekniğidir. Kararlı Difüzyon için bağdaştırıcı, çıkarım hattının metin kodlayıcısına ve U-Net bileşenlerine eklenir. Metin kodlayıcı, giriş istemini U-Net modeli tarafından anlaşılan gizli bir alana dönüştürür ve U-Net modeli, sonraki yayılma sürecinde görüntüyü oluşturmak için gizli anlamı kullanır. İnce ayarın çıktısı sadece text_encoder ve U-Net adaptör ağırlıkları. Çıkarım zamanında bu ağırlıklar, ince ayar sonuçlarını yeniden oluşturmak için temel Kararlı Difüzyon modeline yeniden eklenebilir.

Aşağıdaki şekiller orijinal yazar tarafından sağlanan LoRA ince ayarının ayrıntılı diyagramıdır: Cheng-Han Chiang, Yung-Sung Chuang, Hung-yi Lee, “AACL_2022_tutorial_PLMs,” 2022

Her iki yöntemi birleştirerek, büyüklük sırasına göre daha az parametreyi ayarlarken kişiselleştirilmiş bir model oluşturmayı başardık. Bu, çok daha hızlı bir eğitim süresine ve GPU kullanımının azalmasına neden oldu. Ek olarak depolama, tam Stabil Difüzyon modeli için 70 GB'a kıyasla adaptör ağırlığının yalnızca 6 MB olmasıyla optimize edildi; bu da %99'luk bir boyut küçültmeyi temsil ediyor.

Model eserlerini hazırlayın

İnce ayar tamamlandıktan sonra, son işleme adımı, modelin geri kalanının NVIDIA Triton için dosya sunmasıyla LoRA ağırlıklarını TARlayacaktır. Bir Python arka ucu kullanıyoruz; bu, Triton yapılandırma dosyasının ve çıkarım için kullanılan Python betiğinin gerekli olduğu anlamına gelir. Python betiğinin adlandırılması gerektiğini unutmayın model.py. Nihai model TAR dosyası aşağıdaki dosya yapısına sahip olmalıdır:

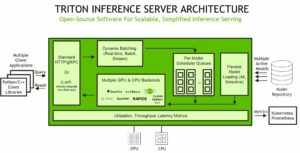

GPU'lu SageMaker MME'leri kullanarak ince ayarlı modelleri barındırın

Modellere ince ayar yapıldıktan sonra kişiselleştirilmiş Stabil Difüzyon modellerini SageMaker MME kullanarak barındırıyoruz. SageMaker MME, tek bir uç noktanın arkasındaki tek bir konteynerde birden fazla modelin barındırılmasına olanak tanıyan güçlü bir dağıtım özelliğidir. Kaynak kullanımını optimize etmek, maliyetlerden tasarruf etmek ve binlerce uç noktayı yönetmenin operasyonel yükünü en aza indirmek için modellerinize yönelik trafiği ve yönlendirmeyi otomatik olarak yönetir. Örneğimizde GPU örnekleri üzerinde çalışıyoruz ve SageMaker MME'ler Triton Sunucusunu kullanan GPU'yu destekliyor. Bu, tek bir GPU cihazında birden fazla modeli çalıştırmanıza ve hızlandırılmış bilgi işlem avantajından yararlanmanıza olanak tanır. SageMaker MME'lerde Stabil Difüzyonun nasıl barındırılacağı hakkında daha fazla ayrıntı için bkz. Stable Diffusion modelleriyle yüksek kaliteli görüntüler oluşturun ve bunları Amazon SageMaker ile uygun maliyetli bir şekilde dağıtın.

Örneğimizde, soğuk başlatma durumlarında ince ayarlı modellerin daha hızlı yüklenmesi için ek optimizasyon yaptık. Bu, LoRA'nın adaptör tasarımı sayesinde mümkündür. Temel model ağırlıkları ve Conda ortamları tüm ince ayarlı modeller için aynı olduğundan, bu ortak kaynakları barındırma kapsayıcısına önceden yükleyerek paylaşabiliriz. Geriye yalnızca Triton yapılandırma dosyası olan Python arka ucu (model.py) ve LoRA bağdaştırıcı ağırlıklarının ilk çağrıdan sonra Amazon S3'ten dinamik olarak yüklenmesini sağlar. Aşağıdaki şemada yan yana bir karşılaştırma sağlanmaktadır.

![]()

Bu, model TAR dosyasının boyutunu yaklaşık 6 GB'tan 70 MB'a önemli ölçüde azaltır ve dolayısıyla yükleme ve paketin açılması çok daha hızlıdır. Örneğimizde ön yüklemeyi yapmak için, Python'un yardımcı programı olan arka uç modelini oluşturduk. models/model_setup. Komut dosyası, temel Stabil Difüzyon modelini ve Conda ortamını Amazon S3'ten tüm ince ayarlı modeller arasında paylaşmak üzere ortak bir konuma kopyalar. Görevi gerçekleştiren kod pasajı aşağıdadır:

Daha sonra ince ayarı yapılan her model, konteyner üzerindeki paylaşılan konuma işaret edecektir. Conda ortamına şurada atıfta bulunulmaktadır: config.pbtxt.

Kararlı Difüzyon temel modeli şuradan yüklenir: initialize() her birinin işlevi model.py dosya. Daha sonra kişiselleştirilmiş LoRA ağırlıklarını unet'e uyguluyoruz ve text_encoder Her ince ayarlı modeli yeniden oluşturmak için model:

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. Otomotiv / EV'ler, karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- Blok Ofsetleri. Çevre Dengeleme Sahipliğini Modernleştirme. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 100

- 12

- 13

- İNDİRİM

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- kabiliyet

- Yapabilmek

- Hakkımızda

- hızlandırılmış

- hızlanan

- erişim

- ulaşılabilir

- birikim

- Başarmak

- karşısında

- adaptasyon

- eklemek

- katma

- ilave

- Ek

- Ayrıca

- Düzeltilmiş

- avantaj

- reklâm

- Sonra

- AI

- AI modelleri

- AI hizmetleri

- AI / ML

- Türkiye

- hafifletmek

- izin vermek

- Izin

- veriyor

- zaten

- Ayrıca

- Rağmen

- amatör

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- Ortam

- miktar

- an

- anatomi

- ve

- herhangi

- uygulamaları

- Tamam

- yaklaşım

- yaklaşık olarak

- mimari

- ARE

- Sanat

- sanat eseri

- AS

- Varlıklar

- yardım

- At

- Dikkat

- çeker

- duruşmalar

- yazar

- Oto

- Otomatik

- otomatik olarak

- mevcut

- avatar

- Avatarlar

- önlemek

- AWS

- Backend

- arka fon

- arka

- Kötü

- baz

- merkezli

- temel

- BE

- Çünkü

- müşterimiz

- olmuştur

- arkasında

- olmak

- altında

- yarar

- İYİ

- Daha iyi

- arasında

- vücut

- her ikisi de

- Kırık

- inşa etmek

- yerleşik

- yük

- iş

- fakat

- by

- Önbellek

- denilen

- CAN

- yetenekleri

- ele geçirmek

- dikkatlice

- dava

- durumlarda

- yakalandı

- zorluklar

- yükler

- seçti

- sinematik

- Cityscape

- sınıf

- Açıkça

- kod

- soğuk

- kombine

- birleştirme

- nasıl

- ortak

- karşılaştırıldığında

- karşılaştırma

- tamamlamak

- tamamlama

- karmaşık

- bileşenler

- kompozisyon

- hesaplamak

- bilgisayar

- Bilgisayar görüşü

- kavram

- eşzamanlı

- yapılandırma

- Konteyner

- içerik

- dönüştürmek

- çekirdek

- Ücret

- maliyetler

- kapaklar

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- Oluşturma

- kreasyonları

- Yaratıcı

- ürün

- küratörlüğünü

- Şu anda

- Müşteriler

- özelleştirmek

- özelleştirilmiş

- kesim

- veri

- gün

- adanmış

- derin

- derin öğrenme

- derin

- tanımlamak

- tanımlı

- tanımlar

- tanımlarken

- Demokratikleştirilmesi

- göstermek

- gösterdi

- gösteriyor

- dağıtmak

- konuşlandırılmış

- dağıtma

- açılma

- Dizayn

- ayrıntı

- detaylı

- ayrıntılar

- Bulma

- Belirlemek

- Geliştirici

- cihaz

- farklı

- Yayılma

- direkt olarak

- çeşitli

- diy

- do

- yok

- domain

- yapılmış

- aşağı

- taslak

- çekilmiş

- gereken

- sırasında

- dinamik

- dinamik

- e

- e-ticaret

- her

- Daha erken

- kolayca

- verimli

- ortadan kaldırır

- katıştırma

- etkin

- sağlar

- karşılaşma

- teşvik etmek

- son uca

- Sonsuz

- Son nokta

- nişan

- Motor

- Mühendislik

- artırmak

- artırılması

- kuruluş

- Entertainment

- çevre

- ortamları

- EPİK

- öz

- örnek

- örnekler

- Dışında

- istisna

- var

- genişleyen

- deneyim

- Deneyimler

- deneme

- Uzmanlık

- Açıklamak

- keşfetmek

- maruz

- ifade

- ifade

- ekstra

- çıkarmak

- Yüz

- yüz

- Başarısızlık

- aile

- Daha hızlı

- Özellikler(Hazırlık aşamasında)

- Özellikler

- Ayaklar

- az

- daha az

- rakamlar

- fileto

- dosyalar

- son

- Nihayet

- mali

- Ad

- odak

- odaklanmış

- odaklanır

- takip etme

- ayak izi

- İçin

- bulundu

- dört

- ÇERÇEVE

- itibaren

- tam

- işlev

- Games

- kumar

- oluşturmak

- üretir

- üreten

- nesil

- üretken

- üretken yapay zeka

- jeneratör

- almak

- gif

- GitHub

- gol

- gidiş

- Tercih Etmenizin

- GPU

- grafik

- büyük

- çok

- Yeşil

- brüt

- rehberlik

- Eller

- Var

- sahip olan

- he

- yardım et

- yardım

- yardımcı olur

- onu

- okuyun

- yüksek performans

- Yüksek kaliteli

- yüksek çözünürlük

- Vurgulamak

- büyük ölçüde

- onun

- tarih

- umut

- ev sahibi

- hosting

- saat

- ev

- Ne kadar

- Nasıl Yapılır

- Ancak

- HTML

- http

- HTTPS

- tanımlayıcı

- Kimlik

- if

- görüntü

- görüntüleri

- hemen

- Etkiler

- uygulamak

- uygulama

- iyileştirmek

- in

- dahil

- Dahil olmak üzere

- Artırmak

- artmış

- bireysellik

- Endüstri

- sanayi

- bilgi

- aydınlatıcı

- başlangıçta

- yenilikçi

- yenilikçi teknolojiler

- giriş

- girişler

- ilham verici

- örnek

- yerine

- talimatlar

- sigorta

- yönelik

- faiz

- içine

- sezgisel

- IT

- ONUN

- kendisi

- james

- İş

- Mesleki Öğretiler

- birleştirme

- jpg

- json

- sadece

- sadece bir

- anahtar

- bilgi

- etiket

- dil

- büyük

- büyük

- sonra

- katmanları

- öncülük etmek

- lider

- Liderlik

- ÖĞRENİN

- öğrenme

- Rüzgâraltı

- kütüphaneler

- Aydınlatma

- sevmek

- LİMİT

- Yüksek Lisans

- yük

- yükler

- yer

- Uzun

- uzun

- Bakın

- Aşk

- Düşük

- makine

- makine öğrenme

- yapılmış

- Ana

- yapmak

- Yapımı

- yönetmek

- yönetilen

- müdür

- yönetir

- yönetme

- çok

- Pazarlama

- Pazarlama reklamı

- maksimum

- Mayıs..

- anlam

- anlamına geliyor

- mekanizma

- mekanizmaları

- medya

- Bellek

- adı geçen

- mesaj

- yöntem

- yöntemleri

- asgari

- dakika

- karıştırmak

- ML

- model

- modelleri

- ılımlılık

- izleme

- Daha

- çoğu

- motive

- film

- çok

- çoklu

- şart

- isim

- adlı

- yerli

- Doğal (Madenden)

- Doğal Dil İşleme

- gerek

- ağ

- Nötr

- sonraki

- Hayır

- defter

- Fark etme..

- tebliğ

- şimdi

- numara

- Nvidia

- nesne

- nesneler

- of

- kapalı

- Sıvı yağ

- on

- ONE

- bir tek

- üstüne

- işletme

- optimizasyon

- optimize

- optimize

- seçenek

- Opsiyonlar

- or

- orkestrasyon

- orijinal

- OS

- Diğer

- bizim

- dışarı

- ana hatlar

- çıktı

- tekrar

- tüm

- paket

- paketler

- ped

- Paralel

- parametre

- parametreler

- Bölüm

- geçti

- tutkulu

- yol

- İnsanlar

- MÜKEMMEL OLAN YERİ BULUN

- Yapmak

- gerçekleştirir

- kişi

- Kişilik

- kişiselleştirmek

- Kişiselleştirilmiş

- perspektifler

- Fotoğraf

- Fotoğraflar

- resim

- boru

- boru hattı

- Platformlar

- Platon

- Plato Veri Zekası

- PlatoVeri

- Nokta

- yoksul

- portre

- olanakları

- mümkün

- Çivi

- potansiyel

- powered

- güçlü

- Predictor

- tercihleri

- Hazırlamak

- hazırlar

- hazırlanması

- koruma

- önceki

- birincil

- Önceki

- süreç

- işleme

- PLATFORM

- ürün müdürü

- Ürünler

- Profil

- Programlama

- Projeler

- teşvik

- uygun şekilde

- özellikleri

- sağlamak

- sağlanan

- sağlar

- Python

- kalite

- miktar

- rasgele

- menzil

- oranlar

- daha doğrusu

- gerekçe

- Okuma

- hazır

- tavsiye etmek

- Tavsiye edilen

- azaltmak

- Indirimli

- azaltır

- azalma

- yansıtmak

- ilişkin

- ilgili

- temsil

- talep

- isteklerinizi

- gereklidir

- kaynak

- Kaynaklar

- yanıt

- sorumlu

- DİNLENME

- sonuç

- Sonuçlar

- Rockstar

- Rol

- kabaca

- yönlendirme

- koşmak

- ishal

- sagemaker

- SageMaker Çıkarımı

- aynı

- İndirim

- ölçek

- ölçekleme

- bilimkurgu

- kapsam

- ekran

- Bölüm

- bölümler

- görmek

- tohum

- bölüm

- SELF

- Selfie

- kıdemli

- gönderdi

- Dizi

- hizmet

- Hizmetler

- servis

- set

- ayar

- kurulum

- birkaç

- Shape

- paylaş

- Paylaşılan

- keskin

- o

- atış

- meli

- gösterilen

- Gösteriler

- yan

- önemli

- önemli ölçüde

- Simon

- Basit

- sadece

- tek

- durumlar

- beden

- küçük

- daha küçük

- pasajı

- Sosyal Medya

- sosyal medya

- sosyal platformlar

- çözüm

- Çözümler

- biraz

- uzay

- uzman

- uzmanlaşmış

- özel

- Harcama

- Dönme

- kararlı

- başlama

- başladı

- başlar

- adım

- Basamaklar

- hafızası

- saklı

- akış

- Akış hizmetleri

- dizi

- yapı

- konu

- sonraki

- başarılı

- böyle

- yeterli

- tedarik

- destek

- elbette

- sistem

- Bizi daha iyi tanımak için

- Görev

- takım

- TechCrunch

- teknikleri

- Teknolojileri

- Teknoloji

- Test yapmak

- testleri

- göre

- o

- The

- ve bazı Asya

- Onları

- sonra

- bu nedenle

- Bunlar

- Re-Tweet

- gerçi?

- düşünce

- düşünce liderliği

- Binlerce

- üç

- İçinden

- zaman

- zamanlar

- başlıkları

- için

- araç

- üst

- trafik

- Tren

- Eğitim

- dönüşüm

- Seyahat

- Triton

- denemek

- tv

- iki

- tip

- tipik

- ui

- altında

- anladım

- benzersiz

- gereksiz

- Yüklenen

- Yükleme

- us

- Amerika Birleşik Devletleri

- kullanım

- kullanım durumu

- Kullanılmış

- kullanıcı

- kullanıcılar

- kullanım

- kullanma

- yarar

- kullanmak

- değer

- çeşitlilik

- çeşitli

- versiyon

- üzerinden

- Görüntüle

- görüntüleme

- Virjinya

- vizyonumuz

- görseller

- istemek

- oldu

- filigran

- we

- ağ

- web hizmetleri

- ağırlık

- vardı

- Ne

- ne zaman

- hangi

- süre

- kimin

- geniş

- Geniş ürün yelpazesi

- irade

- ile

- olmadan

- İş

- çalışma

- En kötü

- olur

- X

- yıl

- Sen

- kendiniz

- zefirnet