Kuruluşlar modelleri üretime dağıtırken, sürekli olarak aşağıdakiler gibi en yeni hızlandırıcılar üzerinde çalışan temel modellerinin (FM'ler) performansını optimize etmenin yollarını arıyorlar. AWS Çıkarımları ve GPU'lar sayesinde son kullanıcılara en iyi deneyimi sunmak için maliyetleri düşürebilir ve yanıt gecikmesini azaltabilirler. Ancak bazı FM'ler, konuşlandırıldıkları bulut sunucularında mevcut olan hızlandırıcıları tam olarak kullanmaz ve bu da donanım kaynaklarının verimsiz kullanılmasına yol açar. Bazı kuruluşlar, mevcut hızlandırıcıların tümünü daha iyi kullanmak için aynı örneğe birden fazla FM dağıtır, ancak bu, zaman alıcı ve yönetilmesi zor olan karmaşık altyapı düzenlemesini gerektirir. Birden fazla FM aynı bulut sunucusunu paylaştığında, her FM'in kendi ölçeklendirme ihtiyaçları ve kullanım modelleri vardır; bu da bulut sunucularını ne zaman eklemeniz veya kaldırmanız gerektiğini tahmin etmeyi zorlaştırır. Örneğin, kullanımın belirli saatlerde artış gösterebileceği bir kullanıcı uygulamasına güç sağlamak için bir model kullanılabilirken, başka bir model daha tutarlı bir kullanım düzenine sahip olabilir. Müşteriler, maliyetleri optimize etmenin yanı sıra gecikmeyi azaltarak en iyi son kullanıcı deneyimini sunmak istiyor. Bunu yapmak için genellikle bir FM'in birden fazla kopyasını kullanıcılardan gelen taleplere paralel olarak dağıtırlar. FM çıkışları tek bir cümleden birden fazla paragrafa kadar değişebildiğinden, çıkarım isteğini tamamlamak için gereken süre önemli ölçüde farklılık gösterir ve istekler örnekler arasında rastgele yönlendirilirse gecikmede öngörülemeyen ani artışlara yol açar. Amazon Adaçayı Yapıcı artık dağıtım maliyetlerini ve gecikmeyi azaltmanıza yardımcı olan yeni çıkarım yeteneklerini destekliyor.

Artık çıkarım bileşeni tabanlı uç noktalar oluşturabilir ve makine öğrenimi (ML) modellerini bir SageMaker uç noktasına dağıtabilirsiniz. Bir çıkarım bileşeni (IC), ML modelinizi soyutlar ve CPU'ları, GPU'ları veya AWS Nöron hızlandırıcılar ve model başına ölçeklendirme politikaları. Çıkarım bileşenleri aşağıdaki faydaları sunar:

- SageMaker, kullanımı en üst düzeye çıkarmak için modelleri makine öğrenimi örneklerine en iyi şekilde yerleştirip paketleyerek maliyet tasarrufu sağlayacaktır.

- SageMaker, makine öğrenimi uygulama gereksinimlerinizi karşılamak için yapılandırmanıza bağlı olarak her modeli yukarı ve aşağı ölçeklendirecektir.

- SageMaker, boşta kalan bilgi işlemi minimumda tutarken kapasitenin kullanılabilir olmasını sağlamak için dinamik olarak örnekleri ekleyip kaldıracak şekilde ölçeklenecektir.

- Diğer modellere kaynak açmak için bir modelin ölçeğini sıfır kopyasına kadar küçültebilirsiniz. Ayrıca önemli modellerin her zaman yüklü ve trafiğe hizmet vermeye hazır tutulmasını da belirtebilirsiniz.

Bu yeteneklerle model dağıtım maliyetlerini ortalama %50 oranında azaltabilirsiniz. Maliyet tasarrufları iş yükünüze ve trafik düzeninize bağlı olarak değişecektir. Birden fazla modeli tek bir uç noktada paketlemenin kullanımı nasıl en üst düzeye çıkarabileceğini ve maliyetlerden nasıl tasarruf edebileceğini göstermek için basit bir örnek alalım. Turistlerin yerel gelenekleri ve Lama 2'nin iki çeşidi kullanılarak oluşturulmuş en iyi uygulamaları anlamalarına yardımcı olan bir sohbet uygulamanız olduğunu varsayalım: biri Avrupalı ziyaretçiler için ince ayarlı, diğeri Amerikalı ziyaretçiler için ince ayarlı. Avrupa modeli için 00:01–11:59 UTC arasında, Amerika modeli için ise 12:00–23:59 UTC arasında trafik bekliyoruz. Bu modelleri, zamanın yarısında boşta kalacakları kendi özel örneklerine dağıtmak yerine, artık maliyetten tasarruf etmek için bunları tek bir uç noktaya dağıtabilirsiniz. Avrupa modeli için kapasiteyi boşaltmaya gerek olmadığında Amerikan modelinin ölçeğini sıfıra düşürebilirsiniz veya bunun tersi de geçerlidir. Bu, donanımınızı verimli bir şekilde kullanmanıza ve israfı önlemenize olanak tanır. Bu, iki modelin kullanıldığı basit bir örnektir, ancak bu fikri, yüzlerce modeli, iş yükünüze göre otomatik olarak ölçeklenen ve küçülen tek bir uç noktaya paketleyecek şekilde kolayca genişletebilirsiniz.

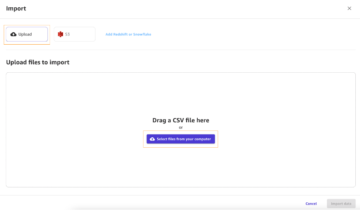

Bu yazıda size IC tabanlı SageMaker uç noktalarının yeni yeteneklerini gösteriyoruz. Ayrıca, çıkarım bileşenlerini ve API'leri kullanarak birden çok modeli dağıtma konusunda da size yol gösteriyoruz. Son olarak, yeni gözlemlenebilirlik özelliklerinden bazılarını, modelleriniz için otomatik ölçeklendirme ilkelerini nasıl ayarlayacağınızı ve uç noktalarınız için örnek ölçeklendirmeyi nasıl yöneteceğinizi ayrıntılarıyla anlatıyoruz. Modelleri yeni, basitleştirilmiş, etkileşimli kullanıcı deneyimimiz aracılığıyla da dağıtabilirsiniz. Çıkarım iş yüklerinizin gecikmesini ve performansını optimize etmek için gelişmiş yönlendirme yeteneklerini de destekliyoruz.

Yapı taşları

Gelin daha derinlemesine bir göz atalım ve bu yeni yeteneklerin nasıl çalıştığını anlayalım. SageMaker barındırma için bazı yeni terminoloji aşağıdadır:

- Çıkarım bileşeni – Bir modeli uç noktaya dağıtmak için kullanabileceğiniz bir SageMaker barındırma nesnesi. Aşağıdakileri sağlayarak bir çıkarım bileşeni oluşturabilirsiniz:

- SageMaker modeli veya SageMaker uyumlu görüntü ve model yapılarının spesifikasyonu.

- CPU çekirdekleri, ana bilgisayar belleği ve hızlandırıcı sayısı dahil olmak üzere modelinizin her bir kopyasının ihtiyaçlarını belirten bilgi işlem kaynağı gereksinimleri.

- Model kopyası – İstekleri sunabilen bir çıkarım bileşeninin çalışma zamanı kopyası.

- Yönetilen örnek otomatik ölçeklendirme – Bir uç nokta için kullanılan işlem örneklerinin sayısını artırmak veya azaltmak için SageMaker barındırma yeteneği. Örnek ölçeklendirme, çıkarım bileşenlerinin ölçeklenmesine tepki verir.

Yeni bir çıkarım bileşeni oluşturmak için bir kapsayıcı görüntüsü ve bir model yapısı belirtebilir veya önceden oluşturmuş olabileceğiniz SageMaker modellerini kullanabilirsiniz. Ayrıca ana bilgisayar CPU çekirdeği sayısı, ana bilgisayar belleği veya modelinizin çalıştırması gereken hızlandırıcı sayısı gibi bilgi işlem kaynağı gereksinimlerini de belirtmeniz gerekir.

Bir çıkarım bileşenini dağıttığınızda şunları belirtebilirsiniz: MinCopies modelin ihtiyaç duyduğunuz miktarda yüklendiğinden ve istekleri karşılamaya hazır olduğundan emin olmak için.

Ayrıca çıkarım bileşeni kopyalarının ölçeği sıfır olacak şekilde politikalarınızı ayarlama seçeneğiniz de vardır. Örneğin, bir IC'ye karşı çalışan yükünüz yoksa model kopyası kaldırılacaktır. Bu, uç noktanızın kullanımını ve verimliliğini optimize etmek için etkin iş yükleriyle değiştirilebilecek kaynakları serbest bırakabilir.

Çıkarım istekleri arttıkça veya azaldıkça IC'lerinizin kopya sayısı da otomatik ölçeklendirme politikalarınıza göre artabilir veya azalabilir. SageMaker, modellerinizin ambalajını kullanılabilirlik ve maliyet açısından optimize etmek için yerleştirme işlemini gerçekleştirecektir.

Ayrıca, yönetilen örnek otomatik ölçeklendirmeyi etkinleştirirseniz SageMaker, trafiğe hizmet vermek için belirli bir zamanda yüklenmesi gereken çıkarım bileşenlerinin sayısına göre işlem örneklerini ölçeklendirir. SageMaker, model performansını korurken maliyeti optimize etmek için örneklerin ölçeğini büyütecek ve örneklerinizi ve çıkarım bileşenlerinizi paketleyecektir. Yönetilen örnek ölçeklendirmenin kullanılmasını önersek de, uygulama otomatik ölçeklendirme yoluyla ölçeklendirmeyi kendiniz yönetme seçeneğiniz de vardır.

SageMaker, çıkarım bileşenleri tarafından artık ihtiyaç duyulmaması durumunda çıkarım bileşenlerini yeniden dengeleyecek ve örneklerin ölçeğini küçültecek ve maliyetlerinizi azaltacaktır.

API'lerin izlenecek yolu

SageMaker adında yeni bir varlık tanıttı InferenceComponent. Bu, ML modelini barındırmanın ayrıntılarını uç noktanın kendisinden ayırır. InferenceComponent Kullanmak istediğiniz SageMaker modeli veya kapsayıcı ayrıntıları ve model yapıları gibi modeli barındırmaya yönelik temel özellikleri belirtmenize olanak tanır. Ayrıca dağıtılacak bileşenlerin kopya sayısını ve gereken hızlandırıcıların (GPU'lar, Inf veya Trn hızlandırıcılar) veya CPU'ların (vCPU'lar) sayısını da belirtirsiniz. Bu, gelecekte dağıtmayı planladığınız herhangi bir sayıda model için tek bir uç noktayı kullanmanız için daha fazla esneklik sağlar.

Çıkarım bileşenine sahip bir uç nokta oluşturmak için Boto3 API çağrılarına bakalım. Bu yazının ilerleyen kısımlarında ele alacağımız bazı parametreler olduğunu unutmayın.

Aşağıdaki örnek koddur CreateEndpointConfig:

Aşağıdaki örnek koddur CreateEndpoint:

Aşağıdaki örnek koddur CreateInferenceComponent:

Bu ayrıştırma InferenceComponent bir uç noktaya erişim esneklik sağlar. Gereksinimleriniz değiştikçe ekleyerek veya çıkararak birden fazla modeli aynı altyapı üzerinde barındırabilirsiniz. Her model gerektiğinde bağımsız olarak güncellenebilir. Ayrıca modelleri iş ihtiyaçlarınıza göre ölçeklendirebilirsiniz. InferenceComponent ayrıca model başına kapasiteyi kontrol etmenize olanak tanır. Yani her modelin kaç kopyasını barındıracağınızı belirleyebilirsiniz. Bu öngörülebilir ölçeklendirme, her model için belirli gecikme gereksinimlerini karşılamanıza yardımcı olur. Etraflı, InferenceComponent Barındırılan modelleriniz üzerinde size çok daha fazla kontrol sağlar.

Aşağıdaki tabloda, uç nokta oluşturma ve çağırmaya yönelik üst düzey yaklaşımın yan yana karşılaştırmasını gösteriyoruz. InferenceComponent Ve birlikte InferenceComponent. CreateModel() işlevinin artık IC tabanlı uç noktalar için isteğe bağlı olduğunu unutmayın.

| adım | Model Tabanlı Uç Noktalar | Çıkarım Bileşen Tabanlı Uç Noktalar |

| 1 | Model Oluştur(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | Uç Nokta Oluştur(…) |

| 3 | Uç Nokta Oluştur(…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName='value'…) |

Getirilmesi InferenceComponent model düzeyinde ölçeklendirmenize olanak tanır. Görmek Örneği ve IC otomatik ölçeklendirmeyi derinlemesine inceleyin nasıl yapılacağına dair daha fazla ayrıntı için InferenceComponent otomatik ölçeklendirmeyle çalışır.

Artık SageMaker uç noktasını çağırırken yeni parametreyi belirtebilirsiniz InferenceComponentName istenileni vurmak InferenceComponentName. SageMaker, talebin, talep edileni barındıran örneğe yönlendirilmesini gerçekleştirecektir. InferenceComponentName. Aşağıdaki koda bakın:

Varsayılan olarak SageMaker, isteklerin uç noktanızı destekleyen örneklere rastgele yönlendirilmesini kullanır. En az bekleyen istek yönlendirmesini etkinleştirmek istiyorsanız, uç nokta yapılandırmasında yönlendirme stratejisini ayarlayabilirsiniz. RoutingConfig:

En az bekleyen istekler, istekleri işlemek için daha fazla kapasiteye sahip belirli örneklere yönlendirme yapar. Bu, daha düzgün bir yük dengeleme ve kaynak kullanımı sağlayacaktır.

Ek olarak CreateInferenceComponent, aşağıdaki API'ler artık kullanılabilir:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent günlükleri ve ölçümleri

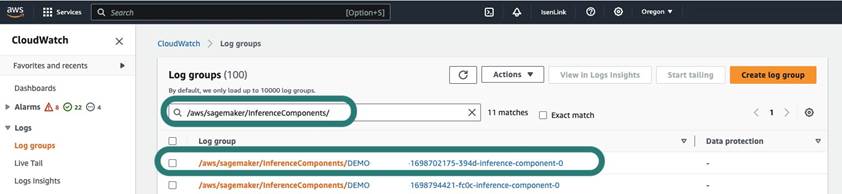

InferenceComponent günlükler şurada bulunur /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Container içerisinde stderr ve stdout'a gönderilen tüm loglar bu loglara gönderilir. Amazon Bulut İzleme.

IC tabanlı uç noktaların kullanıma sunulmasıyla birlikte artık ek örnek metriklerini, çıkarım bileşeni metriklerini ve çağrı metriklerini görüntüleme olanağına sahipsiniz.

SageMaker örnekleri için artık GPUReservation ve CPUReservation Dağıttığınız çıkarım bileşenlerine dayalı olarak bir uç nokta için ayrılan kaynakları görmek için ölçümler. Bu ölçümler, uç nokta ve otomatik ölçeklendirme politikalarınızı boyutlandırmanıza yardımcı olabilir. Ayrıca bir uç noktaya dağıtılan tüm modellerle ilişkili toplu ölçümleri de görüntüleyebilirsiniz.

SageMaker ayrıca, çıkarım bileşeni düzeyindeki ölçümleri de ortaya çıkarır; bu, konuşlandırdığınız çıkarım bileşenleri için kaynakların kullanımına ilişkin daha ayrıntılı bir görünüm gösterebilir. Bu, aşağıdaki gibi toplam kaynak kullanımının ne kadar olduğuna ilişkin bir görünüm elde etmenizi sağlar: GPUUtilizationNormalized ve GPUMemoryUtilizationNormalized konuşlandırdığınız ve sıfır veya daha fazla kopyaya sahip olabilecek her çıkarım bileşeni için.

Son olarak SageMaker, artık çıkarım bileşenlerine yönelik çağrıları toplu olarak izleyen çağrı metrikleri sağlar (Invocations) veya somutlaştırılmış kopya başına (InvocationsPerCopy)

Kapsamlı bir ölçüm listesi için bkz. SageMaker Endpoint Çağırma Metrikleri.

Model düzeyinde otomatik ölçeklendirme

Açıkladığımız otomatik ölçeklendirme davranışını uygulamak için SageMaker uç nokta yapılandırmasını ve çıkarım bileşenini oluştururken sırasıyla ilk örnek sayısını ve ilk model kopya sayısını tanımlarsınız. Uç noktayı ve karşılık gelen IC'leri oluşturduktan sonra, IC düzeyinde otomatik ölçeklendirmeyi uygulamak için önce ölçeklendirme hedefini kaydetmeniz ve ardından ölçeklendirme ilkesini IC ile ilişkilendirmeniz gerekir.

Ölçeklendirme politikasını uygularken şunu kullanırız: SageMakerInferenceComponentInvocationsPerCopySageMaker tarafından tanıtılan yeni bir ölçümdür. Dakikada model kopyası başına ortalama çağrı sayısını yakalar.

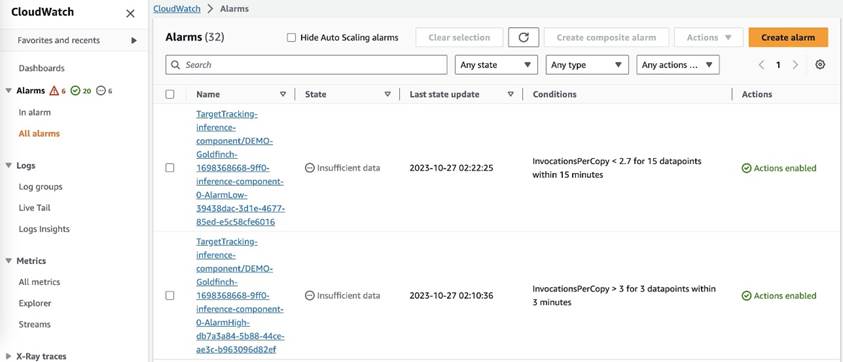

Ölçeklendirme politikasını ayarladıktan sonra, SageMaker her otomatik ölçeklendirme hedefi için iki CloudWatch alarmı oluşturur: biri 3 dakika boyunca alarmdaysa ölçeklendirmeyi tetiklemek için (üç adet 1 dakikalık veri noktası) ve diğeri 15 dakika boyunca alarmdaysa ölçeklendirmeyi tetiklemek için (15 adet 1 dakikalık veri noktası), aşağıdaki ekran görüntüsünde gösterildiği gibi. Ölçeklendirme eylemini tetikleme süresi genellikle bu dakikalardan 1-2 dakika daha uzundur çünkü uç noktanın metrikleri CloudWatch'ta yayınlaması zaman alır ve ayrıca AutoScaling tepki vermek. Soğuma süresi, bir ölçek genişletme veya ölçek genişletme etkinliği tamamlandıktan sonra başka bir ölçek genişletme etkinliğinin başlayabilmesi için saniye cinsinden geçen süredir. Genişletme soğuma süresi uç nokta güncelleme süresinden daha kısaysa, bunun hiçbir etkisi olmaz çünkü SageMaker uç noktasının güncellenmesi mümkün değildir. Güncellenmesi durumu.

IC düzeyinde otomatik ölçeklendirmeyi ayarlarken, MaxInstanceCount parametresi bu uç noktanın işleyebileceği maksimum IC sayısına eşit veya bundan daha küçüktür. Örneğin, uç noktanız uç nokta yapılandırmasında yalnızca bir örneğe sahip olacak şekilde yapılandırılmışsa ve bu örnek, modelin yalnızca en fazla dört kopyasını barındırabiliyorsa, o zaman MaxInstanceCount 4'e eşit veya XNUMX'ten küçük olmalıdır. Bununla birlikte, daha fazla bilgi işlem kaynağı ihtiyacını karşılamak amacıyla örnek sayısını gerekli model kopya numarasına göre otomatik olarak ölçeklendirmek için SageMaker tarafından sağlanan yönetilen otomatik ölçeklendirme özelliğini de kullanabilirsiniz. Aşağıdaki kod parçacığı, uç nokta yapılandırmasının oluşturulması sırasında yönetilen örnek ölçeklendirmenin nasıl ayarlanacağını gösterir. Bu şekilde, IC düzeyinde otomatik ölçeklendirme, model kopyalarını barındırmak için daha fazla örnek sayısı gerektirdiğinde, SageMaker, IC düzeyinde ölçeklendirmenin başarılı olmasını sağlamak için örnek sayısının ölçeğini otomatik olarak genişletecektir.

Aynı uç noktaya karşı birden fazla otomatik ölçeklendirme ilkesi uygulayabilirsiniz; bu, geleneksel otomatik ölçeklendirme ilkesini IC'lerle oluşturulan uç noktalara uygulayabileceğiniz ve diğer uç nokta metriklerine göre ölçeği artırıp azaltabileceğiniz anlamına gelir. Daha fazla bilgi için bkz. Amazon SageMaker'da otomatik ölçeklendirme ile makine öğrenimi dağıtımlarınızı optimize edin. Ancak bu mümkün olsa da ölçeklendirmeyi kendiniz yönetmek yerine yönetilen örnek ölçeklendirmeyi kullanmanızı öneririz.

Sonuç

Bu gönderide, öngörülebilir performans sağlarken hesaplama örneklerinin kullanımını en üst düzeye çıkarmanıza, yüzlerce modele ölçeklendirmenize ve maliyetleri optimize etmenize yardımcı olacak SageMaker çıkarımında yeni bir özelliği tanıttık. Ayrıca API'lere ilişkin bir kılavuz sunduk ve iş yükleriniz için çıkarım bileşenlerini nasıl yapılandırıp dağıtacağınızı gösterdik.

Biz de destekliyoruz gelişmiş yönlendirme yetenekleri Çıkarım iş yüklerinizin gecikmesini ve performansını optimize etmek için. SageMaker, çıkarım iş yüklerinizi maliyet ve performans açısından optimize etmenize yardımcı olabilir ve yönetim için size model düzeyinde ayrıntı düzeyi sağlayabilir. Biz bir defter seti Bu size GitHub'da farklı kapsayıcılar kullanarak ve otomatik ölçeklendirme ilkelerini uygulayarak üç farklı modeli nasıl dağıtacağınızı gösterecek. Dizüstü bilgisayar 1 ile başlamanızı ve yeni SageMaker barındırma özelliklerini bugün uygulamalı olarak kullanmanızı öneririz!

yazarlar hakkında

James Park Amazon Web Services'te Çözüm Mimarıdır. AWS'de teknoloji çözümleri tasarlamak, oluşturmak ve dağıtmak için Amazon.com ile birlikte çalışıyor ve yapay zeka ve makine öğrenimine özel ilgi duyuyor. Boş zamanlarında yeni kültürler, yeni deneyimler aramaktan ve en son teknoloji trendlerini takip etmekten hoşlanıyor. Onu şurada bulabilirsin LinkedIn.

James Park Amazon Web Services'te Çözüm Mimarıdır. AWS'de teknoloji çözümleri tasarlamak, oluşturmak ve dağıtmak için Amazon.com ile birlikte çalışıyor ve yapay zeka ve makine öğrenimine özel ilgi duyuyor. Boş zamanlarında yeni kültürler, yeni deneyimler aramaktan ve en son teknoloji trendlerini takip etmekten hoşlanıyor. Onu şurada bulabilirsin LinkedIn.

melanie li, PhD, Sidney, Avustralya merkezli AWS'de Kıdemli Yapay Zeka/ML Uzmanı TAM'dir. Kurumsal müşterilerin AWS'de en son teknolojiye sahip AI/ML araçlarını kullanarak çözümler oluşturmasına yardımcı olur ve en iyi uygulamalarla makine öğrenimi çözümlerini tasarlama ve uygulama konusunda rehberlik sağlar. Boş zamanlarında doğayı keşfetmeyi, ailesi ve arkadaşlarıyla vakit geçirmeyi çok seviyor.

melanie li, PhD, Sidney, Avustralya merkezli AWS'de Kıdemli Yapay Zeka/ML Uzmanı TAM'dir. Kurumsal müşterilerin AWS'de en son teknolojiye sahip AI/ML araçlarını kullanarak çözümler oluşturmasına yardımcı olur ve en iyi uygulamalarla makine öğrenimi çözümlerini tasarlama ve uygulama konusunda rehberlik sağlar. Boş zamanlarında doğayı keşfetmeyi, ailesi ve arkadaşlarıyla vakit geçirmeyi çok seviyor.

Marc Karp Amazon SageMaker Hizmet ekibinde çalışan bir Makine Öğrenimi Mimarıdır. Müşterilerin makine öğrenimi iş yüklerini uygun ölçekte tasarlamasına, devreye almasına ve yönetmesine yardımcı olmaya odaklanır. Boş zamanlarında seyahat etmekten ve yeni yerler keşfetmekten keyif alıyor.

Marc Karp Amazon SageMaker Hizmet ekibinde çalışan bir Makine Öğrenimi Mimarıdır. Müşterilerin makine öğrenimi iş yüklerini uygun ölçekte tasarlamasına, devreye almasına ve yönetmesine yardımcı olmaya odaklanır. Boş zamanlarında seyahat etmekten ve yeni yerler keşfetmekten keyif alıyor.

Alan Tan SageMaker'da Kıdemli Ürün Müdürüdür ve büyük model çıkarımına yönelik çabalara öncülük etmektedir. Analitik alanına makine öğrenimi uygulama konusunda tutkulu. İş dışında, açık havayı sever.

Alan Tan SageMaker'da Kıdemli Ürün Müdürüdür ve büyük model çıkarımına yönelik çabalara öncülük etmektedir. Analitik alanına makine öğrenimi uygulama konusunda tutkulu. İş dışında, açık havayı sever.

Raghu Rameşa Amazon SageMaker Hizmet ekibinde Kıdemli ML Çözümleri Mimarıdır. Müşterilerin makine öğrenimi üretim iş yüklerini geniş ölçekte oluşturmasına, dağıtmasına ve SageMaker'a taşımasına yardımcı olmaya odaklanıyor. Makine öğrenimi, yapay zeka ve bilgisayarla görme alanlarında uzmanlaşmıştır ve UT Dallas'ta Bilgisayar Bilimleri alanında yüksek lisans derecesine sahiptir. Boş zamanlarında seyahat etmekten ve fotoğraf çekmekten hoşlanıyor.

Raghu Rameşa Amazon SageMaker Hizmet ekibinde Kıdemli ML Çözümleri Mimarıdır. Müşterilerin makine öğrenimi üretim iş yüklerini geniş ölçekte oluşturmasına, dağıtmasına ve SageMaker'a taşımasına yardımcı olmaya odaklanıyor. Makine öğrenimi, yapay zeka ve bilgisayarla görme alanlarında uzmanlaşmıştır ve UT Dallas'ta Bilgisayar Bilimleri alanında yüksek lisans derecesine sahiptir. Boş zamanlarında seyahat etmekten ve fotoğraf çekmekten hoşlanıyor.

Ruinder Grewal AWS'li bir Kıdemli Ai/ML Uzman Çözüm Mimarıdır. Şu anda SageMaker'da modellerin ve MLO'ların sunumuna odaklanıyor. Bu görevden önce Makine Öğrenimi Mühendisi olarak model oluşturma ve barındırma konusunda çalıştı. İş dışında tenis oynamayı ve dağ yollarında bisiklet sürmeyi sever.

Ruinder Grewal AWS'li bir Kıdemli Ai/ML Uzman Çözüm Mimarıdır. Şu anda SageMaker'da modellerin ve MLO'ların sunumuna odaklanıyor. Bu görevden önce Makine Öğrenimi Mühendisi olarak model oluşturma ve barındırma konusunda çalıştı. İş dışında tenis oynamayı ve dağ yollarında bisiklet sürmeyi sever.

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve Yapay Zeka ile ilgili sorunlar üzerinde büyük kuruluşlardan orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve Computer Vision alanları dahil olmak üzere Derin öğrenmeye odaklanmaktadır. Müşterilerin SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve Yapay Zeka ile ilgili sorunlar üzerinde büyük kuruluşlardan orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve Computer Vision alanları dahil olmak üzere Derin öğrenmeye odaklanmaktadır. Müşterilerin SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

Saurabh Trikande Amazon SageMaker Inference için Kıdemli Ürün Yöneticisidir. Müşterilerle çalışma konusunda tutkulu ve makine öğrenimini demokratikleştirme hedefiyle motive oluyor. Karmaşık makine öğrenimi uygulamaları, çok kiracılı makine öğrenimi modelleri, maliyet optimizasyonları ve derin öğrenme modellerinin dağıtımını daha erişilebilir hale getirmeyle ilgili temel zorluklara odaklanıyor. Saurabh boş zamanlarında yürüyüş yapmaktan, yenilikçi teknolojiler hakkında bilgi edinmekten, TechCrunch'ı takip etmekten ve ailesiyle vakit geçirmekten hoşlanıyor.

Saurabh Trikande Amazon SageMaker Inference için Kıdemli Ürün Yöneticisidir. Müşterilerle çalışma konusunda tutkulu ve makine öğrenimini demokratikleştirme hedefiyle motive oluyor. Karmaşık makine öğrenimi uygulamaları, çok kiracılı makine öğrenimi modelleri, maliyet optimizasyonları ve derin öğrenme modellerinin dağıtımını daha erişilebilir hale getirmeyle ilgili temel zorluklara odaklanıyor. Saurabh boş zamanlarında yürüyüş yapmaktan, yenilikçi teknolojiler hakkında bilgi edinmekten, TechCrunch'ı takip etmekten ve ailesiyle vakit geçirmekten hoşlanıyor.

Lakshmi Ramakrishnan AWS'deki Amazon SageMaker Machine Learning (ML) platform ekibinde, ürün için teknik liderlik sağlayan bir Baş Mühendis. Amazon'da 9 yılı aşkın bir süredir çeşitli mühendislik rollerinde çalıştı. Hindistan, Karnataka, Ulusal Teknoloji Enstitüsü'nden Bilgi Teknolojisi alanında Mühendislik Diploması ve Minnesota Twin Cities Üniversitesi'nden Bilgisayar Bilimleri alanında Yüksek Lisans derecesi vardır.

Lakshmi Ramakrishnan AWS'deki Amazon SageMaker Machine Learning (ML) platform ekibinde, ürün için teknik liderlik sağlayan bir Baş Mühendis. Amazon'da 9 yılı aşkın bir süredir çeşitli mühendislik rollerinde çalıştı. Hindistan, Karnataka, Ulusal Teknoloji Enstitüsü'nden Bilgi Teknolojisi alanında Mühendislik Diploması ve Minnesota Twin Cities Üniversitesi'nden Bilgisayar Bilimleri alanında Yüksek Lisans derecesi vardır.

david nigenda Amazon SageMaker ekibinde Kıdemli Yazılım Geliştirme Mühendisi, şu anda üretim makine öğrenimi iş akışlarını iyileştirmenin yanı sıra yeni çıkarım özellikleri sunmaya çalışıyor. Boş zamanlarında çocuklarına ayak uydurmaya çalışır.

david nigenda Amazon SageMaker ekibinde Kıdemli Yazılım Geliştirme Mühendisi, şu anda üretim makine öğrenimi iş akışlarını iyileştirmenin yanı sıra yeni çıkarım özellikleri sunmaya çalışıyor. Boş zamanlarında çocuklarına ayak uydurmaya çalışır.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- İNDİRİM

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- kabiliyet

- Yapabilmek

- Hakkımızda

- özetler

- hızlandırıcılar

- ulaşılabilir

- Göre

- Başarmak

- Action

- aktif

- etkinlik

- eklemek

- ekleme

- ilave

- Ek

- Ayrıca

- adres

- ileri

- Sonra

- karşı

- toplam

- AI

- AI / ML

- Alan

- alarm

- Türkiye

- izin vermek

- veriyor

- zaten

- Ayrıca

- Rağmen

- her zaman

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- Amazon.com

- Amerikan

- miktar

- an

- analytics

- ve

- Başka

- herhangi

- api

- API'ler

- Uygulama

- uygulamaları

- Tamam

- Uygulanması

- yaklaşım

- ARE

- ALAN

- yapay

- yapay zeka

- AS

- Ortak

- ilişkili

- At

- Avustralya

- Oto

- otomatik olarak

- kullanılabilirliği

- mevcut

- ortalama

- önlemek

- AWS

- destek

- merkezli

- BE

- Çünkü

- önce

- davranış

- faydaları

- İYİ

- en iyi uygulamalar

- Daha iyi

- arasında

- inşa etmek

- bina

- yapılı

- iş

- fakat

- by

- denilen

- aramalar

- CAN

- yetenekleri

- kabiliyet

- yetenekli

- Kapasite

- yakalar

- belli

- zorluklar

- zor

- değişiklik

- Klinik

- Şehirler

- kod

- COM

- karşılaştırma

- tamamlamak

- Tamamladı

- karmaşık

- bileşen

- bileşenler

- kapsamlı

- hesaplamak

- bilgisayar

- Bilgisayar Bilimleri

- Bilgisayar görüşü

- bilgisayar

- yapılandırma

- yapılandırılmış

- tutarlı

- sürekli

- tüketen

- Konteyner

- Konteynerler

- kontrol

- çekirdek

- uyan

- Ücret

- tasarruf

- maliyetler

- olabilir

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- oluşturur

- Oluşturma

- oluşturma

- Şu anda

- Müşteriler

- gümrük

- Dallas

- veri

- Veri noktaları

- Tarih

- azaltmak

- adanmış

- derin

- derin öğrenme

- derin

- Varsayılan

- tanımlamak

- derece

- altüst ederek aramak

- Demokratikleştirilmesi

- gösteriyor

- bağlı

- dağıtmak

- konuşlandırılmış

- dağıtma

- açılma

- dağıtımları

- tarif edilen

- Dizayn

- İstediğiniz

- ayrıntı

- ayrıntılar

- Belirlemek

- gelişme

- farklı

- zor

- dağıtıldı

- Dağıtılmış bilgi işlem

- do

- etki

- Dont

- aşağı

- sırasında

- dinamik

- her

- kolayca

- Efekt

- verim

- verimli biçimde

- çabaları

- etkinleştirmek

- etkin

- sağlar

- teşvik etmek

- Son nokta

- mühendis

- Mühendislik

- sağlamak

- kuruluş

- işletmelerin

- varlık

- eşit

- Avrupa

- örnek

- beklemek

- deneyim

- Deneyimler

- keşfetmek

- Keşfetmek

- uzatmak

- aile

- Özellikler(Hazırlık aşamasında)

- Özellikler

- alan

- bulmak

- Ad

- Esneklik

- odaklanır

- takip etme

- İçin

- vakıf

- dört

- Ücretsiz

- arkadaşlar

- itibaren

- tamamen

- Ayrıca

- gelecek

- almak

- gif

- GitHub

- Vermek

- verilmiş

- verir

- gol

- GPU

- GPU'lar

- granül

- rehberlik

- Yarım

- sap

- Eller

- donanım

- Var

- he

- yardım et

- yardım

- yardımcı olur

- onu

- Yüksek

- üst düzey

- onu

- onun

- vurmak

- tutar

- ev sahibi

- ev sahipliği yaptı

- hosting

- SAAT

- Ne kadar

- Nasıl Yapılır

- Ancak

- http

- HTTPS

- Yüzlerce

- Fikir

- boş

- if

- örneklemek

- görüntü

- uygulamak

- uygulanması

- önemli

- geliştirme

- in

- Diğer

- Dahil olmak üzere

- Artırmak

- bağımsız

- Hindistan

- verimsiz

- bilgi

- bilgi teknolojisi

- Altyapı

- ilk

- yenilikçi

- yenilikçi teknolojiler

- örnek

- yerine

- Enstitü

- İstihbarat

- interaktif

- faiz

- içine

- tanıttı

- Giriş

- IT

- ONUN

- kendisi

- jpg

- tutmak

- koruma

- anahtar

- çocuklar

- büyük

- Büyük işletmeler

- son olarak

- Gecikme

- sonra

- son

- fırlatma

- Liderlik

- önemli

- öğrenme

- en az

- seviye

- sevmek

- Liste

- lama

- yük

- yerel

- bulunan

- uzun

- Bakın

- bakıyor

- seviyor

- makine

- makine öğrenme

- yapmak

- Yapımı

- yönetmek

- yönetilen

- yönetim

- müdür

- yönetme

- çok

- usta

- yüksek lisans

- Maksimuma çıkarmak

- maksimum

- Mayıs..

- anlamına geliyor

- Neden

- Bellek

- metrik

- Metrikleri

- göç

- asgari

- dakika

- dakika

- ML

- MLO'lar

- model

- modelleri

- Daha

- motive

- Dağ

- çok

- çoklu

- ulusal

- Tabiat

- gerek

- gerekli

- ihtiyaçlar

- yeni

- nlp

- yok hayır

- notlar

- defter

- şimdi

- numara

- nesne

- of

- teklif

- sık sık

- on

- ONE

- bir tek

- üstüne

- optimize

- optimize

- seçenek

- or

- orkestrasyon

- organizasyonlar

- Diğer

- bizim

- dışarı

- açık havada

- çıkışlar

- dışında

- ödenmemiş

- tekrar

- tüm

- kendi

- Paketlemek

- Paralel

- parametre

- parametreler

- belirli

- tutkulu

- model

- desen

- başına

- performans

- dönem

- doktora

- fotoğrafçılık

- yer

- yerleştirme

- Yerler

- plan

- platform

- Platon

- Plato Veri Zekası

- PlatoVeri

- oynama

- noktaları

- politikaları

- politika

- mümkün

- Çivi

- güç kelimesini seçerim

- uygulamalar

- tahmin

- tahmin edilebilir

- korunması

- Anapara

- Önceki

- sorunlar

- süreç

- PLATFORM

- ürün müdürü

- üretim

- özellikleri

- sağlamak

- sağlanan

- sağlar

- sağlama

- yayınlamak

- miktar

- rasgele

- menzil

- değişen

- React

- reaksiyona girer

- hazır

- yeniden dengelemeye

- tavsiye etmek

- azaltmak

- azaltarak

- başvurmak

- kayıt olmak

- ilgili

- Kaldır

- kaldırma

- yerine

- talep

- isteklerinizi

- gerektirir

- gereklidir

- Yer Alan Kurallar

- gerektirir

- ayrılmış

- kaynak

- Kaynaklar

- sırasıyla

- yanıt

- Rol

- rolleri

- yolları

- yönlendirme

- koşmak

- koşu

- runtime

- sagemaker

- SageMaker Çıkarımı

- aynı

- İndirim

- Tasarruf

- söylemek

- ölçek

- terazi

- ölçekleme

- Bilim

- saniye

- görmek

- arayan

- kıdemli

- gönderdi

- cümle

- hizmet vermek

- hizmet

- Hizmetler

- servis

- set

- ayar

- birkaç

- paylaş

- o

- meli

- şov

- gösterdi

- gösterilen

- önemli ölçüde

- Basit

- basitleştirilmiş

- tek

- oturmak

- beden

- daha küçük

- pasajı

- So

- Yazılım

- yazılım geliştirme

- Çözümler

- biraz

- uzman

- uzmanlaşmış

- özel

- şartname

- geçirmek

- Harcama

- başak

- çiviler

- başlama

- Startups

- state-of-the-art

- Durum

- kalma

- Yine

- Stratejileri

- başarılı

- böyle

- tedarik

- destek

- Destekler

- elbette

- sydney

- tablo

- Bizi daha iyi tanımak için

- alır

- Hedef

- takım

- TechCrunch

- Teknik

- Teknolojileri

- Teknoloji

- tenis

- terminoloji

- göre

- o

- The

- Alan

- Gelecek

- ve bazı Asya

- Onları

- sonra

- Orada.

- Bunlar

- onlar

- Re-Tweet

- Bu

- üç

- İçinden

- zaman

- için

- araçlar

- iz

- geleneksel

- trafik

- Seyahat

- Trendler

- tetikleyebilir

- ikiz

- iki

- anlamak

- üniversite

- öngörülemeyen

- Güncelleme

- güncellenmiş

- kullanım

- kullanım

- Kullanılmış

- kullanıcı

- Kullanıcı Deneyimi

- kullanıcılar

- kullanım

- kullanma

- genellikle

- UTC

- kullanmak

- mengene

- Görüntüle

- vizyonumuz

- ziyaretçi

- yürümek

- örneklerde

- istemek

- Atık

- Yol..

- yolları

- we

- ağ

- web hizmetleri

- İYİ

- ne zaman

- oysa

- hangi

- süre

- irade

- ile

- olmadan

- sözler

- İş

- işlenmiş

- iş akışları

- çalışma

- çalışır

- yıl

- Sen

- kendiniz

- zefirnet

- sıfır