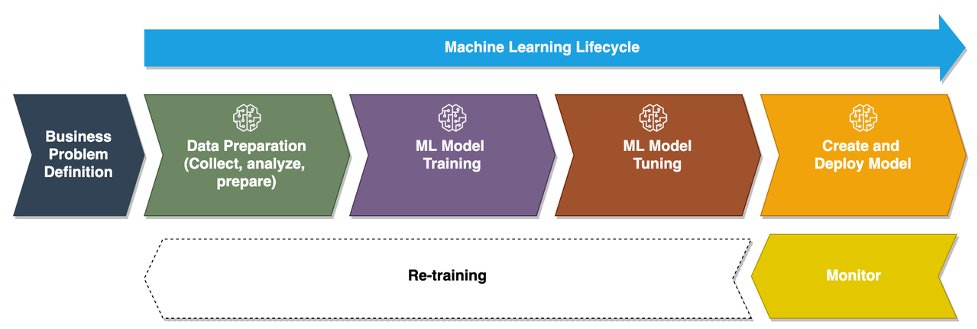

İşletmeler, işlerini geniş ölçekte dönüştürmek için özel makine öğrenimi (ML) modelleri çalıştırmaktan AI/ML kullanmaya geçtikçe, ML Operasyonlarının (MLOps) benimsenmesi kaçınılmaz hale gelir. Aşağıdaki şekilde gösterildiği gibi, ML yaşam döngüsü, bir iş sorununun ML kullanım durumu olarak çerçevelenmesiyle başlar ve ardından veri hazırlama, özellik mühendisliği, model oluşturma, dağıtım, sürekli izleme ve yeniden eğitimi içeren bir dizi aşama gelir. Pek çok işletme için bu adımların birçoğu hala manüeldir ve birbirleriyle gevşek bir şekilde entegre edilmiştir. Bu nedenle, uçtan uca makine öğrenimi yaşam döngüsünü otomatikleştirmek önemlidir; bu, daha iyi iş sonuçları elde etmek için sık sık deneme yapılmasına olanak tanır. Veri hazırlama bu yaşam döngüsündeki önemli adımlardan biridir çünkü ML modelinin doğruluğu eğitim veri kümesinin kalitesine bağlıdır.

Veri bilimcileri ve makine öğrenimi mühendisleri, zamanlarının %70-80'ini model eğitimi için gereken verileri toplamaya, analiz etmeye, temizlemeye ve dönüştürmeye harcıyor. Amazon SageMaker Veri Düzenleyicisi tamamen yönetilen bir yetenektir Amazon Adaçayı Yapıcı bu, veri bilimcilerin ve makine öğrenimi mühendislerinin çok az kod kullanarak veya hiç kod kullanmadan makine öğrenimi projeleri için verileri analiz etmelerini ve hazırlamalarını hızlandırır. Uçtan uca bir makine öğrenimi yaşam döngüsünün operasyonel hale getirilmesi söz konusu olduğunda, veri hazırlığı neredeyse her zaman süreçteki ilk adımdır. Uçtan uca bir ML işlem hattı oluşturmanın birçok yolu olduğu göz önüne alındığında, bu yazıda Data Wrangler'ı iyi bilinen bazı iş akışı otomasyonu ve düzenleme teknolojileriyle nasıl kolayca entegre edebileceğinizi tartışıyoruz.

Çözüme genel bakış

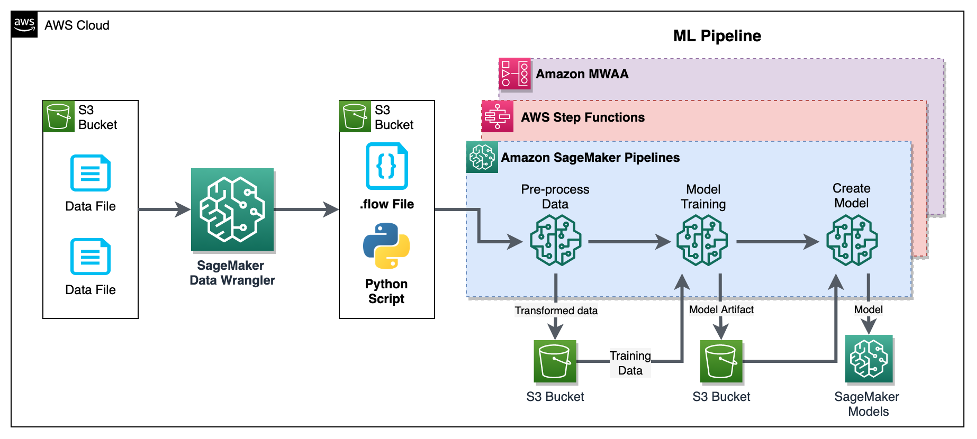

Bu yazıda kullanıcıların Data Wrangler'ı kullanarak veri hazırlamayı nasıl entegre edebileceklerini gösteriyoruz. Amazon SageMaker Ardışık Düzenleri, AWS Basamak İşlevleri, ve Apache Hava Akışı ile Apache Airflow için Amazon Tarafından Yönetilen İş Akışı (Amazon MWAA). Pipelines, makine öğrenimi için amaca yönelik olarak oluşturulmuş ve kullanımı kolay bir sürekli entegrasyon ve sürekli teslim (CI/CD) hizmeti olan bir SageMaker özelliğidir. Step Functions, AWS hizmetlerini düzenlemek ve iş süreçlerini otomatikleştirmek için kullanılan sunucusuz, az kodlu bir görsel iş akışı hizmetidir. Amazon MWAA, Apache Airflow için uçtan uca veri ve makine öğrenimi işlem hatlarını çalıştırmayı kolaylaştıran yönetilen bir düzenleme hizmetidir.

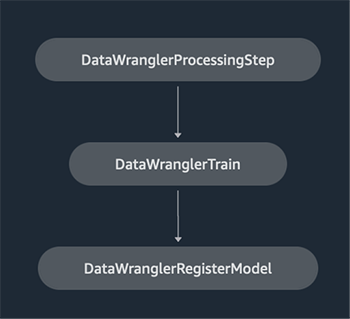

Gösterim amacıyla, yerleşik SageMaker ile bir ML modelini eğitmeye yönelik verileri hazırlamak için bir kullanım senaryosu düşünüyoruz. XGBoost algoritması Bu, sahte araç sigortası taleplerini tespit etmemize yardımcı olacaktır. Modeli eğitmek ve eğitim sürecindeki model yapıtlarını kullanarak bir SageMaker modeli oluşturmak için sentetik olarak oluşturulmuş bir örnek veri seti kullandık. Amacımız bir ML iş akışı kurarak bu süreci uçtan uca operasyonel hale getirmektir. Makine öğrenimi iş akışları daha ayrıntılı olabilse de gösterim amacıyla minimum düzeyde bir iş akışı kullanıyoruz. İş akışının ilk adımı Data Wrangler ile veri hazırlama, ardından model eğitimi adımı ve son olarak model oluşturma adımıdır. Aşağıdaki diyagram çözüm iş akışımızı göstermektedir.

Aşağıdaki bölümlerde, bir Data Wrangler akışının nasıl kurulacağı ve Data Wrangler'ın Pipelines, Step Functions ve Apache Airflow ile nasıl entegre edileceği konusunda size yol göstereceğiz.

Veri Wrangler akışı ayarlama

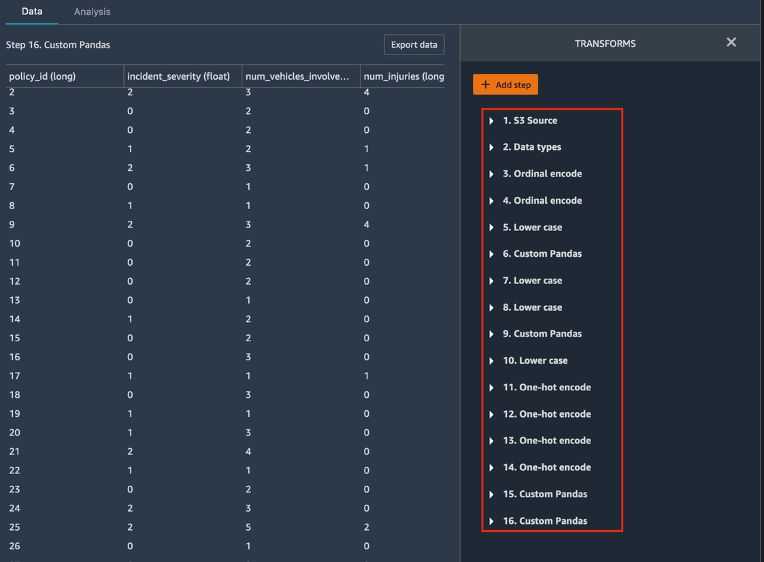

Veri Wrangler akışı olarak da adlandırılan bir Veri Wrangler akışı oluşturarak başlıyoruz. veri akışıKullanılarak veri akışı kullanıcı arayüzü ile Amazon SageMaker Stüdyosu IDE. Örnek veri kümemiz iki veri dosyasından oluşur: iddialar.csv ve müşteriler.csvbir dosyada saklanan Amazon Basit Depolama Hizmeti (Amazon S3) kova. Data Wrangler'ı uygulamak için veri akışı kullanıcı arayüzünü kullanıyoruz yerleşik dönüşümler bu tür kategorik kodlama, dize biçimlendirmesi ve bu dosyaların her birindeki özellik sütunlarına atama. Biz de başvuruyoruz özel dönüşüm birkaç satırlık özel Python kodunu kullanarak birkaç özellik sütununa Pandalar Veri Çerçevesi. Aşağıdaki ekran görüntüsü, veri akışı kullanıcı arayüzünde Claims.csv dosyasına uygulanan dönüşümleri göstermektedir.

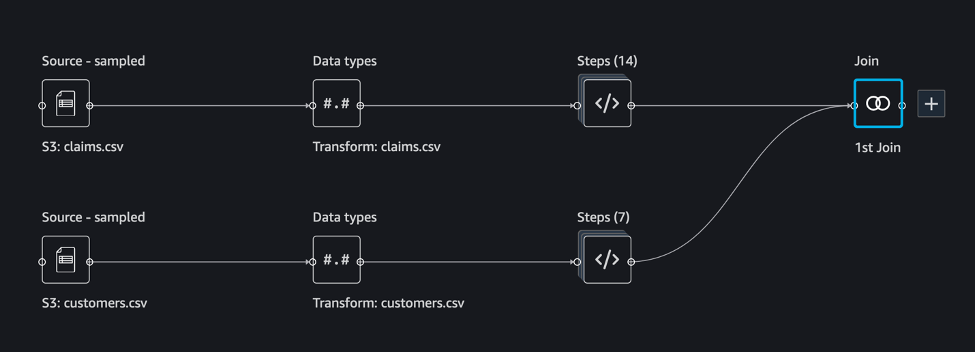

Son olarak, model eğitimimiz için tek bir eğitim veri seti oluşturmak üzere iki veri dosyasına uygulanan dönüşümlerin sonuçlarını birleştiriyoruz. Data Wrangler'ın yerleşik özelliğini kullanıyoruz veri kümelerine katıl Tablo verileri üzerinde SQL benzeri birleştirme işlemleri gerçekleştirmemize olanak sağlayan yetenek. Aşağıdaki ekran görüntüsü Studio'daki veri akışı kullanıcı arayüzündeki veri akışını göstermektedir. Data Wrangler'ı kullanarak veri akışını oluşturmaya yönelik adım adım talimatlar için bkz. GitHub deposu.

Artık ham veri dosyalarımızda veri dönüşümleri gerçekleştirmek için veri akışı (.flow) dosyasını kullanabilirsiniz. Veri akışı kullanıcı arayüzü, SageMaker SDK'yı kullanarak doğrudan Pipelines ile kullanmamız ve entegre etmemiz için Python not defterlerini otomatik olarak oluşturabilir. Adım Fonksiyonları için şunu kullanırız: AWS Step Functions Veri Bilimi Python SDK Data Wrangler işlememizi Step Functions işlem hattıyla entegre etmek. Amazon MWAA için şunu kullanıyoruz: özel Hava Akışı operatörü ve Hava Akışı SageMaker operatörü. Bu yaklaşımların her birini aşağıdaki bölümlerde ayrıntılı olarak tartışacağız.

Data Wrangler'ı Pipelines'la entegre edin

SageMaker Pipelines, doğrudan SageMaker entegrasyonundan yararlanan ML işlem hatları oluşturmaya yönelik yerel bir iş akışı düzenleme aracıdır. İle birlikte SageMaker model kaydıPipelines, makine öğrenimi iş akışlarınızın operasyonel esnekliğini ve tekrarlanabilirliğini artırır. Bu iş akışı otomasyon bileşenleri, üretimde yüzlerce modeli oluşturma, eğitme, test etme ve dağıtma yeteneğinizi kolayca ölçeklendirmenize olanak tanır; daha hızlı yineleyin; manuel düzenlemeden kaynaklanan hataları azaltın; ve tekrarlanabilir mekanizmalar oluşturun. İşlem hattındaki her adım, kökeni takip edebilir ve işlem hattının hızlı bir şekilde yeniden çalıştırılması için ara adımlar önbelleğe alınabilir. Yapabilirsiniz SageMaker Python SDK'yı kullanarak işlem hatları oluşturun.

SageMaker işlem hatlarıyla oluşturulan bir iş akışı, Yönlendirilmiş Döngüsel Olmayan Grafik (DAG) oluşturan bir dizi adımdan oluşur. Bu örnekte, bir ile başlıyoruz işlem adımı, çalıştıran SageMaker İşleme işi bir eğitim veri kümesi oluşturmak için Data Wrangler'ın akış dosyasını temel alır. Daha sonra bir ile devam ediyoruz eğitim adımıBurada SageMaker'ın yerleşik XGBoost algoritmasını ve önceki adımda oluşturulan eğitim veri kümesini kullanarak bir XGBoost modelini eğitiyoruz. Bir model eğitildikten sonra bu iş akışını şu şekilde sonlandırıyoruz: KaydetModel adımı Eğitilen modeli SageMaker model kaydına kaydetmek için.

Kurulum ve izlenecek yol

Bu örneği çalıştırmak için Studio ortamındaki Veri Bilimi çekirdek görüntüsü üzerinde Python3 çalıştıran bir Jupyter not defteri kullanıyoruz. Ayrıca, SageMaker yürütme rolünü üstlenecek kimlik bilgilerini ayarlayarak makinenizdeki yerel olarak bir Jupyter not defteri örneğinde de çalıştırabilirsiniz. Dizüstü bilgisayar hafiftir ve ml.t3.medium örneğinde çalıştırılabilir. Ayrıntılı adım adım talimatları şurada bulabilirsiniz: GitHub deposu.

Pipelines kodunu oluşturmak için Data Wrangler'ın dışa aktarma özelliğini kullanabilir veya sıfırdan kendi komut dosyanızı oluşturabilirsiniz. Örnek havuzumuzda, basitlik adına her iki yaklaşımın bir kombinasyonunu kullanıyoruz. Yüksek düzeyde, İşlem Hatları iş akışını oluşturma ve çalıştırma adımları şunlardır:

- Data Wrangler'dan bir akış dosyası oluşturun veya önceden yapılandırılmış bir şablondan bir akış dosyası oluşturmak için kurulum komut dosyasını kullanın.

- Bir oluşturma Amazon Basit Depolama Hizmeti (Amazon S3) paketini oluşturun ve akış dosyanızı ve giriş dosyalarınızı pakete yükleyin. Örnek not defterimizde SageMaker varsayılan S3 kovasını kullanıyoruz.

- Veri Wrangler akış dosyasını temel alan bir İşlemci nesnesi ve eğitim işinin parametrelerini içeren bir Tahminci nesnesi oluşturmak için not defterindeki talimatları izleyin.

- Örneğimizde yalnızca SageMaker özelliklerini ve varsayılan S3 klasörünü kullandığımız için Studio'nun varsayılan yürütme rolünü kullanabiliriz. Aynısı AWS Kimlik ve Erişim Yönetimi (IAM) rolü ardışık düzen çalıştırması, işleme işi ve eğitim işi tarafından üstlenilir. Yürütme rolünü minimum ayrıcalığa göre daha da özelleştirebilirsiniz.

- İşlemci ve Tahminci nesnelerine başvuran adımlarla bir işlem hattı oluşturma talimatlarına devam edin ve ardından işlem hattını çalıştırın. İşleme ve eğitim işleri SageMaker tarafından yönetilen ortamlarda yürütülür ve tamamlanması birkaç dakika sürer.

- Studio'da, ardışık düzen ayrıntılarının ardışık düzen çalışmasını izlediğini görebilirsiniz. Ayrıca temel işleme ve eğitim işlerini SageMaker konsolundan veya Amazon Bulut İzleme.

Data Wrangler'ı Step Functions ile entegre edin

Step Functions ile karmaşık iş mantığını, farklı AWS hizmetlerini birbirine bağlayan az kodlu, olay odaklı iş akışları olarak ifade edebilirsiniz. Step Functions Veri Bilimi SDK'sı veri bilimcilerinin, SageMaker ve Step Functions'ı kullanarak veri kümelerini önceden işleyebilen ve makine öğrenimi modellerini oluşturabilen, dağıtabilen ve izleyebilen iş akışları oluşturmasına olanak tanıyan açık kaynaklı bir kitaplıktır. Step Functions, durum makinelerine ve görevlerine dayanmaktadır. Step Functions, adı verilen adımlardan iş akışları oluşturur devletlerve bu iş akışını ifade eder Amazon Devletleri Dili. Step Functions Data Science SDK'yı kullanarak bir iş akışı oluşturduğunuzda, Step Functions'taki iş akışınızı ve adımlarınızı temsil eden bir durum makinesi oluşturulur.

Bu kullanım örneği için, bu gönderide kullanılan ve bir işleme adımı, eğitim adımı ve RegisterModel adım. Bu durumda bu adımları Step Functions Data Science Python SDK'sından içe aktarıyoruz. Bir Step Functions iş akışı oluşturmak için bu adımları aynı sırayla zincirliyoruz. İş akışı, Data Wrangler'dan oluşturulan akış dosyasını kullanır ancak kendi Data Wrangler akış dosyanızı da kullanabilirsiniz. Data Wrangler'daki bazı kodları yeniden kullanıyoruz dışa aktarma özelliği basitlik için. Bir eğitim veri kümesi oluşturmak, XGBoost algoritmasını kullanarak bir modeli eğitmek ve eğitilen model yapıtını bir SageMaker modeli olarak kaydetmek için Data Wrangler akış dosyası tarafından oluşturulan veri ön işleme mantığını çalıştırıyoruz. Ayrıca GitHub deposunda Step Functions'ın hataları denememize ve yakalamamıza, hataları ve yeniden denemeleri ele almamıza nasıl olanak tanıdığını da gösteriyoruz. FailStateStep ve CatchStateStep.

Ortaya çıkan akış şeması, aşağıdaki ekran görüntüsünde gösterildiği gibi, iş akışı başladıktan sonra Step Functions konsolunda mevcuttur. Bu, veri bilimcilerin ve mühendislerin iş akışının tamamını ve içindeki her adımı görselleştirmesine ve her adım için bağlantılı CloudWatch günlüklerine erişmesine yardımcı olur.

Kurulum ve izlenecek yol

Bu örneği çalıştırmak için Studio ortamında Veri Bilimi çekirdeğiyle çalışan bir Python not defteri kullanıyoruz. Ayrıca, SageMaker yürütme rolünü üstlenecek kimlik bilgilerini ayarlayarak makinenizdeki yerel olarak bir Python not defteri örneğinde de çalıştırabilirsiniz. Dizüstü bilgisayar hafiftir ve örneğin t3 orta düzey bir örnekte çalıştırılabilir. Ayrıntılı adım adım talimatları şurada bulabilirsiniz: GitHub deposu.

Pipelines kodunu oluşturmak ve bunu Step Functions için değiştirmek için Data Wrangler'ın dışa aktarma özelliğini kullanabilir veya sıfırdan kendi komut dosyanızı oluşturabilirsiniz. Örnek havuzumuzda basitlik adına her iki yaklaşımın bir kombinasyonunu kullanıyoruz. Yüksek düzeyde, Step Functions iş akışını oluşturma ve çalıştırma adımları şunlardır:

- Data Wrangler'dan bir akış dosyası oluşturun veya önceden yapılandırılmış bir şablondan bir akış dosyası oluşturmak için kurulum komut dosyasını kullanın.

- Bir S3 grubu oluşturun ve akış dosyanızı ve giriş dosyalarınızı bu gruba yükleyin.

- SageMaker yürütme rolünüzü daha önce belirtildiği gibi gerekli izinlerle yapılandırın. Ayrıntılı talimatlar için GitHub deposuna bakın.

- Bir iş akışını başlatmak için not defterini depoda çalıştırmak üzere talimatları izleyin. İşleme işi, SageMaker tarafından yönetilen bir Spark ortamında çalışır ve tamamlanması birkaç dakika sürebilir.

- Step Functions konsoluna gidin ve iş akışını görsel olarak izleyin. Hataları ayıklamak için bağlantılı CloudWatch günlüklerine de gidebilirsiniz.

Kodun bazı önemli bölümlerini burada inceleyelim. İş akışını tanımlamak için öncelikle Adım Fonksiyonu durum makinesi için iş akışındaki adımları tanımlıyoruz. İlk adım data_wrangler_step ham veri dosyalarını dönüştürmek için Veri Wrangler akış dosyasını girdi olarak kullanan veri işleme için. Ayrıca bir model eğitim adımı ve adında bir model oluşturma adımı da tanımlıyoruz. training_step ve model_step, sırasıyla. Son olarak oluşturduğumuz tüm adımları aşağıdaki kodda gösterildiği gibi zincirleyerek bir iş akışı oluşturuyoruz:

Örneğimizde, iş adlarını parametre olarak alacak iş akışını oluşturduk çünkü bunlar benzersizdir ve her işlem hattı çalıştırması sırasında rastgele oluşturulması gerekir. İş akışı çalıştığında bu adları iletiriz. Ayrıca Step Functions iş akışını CloudWatch kullanarak çalışacak şekilde de planlayabilirsiniz (bkz. AWS Step Functions ve Amazon CloudWatch ile Sunucusuz Bir İş Akışı Planlayın), kullanılarak çağrılır Amazon S3 Etkinlikleriveya şuradan çağrılır: Amazon EventBridge (görmek Step Functions iş akışını tetikleyen bir EventBridge kuralı oluşturun). Gösterim amacıyla, Step Functions konsolu kullanıcı arayüzünden veya dizüstü bilgisayardan aşağıdaki kodu kullanarak Step Functions iş akışını çağırabiliriz.

Data Wrangler'ı Apache Airflow ile entegre edin

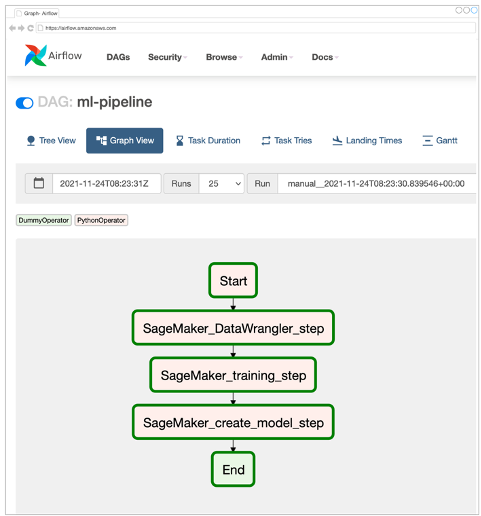

Makine öğrenimi iş akışları oluşturmanın bir diğer popüler yolu da Apache Airflow'u kullanmaktır. Apache Airflow, iş akışlarını programlı bir şekilde yazmanıza, planlamanıza ve izlemenize olanak tanıyan açık kaynaklı bir platformdur. Amazon MWAA, bulutta Apache Airflow ile uygun ölçekte uçtan uca makine öğrenimi hatları kurmayı ve çalıştırmayı kolaylaştırır. Hava Akışı boru hattı, aynı zamanda hava akışı olarak da adlandırılan bir dizi görevden oluşur. iş akışı. İş akışı, görevleri ve aralarındaki bağımlılıkları kapsayan ve bunların iş akışı içinde nasıl çalışması gerektiğini tanımlayan bir DAG olarak tanımlanır.

MLOps iş akışımızı uygulamak için Amazon MWAA ortamında bir Airflow DAG oluşturduk. İş akışındaki her görev, Python programlama dilinde yazılmış ve bazı eylemleri gerçekleştiren yürütülebilir bir birimdir. Bir görev ya bir olabilir Şebeke ya da sensörü. Bizim durumumuzda, bir kullanıyoruz Hava Akışı Python operatörü ile birlikte SageMaker Python SDK'sı Data Wrangler Python betiğini çalıştırmak ve Airflow'un yerel olarak desteklediğini kullanmak için SageMaker operatörleri SageMaker'ın yerleşik XGBoost algoritmasını eğitmek ve ortaya çıkan yapıtlardan model oluşturmak için. Ayrıca yararlı bir özel Veri Wrangler operatörü (SageMakerDataWranglerOperator) Apache Airflow için, herhangi bir ek koda ihtiyaç duymadan veri işleme amacıyla Data Wrangler akış dosyalarını işlemek için kullanabilirsiniz.

Aşağıdaki ekran görüntüsü, MLOps iş akışımızı uygulamaya yönelik beş adımlı Airflow DAG'yi göstermektedir.

Başlangıç adımı, iş akışındaki geri kalan adımlara ilişkin yapılandırmaları başlatmak için bir Python operatörü kullanır. SageMaker_DataWrangler_Step kullanım SageMakerDataWranglerOperator ve daha önce oluşturduğumuz veri akışı dosyası. SageMaker_training_step ve SageMaker_create_model_step sırasıyla model eğitimi ve model oluşturma için yerleşik SageMaker operatörlerini kullanın. Amazon MWAA ortamımız en küçük bulut sunucusu türünü (mw1.small) kullanır çünkü işlemenin büyük bir kısmı, iş akışında yapılandırma parametreleri olarak tanımlanabilen kendi bulut sunucusu türünü kullanan İşleme işleri aracılığıyla yapılır.

Kurulum ve izlenecek yol

Bu çözümün dağıtımına ilişkin ayrıntılı adım adım kurulum talimatlarını burada bulabilirsiniz. GitHub deposu. Airflow DAG'ı ayarlamak için Python kod hücrelerine sahip bir Jupyter not defteri kullandık. Veri akışı dosyasını zaten oluşturduğunuzu varsayarsak, kurulum adımlarına üst düzey bir genel bakış aşağıda verilmiştir:

- S3 grubu oluşturma ve Amazon MWAA'nın gerektirdiği sonraki klasörler.

- Bir Amazon MWAA ortamı oluşturun. Bu çözüm için Airflow 2.0.2 sürümünü kullandığımızı unutmayın.

- Oluşturun ve yükleyin

requirements.txtAirflow görevlerinin gerektirdiği tüm Python bağımlılıklarını içeren bir dosya oluşturun ve bunu/requirementsAmazon MWAA birincil S3 klasöründeki dizin. Bu, yönetilen Airflow ortamı tarafından Python bağımlılıklarını yüklemek için kullanılır. - Yükle

SMDataWranglerOperator.pydosyaya/dagsdizin. Bu Python betiği, Data Wrangler'a yönelik özel Hava Akışı operatörünün kodunu içerir. Bu operatör herhangi bir .flow dosyasını işlemeye yönelik görevler için kullanılabilir. - Oluşturun ve yükleyin

config.pysenaryoya/dagsdizin. Bu Python betiği, iş akışının geri kalan adımlarının gerektirdiği yapılandırma nesnelerini oluşturmak için DAG'ımızın ilk adımında kullanılır. - Son olarak, şunu oluşturun ve yükleyin:

ml_pipelines.pydosyaya/dagsdizin. Bu komut dosyası, Hava Akışı iş akışına ilişkin DAG tanımını içerir. Burası her bir görevi tanımladığımız ve aralarındaki bağımlılıkları kurduğumuz yerdir. Amazon MWAA periyodik olarak anketler yapar./dagsDAG'ı oluşturmak veya mevcut olanı en son değişikliklerle güncellemek için bu betiği çalıştıracak dizini seçin.

Aşağıdaki kod SageMaker_DataWrangler_step, geleneği kullanan SageMakerDataWranglerOperator. DAG tanımı Python betiğinizde yalnızca birkaç satır kodla, SageMakerDataWranglerOperator Data Wrangler akış dosyası konumuna (bu bir S3 konumudur). Perde arkasında bu operatör şunu kullanıyor: SageMaker İşleme işleri Tanımlanan dönüşümleri ham veri dosyalarınıza uygulamak amacıyla .flow dosyasını işlemek için. Ayrıca şunları da belirtebilirsiniz: örnek türü ve Data Wrangler işleme işinin ihtiyaç duyduğu örnek sayısı.

The config parametresi, son çıktı dosyasının çıktı öneki, çıktı dosyasının türü (CSV veya Parquet) ve yerleşik Data Wrangler kapsayıcısı için URI gibi işleme işinin gerektirdiği ek yapılandırmaların bir sözlüğünü (anahtar/değer çiftleri) kabul eder. görüntü. Aşağıdaki kod ne config için sözlük SageMakerDataWranglerOperator benziyor. Bu yapılandırmalar SageMaker İşleme için gereklidir işlemci. Bu yapılandırma parametrelerinin her birinin ayrıntıları için bkz. sagemaker.processing.Processor().

Temizlemek

Gelecekte ücret alınmasını önlemek için uyguladığınız çözümler için oluşturulan kaynakları silin.

- bu takip talimatlar SageMaker Pipelines çözümü tarafından oluşturulan kaynakları temizlemek için GitHub deposunda sağlanır.

- bu takip talimatlar Step Functions çözümü tarafından oluşturulan kaynakları temizlemek için GitHub deposunda sağlanır.

- bu takip talimatlar Amazon MWAA çözümü tarafından oluşturulan kaynakları temizlemek için GitHub deposunda sağlanır.

Sonuç

Bu gönderi, Data Wrangler'ı AWS'deki iyi bilinen iş akışı otomasyonu ve düzenleme teknolojilerinden bazılarıyla nasıl kolayca entegre edebileceğinizi gösterdi. Veri ön işleme için Data Wrangler'ı kullanan çözüm için ilk olarak örnek bir kullanım senaryosunu ve mimariyi inceledik. Daha sonra Data Wrangler'ı Pipelines, Step Functions ve Amazon MWAA ile nasıl entegre edebileceğinizi gösterdik.

Bir sonraki adım olarak kod örneklerini ve not defterlerini sitemizde bulabilir ve deneyebilirsiniz. GitHub deposu Bu yazıda tartışılan çözümlerin her biri için ayrıntılı talimatları kullanarak. Data Wrangler'ın makine öğrenimi iş yüklerinize nasıl yardımcı olabileceği hakkında daha fazla bilgi edinmek için Data Wrangler'ı ziyaret edin Ürün sayfası ve Amazon SageMaker Data Wrangler ile ML Verilerini Hazırlayın.

yazarlar hakkında

Rodrigo Alarcon Santiago, Şili merkezli AWS'de Kıdemli ML Strateji Çözümleri Mimarıdır. Rodrigo, görevinde farklı büyüklükteki şirketlerin bulut tabanlı yapay zeka ve makine öğrenimi çözümleri aracılığıyla iş sonuçları elde etmelerine yardımcı oluyor. İlgi alanları arasında makine öğrenimi ve siber güvenlik yer alıyor.

Rodrigo Alarcon Santiago, Şili merkezli AWS'de Kıdemli ML Strateji Çözümleri Mimarıdır. Rodrigo, görevinde farklı büyüklükteki şirketlerin bulut tabanlı yapay zeka ve makine öğrenimi çözümleri aracılığıyla iş sonuçları elde etmelerine yardımcı oluyor. İlgi alanları arasında makine öğrenimi ve siber güvenlik yer alıyor.

Ganapathi Krishnamoorthi AWS'de Kıdemli ML Çözümleri Mimarıdır. Ganapathi, başlangıç ve kurumsal müşterilere, bulut uygulamalarını uygun ölçekte tasarlamalarına ve dağıtmalarına yardımcı olan kuralcı rehberlik sağlar. Makine öğrenimi konusunda uzmanlaşmıştır ve müşterilerin iş sonuçları için AI/ML'den yararlanmasına yardımcı olmaya odaklanmıştır. İşte olmadığı zamanlarda, dışarıda keşfetmekten ve müzik dinlemekten hoşlanır.

Ganapathi Krishnamoorthi AWS'de Kıdemli ML Çözümleri Mimarıdır. Ganapathi, başlangıç ve kurumsal müşterilere, bulut uygulamalarını uygun ölçekte tasarlamalarına ve dağıtmalarına yardımcı olan kuralcı rehberlik sağlar. Makine öğrenimi konusunda uzmanlaşmıştır ve müşterilerin iş sonuçları için AI/ML'den yararlanmasına yardımcı olmaya odaklanmıştır. İşte olmadığı zamanlarda, dışarıda keşfetmekten ve müzik dinlemekten hoşlanır.

Anjan Biswas AI/ML ve Veri Analitiğine odaklanan Kıdemli AI Hizmetleri Çözümleri Mimarıdır. Anjan, dünya çapındaki AI hizmetleri ekibinin bir parçasıdır ve AI ve ML ile iş sorunlarını anlamalarına ve bunlara çözümler geliştirmelerine yardımcı olmak için müşterilerle birlikte çalışır. Anjan, küresel tedarik zinciri, üretim ve perakende kuruluşlarıyla 14 yılı aşkın deneyime sahiptir ve müşterilerin AWS AI hizmetlerini başlatmasına ve ölçeklendirmesine aktif olarak yardımcı olmaktadır.

Anjan Biswas AI/ML ve Veri Analitiğine odaklanan Kıdemli AI Hizmetleri Çözümleri Mimarıdır. Anjan, dünya çapındaki AI hizmetleri ekibinin bir parçasıdır ve AI ve ML ile iş sorunlarını anlamalarına ve bunlara çözümler geliştirmelerine yardımcı olmak için müşterilerle birlikte çalışır. Anjan, küresel tedarik zinciri, üretim ve perakende kuruluşlarıyla 14 yılı aşkın deneyime sahiptir ve müşterilerin AWS AI hizmetlerini başlatmasına ve ölçeklendirmesine aktif olarak yardımcı olmaktadır.

- AI

- yapay zeka

- AI sanat üreteci

- yapay zeka robotu

- Apache Airflow için Amazon Tarafından Yönetilen İş Akışları (Amazon MWAA)

- Amazon Adaçayı Yapıcı

- Amazon SageMaker Veri Düzenleyicisi

- yapay zeka

- yapay zeka sertifikası

- bankacılıkta yapay zeka

- yapay zeka robotu

- yapay zeka robotları

- yapay zeka yazılımı

- AWS Makine Öğrenimi

- AWS Basamak İşlevleri

- blockchain

- blockchain konferans ai

- zeka

- konuşma yapay zekası

- kripto konferans ai

- dal-e

- derin öğrenme

- google ai

- makine öğrenme

- Platon

- plato yapay zekası

- Plato Veri Zekası

- Plato Oyunu

- PlatoVeri

- plato oyunu

- ölçek ai

- sözdizimi

- zefirnet