Рентгенологічні звіти — це вичерпні, довгі документи, які описують та інтерпретують результати рентгенологічного обстеження. У типовому робочому процесі радіолог контролює, читає та інтерпретує зображення, а потім коротко підсумовує ключові результати. Підведення підсумків (або враження) є найважливішою частиною звіту, оскільки вона допомагає клініцистам і пацієнтам зосередитися на важливому вмісті звіту, який містить інформацію для прийняття клінічних рішень. Створення чіткого та вражаючого враження потребує набагато більше зусиль, ніж просто повторення висновків. Тому весь процес є трудомістким, трудомістким і схильним до помилок. Часто на це потрібні роки навчання щоб лікарі накопичили достатній досвід у написанні стислого та інформативного резюме радіологічного звіту, ще більше підкреслюючи важливість автоматизації процесу. Крім того, автоматичне формування підсумків звіту має вирішальне значення для радіологічного звіту. Це дає змогу перекладати звіти на зрозумілу людині мову, тим самим полегшуючи пацієнтам тягар читання довгих і незрозумілих звітів.

Щоб вирішити цю проблему, ми пропонуємо використовувати генеративний штучний інтелект, тип штучного інтелекту, який може створювати новий контент та ідеї, зокрема розмови, історії, зображення, відео та музику. Генеративний штучний інтелект базується на моделях машинного навчання (ML) — дуже великих моделях, попередньо навчених на величезних обсягах даних, які зазвичай називають базовими моделями (FM). Нещодавні досягнення в ML (зокрема, винахід архітектури нейронної мережі на основі трансформатора) призвели до появи моделей, які містять мільярди параметрів або змінних. Рішення, запропоноване в цій публікації, використовує тонке налаштування попередньо підготовлених великих мовних моделей (LLM), щоб допомогти генерувати підсумки на основі результатів радіологічних звітів.

У цьому дописі демонструється стратегія тонкого налаштування загальнодоступних LLM для завдання узагальнення радіологічного звіту за допомогою сервісів AWS. LLMs продемонстрували надзвичайні можливості в розумінні та створенні природної мови, слугуючи базовими моделями, які можна адаптувати до різних областей і завдань. Використання попередньо навченої моделі має значні переваги. Це зменшує витрати на обчислення, зменшує викиди вуглецю та дозволяє використовувати найсучасніші моделі без необхідності навчання з нуля.

Наше рішення використовує FLAN-T5 XL FM, використовуючи Amazon SageMaker JumpStart, який є центром ML, що пропонує алгоритми, моделі та рішення ML. Ми демонструємо, як це зробити за допомогою блокнота в Студія Amazon SageMaker. Тонке налаштування попередньо навченої моделі передбачає подальше навчання конкретних даних для покращення продуктивності в іншому, але пов’язаному завданні. Це рішення передбачає точне налаштування моделі FLAN-T5 XL, яка є вдосконаленою версією T5 (Text-to-Text Transfer Transformer) LLM загального призначення. T5 перетворює завдання обробки природної мови (NLP) в уніфікований формат тексту в текст, на відміну від БЕРТмоделі стилю, які можуть виводити лише мітку класу або діапазон вхідних даних. Його точно налаштовано для виконання завдання підсумовування 91,544 XNUMX довільних текстових радіологічних звітів, отриманих від Набір даних MIMIC-CXR.

Огляд рішення

У цьому розділі ми обговорюємо ключові компоненти нашого рішення: вибір стратегії для завдання, точне налаштування LLM та оцінка результатів. Ми також проілюструємо архітектуру рішення та етапи впровадження рішення.

Визначте стратегію виконання завдання

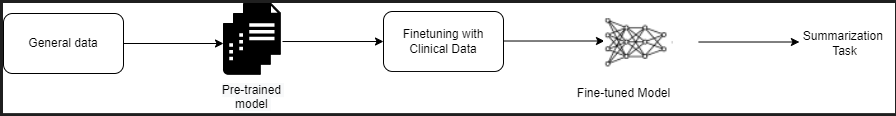

Існують різні стратегії підходу до завдання автоматизації узагальнення клінічних звітів. Наприклад, ми могли б використовувати спеціалізовану мовну модель, попередньо навчену клінічним звітам з нуля. Крім того, ми могли б безпосередньо налаштувати загальнодоступну мовну модель загального призначення для виконання клінічного завдання. Використання точно налаштованої агностичної моделі домену може знадобитися в умовах, де навчання a модель мови з нуля занадто дорого. У цьому рішенні ми демонструємо останній підхід до використання моделі FLAN -T5 XL, яку ми налаштовуємо для клінічного завдання узагальнення радіологічних звітів. Наступна діаграма ілюструє робочий процес моделі.

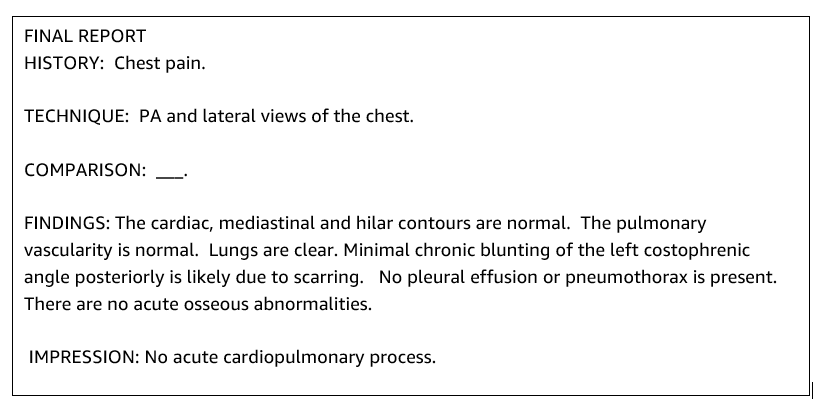

Типовий радіологічний звіт добре організований і стислий. Такі звіти часто мають три ключові розділи:

- фон – Надає загальну інформацію про демографічні дані пацієнта з важливою інформацією про пацієнта, історію хвороби, відповідну історію хвороби та подробиці процедур обстеження

- Результати – Представляє детальний діагноз і результати обстеження

- друк – Коротко підсумовує найбільш помітні результати або інтерпретацію результатів з оцінкою значущості та потенційним діагнозом на основі спостережуваних аномалій

Використовуючи розділ висновків у радіологічних звітах, рішення генерує розділ відбитків, який відповідає резюме лікарів. Наступний малюнок є прикладом рентгенологічного звіту.

Тонко налаштуйте LLM загального призначення для клінічного завдання

У цьому рішенні ми налаштовуємо модель FLAN-T5 XL (налаштовуємо всі параметри моделі та оптимізуємо їх для завдання). Ми налаштовуємо модель за допомогою набору даних клінічної області МІМІК-CXR, який є загальнодоступним набором даних рентгенограм грудної клітки. Для точного налаштування цієї моделі за допомогою SageMaker Jumpstart потрібно надати приклади з мітками у формі пар {prompt, completion}. У цьому випадку ми використовуємо пари {Findings, Impression} з оригінальних звітів у наборі даних MIMIC-CXR. Для висновку ми використовуємо підказку, як показано в наступному прикладі:

![]()

Модель налаштована на прискорені обчислення ml.p3.16xlarge екземпляр із 64 віртуальними процесорами та 488 ГіБ пам’яті. Для перевірки 5% набору даних було обрано випадковим чином. Час виконання навчального завдання SageMaker із тонким налаштуванням становив 38,468 11 секунд (приблизно XNUMX годин).

Оцініть результати

Коли навчання завершено, дуже важливо оцінити результати. Для кількісного аналізу сформованого враження ми використовуємо ЧЕРВОНИЙ (Recall-Oriented Understudy for Gisting Evaluation), найбільш часто використовуваний показник для оцінки підсумовування. Цей показник порівнює автоматично створене резюме з посиланням або набором посилань (створених людиною) резюме чи перекладу. ROUGE1 стосується перекриття уніграми (кожне слово) між кандидатом (вихідні дані моделі) і довідковими резюме. ROUGE2 стосується перекриття біграми (два слова) між кандидатським і опорним резюме. ROUGEL — це метрика рівня речення, яка стосується найдовшої спільної підпослідовності (LCS) між двома частинами тексту. Він ігнорує нові рядки в тексті. ROUGELsum — це метрика підсумкового рівня. Для цього показника нові рядки в тексті не ігноруються, але інтерпретуються як межі речень. Потім обчислюється LCS між кожною парою посилань і речень-кандидатів, а потім обчислюється об’єднання LCS. Для агрегування цих балів за даним набором еталонних і потенційних речень обчислюється середнє значення.

Проходження та архітектура

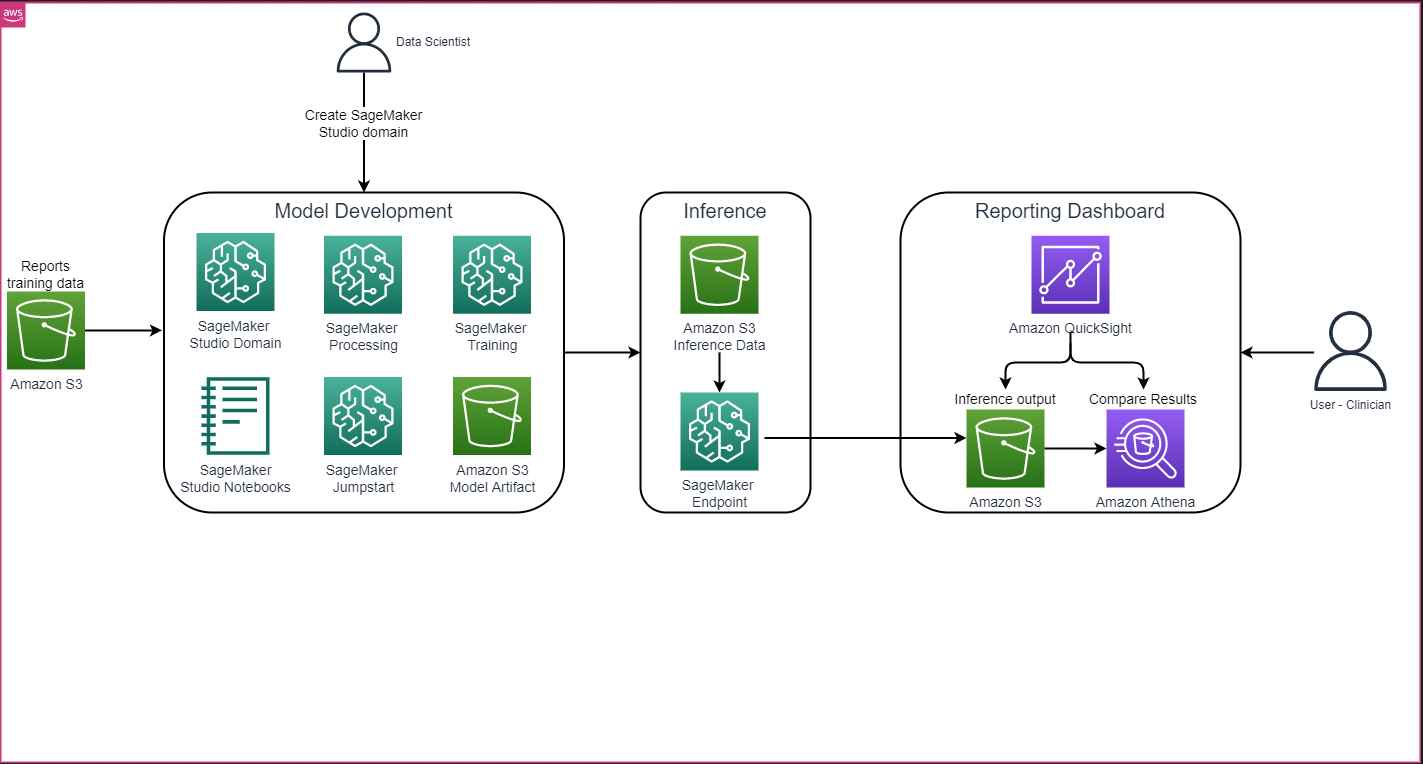

Загальна архітектура рішення, як показано на наступному малюнку, в основному складається із середовища розробки моделі, яке використовує SageMaker Studio, розгортання моделі з кінцевою точкою SageMaker і панелі звітів за допомогою Amazon QuickSight.

У наступних розділах ми демонструємо точне налаштування LLM, доступного на SageMaker JumpStart, для узагальнення предметно-спеціального завдання за допомогою SDK SageMaker Python. Зокрема, обговорюємо такі теми:

- Етапи налаштування середовища розробки

- Огляд наборів даних радіологічних звітів, на основі яких налаштовується та оцінюється модель

- Демонстрація точного налаштування моделі FLAN-T5 XL за допомогою програми SageMaker JumpStart із SDK SageMaker Python

- Виведення та оцінка попередньо навчених і налаштованих моделей

- Порівняння результатів попередньо навченої моделі та точно налаштованих моделей

Рішення доступне в Створення вражень радіологічного звіту за допомогою генеративного ШІ з моделлю великої мови на AWS GitHub репо.

Передумови

Щоб почати, вам потрібен Обліковий запис AWS в якому можна використовувати SageMaker Studio. Вам потрібно буде створити профіль користувача для SageMaker Studio, якщо ви його ще не маєте.

Тип навчального екземпляра, який використовується в цій публікації, – ml.p3.16xlarge. Зауважте, що тип екземпляра p3 вимагає збільшення ліміту послуг.

Команда Набір даних MIMIC CXR можна отримати доступ через угоду про використання даних, яка вимагає реєстрації користувача та завершення процесу ідентифікації.

Налаштуйте середовище розробки

Щоб налаштувати середовище розробки, ви створюєте сегмент S3, налаштовуєте блокнот, створюєте кінцеві точки та розгортаєте моделі, а також створюєте інформаційну панель QuickSight.

Створіть відро S3

Створіть відро S3 званий llm-radiology-bucket для розміщення наборів даних для навчання та оцінювання. Це також використовуватиметься для зберігання артефакту моделі під час розробки моделі.

Налаштувати блокнот

Виконайте такі дії:

- Запустіть SageMaker Studio з консолі SageMaker або з Інтерфейс командного рядка AWS (AWS CLI).

Додаткову інформацію про підключення до домену див На борту до домену Amazon SageMaker.

- Створіть новий Блокнот SageMaker Studio для очищення даних звіту та точного налаштування моделі. Ми використовуємо примірник ноутбука ml.t3.medium 2vCPU+4GiB з ядром Python 3.

- У блокноті встановіть відповідні пакети, наприклад

nest-asyncio,IPyWidgets(для інтерактивних віджетів для ноутбука Jupyter) і SageMaker Python SDK:

Для виведення попередньо підготовлених і точно налаштованих моделей, створити кінцеву точку та розгорнути кожну модель у зошиті наступним чином:

- Створіть об’єкт моделі з класу Model, який можна розгорнути на кінцевій точці HTTPS.

- Створіть кінцеву точку HTTPS із попередньо створеним об’єктом моделі

deploy()метод:

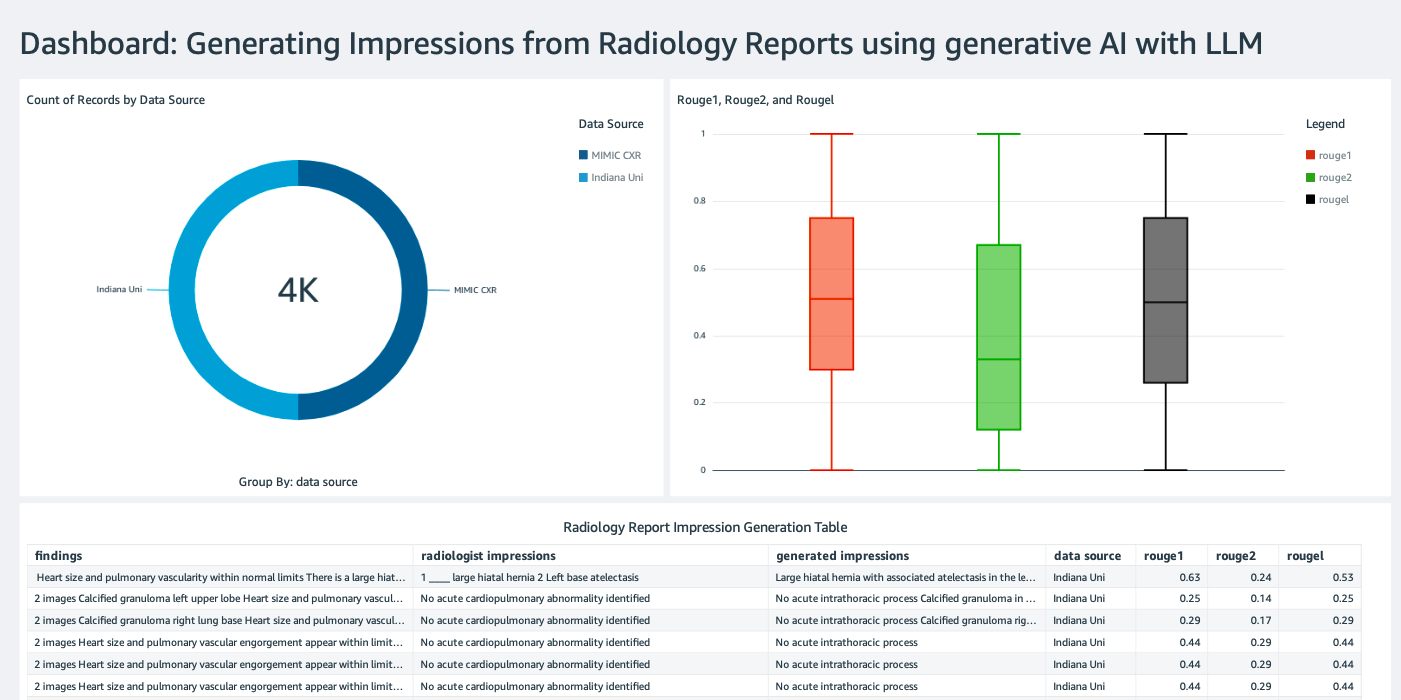

Створіть інформаційну панель QuickSight

Створити Інформаційна панель QuickSight із джерелом даних Athena з результатами висновку Служба простого зберігання Amazon (Amazon S3), щоб порівняти результати висновків із основною правдою. На наступному знімку екрана показано приклад панелі інструментів.

Набори даних радіологічного звіту

Тепер модель налаштована, усі параметри моделі налаштовані на 91,544 XNUMX звіти, завантажені з Набір даних MIMIC-CXR v2.0. Оскільки ми використовували лише текстові дані радіологічного звіту, ми завантажили лише один стиснутий файл звіту (mimic-cxr-reports.zip) з веб-сайту MIMIC-CXR. Зараз ми оцінюємо налаштовану модель на основі 2,000 звітів (іменованих як dev1 набір даних) з окрем тримав підмножину цього набору даних. Ми використовуємо ще 2,000 радіологічних звітів (іменовані як dev2) для оцінки точно налаштованої моделі з колекції рентгенівських знімків грудної клітки від Мережа лікарень університету Індіани. Усі набори даних зчитуються як файли JSON і завантажуються в щойно створений сегмент S3 llm-radiology-bucket. Зауважте, що всі набори даних за замовчуванням не містять жодної захищеної медичної інформації (PHI); уся конфіденційна інформація замінюється трьома послідовними символами підкреслення (___) постачальниками.

Точне налаштування за допомогою SDK SageMaker Python

Для точного налаштування model_id вказано як huggingface-text2text-flan-t5-xl зі списку моделей SageMaker JumpStart. The training_instance_type встановлено як ml.p3.16xlarge і inference_instance_type як ml.g5.2xlarge. Навчальні дані у форматі JSON зчитуються з відра S3. Наступним кроком є використання вибраного model_id для отримання URI ресурсів SageMaker JumpStart, включно з image_uri ( Реєстр контейнерів Amazon Elastic (Amazon ECR) URI для зображення Docker), model_uri (попередньо навчений артефакт моделі Amazon S3 URI) і script_uri (сценарій навчання):

Крім того, місце виведення встановлюється як папка в сегменті S3.

Лише один гіперпараметр, епохи, змінено на 3, а решта встановлено за замовчуванням:

Такі показники навчання, як eval_loss (для втрати підтвердження), loss (за втрату навчання), і epoch для відстеження визначено та перераховано:

Ми використовуємо URI ресурсів SageMaker JumpStart (image_uri, model_uri, script_uri), визначені раніше, щоб створити оцінювач і точно налаштувати його на навчальному наборі даних, вказавши шлях S3 набору даних. Для класу Estimator потрібен entry_point параметр. У цьому випадку JumpStart використовує transfer_learning.py. Завдання навчання не запускається, якщо це значення не встановлено.

На виконання цієї навчальної роботи можуть знадобитися години; отже, рекомендовано встановити для параметра очікування значення False і відстежувати стан навчального завдання на консолі SageMaker. Використовувати TrainingJobAnalytics функція для відстеження показників навчання в різних часових мітках:

Розгорнути кінцеві точки висновку

Щоб проводити порівняння, ми розгортаємо кінцеві точки висновків як для попередньо навчених, так і для точно налаштованих моделей.

Спочатку отримайте URI зображення Docker для висновку за допомогою model_idі використовуйте цей URI для створення екземпляра моделі SageMaker попередньо навченої моделі. Розгорніть попередньо навчену модель, створивши кінцеву точку HTTPS із попередньо створеним об’єктом моделі deploy() метод. Щоб запустити висновок через SageMaker API, обов’язково передайте клас Predictor.

Повторіть попередній крок, щоб створити екземпляр моделі SageMaker налаштованої моделі та створити кінцеву точку для розгортання моделі.

Оцініть моделі

Спочатку встановіть довжину короткого тексту, кількість вихідних даних моделі (має бути більше 1, якщо необхідно створити декілька підсумків) і кількість променів для променевий пошук.

Створіть запит на висновок як корисне навантаження JSON і використовуйте його для запиту кінцевих точок для попередньо навчених і налаштованих моделей.

Обчислити агрегований РУЖ забиває (ROUGE1, ROUGE2, ROUGEL, ROUGELsum), як описано раніше.

Порівняйте результати

У таблиці нижче наведено результати оцінки для dev1 та dev2 набори даних. Результат оцінювання на dev1 (2,000 результатів із радіологічного звіту MIMIC CXR) показує приблизно 38 процентних пунктів покращення у сукупному середньому ROUGE1 і ROUGE2 бали порівняно з попередньо навченою моделлю. Для dev2 показники ROUGE31 і ROUGE25 покращилися на 1 відсотковий пункт і 2 відсоткових пунктів. Загалом, точне налаштування призвело до покращення на 38.2 відсоткових пунктів і 31.3 відсоткових пунктів у балах ROUGELsum для dev1 та dev2 набори даних відповідно.

|

Оцінка Набір даних |

Попередньо навчена модель | Досконала модель | ||||||

| ROUGE1 | ROUGE2 | РУГЕЛЬ | РУГЕЛЬсум | ROUGE1 | ROUGE2 | РУГЕЛЬ | РУГЕЛЬсум | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

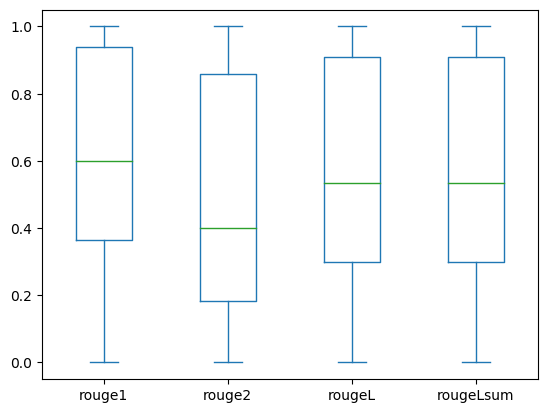

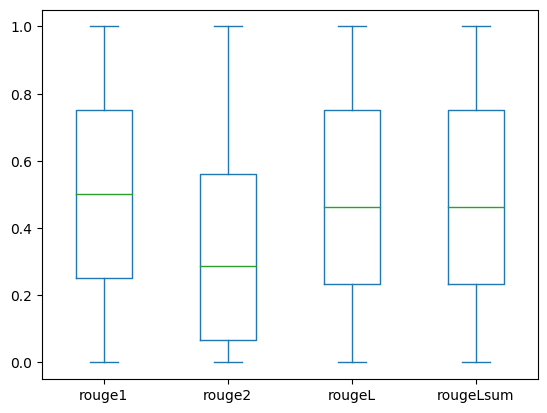

Наступні графіки зображають розподіл балів ROUGE для dev1 та dev2 набори даних, оцінені за допомогою точно налаштованої моделі.

|

|

(а): dev1 |

(б): dev2 |

У наведеній нижче таблиці показано, що показники ROUGE для наборів даних оцінювання мають приблизно однакові медіану та середнє значення, а отже, розподілені симетрично.

| Набори даних | Партитура | Рахувати | Середня | Стандартне відхилення | мінімальний | 25% процентиль | 50% процентиль | 75% процентиль | Максимальний |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| РУЖ Л | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| РУГЕЛЬсум | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| РУЖ Л | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| РУЖ Лсум | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Прибирати

Щоб уникнути майбутніх витрат, видаліть ресурси, створені за допомогою такого коду:

Висновок

У цьому дописі ми продемонстрували, як точно налаштувати модель FLAN-T5 XL для задачі узагальнення, що стосується конкретної клінічної області, за допомогою SageMaker Studio. Щоб підвищити впевненість, ми порівняли прогнози з базовою правдою та оцінили результати за допомогою показників ROUGE. Ми продемонстрували, що модель, налаштована на конкретне завдання, дає кращі результати, ніж модель, попередньо навчена на загальне завдання НЛП. Ми хотіли б зазначити, що точне налаштування LLM загального призначення повністю усуває витрати на попереднє навчання.

Хоча представлена тут робота зосереджена на звітах про рентген грудної клітки, її можна розширити до більших наборів даних із різними анатоміями та модальностями, такими як МРТ і КТ, для яких радіологічні звіти можуть бути складнішими з кількома результатами. У таких випадках радіологи можуть створити враження в порядку критичності та включити рекомендації щодо подальшого спостереження. Крім того, налаштування циклу зворотного зв’язку для цього додатка дозволить радіологам з часом покращити продуктивність моделі.

Як ми показали в цій публікації, точно налаштована модель генерує покази для радіологічних звітів із високими оцінками ROUGE. Ви можете спробувати налаштувати LLM на інших медичних звітах із різних відділів, що стосуються конкретного домену.

Про авторів

Доктор Адевале Акінфадерін є старшим спеціалістом із обробки даних у сфері охорони здоров’я та наук про життя в AWS. Його досвід полягає у відтворюваних і наскрізних методах AI/ML, практичних реалізаціях і допомозі глобальним клієнтам охорони здоров’я формулювати та розробляти масштабовані рішення для міждисциплінарних проблем. Він має два дипломи з фізики та ступінь доктора інженерії.

Доктор Адевале Акінфадерін є старшим спеціалістом із обробки даних у сфері охорони здоров’я та наук про життя в AWS. Його досвід полягає у відтворюваних і наскрізних методах AI/ML, практичних реалізаціях і допомозі глобальним клієнтам охорони здоров’я формулювати та розробляти масштабовані рішення для міждисциплінарних проблем. Він має два дипломи з фізики та ступінь доктора інженерії.

Прія Падате є старшим архітектором партнерських рішень із великим досвідом у сфері охорони здоров’я та наук про життя в AWS. Priya разом із партнерами розробляє стратегії виходу на ринок і сприяє розробці рішень для прискорення розробки на основі ШІ/ML. Вона захоплена використанням технологій для трансформації галузі охорони здоров’я, щоб досягти кращих результатів лікування пацієнтів.

Прія Падате є старшим архітектором партнерських рішень із великим досвідом у сфері охорони здоров’я та наук про життя в AWS. Priya разом із партнерами розробляє стратегії виходу на ринок і сприяє розробці рішень для прискорення розробки на основі ШІ/ML. Вона захоплена використанням технологій для трансформації галузі охорони здоров’я, щоб досягти кращих результатів лікування пацієнтів.

Екта Валія Бхуллар, PhD, є старшим консультантом зі штучного інтелекту та ML бізнес-підрозділу професійних послуг AWS Healthcare and Life Sciences (HCLS). Вона має значний досвід застосування ШІ/ML у сфері охорони здоров’я, особливо в радіології. Поза роботою, коли не обговорюють ШІ в радіології, вона любить бігати та піти в походи.

Екта Валія Бхуллар, PhD, є старшим консультантом зі штучного інтелекту та ML бізнес-підрозділу професійних послуг AWS Healthcare and Life Sciences (HCLS). Вона має значний досвід застосування ШІ/ML у сфері охорони здоров’я, особливо в радіології. Поза роботою, коли не обговорюють ШІ в радіології, вона любить бігати та піти в походи.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- ChartPrime. Розвивайте свою торгову гру за допомогою ChartPrime. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- : має

- :є

- : ні

- :де

- $UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Здатний

- МЕНЮ

- прискорювати

- прискорений

- доступний

- виконувати

- Накопичуватися

- Додатково

- досягнення

- проти

- агрегація

- Угода

- AI

- AI / ML

- алгоритми

- ВСІ

- дозволяє

- вже

- Також

- взагалі

- Amazon

- Amazon SageMaker

- Amazon Web Services

- суми

- an

- аналіз

- та

- Інший

- будь-який

- API

- додаток

- підхід

- приблизно

- архітектура

- ЕСТЬ

- аргумент

- AS

- оцінка

- At

- автоматичний

- автоматично

- автоматизація

- доступний

- середній

- уникнути

- AWS

- база

- заснований

- BE

- оскільки

- перед тим

- буття

- Переваги

- Краще

- між

- більший

- мільярди

- обидва

- Межі

- Box

- тягар

- бізнес

- але

- by

- званий

- CAN

- кандидат

- можливості

- вуглець

- який

- випадок

- випадків

- змінилися

- вантажі

- Вибираючи

- клас

- Очищення

- ясно

- Клінічний

- клініцисти

- код

- збір

- загальний

- зазвичай

- порівняти

- порівняний

- повний

- завершення

- комплекс

- Компоненти

- всеосяжний

- обчислення

- обчислення

- лаконічний

- довіра

- поспіль

- складається

- Консоль

- консультант

- містити

- Контейнер

- зміст

- зміст

- контрастність

- розмови

- відповідає

- Коштувати

- дорого

- витрати

- може

- Пара

- створювати

- створений

- створення

- критичний

- критичність

- виготовлений на замовлення

- Клієнти

- приладова панель

- дані

- вчений даних

- набори даних

- Прийняття рішень

- дефолт

- певний

- Ступінь

- Демографічна

- демонструвати

- продемонстрований

- демонструє

- відомства

- розгортання

- розгорнути

- розгортання

- описувати

- описаний

- докладно

- деталі

- розвивати

- розробка

- різний

- безпосередньо

- обговорювати

- обговорення

- розподілений

- розподіл

- Docker

- Лікарі

- документація

- домен

- домени

- Не знаю

- малювати

- управляти

- диски

- під час

- кожен

- Раніше

- зусилля

- або

- Усуває

- ще

- включіть

- дозволяє

- кінець в кінець

- Кінцева точка

- Машинобудування

- підвищена

- досить

- Весь

- Навколишнє середовище

- епоха

- епохи

- помилка

- особливо

- істотний

- оцінювати

- оцінюється

- оцінки

- оцінка

- іспит

- приклад

- Приклади

- виконувати

- розширений

- досвід

- експертиза

- обширний

- Великий досвід

- витяг

- зазнає невдачі

- false

- зворотний зв'язок

- Рисунок

- філе

- Файли

- результати

- Сфокусувати

- фокусується

- після

- слідує

- для

- форма

- формат

- фонд

- від

- функція

- далі

- Крім того

- майбутнє

- Загальне

- Головна мета

- породжувати

- генерується

- генерує

- покоління

- генеративний

- Генеративний ШІ

- отримати

- даний

- Глобальний

- Вихід на ринок

- випускник

- великий

- Земля

- Мати

- має

- he

- здоров'я

- інформація про стан здоров'я

- охорона здоров'я

- healthcare industry

- допомога

- допомогу

- допомагає

- тут

- Високий

- виділивши

- Похід

- його

- історія

- господар

- ГОДИННИК

- Як

- How To

- HTML

- HTTP

- HTTPS

- Концентратор

- HuggingFace

- людина

- ID

- ідеї

- ідентифікований

- if

- ілюструє

- зображення

- зображень

- Зображеннями

- вражаючий

- здійснювати

- реалізації

- імпорт

- важливо

- удосконалювати

- поліпшення

- in

- включати

- У тому числі

- Augmenter

- промисловість

- інформація

- інформативний

- вхід

- встановлювати

- екземпляр

- інтерактивний

- інтерпретація

- в

- Винахід

- IT

- робота

- Джобс

- json

- просто

- тільки один

- тримати

- ключ

- етикетка

- мова

- великий

- запуск

- вивчення

- Led

- довжина

- життя

- Life Sciences

- як

- Сподобалося

- МЕЖА

- Лінія

- список

- Перераховані

- LLM

- розташований

- розташування

- від

- машина

- навчання за допомогою машини

- зробити

- Може..

- значити

- медичний

- середа

- пам'ять

- метод

- методика

- метрика

- Метрика

- може бути

- хвилин

- ML

- модель

- Моделі

- монітор

- більше

- найбільш

- МРТ

- багато

- множинний

- музика

- повинен

- ім'я

- Природний

- Обробка природних мов

- необхідно

- Необхідність

- мережу

- нейронної мережі

- Нові

- нещодавно

- наступний

- nlp

- ноутбук

- зараз

- номер

- об'єкт

- отриманий

- of

- пропонує

- часто

- on

- На борту

- ONE

- тільки

- оптимізуючий

- or

- порядок

- оригінал

- Інше

- наші

- з

- Результати

- вихід

- поза

- над

- загальний

- перевизначення

- огляд

- пакети

- пара

- пар

- параметр

- параметри

- частина

- приватність

- партнер

- партнери

- проходити

- пристрасний

- шлях

- пацієнт

- pacientes

- відсоток

- Виконувати

- продуктивність

- Вчений ступінь

- Фізика

- частин

- plato

- Інформація про дані Платона

- PlatoData

- точка

- точок

- пошта

- потенціал

- Харчування

- Практичний

- Прогнози

- Прогноз

- представлений

- подарунки

- в першу чергу

- Проблема

- проблеми

- процес

- обробка

- Вироблений

- професійний

- профіль

- пропонувати

- запропонований

- захищений

- за умови

- провайдери

- забезпечує

- публічно

- Python

- кількісний

- Читати

- читання

- останній

- рекомендації

- рекомендований

- знижує

- посилання

- називають

- відноситься

- regex

- Реєстрація

- пов'язаний

- доречний

- чудовий

- замінити

- звітом

- Звітність

- Звіти

- запросити

- вимагається

- Вимагається

- ресурс

- ресурси

- відповідно

- REST

- результат

- результати

- Умови повернення

- Зростання

- прогін

- біг

- мудрець

- то ж

- масштабовані

- НАУКИ

- вчений

- подряпати

- Sdk

- Пошук

- seconds

- розділ

- розділам

- побачити

- обраний

- старший

- чутливий

- пропозиція

- окремий

- обслуговування

- Послуги

- виступаючої

- комплект

- установка

- налаштування

- вона

- Повинен

- показав

- показаний

- Шоу

- значення

- значний

- простий

- просто

- невеликий

- So

- рішення

- Рішення

- ВИРІШИТИ

- деякі

- span

- спеціалізований

- конкретний

- конкретно

- зазначений

- старт

- почалася

- впроваджений

- Статус

- Крок

- заходи

- Як і раніше

- зберігання

- зберігати

- історії

- стратегії

- Стратегія

- студія

- такі

- РЕЗЮМЕ

- Переконайтеся

- таблиця

- Приймати

- приймає

- Завдання

- завдання

- Технологія

- ніж

- Що

- Команда

- Їх

- потім

- Там.

- тим самим

- отже

- Ці

- це

- ті

- три

- через

- час

- до

- занадто

- теми

- трек

- поїзд

- Навчання

- переклад

- Перетворення

- трансформатор

- Переклад

- Правда

- намагатися

- два

- тип

- типовий

- нижнє підкреслення

- розуміння

- єдиний

- блок

- університет

- завантажено

- використання

- використовуваний

- користувач

- використовує

- використання

- перевірка достовірності

- значення

- Цінності

- різний

- величезний

- версія

- через

- Відео

- Віртуальний

- чекати

- було

- we

- Web

- веб-сервіси

- веб-сайт

- коли

- який

- в той час як

- ширина

- волі

- з

- в

- без

- слово

- слова

- Work

- робочий

- б

- лист

- рентгенівський

- років

- Ти

- вашу

- зефірнет