з Бази знань для Amazon Bedrock, ви можете безпечно підключити базові моделі (FM). Amazon Bedrock до даних вашої компанії для Retrieval Augmented Generation (RAG). Доступ до додаткових даних допомагає моделі генерувати більш релевантні, залежно від контексту та точні відповіді без перенавчання FM.

У цій публікації ми обговорюємо дві нові функції баз знань для Amazon Bedrock, специфічні для RetrieveAndGenerate API: налаштування максимальної кількості результатів і створення спеціальних підказок за допомогою шаблону підказки бази знань. Тепер ви можете вибрати їх як параметри запиту поряд із типом пошуку.

Огляд і переваги нових функцій

Опція максимальної кількості результатів дає вам контроль над кількістю результатів пошуку, які будуть отримані з векторного сховища та передані FM для генерації відповіді. Це дозволяє вам налаштувати обсяг довідкової інформації, що надається для генерації, таким чином надаючи більше контексту для складних питань або менше для простіших питань. Це дозволяє отримати до 100 результатів. Ця опція допомагає підвищити ймовірність відповідного контексту, тим самим підвищуючи точність і зменшуючи галюцинації згенерованої відповіді.

Настроюваний шаблон підказки бази знань дозволяє замінити шаблон підказки за замовчуванням власним, щоб налаштувати підказку, яка надсилається в модель для створення відповіді. Це дозволяє налаштувати тон, вихідний формат і поведінку FM, коли він відповідає на запитання користувача. За допомогою цього параметра ви можете точно налаштувати термінологію, щоб вона краще відповідала вашій галузі чи домену (наприклад, охорона здоров’я чи юридична). Крім того, ви можете додати власні інструкції та приклади, адаптовані до ваших конкретних робочих процесів.

У наступних розділах ми пояснюємо, як ви можете використовувати ці функції з будь-яким Консоль управління AWS або SDK.

Передумови

Щоб слідувати цим прикладам, вам потрібно мати наявну базу знань. Інструкції щодо створення див Створіть базу знань.

Налаштуйте максимальну кількість результатів за допомогою консолі

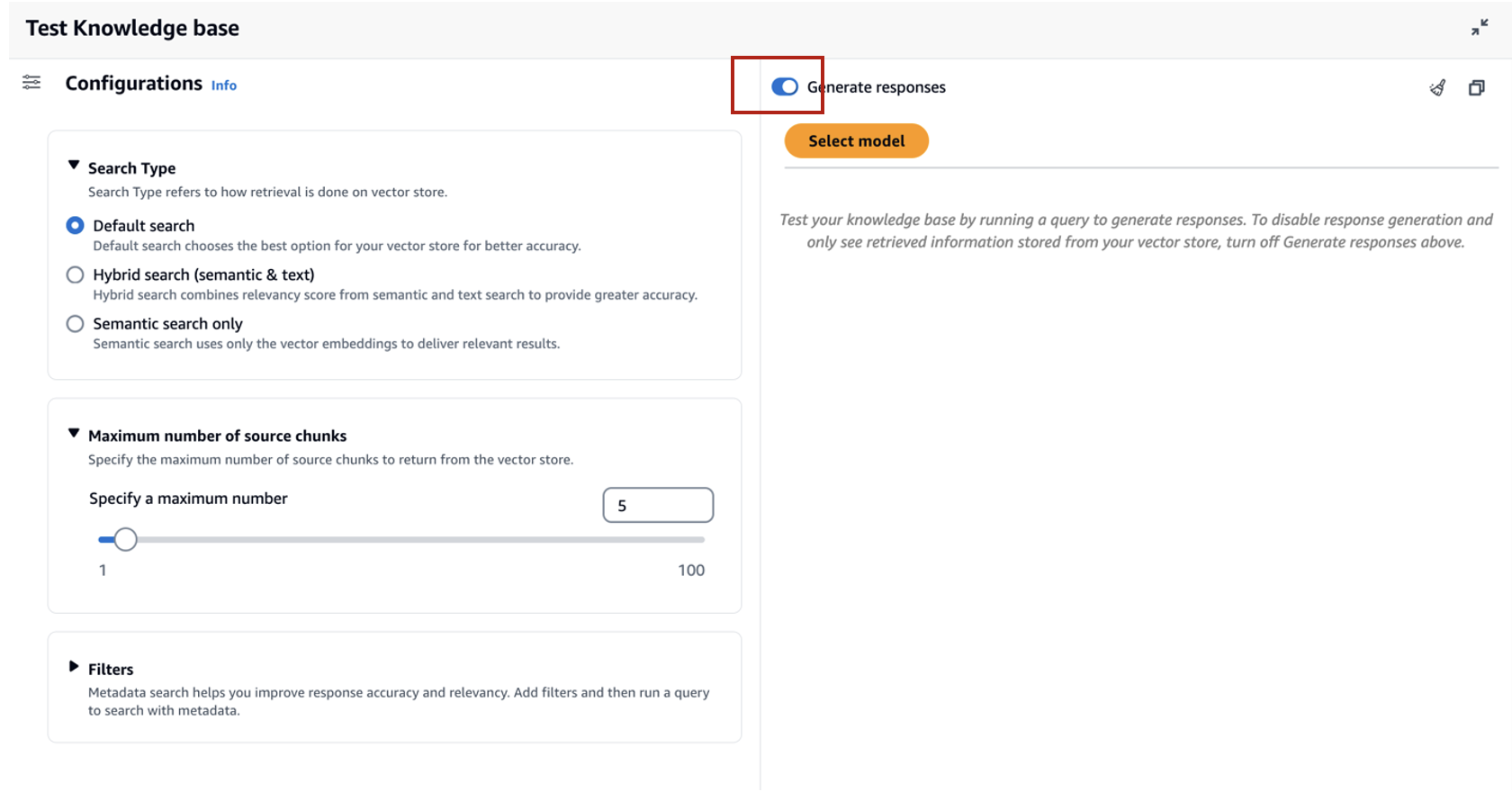

Щоб використовувати опцію максимальної кількості результатів за допомогою консолі, виконайте такі дії:

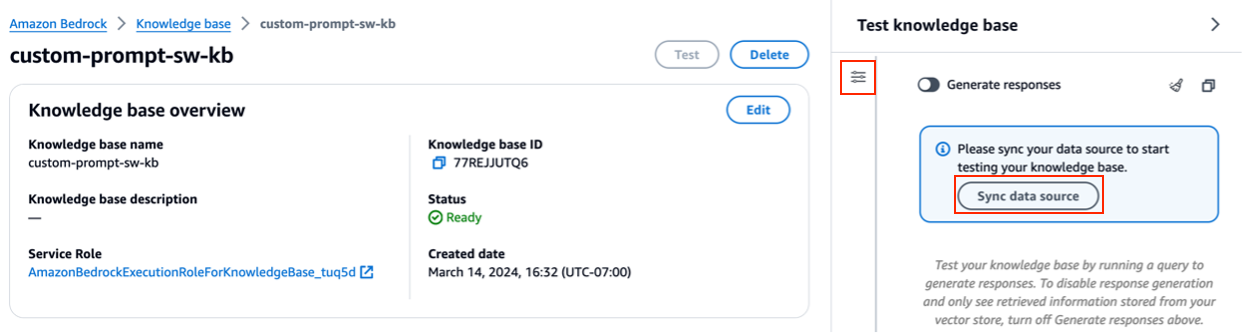

- Виберіть на консолі Amazon Bedrock Бази знань на лівій навігаційній панелі.

- Виберіть створену базу знань.

- Вибирати Тест бази знань.

- Виберіть піктограму конфігурації.

- Вибирати Синхронізувати джерело даних перед початком тестування своєї бази знань.

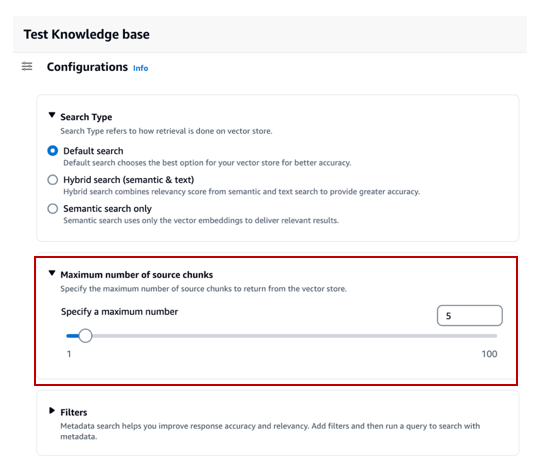

- під Конфігурації, Для Тип пошуку, виберіть тип пошуку на основі вашого випадку використання.

Для цієї публікації ми використовуємо гібридний пошук, оскільки він поєднує семантичний і текстовий пошук для забезпечення більшої точності. Щоб дізнатися більше про гібридний пошук, див Бази знань для Amazon Bedrock тепер підтримують гібридний пошук.

- Розширювати Максимальна кількість вихідних блоків і встановіть максимальну кількість результатів.

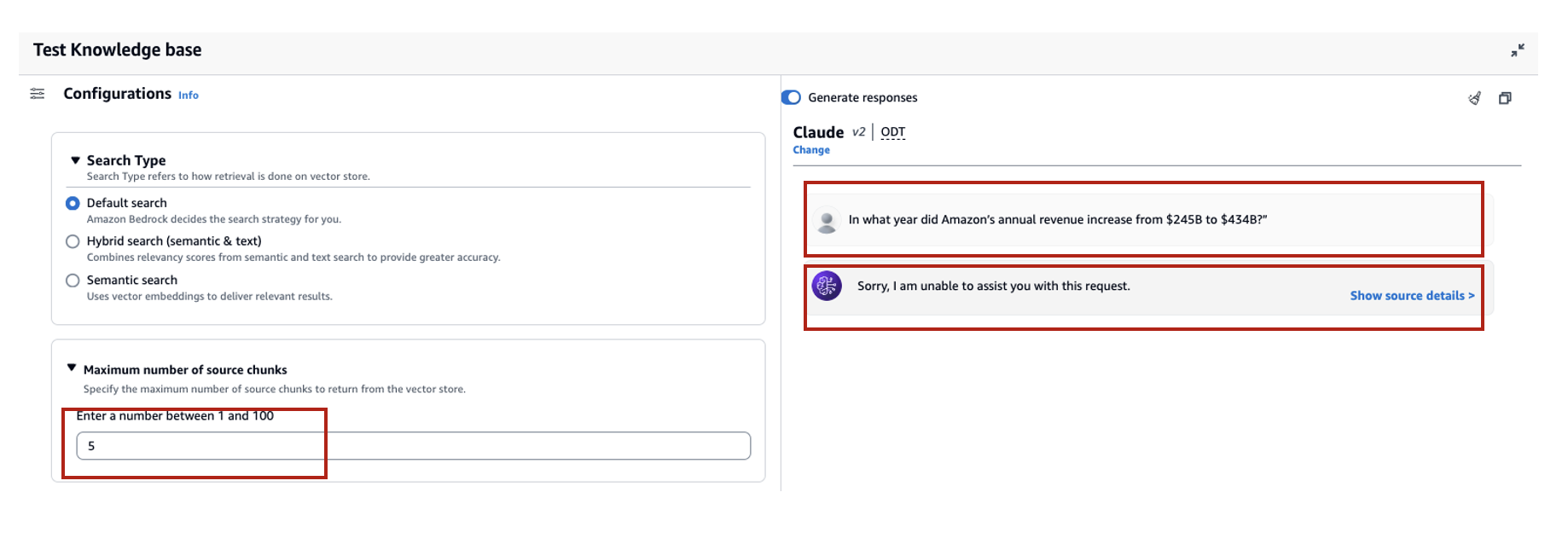

Щоб продемонструвати цінність нової функції, ми показуємо приклади того, як можна підвищити точність згенерованої відповіді. Ми використовували Документ Amazon 10K за 2023 рік як вихідні дані для створення бази знань. Ми використовуємо такий запит для експерименту: «У якому році річний дохід Amazon збільшився з 245 мільярдів доларів США до 434 мільярдів доларів США?»

Правильна відповідь на цей запит: «Річний дохід Amazon збільшився з 245 мільярдів доларів у 2019 році до 434 мільярдів доларів у 2022 році» на основі документів у базі знань. Ми використали Claude v2 як FM для створення остаточної відповіді на основі контекстної інформації, отриманої з бази знань. Claude 3 Sonnet і Claude 3 Haiku також підтримуються як покоління FM.

Ми запустили ще один запит, щоб продемонструвати порівняння отримання з різними конфігураціями. Ми використали той самий вхідний запит («У якому році річний дохід Amazon збільшився з 245 мільярдів доларів до 434 мільярдів доларів?») і встановили максимальну кількість результатів до 5.

Як показано на наступному знімку екрана, згенерованою відповіддю було «Вибачте, я не можу допомогти вам із цим запитом».

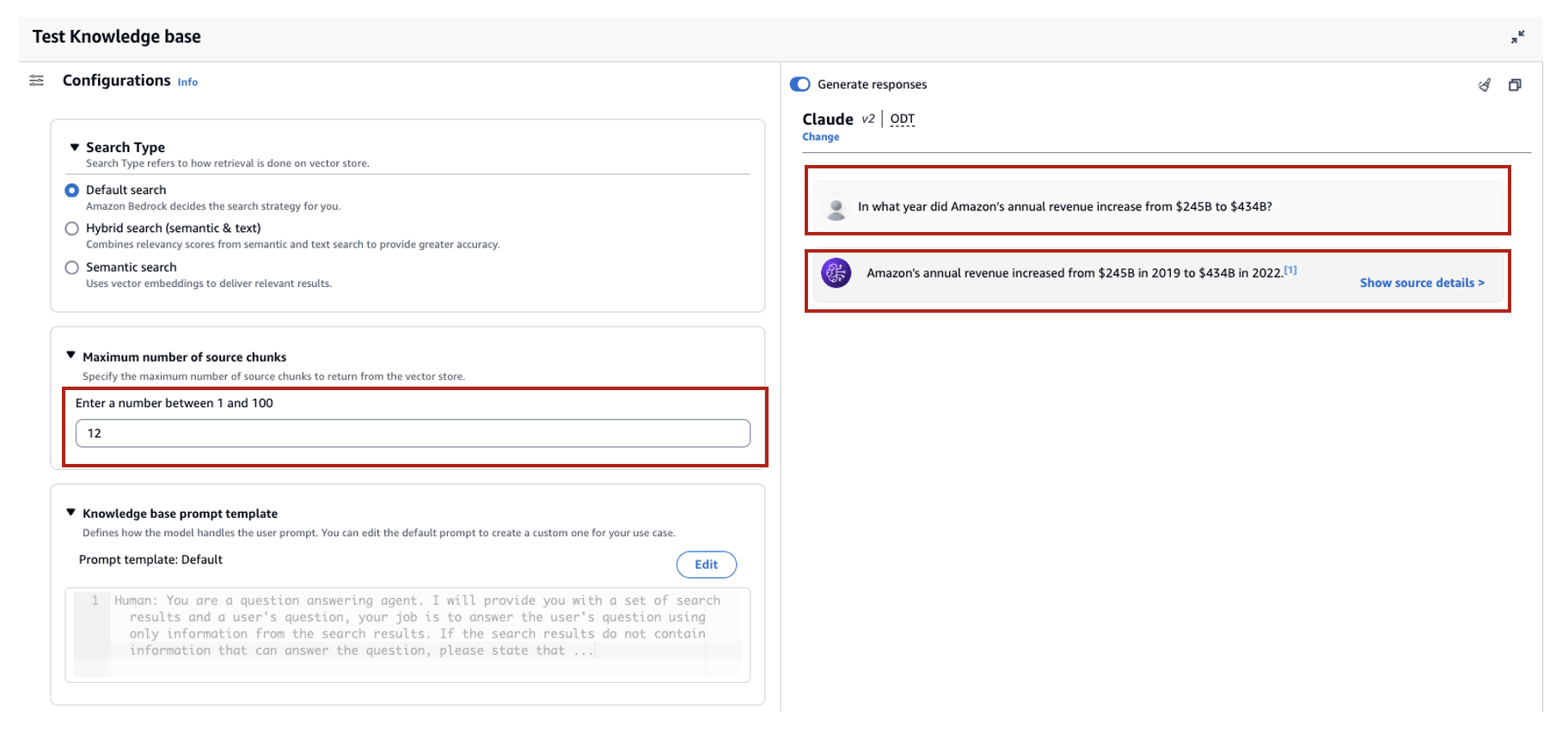

Далі ми встановлюємо максимальні результати 12 і ставимо те саме запитання. Згенерована відповідь: «Річний дохід Amazon збільшився з 245 мільярдів доларів у 2019 році до 434 мільярдів доларів у 2022 році».

Як показано в цьому прикладі, ми можемо отримати правильну відповідь на основі кількості отриманих результатів. Якщо ви хочете дізнатися більше про атрибуцію джерела, яка становить кінцевий результат, виберіть Показати деталі джерела перевірити згенеровану відповідь на основі бази знань.

Налаштуйте шаблон підказки бази знань за допомогою консолі

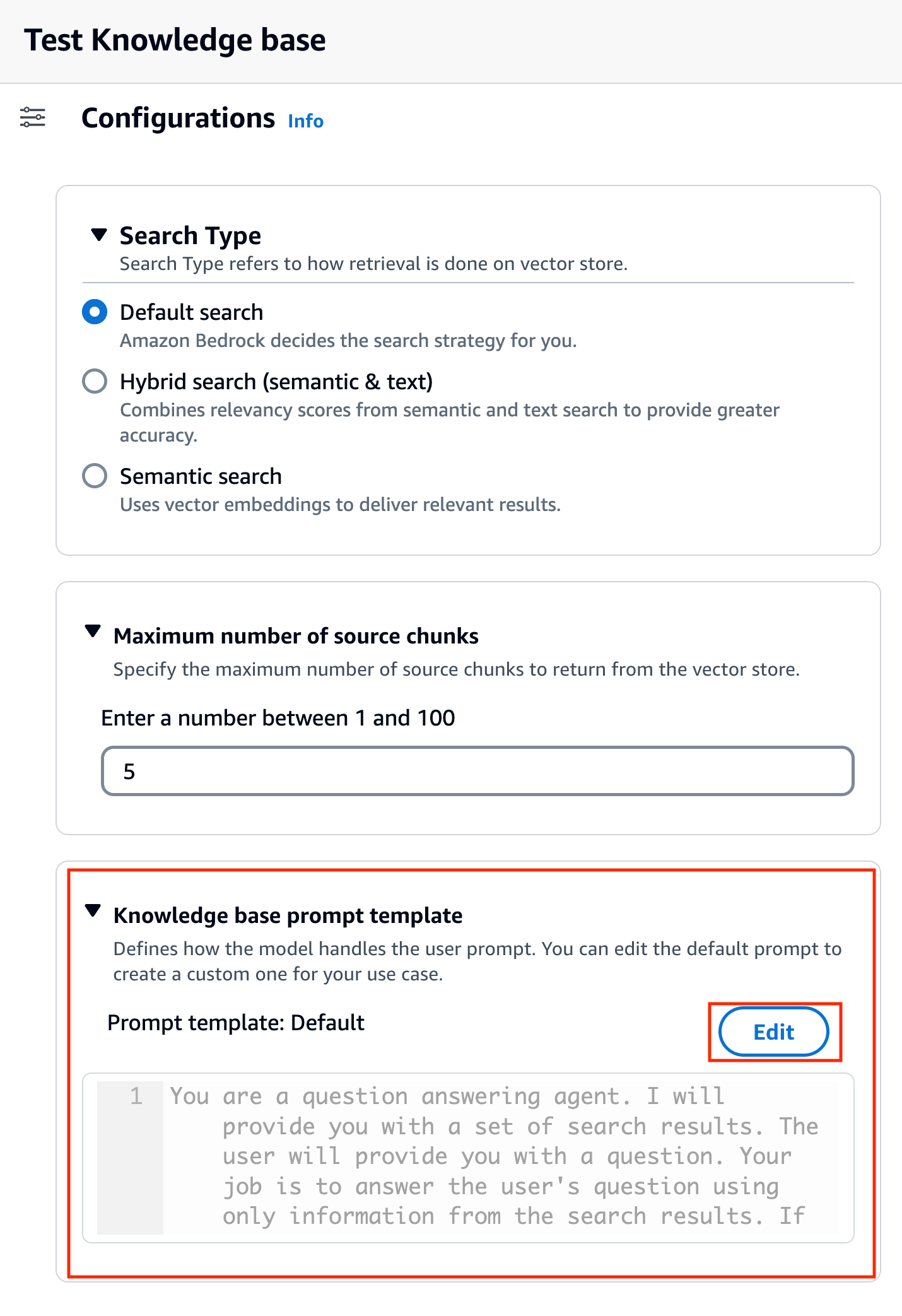

Ви також можете налаштувати підказку за замовчуванням за допомогою власної підказки відповідно до варіанту використання. Щоб зробити це на консолі, виконайте такі дії:

- Повторіть кроки з попереднього розділу, щоб почати перевірку своєї бази знань.

- включити Генеруйте відповіді.

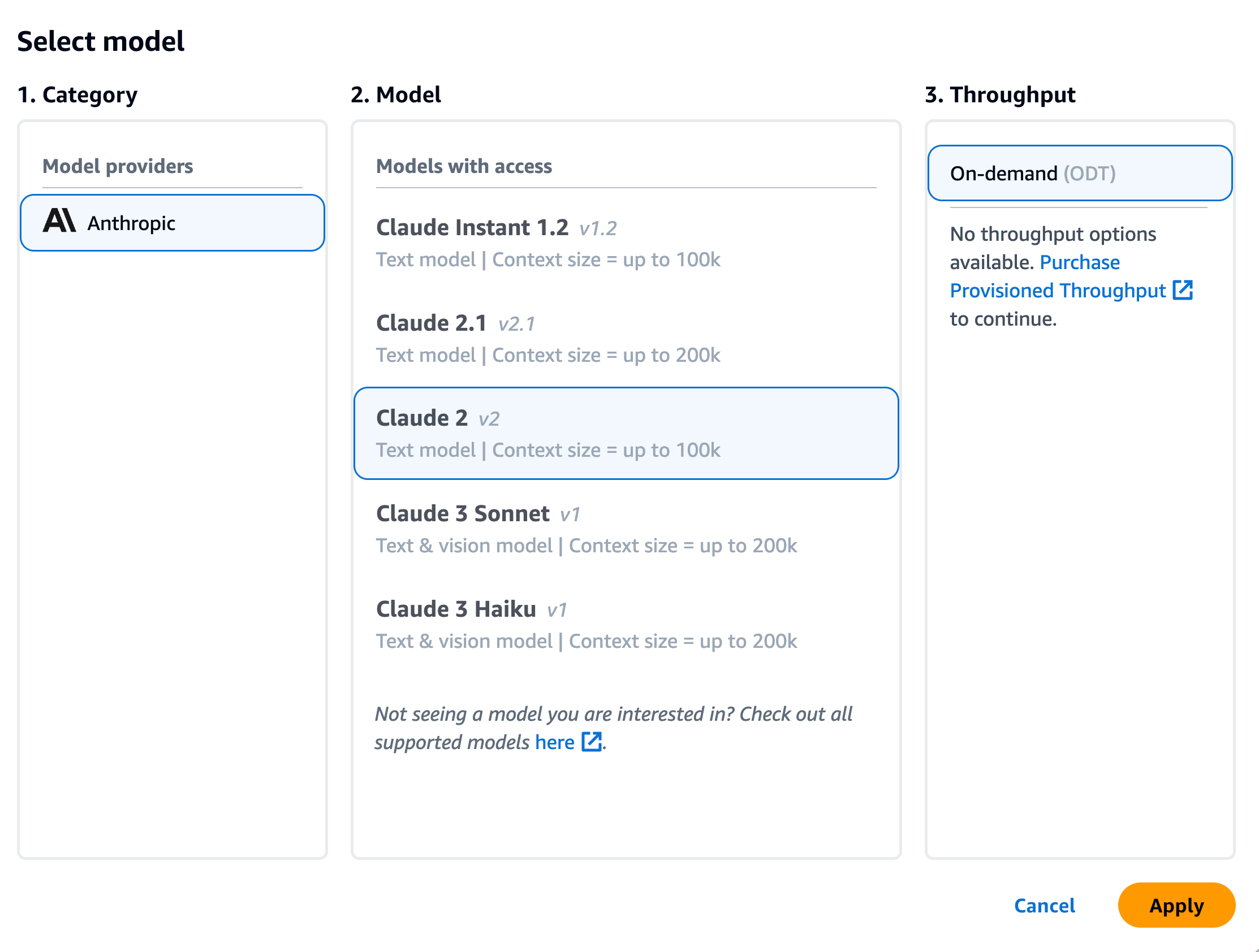

- Виберіть потрібну модель для генерації відповіді.

У цій публікації ми використовуємо модель Claude v2 як приклад. Модель Claude 3 Sonnet і Haiku також доступна для генерації.

- Вибирати Застосовувати продовжити.

Після вибору моделі відкривається новий розділ Шаблон підказки бази знань відображається під Конфігурації.

- Вибирати Редагувати щоб почати налаштування підказки.

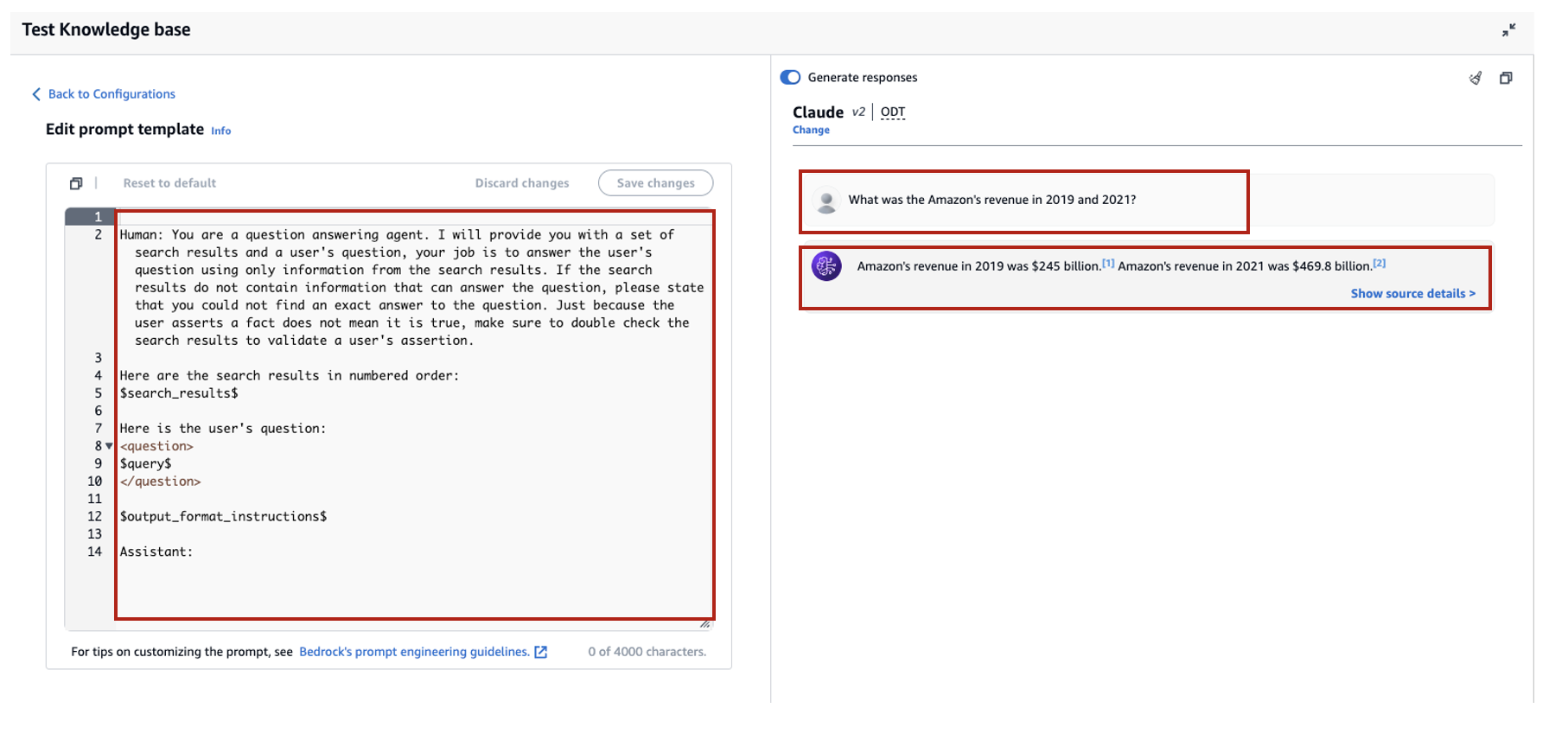

- Налаштуйте шаблон підказки, щоб налаштувати спосіб використання отриманих результатів і створення вмісту.

У цьому дописі ми навели кілька прикладів створення «системи штучного інтелекту фінансового консультанта» за допомогою фінансових звітів Amazon із спеціальними підказками. Найкращі методи швидкого проектування див Оперативні інженерні вказівки.

Тепер ми налаштовуємо шаблон запиту за замовчуванням кількома різними способами та спостерігаємо за відповідями.

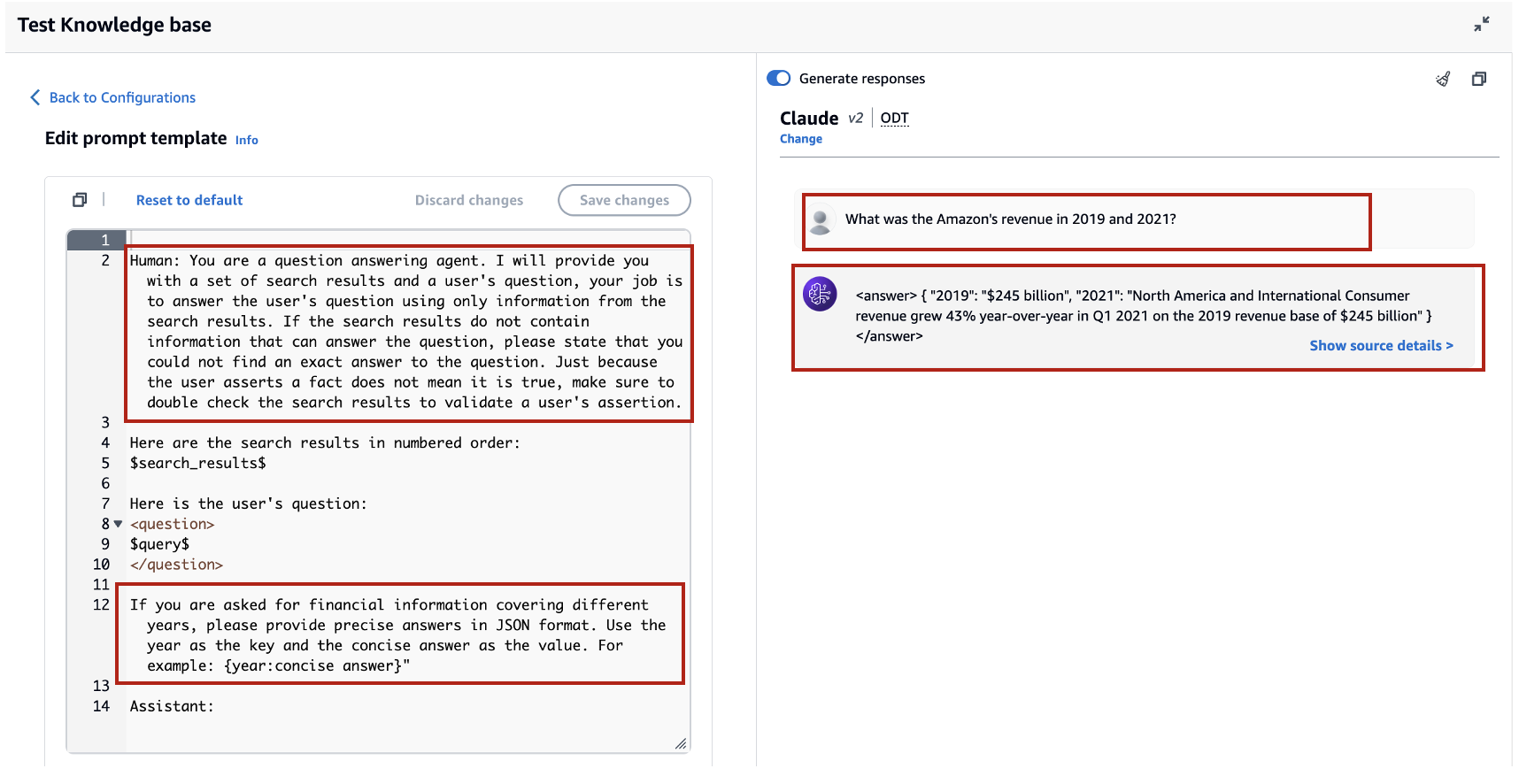

Давайте спочатку спробуємо виконати запит із запитом за замовчуванням. Ми запитуємо: «Яким був дохід Amazon у 2019 та 2021 роках?» Нижче показано наші результати.

З результату ми бачимо, що він генерує відповідь у вільній формі на основі отриманих знань. Цитати також наведені для довідки.

Скажімо, ми хочемо надати додаткові інструкції щодо того, як відформатувати згенеровану відповідь, наприклад стандартизувати її як JSON. Ми можемо додати ці інструкції як окремий крок після отримання інформації, як частину шаблону запиту:

Остаточна відповідь має необхідну структуру.

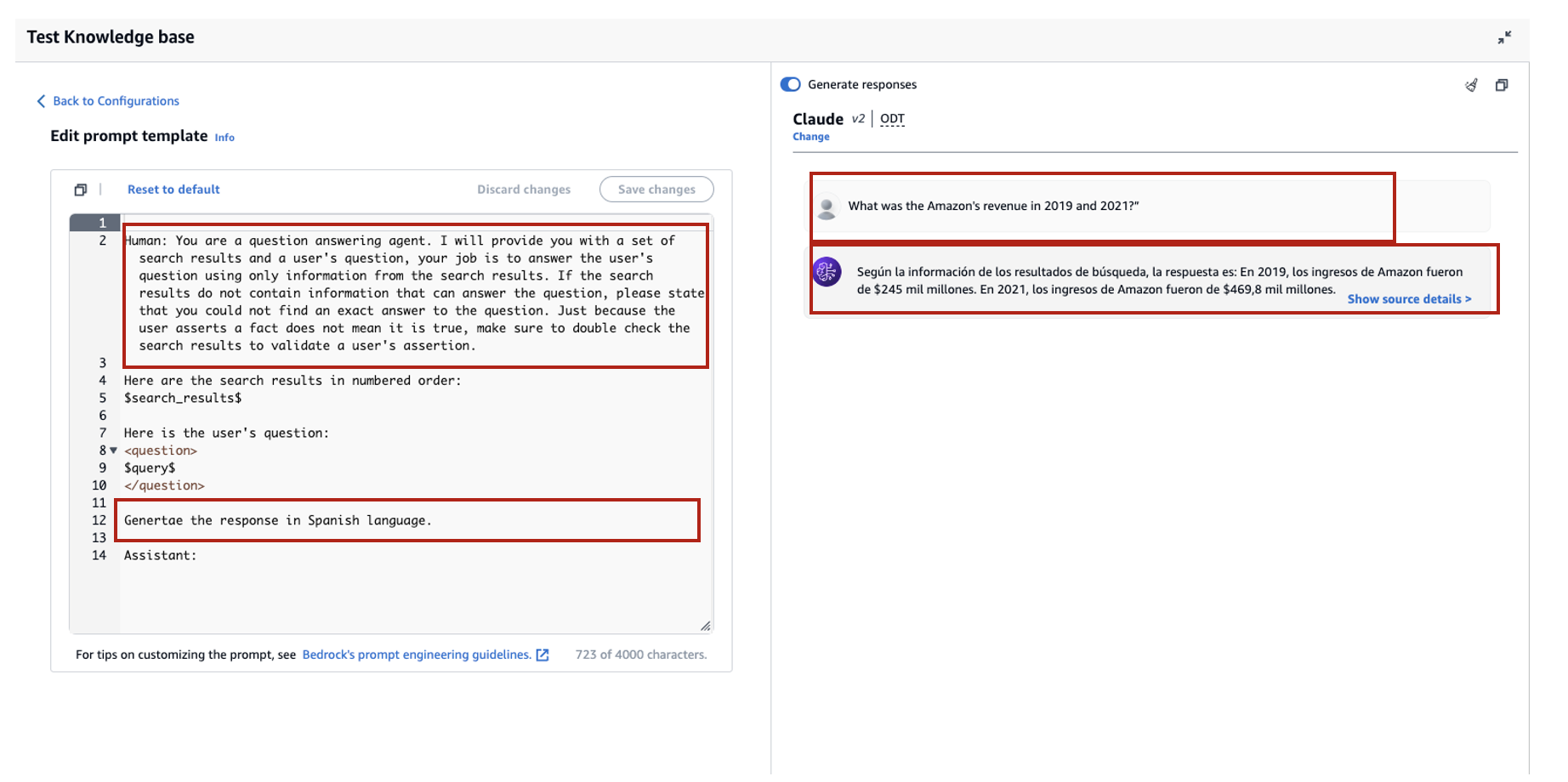

Налаштувавши підказку, ви також можете змінити мову згенерованої відповіді. У наступному прикладі ми наказуємо моделі надати відповідь іспанською мовою.

Після видалення $output_format_instructions$ із запиту за замовчуванням цитата зі згенерованої відповіді видаляється.

У наступних розділах ми пояснюємо, як можна використовувати ці функції з SDK.

Налаштуйте максимальну кількість результатів за допомогою SDK

Щоб змінити максимальну кількість результатів за допомогою SDK, використовуйте такий синтаксис. Для цього прикладу запит виглядає так: «У якому році річний дохід Amazon збільшився з 245 мільярдів доларів США до 434 мільярдів доларів США?» Правильна відповідь: «Річний дохід Amazon збільшився з 245 мільярдів доларів у 2019 році до 434 мільярдів доларів у 2022 році».

"numberOfResults"опція під"retrievalConfiguration' дозволяє вибрати кількість результатів, які ви хочете отримати. Вихід RetrieveAndGenerate API містить згенеровану відповідь, посилання на джерело та фрагменти отриманого тексту.

Нижче наведено результати для різних значень 'numberOfResults' параметри. Спочатку встановлюємо numberOfResults = 5.

Потім ставимо numberOfResults = 12.

Налаштуйте шаблон підказки бази знань за допомогою SDK

Щоб налаштувати підказку за допомогою SDK, ми використовуємо наступний запит із різними шаблонами підказок. Для цього прикладу запит: «Яким був дохід Amazon у 2019 та 2021 роках?»

Нижче наведено стандартний шаблон запиту:

Нижче наведено налаштований шаблон підказки:

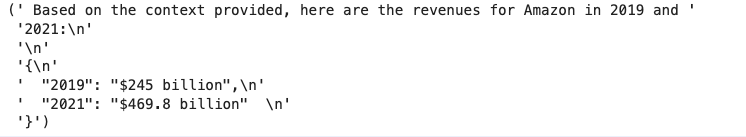

Зі стандартним шаблоном підказки ми отримуємо таку відповідь:

![]()

Якщо ви хочете надати додаткові інструкції щодо вихідного формату генерації відповіді, як-от стандартизація відповіді в певному форматі (наприклад, JSON), ви можете налаштувати наявний запит, надавши додаткові вказівки. За допомогою нашого спеціального шаблону запиту ми отримуємо таку відповідь.

"promptTemplate"опція в"generationConfiguration' дозволяє налаштувати підказку для кращого контролю над створенням відповіді.

Висновок

У цій публікації ми представили дві нові функції в базах знань для Amazon Bedrock: налаштування максимальної кількості результатів пошуку та налаштування шаблону запиту за замовчуванням для RetrieveAndGenerate API. Ми продемонстрували, як налаштувати ці функції на консолі та за допомогою SDK, щоб підвищити продуктивність і точність згенерованої відповіді. Збільшення максимальних результатів надає більш повну інформацію, тоді як налаштування шаблону підказки дозволяє точніше налаштувати інструкції для базової моделі для кращого узгодження з конкретними випадками використання. Ці удосконалення пропонують більшу гнучкість і контроль, дозволяючи надавати персоналізований досвід для додатків на основі RAG.

Додаткові ресурси для впровадження у вашому середовищі AWS див.

Про авторів

Сандіп Сінгх є старшим науковцем з генеративного штучного інтелекту в Amazon Web Services, який допомагає компаніям впроваджувати інновації за допомогою генеративного штучного інтелекту. Він спеціалізується на генеративному штучному інтелекті, штучному інтелекті, машинному навчанні та системному дизайні. Він захоплений розробкою найсучасніших рішень на основі ШІ/ML для вирішення складних бізнес-завдань для різних галузей, оптимізуючи ефективність і масштабованість.

Сандіп Сінгх є старшим науковцем з генеративного штучного інтелекту в Amazon Web Services, який допомагає компаніям впроваджувати інновації за допомогою генеративного штучного інтелекту. Він спеціалізується на генеративному штучному інтелекті, штучному інтелекті, машинному навчанні та системному дизайні. Він захоплений розробкою найсучасніших рішень на основі ШІ/ML для вирішення складних бізнес-завдань для різних галузей, оптимізуючи ефективність і масштабованість.

Суінь Ван є архітектором спеціалістів із штучного інтелекту та ML в AWS. Вона має міждисциплінарну освіту в галузі машинного навчання, фінансових інформаційних служб та економіки, а також багаторічний досвід створення програм Data Science і Machine Learning, які вирішували реальні бізнес-проблеми. Їй подобається допомагати клієнтам визначати правильні бізнес-питання та створювати правильні рішення AI/ML. У вільний час вона любить співати та готувати.

Суінь Ван є архітектором спеціалістів із штучного інтелекту та ML в AWS. Вона має міждисциплінарну освіту в галузі машинного навчання, фінансових інформаційних служб та економіки, а також багаторічний досвід створення програм Data Science і Machine Learning, які вирішували реальні бізнес-проблеми. Їй подобається допомагати клієнтам визначати правильні бізнес-питання та створювати правильні рішення AI/ML. У вільний час вона любить співати та готувати.

Шеррі Дін є старшим архітектором рішень у сфері штучного інтелекту (AI) і машинного навчання (ML) в Amazon Web Services (AWS). Вона має великий досвід машинного навчання зі ступенем доктора філософії з інформатики. В основному вона працює з клієнтами державного сектору над різними бізнес-завданнями, пов’язаними зі штучним інтелектом/ML, допомагаючи їм прискорити процес машинного навчання в AWS Cloud. Коли вона не допомагає клієнтам, вона любить активний відпочинок.

Шеррі Дін є старшим архітектором рішень у сфері штучного інтелекту (AI) і машинного навчання (ML) в Amazon Web Services (AWS). Вона має великий досвід машинного навчання зі ступенем доктора філософії з інформатики. В основному вона працює з клієнтами державного сектору над різними бізнес-завданнями, пов’язаними зі штучним інтелектом/ML, допомагаючи їм прискорити процес машинного навчання в AWS Cloud. Коли вона не допомагає клієнтам, вона любить активний відпочинок.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/knowledge-bases-for-amazon-bedrock-now-supports-custom-prompts-for-the-retrieveandgenerate-api-and-configuration-of-the-maximum-number-of-retrieved-results/

- : має

- :є

- : ні

- :де

- $UP

- 10

- 100

- 10K

- 12

- 13

- 15%

- 2019

- 2021

- 2022

- 25

- 28

- 32

- 7

- 900

- a

- Здатний

- МЕНЮ

- прискорювати

- доступ

- точність

- точний

- діяльності

- додавати

- Додатковий

- Додатково

- коригування

- радник

- після

- Агент

- AI

- Дані ШІ

- AI / ML

- вирівнювати

- дозволяє

- по

- пліч-о-пліч

- Також

- am

- Amazon

- Amazon Web Services

- Веб-служби Amazon (AWS)

- кількість

- an

- та

- щорічний

- РІЧНИЙ ДОХІД

- Інший

- відповідь

- відповідь

- Відповіді

- API

- з'являється

- застосування

- ЕСТЬ

- навколо

- штучний

- штучний інтелект

- Штучний інтелект (AI)

- AS

- запитати

- допомогу

- Помічник

- At

- збільшено

- доступний

- AWS

- фон

- база

- заснований

- BE

- оскільки

- перед тим

- поведінка

- буття

- Переваги

- КРАЩЕ

- передового досвіду

- Краще

- Створюємо

- бізнес

- підприємства

- by

- званий

- CAN

- випадок

- випадків

- проблеми

- зміна

- перевірка

- вибір

- Вибирати

- хмара

- комбінати

- компанія

- порівняння

- повний

- комплекс

- всеосяжний

- комп'ютер

- Інформатика

- лаконічний

- конфігурація

- конфігурування

- З'єднуватися

- Консоль

- містити

- зміст

- контекст

- контекстуальний

- контроль

- виправити

- може

- покриття

- створювати

- створений

- створення

- виготовлений на замовлення

- Клієнти

- налаштувати

- налаштувати

- дані

- наука про дані

- вчений даних

- дефолт

- Ступінь

- доставляти

- демонструвати

- продемонстрований

- дизайн

- розвивається

- DID

- різний

- обговорювати

- Різне

- do

- документ

- документація

- робить

- домен

- подвійний

- Економіка

- Освіта

- ефективність

- або

- дозволяє

- Машинобудування

- Удосконалення

- Навколишнє середовище

- точний

- приклад

- Приклади

- існуючий

- досвід

- Досліди

- Пояснювати

- обширний

- Великий досвід

- додатково

- факт

- особливість

- риси

- кілька

- остаточний

- фінансовий

- фінансова інформація

- знайти

- Перший

- Гнучкість

- стежити

- після

- для

- формат

- фонд

- від

- дав

- породжувати

- генерується

- породжує

- покоління

- генеративний

- Генеративний ШІ

- отримати

- Давати

- дає

- дає

- великий

- керівництво

- Мати

- he

- охорона здоров'я

- допомогу

- допомагає

- її

- тут

- Як

- How To

- HTML

- HTTP

- HTTPS

- людина

- гібрид

- i

- ICON

- ідентифікувати

- if

- реалізації

- удосконалювати

- поліпшення

- in

- includes

- Augmenter

- збільшений

- зростаючий

- промисловості

- промисловість

- інформація

- оновлювати

- вхід

- інструкції

- Інтелект

- введені

- IT

- робота

- подорож

- JPEG

- json

- просто

- ключ

- знання

- мова

- УЧИТЬСЯ

- вивчення

- залишити

- легальний

- менше

- як

- ймовірність

- список

- Перераховані

- любить

- машина

- навчання за допомогою машини

- головним чином

- зробити

- управління

- матч

- максимальний

- значити

- ML

- модель

- Моделі

- більше

- множинний

- навігація

- Необхідність

- Нові

- Нові можливості

- зараз

- номер

- пронумерований

- спостерігати

- of

- пропонувати

- on

- ONE

- тільки

- оптимізуючий

- варіант

- Опції

- or

- порядок

- наші

- вихід

- над

- власний

- pane

- параметри

- частина

- Пройшов

- пристрасний

- продуктивність

- Вчений ступінь

- plato

- Інформація про дані Платона

- PlatoData

- будь ласка

- пошта

- практики

- необхідність

- попередній

- проблеми

- продовжити

- підказок

- забезпечувати

- за умови

- Постачальник

- забезпечує

- забезпечення

- громадськість

- запит

- питання

- питань

- ганчіркою

- RE

- Реальний світ

- зниження

- послатися

- посилання

- пов'язаний

- доречний

- Вилучено

- видалення

- замінювати

- Звіти

- запросити

- вимагається

- ресурси

- відповідь

- відповіді

- результати

- пошук

- повертати

- revenue

- право

- s

- то ж

- say

- масштабованість

- наука

- вчений

- Sdk

- Пошук

- розділ

- розділам

- сектор

- безпечно

- побачити

- вибрати

- смисловий

- старший

- посланий

- окремий

- обслуговування

- Послуги

- комплект

- кілька

- вона

- Показувати

- показаний

- Шоу

- простий

- So

- Рішення

- ВИРІШИТИ

- Source

- іспанська

- спеціаліст

- спеціалізується

- конкретний

- стандартизації

- старт

- стан

- впроваджений

- Крок

- заходи

- зберігати

- структура

- такі

- Підтриманий

- Опори

- Переконайтеся

- синтаксис

- система

- з урахуванням

- шаблон

- Шаблони

- термінологія

- Тестування

- текст

- Що

- Команда

- інформація

- Джерело

- їх

- Їх

- тим самим

- Ці

- це

- час

- до

- TONE

- правда

- намагатися

- два

- тип

- не в змозі

- при

- використання

- використання випадку

- використовуваний

- користувач

- використання

- ПЕРЕВІР

- значення

- Цінності

- різний

- дуже

- через

- хотіти

- було

- способи

- we

- Web

- веб-сервіси

- Що

- коли

- в той час як

- волі

- з

- без

- Робочі процеси

- працює

- рік

- років

- Ти

- вашу

- зефірнет