Штучний інтелект (AI) нещодавно викликав фурор завдяки своїй можливості революціонізувати підходи людей до вирішення різних завдань і складних проблем. Від охорони здоров’я до фінансів, штучний інтелект і пов’язані з ним моделі машинного навчання продемонстрували свій потенціал для оптимізації складних процесів, вдосконалення моделей прийняття рішень і відкриття цінних ідей.

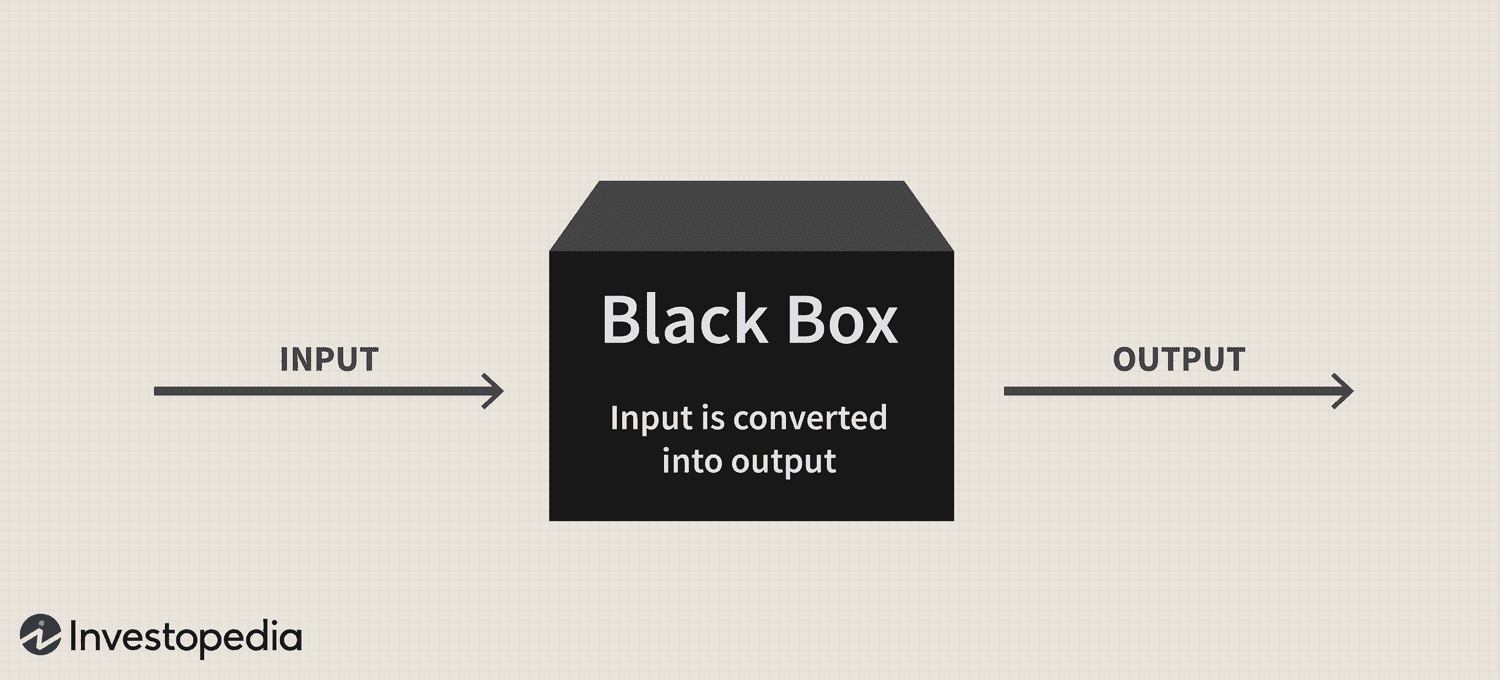

Однак, незважаючи на величезний потенціал технології, проблема «чорної скриньки», яка залишається, і надалі представляє серйозну проблему для її впровадження, викликаючи питання про прозорість та можливість інтерпретації цих складних систем.

Коротше кажучи, проблема чорної скриньки виникає через складність розуміння того, як системи ШІ та моделі машинного навчання обробляють дані та генерують прогнози чи рішення. Ці моделі часто покладаються на складні алгоритми, які нелегко зрозуміти людям, що призводить до відсутності відповідальності та довіри.

Тому, оскільки ШІ все більше інтегрується в різні аспекти нашого життя, вирішення цієї проблеми має вирішальне значення для забезпечення відповідального та етичного використання цієї потужної технології.

Чорний ящик: огляд

Метафора «чорної скриньки» походить від уявлення про те, що системи штучного інтелекту та моделі машинного навчання працюють у спосіб, прихований від людського розуміння, подібно до вмісту запечатаної непрозорої коробки. Ці системи побудовані на складних математичних моделях і масивних наборах даних, які створюють складні зв’язки та закономірності, які керують процесами прийняття рішень. Однак ця внутрішня робота не є легкодоступною або зрозумілою людям.

На практиці проблема чорної скриньки штучного інтелекту полягає в тому, що важко розшифрувати обґрунтування прогнозів або рішень системи штучного інтелекту. Ця проблема особливо поширена в моделях глибокого навчання, таких як нейронні мережі, де кілька рівнів взаємопов’язаних вузлів обробляють і перетворюють дані в ієрархічний спосіб. Складність цих моделей і нелінійні перетворення, які вони виконують, роблять надзвичайно складним пошук обґрунтування їхніх результатів.

Микита Бруднов, генеральний директор BR Group — інформаційної панелі маркетингової аналітики на основі штучного інтелекту — сказав Cointelegraph, що відсутність прозорості в тому, як моделі штучного інтелекту приймають певні рішення та прогнози, може бути проблематичною в багатьох контекстах, таких як медична діагностика, прийняття фінансових рішень і судові розгляди, що суттєво вплине на продовження впровадження ШІ.

Magazine: Джо Лубін: Правда про розкол засновників ETH і «Crypto Google»

«Останніми роками велика увага приділяється розробці методів інтерпретації та пояснення рішень, прийнятих моделями штучного інтелекту, таких як генерація балів важливості функцій, візуалізація меж рішень та виявлення гіпотетичних пояснень», — сказав він, додавши:

«Однак ці методи все ще знаходяться в зародковому стані, і немає гарантії, що вони будуть ефективними у всіх випадках».

Крім того, Бруднов вважає, що з подальшою децентралізацією регулятори можуть вимагати, щоб рішення, які приймаються системами штучного інтелекту, були більш прозорими та підзвітними, щоб забезпечити їх етичну обґрунтованість і загальну справедливість. Він також припустив, що споживачі можуть вагатися використовувати продукти та послуги на основі ШІ, якщо вони не розуміють, як вони працюють і процес прийняття рішень.

Джеймс Во, засновник DFG — інвестиційної компанії, яка активно інвестує в технології, пов’язані зі штучним інтелектом — вважає, що проблема чорної скриньки не вплине на впровадження в осяжному майбутньому. За Во, більшість користувачів не обов’язково хвилює, як працюють існуючі моделі штучного інтелекту, і вони раді просто отримати від них корисність, принаймні на даний момент.

«У середньостроковій перспективі, коли новизна цих платформ зникне, однозначно з’явиться більше скепсису щодо методології чорної скриньки. Питань також збільшуватиметься, коли використання штучного інтелекту поширюється на криптовалюти та Web3, де є фінансові ставки та наслідки, які слід враховувати», — визнав він.

Вплив на довіру та прозорість

Одним із сфер, де відсутність прозорості може суттєво вплинути на довіру, є медична діагностика, керована ШІ. Наприклад, моделі ШІ можуть аналізувати складні медичні дані в охороні здоров’я, щоб генерувати діагнози або рекомендації щодо лікування. Однак, коли клініцисти та пацієнти не можуть зрозуміти обґрунтування цих пропозицій, вони можуть поставити під сумнів надійність і обґрунтованість цих висновків. Цей скептицизм може ще більше призвести до вагань у прийнятті рішень штучного інтелекту, потенційно перешкоджаючи прогресу в догляді за пацієнтами та персоналізованій медицині.

У фінансовій сфері системи штучного інтелекту можна використовувати для кредитного рейтингу, виявлення шахрайства та оцінки ризиків. Однак проблема «чорної скриньки» може створити невизначеність щодо чесності та точності цих кредитних балів або аргументації сповіщень про шахрайство, обмежуючи здатність технології оцифрувати галузь.

Криптоіндустрія також стикається з наслідками проблеми чорної скриньки. Наприклад, цифрові активи та технологія блокчейн ґрунтуються на децентралізації, відкритості та можливості перевірки. Системи штучного інтелекту, яким бракує прозорості та інтерпретації, створюють розрив між очікуваннями користувачів і реальністю рішень, керованих штучним інтелектом, у цьому просторі.

Проблеми регулювання

З нормативної точки зору проблема чорної скриньки ШІ представляє унікальні виклики. По-перше, через непрозорість процесів штучного інтелекту регуляторам стає все важче оцінювати відповідність цих систем існуючим правилам і рекомендаціям. Крім того, відсутність прозорості може ускладнити здатність регуляторів розробляти нові рамки, які можуть усунути ризики та проблеми, пов’язані з додатками ШІ.

Законодавцям може бути важко оцінити справедливість систем штучного інтелекту, упередженість і методи захисту конфіденційності даних, а також їхній потенційний вплив на права споживачів і стабільність ринку. Крім того, без чіткого розуміння процесів прийняття рішень у системах, керованих штучним інтелектом, регулюючі органи можуть зіткнутися з труднощами у виявленні потенційних вразливостей і забезпеченні відповідних заходів безпеки для зменшення ризиків.

Однією з помітних регуляторних подій щодо цієї технології став Закон Європейського Союзу про штучний інтелект, яка наближається щоб стати частиною статуту блоку після досягнення попередньої політичної угоди 27 квітня.

За своєю суттю Закон про штучний інтелект спрямований на створення надійного та відповідального середовища для розвитку ШІ в ЄС. Законодавці прийняли систему класифікації, яка класифікує різні типи ШІ за ризиком: неприйнятний, високий, обмежений і мінімальний. Ця структура розроблена для вирішення різноманітних проблем, пов’язаних із проблемою чорної скриньки штучного інтелекту, включаючи питання прозорості та підзвітності.

Нездатність ефективно контролювати та регулювати системи штучного інтелекту вже призвела до напружених стосунків між різними галузями та регуляторними органами.

На початку минулого місяця популярний чат-бот AI ChatGPT був заборонено в Італії на 29 днів, насамперед через занепокоєння щодо конфіденційності, висунуте агентством із захисту даних країни щодо ймовірних порушень Загальних правил захисту даних ЄС (GDPR). Однак платформі дозволили відновити роботу 29 квітня після того, як генеральний директор Сем Альтман оголосив, що він і його команда вжили конкретних заходів для виконання вимог регулятора, включаючи розкриття методів обробки даних і впровадження вікових обмежень. стробові заходи.

Неадекватне регулювання систем штучного інтелекту може підірвати довіру громадськості до програм штучного інтелекту, оскільки користувачі дедалі більше стурбовані властивими упередженнями, неточностями та етичними наслідками.

Вирішення проблеми чорної скриньки

Для ефективного вирішення проблеми «чорної скриньки» штучного інтелекту необхідно використовувати комбінацію підходів, які сприяють прозорості, інтерпретації та підзвітності. Дві такі взаємодоповнюючі стратегії — це пояснюваний ШІ (XAI) і моделі з відкритим кодом.

XAI — це область досліджень, спрямована на подолання розриву між складністю систем ШІ та потребою в інтерпретації людиною. XAI зосереджується на розробці методів і алгоритмів, які можуть надати зрозумілі людині пояснення рішень, керованих штучним інтелектом, пропонуючи розуміння міркувань, що стоять за цим вибором.

Методи, які часто застосовуються в XAI, включають сурогатні моделі, аналіз важливості ознак, аналіз чутливості та локальні інтерпретовані модельно-агностичні пояснення. Впровадження XAI у різних галузях може допомогти зацікавленим сторонам краще зрозуміти процеси, керовані штучним інтелектом, підвищуючи довіру до технології та сприяючи дотриманню нормативних вимог.

У тандемі з XAI сприяння прийняттю моделей штучного інтелекту з відкритим кодом може бути ефективною стратегією вирішення проблеми чорної скриньки. Моделі з відкритим вихідним кодом надають повний доступ до алгоритмів і даних, які керують системами штучного інтелекту, дозволяючи користувачам і розробникам уважно вивчати та розуміти основні процеси.

Така підвищена прозорість може допомогти зміцнити довіру та сприяти співпраці між розробниками, дослідниками та користувачами. Крім того, підхід з відкритим вихідним кодом може створити більш надійні, підзвітні та ефективні системи ШІ.

Проблема чорної скриньки в криптопросторі

Проблема чорної скриньки має значні наслідки для різних аспектів криптопростору, включаючи торгові стратегії, прогнози ринку, заходи безпеки, токенізацію та смарт-контракти.

У сфері торгових стратегій і ринкових прогнозів моделі, керовані ШІ, набувають популярності, оскільки інвестори прагнуть заробити на алгоритмічній торгівлі. Однак проблема чорного ящика заважає користувачам зрозуміти, як ці моделі функціонують, що ускладнює оцінку їх ефективності та потенційних ризиків. Отже, ця непрозорість також може призвести до невиправданої довіри до інвестиційних рішень, керованих ШІ, або змусити інвесторів надмірно покладатися на автоматизовані системи.

ШІ відіграє вирішальну роль у посиленні заходів безпеки в екосистемі блокчейну шляхом виявлення шахрайських транзакцій і підозрілих дій. Тим не менш, проблема чорної скриньки ускладнює процес перевірки для цих керованих ШІ рішень безпеки. Відсутність прозорості в прийнятті рішень може підірвати довіру до систем безпеки, викликаючи занепокоєння щодо їх здатності захищати активи та інформацію користувачів.

Останні: Консенсус 2023: Компанії виявляють інтерес до Web3, незважаючи на регулятивні проблеми США

Токенізація та смарт-контракти — два життєво важливі компоненти екосистеми блокчейну — також свідчать про посилення інтеграції ШІ. Однак проблема чорної скриньки може приховати логіку токенів, згенерованих ШІ, або виконання смарт-контракту.

Оскільки ШІ революціонізує різні галузі, вирішення проблеми чорної скриньки стає все більш актуальним. Сприяючи співпраці між дослідниками, розробниками, політиками та зацікавленими сторонами галузі, можна розробити рішення для сприяння прозорості, підзвітності та довірі до систем ШІ. Таким чином, буде цікаво спостерігати, як ця нова технологічна парадигма продовжує розвиватися.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoAiStream. Web3 Data Intelligence. Розширення знань. Доступ тут.

- Карбування майбутнього з Адріенн Ешлі. Доступ тут.

- Купуйте та продавайте акції компаній, які вийшли на IPO, за допомогою PREIPO®. Доступ тут.

- джерело: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- : має

- :є

- : ні

- :де

- 2023

- 27

- a

- здатність

- МЕНЮ

- доступ

- доступною

- підзвітність

- підзвітний

- точність

- через

- Діяти

- активно

- діяльності

- додати

- Додатково

- адреса

- адресація

- прийнята

- Прийняття

- Прийняття

- досягнення

- впливати

- після

- агентство

- Угода

- AI

- Закон про ШІ

- AI чат

- Можливість

- Цілі

- Alerts

- алгоритмічний

- алгоритмічна торгівля

- алгоритми

- ВСІ

- вже

- Також

- серед

- an

- аналіз

- аналітика

- аналізувати

- та

- оголошений

- застосування

- підхід

- підходи

- відповідний

- квітня

- ЕСТЬ

- ПЛОЩА

- навколо

- штучний

- штучний інтелект

- AS

- аспекти

- оцінка

- Активи

- асоційований

- At

- увагу

- Автоматизований

- BE

- ставати

- стає

- становлення

- було

- за

- вважає,

- Краще

- між

- зміщення

- упередження

- Black

- blockchain

- екосистема блокчейну

- Технологія блокчейна

- органів

- книга

- Межі

- Box

- мостинг

- будувати

- побудувати довіру

- побудований

- підприємства

- by

- CAN

- не може

- капіталізувати

- який

- випадків

- Генеральний директор

- певний

- виклик

- проблеми

- складні

- Chatbot

- ChatGPT

- вибір

- класифікація

- система класифікації

- ясно

- клініцисти

- Монеттелеграф

- співробітництво

- поєднання

- взаємодоповнюючі

- комплекс

- складність

- дотримання

- Компоненти

- осягнути

- стурбований

- Турбота

- Наслідки

- Отже

- Вважати

- споживач

- Права споживачів

- Споживачі

- зміст

- контексти

- триває

- триває

- контракт

- контрактів

- Core

- може

- країни

- створювати

- створений

- кредит

- вирішальне значення

- крипто

- Криптовалюта

- крипто простір

- приладова панель

- дані

- конфіденційність даних

- обробка даних

- захист даних

- набори даних

- децентралізація

- рішення

- Прийняття рішень

- рішення

- присвячених

- глибокий

- глибоке навчання

- безумовно

- запити

- продемонстрований

- призначений

- Незважаючи на

- Виявлення

- розвивати

- розвиненою

- розробників

- розвивається

- розробка

- різний

- важкий

- утруднення

- трудність

- цифровий

- Цифрові активи

- оцифрувати

- do

- домен

- Не знаю

- управляти

- два

- легко

- екосистема

- Ефективний

- фактично

- ефективність

- працевлаштований

- дозволяє

- підвищувати

- підвищення

- забезпечувати

- забезпечення

- Входить

- Навколишнє середовище

- істотний

- ETH

- етичний

- EU

- Європейська

- оцінювати

- еволюціонувати

- приклад

- виконання

- існуючий

- очікування

- пояснюючи

- Face

- особи

- сприяння

- справедливість

- особливість

- фінансування

- фінансовий

- Фірма

- фокусується

- для

- передбачуваний

- форма

- Сприяти

- виховання

- засновник

- засновники

- Рамки

- каркаси

- шахрайство

- виявлення шахрайства

- шахрайський

- від

- Повний

- функція

- далі

- Крім того

- майбутнє

- набирає

- розрив

- GDPR

- Загальне

- загальні дані

- породжувати

- породжує

- надавати

- Group

- гарантувати

- керівництво

- керівні вказівки

- було

- щасливий

- Мати

- he

- охорона здоров'я

- допомога

- Високий

- заважає

- його

- Як

- Однак

- HTTPS

- людина

- Людей

- ідентифікує

- if

- величезний

- Impact

- впливає

- реалізація

- реалізації

- наслідки

- значення

- in

- нездатність

- включати

- У тому числі

- Augmenter

- збільшений

- все більше і більше

- промисловості

- промисловість

- інформація

- притаманне

- розуміння

- інтегрований

- інтеграція

- Інтелект

- взаємопов'язані

- інтерес

- цікавий

- в

- інвестиції

- Інвестори

- Інвестує

- питання

- питання

- IT

- Італія

- ЙОГО

- відсутність

- останній

- законодавці

- шарів

- вести

- провідний

- вивчення

- найменш

- легальний

- судочинство

- як

- обмеженою

- Місце проживання

- місцевий

- логіка

- машина

- навчання за допомогою машини

- made

- зробити

- Робить

- манера

- багато

- ринок

- ринкові прогнози

- Маркетинг

- математичний

- Може..

- заходи

- медичний

- медичні дані

- медицина

- Методологія

- може бути

- мінімальний

- Пом'якшити

- Моделі

- монітор

- місяць

- більше

- Більше того

- найбільш

- переміщення

- багато

- множинний

- обов'язково

- Необхідність

- мереж

- нейронні мережі

- проте

- Нові

- немає

- вузли

- Помітний

- поняття

- роман

- новинка

- зараз

- of

- від

- пропонує

- часто

- on

- один раз

- непрозорий

- з відкритим вихідним кодом

- Відкритість

- працювати

- or

- наші

- загальний

- оплачувану

- парадигма

- частина

- особливо

- пацієнт

- pacientes

- моделі

- Люди

- Виконувати

- Персоналізовані

- місце

- платформа

- Платформи

- plato

- Інформація про дані Платона

- PlatoData

- Play

- політиків

- політичний

- популярний

- популярність

- можливість

- потенціал

- потенційно

- потужний

- Практичний

- практики

- Прогнози

- представити

- подарунки

- поширений

- в першу чергу

- недоторканність приватного життя

- Проблема

- проблеми

- Праці

- процес

- процеси

- обробка

- Продукти

- сприяти

- сприяння

- захист

- забезпечувати

- попередній

- громадськість

- суспільну довіру

- питання

- питань

- піднятий

- залучення

- обгрунтування

- досягнення

- Реальність

- царство

- останній

- нещодавно

- рекомендації

- про

- Регулювати

- Регулювання

- правила

- Регулятори

- регуляторні

- пов'язаний

- Відносини

- надійність

- покладатися

- наслідки

- вимагати

- Вимога

- дослідження

- Дослідники

- відповідальний

- результат

- резюме

- здійснити революцію

- революціонізує

- праві

- Risk

- оцінка ризику

- ризики

- міцний

- Роль

- Правила

- гарантії

- Зазначений

- Сем

- Сем Альтман

- рахунок

- безпеку

- Заходи безпеки

- побачити

- Шукати

- Чутливість

- Послуги

- набори

- Показувати

- значний

- істотно

- просто

- Скептицизм

- розумний

- розумний контракт

- Спритні контракти

- Рішення

- ВИРІШИТИ

- складний

- Source

- Простір

- конкретний

- розкол

- Стабільність

- зацікавлених сторін

- стояти

- стенди

- стебла

- заходи

- Як і раніше

- стратегії

- Стратегія

- раціоналізувати

- боротьба

- такі

- підозрілі

- система

- Systems

- Тандем

- завдання

- команда

- технології

- методи

- Технології

- Технологія

- terms

- Що

- Команда

- їх

- Їх

- Там.

- Ці

- вони

- це

- до

- Токенізація

- Жетони

- Трасування

- торгові площі

- торгові стратегії

- Transactions

- Перетворення

- перетворень

- прозорість

- прозорий

- лікування

- Довіряйте

- заслуговуючий довіри

- Правда

- два

- Типи

- Невизначеність

- розкрити

- що лежить в основі

- розуміти

- зрозуміло

- розуміння

- створеного

- на

- us

- використання

- користувач

- користувачі

- утиліта

- Цінний

- різний

- перевірка

- Порушення

- життєво важливий

- Уразливості

- було

- Web3

- коли

- який

- волі

- з

- в

- без

- спостереження

- wo

- Work

- виробки

- років

- зефірнет