Виявлення зміщень у даних і результатах моделей є фундаментальною вимогою для побудови відповідальних моделей штучного інтелекту (AI) і машинного навчання (ML). На жаль, виявлення упередженості є нелегким завданням для переважної більшості практиків через велику кількість способів її вимірювання та різні фактори, які можуть сприяти упередженому результату. Наприклад, незбалансована вибірка навчальних даних може призвести до того, що модель буде менш точною для певних підмножин даних. Зміщення також може бути внесено самим алгоритмом ML — навіть із добре збалансованим набором навчальних даних результати можуть сприяти певним підмножинам даних порівняно з іншими.

Щоб виявити упередження, ви повинні мати досконале розуміння різних типів упереджень і відповідних їм метрики зміщення. Наприклад, на момент написання цієї статті, Роз'яснити Amazon SageMaker пропонує 21 різний показник на вибір.

У цій публікації ми використовуємо варіант використання прогнозування доходу (прогнозування доходів користувачів на основі вхідних функцій, таких як освіта та кількість відпрацьованих годин на тиждень), щоб продемонструвати різні типи упереджень і відповідні показники в SageMaker Clarify. Ми також розробляємо структуру, яка допоможе вам вирішити, які показники важливі для вашої програми.

Знайомство з SageMaker Clarify

Моделі машинного навчання все частіше використовуються для прийняття рішень у різноманітних сферах, таких як фінансові послуги, охорона здоров’я, освіта та людські ресурси. У багатьох ситуаціях важливо зрозуміти, чому модель ML зробила певний прогноз, а також чи вплинуло на прогнози упередження.

SageMaker Clarify надає інструменти для обох цих потреб, але в цій публікації ми зосередимося лише на функції виявлення зміщення. Щоб дізнатися більше про пояснюваність, перегляньте Пояснення фактів про матч Бундесліги xGoals за допомогою Amazon SageMaker Clarify.

SageMaker Clarify є частиною Amazon SageMaker, який є повністю керованим сервісом для створення, навчання та розгортання моделей машинного навчання.

Приклади питань про упередженість

Щоб обґрунтувати обговорення, нижче наведено кілька прикладів запитань, які можуть мати розробники машинного навчання та їхні зацікавлені сторони щодо упередженості. Список складається з деяких загальних запитань, які можуть стосуватися кількох програм ML, а також запитань про конкретні програми, як-от пошук документів.

Ви можете запитати, враховуючи групи інтересів у тренувальних даних (наприклад, чоловіки проти жінок), які показники слід використовувати, щоб відповісти на такі запитання:

- Чи представлення групи в тренувальних даних відображає реальний світ?

- Чи цільові мітки в навчальних даних віддають перевагу одній групі над іншою, призначаючи їй більше позитивних міток?

- Чи має модель різну точність для різних груп?

- У моделі, метою якої є визначення кваліфікованих кандидатів для найму, чи має модель однакову точність для різних груп?

- У моделі, метою якої є отримання документів, релевантних вхідному запиту, чи модель отримує релевантні документи з різних груп у однаковій пропорції?

У решті цієї публікації ми розробляємо структуру для того, як розглядати відповіді на ці та інші запитання за допомогою показників, доступних у SageMaker Clarify.

Випадок використання та контекст

У цій публікації використовується існуючий приклад завдання SageMaker Clarify від Справедливість і зрозумілість із записником SageMaker Clarify і пояснює згенеровані значення метрики зміщення. Ноутбук працює на моделі XGBoost Набір даних UCI для дорослих (Дуа, Д. та Графф, К. (2019). Репозиторій машинного навчання UCI. Ірвайн, Каліфорнія: Каліфорнійський університет, Школа інформації та комп’ютерних наук).

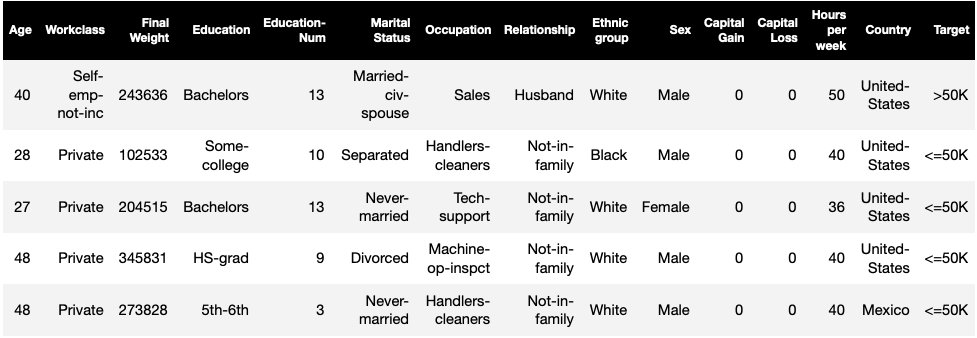

Завдання ML у цьому наборі даних полягає в тому, щоб передбачити, чи має людина річний дохід більше або менше 50,000 XNUMX доларів США. У наведеній нижче таблиці наведено деякі приклади разом із їхніми функціями. Вимірювання похибки у прогнозуванні доходу є важливим, оскільки ми можемо використовувати ці прогнози для прийняття інформативних рішень, таких як пропозиції знижок і цільовий маркетинг.

Упереджена термінологія

Перш ніж зануритися глибше, давайте розглянемо деякі основні терміни. Повний список термінів див Amazon SageMaker роз’яснює умови упередженості та справедливості.

- етикетка – Цільова функція, яку навчена прогнозувати модель ML. Ан спостерігається мітка відноситься до значення мітки, що спостерігається в даних, які використовуються для навчання або тестування моделі. А передбачена мітка це значення, передбачене моделлю ML. Мітки можуть бути двійковими та часто кодуються як 0 і 1. Ми припускаємо, що 1 означає сприятливу або позитивну мітку (наприклад, дохід більше або дорівнює 50,000 0 доларів США), а XNUMX представляє несприятливу або негативну мітку. Мітки також можуть складатися з більш ніж двох значень. Навіть у цих випадках одне або декілька значень є сприятливими мітками. Заради простоти в цьому дописі розглядаються лише двійкові мітки. Докладніше про обробку міток із більш ніж двома значеннями та міток із безперервними значеннями (наприклад, у регресії) див. Офіційний документ Amazon AI Fairness and Explainability.

- Фасета – Стовпець або ознака, щодо яких вимірюється зсув. У нашому прикладі грань є

sexі приймає два значення:womanтаman, закодований якfemaleтаmaleу даних (ці дані взято з перепису 1994 року та застосовують двійковий варіант). Незважаючи на те, що в публікації розглядається один фасет лише з двома значеннями, для більш складних випадків із кількома фасетами або фасетами з більш ніж двома значеннями див. Офіційний документ Amazon AI Fairness and Explainability. - Зсув – Значний дисбаланс у вхідних даних або прогнозах моделі за різними значеннями аспектів. Що вважається «значним», залежить від вашої заявки. Для більшості показників значення 0 означає відсутність дисбалансу. Показники зсуву в SageMaker Clarify поділяються на дві категорії:

- Попередня підготовка – За наявності зміщення перед навчанням вказує лише на дисбаланс даних.

- Посттренування – Упередження після навчання додатково враховує прогнози моделей.

Розглянемо кожну категорію окремо.

Передтренувальний ухил

Метрики зміщення перед навчанням у SageMaker Clarify відповідають на таке запитання: чи всі значення аспектів мають однакове (або подібне) представлення в даних? Важливо перевірити дані на предмет зміщення перед тренуванням, оскільки це може призвести до зміщення після тренування в прогнозах моделі. Наприклад, модель, навчена на незбалансованих даних, де значення одного аспекту з’являється дуже рідко, може продемонструвати значно гіршу точність для цього значення аспекту. Рівне представництво можна розрахувати за такими показниками:

- Усі навчальні дані, незалежно від міток

- Підмножина навчальних даних лише з позитивними мітками

- Кожна етикетка окремо

На наступному малюнку показано, як кожен показник відповідає кожній із трьох категорій.

Деякі категорії складаються з кількох показників. Основні показники (сірі прямокутники) відповідають на питання про упередженість у цій категорії в найпростішій формі. Показники в білих прямокутниках додатково охоплюють особливі випадки (наприклад, парадокс Сімпсона) і вподобання користувача (наприклад, зосередження на певних частинах сукупності під час обчислення прогнозної ефективності).

Представлення значення аспекту незалежно від міток

Єдиним показником у цій категорії є класовий дисбаланс (CI). Ціль цієї метрики — визначити, чи однаково представлені всі значення аспектів у даних.

CI — це різниця у частці даних, складених двома значеннями аспектів. У нашому прикладі набору даних для аспекту sex, розбивка (показана на круговій діаграмі) показує, що жінки становлять 32.4% тренувальних даних, тоді як чоловіки становлять 67.6%. Як результат:

CI = 0.676 - 0.324 = 0.352

Дуже високий дисбаланс класу може призвести до гіршої прогнозної ефективності для значення аспекту з меншим представленням.

Представлення значення аспекту лише на рівні позитивних міток

Інший спосіб вимірювання рівного представлення полягає в тому, щоб перевірити, чи всі значення фасетів містять подібну частку зразків з позитивними спостережуваними мітками. Позитивні мітки складаються зі сприятливих результатів (наприклад, надання позики, обрання для роботи), тому аналіз позитивних міток окремо допомагає оцінити, чи сприятливі рішення розподілені рівномірно.

У нашому прикладі набору даних спостережувані мітки розбиваються на позитивні та негативні значення, як показано на малюнку нижче.

11.4% усіх жінок і 31.4% усіх чоловіків мають позитивну позначку (темні заштриховані області в лівій і правій смугах). Різниця в позитивних пропорціях у етикетках (DPL) вимірює цю різницю.

DPL = 0.314 - 0.114 = 0.20

Розширений показник у цій категорії, умовна демографічна відмінність у мітках (CDDL), вимірює відмінності в позитивних мітках, але стратифікує їх відносно іншої змінної. Цей показник допомагає контролювати Парадокс Сімпсона, випадок, коли обчислення всіх даних показує зміщення, але зміщення зникає під час групування даних відносно деякої побічної інформації.

Команда 1973 Каліфорнійський університет Берклі Дослідження прийому наводить приклад. Згідно з даними, чоловіків приймали частіше, ніж жінок. Проте, під час обстеження на рівні окремих факультетів університету, жінки були прийняті з однаковою або вищою частотою на кожному факультеті. Це спостереження можна пояснити парадоксом Сімпсона, який виник тут через те, що жінки подавали документи до шкіл, які були більш конкурентоспроможними. У результаті загалом було прийнято менше жінок, ніж чоловіків, навіть незважаючи на те, що в школах їх приймали з однаковою або вищою частотою.

Докладніше про те, як обчислюється CDDL, див Офіційний документ Amazon AI Fairness and Explainability.

Представлення значення аспекту на рівні кожної мітки окремо

Рівність у представленні також можна виміряти для кожної окремої мітки, а не лише для позитивної мітки.

Показники в цій категорії обчислюють різницю в розподілі міток різних значень аспекту. Розподіл міток для значення аспекту містить усі спостережувані значення міток разом із часткою зразків із значенням цієї мітки. Наприклад, на малюнку, який показує розподіл ярликів, 88.6% жінок мають негативну мітку спостереження, а 11.4% мають позитивну мітку спостереження. Отже, розподіл міток для жінок становить [0.886, 0.114], а для чоловіків — [0.686, 0.314].

Основний показник у цій категорії, розбіжність Кульбака-Лейблера (KL), вимірює цю різницю як:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Розширені показники цієї категорії, розбіжність Дженсена-Шеннона (JS), Lp-норма (LP), загальна відстань варіації (TVD) і Колмогорова-Смирнова (KS), також вимірюють різницю між розподілами, але мають інші математичні властивості. За винятком особливих випадків, вони нададуть інформацію, подібну до KL. Наприклад, хоча значення KL може бути нескінченним, коли значення фасету не містить зразків із певними мітками (наприклад, немає людей із негативною міткою), JS уникає цих нескінченних значень. Докладніше про ці відмінності див Офіційний документ Amazon AI Fairness and Explainability.

Зв’язок між DPL (Категорія 2) і метриками на основі розподілу KL/JS/LP/TVD/KS (Категорія 3)

Метрики на основі розподілу більш природно застосовні до небінарних міток. Для двійкових міток завдяки тому факту, що дисбаланс у позитивній мітці можна використовувати для обчислення дисбалансу в негативній мітці, метрики розподілу дають таку саму інформацію, як DPL. Тому в таких випадках можна просто використовувати DPL.

Упередженість після тренування

Показники зміщення після навчання в SageMaker Clarify допомагають нам відповісти на два ключові запитання:

- Чи всі значення аспектів представлені з однаковою швидкістю в позитивних (сприятливих) прогнозах моделі?

- Чи має модель однакову прогностичну продуктивність для всіх значень фасетів?

На наступному малюнку показано, як показники зіставляються з кожним із цих запитань. Друге питання можна розбити далі залежно від того, щодо якого мітка вимірюється ефективність.

Рівне представництво в прогнозах позитивної моделі

Метрики в цій категорії перевіряють, чи всі значення фасетів містять подібну частку зразків із позитивною прогнозованою міткою моделлю. Цей клас метрик дуже схожий на метрики попереднього навчання DPL і CDDL — єдина відмінність полягає в тому, що ця категорія враховує прогнозовані мітки замість спостережуваних міток.

У нашому прикладі даних модель оцінює 4.5% усіх жінок, а 13.7% чоловіків.

Основний показник у цій категорії, різниця в позитивних пропорціях у прогнозованих мітках (DPPL), вимірює різницю в позитивних призначеннях класів.

DPPL = 0.137 - 0.045 = 0.092

Зверніть увагу на те, що в тренувальних даних більша частка чоловіків мала позитивну спостережувану позначку. Подібним чином більшій частині чоловіків присвоюється позитивна прогнозована мітка.

Переходячи до розширених показників у цій категорії, Disparate Impact (DI) вимірює таку ж різницю в позитивних класах, але замість різниці він обчислює співвідношення:

DI = 0.045 / 0.137 = 0.328

І DI, і DPPL передають якісно схожі ідеї, але відрізняються в деяких кутових випадках. Наприклад, коефіцієнти мають тенденцію зростати до дуже великих чисел, якщо знаменник малий. Візьмемо для прикладу числа 0.1 і 0.0001. Співвідношення 0.1/0.0001 = 10,000 0.1, тоді як різниця 0.0001 – 0.1 ≈ 0. На відміну від інших показників, де значення 1 означає відсутність зміщення, для DI відсутність зміщення відповідає значенню XNUMX.

Умовна демографічна невідповідність у прогнозованих мітках (CDDPL) вимірює невідповідність у представленні значення фасетів у позитивній мітці, але, як і переднавчальна метрика CDDL, вона також контролює парадокс Сімпсона.

Контрфактичний фліптест (FT) вимірює, чи схожі зразки з двох значень аспекту отримують подібні рішення від моделі. Модель, яка призначає різні рішення двом зразкам, які схожі один на одного, але відрізняються значеннями фасета, може вважатися зміщеною проти того, щоб значення фасета було присвоєно несприятливу (негативну) позначку. Враховуючи значення першого аспекту (жінки), він оцінює, чи мають аналогічні члени з іншим значенням аспекту (чоловіки) інший прогноз моделі. Подібні члени вибираються на основі алгоритму k-найближчого сусіда.

Рівна продуктивність

Прогнози моделі можуть мати однакове представлення в позитивних мітках із різних значень фасетів, але продуктивність моделі для цих груп може значно відрізнятися. У багатьох додатках може бути бажаним мати однакову прогностичну продуктивність для різних значень аспекту. Показники в цій категорії вимірюють різницю в ефективності прогнозування за значеннями аспектів.

Оскільки дані можна розділяти багатьма різними способами на основі спостережуваних або прогнозованих міток, існує багато різних способів вимірювання прогнозованої ефективності.

Однакова ефективність прогнозування незалежно від міток

Ви можете розглянути продуктивність моделі на всіх даних, незалежно від спостережуваних або прогнозованих міток, тобто загальну точність.

На наступних малюнках показано, як модель класифікує вхідні дані з двох значень фасетів у нашому прикладі набору даних. Справжні негативні результати (TN) – це випадки, коли і спостережувана, і прогнозована мітка дорівнювали 0. Хибнопозитивні результати (FP) – це неправильна класифікація, де спостережувана мітка була 0, а прогнозована мітка – 1. Істинні позитивні результати (TP) і хибні негативні результати (FN) визначені так само.

|

|

Для кожного значення фасету загальна продуктивність моделі, тобто точність цього значення фасета, становить:

Точність = (TN + TP🇧🇷TN + FP + FN + TP)

За цією формулою точність для жінок становить 0.930, а для чоловіків – 0.815. Це призводить до єдиного показника в цій категорії, різниці точності (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 означає, що точність для обох груп однакова. Більші (позитивні чи від’ємні) значення вказують на більшу різницю в точності.

Рівна продуктивність лише на позитивних етикетках

Ви можете обмежити аналіз продуктивності моделі лише позитивними мітками. Наприклад, якщо програма стосується виявлення дефектів на складальній лінії, може бути бажано перевірити, чи недефектні частини (позитивна етикетка) різних типів (значення фасетів) класифікуються як бездефектні з однаковою швидкістю. Ця кількість називається відкликанням, або істинно позитивною швидкістю:

Згадувати = TP / (TP + FN)

У нашому прикладі набору даних показник запам’ятовування для жінок становить 0.389, а для чоловіків – 0.425. Це веде до основного показника в цій категорії, різниці запам’ятовування (RD):

RD = 0.425 - 0.389 = 0.036

Тепер давайте розглянемо три розширені метрики в цій категорії, побачимо, які налаштування користувача вони кодують, і чим вони відрізняються від основної метрики RD.

По-перше, замість того, щоб вимірювати продуктивність за позитивними спостережуваними мітками, ви можете вимірювати її за позитивними прогнозованими мітками. Враховуючи значення аспекту, наприклад, жінок, і всі зразки з таким значенням аспекту, які за прогнозами моделі будуть позитивними, скільки насправді правильно класифіковано як позитивні? Ця величина називається коефіцієнтом прийняття (AR), або точністю:

AR = TP / (TP + FP)

У нашому прикладі AR для жінок становить 0.977, а AR для чоловіків — 0.970. Це призводить до різниці в рівні прийняття (DAR):

DAR = 0.970 - 0.977 = -0.007

Інший спосіб вимірювання упередженості полягає в об’єднанні двох попередніх показників і вимірюванні кількості позитивних прогнозів, які моделі присвоюють значенню аспекту, порівняно з спостережуваними позитивними мітками. SageMaker Clarify вимірює цю перевагу за допомогою моделі як відношення між кількістю спостережуваних позитивних міток для цього значення аспекту та кількістю прогнозованих позитивних міток і називає це умовним прийняттям (CA):

CA = (TP + FN🇧🇷TP + FP)

У нашому прикладі CA для жінок становить 2.510, а для чоловіків — 2.283. Різниця в CA призводить до остаточного показника в цій категорії, різниці в умовному прийнятті (DCA):

DCA = 2.283 - 2.510 = -0.227

Рівна продуктивність лише на негативних етикетках

Подібно до позитивних міток, упередження також можна обчислити як різницю продуктивності негативних міток. Розгляд негативних міток окремо може бути важливим у певних програмах. Наприклад, у нашому прикладі виявлення дефектів ми можемо захотіти виявити дефектні частини (негативна мітка) різних видів (значення фасету) з однаковою швидкістю.

Основний показник у цій категорії, специфічність, аналогічний показнику запам’ятовування (істинний позитивний показник). Специфічність обчислює точність моделі на зразках із цим значенням аспекту, які мають спостережувану негативну позначку:

Специфіка = TN / (TN + FP)

У нашому прикладі (див. таблиці плутанини) специфічність для жінок і чоловіків становить 0.999 і 0.994 відповідно. Отже, Специфіка Різниця (SD) є:

SD = 0.994 - 0.999 = -0.005

Подібно до метрики рівня прийняття, аналогічна величина для негативних міток — коефіцієнт відхилення (RR) — це:

RR = TN / (TN + FN)

RR для жінок становить 0.927, а для чоловіків – 0.791, що призводить до показника різниці в частоті відхилень (DRR):

DRR = 0.927 - 0.791 = -0.136

Нарешті, аналог негативної мітки умовного прийняття, умовна відмова (CR), є співвідношенням між кількістю спостережених негативних міток для цього значення аспекту та кількістю прогнозованих негативних міток:

CR = (TN + FP🇧🇷TN + FN)

CR для жінок становить 0.928, а для чоловіків – 0.796. Останнім показником у цій категорії є різниця в умовному відхиленні (DCR):

DCR = 0.796 - 0.928 = 0.132

Рівна продуктивність на позитивних і негативних етикетках

SageMaker Clarify поєднує дві попередні категорії, враховуючи співвідношення продуктивності моделі на позитивних і негативних етикетках. Зокрема, для кожного значення фасету SageMaker Clarify обчислює співвідношення між помилковими негативами (FN) і помилково позитивними результатами (FP). У нашому прикладі співвідношення FN/FP для жінок становить 679/10 = 67.9, а для чоловіків – 3678/84 = 43.786. Це призводить до метрики рівності лікування (TE), яка вимірює різницю між співвідношенням FP/FN:

TE = 67.9 - 43.786 = 24.114

На наступному знімку екрана показано, як можна використовувати SageMaker Clarify з Студія Amazon SageMaker щоб показати значення, а також діапазони та короткі описи різних показників зміщення.

Запитання щодо упередженості: з яких показників почати?

Згадайте зразки запитань про упередженість на початку цієї публікації. Переглянувши метрики з різних категорій, розгляньте питання ще раз. Щоб відповісти на перше запитання, яке стосується репрезентації різних груп у навчальних даних, ви можете почати з показника дисбалансу класу (CI). Подібним чином для решти питань ви можете почати з вивчення різниці в позитивних пропорціях у етикетках (DPL), різниці в точності (AD), різниці в прийнятному рівні (DAR) і різниці в запам’ятовуванні (RD) відповідно.

Зміщення без значень грані

Для простоти викладу цей опис показників після тренування виключив показник узагальненого індексу ентропії (GE). Ця метрика вимірює зміщення без урахування значення аспекту та може бути корисною для оцінки того, як розподіляються помилки моделі. Детальніше див Узагальнена ентропія (GE).

Висновок

У цій публікації ви побачили, як 21 різна метрика в SageMaker Clarify вимірює зміщення на різних етапах конвеєра машинного навчання. Ви дізналися про різні показники за допомогою сценарію використання прогнозування доходу, як вибрати показники для свого сценарію використання та з яких з них можна почати.

Розпочніть свою відповідальну подорож зі штучним інтелектом, оцінивши упередженість у своїх моделях машинного навчання за допомогою демонстраційного блокнота Справедливість і зрозумілість із SageMaker Clarify. Ви можете знайти детальну документацію для SageMaker Clarify, включно з формальним визначенням показників, за адресою Що таке справедливість і можливість пояснення моделі для прогнозів машинного навчання. Щоб дізнатися про реалізацію метрик зміщення з відкритим кодом, див aws-sagemaker-clarify репозиторій GitHub. Для детального обговорення, включаючи обмеження, зверніться до Офіційний документ Amazon AI Fairness and Explainability.

Про авторів

Білал Зафар є вченим-прикладником в AWS, працює над справедливістю, зрозумілістю та безпекою в машинному навчанні.

Білал Зафар є вченим-прикладником в AWS, працює над справедливістю, зрозумілістю та безпекою в машинному навчанні.

Баталов Денис Васильович є архітектором рішень для AWS, який спеціалізується на машинному навчанні. Працює в Amazon з 2005 року. Денис має ступінь доктора філософії в галузі ШІ. Слідкуйте за ним у Twitter: @dbatalov.

Мікеле Доніні є старшим прикладним науковцем в AWS. Він очолює групу вчених, які працюють над відповідальним штучним інтелектом, і його дослідницькі інтереси — алгоритмічна чесність і зрозуміле машинне навчання.

Мікеле Доніні є старшим прикладним науковцем в AWS. Він очолює групу вчених, які працюють над відповідальним штучним інтелектом, і його дослідницькі інтереси — алгоритмічна чесність і зрозуміле машинне навчання.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Amazon SageMaker

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- зефірнет