Оскільки організації розгортають моделі у виробництві, вони постійно шукають шляхи оптимізації продуктивності своїх базових моделей (FM), що працюють на найновіших прискорювачах, таких як AWS Inferentia і графічні процесори, щоб вони могли зменшити свої витрати та зменшити затримку відповіді, щоб забезпечити найкращий досвід для кінцевих користувачів. Однак деякі FM не повністю використовують прискорювачі, доступні в інстансах, на яких вони розгорнуті, що призводить до неефективного використання апаратних ресурсів. Деякі організації розгортають кілька FM в одному екземплярі, щоб краще використовувати всі доступні прискорювачі, але для цього потрібна складна оркестровка інфраструктури, яка займає багато часу та важко керувати. Коли кілька FM використовують один і той самий екземпляр, кожен FM має власні потреби в масштабуванні та шаблони використання, тому важко передбачити, коли вам потрібно буде додати чи видалити екземпляри. Наприклад, одна модель може використовуватися для роботи програми користувача, де використання може різко підвищитися протягом певних годин, тоді як інша модель може мати більш послідовний шаблон використання. На додаток до оптимізації витрат, клієнти хочуть забезпечити найкращий досвід кінцевого користувача шляхом зменшення затримки. Для цього вони часто розгортають кілька копій FM паралельно до запитів користувачів. Оскільки вихідні дані FM можуть варіюватися від одного речення до кількох абзаців, час, потрібний для виконання запиту на висновок, значно відрізняється, що призводить до непередбачуваних стрибків затримки, якщо запити маршрутизуються випадковим чином між екземплярами. Amazon SageMaker тепер підтримує нові можливості висновків, які допомагають зменшити витрати на розгортання та затримку.

Тепер ви можете створювати кінцеві точки на основі компонентів висновку та розгортати моделі машинного навчання (ML) у кінцевій точці SageMaker. Компонент висновку (IC) абстрагує вашу модель ML і дає змогу призначати ЦП, ГП або AWS нейрон прискорювачі та політики масштабування для кожної моделі. Компоненти висновку пропонують такі переваги:

- SageMaker оптимально розмістить і упакує моделі в екземпляри ML для максимального використання та економії коштів.

- SageMaker збільшить і зменшить масштаб кожної моделі залежно від вашої конфігурації, щоб відповідати вимогам програми ML.

- SageMaker буде масштабуватися, щоб динамічно додавати та видаляти екземпляри, щоб забезпечити доступність ємності, зводячи до мінімуму неактивні обчислення.

- Ви можете зменшити масштаб до нуля копій моделі, щоб звільнити ресурси для інших моделей. Ви також можете вказати, щоб важливі моделі завжди були завантаженими та готовими до обслуговування трафіку.

Завдяки цим можливостям ви можете зменшити витрати на розгортання моделі в середньому на 50%. Економія витрат буде різною залежно від вашого робочого навантаження та моделей трафіку. Розглянемо простий приклад, щоб проілюструвати, як упаковка кількох моделей на одній кінцевій точці може максимально збільшити використання та заощадити кошти. Припустімо, у вас є програма для чату, яка допомагає туристам зрозуміти місцеві звичаї та найкращі практики, створена за допомогою двох варіантів Llama 2: одного, налаштованого для європейських відвідувачів, а іншого — для американських. Ми очікуємо трафік для європейської моделі між 00:01–11:59 UTC і американської моделі між 12:00–23:59 UTC. Замість того, щоб розгортати ці моделі на власних виділених екземплярах, де вони будуть простоювати половину часу, тепер ви можете розгорнути їх на одній кінцевій точці, щоб заощадити кошти. Ви можете зменшити масштаб американської моделі до нуля, якщо це не потрібно, щоб звільнити ємність для європейської моделі, і навпаки. Це дозволяє ефективно використовувати апаратне забезпечення та уникати відходів. Це простий приклад використання двох моделей, але ви можете легко розширити цю ідею, щоб упакувати сотні моделей в одну кінцеву точку, яка автоматично масштабується відповідно до вашого робочого навантаження.

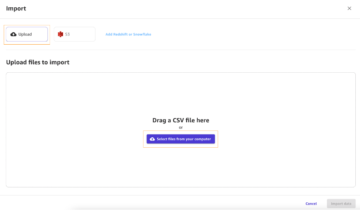

У цій публікації ми покажемо вам нові можливості кінцевих точок SageMaker на основі IC. Ми також проведемо вас через розгортання кількох моделей за допомогою компонентів висновку та API. Нарешті, ми детально описуємо деякі нові можливості спостережуваності та те, як налаштувати політики автоматичного масштабування для ваших моделей і керувати масштабуванням екземплярів для ваших кінцевих точок. Ви також можете розгортати моделі через наш новий спрощений інтерактивний інтерфейс користувача. Ми також підтримуємо розширені можливості маршрутизації для оптимізації затримки та продуктивності ваших робочих навантажень.

Будівельні блоки

Давайте розглянемо глибше та зрозуміємо, як працюють ці нові можливості. Нижче наведено деякі нові терміни для хостингу SageMaker:

- Компонент умовиводу – Об’єкт розміщення SageMaker, який можна використовувати для розгортання моделі на кінцевій точці. Ви можете створити компонент висновку, надавши наступне:

- Модель SageMaker або специфікація SageMaker-сумісного зображення та артефактів моделі.

- Вимоги до обчислювальних ресурсів, які визначають потреби кожної копії вашої моделі, включаючи ядра ЦП, пам’ять хоста та кількість прискорювачів.

- Копія моделі – Виконувана копія компонента висновку, яка здатна обслуговувати запити.

- Автоматичне масштабування керованого екземпляра – Можливість розміщення SageMaker для збільшення чи зменшення кількості обчислювальних екземплярів, які використовуються для кінцевої точки. Масштабування екземплярів реагує на масштабування компонентів висновку.

Щоб створити новий компонент висновку, ви можете вказати зображення контейнера та артефакт моделі або використати моделі SageMaker, які ви, можливо, вже створили. Вам також потрібно вказати вимоги до обчислювальних ресурсів, наприклад кількість ядер центрального процесора, пам’ять хоста або кількість прискорювачів, які потрібна для роботи вашої моделі.

Коли ви розгортаєте компонент висновку, ви можете вказати MinCopies щоб переконатися, що модель уже завантажено в потрібній вам кількості та готова обслуговувати запити.

У вас також є можливість налаштувати свої політики так, щоб копії компонента висновку масштабувалися до нуля. Наприклад, якщо у вас немає навантаження на IC, копію моделі буде вивантажено. Це може звільнити ресурси, які можна замінити активними робочими навантаженнями для оптимізації використання та ефективності кінцевої точки.

У міру того, як запити на висновок збільшуються або зменшуються, кількість копій ваших мікросхем також може збільшуватися або зменшуватися відповідно до ваших політик автоматичного масштабування. SageMaker виконає розміщення, щоб оптимізувати упаковку ваших моделей за доступністю та вартістю.

Крім того, якщо ви ввімкнете автоматичне масштабування керованого екземпляра, SageMaker масштабуватиме екземпляри обчислень відповідно до кількості компонентів висновку, які потрібно завантажити в певний час для обслуговування трафіку. SageMaker збільшить масштаб екземплярів і упакує ваші екземпляри та компоненти логічного висновку для оптимізації витрат, зберігаючи при цьому продуктивність моделі. Хоча ми рекомендуємо використовувати масштабування керованого екземпляра, ви також можете самостійно керувати масштабуванням за допомогою автоматичного масштабування програми.

SageMaker перебалансує компоненти висновків і зменшить масштаб екземплярів, якщо вони більше не потрібні компонентам висновків, і заощадить ваші витрати.

Покрокове керівництво API

SageMaker представив нову сутність під назвою the InferenceComponent. Це відокремлює деталі розміщення моделі ML від самої кінцевої точки. The InferenceComponent дозволяє вказати ключові властивості для розміщення моделі, наприклад модель SageMaker, яку ви бажаєте використовувати, або деталі контейнера та артефакти моделі. Ви також вказуєте кількість копій самих компонентів для розгортання та кількість необхідних прискорювачів (GPU, Inf або Trn) або CPU (vCPU). Це забезпечує більшу гнучкість для використання однієї кінцевої точки для будь-якої кількості моделей, які ви плануєте розгорнути на ній у майбутньому.

Давайте розглянемо виклики API Boto3 для створення кінцевої точки з компонентом висновку. Зауважте, що є деякі параметри, які ми розглянемо пізніше в цій публікації.

Нижче наведено приклад коду для CreateEndpointConfig:

Нижче наведено приклад коду для CreateEndpoint:

Нижче наведено приклад коду для CreateInferenceComponent:

Це роз'єднання InferenceComponent до кінцевої точки забезпечує гнучкість. Ви можете розмістити кілька моделей в одній інфраструктурі, додаючи або видаляючи їх у міру зміни ваших вимог. Кожну модель можна оновлювати незалежно за потреби. Крім того, ви можете масштабувати моделі відповідно до потреб свого бізнесу. InferenceComponent також дозволяє контролювати ємність кожної моделі. Іншими словами, ви можете визначити, скільки копій кожної моделі розмістити. Це передбачуване масштабування допомагає відповідати конкретним вимогам до затримки для кожної моделі. Загалом, InferenceComponent дає вам набагато більше контролю над розміщеними моделями.

У наступній таблиці ми показуємо паралельне порівняння підходу високого рівня до створення та виклику кінцевої точки без InferenceComponent і з InferenceComponent. Зауважте, що CreateModel() тепер необов’язковий для кінцевих точок на основі IC.

| Крок | Кінцеві точки на основі моделі | Кінцеві точки на основі компонентів висновку |

| 1 | Створити модель(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | Створити кінцеву точку (…) |

| 3 | Створити кінцеву точку (…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName='value'…) |

введення InferenceComponent дозволяє масштабувати на рівні моделі. Побачити Пориньте в автоматичне масштабування екземплярів і IC щоб дізнатися більше про те, як InferenceComponent працює з автоматичним масштабуванням.

Під час виклику кінцевої точки SageMaker тепер ви можете вказати новий параметр InferenceComponentName досягти бажаного InferenceComponentName. SageMaker обробить маршрутизацію запиту до екземпляра, на якому розміщено запрошений InferenceComponentName. Дивіться наступний код:

За замовчуванням SageMaker використовує випадкову маршрутизацію запитів до екземплярів, які підтримують вашу кінцеву точку. Якщо ви бажаєте ввімкнути маршрутизацію найменших запитів, ви можете встановити стратегію маршрутизації в конфігурації кінцевої точки RoutingConfig:

Найменш нерозглянуті запити маршрутизують до конкретних примірників, які мають більше можливостей для обробки запитів. Це забезпечить більш рівномірний розподіл навантаження та використання ресурсів.

На додаток до CreateInferenceComponent, тепер доступні такі API:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

Журнали та метрики InferenceComponent

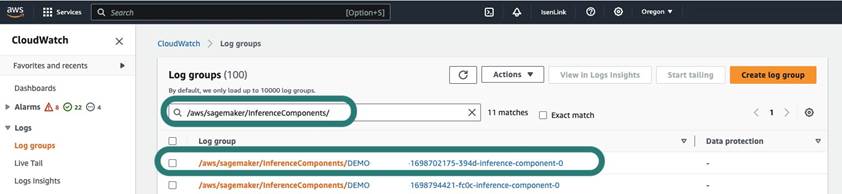

InferenceComponent журнали розташовані в /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Усі журнали, надіслані до stderr і stdout у контейнері, надсилаються до цих журналів Amazon CloudWatch.

З появою кінцевих точок на основі IC тепер у вас є можливість переглядати додаткові метрики екземплярів, метрики компонентів висновку та метрики виклику.

Для екземплярів SageMaker тепер ви можете відстежувати GPUReservation та CPUReservation метрики, щоб побачити ресурси, зарезервовані для кінцевої точки, на основі компонентів висновку, які ви розгорнули. Ці показники можуть допомогти вам визначити кінцеву точку та політику автоматичного масштабування. Ви також можете переглядати сукупні показники, пов’язані з усіма моделями, розгорнутими на кінцевій точці.

SageMaker також надає метрики на рівні компонентів висновку, які можуть показати більш детальне уявлення про використання ресурсів для компонентів висновку, які ви розгорнули. Це дозволяє отримати уявлення про те, наскільки сукупне використання ресурсів, наприклад GPUUtilizationNormalized та GPUMemoryUtilizationNormalized для кожного розгорнутого вами компонента висновку, який може мати нуль або багато копій.

Нарешті, SageMaker надає метрику викликів, яка тепер сукупно відстежує виклики для компонентів висновку (Invocations) або за екземпляр копії (InvocationsPerCopy)

Повний список показників див Метрики виклику кінцевої точки SageMaker.

Автоматичне масштабування на рівні моделі

Щоб реалізувати описану нами поведінку автоматичного масштабування, під час створення конфігурації кінцевої точки SageMaker і компонента висновку ви визначаєте початкову кількість екземплярів і початкову кількість копій моделі відповідно. Після створення кінцевої точки та відповідних IC, щоб застосувати автоматичне масштабування на рівні IC, вам потрібно спочатку зареєструвати ціль масштабування, а потім пов’язати політику масштабування з IC.

При реалізації політики масштабування ми використовуємо SageMakerInferenceComponentInvocationsPerCopy, який є новим показником, представленим SageMaker. Він фіксує середню кількість звернень на одну копію моделі за хвилину.

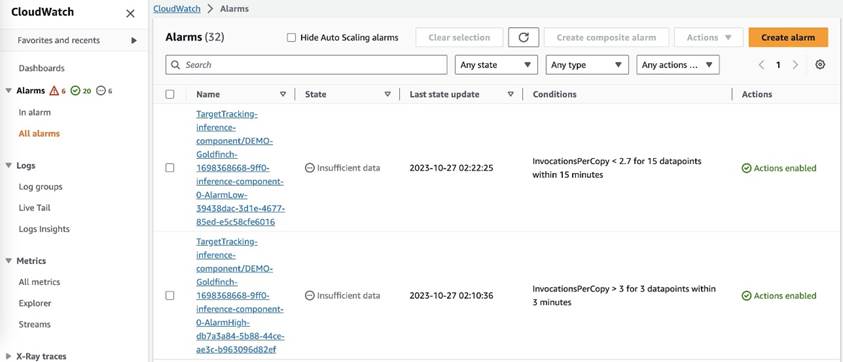

Після того як ви налаштуєте політику масштабування, SageMaker створює два нагадування CloudWatch для кожної цілі автомасштабування: один для ініціювання масштабування, якщо тривога триватиме 3 хвилини (три точки даних по 1 хвилині), і один, щоб запускати масштабування, якщо тривога триватиме 15 хвилин. (15 точок даних за 1 хвилину), як показано на наступному знімку екрана. Час для запуску дії масштабування зазвичай на 1–2 хвилини довший, ніж ці хвилини, оскільки кінцевій точці потрібен час для публікації метрик у CloudWatch, а також для AutoScaling реагувати. Період охолодження — це проміжок часу в секундах після завершення масштабування або масштабування, перш ніж можна буде розпочати іншу масштабування. Якщо масштабне охолодження коротше, ніж час оновлення кінцевої точки, воно не матиме ефекту, оскільки неможливо оновити кінцеву точку SageMaker, коли вона знаходиться в стані Оновлення Статус.

Зауважте, що під час налаштування автоматичного масштабування на рівні IC необхідно переконатися, що MaxInstanceCount параметр дорівнює або менший за максимальну кількість IC, яку може обробляти ця кінцева точка. Наприклад, якщо ваша кінцева точка налаштована на наявність лише одного екземпляра в конфігурації кінцевої точки, і цей екземпляр може розміщувати максимум чотири копії моделі, тоді MaxInstanceCount має дорівнювати або бути меншим за 4. Однак ви також можете використовувати можливість керованого автоматичного масштабування, надану SageMaker, щоб автоматично масштабувати кількість екземплярів на основі необхідної кількості копій моделі, щоб задовольнити потребу в додаткових обчислювальних ресурсах. Наведений нижче фрагмент коду демонструє, як налаштувати масштабування керованого екземпляра під час створення конфігурації кінцевої точки. Таким чином, коли для автоматичного масштабування на рівні IC потрібна більша кількість екземплярів для розміщення копій моделі, SageMaker автоматично масштабує номер екземпляра, щоб забезпечити успішне масштабування на рівні IC.

Ви можете застосувати кілька політик автоматичного масштабування до однієї кінцевої точки, що означає, що ви зможете застосувати традиційну політику автоматичного масштабування до кінцевих точок, створених за допомогою IC, і масштабувати вгору та вниз на основі інших показників кінцевої точки. Для отримання додаткової інформації див Оптимізуйте розгортання машинного навчання за допомогою автоматичного масштабування на Amazon SageMaker. Однак, незважаючи на те, що це можливо, ми все ж рекомендуємо використовувати кероване масштабування екземпляра, а не самостійно керувати масштабуванням.

Висновок

У цьому дописі ми представили нову функцію в SageMaker inference, яка допоможе вам максимізувати використання обчислювальних екземплярів, масштабувати до сотень моделей і оптимізувати витрати, забезпечуючи передбачувану продуктивність. Крім того, ми надали покрокове керівництво по API і показали вам, як налаштувати та розгорнути компоненти висновку для ваших робочих навантажень.

Ми також підтримуємо розширені можливості маршрутизації щоб оптимізувати затримку та продуктивність ваших робочих навантажень. SageMaker може допомогти вам оптимізувати робочі навантаження для висновків щодо вартості та продуктивності та надати деталізацію рівня моделі для керування. Ми створили a набір зошитів який покаже вам, як розгорнути три різні моделі, використовуючи різні контейнери та застосовуючи політики автоматичного масштабування в GitHub. Ми заохочуємо вас почати з ноутбука 1 і почати користуватися новими можливостями хостингу SageMaker вже сьогодні!

Про авторів

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Мелані Лі, PhD, є старшим спеціалістом зі штучного інтелекту та ML в AWS у Сіднеї, Австралія. Вона допомагає корпоративним клієнтам створювати рішення за допомогою найсучасніших інструментів AI/ML на AWS і надає вказівки щодо архітектури та впровадження рішень ML із передовими практиками. У вільний час вона любить досліджувати природу та проводити час із родиною та друзями.

Мелані Лі, PhD, є старшим спеціалістом зі штучного інтелекту та ML в AWS у Сіднеї, Австралія. Вона допомагає корпоративним клієнтам створювати рішення за допомогою найсучасніших інструментів AI/ML на AWS і надає вказівки щодо архітектури та впровадження рішень ML із передовими практиками. У вільний час вона любить досліджувати природу та проводити час із родиною та друзями.

Марк Карп є архітектором ML у команді Amazon SageMaker Service. Він зосереджується на допомозі клієнтам проектувати, розгортати та керувати робочими навантаженнями ML у масштабі. У вільний час він любить подорожувати та досліджувати нові місця.

Марк Карп є архітектором ML у команді Amazon SageMaker Service. Він зосереджується на допомозі клієнтам проектувати, розгортати та керувати робочими навантаженнями ML у масштабі. У вільний час він любить подорожувати та досліджувати нові місця.

Алан Тан є старшим менеджером із продуктів у SageMaker, керуючи зусиллями з виведення великих моделей. Він захоплений застосуванням машинного навчання в галузі аналітики. Поза роботою він любить прогулянки на природі.

Алан Тан є старшим менеджером із продуктів у SageMaker, керуючи зусиллями з виведення великих моделей. Він захоплений застосуванням машинного навчання в галузі аналітики. Поза роботою він любить прогулянки на природі.

Рагу Рамеша є старшим архітектором рішень ML у команді Amazon SageMaker Service. Він зосереджується на допомозі клієнтам створювати, розгортати та переносити робочі навантаження ML на SageMaker у великих масштабах. Він спеціалізується на машинному навчанні, штучному інтелекті та комп’ютерному зорі, а також має ступінь магістра комп’ютерних наук в UT Dallas. У вільний час захоплюється подорожами та фотографією.

Рагу Рамеша є старшим архітектором рішень ML у команді Amazon SageMaker Service. Він зосереджується на допомозі клієнтам створювати, розгортати та переносити робочі навантаження ML на SageMaker у великих масштабах. Він спеціалізується на машинному навчанні, штучному інтелекті та комп’ютерному зорі, а також має ступінь магістра комп’ютерних наук в UT Dallas. У вільний час захоплюється подорожами та фотографією.

Рупіндер Гревал є старшим архітектором рішень Ai/ML в AWS. Зараз він зосереджується на обслуговуванні моделей і MLO на SageMaker. До цієї посади він працював інженером машинного навчання, створюючи та розміщуючи моделі. Поза роботою він любить грати в теніс і їздити на велосипеді гірськими стежками.

Рупіндер Гревал є старшим архітектором рішень Ai/ML в AWS. Зараз він зосереджується на обслуговуванні моделей і MLO на SageMaker. До цієї посади він працював інженером машинного навчання, створюючи та розміщуючи моделі. Поза роботою він любить грати в теніс і їздити на велосипеді гірськими стежками.

Дхавал Патель є головним архітектором машинного навчання в AWS. Він працював з організаціями, починаючи від великих підприємств і закінчуючи стартапами середнього розміру, над проблемами, пов’язаними з розподіленими обчисленнями та штучним інтелектом. Він зосереджується на глибокому навчанні, включаючи домени НЛП та комп’ютерного зору. Він допомагає клієнтам досягти високопродуктивної моделі висновку на SageMaker.

Дхавал Патель є головним архітектором машинного навчання в AWS. Він працював з організаціями, починаючи від великих підприємств і закінчуючи стартапами середнього розміру, над проблемами, пов’язаними з розподіленими обчисленнями та штучним інтелектом. Він зосереджується на глибокому навчанні, включаючи домени НЛП та комп’ютерного зору. Він допомагає клієнтам досягти високопродуктивної моделі висновку на SageMaker.

Саураб Тріканде є старшим менеджером із продуктів Amazon SageMaker Inference. Він захоплений роботою з клієнтами та мотивований метою демократизації машинного навчання. Він зосереджується на основних проблемах, пов’язаних із розгортанням складних програм ML, моделями ML з кількома клієнтами, оптимізацією витрат і забезпеченням більшої доступності розгортання моделей глибокого навчання. У вільний час Саураб любить піші прогулянки, вивчає інноваційні технології, стежить за TechCrunch і проводить час із сім’єю.

Саураб Тріканде є старшим менеджером із продуктів Amazon SageMaker Inference. Він захоплений роботою з клієнтами та мотивований метою демократизації машинного навчання. Він зосереджується на основних проблемах, пов’язаних із розгортанням складних програм ML, моделями ML з кількома клієнтами, оптимізацією витрат і забезпеченням більшої доступності розгортання моделей глибокого навчання. У вільний час Саураб любить піші прогулянки, вивчає інноваційні технології, стежить за TechCrunch і проводить час із сім’єю.

Лакшмі Рамакрішнан є головним інженером команди платформи Amazon SageMaker Machine Learning (ML) в AWS, забезпечує технічне керівництво продуктом. Він працював на кількох інженерних посадах в Amazon понад 9 років. Він має ступінь бакалавра інженерних наук у галузі інформаційних технологій у Національному технологічному інституті, штат Карнатака, Індія, і ступінь магістра наук у галузі комп’ютерних наук в Університеті міст-побратимів Міннесоти.

Лакшмі Рамакрішнан є головним інженером команди платформи Amazon SageMaker Machine Learning (ML) в AWS, забезпечує технічне керівництво продуктом. Він працював на кількох інженерних посадах в Amazon понад 9 років. Він має ступінь бакалавра інженерних наук у галузі інформаційних технологій у Національному технологічному інституті, штат Карнатака, Індія, і ступінь магістра наук у галузі комп’ютерних наук в Університеті міст-побратимів Міннесоти.

Девід Нігенда є старшим інженером з розробки програмного забезпечення в команді Amazon SageMaker, зараз працює над удосконаленням робочих процесів машинного навчання виробництва, а також над запуском нових функцій висновків. У вільний час він намагається не відставати від своїх дітей.

Девід Нігенда є старшим інженером з розробки програмного забезпечення в команді Amazon SageMaker, зараз працює над удосконаленням робочих процесів машинного навчання виробництва, а також над запуском нових функцій висновків. У вільний час він намагається не відставати від своїх дітей.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- : має

- :є

- : ні

- :де

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- здатність

- Здатний

- МЕНЮ

- тези

- прискорювачі

- доступною

- За

- Achieve

- дію

- активний

- діяльність

- додавати

- додати

- доповнення

- Додатковий

- Додатково

- адреса

- просунутий

- після

- проти

- сукупність

- AI

- AI / ML

- Алан

- тривога

- ВСІ

- дозволяти

- дозволяє

- вже

- Також

- хоча

- завжди

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- американська

- кількість

- an

- аналітика

- та

- Інший

- будь-який

- API

- Інтерфейси

- додаток

- застосування

- Застосовувати

- Застосування

- підхід

- ЕСТЬ

- ПЛОЩА

- штучний

- штучний інтелект

- AS

- Юрист

- асоційований

- At

- Австралія

- автоматичний

- автоматично

- наявність

- доступний

- середній

- уникнути

- AWS

- підтримка

- заснований

- BE

- оскільки

- перед тим

- поведінка

- Переваги

- КРАЩЕ

- передового досвіду

- Краще

- між

- будувати

- Створюємо

- побудований

- бізнес

- але

- by

- званий

- Виклики

- CAN

- можливості

- можливості

- здатний

- потужність

- захвати

- певний

- проблеми

- складні

- зміна

- Вибирати

- Міста

- код

- COM

- порівняння

- повний

- Завершує

- комплекс

- компонент

- Компоненти

- всеосяжний

- обчислення

- комп'ютер

- Інформатика

- Комп'ютерне бачення

- обчислення

- конфігурація

- налаштувати

- послідовний

- постійно

- споживання

- Контейнер

- Контейнери

- контроль

- Core

- Відповідний

- Коштувати

- економія на витратах

- витрати

- може

- створювати

- створений

- створює

- створення

- створення

- В даний час

- Клієнти

- митний

- Даллас

- дані

- точки даних

- Дата

- зменшити

- присвячених

- глибокий

- глибоке навчання

- глибше

- дефолт

- визначати

- Ступінь

- заглиблюватися

- Демократизувати

- демонструє

- Залежно

- розгортання

- розгорнути

- розгортання

- розгортання

- розгортання

- описаний

- дизайн

- бажаний

- деталь

- деталі

- Визначати

- розробка

- різний

- важкий

- розподілений

- розподілені обчислення

- do

- домени

- Не знаю

- вниз

- під час

- динамічно

- кожен

- легко

- ефект

- ефективність

- продуктивно

- зусилля

- включіть

- включений

- дозволяє

- заохочувати

- Кінцева точка

- інженер

- Машинобудування

- забезпечувати

- підприємство

- підприємств

- суб'єкта

- рівним

- Європейська

- приклад

- очікувати

- досвід

- Досліди

- дослідити

- Дослідження

- продовжити

- сім'я

- особливість

- риси

- поле

- знайти

- Перший

- Гнучкість

- фокусується

- після

- для

- фонд

- чотири

- Безкоштовна

- друзі

- від

- повністю

- Крім того

- майбутнє

- отримати

- GIF

- GitHub

- Давати

- даний

- дає

- мета

- GPU

- Графічні процесори

- зернистий

- керівництво

- Половина

- обробляти

- Руки

- апаратні засоби

- Мати

- he

- допомога

- допомогу

- допомагає

- її

- Високий

- на вищому рівні

- його

- його

- хіт

- тримає

- господар

- відбувся

- хостинг

- ГОДИННИК

- Як

- How To

- Однак

- HTTP

- HTTPS

- Сотні

- ідея

- Idle

- if

- ілюструвати

- зображення

- здійснювати

- реалізації

- важливо

- поліпшення

- in

- В інших

- У тому числі

- Augmenter

- самостійно

- Індію

- неефективний

- інформація

- інформаційна технологія

- Інфраструктура

- початковий

- інноваційний

- інноваційні технології

- екземпляр

- замість

- Інститут

- Інтелект

- інтерактивний

- інтерес

- в

- введені

- Вступ

- IT

- ЙОГО

- сам

- JPG

- тримати

- зберігання

- ключ

- Діти

- великий

- Великі підприємства

- нарешті

- Затримка

- пізніше

- останній

- запуск

- Керівництво

- провідний

- вивчення

- найменш

- рівень

- як

- список

- Лама

- загрузка

- місцевий

- розташований

- довше

- подивитися

- шукати

- любить

- машина

- навчання за допомогою машини

- зробити

- Робить

- управляти

- вдалося

- управління

- менеджер

- управління

- багато

- майстер

- магістра

- Максимізувати

- максимальний

- Може..

- засоби

- Зустрічатися

- пам'ять

- метрика

- Метрика

- мігрувати

- мінімальний

- хвилин

- хвилин

- ML

- MLOps

- модель

- Моделі

- більше

- мотивовані

- Гора

- багато

- множинний

- National

- природа

- Необхідність

- необхідний

- потреби

- Нові

- nlp

- немає

- увагу

- ноутбук

- зараз

- номер

- об'єкт

- of

- пропонувати

- часто

- on

- ONE

- тільки

- на

- Оптимізувати

- оптимізуючий

- варіант

- or

- оркестровка

- організації

- Інше

- наші

- з

- на відкритому повітрі

- виходи

- поза

- видатний

- над

- загальний

- власний

- Pack

- Паралельні

- параметр

- параметри

- приватність

- пристрасний

- Викрійки

- моделі

- для

- продуктивність

- period

- Вчений ступінь

- малюнок

- місце

- розміщення

- місця

- план

- платформа

- plato

- Інформація про дані Платона

- PlatoData

- ігри

- точок

- Політика

- політика

- це можливо

- пошта

- влада

- практики

- передбачати

- Передбачуваний

- консервування

- Головний

- попередній

- проблеми

- процес

- Product

- менеджер по продукції

- Production

- властивості

- забезпечувати

- за умови

- забезпечує

- забезпечення

- публікувати

- кількість

- випадковий

- діапазон

- ранжування

- Реагувати

- вступає в реакцію

- готовий

- ребаланс

- рекомендувати

- зменшити

- зниження

- послатися

- реєструвати

- пов'язаний

- видаляти

- видалення

- замінити

- запросити

- запитів

- вимагати

- вимагається

- Вимога

- Вимагається

- захищені

- ресурс

- ресурси

- відповідно

- відповідь

- Роль

- ролі

- маршрути

- Маршрутизація

- прогін

- біг

- час виконання

- мудрець

- Висновок SageMaker

- то ж

- зберегти

- Економія

- say

- шкала

- ваги

- Масштабування

- наука

- seconds

- побачити

- пошук

- старший

- посланий

- пропозиція

- служити

- обслуговування

- Послуги

- виступаючої

- комплект

- установка

- кілька

- Поділитись

- вона

- Повинен

- Показувати

- показав

- показаний

- істотно

- простий

- спрощений

- один

- сидіти

- Розмір

- менше

- уривок

- So

- Софтвер

- розробка програмного забезпечення

- Рішення

- деякі

- спеціаліст

- спеціалізується

- конкретний

- специфікація

- витрачати

- Витрати

- шип

- шипи

- старт

- Стартапи

- впроваджений

- Статус

- перебування

- Як і раніше

- Стратегія

- успішний

- такі

- поставки

- підтримка

- Опори

- Переконайтеся

- Сідней

- таблиця

- Приймати

- приймає

- Мета

- команда

- TechCrunch

- технічний

- Технології

- Технологія

- теніс

- термінологія

- ніж

- Що

- Команда

- Площа

- Майбутнє

- їх

- Їх

- потім

- Там.

- Ці

- вони

- це

- ті

- три

- через

- час

- до

- інструменти

- трек

- традиційний

- трафік

- Подорож

- Тенденції

- викликати

- twin

- два

- розуміти

- університет

- непередбачуваний

- Оновити

- оновлений

- Використання

- використання

- використовуваний

- користувач

- User Experience

- користувачі

- використовує

- використання

- зазвичай

- UTC

- використовувати

- віце

- вид

- бачення

- відвідувачів

- ходити

- покрокове керівництво

- хотіти

- Відходи

- шлях..

- способи

- we

- Web

- веб-сервіси

- ДОБРЕ

- коли

- в той час як

- який

- в той час як

- волі

- з

- без

- слова

- Work

- працював

- Робочі процеси

- робочий

- працює

- років

- Ти

- вашу

- себе

- зефірнет

- нуль