Оскільки все більше організацій застосовують генеративні технології штучного інтелекту — щоб створювати презентації, заповнювати грантові заявки та писати шаблонний код — групи безпеки усвідомлюють необхідність відповісти на нове питання: як захистити інструменти ШІ?

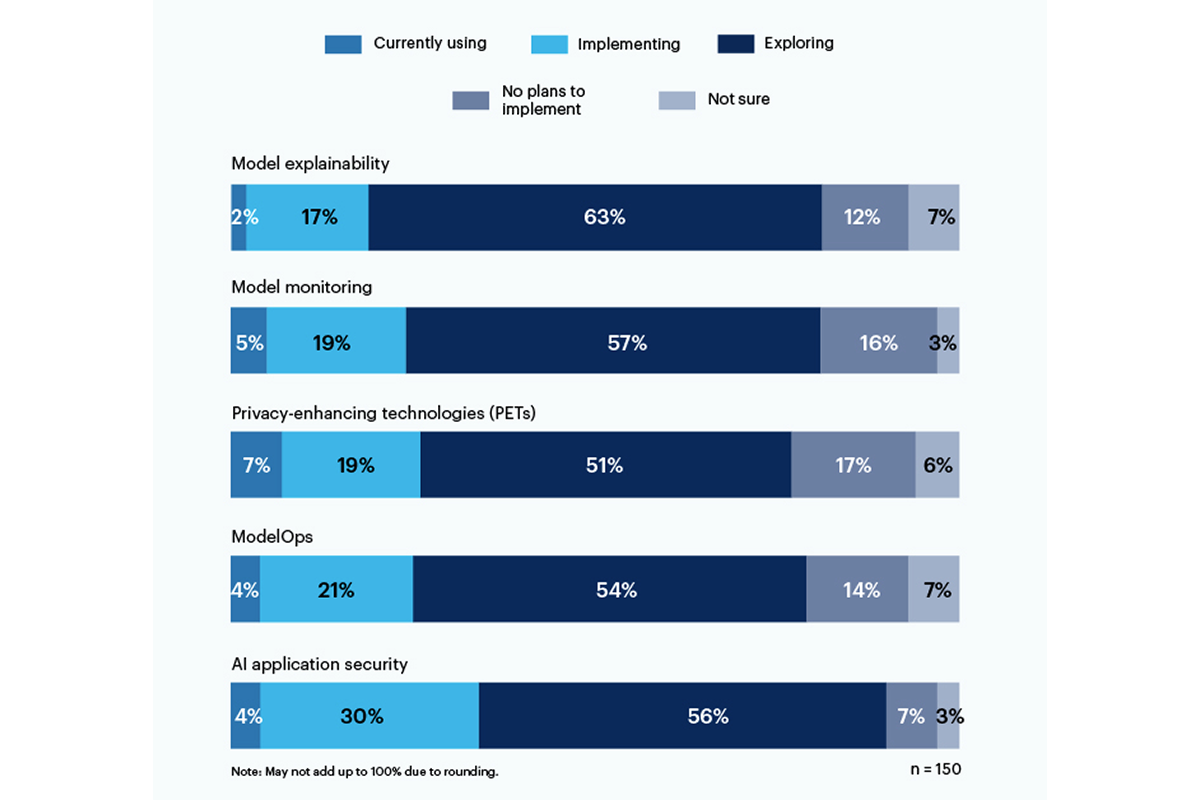

Одна третина респондентів у нещодавньому опитуванні Gartner повідомили також використання або впровадження інструментів безпеки додатків на основі ШІ подолати ризики, пов’язані з використанням генеративного ШІ в їхній організації.

Технології підвищення конфіденційності (PET) продемонстрували найбільше використання в даний час у 7% респондентів, причому 19% компаній їх впроваджують; ця категорія включає способи захисту персональних даних, такі як гомоморфне шифрування, Синтетичні дані, створені ШІ, безпечні багатосторонні обчислення, федеративне навчання та диференційна конфіденційність. Проте цілих 17% не планують впроваджувати ПЕТ у своєму оточенні.

Лише 19% використовують або впроваджують інструменти для пояснення моделі, але серед респондентів є значний інтерес (56%) у вивченні та розумінні цих інструментів для усунення генеративного ризику ШІ. Зрозумілість, моніторинг моделі та інструменти захисту додатків штучного інтелекту можна використовувати в моделях з відкритим кодом або пропрієтарних моделях, щоб досягти достовірності та надійності, які потрібні корпоративним користувачам, згідно з Gartner.

Ризики, які найбільше хвилюють респондентів, включають неправильні або упереджені результати (58%), а також уразливості або витік секретів у створеному ШІ коді (57%). Важливо, що 43% назвали потенційні проблеми з авторським правом або ліцензуванням, що виникають через контент, створений штучним інтелектом, як головний ризик для їхньої організації.

«Досі немає прозорості щодо моделей даних, на яких навчаються, тому ризик, пов’язаний із упередженістю та конфіденційністю, дуже важко зрозуміти й оцінити», — написав керівник C-suite у відповідь на опитування Gartner.

У червні Національний інститут стандартів і технологій ім (NIST) створив публічну робочу групу щоб допомогти у вирішенні цього питання, ґрунтуючись на своїй структурі управління ризиками штучного інтелекту від січня. Як показують дані Gartner, компанії не чекають для директив NIST.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :є

- : ні

- 7

- a

- МЕНЮ

- За

- Achieve

- адреса

- прийняти

- AI

- ВСІ

- серед

- та

- додаток

- захист додатків

- застосування

- ЕСТЬ

- AS

- асоційований

- At

- заснований

- BE

- зміщення

- упереджений

- але

- by

- C-люкс

- CAN

- Категорія

- цитується

- код

- Компанії

- повний

- стурбований

- зміст

- авторське право

- виробити

- Поточний

- дані

- важкий

- директиви

- do

- або

- підприємство

- Навколишнє середовище

- оцінити

- виконавчий

- Дослідження

- для

- Рамки

- від

- Gartner

- генеративний

- Генеративний ШІ

- надавати

- найбільший

- Мати

- допомога

- Як

- Однак

- HTTPS

- реалізації

- in

- включати

- includes

- Інститут

- інтерес

- питання

- IT

- ЙОГО

- січня

- червень

- запущений

- ліцензування

- управління

- методика

- модель

- Моделі

- моніторинг

- більше

- найбільш

- множинний

- National

- Необхідність

- Нові

- nist

- немає

- of

- on

- відкрити

- з відкритим вихідним кодом

- or

- організація

- організації

- персонал

- особисті дані

- Домашні тварини

- смоли

- плани

- plato

- Інформація про дані Платона

- PlatoData

- поставлений

- потенціал

- недоторканність приватного життя

- власником

- захист

- громадськість

- питання

- розуміючи,

- останній

- надійність

- покладатися

- Повідомляється

- респонденти

- відповідь

- Risk

- управління ризиками

- ризики

- секрети

- безпечний

- безпеку

- показав

- Шоу

- значний

- істотно

- So

- solid

- Source

- стандартів

- Як і раніше

- такі

- Огляд

- синтетичний

- команди

- Технології

- Технологія

- Що

- Команда

- їх

- Там.

- Ці

- це

- до

- інструменти

- топ

- Навчання

- прозорість

- надійність

- розуміти

- розуміння

- використання

- використовуваний

- користувачі

- використання

- дуже

- Уразливості

- способи

- з

- робочий

- запис

- пише

- Ти

- зефірнет