Сьогодні ми раді повідомити, що моделі основи Llama 2, розроблені Meta, доступні для клієнтів через Amazon SageMaker JumpStart. Сімейство великих мовних моделей (LLM) Llama 2 — це набір попередньо підготовлених і точно налаштованих генеративних текстових моделей із масштабом від 7 до 70 мільярдів параметрів. Тонко налаштовані LLM, які називаються Llama-2-chat, оптимізовані для випадків використання діалогу. Ви можете легко випробувати ці моделі та використовувати їх із SageMaker JumpStart, центром машинного навчання (ML), який надає доступ до алгоритмів, моделей і рішень ML, щоб ви могли швидко розпочати роботу з ML.

У цій публікації ми розглянемо, як використовувати моделі Llama 2 через SageMaker JumpStart.

Що таке Лама 2

Llama 2 — це авторегресивна модель мови, яка використовує оптимізовану трансформаторну архітектуру. Llama 2 призначений для комерційного та наукового використання англійською мовою. Він доступний у діапазоні розмірів параметрів — 7 мільярдів, 13 мільярдів і 70 мільярдів — а також у попередньо підготовлених і точно налаштованих варіантах. Відповідно до Meta, налаштовані версії використовують контрольовану точну настройку (SFT) і навчання з підкріпленням із зворотним зв’язком людини (RLHF), щоб узгодити людські переваги щодо корисності та безпеки. Llama 2 був попередньо навчений на 2 трильйонах токенів даних із загальнодоступних джерел. Налаштовані моделі призначені для чату, схожого на помічника, тоді як попередньо навчені моделі можна адаптувати для різноманітних завдань генерації природної мови. Незалежно від того, яку версію моделі використовує розробник, посібник із відповідального використання від Meta може допомогти в проведенні додаткових тонких налаштувань, які можуть знадобитися для налаштування й оптимізації моделей із відповідними пом’якшеними засобами безпеки.

Що таке SageMaker JumpStart

Завдяки SageMaker JumpStart фахівці з машинного навчання можуть вибирати з широкого вибору моделей основи з відкритим кодом. Практикуючі ML можуть розгортати базові моделі на спеціальному Amazon SageMaker екземпляри з мережевого ізольованого середовища та налаштовуйте моделі за допомогою SageMaker для навчання та розгортання моделі.

Тепер ви можете знайти та розгорнути Llama 2 кількома клацаннями миші Студія Amazon SageMaker або програмно за допомогою SDK SageMaker Python, що дає змогу отримувати продуктивність моделі та елементи керування MLOps за допомогою таких функцій SageMaker, як Трубопроводи Amazon SageMaker, Налагоджувач Amazon SageMaker, або контейнерні журнали. Модель розгортається в захищеному середовищі AWS і під керуванням вашого VPC, що допомагає забезпечити безпеку даних. Моделі Llama 2 доступні сьогодні в Amazon SageMaker Studio, спочатку в us-east 1 та us-west 2 регіони.

Відкрийте для себе моделі

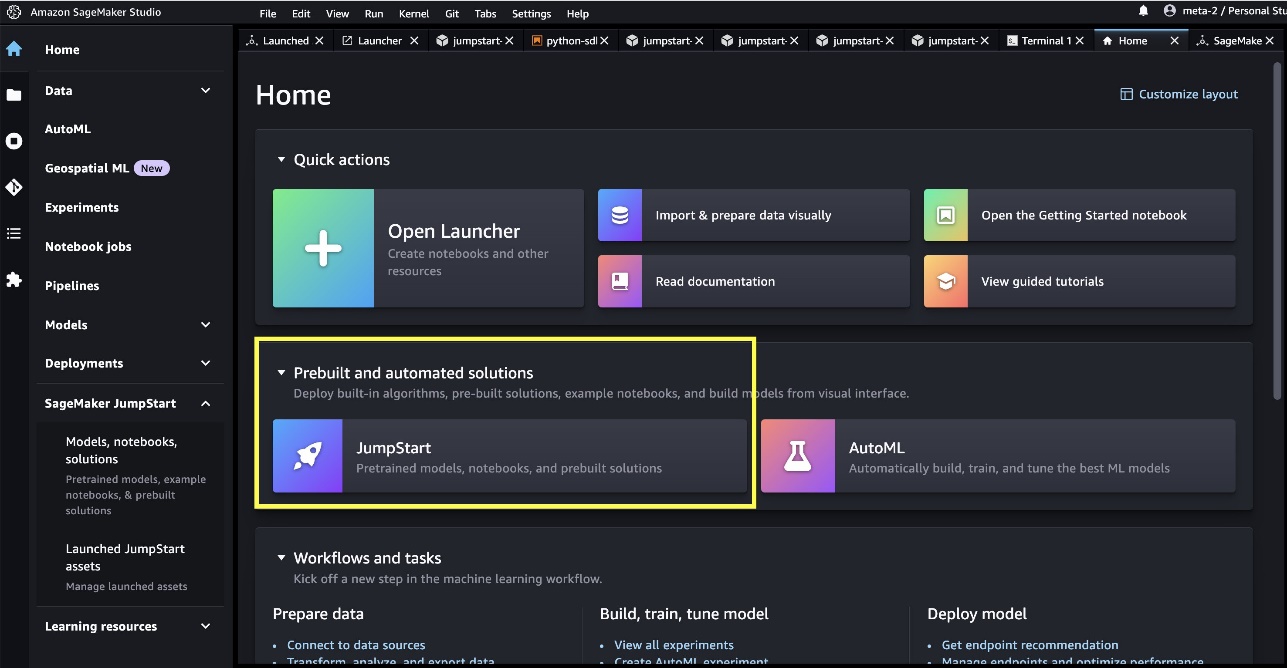

Ви можете отримати доступ до базових моделей через SageMaker JumpStart в інтерфейсі користувача SageMaker Studio та SageMaker Python SDK. У цьому розділі ми розглянемо, як знайти моделі в SageMaker Studio.

SageMaker Studio — це інтегроване середовище розробки (IDE), яке забезпечує єдиний візуальний веб-інтерфейс, де ви можете отримати доступ до спеціально створених інструментів для виконання всіх етапів розробки ML, від підготовки даних до створення, навчання та розгортання ваших моделей ML. Докладніше про те, як розпочати роботу та налаштувати SageMaker Studio, див Студія Amazon SageMaker.

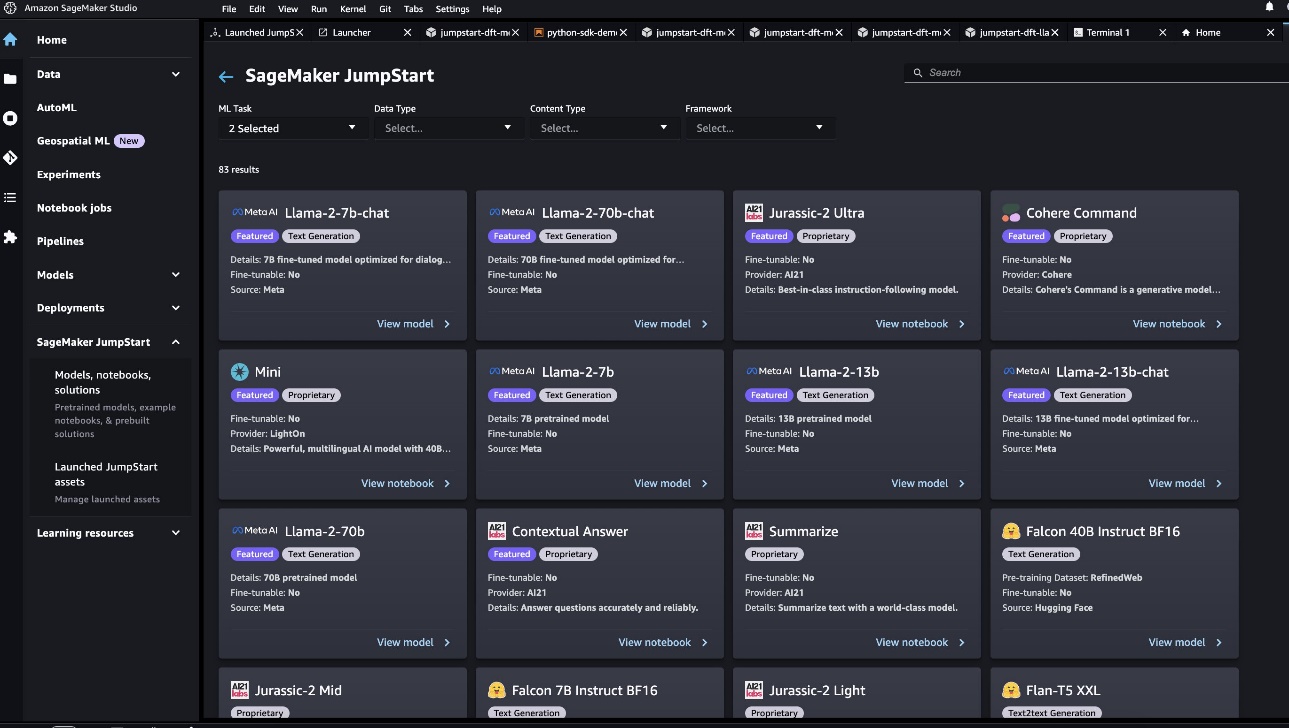

Увійшовши до SageMaker Studio, ви можете отримати доступ до SageMaker JumpStart, який містить попередньо підготовлені моделі, блокноти та готові рішення, у розділі Готові та автоматизовані рішення.

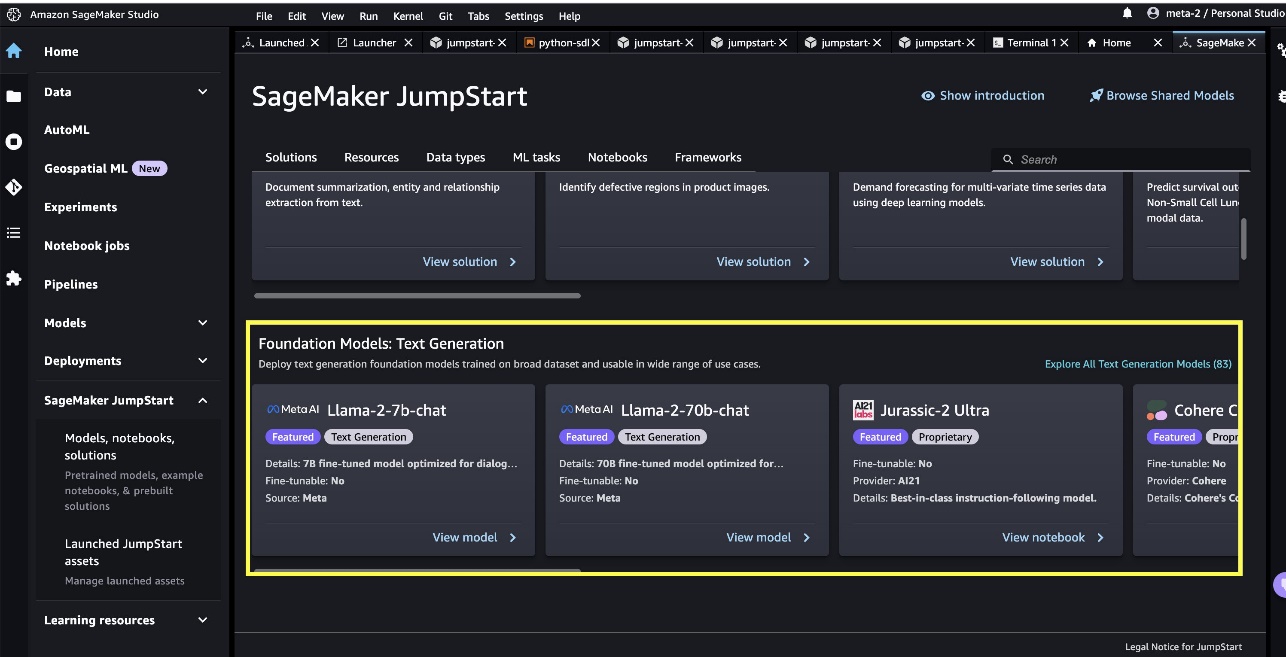

На цільовій сторінці SageMaker JumpStart ви можете переглядати рішення, моделі, блокноти та інші ресурси. Ви можете знайти дві флагманські моделі Llama 2 у Моделі основи: Генерація тексту карусель. Якщо ви не бачите моделей Llama 2, оновіть версію SageMaker Studio, вимкнувши та перезапустивши програму. Додаткову інформацію про оновлення версій див Вимкніть і оновіть програми Studio.

Ви також можете знайти інші чотири варіанти моделі, вибравши Дослідіть усі моделі генерації тексту або шукає llama у вікні пошуку.

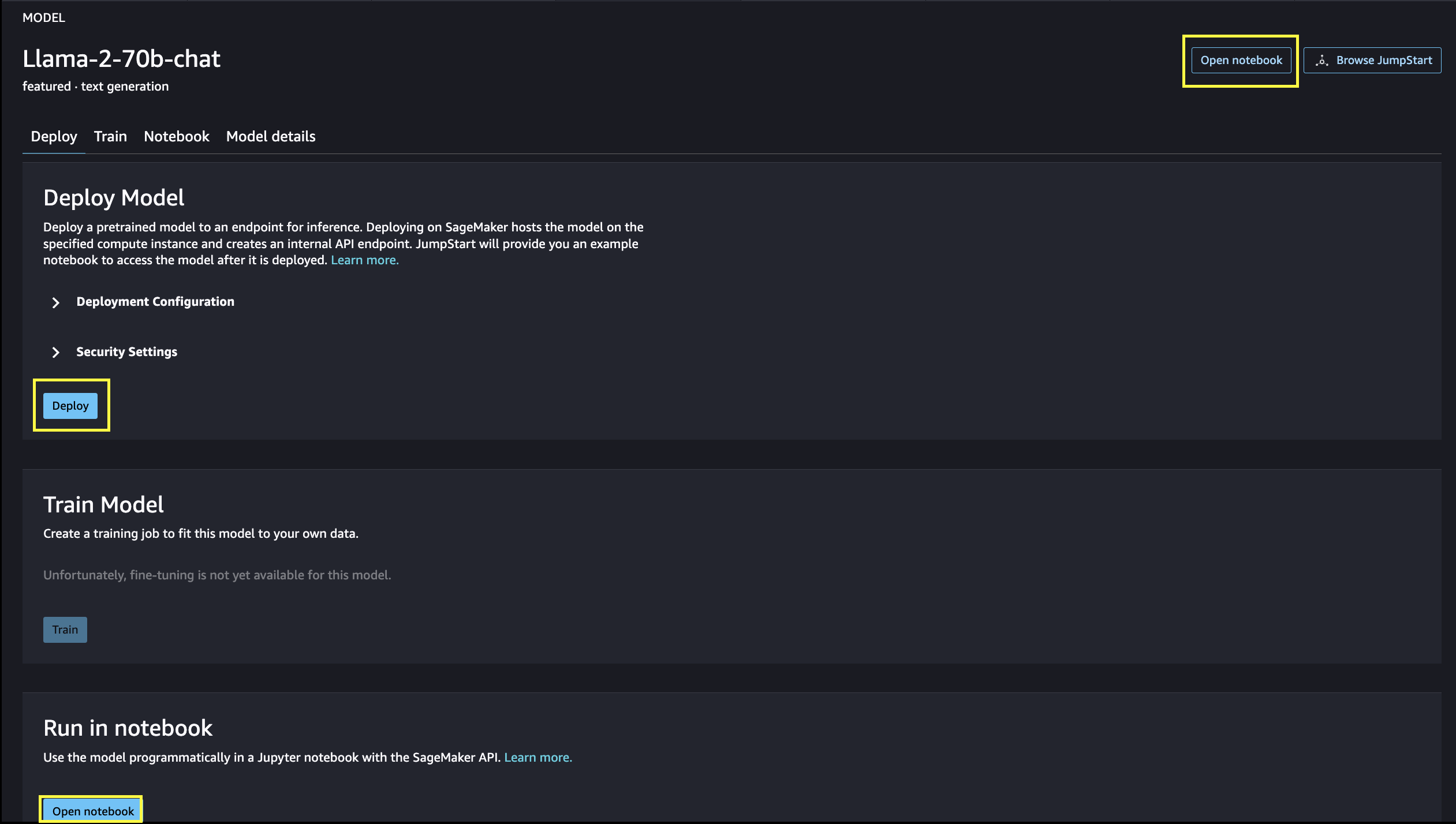

Ви можете вибрати картку моделі, щоб переглянути деталі моделі, наприклад ліцензію, дані, які використовуються для навчання, і спосіб використання. Ви також можете знайти дві кнопки, Розгортання та Відкрийте Блокнот, які допоможуть вам використовувати модель.

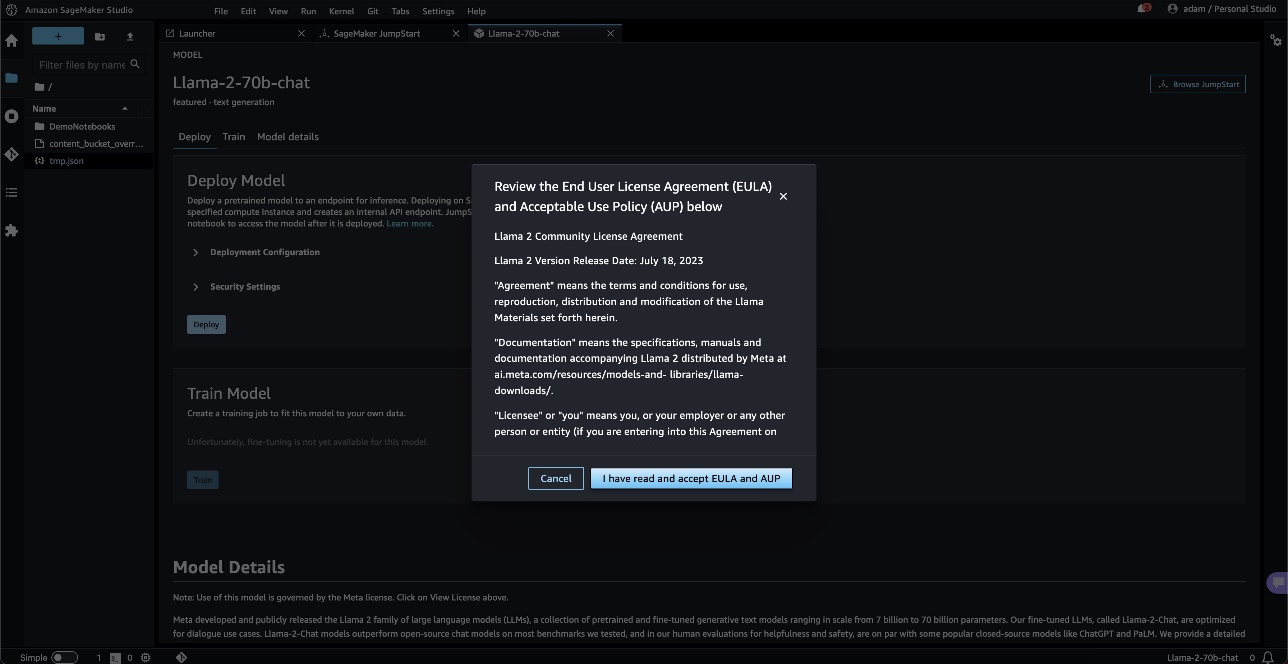

Коли ви натискаєте будь-яку кнопку, у спливаючому вікні відображатиметься ліцензійна угода кінцевого користувача та політика прийнятного використання, які ви повинні підтвердити.

Після підтвердження ви переходите до наступного кроку використання моделі.

Розгорнути модель

Коли ви обираєте Розгортання і підтвердити умови, почнеться розгортання моделі. Крім того, ви можете розгорнути за допомогою прикладу блокнота, який з’явиться, вибравши Відкрийте Блокнот. Приклад блокнота містить наскрізні вказівки щодо того, як розгорнути модель для висновків і очистити ресурси.

Для розгортання за допомогою ноутбука ми починаємо з вибору відповідної моделі, зазначеної в model_id. Ви можете розгорнути будь-яку з вибраних моделей на SageMaker за допомогою такого коду:

Це розгортає модель на SageMaker із конфігураціями за замовчуванням, включаючи тип екземпляра за замовчуванням і конфігурації VPC за замовчуванням. Ви можете змінити ці конфігурації, вказавши значення, відмінні від замовчування JumpStartModel. Після розгортання ви можете запустити висновок щодо розгорнутої кінцевої точки за допомогою предиктора SageMaker:

Тонко налаштовані моделі чату (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) приймають історію чату між користувачем і помічником чату та генерують наступний чат. Попередньо навчені моделі (Llama-2-7b, Llama-2-13b, Llama-2-70b) вимагають рядкової підказки та виконують завершення тексту у наданій підказці. Перегляньте наступний код:

Зауважте, що за замовчуванням, accept_eula має значення false. Вам потрібно встановити accept_eula=true щоб успішно викликати кінцеву точку. Роблячи це, ви приймаєте ліцензійну угоду користувача та політику прийнятного використання, про які згадувалося раніше. Ви також можете скачати ліцензійний договір.

Custom_attributes використовуються для передачі EULA, це пари ключ/значення. Ключ і значення розділені символом = і пари розділені ;. Якщо користувач передає той самий ключ більше одного разу, останнє значення зберігається та передається обробнику сценарію (тобто в цьому випадку використовується для умовної логіки). Наприклад, якщо accept_eula=false; accept_eula=true потім передається на сервер accept_eula=true зберігається та передається обробнику сценарію.

Параметри висновку керують процесом генерації тексту в кінцевій точці. Максимальний контроль над новими маркерами стосується розміру результату, створеного моделлю. Зауважте, що це не те саме, що кількість слів, оскільки словниковий запас моделі не такий самий, як словниковий запас англійської мови, і кожна лексема може не бути словом англійської мови. Температура контролює випадковість виведення. Більш висока температура призводить до більшої творчості та галюцинацій. Усі параметри висновку є необов’язковими.

У наведеній нижче таблиці перераховано всі моделі Llama, доступні в SageMaker JumpStart разом із model_ids, типові екземпляри за замовчуванням і максимальна кількість загальних маркерів (сума кількості введених маркерів і кількості згенерованих маркерів), підтримуваних для кожної з цих моделей.

| Назва моделі | Ідентифікатор моделі | Максимальна загальна кількість токенів | Тип екземпляра за замовчуванням |

| Лама-2-7б | meta-textgeneration-llama-2-7b | 4096 | мл.g5.2xвеликий |

| Лама-2-7б-чат | meta-textgeneration-llama-2-7b-f | 4096 | мл.g5.2xвеликий |

| Лама-2-13б | meta-textgeneration-llama-2-13b | 4096 | мл.g5.12xвеликий |

| Лама-2-13б-чат | meta-textgeneration-llama-2-13b-f | 4096 | мл.g5.12xвеликий |

| Лама-2-70б | meta-textgeneration-llama-2-70b | 4096 | мл.g5.48xвеликий |

| Лама-2-70б-чат | meta-textgeneration-llama-2-70b-f | 4096 | мл.g5.48xвеликий |

Зауважте, що кінцеві точки SageMaker мають обмеження часу очікування 60 с. Таким чином, навіть незважаючи на те, що модель може генерувати 4096 токенів, якщо генерація тексту займає більше 60 секунд, запит не вдасться. Для моделей 7B, 13B і 70B ми рекомендуємо встановити max_new_tokens не більше 1500, 1000 і 500 відповідно, зберігаючи загальну кількість токенів менше 4K.

Підказки для висновків і прикладів для Llama-2-70b

Ви можете використовувати моделі Llama для завершення будь-якого фрагмента тексту. За допомогою генерації тексту ви можете виконувати різноманітні завдання, наприклад відповідати на запитання, перекладати мовою, аналізувати настрої та багато іншого. Вхідне навантаження на кінцеву точку виглядає так:

Нижче наведено кілька прикладів підказок і тексту, створеного моделлю. Усі виходи генеруються з параметрами висновку {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

У наступному прикладі ми показуємо, як використовувати моделі Llama з невеликим кадровим навчанням у контексті, де ми надаємо навчальні зразки, доступні для моделі. Зауважте, що ми робимо висновки лише щодо розгорнутої моделі, і під час цього процесу ваги моделі не змінюються.

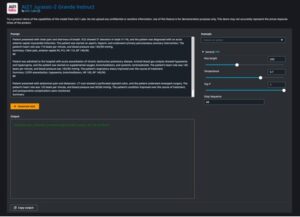

Висновки та приклади підказок для Llama-2-70b-чату

З моделями Llama-2-Chat, які оптимізовані для випадків використання діалогу, вхідними даними для кінцевих точок моделі чату є попередня історія між помічником у чаті та користувачем. Ви можете задавати питання, пов’язані з розмовою, яка відбулася до цього часу. Ви також можете надати конфігурацію системи, як-от особи, які визначають поведінку помічника в чаті. Вхідне навантаження на кінцеву точку виглядає так:

Нижче наведено кілька прикладів підказок і тексту, створеного моделлю. Усі виходи генеруються з параметрами висновку {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

У наступному прикладі користувач мав розмову з помічником про туристичні місця в Парижі. Далі користувач запитує про перший варіант, рекомендований помічником у чаті.

У наступних прикладах ми встановлюємо конфігурацію системи:

Прибирати

Після того, як ви завершите роботу блокнота, переконайтеся, що ви видалили всі ресурси, щоб усі ресурси, які ви створили в процесі, було видалено, а виставлення рахунків припинено:

Висновок

У цій публікації ми показали вам, як почати роботу з моделями Llama 2 у SageMaker Studio. Завдяки цьому ви маєте доступ до шести моделей основи Llama 2, які містять мільярди параметрів. Оскільки базові моделі проходять попередню підготовку, вони також можуть допомогти знизити витрати на навчання та інфраструктуру, а також уможливити налаштування для вашого випадку використання. Щоб розпочати роботу з SageMaker JumpStart, відвідайте такі ресурси:

Про авторів

Джун Вон є менеджером із продуктів SageMaker JumpStart. Він зосереджується на тому, щоб базові моделі легко знаходити та використовувати, щоб допомогти клієнтам створювати генеративні додатки ШІ. Його досвід роботи в Amazon також включає мобільний додаток для покупок і доставку «останньої милі».

Джун Вон є менеджером із продуктів SageMaker JumpStart. Він зосереджується на тому, щоб базові моделі легко знаходити та використовувати, щоб допомогти клієнтам створювати генеративні додатки ШІ. Його досвід роботи в Amazon також включає мобільний додаток для покупок і доставку «останньої милі».

Доктор Вівек Мадан є прикладним науковцем у команді Amazon SageMaker JumpStart. Він отримав ступінь доктора філософії в Університеті Іллінойсу в Урбана-Шампейн і був науковим співробітником у технічному університеті Джорджії. Він є активним дослідником машинного навчання та розробки алгоритмів і публікував статті на конференціях EMNLP, ICLR, COLT, FOCS і SODA.

Доктор Вівек Мадан є прикладним науковцем у команді Amazon SageMaker JumpStart. Він отримав ступінь доктора філософії в Університеті Іллінойсу в Урбана-Шампейн і був науковим співробітником у технічному університеті Джорджії. Він є активним дослідником машинного навчання та розробки алгоритмів і публікував статті на конференціях EMNLP, ICLR, COLT, FOCS і SODA.  Доктор Кайл Ульріх є прикладним науковцем у команді Amazon SageMaker JumpStart. Його дослідницькі інтереси включають масштабовані алгоритми машинного навчання, комп’ютерне бачення, часові ряди, байєсівські непараметричні процеси та процеси Гаусса. Його доктор філософії отримав в Університеті Дьюка, і він опублікував статті в NeurIPS, Cell і Neuron.

Доктор Кайл Ульріх є прикладним науковцем у команді Amazon SageMaker JumpStart. Його дослідницькі інтереси включають масштабовані алгоритми машинного навчання, комп’ютерне бачення, часові ряди, байєсівські непараметричні процеси та процеси Гаусса. Його доктор філософії отримав в Університеті Дьюка, і він опублікував статті в NeurIPS, Cell і Neuron.  Доктор Ашиш Хетан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.  Сундар Ранганатан є глобальним керівником спеціалістів GenAI/Frameworks GTM в AWS. Він зосереджується на розробці стратегії GTM для великих мовних моделей, GenAI і великомасштабних робочих навантажень машинного навчання в таких сервісах AWS, як Amazon EC2, EKS, EFA, AWS Batch і Amazon SageMaker. Його досвід включає керівні ролі в управлінні продуктами та розробці продуктів у NetApp, Micron Technology, Qualcomm і Mentor Graphics.

Сундар Ранганатан є глобальним керівником спеціалістів GenAI/Frameworks GTM в AWS. Він зосереджується на розробці стратегії GTM для великих мовних моделей, GenAI і великомасштабних робочих навантажень машинного навчання в таких сервісах AWS, як Amazon EC2, EKS, EFA, AWS Batch і Amazon SageMaker. Його досвід включає керівні ролі в управлінні продуктами та розробці продуктів у NetApp, Micron Technology, Qualcomm і Mentor Graphics.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : має

- :є

- : ні

- :де

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-градус

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Здатний

- МЕНЮ

- Прийняти

- прийнятний

- доступ

- доступність

- доступною

- За

- визнавати

- через

- активний

- додавати

- додати

- Додатковий

- адреса

- після

- знову

- проти

- Угода

- AI

- алгоритм

- алгоритми

- вирівнювати

- ВСІ

- дозволяти

- по

- Також

- завжди

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Студія Amazon SageMaker

- Amazon Web Services

- американська

- an

- аналіз

- та

- та інфраструктури

- Оголосити

- Інший

- відповідь

- будь-який

- будь

- додаток

- застосування

- прикладної

- цінувати

- відповідний

- Дуга

- архітектура

- ЕСТЬ

- Art

- AS

- допомогу

- Помічник

- At

- атмосфера

- пам'ятки

- Автоматизований

- доступний

- AWS

- Банан

- основний

- Бій

- Байєсівський

- BE

- красивий

- Краса

- стали

- оскільки

- ставати

- було

- пиво

- перед тим

- поведінка

- Пекін

- Вірити

- вважається,

- КРАЩЕ

- між

- біллінг

- Мільярд

- мільярди

- Black

- Box

- Перерва

- захоплюючи дух

- широкий

- будувати

- Створюємо

- побудований

- але

- button

- by

- званий

- CAN

- капітал

- автомобіль

- карта

- карусель

- випадок

- випадків

- КПП

- зміна

- шоколад

- Вибирати

- Вибираючи

- Місто

- classic

- код

- збір

- комбінований

- комбінати

- приходить

- майбутній

- комерційний

- компанія

- завершення

- комп'ютер

- Комп'ютерне бачення

- конференції

- впевнений

- конфігурація

- вважається

- постійна

- будівництво

- містити

- Контейнер

- містить

- зміст

- контекстуальний

- продовжувати

- постійно

- контроль

- управління

- Зручний

- Розмова

- витрати

- країна

- мужність

- обкладинка

- створювати

- створений

- Креатив

- культурний

- культура

- Чашка

- Клієнти

- настройка

- налаштувати

- дані

- безпеку даних

- присвячених

- відданість

- дефолт

- визначати

- доставка

- розгортання

- розгорнути

- розгортання

- розгортання

- розгортає

- дизайн

- призначений

- бажаний

- призначення

- напрямки

- деталі

- розвивати

- розвиненою

- Розробник

- розвивається

- розробка

- Діалог

- різниця

- різний

- важкий

- відкрити

- відмітний

- do

- документальні фільми

- справи

- зроблений

- Не знаю

- подвоєний

- вниз

- Герцог

- герцогський університет

- під час

- e

- кожен

- Раніше

- легко

- легко

- Едвард

- Einstein

- або

- включіть

- дозволяє

- кінець

- кінець в кінець

- Кінцева точка

- Машинобудування

- англійська

- користуватися

- досить

- забезпечувати

- Навколишнє середовище

- обладнання

- Ефір

- Навіть

- Події

- все

- приклад

- Приклади

- збуджений

- досвід

- експеримент

- Експерименти

- експрес

- FAIL

- не вдалося

- ярмарок

- false

- сім'я

- знаменитий

- далеко

- подвиг

- ознаками

- риси

- зворотний зв'язок

- ноги

- кілька

- фільми

- остаточний

- в кінці кінців

- знайти

- Перший

- Флагман

- Поплавок

- Потоки

- фокусується

- після

- для

- Вперед

- знайдений

- фонд

- чотири

- Франція

- французька

- від

- повністю

- далі

- майбутнє

- Загальне

- породжувати

- генерується

- покоління

- генеративний

- Генеративний ШІ

- Грузія

- отримати

- Давати

- скло

- Глобальний

- Go

- буде

- графіка

- великий

- великий

- новаторський

- Рости

- керівництво

- керівництво

- було

- Ручки

- сталося

- щасливий

- Жорсткий

- важка робота

- Мати

- має

- he

- голова

- допомога

- допомогу

- допомагає

- тут

- hi

- Високий

- вище

- його

- історичний

- історія

- житло

- Як

- How To

- HTML

- HTTPS

- Концентратор

- людина

- i

- знакових

- ідея

- if

- ii

- Іллінойс

- Impact

- імпорт

- важливо

- вражаючий

- in

- включати

- includes

- У тому числі

- Зареєстрований

- інформація

- Інфраструктура

- спочатку

- вхід

- натхненний

- надихаючий

- екземпляр

- негайно

- інструкції

- інтегрований

- призначених

- інтереси

- інтерфейс

- в

- ізольований

- IT

- ЙОГО

- подорож

- JPG

- просто

- зберігання

- збережений

- ключ

- Дитина

- Знати

- відомий

- посадка

- орієнтир

- мова

- великий

- масштабний

- найбільших

- останній

- Пізно

- запуск

- Законодавство

- Керівництво

- УЧИТЬСЯ

- Вчіться та зростайте

- вивчення

- найменш

- менше

- рівні

- ліцензія

- життя

- світло

- як

- МЕЖА

- списки

- літератури

- ll

- Лама

- логіка

- Довго

- багато часу

- шукати

- ВИГЛЯДИ

- любов

- улюблене

- знизити

- машина

- навчання за допомогою машини

- made

- зробити

- РОБОТИ

- Робить

- управління

- менеджер

- багато

- чудо

- Матерія

- максимальний

- Може..

- сенс

- вимір

- Медіа

- середа

- згаданий

- повідомлення

- Meta

- micron

- хвилин

- хвилин

- суміш

- ML

- MLOps

- Mobile

- модель

- Моделі

- момент

- місяців

- більше

- найбільш

- Найбільш популярний

- рух

- фільм

- багато

- музей

- Музеї

- музика

- ім'я

- Природний

- необхідно

- Необхідність

- необхідний

- мережу

- Нові

- Нью-Йорк

- наступний

- немає

- ноутбук

- зараз

- номер

- численний

- NY

- of

- пропонувати

- пропонує

- Пропозиції

- Нафта

- on

- один раз

- ONE

- тільки

- відкрити

- з відкритим вихідним кодом

- Оптимізувати

- оптимізований

- варіант

- or

- Інше

- інші

- інакше

- наші

- з

- вихід

- над

- загальний

- сторінка

- пар

- Папір

- документи

- параметр

- параметри

- Паріс

- частина

- проходити

- Пройшов

- проходить

- Минуле

- світ

- Виконувати

- продуктивність

- постійний

- телефон

- фотографії

- Фізика

- частина

- Піца

- пластик

- plato

- Інформація про дані Платона

- PlatoData

- грав

- політика

- спливаючий

- популярний

- пошта

- поштовий

- Прогноз

- переваги

- підготовка

- представити

- попередній

- процес

- процеси

- Product

- розробка продукту

- Управління продуктом

- менеджер по продукції

- Пропозиції

- гордий

- забезпечувати

- за умови

- забезпечує

- забезпечення

- громадськість

- громадський транспорт

- публічно

- опублікований

- мета

- put

- Python

- Qualcomm

- питань

- Швидко

- швидко

- Пандуси

- випадковість

- діапазон

- ранжування

- готовий

- Причини

- отримати

- рецепт

- рекомендувати

- рекомендований

- відноситься

- Незалежно

- райони

- відносний

- відносності

- повторний

- представляти

- запросити

- Вимагається

- дослідження

- дослідник

- ресурси

- відповідно

- Реагувати

- REST

- результат

- результати

- Річка

- Роль

- ролі

- прогін

- біг

- s

- Безпека

- мудрець

- сіль

- то ж

- масштабовані

- шкала

- вчений

- Вчені

- Sdk

- SEA

- Пошук

- Грати короля карти - безкоштовно Nijumi логічна гра гри

- розділ

- безпечний

- безпеку

- побачити

- бачачи

- здавалося

- обраний

- вибирає

- вибір

- послати

- старший

- настрій

- Серія

- Послуги

- виступаючої

- комплект

- установка

- Форма

- Акула

- покупка

- Повинен

- Показувати

- показав

- Шоу

- закриття

- значення

- значний

- простий

- просто

- один

- сайт

- сайти

- SIX

- Розмір

- Повільно

- невеликий

- So

- так далеко

- соціальна

- соціальні медіа

- Рішення

- деякі

- Source

- Джерела

- спеціальний

- Фахівці

- зазначений

- швидкість

- стенди

- старт

- почалася

- стан

- Штати

- статистичний

- Крок

- заходи

- зупинений

- Стратегія

- рядок

- структура

- студія

- Приголомшливий

- тема

- наступні

- успіх

- Успішно

- такі

- Підтриманий

- Переконайтеся

- символ

- система

- таблиця

- Приймати

- приймає

- завдання

- ключі

- команда

- технології

- Технологія

- тимчасовий

- terms

- ніж

- Дякую

- Що

- Команда

- Капітал

- Майбутнє

- Джерело

- світ

- їх

- Їх

- теорія

- Там.

- Ці

- вони

- речі

- думати

- це

- хоча?

- через

- Тигр

- час

- Часовий ряд

- times

- назва

- до

- сьогодні

- разом

- знак

- Жетони

- інструменти

- топ

- Усього:

- Башта

- поїзд

- Навчання

- трансформатор

- переводити

- Переклад

- транспорт

- трильйон

- намагатися

- два

- тип

- Типи

- ui

- при

- незабутнє

- створеного

- університет

- до

- Оновити

- Updates

- корисний

- використання

- використання випадку

- використовуваний

- користувач

- користувачі

- використовує

- використання

- значення

- Цінності

- різноманітність

- версія

- версії

- дуже

- через

- вид

- думки

- бачення

- візит

- відвідувачів

- обсяг

- хотів

- війна

- було

- we

- Web

- веб-сервіси

- Web-Based

- веб-сайт

- ДОБРЕ

- Кит

- Що

- Що таке

- коли

- в той час як

- який

- в той час як

- чому

- волі

- windows

- з

- слово

- слова

- Work

- працює

- світ

- всесвітньо відомий

- обернути

- років

- йорк

- Ти

- вашу

- себе

- зефірнет

- Zip