Сьогодні ми раді повідомити, що базова модель OpenAI Whisper доступна для користувачів Amazon SageMaker JumpStart. Whisper — це попередньо навчена модель для автоматичного розпізнавання мовлення (ASR) і перекладу мовлення. Напрацьовані на 680 тисячах годин помічених даних моделі Whisper демонструють потужну здатність узагальнювати багато наборів даних і доменів без необхідності тонкого налаштування. Sagemaker JumpStart — це центр машинного навчання (ML) SageMaker, який надає доступ до основних моделей на додаток до вбудованих алгоритмів і наскрізних шаблонів рішень, щоб допомогти вам швидко розпочати роботу з ML.

Ви також можете виконувати ASR за допомогою Амазонська розшифровка , повністю керована служба автоматичного розпізнавання мовлення з постійним навчанням.

У цій публікації ми покажемо вам, як розгорнути OpenAI Whisper модель і викликати модель для транскрибування та перекладу аудіо.

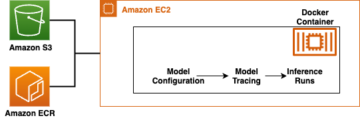

Модель OpenAI Whisper використовує huggingface-pytorch-inference контейнер. Як клієнт центру моделей SageMaker JumpStart ви можете використовувати ASR без необхідності підтримувати сценарій моделі за межами SDK SageMaker. Моделі SageMaker JumpStart також покращують рівень безпеки завдяки кінцевим точкам, які забезпечують ізоляцію мережі.

Моделі основи в SageMaker

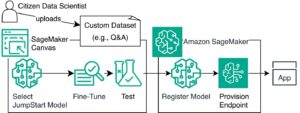

SageMaker JumpStart надає доступ до ряду моделей із популярних центрів моделювання, зокрема Hugging Face, PyTorch Hub і TensorFlow Hub, які ви можете використовувати в процесі розробки ML у SageMaker. Нещодавні досягнення в ML дали початок новому класу моделей, відомих як моделі фундаменту, які зазвичай навчаються на мільярдах параметрів і можуть бути адаптовані до широкої категорії випадків використання, таких як узагальнення тексту, створення цифрового мистецтва та мовний переклад. Оскільки навчання цих моделей є дорогим, клієнти хочуть використовувати існуючі попередньо навчені базові моделі та налаштовувати їх за потреби, а не навчати ці моделі самостійно. SageMaker надає підібраний список моделей, які можна вибрати на консолі SageMaker.

Тепер ви можете знайти моделі основи від різних постачальників моделей у SageMaker JumpStart, що дає змогу швидко розпочати роботу з моделями основи. SageMaker JumpStart пропонує базові моделі на основі різних завдань або постачальників моделей, і ви можете легко переглянути характеристики моделі та умови використання. Ви також можете спробувати ці моделі за допомогою тестового віджета інтерфейсу користувача. Якщо ви хочете використовувати базову модель у великому масштабі, ви можете зробити це, не виходячи з SageMaker, використовуючи попередньо зібрані блокноти від постачальників моделей. Оскільки моделі розміщуються та розгортаються на AWS, ви вірите, що ваші дані, незалежно від того, чи використовуються вони для оцінки чи використання моделі в масштабі, не будуть передані третім особам.

Основні моделі OpenAI Whisper

Whisper — це попередньо навчена модель для ASR і перекладу мовлення. У статті було запропоновано Шепіт Надійне розпізнавання мовлення за допомогою широкомасштабного слабкого контролю Алек Редфорд та інші з OpenAI. Оригінальний код можна знайти у цьому репозиторії GitHub.

Whisper — це модель кодера-декодера на основі Transformer, яку також називають a послідовність до послідовності модель. Він був навчений на 680 тисячах годин мічених мовних даних, анотованих за допомогою широкомасштабного слабкого спостереження. Моделі Whisper демонструють потужну здатність узагальнювати багато наборів даних і доменів без необхідності тонкого налаштування.

Моделі тренувалися на даних лише англійською мовою або на багатомовних даних. Моделі, які володіють лише англійською мовою, навчалися розпізнаванню мовлення. Багатомовні моделі були навчені розпізнаванню мовлення та перекладу мовлення. Для розпізнавання мовлення модель передбачає транскрипції в то ж мова як аудіо. Для перекладу мовлення модель передбачає транскрипцію в a різний мову до аудіо.

Контрольно-пропускні пункти Whisper поставляються в п’яти конфігураціях різних розмірів моделей. Четверо найменших навчаються на даних лише англійською або багатомовними. Найбільші пункти пропуску лише багатомовні. Усі десять попередньо підготовлених контрольно-пропускних пунктів доступні на Hugging Face хаб. Контрольні точки підсумовано в наведеній нижче таблиці з посиланнями на моделі на хабі:

| назва моделі | Кількість параметрів | Багатомовний |

| шепіт-малесенький | 39 M | Так |

| шепіт-основа | 74 M | Так |

| шепіт-мал | 244 M | Так |

| шепіт-середній | 769 M | Так |

| шепіт-великий | 1550 M | Так |

| whisper-large-v2 | 1550 M | Так |

Давайте дослідимо, як можна використовувати моделі Whisper у SageMaker JumpStart.

Основні моделі OpenAI Whisper WER і порівняння затримок

Частота помилок у словах (WER) для різних моделей OpenAI Whisper на основі LibriSpeech test-clean показано в наступній таблиці. WER — це загальний показник продуктивності системи розпізнавання мовлення або машинного перекладу. Він вимірює різницю між еталонним текстом (основна істина або правильна транскрипція) і виводом системи ASR з точки зору кількості помилок, включаючи заміни, вставки та видалення, які необхідні для перетворення виводу ASR у еталонний текст. Ці цифри були взяті з Обіймати обличчя .

| Model | WER (відсоток) |

| шепіт-малесенький | 7.54 |

| шепіт-основа | 5.08 |

| шепіт-мал | 3.43 |

| шепіт-середній | 2.9 |

| шепіт-великий | 3 |

| whisper-large-v2 | 3 |

Для цього блогу ми взяли наведений нижче аудіофайл і порівняли затримку розпізнавання мовлення в різних моделях шепоту. Затримка — це проміжок часу з моменту, коли користувач надсилає запит, до моменту, коли ваша програма вкаже, що запит виконано. Цифри в наведеній нижче таблиці представляють середню затримку для загалом 100 запитів із використанням того самого аудіофайлу з моделлю, розміщеною на примірнику ml.g5.2xlarge.

| Model | Середня затримка | Вихід моделі |

| шепіт-малесенький | 0.43 | Ми живемо в дуже цікаві часи з машинним освітленням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не дійдете до того стану, що ми виграли, у найближчі роки. Якщо ми не зробимо ці моделі доступнішими для всіх. |

| шепіт-основа | 0.49 | Ми живемо в дуже цікаві часи з машинним навчанням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не дійдете до того стану, що ми виграли, у найближчі роки. Якщо ми не зробимо ці моделі доступнішими для всіх. |

| шепіт-мал | 0.84 | Ми живемо в дуже цікаві часи з машинним навчанням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не досягнете того кінцевого стану, якого ми хочемо, у найближчі роки, якщо ми не зробимо ці моделі доступнішими для всіх. |

| шепіт-середній | 1.5 | Ми живемо в дуже цікаві часи з машинним навчанням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не досягнете того кінцевого стану, якого ми хочемо, у найближчі роки, якщо ми не зробимо ці моделі доступнішими для всіх. |

| шепіт-великий | 1.96 | Ми живемо в дуже цікаві часи з машинним навчанням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не досягнете того кінцевого стану, якого ми хочемо, у найближчі роки, якщо ми не зробимо ці моделі доступнішими для всіх. |

| whisper-large-v2 | 1.98 | Ми живемо в дуже цікаві часи з машинним навчанням. Швидкість розробки моделі ML дійсно збільшиться. Але ви не досягнете того кінцевого стану, якого ми хочемо, у найближчі роки, якщо ми не зробимо ці моделі доступнішими для всіх. |

Покрокове керівництво

Ви можете розгортати моделі Whisper за допомогою консолі Amazon SageMaker або за допомогою Amazon SageMaker Notebook. У цій публікації ми демонструємо, як розгорнути Whisper API за допомогою консолі SageMaker Studio або SageMaker Notebook, а потім використовувати розгорнуту модель для розпізнавання мовлення та мовного перекладу. Код, використаний у цій публікації, можна знайти в цей блокнот GitHub.

Давайте детально розглянемо кожен крок.

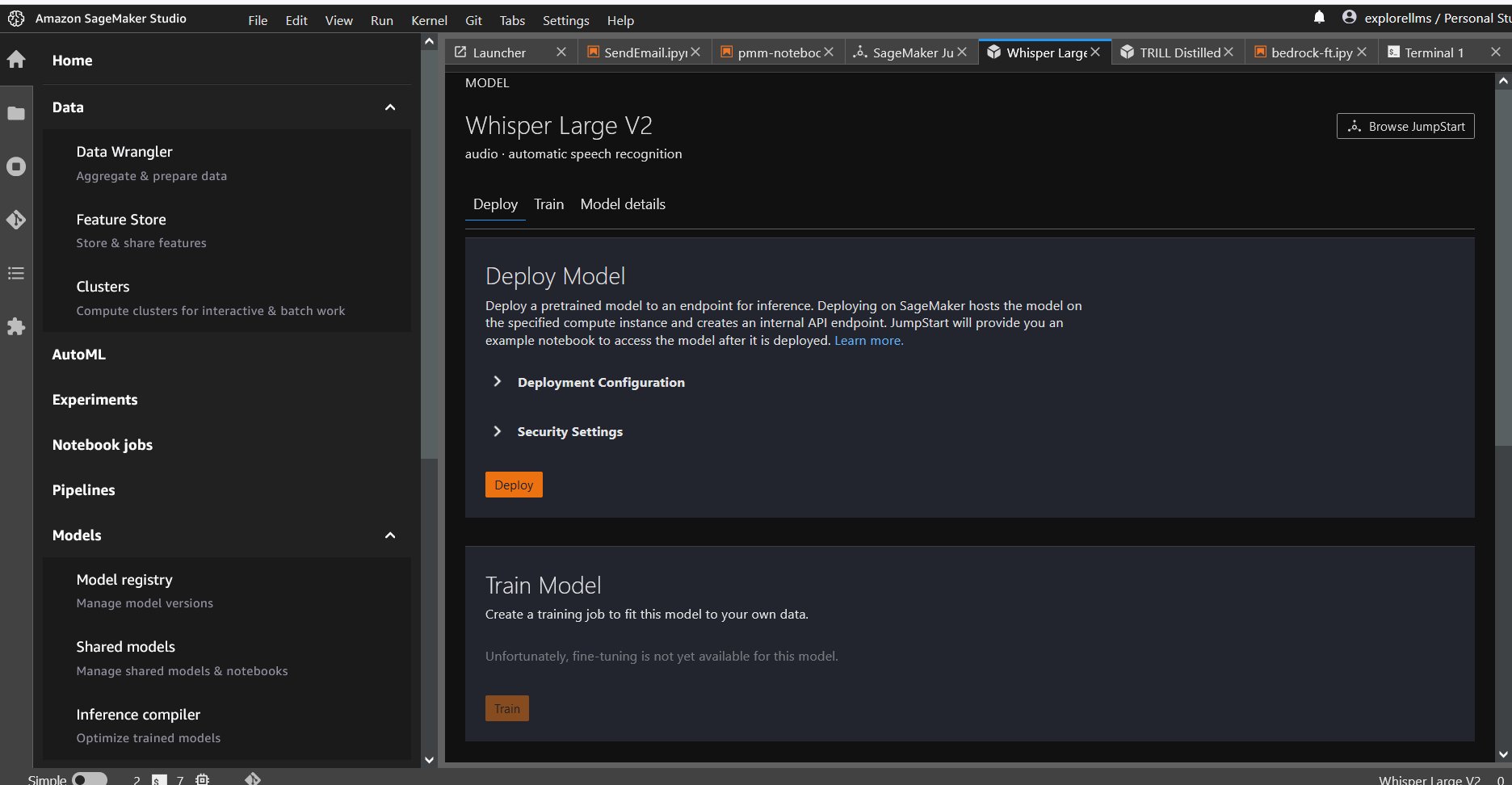

Розгорніть Whisper з консолі

- Щоб розпочати роботу з SageMaker JumpStart, відкрийте консоль Amazon SageMaker Studio, перейдіть на сторінку запуску SageMaker JumpStart і виберіть Почніть роботу з JumpStart.

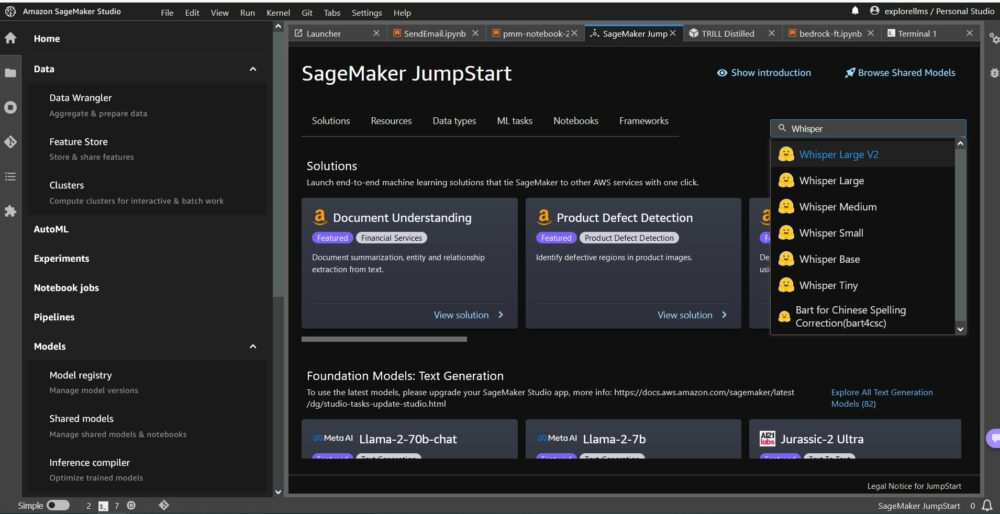

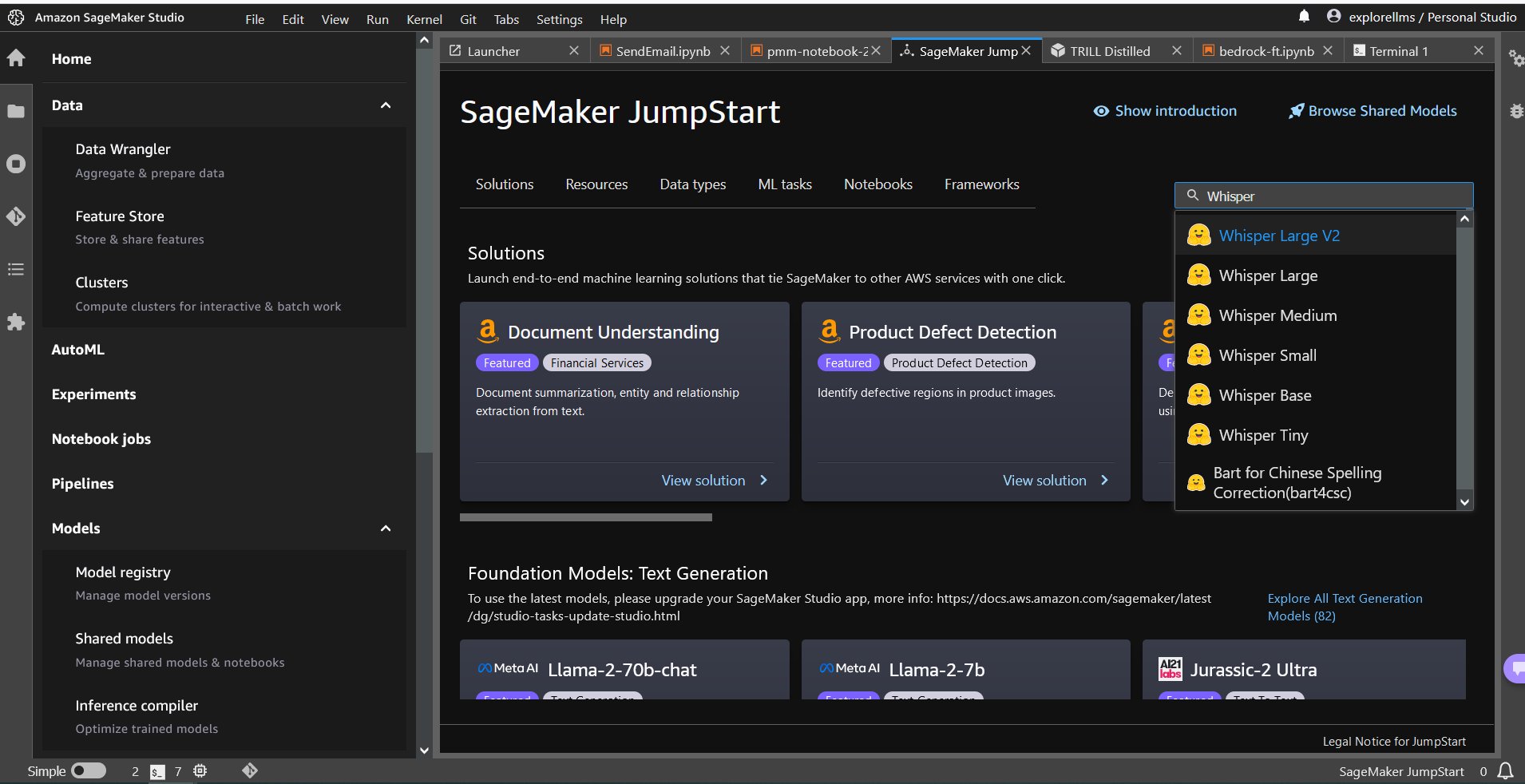

- Щоб вибрати модель Whisper, ви можете скористатися вкладками вгорі або скористатись полем пошуку у верхньому правому куті, як показано на наступному знімку екрана. Для цього прикладу скористайтеся полем пошуку у верхньому правому куті та введіть

Whisper, а потім виберіть відповідну модель Whisper зі спадного меню.

- Після вибору моделі Whisper можна використовувати консоль для розгортання моделі. Ви можете вибрати екземпляр для розгортання або використовувати стандартний.

Розгорніть базову модель із ноутбука Sagemaker

Кроки, щоб спочатку розгорнути, а потім використовувати розгорнуту модель для вирішення різних завдань:

- Створювати

- Виберіть модель

- Отримайте артефакти та розгорніть кінцеву точку

- Використовуйте розгорнуту модель для ASR

- Використовуйте розгорнуту модель для мовного перекладу

- Очистіть кінцеву точку

Створювати

Цей блокнот було протестовано на примірнику ml.t3.medium у SageMaker Studio з ядром Python 3 (наука про дані) та в примірнику Amazon SageMaker Notebook із conda_python3 ядро

Виберіть попередньо навчену модель

Налаштуйте сеанс SageMaker за допомогою Boto3, а потім виберіть ідентифікатор моделі, яку потрібно розгорнути.

Отримайте артефакти та розгорніть кінцеву точку

Використовуючи SageMaker, ви можете робити висновок на попередньо навченій моделі, навіть без попереднього тонкого налаштування на новому наборі даних. Щоб розмістити попередньо навчену модель, створіть екземпляр sagemaker.model.Model і розгорнути його. Наступний код використовує екземпляр за замовчуванням ml.g5.2xlarge для кінцевої точки висновку моделі whisper-large-v2. Ви можете розгорнути модель на інших типах екземплярів шляхом передачі instance_type в JumpStartModel клас. Розгортання може зайняти кілька хвилин.

Автоматичне розпізнавання мовлення

Далі ви читаєте зразок аудіофайлу, sample1.wav, із публічного сайту SageMaker Jumpstart Служба простого зберігання Amazon (Amazon S3) розташування та передайте його до провісник для розпізнавання мовлення. Ви можете замінити цей файл зразка будь-яким іншим зразком аудіофайлу, але переконайтеся, що файл .wav має частоту дискретизації 16 кГц, оскільки це вимагається моделями автоматичного розпізнавання мовлення. Вхідний аудіофайл має бути менше 30 секунд.

Ця модель підтримує багато параметрів під час виконання логічного висновку. Вони включають:

max_length: Модель генерує текст до вихідної довжини. Якщо вказано, воно має бути додатним цілим числом.- мова та завдання: тут вкажіть мову виведення та завдання. Модель підтримує завдання транскрипції або перекладу.

max_new_tokens: Максимальна кількість токенів для генерації.num_return_sequences: кількість повернених вихідних послідовностей. Якщо вказано, воно має бути додатним цілим числом.num_beams: кількість променів, використаних у жадібному пошуку. Якщо вказано, воно має бути цілим числом, більшим або рівнимnum_return_sequences.no_repeat_ngram_size: Модель гарантує, що послідовність слівno_repeat_ngram_sizeне повторюється у вихідній послідовності. Якщо вказано, воно має бути додатним цілим числом, більшим за 1.- температура: це контролює випадковість виведення. Вища температура призводить до вихідної послідовності зі словами з низькою ймовірністю, а нижча температура призводить до вихідної послідовності зі словами з високою ймовірністю. Якщо температура наближається до 0, це призводить до жадібного декодування. Якщо вказано, це має бути позитивне плаваюче значення.

early_stopping: ЯкщоTrueгенерація тексту завершується, коли всі гіпотези променя досягають кінця маркера речення. Якщо вказано, воно має бути логічним.do_sample: ЯкщоTrue, спробуйте наступне слово для ймовірності. Якщо вказано, воно має бути логічним.top_k: на кожному кроці створення тексту вибирайте лише зtop_kшвидше за все слова. Якщо вказано, воно має бути додатним цілим числом.top_p: на кожному кроці генерації тексту вибирайте з найменшого можливого набору слів із сукупною ймовірністюtop_p. Якщо вказано, це має бути число з плаваючою речовиною між 0 і 1.

Ви можете вказати будь-яку підмножину попередніх параметрів під час виклику кінцевої точки. Далі ми покажемо вам приклад того, як викликати кінцеву точку з цими аргументами.

Мовний переклад

Щоб продемонструвати переклад мови за допомогою моделей Whisper, скористайтеся наведеним нижче аудіофайлом французькою мовою та перекладіть його англійською. Файл має бути дискретизований із частотою 16 кГц (відповідно до вимог моделей ASR), тому за потреби обов’язково повторно дискретизуйте файли та переконайтеся, що ваші зразки не перевищують 30 секунд.

- Завантажити

sample_french1.wavвід SageMaker JumpStart із загальнодоступного розташування S3, щоб його можна було передати в корисному навантаженні для перекладу моделлю Whisper.

- Встановіть параметр завдання як

translateі мова якFrenchщоб змусити модель Whisper виконувати переклад мовлення. - Скористайтесь провісник передбачити переклад мови. Якщо ви отримуєте помилку клієнта (помилка 413), перевірте розмір корисного навантаження до кінцевої точки. Корисне навантаження для запитів кінцевих точок виклику SageMaker обмежено приблизно 5 МБ.

- Текст, перекладений англійською мовою з французького аудіофайлу, наведено нижче:

Прибирати

Після перевірки кінцевої точки видаліть кінцеву точку висновку SageMaker і видаліть модель, щоб уникнути стягнення плати.

Висновок

У цій публікації ми показали вам, як тестувати та використовувати моделі OpenAI Whisper для створення цікавих програм за допомогою Amazon SageMaker. Спробуйте модель фундаменту в SageMaker сьогодні та повідомте нам свої відгуки!

Ця інструкція призначена лише для інформаційних цілей. Ви все одно повинні провести власну незалежну оцінку та вжити заходів, щоб переконатися, що ви дотримуєтеся своїх власних практик і стандартів контролю якості, а також місцевих правил, законів, постанов, ліцензій і умов використання, які стосуються вас, вашого вмісту та модель третьої сторони, на яку посилається в цьому посібнику. AWS не контролює та не має повноважень щодо моделі третьої сторони, на яку посилається в цьому посібнику, і не робить жодних заяв чи гарантій, що модель третьої сторони безпечна, не містить вірусів, працює чи сумісна з вашим робочим середовищем і стандартами. AWS не робить жодних заяв, гарантій або гарантій того, що будь-яка інформація в цьому посібнику призведе до певного результату.

Про авторів

Гемант Сінгх є прикладним науковцем із досвідом роботи в Amazon SageMaker JumpStart. Він отримав ступінь магістра в Інституті математичних наук ім. Куранта та ступінь бакалавра технічних наук в IIT Делі. Він має досвід роботи над різноманітними проблемами машинного навчання в області обробки природної мови, комп’ютерного зору та аналізу часових рядів.

Гемант Сінгх є прикладним науковцем із досвідом роботи в Amazon SageMaker JumpStart. Він отримав ступінь магістра в Інституті математичних наук ім. Куранта та ступінь бакалавра технічних наук в IIT Делі. Він має досвід роботи над різноманітними проблемами машинного навчання в області обробки природної мови, комп’ютерного зору та аналізу часових рядів.

Рачна Чадха є головним архітектором рішень AI/ML у Strategic Accounts в AWS. Рахна — оптиміст, який вірить, що етичне та відповідальне використання ШІ може покращити суспільство в майбутньому та принести економічне та соціальне процвітання. У вільний час Рачна любить проводити час з сім'єю, гуляти в походах і слухати музику.

Рачна Чадха є головним архітектором рішень AI/ML у Strategic Accounts в AWS. Рахна — оптиміст, який вірить, що етичне та відповідальне використання ШІ може покращити суспільство в майбутньому та принести економічне та соціальне процвітання. У вільний час Рачна любить проводити час з сім'єю, гуляти в походах і слухати музику.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/whisper-models-for-automatic-speech-recognition-now-available-in-amazon-sagemaker-jumpstart/

- : має

- :є

- : ні

- $UP

- 1

- 10

- 100

- 12

- 14

- 15%

- 150

- 16

- 30

- 7

- 8

- 9

- a

- здатність

- МЕНЮ

- доступ

- доступною

- Рахунки

- через

- активний

- насправді

- доповнення

- аванси

- AI

- AI / ML

- алгоритми

- ВСІ

- Також

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Студія Amazon SageMaker

- Amazon Web Services

- кількість

- an

- аналіз

- та

- Оголосити

- будь-який

- API

- додаток

- застосування

- прикладної

- Застосовувати

- підходи

- відповідний

- ЕСТЬ

- аргументація

- Art

- AS

- оцінка

- At

- аудіо

- влада

- автоматичний

- доступний

- середній

- уникнути

- AWS

- заснований

- BE

- Промінь

- оскільки

- було

- вважає,

- нижче

- між

- мільярди

- Блог

- Box

- приносити

- будувати

- вбудований

- але

- by

- CAN

- випадків

- Категорія

- характеристика

- вантажі

- перевірка

- Вибирати

- клас

- клієнт

- код

- Приходити

- майбутній

- загальний

- порівняний

- сумісний

- Зроблено

- дотримуватися

- комп'ютер

- Комп'ютерне бачення

- конференції

- Консоль

- Контейнер

- зміст

- постійно

- контроль

- управління

- виправити

- створювати

- Куратор

- клієнт

- Клієнти

- дані

- наука про дані

- набори даних

- Декодування

- дефолт

- Делі

- демонструвати

- розгортання

- розгорнути

- розгортання

- деталь

- розвивати

- розвиненою

- розробка

- різниця

- різний

- цифровий

- цифрове мистецтво

- Різне

- do

- робить

- домен

- домени

- Не знаю

- кожен

- легко

- або

- співробітників

- включіть

- дозволяє

- кінець

- кінець в кінець

- Кінцева точка

- англійська

- забезпечувати

- гарантує

- Що натомість? Створіть віртуальну версію себе у

- Навколишнє середовище

- рівним

- помилка

- помилки

- етичний

- оцінки

- Навіть

- всі

- приклад

- перевищувати

- збуджений

- захоплюючий

- існуючий

- Розширювати

- дорогий

- досвід

- дослідити

- Face

- сім'я

- кілька

- філе

- Файли

- знайти

- Перший

- п'ять

- Поплавок

- після

- слідує

- для

- Примусово

- знайдений

- фонд

- чотири

- французька

- від

- майбутнє

- породжувати

- генерує

- породжує

- покоління

- отримати

- GitHub

- даний

- Go

- є

- великий

- Жадібний

- Земля

- гарантії

- керівництво

- Мати

- має

- he

- допомога

- допомагає

- її

- тут

- вище

- його

- господар

- відбувся

- ГОДИННИК

- Як

- How To

- HTML

- HTTPS

- Концентратор

- концентратори

- ID

- if

- Іллінойс

- імпорт

- удосконалювати

- in

- включати

- У тому числі

- Augmenter

- незалежний

- вказує

- інформація

- Інформаційний

- вхід

- встановлювати

- екземпляр

- Інститут

- цікавий

- в

- ізоляція

- IT

- JPG

- json

- Знати

- відомий

- мова

- масштабний

- найбільших

- Затримка

- запуск

- Законодавство

- вивчення

- догляд

- довжина

- менше

- дозволяти

- ліцензії

- Освітлення

- ймовірність

- Ймовірно

- Сподобалося

- обмеженою

- зв'язку

- список

- Прослуховування

- життя

- місцевий

- розташування

- знизити

- машина

- навчання за допомогою машини

- підтримувати

- зробити

- багато

- математичний

- максимальний

- заходи

- середа

- Меню

- метрика

- може бути

- хвилин

- ML

- модель

- Моделі

- момент

- більше

- найбільш

- музика

- повинен

- Природний

- Обробка природних мов

- Необхідність

- необхідний

- мережу

- Нові

- наступний

- немає

- ніхто

- ноутбук

- зараз

- номер

- номера

- of

- Пропозиції

- on

- тільки

- відкрити

- OpenAI

- оперативний

- or

- оригінал

- Інше

- інші

- з

- Результат

- вихід

- поза

- над

- власний

- сторінка

- документи

- параметр

- параметри

- приватність

- Сторони

- проходити

- Пройшов

- Патенти

- відсотків

- Виконувати

- продуктивність

- виконанні

- Вчений ступінь

- plato

- Інформація про дані Платона

- PlatoData

- будь ласка

- популярний

- позитивний

- це можливо

- пошта

- практики

- передбачати

- Прогноз

- Прогнози

- Головний

- проблеми

- обробка

- Production

- запропонований

- процвітання

- провайдери

- забезпечує

- громадськість

- опублікований

- цілей

- Python

- піторх

- якість

- швидко

- випадковість

- діапазон

- ставка

- швидше

- досягати

- Читати

- насправді

- отримати

- останній

- визнання

- посилання

- називають

- правила

- повторний

- замінювати

- представляти

- запросити

- запитів

- вимагається

- дослідник

- відповідь

- відповідальний

- результат

- результати

- огляд

- право

- Зростання

- Правила

- s

- мудрець

- Висновок SageMaker

- продажів

- то ж

- шкала

- наука

- НАУКИ

- вчений

- сценарій

- Sdk

- Пошук

- seconds

- безпечний

- безпеку

- посилає

- старший

- пропозиція

- Послідовність

- Серія

- обслуговування

- Послуги

- Сесія

- комплект

- загальні

- Повинен

- Показувати

- демонстрації

- показав

- показаний

- простий

- Розмір

- розміри

- So

- соціальна

- суспільство

- рішення

- ВИРІШИТИ

- конкретний

- зазначений

- мова

- Розпізнавання мови

- швидкість

- Витрати

- стандартів

- почалася

- стан

- статистичний

- Крок

- заходи

- Як і раніше

- зберігання

- Стратегічний

- сильний

- студія

- такі

- нагляд

- Опори

- Переконайтеся

- система

- таблиця

- Приймати

- прийняті

- Завдання

- завдання

- технології

- Шаблони

- десять

- тензорний потік

- terms

- тест

- перевірений

- текст

- ніж

- Що

- Команда

- концентратор

- Їх

- самі

- потім

- Ці

- вони

- третій

- треті сторони

- третя сторона

- це

- тисяча

- час

- Часовий ряд

- times

- до

- сьогодні

- знак

- Жетони

- прийняли

- топ

- Усього:

- поїзд

- навчений

- Перетворення

- переводити

- Переклад

- Довіряйте

- Правда

- намагатися

- Типи

- типово

- ui

- університет

- до

- us

- Використання

- використання

- використовуваний

- користувач

- використовує

- використання

- значення

- різний

- дуже

- через

- бачення

- хотіти

- було

- we

- Web

- веб-сервіси

- ласкаво просимо

- були

- коли

- Чи

- який

- Шепіт

- ВООЗ

- широкий

- волі

- з

- в

- без

- Виграв

- слово

- слова

- робочий

- робочий

- років

- Ти

- вашу

- зефірнет