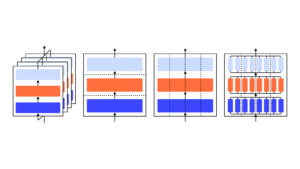

Ми показуємо, що модель GPT-3 може навчитися виражати невизначеність щодо власних відповідей природною мовою — без використання логітів моделі. Коли дається запитання, модель генерує як відповідь, так і рівень достовірності (наприклад, «90% довіри» або «висока довіра»). Ці рівні відображаються на ймовірності, які добре відкалібровані. Модель також залишається помірно відкаліброваною в умовах зміни розподілу та чутлива до невизначеності у власних відповідях, а не імітує людські приклади. Наскільки нам відомо, це перший раз, коли було показано, що модель виражає відкалібровану невизначеність щодо власних відповідей природною мовою. Для перевірки калібрування ми представляємо набір завдань CalibratedMath. Ми порівнюємо калібрування невизначеності, вираженої словами («вербалізована ймовірність»), з невизначеністю, отриманою з логітів моделі. Обидва види невизначеності здатні узагальнити калібрування при зсуві розподілу. Ми також надаємо докази того, що здатність GPT-3 узагальнювати калібрування залежить від попередньо навчених латентних уявлень, які корелюють з епістемічною невизначеністю щодо його відповідей.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. Доступ тут.

- джерело: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :є

- a

- здатність

- МЕНЮ

- та

- відповідь

- Відповіді

- ЕСТЬ

- CAN

- здатний

- порівняти

- довіра

- залежить

- розподіл

- e

- докази

- Приклади

- експрес

- виражений

- Перший

- перший раз

- для

- від

- генерує

- даний

- Високий

- HTTPS

- людина

- in

- вводити

- ЙОГО

- знання

- мова

- УЧИТЬСЯ

- рівень

- рівні

- карта

- модель

- Моделі

- Природний

- of

- on

- власний

- plato

- Інформація про дані Платона

- PlatoData

- забезпечувати

- питання

- швидше

- залишається

- s

- чутливий

- зсув

- Показувати

- показаний

- набір

- завдання

- Навчання

- Тестування

- Що

- Команда

- їх

- Ці

- час

- до

- Невизначеність

- при

- використання

- ДОБРЕ

- з

- слова

- зефірнет