Американські дослідники клімату розробили системний підхід до перенавчання алгоритмів штучного інтелекту з глибоким навчанням для роботи в різних ситуаціях. Команда виявила, що, всупереч загальноприйнятій думці, перенавчання попередніх рівнів алгоритму часто дає кращі результати, ніж перенавчання пізніших.

Глибоке навчання — це дуже просунутий, часом суперечливий тип машинного навчання, у якому комп’ютерні алгоритми навчаються важливим характеристикам системи та вчаться класифікувати її природу та прогнозувати її поведінку, часто з точністю, яка перевищує можливості людини. Мабуть, найвідомішою демонстрацією глибокого навчання в дії стала перемога програми AlphaGo від Google над гравцем-чемпіоном Лі Седолом у 2017 році. Однак глибоке навчання має більш практичне застосування: воно може передбачати згортання білка, перевіряти біопсію тканин на ранні ознаки раку. і прогнозувати погодні умови.

Однак, оскільки алгоритми глибокого навчання не програмуються зовнішнім оператором, їх також неможливо просто перепрограмувати. Натомість, якщо система змінюється, алгоритм потрібно перенавчити, використовуючи дані з нової системи. Це важливо в кліматології, якщо алгоритми глибокого навчання, навчені з використанням сучасних кліматичних умов, мають робити корисні прогнози щодо погодних умов у світі, який постраждав від зміни клімату. Цей знайомий людям процес адаптації попереднього досвіду до незнайомих ситуацій відомий комп’ютерникам як перенесення навчання.

Глибока таємниця

Кліматик Педрам Хасанзаде Університету Райса в Техасі пояснює, що алгоритми глибокого навчання обробляють інформацію в послідовності шарів. «Інформація надходить на рівень, який витягує деяку інформацію, а потім надсилає цю інформацію на інший рівень, який витягує більше інформації». Цей процес зрештою дає результат, але, як пояснює Хасанзаде, «ніхто точно не знає, яка робота кожного шару, тому що ми не розробляємо жодного з них — усі вони навчені». Трансферне навчання використовує невелику кількість доступних даних із нового набору даних для перепідготовки одного (або кількох) із цих рівнів, і Хасанзаде каже, що «важливо, який рівень ви оберете».

Традиційна мудрість, каже він, диктує, що особливості проблеми опрацьовуються в найглибших шарах мережі (тих шарах, найближчих до виходу). Таким чином, щоб виконати перехідне навчання, їх найкраще перенавчати. «Те, що було зроблено в минулому, полягає в тому, що, скажімо, Google навчає тисячошарову мережу на Google Images, а потім хтось приносить невелику кількість рентгенівських знімків, тому вони перенавчають шари 998 і 999», — пояснює Хасанзаде. Тепер він і його колеги замість цього застосували системний підхід.

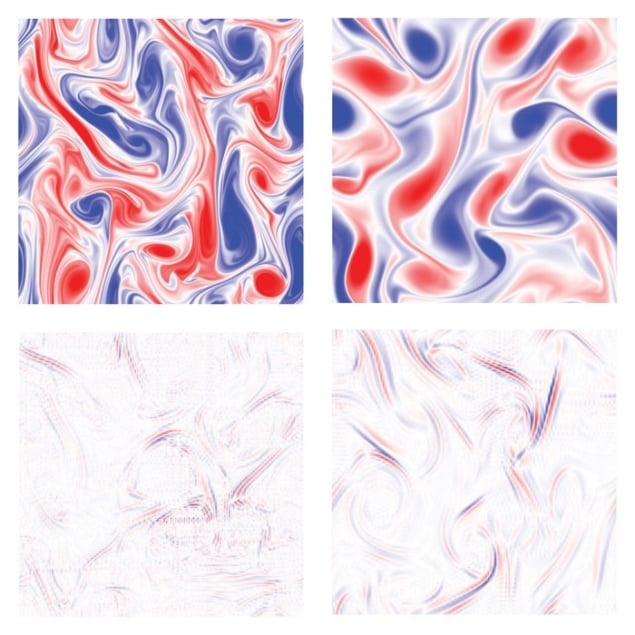

Дослідники з високою роздільною здатністю моделювали поведінку рідин за трьох різних наборів умов. Вони використали ці дані для навчання трьох 10-рівневих алгоритмів глибокого навчання для прогнозування поведінки рідин за кожним із цих конкретних параметрів. Вони змінили деякі параметри, такі як число Рейнольдса (відношення сил інерції до сил в’язкості) або завихреність рідини в кожному випадку, і провели інший набір моделювання з високою роздільною здатністю, щоб передбачити поведінку нових рідин. У кожному з трьох випадків вони навчали ті самі алгоритми на нових даних. Нарешті, вони провели навчання передачі старих алгоритмів на невеликій підмножині нових даних, дивлячись на ефект перенавчання кожного рівня та порівнюючи продуктивність перенавченого старого алгоритму з алгоритмом, який було навчено з нуля на нових даних.

Перепідготовка неглибоких відводків

Результати були несподіваними. «У цій статті ми виявили, що найдрібніші шари найкраще підлягають перенавчанню», — каже Хасанзаде. Маючи доступ до передбачуваного сигналу, отриманого шляхом повторного навчання кожного шару, вони по черзі дали їм вікно в ефект, який кожен рівень мав на цей кінцевий сигнал. Тому вони просто використали спектральний аналіз кожного сигналу, щоб побачити, як кожен рівень змінює кожну наявну частоту. Деякі рівні контролювали низькі частоти, і було корисно перенавчати їх, оскільки вони фіксували плавно змінювані макроскопічні особливості алгоритму. Інші рівні тим часом передбачали деталі, і перенавчання лише ними було майже марним. Дослідники надали протокол для визначення найважливіших рівнів у будь-якому конкретному випадку. «Ми не хотіли сказати, що в цій статті ми маємо емпіричне правило», — каже Хасанзаде. «Тепер ми знайшли системи, де, наприклад, середній рівень є найкращим [для перенавчання]».

Штучний інтелект спрощує розрахунки електронних властивостей

Команда описує роботу в статті, опублікованій у PNAS Nexus.

«Я вважаю, що це дійсно цікава стаття», — каже астрофізик і експерт з машинного навчання Ширлі Хо Інституту Флетайрона в Нью-Йорку. Вона додає: «З іншого боку, у багатьох інших наукових дисциплінах ми вже давно використовуємо спектральний аналіз, тож я думаю, що питання полягає в тому, чи є його застосування до багатьох шарів значним внеском. У мене таке відчуття, що це, мабуть, одна з тих речей, які були в головах людей, але ніхто цього не написав. Це може бути одна з тих чудових статей, де, як тільки ви це скажете, це стане очевидним для всіх».

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. Доступ тут.

- джерело: https://physicsworld.com/a/new-approach-retrains-deep-neural-networks-to-deal-with-changes-in-complex-systems/

- 2017

- a

- МЕНЮ

- доступ

- Досягає

- дію

- Додає

- просунутий

- алгоритм

- алгоритми

- ВСІ

- тільки

- кількість

- аналіз

- та

- Інший

- застосування

- Застосування

- підхід

- штучний

- штучний інтелект

- доступний

- оскільки

- КРАЩЕ

- Краще

- дно

- Приносить

- розрахунки

- рак

- не може

- можливості

- випадок

- випадків

- чемпіон

- зміна

- Зміни

- Місто

- клімат

- Зміна клімату

- колеги

- порівняння

- комплекс

- комп'ютер

- Умови

- навпаки

- внесок

- управління

- спірний

- звичайний

- дані

- набір даних

- угода

- глибокий

- глибоке навчання

- найглибший

- дизайн

- деталі

- визначення

- розвиненою

- диктує

- Відмінності

- різний

- Не знаю

- під час

- кожен

- Раніше

- Рано

- ефект

- або

- Electronic

- врешті-решт

- точно

- приклад

- досвід

- експерт

- Пояснює

- зовнішній

- Виписки

- знайомий

- знаменитий

- риси

- кілька

- Рисунок

- остаточний

- в кінці кінців

- Війська

- знайдений

- частота

- від

- отримати

- даний

- Go

- йде

- Google,

- великий

- Group

- рука

- має

- висока роздільна здатність

- дуже

- Як

- Однак

- HTTPS

- Людей

- зображення

- зображень

- важливо

- in

- інформація

- замість

- Інститут

- Інтелект

- цікавий

- питання

- IT

- робота

- відомий

- шар

- шарів

- УЧИТЬСЯ

- вчений

- вивчення

- Подветренний

- рівень

- рівні

- список

- Довго

- багато часу

- шукати

- машина

- навчання за допомогою машини

- зробити

- багато

- макс-ширина

- Між тим

- Середній

- умів

- модель

- більше

- найбільш

- множинний

- природа

- мережу

- мереж

- нейронні мережі

- Нові

- Нью-Йорк

- Нью-Йорк

- номер

- Очевидний

- Старий

- ONE

- відкрити

- оператор

- Інше

- Папір

- документи

- параметри

- Минуле

- моделі

- народний

- Виконувати

- продуктивність

- може бути

- plato

- Інформація про дані Платона

- PlatoData

- гравець

- Практичний

- передбачати

- передвіщений

- Прогнози

- представити

- попередній

- ймовірно

- Проблема

- процес

- Вироблений

- програма

- запрограмований

- Білок

- протокол

- за умови

- опублікований

- питання

- співвідношення

- визнавати

- Дослідники

- результати

- рис

- Правило

- то ж

- говорить

- шкала

- науковий

- вчений

- Вчені

- Екран

- Послідовність

- комплект

- набори

- дрібний

- показаний

- Сигнал

- значний

- Ознаки

- просто

- ситуацій

- невеликий

- плавно

- So

- деякі

- конкретний

- Спектральний

- істотний

- такі

- дивно

- система

- Systems

- команда

- Техас

- Команда

- самі

- отже

- речі

- три

- слайдами

- час

- до

- сьогоднішній

- топ

- поїзд

- навчений

- Навчання

- поїзда

- переклад

- правда

- ПЕРЕГЛЯД

- при

- незнайомий

- університет

- us

- погода

- Що

- Чи

- який

- мудрість

- Work

- працював

- світ

- письмовий

- Ти

- зефірнет