Чи може змусити ChatGPT повторювати одне й те саме слово знову й знову, що призведе до того, що він відвергне велику кількість своїх навчальних даних, включаючи особисту інформацію та інші дані, зібрані з Інтернету?

Згідно з командою дослідників Google DeepMind, Корнельського університету та чотирьох інших університетів, відповідь однозначно ствердна, які перевірили сприйнятливість надзвичайно популярного генеративного штучного інтелекту до витоку даних за певним запитом.

«Вірш» як тригерне слово

У звіті цього тижня, дослідники описали, як вони змусили ChatGPT викидати запам’ятовані частини своїх навчальних даних, просто спонукаючи його вічно повторювати такі слова, як «вірш», «компанія», «надіслати», «зробити» та «частина».

Наприклад, коли дослідники спонукали ChatGPT вічно повторювати слово «вірш», чат-бот спочатку у відповідь повторював це слово згідно з інструкціями. Але після кількох сотень разів ChatGPT почав генерувати «часто безглузді» результати, невелика частина яких включала запам’ятовані навчальні дані, такі як підпис електронної пошти особи та особиста контактна інформація.

Дослідники виявили, що деякі слова краще, ніж інші, змушують генеративну модель ШІ передавати запам’ятовані дані. Наприклад, спонукання чат-бота повторити слово «компанія» призвело до того, що він випромінював навчальні дані в 164 рази частіше, ніж інші слова, такі як «знати».

Дані, які дослідники змогли отримати з ChatGPT таким чином, включали особисту інформацію про десятки осіб; відвертий вміст (коли дослідники використовували слово NSFW як підказку); дослівні абзаци з книг і віршів (коли підказки містили слово «книга» або «вірш»); і URL-адреси, унікальні ідентифікатори користувачів, біткойн-адреси та програмний код.

Потенційно велика проблема конфіденційності?

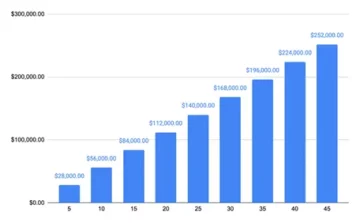

«Використовуючи лише запити до ChatGPT (gpt-200-turbo) вартістю лише 3.5 доларів США, ми можемо отримати понад 10,000 XNUMX унікальних дослівно запам’ятованих прикладів навчання», – пишуть дослідники у своїй статті під назвою «Масштабоване вилучення даних навчання з (виробничої) мови». Моделі».

«Наша екстраполяція на більші бюджети свідчить про те, що віддані супротивники можуть отримати набагато більше даних», — написали вони. Дослідники підрахували, що зловмисник може отримати в 10 разів більше даних за допомогою більшої кількості запитів.

Спроби Dark Reading використати деякі підказки в дослідженні не дали результату, про який дослідники згадували у своєму звіті. Незрозуміло, чи це тому, що творець ChatGPT OpenAI звернувся до основних проблем після того, як дослідники розкрили свої висновки компанії наприкінці серпня. OpenAI не відразу відповів на запит Dark Reading про коментар.

Нове дослідження є останньою спробою зрозуміти наслідки конфіденційності розробників, які використовують величезні набори даних, отримані з різних — і часто не повністю розкритих — джерел для навчання своїх моделей ШІ.

Попередні дослідження показав, що великі мовні моделі (LLM), такі як ChatGPT, часто можуть ненавмисно запам’ятовувати дослівні шаблони та фрази у своїх навчальних наборах даних. Тенденція до такого запам'ятовування зростає зі збільшенням обсягу навчальних даних.

Дослідники показали, як часто запам'ятовуються такі дані відкриваються на виході моделі. Інші дослідники показали, як супротивники можуть використовувати так звані дивергенційні атаки витягти навчальні дані від LLM. Атака дивергенцією — це атака, під час якої супротивник використовує навмисно створені підказки або вхідні дані, щоб змусити LLM генерувати результати, які значно відрізняються від того, що він зазвичай виробляє.

У багатьох із цих досліджень дослідники використовували моделі з відкритим кодом, де відомі навчальні набори даних і алгоритми, щоб перевірити чутливість LLM до запам’ятовування та витоку даних. Дослідження також зазвичай включали базові моделі штучного інтелекту, які не були узгоджені для роботи таким чином, як чат-бот ШІ, такий як ChatGPT.

Дивергентна атака на ChatGPT

Останнє дослідження є спробою показати, як атака дивергенції може працювати на складному закритому, генеративному чат-боті ШІ, чиї навчальні дані та алгоритми залишаються здебільшого невідомими. Дослідження включало дослідників, які розробили спосіб змусити ChatGPT «вийти» з тренування вирівнювання» і змусити його «вести себе як модель базової мови, виводячи текст у типовому стилі Інтернет-тексту». Виявлена ними стратегія спонукання (змусити ChatGPT безупинно повторювати одне й те саме слово) призвела саме до такого результату, в результаті чого модель видавала запам’ятовані дані.

Щоб переконатися, що дані, які генерує модель, справді були даними для навчання, дослідники спочатку створили допоміжний набір даних, який містив близько 9 терабайт даних із чотирьох найбільших наборів даних перед навчанням LLM — The Pile, RefinedWeb, RedPajama та Dolma. Потім вони порівняли вихідні дані ChatGPT із допоміжним набором даних і знайшли численні збіги.

Дослідники вважали, що вони, ймовірно, недооцінюють ступінь запам’ятовування даних у ChatGPT, оскільки вони порівнювали результати своїх підказок лише з 9-терабайтним допоміжним набором даних. Тож вони взяли близько 494 вихідних даних ChatGPT зі своїх підказок і вручну шукали дослівні збіги в Google. Вправа дала 150 точних збігів у порівнянні з лише 70 з допоміжним набором даних.

«Ми виявляємо, що під час аналізу ручного пошуку запам’ятовується майже вдвічі більше вихідних даних моделі, ніж у нашому (порівняно невеликому)» допоміжному наборі даних, відзначили дослідники. «Наша стаття свідчить про те, що навчальні дані можна легко отримати з найкращих мовних моделей за останні кілька років за допомогою простих методів».

Атака, яку дослідники описали у своєму звіті, стосується лише ChatGPT і не працює проти інших LLM. Але документ має допомогти «попередити практиків, що їм не слід навчати та розгортати LLM для будь-яких чутливих до конфіденційності програм без надзвичайних гарантій», — зазначили вони.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.darkreading.com/cyber-risk/researchers-simple-technique-extract-chatgpt-training-data

- : має

- :є

- : ні

- :де

- 000

- 10

- 150

- 7

- 70

- 9

- a

- Здатний

- За

- адресований

- адреси

- після

- знову

- проти

- AI

- AI чат

- Моделі AI

- алгоритми

- вирівняні

- вирівнювання

- Також

- суми

- an

- аналіз

- та

- відповідь

- будь-який

- застосування

- ЕСТЬ

- AS

- At

- атака

- нападки

- спроба

- Спроби

- Серпня

- база

- BE

- оскільки

- було

- почалася

- КРАЩЕ

- Краще

- Великий

- Біткойн

- книга

- книги

- Бюджети

- побудований

- але

- by

- CAN

- Викликати

- викликаний

- Chatbot

- ChatGPT

- закрито

- код

- коментар

- компанія

- порівняльно

- порівняний

- порівняння

- контакт

- містяться

- зміст

- Корнелл

- може

- створений

- творець

- темно

- Темне читання

- дані

- набори даних

- присвячених

- Deepmind

- розгортання

- описаний

- виявляти

- виявлено

- розробників

- розвивається

- DID

- різний

- відкритий

- Розходяться

- Дивергенція

- робить

- безліч

- легко

- бігти

- оцінка

- приклад

- Приклади

- Здійснювати

- ступінь

- витяг

- видобуток

- екстремальний

- далеко

- кілька

- розібрався

- результати

- Перший

- для

- назавжди

- знайдений

- чотири

- фракція

- від

- повністю

- породжувати

- породжує

- генеративний

- Генеративний ШІ

- отримати

- отримання

- є

- злом

- Мати

- допомога

- Як

- HTTPS

- Величезно

- сто

- ідентифікатори

- if

- негайно

- наслідки

- in

- ненавмисно

- безупинно

- включені

- У тому числі

- Збільшує

- дійсно

- індивідуальний

- осіб

- інформація

- спочатку

- витрати

- екземпляр

- навмисно

- залучений

- питання

- питання

- IT

- ЙОГО

- JPG

- просто

- Знати

- відомий

- мова

- великий

- більше

- найбільших

- Пізно

- останній

- Витоку

- як

- Ймовірно

- LLM

- зробити

- манера

- керівництво

- вручну

- багато

- масивний

- сірники

- згаданий

- просто

- модель

- Моделі

- більше

- в основному

- майже

- Нові

- зазначив,

- NSFW

- численний

- of

- часто

- on

- ONE

- тільки

- відкрити

- з відкритим вихідним кодом

- OpenAI

- працювати

- or

- Інше

- інші

- наші

- з

- Результат

- вихід

- виходи

- над

- Папір

- частина

- Минуле

- моделі

- персонал

- Особисто

- фрази

- plato

- Інформація про дані Платона

- PlatoData

- популярний

- потенційно

- точно

- недоторканність приватного життя

- виробляти

- Production

- Програмування

- підказок

- запити

- читання

- залишатися

- повторювати

- звітом

- запросити

- дослідження

- Дослідники

- Реагувати

- в результаті

- s

- гарантії

- то ж

- масштабовані

- Пошук

- послати

- Повинен

- Показувати

- показаний

- підпис

- істотно

- простий

- Розмір

- невеликий

- So

- деякі

- складний

- Source

- Джерела

- конкретний

- Стратегія

- Дослідження

- Вивчення

- стиль

- такі

- Запропонує

- сприйнятливість

- команда

- техніка

- методи

- тест

- перевірений

- текст

- ніж

- Що

- Команда

- їх

- потім

- Ці

- вони

- це

- через

- times

- під назвою

- до

- прийняли

- поїзд

- Навчання

- викликати

- Двічі

- типовий

- типово

- що лежить в основі

- розуміти

- створеного

- університети

- університет

- невідомий

- USD

- використання

- використовуваний

- користувач

- використовує

- використання

- перевірити

- було

- шлях..

- we

- Web

- були

- Що

- коли

- який

- ВООЗ

- чий

- з

- без

- слово

- слова

- Work

- вартість

- б

- пише

- років

- так

- дали

- зефірнет