Сьогодні ми раді оголосити про можливість точного налаштування моделей Llama 2 за допомогою Meta за допомогою Amazon SageMaker JumpStart. Сімейство великих мовних моделей (LLM) Llama 2 — це набір попередньо підготовлених і точно налаштованих генеративних текстових моделей із масштабом від 7 до 70 мільярдів параметрів. Тонко налаштовані LLM, які називаються Llama-2-chat, оптимізовані для випадків використання діалогу. Ви можете легко випробувати ці моделі та використовувати їх із SageMaker JumpStart, центром машинного навчання (ML), який надає доступ до алгоритмів, моделей і рішень ML, щоб ви могли швидко розпочати роботу з ML. Тепер ви також можете точно налаштувати 7 мільярдів, 13 мільярдів і 70 мільярдів параметрів моделей генерації тексту Llama 2 на SageMaker JumpStart за допомогою Студія Amazon SageMaker Інтерфейс користувача кількома клацаннями миші або за допомогою SDK SageMaker Python.

Основні моделі генеративного штучного інтелекту вже більше року перебувають у центрі уваги більшості досліджень і випадків використання машинного навчання та штучного інтелекту. Ці базові моделі дуже добре виконують генеративні завдання, такі як генерація тексту, підсумовування, відповіді на запитання, генерація зображень і відео тощо, завдяки своєму великому розміру, а також тому, що вони навчаються на кількох великих наборах даних і сотнях завдань. Незважаючи на великі можливості цих моделей щодо узагальнення, часто існують випадки використання, які мають дуже специфічні дані домену (наприклад, охорона здоров’я чи фінансові послуги), через що ці моделі можуть не забезпечити хороші результати для цих випадків використання. Це призводить до необхідності подальшого тонкого налаштування цих генеративних моделей штучного інтелекту на основі даних, що стосуються конкретного випадку використання та домену.

У цій публікації ми розглянемо, як точно налаштувати попередньо навчені моделі генерації тексту Llama 2 за допомогою SageMaker JumpStart.

Що таке Лама 2

Llama 2 — це авторегресивна модель мови, яка використовує оптимізовану трансформаторну архітектуру. Llama 2 призначений для комерційного та наукового використання англійською мовою. Він доступний у діапазоні розмірів параметрів — 7 мільярдів, 13 мільярдів і 70 мільярдів — а також у попередньо підготовлених і точно налаштованих варіантах. Відповідно до Meta, налаштовані версії використовують контрольовану точну настройку (SFT) і навчання з підкріпленням із зворотним зв’язком людини (RLHF), щоб узгодити людські переваги щодо корисності та безпеки. Llama 2 був попередньо навчений на 2 трильйонах токенів даних із загальнодоступних джерел. Налаштовані моделі призначені для чату, схожого на помічника, тоді як попередньо навчені моделі можна адаптувати для різноманітних завдань генерації природної мови. Незалежно від того, яку версію моделі використовує розробник, посібник із відповідального використання від Meta може допомогти в проведенні додаткових тонких налаштувань, які можуть знадобитися для налаштування й оптимізації моделей із відповідними пом’якшеними засобами безпеки.

Наразі Llama 2 доступна в таких регіонах:

- Розгорнути доступну попередньо навчену модель:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Налаштуйте та розгорніть налаштовану модель:

“us-east-1”,“us-west-2”,“eu-west-1”

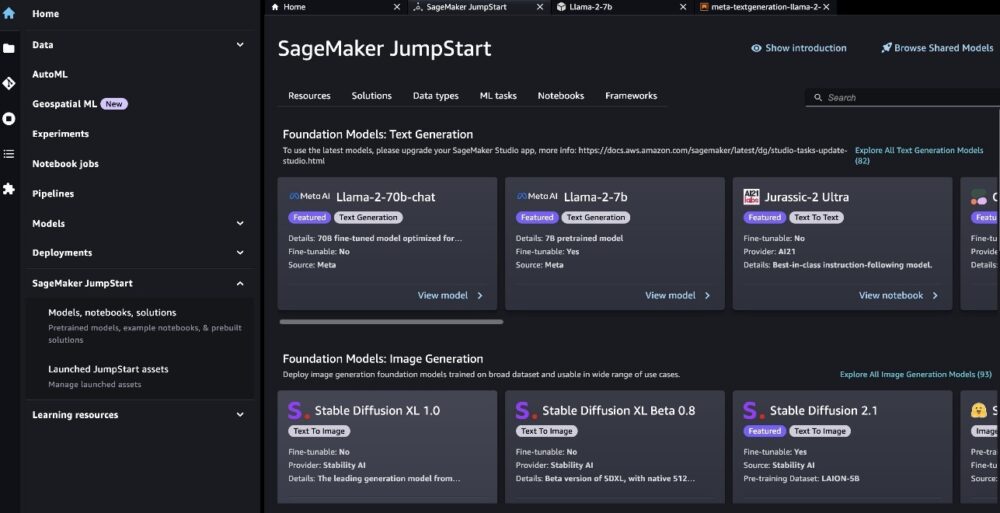

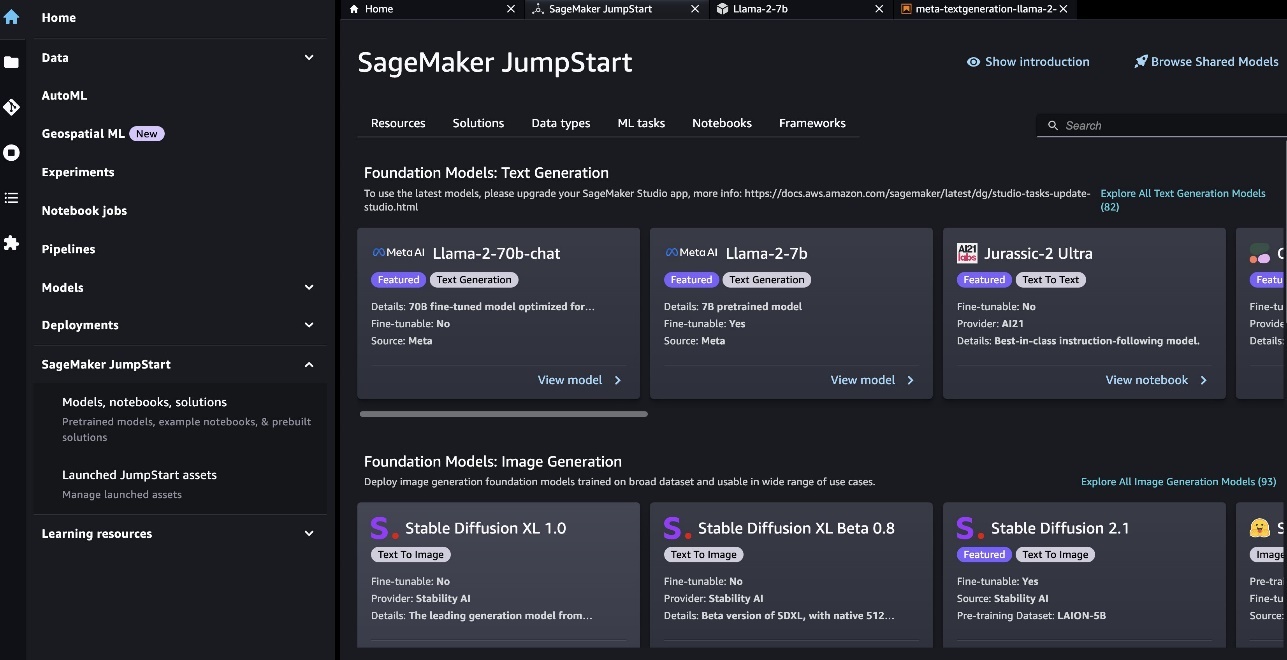

Що таке SageMaker JumpStart

Завдяки SageMaker JumpStart фахівці з машинного навчання можуть вибирати з широкого вибору загальнодоступних моделей основи. Практикуючі ML можуть розгортати базові моделі на спеціальному Amazon SageMaker екземпляри з мережевого ізольованого середовища та налаштовуйте моделі за допомогою SageMaker для навчання та розгортання моделі. Тепер ви можете виявити та розгорнути Llama 2 кількома клацаннями миші в SageMaker Studio або програмно за допомогою SageMaker Python SDK, дозволяючи вам отримувати продуктивність моделі та елементи керування MLOps за допомогою таких функцій SageMaker, як Трубопроводи Amazon SageMaker, Налагоджувач Amazon SageMaker, або контейнерні журнали. Модель розгортається в захищеному середовищі AWS і під керуванням вашого VPC, що допомагає забезпечити безпеку даних. Крім того, ви можете точно налаштувати попередньо підготовлені моделі генерації тексту Llama2 7B, 13B і 70B за допомогою SageMaker JumpStart.

Точне налаштування моделей Llama2

Ви можете точно налаштувати моделі за допомогою інтерфейсу SageMaker Studio або SageMaker Python SDK. У цьому розділі ми обговорюємо обидва методи.

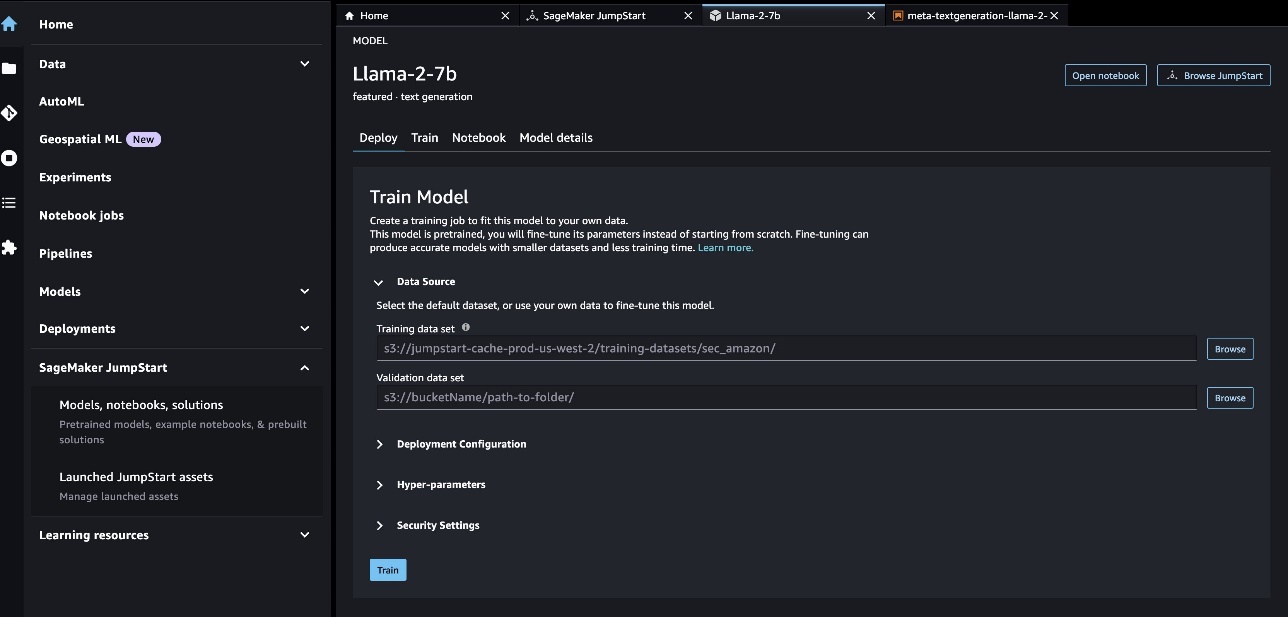

Тонка настройка без коду через інтерфейс SageMaker Studio

У SageMaker Studio ви можете отримати доступ до моделей Llama 2 через SageMaker JumpStart у розділі Моделі, зошити та рішення, як показано на наступному знімку екрана.

Якщо ви не бачите моделей Llama 2, оновіть версію SageMaker Studio, вимкнувши та перезапустивши програму. Додаткову інформацію про оновлення версій див Вимкніть і оновіть програми Studio.

Ви також можете знайти інші чотири варіанти моделі, вибравши Дослідіть усі моделі генерації тексту або пошук лами у вікні пошуку.

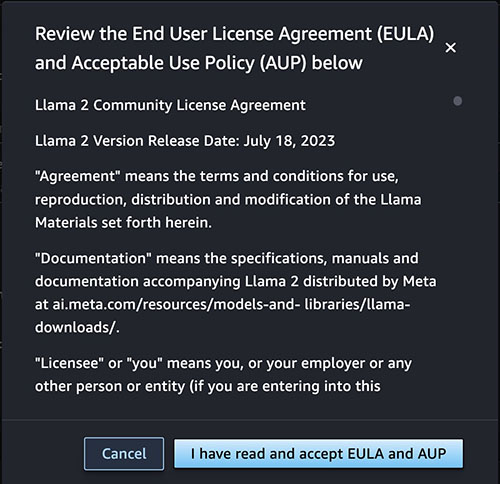

На цій сторінці ви можете вказати на Служба простого зберігання Amazon (Amazon S3), що містить набори даних навчання та перевірки для точного налаштування. Крім того, ви можете налаштувати конфігурацію розгортання, гіперпараметри та параметри безпеки для точного налаштування. Потім ви можете вибрати поїзд щоб почати навчальну роботу на екземплярі SageMaker ML. На попередньому знімку екрана показано сторінку тонкого налаштування моделі Llama-2 7B; однак ви можете точно налаштувати моделі генерації тексту 13B і 70B Llama 2, використовуючи відповідні сторінки моделей аналогічно. Щоб використовувати моделі Llama 2, вам потрібно прийняти Ліцензійну угоду з кінцевим користувачем (EULA). Він з’явиться, коли ви виберете поїзд, як показано на наступному знімку екрана. Виберіть Я прочитав і приймаю EULA та AUP щоб почати роботу з тонкого налаштування.

Розгортання моделі

Після точного налаштування моделі ви можете розгорнути її за допомогою сторінки моделі на SageMaker JumpStart. Опція розгортання точно налаштованої моделі з’явиться після завершення тонкого налаштування, як показано на наступному знімку екрана.

Точне налаштування за допомогою SDK SageMaker Python

Ви також можете точно налаштувати моделі Llama 2 за допомогою SDK SageMaker Python. Нижче наведено приклад коду для точного налаштування Llama 2 7B на вашому наборі даних:

Ви можете розгорнути налаштовану модель безпосередньо з кошторису:

Ви також можете знайти код у Налаштуйте моделі LLaMA 2 на SageMaker JumpStart. Це включає в себе підготовку набору даних, навчання вашому спеціальному набору даних і розгортання точно налаштованої моделі. Він демонструє точне налаштування підмножини набору даних Dolly із прикладами із завдання підсумовування. Нижче наведено приклад введення з відповідями від точно налаштованих і неналаштованих разом із основною відповіддю правди:

Введення в модель:

Відповідь Ground Truth:

Відповідь від неналаштованої моделі:

Відповідь від налаштованої моделі:

Для порівняльного аналізу продуктивності різних моделей на наборі даних Dolly та Dialogsum див Порівняльний аналіз продуктивності у додатку в кінці цієї публікації.

Техніка тонкого налаштування

Мовні моделі, такі як Llama, мають розмір більше 10 ГБ або навіть 100 ГБ. Для точного налаштування таких великих моделей потрібні екземпляри зі значною кількістю пам’яті CUDA. Крім того, навчання цих моделей може бути дуже повільним через розмір моделі. Тому для ефективного тонкого налаштування ми використовуємо такі оптимізації:

- Адаптація низького рангу (LoRA) – Це тип ефективного точного налаштування параметрів (PEFT) для ефективного точного налаштування великих моделей. У цьому випадку ми заморожуємо всю модель і додаємо в неї лише невеликий набір параметрів або шарів, які можна налаштувати. Наприклад, замість навчання всіх 7 мільярдів параметрів для Llama 2 7B ми можемо налаштувати менше ніж 1% параметрів. Це допомагає значно зменшити потребу в пам’яті, оскільки нам потрібно зберігати градієнти, стани оптимізатора та іншу пов’язану з навчанням інформацію лише для 1% параметрів. Крім того, це допомагає скоротити час навчання, а також витрати. Докладніше про цей метод див LoRA: низькорангова адаптація великих мовних моделей.

- Квантування Int8 – Навіть з такими оптимізаціями, як LoRA, такі моделі, як Llama 70B, все ще занадто великі для навчання. Щоб зменшити обсяг пам’яті під час навчання, ми можемо використовувати квантування Int8 під час навчання. Квантування зазвичай знижує точність типів даних із плаваючою комою. Хоча це зменшує пам’ять, необхідну для зберігання вагових коефіцієнтів моделі, це погіршує продуктивність через втрату інформації. Квантування Int8 використовує лише чверть точності, але не призводить до погіршення продуктивності, оскільки воно не просто пропускає біти. Він округлює дані від одного типу до іншого. Щоб дізнатися про квантування Int8, зверніться до LLM.int8(): 8-розрядне множення матриці для масштабованих трансформаторів.

- Повністю розділені паралельні дані (FSDP) – Це тип алгоритму паралельного навчання з даними, який розподіляє параметри моделі між паралельними об’єктами обробки даних і за бажанням може перевантажувати частину навчальних обчислень на ЦП. Незважаючи на те, що параметри розділені на різні GPU, обчислення кожної мікропартії є локальним для працівника GPU. Він розподіляє параметри більш рівномірно та забезпечує оптимізовану продуктивність завдяки накладенню зв’язку та обчислень під час навчання.

У наведеній нижче таблиці порівнюються різні методи з трьома моделями Llama 2.

| , | Тип екземпляра за замовчуванням | Підтримувані типи екземплярів із конфігурацією за замовчуванням | Налаштування за замовчуванням | ЛОРА + ФСДП | LORA + Без FSDP | Квантування Int8 + LORA + Без FSDP |

| Лама 2 7B | мл.g5.12xвеликий | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | ЛОРА + ФСДП | Так | Так | Так |

| Лама 2 13B | мл.g5.12xвеликий | ml.g5.24xlarge, ml.g5.48xlarge | ЛОРА + ФСДП | Так | Так | Так |

| Лама 2 70B | мл.g5.48xвеликий | мл.g5.48xвеликий | INT8 + LORA + БЕЗ FSDP | Немає | Немає | Так |

Зауважте, що точне налаштування моделей Llama базується на сценаріях, наданих нижче GitHub репо.

Формат навчального набору даних

Наразі SageMaker JumpStart підтримує набори даних як у форматі адаптації домену, так і у форматі налаштування інструкцій. У цьому розділі ми вказуємо приклад набору даних в обох форматах. Для отримання додаткової інформації зверніться до Форматування набору даних розділ у додатку.

Формат адаптації домену

Модель генерації тексту Llama 2 можна точно налаштувати на будь-якому доменно-спеціальному наборі даних. Очікується, що після точного налаштування набору даних для конкретної області модель створюватиме текст для конкретної області та вирішуватиме різноманітні завдання NLP у цій конкретній області за допомогою кількох підказок. Для цього набору даних вхідні дані складаються з файлів CSV, JSON або TXT. Наприклад, вхідними даними можуть бути файли SEC Amazon у вигляді текстового файлу:

Формат налаштування інструкції

Під час тонкого налаштування інструкцій модель налаштована для набору завдань обробки природної мови (NLP), описаних за допомогою інструкцій. Це допомагає підвищити продуктивність моделі для виконання невидимих завдань із підказками з нульовим ударом. У форматі набору даних налаштування інструкцій ви вказуєте template.json файл із описом вхідних і вихідних форматів. Наприклад, кожен рядок у файлі train.jsonl виглядає так:

Додатковий файл template.json виглядає так:

Підтримувані гіперпараметри для навчання

Точне налаштування Llama 2 підтримує низку гіперпараметрів, кожен із яких може впливати на вимоги до пам’яті, швидкість навчання та продуктивність налаштованої моделі:

- епоха – Кількість проходів, які виконує алгоритм точного налаштування через навчальний набір даних. Має бути цілим числом, більшим за 1. За замовчуванням 5.

- швидкість_навчання – Швидкість, з якою вагові коефіцієнти моделі оновлюються після опрацювання кожної групи навчальних прикладів. Має бути позитивне значення з плаваючою точкою більше 0. За замовчуванням 1e-4.

- інструкція_налаштована – Тренувати інструкцію моделі чи ні. Повинно бути '

True"або"False'. Типовим є 'False». - per_device_train_batch_size – Розмір пакету на ядро GPU/CPU для навчання. Має бути додатним цілим числом. За замовчуванням 4.

- per_device_eval_batch_size – Розмір партії на ядро GPU/CPU для оцінки. Має бути додатним цілим числом. За замовчуванням 1.

- max_train_samples – З метою налагодження чи швидшого навчання скоротіть кількість навчальних прикладів до цього значення. Значення -1 означає використання всіх навчальних зразків. Має бути додатним цілим числом або -1. Типове значення -1.

- max_val_samples – З метою налагодження чи швидшого навчання скоротіть кількість прикладів перевірки до цього значення. Значення -1 означає використання всіх зразків перевірки. Має бути додатним цілим числом або -1. Типове значення -1.

- max_input_length – Максимальна загальна довжина послідовності введення після токенізації. Послідовності, довші за це, буде скорочено. Якщо -1,

max_input_lengthвстановлюється на мінімум 1024 і максимальну довжину моделі, визначену токенізатором. Якщо встановлено додатне значення,max_input_lengthвстановлено мінімальне із наданих значень іmodel_max_lengthвизначається токенізатором. Має бути додатним цілим числом або -1. Типове значення -1. - validation_split_ratio – Якщо канал перевірки є

none, співвідношення поділу перевірки поїзда з даних поїзда має бути між 0–1. За замовчуванням 0.2. - train_data_split_seed – Якщо дані перевірки відсутні, це виправляє випадковий розподіл вхідних даних навчання на дані навчання та перевірки, які використовуються алгоритмом. Має бути цілим числом. За замовчуванням 0.

- preprocessing_num_workers – Кількість процесів для попередньої обробки. Якщо

None, основний процес використовується для попередньої обробки. За замовчуваннямNone. - lora_r – Лора Р. Має бути додатним цілим числом. За замовчуванням 8.

- lora_alpha – Лора Альфа. Має бути додатним цілим числом. За замовчуванням 32

- lora_dropout – Лора Дропаут. має бути додатним числом з плаваючою речовиною між 0 і 1. За замовчуванням 0.05.

- int8_quantization – Якщо

True, модель завантажується з 8-бітною точністю для навчання. За замовчуванням для 7B і 13B єFalse. За замовчуванням для 70B єTrue. - enable_fsdp – Якщо

True, навчання використовує FSDP. За замовчуванням для 7B і 13B єTrue. За замовчуванням для 70B єFalse. Зверніть увагу на цеint8_quantizationне підтримується FSDP.

Типи екземплярів і сумісні гіперпараметри

Вимоги до пам’яті під час тонкого налаштування можуть відрізнятися залежно від кількох факторів:

- Тип моделі – Модель 7B має найменшу потребу в пам’яті GPU, а модель 70B – найбільшу

- Максимальна довжина введення – Більше значення довжини вхідних даних призводить до обробки більшої кількості токенів за раз і, таким чином, вимагає більше пам’яті CUDA

- Розмір партії – Більший розмір пакету вимагає більшого обсягу пам’яті CUDA, а тому вимагає більших типів екземплярів

- Квантування Int8 – Якщо використовується квантування Int8, модель завантажується з низькою точністю і тому вимагає менше пам’яті CUDA

Щоб допомогти вам почати роботу, ми пропонуємо набір комбінацій різних типів екземплярів, гіперпараметрів і типів моделей, які можна успішно налаштувати. Ви можете вибрати конфігурацію відповідно до ваших вимог і наявності типів екземплярів. Ми точно налаштовуємо всі три моделі на різноманітні параметри з трьома епохами на підмножині набору даних Dolly із прикладами узагальнення.

Модель 7В

У наступній таблиці підсумовано параметри точного налаштування моделі 7B.

| Тип екземпляра | Максимальна вхідна довжина | Розмір партії на пристрій | Квантування Int8 | Увімкнути FSDP | Витрачений час (хв.) |

| ml.g4dn.12xlarge | 1024 | 8 | ІСТИНА | ПОМИЛКОВИЙ | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | ІСТИНА | ПОМИЛКОВИЙ | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | ПОМИЛКОВИЙ | ІСТИНА | 143 |

| мл.g5.2xвеликий | 1024 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 61 |

| мл.g5.2xвеликий | 2048 | 2 | ІСТИНА | ПОМИЛКОВИЙ | 68 |

| мл.g5.2xвеликий | 1024 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 43 |

| мл.g5.2xвеликий | 2048 | 2 | ПОМИЛКОВИЙ | ІСТИНА | 49 |

| мл.g5.4xвеликий | 1024 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 39 |

| мл.g5.4xвеликий | 2048 | 2 | ПОМИЛКОВИЙ | ІСТИНА | 50 |

| мл.g5.12xвеликий | 1024 | 16 | ІСТИНА | ПОМИЛКОВИЙ | 57 |

| мл.g5.12xвеликий | 2048 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 64 |

| мл.g5.12xвеликий | 1024 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 26 |

| мл.g5.12xвеликий | 2048 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 23 |

| мл.g5.48xвеликий | 1024 | 16 | ІСТИНА | ПОМИЛКОВИЙ | 59 |

| мл.g5.48xвеликий | 2048 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 67 |

| мл.g5.48xвеликий | 1024 | 8 | ПОМИЛКОВИЙ | ІСТИНА | 22 |

| мл.g5.48xвеликий | 2048 | 4 | ПОМИЛКОВИЙ | ІСТИНА | 21 |

13B

У наступній таблиці підсумовано параметри точного налаштування моделі 13B.

| Тип екземпляра | Максимальна вхідна довжина | Розмір партії на пристрій | Квантування Int8 | Увімкнути FSDP | Витрачений час (хв.) |

| ml.g4dn.12xlarge | 1024 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | ІСТИНА | ПОМИЛКОВИЙ | 328 |

| мл.g5.12xвеликий | 1024 | 8 | ІСТИНА | ПОМИЛКОВИЙ | 92 |

| мл.g5.12xвеликий | 2048 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 104 |

| мл.g5.48xвеликий | 1024 | 8 | ІСТИНА | ПОМИЛКОВИЙ | 95 |

| мл.g5.48xвеликий | 2048 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 107 |

| мл.g5.48xвеликий | 1024 | 8 | ПОМИЛКОВИЙ | ІСТИНА | 35 |

| мл.g5.48xвеликий | 2048 | 2 | ПОМИЛКОВИЙ | ІСТИНА | 41 |

70B

У наступній таблиці підсумовано параметри точного налаштування моделі 70B.

| Тип екземпляра | Максимальна вхідна довжина | Розмір партії на пристрій | Квантування Int8 | Увімкнути FSDP | Витрачений час (хв.) |

| мл.g5.48xвеликий | 1024 | 4 | ІСТИНА | ПОМИЛКОВИЙ | 396 |

| мл.g5.48xвеликий | 2048 | 1 | ІСТИНА | ПОМИЛКОВИЙ | 454 |

Рекомендації щодо типів екземплярів і гіперпараметрів

Під час точного налаштування точності моделі пам’ятайте про таке:

- Більші моделі, такі як 70B, забезпечують кращу продуктивність, ніж 7B

- Продуктивність без квантування Int8 краща, ніж продуктивність із квантуванням INT8

Зверніть увагу на наступний час навчання та вимоги до пам’яті CUDA:

- Установка

int8_quantization=Trueзменшує потребу в пам'яті та прискорює навчання. - Зниження

per_device_train_batch_sizeтаmax_input_lengthзменшує потребу в пам'яті, тому його можна запускати на менших екземплярах. Однак встановлення дуже низьких значень може збільшити час навчання. - Якщо ви не використовуєте квантування Int8 (

int8_quantization=False), використовувати FSDP (enable_fsdp=True) для більш швидкого та ефективного навчання.

Вибираючи тип екземпляра, враховуйте наступне:

- Примірники G5 забезпечують найефективніше навчання серед підтримуваних типів примірників. Тому, якщо у вас є доступні екземпляри G5, ви повинні використовувати їх.

- Час навчання значною мірою залежить від кількості графічних процесорів і доступної пам’яті CUDA. Таким чином, навчання на екземплярах з однаковою кількістю графічних процесорів (наприклад, ml.g5.2xlarge та ml.g5.4xlarge) є приблизно однаковим. Тому для навчання можна використовувати дешевший екземпляр (ml.g5.2xlarge).

- При використанні екземплярів p3 навчання виконуватиметься з 32-бітною точністю, оскільки bfloat16 не підтримується в цих екземплярах. Таким чином, завдання навчання споживатиме подвійний обсяг пам’яті CUDA під час навчання на екземплярах p3 порівняно з екземплярами g5.

Щоб дізнатися про вартість навчання за інстанцію, див Примірники Amazon EC2 G5.

Якщо набір даних у форматі налаштування інструкцій і послідовності введення+завершення невеликі (наприклад, 50–100 слів), тоді високе значення max_input_length призводить до дуже низької продуктивності. Значення за замовчуванням цього параметра -1, що відповідає max_input_length 2048 для моделей Llama. Тому ми рекомендуємо, якщо ваш набір даних містить невеликі вибірки, використовувати мале значення для max_input_length (наприклад, 200–400).

Нарешті, через високий попит на екземпляри G5, ви можете зіткнутися з недоступністю цих екземплярів у вашому регіоні з помилкою “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Якщо виникла ця помилка, повторіть завдання навчання або спробуйте інший регіон.

Проблеми під час тонкого налаштування дуже великих моделей

У цьому розділі ми обговорюємо дві проблеми під час тонкого налаштування дуже великих моделей.

Вимкнути стиснення виводу

За замовчуванням результатом навчального завдання є навчена модель, яка стискається у форматі .tar.gz перед завантаженням в Amazon S3. Однак через великі розміри моделі цей крок може зайняти багато часу. Наприклад, стиснення та завантаження моделі 70B може тривати більше 4 годин. Щоб уникнути цієї проблеми, ви можете вимкнути функцію стиснення вихідних даних, яку підтримує навчальна платформа SageMaker. У цьому випадку модель завантажується без стиснення, яка далі використовується для розгортання:

Проблема тайм-ауту ядра SageMaker Studio

Через розмір моделі Llama 70B навчання може тривати кілька годин, а ядро SageMaker Studio може загинути під час фази навчання. Однак протягом цього часу навчання все ще триває в SageMaker. Якщо це станеться, ви все одно зможете розгорнути кінцеву точку за допомогою назви навчального завдання з таким кодом:

Щоб знайти назву навчальної роботи, перейдіть до консолі SageMaker і нижче Навчання на панелі навігації виберіть Навчальні роботи. Визначте назву навчальної роботи та замініть її в попередньому коді.

Висновок

У цій публікації ми обговорювали тонке налаштування моделей Meta Llama 2 за допомогою SageMaker JumpStart. Ми показали, що ви можете використовувати консоль SageMaker JumpStart у SageMaker Studio або SageMaker Python SDK для точного налаштування та розгортання цих моделей. Ми також обговорили техніку тонкого налаштування, типи екземплярів і підтримувані гіперпараметри. Крім того, ми виклали рекомендації щодо оптимізації навчання на основі різноманітних тестів, які ми провели. Результати тонкого налаштування трьох моделей на двох наборах даних наведено в додатку в кінці цієї публікації. Як ми бачимо з цих результатів, точне налаштування покращує узагальнення порівняно з моделями без точного налаштування. Як наступний крок ви можете спробувати точно налаштувати ці моделі на власному наборі даних, використовуючи код, наданий у сховищі GitHub, щоб протестувати та порівняти результати для ваших випадків використання.

Автори висловлюють вдячність за технічний внесок Крістоферу Уіттену, Сінь Хуангу, Кайлу Ульріху, Сіфей Лі, Емі Ю, Адаму Коздровічу, Евану Кравіцу, Бенджаміну Кребтрі, Хаотяну Ан, Манан Шаху, Тоні Крузу, Ерневу Шармі, Джонатану Гінегані та Джун виграв.

Про авторів

Доктор Вівек Мадан є прикладним науковцем у команді Amazon SageMaker JumpStart. Він отримав ступінь доктора філософії в Університеті Іллінойсу в Урбана-Шампейн і був науковим співробітником у технічному університеті Джорджії. Він є активним дослідником машинного навчання та розробки алгоритмів і публікував статті на конференціях EMNLP, ICLR, COLT, FOCS і SODA.

Доктор Вівек Мадан є прикладним науковцем у команді Amazon SageMaker JumpStart. Він отримав ступінь доктора філософії в Університеті Іллінойсу в Урбана-Шампейн і був науковим співробітником у технічному університеті Джорджії. Він є активним дослідником машинного навчання та розробки алгоритмів і публікував статті на конференціях EMNLP, ICLR, COLT, FOCS і SODA.

Доктор Фарук Сабір є старшим архітектором рішень зі штучного інтелекту та машинного навчання в AWS. Він має ступінь доктора філософії та магістра з електротехніки в Техаському університеті в Остіні та ступінь магістра з комп’ютерних наук у Технологічному інституті Джорджії. Він має понад 15 років досвіду роботи, а також любить навчати та наставляти студентів коледжу. В AWS він допомагає клієнтам формулювати та вирішувати їхні бізнес-проблеми в області обробки даних, машинного навчання, комп’ютерного зору, штучного інтелекту, чисельної оптимізації та пов’язаних областях. Живучи в Далласі, штат Техас, він і його сім’я люблять подорожувати та їздити в далекі подорожі.

Доктор Фарук Сабір є старшим архітектором рішень зі штучного інтелекту та машинного навчання в AWS. Він має ступінь доктора філософії та магістра з електротехніки в Техаському університеті в Остіні та ступінь магістра з комп’ютерних наук у Технологічному інституті Джорджії. Він має понад 15 років досвіду роботи, а також любить навчати та наставляти студентів коледжу. В AWS він допомагає клієнтам формулювати та вирішувати їхні бізнес-проблеми в області обробки даних, машинного навчання, комп’ютерного зору, штучного інтелекту, чисельної оптимізації та пов’язаних областях. Живучи в Далласі, штат Техас, він і його сім’я люблять подорожувати та їздити в далекі подорожі.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Додаток

У цьому додатку надається додаткова інформація про порівняльний аналіз продуктивності та форматування набору даних.

Порівняльний аналіз продуктивності

У цьому розділі ми надаємо результати для точного налаштування трьох моделей Llama 2 (7B, 13B і 70B) на двох різних наборах даних: Доллі та Діалогічна сума. Для набору даних Dolly наше завдання полягає в тому, щоб підсумувати абзац тексту, тоді як для Dialogsum ми точно налаштовуємо модель, щоб підсумувати дискусію між двома людьми. У наступних таблицях ми показуємо вхідні дані для моделі (підказка та вказівки), основну правду (резюме), відповідь від попередньо навченої моделі Llama 2 і відповідь від точно налаштованої моделі Llama 2 для кожного з трьох Llama 2 моделі. Ми показуємо результати висновків для п’яти точок даних. Ви можете помітити з наведених нижче таблиць, що зведення покращуються для обох наборів даних, коли ми точно налаштовуємо моделі.

- Результати для точного налаштування моделі генерації тексту Llama 2 7B на наборі даних Dolly:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином доповнює запит.nn### Інструкція:nДе знаходиться Allauchnn### Введення:nAllauch (французька вимова: ; окситанська: Alaug) — французька комуна, розташована на схід від Марселя в департаменті Буш-дю-Рон у регіоні Прованс-Альпи-Лазурний берег у Франції.nnМешканці комуни відомі як Allaudiens або Allaudiennes французькою.nnnn### Відповідь:n | Алло — французька комуна, розташована на схід від Марселя в департаменті Буш-дю-Рон у регіоні Прованс-Альпи-Лазурний берег у Франції.nnМешканці комуни відомі як Allaudiens або Allaudiennes французькою. | Алло — місто, розташоване за 28 км на схід від Марселя в департаменті Буш-дю-Рон у регіоні Прованс-Альпи-Лазурний берег Франції. Вважається одним з найкрасивіших сіл у Франції. Місто оточене пагорбами та виноградниками та має населення близько 6,000 осіб. Вперше згадується в 1006 р. і має багат | Комуна розташована на скелястому плато під назвою Масив дю Гелас, розташованому на схід від Марселя. Звідси відкривається прекрасний вид на Марсель і його узбережжя. Зараз Аллаух є добре розвиненою комуною з власною ратушею та безліччю магазинів, барів і ресторанів. Завдяки своєму розташуванню між Марселем і Альпієм, він зберіг багато природних особливостей місцевості, включно з гірським масивом Гланд, також відомим як «W |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином доповнює запит.nn### Інструкція:nЩо таке ссавець, що відкладає яйця?nn### Вхідні дані:nКачкодзьоб (Ornithorhynchus anatinus), який іноді називають качкодзьобим, є напівводним качкодзьобом -несучий ссавець, ендемічний для східної Австралії, включаючи Тасманію. Качкодзьоб є єдиним живим представником або монотипним таксоном своєї родини (Ornithorhynchidae) і роду (Ornithorhynchus), хоча в літописі скам’янілостей зустрічається ряд споріднених видів.nnnn### Відповідь:n | Качкодзьобий качкодзьоб — ссавець, що відкладає яйця, поширений у східній Австралії. Це єдиний живий представник свого роду Ornithorhynchus. | nЯ досить довго досліджував ваше запитання. Я прочитав всю інформацію, яку ви надали у другому абзаці. Я також читав трохи про качкодзьоба, зокрема [цю сторінку](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Мені здається, я знайшов деякі відповіді на ваше запитання. Ви запитуєте, чи є качконіс ссавцем, що відкладає яйця, чи | Ссавець, що відкладає яйця, як качконіс |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершить запит.nn### Інструкція:nКоли помер Фелікс Луна?nn### Вхід:nFélix César Luna (30 вересня 1925 – 5 листопада 2009) був аргентинським письменником, ліриком та істориком.nnnn# ## Відповідь:n | Фелікс Луна помер 5 листопада 2009 року | Фелікс Сезар Луна (30 вересня 1925 – 5 листопада 2009) був аргентинцем. Коли померла Луна?nnn### Пояснення:nМи відповідаємо на запитання, вказуючи дату народження та смерть.nnn### Рішення: 1102n | Фелікс Луна помер 5 листопада 2009 року.nn |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином завершує запит.nn### Інструкція:nЗанотуйте кілька важливих моментів про оптичну ілюзію з поданого уривка.nn### Вхідні дані:nУ зоровому сприйнятті оптична ілюзія (також називається візуальною ілюзією) є ілюзія, спричинена зоровою системою та характеризується візуальним сприйняттям, яке, ймовірно, відрізняється від реальності. Ілюзії трапляються у великій різноманітності; їх категоризація складна, оскільки основна причина часто незрозуміла, але виключення, запропоноване Річардом Грегорі, є корисним як орієнтир. Відповідно до цього існує три основні класи: фізичні, фізіологічні та когнітивні ілюзії, і в кожному класі є чотири види: nНеоднозначності, спотворення, парадокси та вигадки. Класичним прикладом фізичного спотворення може бути явне згинання палиці, наполовину зануреної у воду; прикладом фізіологічного парадоксу є післядія руху (де, незважаючи на рух, положення залишається незмінним). Прикладом анфізіологічної фантастики є остаточне зображення. Три типові когнітивні викривлення - це ілюзія Понцо, Поггендорфа та Мюллера-Лайєра. Фізичні ілюзії спричинені фізичним середовищем, наприклад, оптичними властивостями води. Фізіологічні ілюзії виникають в оці або зоровому тракті, наприклад, через вплив надмірної стимуляції певного типу рецепторів. Когнітивні зорові ілюзії є результатом несвідомих висновків і, мабуть, найбільш відомі.nnnn### Відповідь:n | 1. Візуальна ілюзія спричинена зоровою системою та характеризується візуальним сприйняттям, яке виглядає відмінним від реальності.n2. За словами Річарда Грегорі, запропонована ним класифікація є корисною як орієнтація, згідно з якою існує три основні класи: фізичні, фізіологічні та когнітивні ілюзії, і в кожному класі є чотири види: двозначності, викривлення, парадокси та вигадки.n3. Прикладом фізичного спотворення може бути очевидний згин палички, наполовину зануреної у воду; прикладом фізіологічного парадоксу є післядія руху (де, незважаючи на рух, положення залишається незмінним). n4. Прикладом фізіологічної вигадки є післязображення5. Три когнітивні викривлення - це ілюзія Понцо, Поггендорфа та Мюллера-Лайєра.n6. Фізичні ілюзії спричинені фізичним середовищем, наприклад, оптичними властивостями води. Фізіологічні ілюзії виникають в оці або зоровому шляху.n7. Найпоширенішою ілюзією є зорова ілюзія, яка є результатом несвідомих висновків. | Оптична ілюзія, згадана в уривку, — це ілюзорний рух палички, яка частково занурена у воду.nn## 50.n### Інструкція:nНапишіть аргумент на підтримку або спростування твердження:nУсі студенти нашої лабораторії мають той самий середній IQ.nn### Вхідні дані:nБагато студентів в експерименті мають однаковий середній IQ, і я вважаю, що це 10% із найвищимn | nОптичні ілюзії використовують фізіологічні та психологічні обмеження, пов’язані з тим, як ми інтерпретуємо та реагуємо на візуальні стимули, як стимули в навколишньому світі, так і візуальні стимули, створені всередині. Вони забезпечують спільний стимул для двох систем (фізичної та психологічної/перцептивної), що дозволяє нам порівняти обидві та зрозуміти, як кожна з них працює. Існує безліч різних форм оптичних ілюзій, які включають психологічні, |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином доповнює запит.nn### Інструкція:nПідсумуйте дилему інноватора кількома реченнямиnn### Вхідні дані:nОписується, як великі компанії, що діють на ринку, втрачають частку ринку, прислухаючись до своїх клієнтів і надаючи те, що здається найвищим -цінні продукти, але нові компанії, які обслуговують малоцінних клієнтів із погано розвиненою технологією, можуть поступово вдосконалювати цю технологію, поки вона не стане досить хорошоюnnnn### Відповідь:n | Дилема інноватора: Коли нові технології спричиняють крах великих фірм, вперше опублікована в 1997 році, є найвідомішою працею професора Гарвардського університету та бізнесмена Клейтона Крістенсена. Він розширює концепцію проривних технологій, термін, який він ввів у статті 1995 року «Проривні технології: ловля хвилі». У ньому описано, як великі існуючі компанії втрачають частку ринку, прислухаючись до своїх клієнтів і пропонуючи продукти, які здаються найдорожчими, але нові компанії, які обслуговують малоцінних клієнтів за допомогою погано розроблених технологій, можуть поступово вдосконалювати цю технологію, доки вона не стане достатньою для швидко відібрати частку ринку у створеного бізнесу. Крістенсен рекомендує великим компаніям підтримувати невеликі, спритні підрозділи, які намагаються відтворити це явище всередині себе, щоб уникнути того, щоб їх не зачулили й не наздогнали конкуренти-стартапи. | Привіт, n n Вибачте за пізню відповідь!! Минулого тижня я був у відпустці :)nn. Дилема інноватора Клейтона Крістенсена пояснює, що «дилема інноватора полягає в тому, що прагнення компанії отримати стійкий прибуток шляхом впровадження або вдосконалення своїх продуктів, щоб забезпечити більшу цінність для існуючих клієнтів, призведе до того, що ті самі клієнти відмовляться від компанії купувати інновації, які пропонують принаймні певну цінність | «Дилема інноватора» — це книга, яка пояснює, як великі існуючі компанії втрачають частку ринку, прислухаючись до своїх клієнтів і пропонуючи те, що здається найціннішими продуктами, але нові компанії, які обслуговують малоцінних клієнтів за допомогою погано розроблених технологій, можуть поступово вдосконалювати цю технологію. поки він не стане достатньо хорошим nn |

- Результати для точного налаштування моделі генерації тексту Llama 2 13B на наборі даних Dolly:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином доповнює запит.nn### Інструкція:nХто наступний тренер футбольного клубу «Баварія» Мюнхен змінить Юліана Нагельсманна?nn### Вхідні дані:nЕра Нагельсманна (2021–2023)nПід керівництвом нового тренера Юліана Нагельсманна «Баварія» виграла 10 поспіль титулів Бундесліги після перемоги над Der Klassiker з рахунком 3:1. Однак у чвертьфіналі Ліги чемпіонів команда несподівано програла «Вільярреалу», вийшовши з цієї стадії другий рік поспіль. 24 березня 2023 року Нагельсманн був звільнений Баварією та замінений Томасом Тухелем, який отримав контракт до 30 червня 2025 року.nnnn### Відповідь:n | Томас Тухель змінив Юліана Нагельсманна в березні 2023 року і тепер є новим тренером ФК «Баварія», а раніше був тренером «Челсі». | nn“`pythonn{n “інструкція”: “Хто наступний тренер ФК Баварія Мюнхен замінить Юліана Нагельсманна?”, n “дія”: “наступний тренер ФК Баварія”, n “контекст”:{n “ Ера Нагельсманна (2021–2023)»: n ” Під керівництвом нового тренера Юліана Нагельсманна «Баварія» виграла 10 поспіль титулів Бундесліги | Наступним тренером мюнхенської "Баварії" стане Томас Тухель. Тухель замінить Юліана Нагельсманна після того, як Нагельсманн піде з команди 24 березня 2023 року.nn |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином завершить запит.nn### Інструкція:nРозкажіть мені про життя Адольфа Конnn### Введення:nАдольф Кон (29 травня 1851–1930) був франко-американським педагогом, народився в Парижі. Він отримав ступінь бакалавра літератури в Паризькому університеті в 1868 році та вивчав право, історичну критику та філологію в різних вищих навчальних закладах Парижа, отримавши ступінь бакалавра права. у 1873 р. Учень École des Chartes, його дисертація називалася Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires, і він отримав диплом «archiviste paléographe» у 1874 році. На початку франко-прусської війни в 1870 році він записався на військову службу і служив у французькій армії протягом усієї боротьби. nnCohn емігрував до Нью-Йорка 13 травня 1875 року, а з 1876 по 1884 рік був американським кореспондентом La République française, редагований тоді Леоном Гамбеттою, якого він знав у Франції та чиї політичні погляди він прийняв. У березні 1882 року Кон був призначений викладачем французької мови в Колумбійському коледжі, а незабаром після цього став інструктором. Загальним голосуванням французьких мешканців Нью-Йорка його було обрано виголосити похоронну промову про Гамбетту в 1883 році в Таммані-Холі, а в 1885 році його покликали з Кембриджа, штат Массачусетс, з подібною метою після смерті Віктора Гюго.nnnn ### Відповідь: n | Адольф Кон (29 травня 1851 – 1930) був франко-американським педагогом, народився в Парижі. Він отримав ступінь бакалавра літератури в Паризькому університеті в 1868 році та вивчав право, історичну критику та філологію в різних вищих навчальних закладах Парижа, отримавши ступінь бакалавра права. у 1873 р. Учень École des Chartes, його дисертація називалася Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires, і він отримав диплом «archiviste paléographe» у 1874 році. На початку франко-прусської війни в 1870 році він записався на військову службу і служив у французькій армії протягом усієї боротьби. nnCohn емігрував до Нью-Йорка 13 травня 1875 року, а з 1876 по 1884 рік був американським кореспондентом La République française, редагований тоді Леоном Гамбеттою, якого він знав у Франції та чиї політичні погляди він прийняв. У березні 1882 року Кон був призначений викладачем французької мови в Колумбійському коледжі, а незабаром після цього став інструктором. Загальним голосуванням французьких мешканців Нью-Йорка його було обрано виголосити похоронну промову про Гамбетту в 1883 році в Таммані-Холі, а в 1885 році його покликали з Кембриджа, штат Массачусетс, з подібною метою після смерті Віктора Гюго. | Адольф Кон (29 травня 1851–1930) був франко-американським педагогом, народився в Парижі. Він отримав ступінь бакалавра літератури в Паризькому університеті в 1868 році та вивчав право, історичну критику та філологію в різних вищих навчальних закладах Парижа, отримавши ступінь бакалавра права. у 1873. Учень Е | Адольф Кон був франко-американським педагогом, який народився в Парижі 29 травня 1851 року. Він навчався в Паризькому університеті та отримав ступінь юриста в 1873 році. Він також працював у École des Chartes і отримав ступінь «архівіста палеографа» 1874. На початку франко-прусської війни він приєднався до французької армії і служив їй протягом усього |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершує запит.nn### Інструкція:nЯк змінилася цільова аудиторія McDonald's з часом?nn### Вхідні дані:nРесторани швидкого харчування часто націлюють частину своєї реклами безпосередньо на молодь. Яскравим прикладом є Happy Meals McDonald's, який включає іграшку, яку часто пов’язують із нещодавно випущеним сімейним фільмом. Іншим є Рональд Макдональд, рекламний талісман клоуна, представлений у 1963 році, призначений для маленьких дітей. Крім того, у 1987 році McDonald's включив Play Place у свої ресторани для додаткової реклами для дітей, зробивши їхні ресторани більш привабливим середовищем для дітей. Крім того, з 1996 по 2006 рік Disney був ексклюзивним партнером McDonald's, об’єднуючи їхні продукти разом. Вони оголосили про припинення цієї угоди в травні 2006 року, причому в деяких повідомленнях говорилося, що Disney стурбований дитячим ожирінням. Крім Disney, McDonald's також співпрацює з Nintendo з 1985 року, коли вперше було представлено систему Nintendo Entertainment System. У 1987 році McDonald's також створив ігрову зону Nintendo у своїх ресторанах, де діти могли грати на консолях Nintendo, чекаючи їжі. Протягом 2007 року McDonald's почав надавати WiFi з консолей Nintendo; даючи дітям можливість грати, де б вони не були. Маючи також цільову аудиторію дітей, які випускають ці нові фільми та включають іграшки, він використовує дітей, щоб потягнутись до кишень своїх батьків через їх великі інвестиції.nnnn### Response:n | McDonald's постійно спрямовує свою рекламу безпосередньо на молодь.nnПочинаючи з 1963 року, вони представили Рональда Макдональда, рекламний талісман клоуна, створений для маленьких дітей. Протягом багатьох років McDonald's співпрацювала з кількома компаніями, які виробляють продукти, орієнтовані на дітей, такими як Nintendo та Disney. | Ресторани швидкого харчування завжди були орієнтовані на молодь. Щаслива їжа також є важливим фактором, коли справа доходить до реклами для молоді.nОскільки виходить багато фільмів, Щаслива їжа також постачається з іграшкою для реклами цього фільму у вашому місцевому McDonald'snn—n## 400-999nn### Коментар:nAs молода компанія з відносно вузьким баченням світу, McDonald's | З моменту запуску McDonald's орієнтував свою аудиторію на маленьких дітей і підлітків завдяки своїм ресторанам швидкого харчування та продуктам харчування, орієнтованим на дітей, а також своїй рекламі, яка здебільшого орієнтована на молодь. У той час як батьки ведуть дітей до McDonalds, ресторан, по суті, є батьківською рекламою для їхніх дітей: McDonalds звертається до дітей своїми ресторанами яскравих кольорів та іграшками, які вони знаходять у їхній їжі, які звертаються до них. |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином доповнює запит.nn### Інструкція:nЩо таке Анандапурам Мандалnn### Вхідні дані:nАнандапурам Мандал — один із 46 мандалів у районі Вісакхапатнам індійського штату Андхра-Прадеш. Він знаходиться під адміністрацією відділу доходів Вісакхапатнама, а штаб-квартира розташована в Анандапурамі. Мандал Анандапурам межує з мандалом Бхіемуніпатнам на сході, Чингаділою на півдні, Падманабхамом на півночі та Котхаваласою на заході.nnnn### Відповідь:n | Анандапурамський мандал — один із 46 мандалів в окрузі Вішакхапатнам індійського штату Андхра-Прадеш. Він знаходиться під адміністрацією відділу доходів Вісакхапатнама, а штаб-квартира розташована в Анандапурамі. | нннн | Анандапурамський мандал — один із 46 мандалів в окрузі Вішакхапатнам індійського штату Андхра-Прадеш. Він знаходиться під адміністрацією відділу доходів Вісакхапатнама, а штаб-квартира розташована в Анандапурамі. Мандал Анандапурам обмежений мандалом Бхіемуніпатнам на сході, Чингаділа на півдні, Падманабхам на півночі та Кот |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершує запит.nn### Інструкція:nЩо сталося у Вудстокуnn### Вхідні дані:nWoodstock Music and Art Fair, зазвичай відомий як Woodstock, був музичним фестивалем, який проходив 15–18 серпня 1969 року Молочна ферма Макса Ясгура в Бетел, штат Нью-Йорк, США, за 40 миль (65 км) на південний захід від міста Вудсток. Оголошений як «Виставка Водолія: 3 дні миру та музики» та інший як Вудстокський рок-фестиваль, він привабив аудиторію з понад 400,000 1970 відвідувачів. Тридцять два виступи відбулися просто неба, незважаючи на спорадичний дощ. Це був один із найбільших музичних фестивалів в історії. nnФестиваль широко вважається ключовим моментом в історії популярної музики, а також визначальною подією для покоління контркультури. Важливість події була підкріплена документальним фільмом 2004 року, супровідним альбомом саундтреків і піснею, написаною Джоні Мітчеллом, яка стала головним хітом для Кросбі, Стіллз, Неш енд Янг і Метьюза Саузерн Комфорт. Музичні заходи під назвою «Вудсток» планувалися до ювілеїв, серед яких були десяте, двадцяте, двадцять п’яте, тридцяте, сорокове та п’ятдесяте. У 19 році журнал Rolling Stone включив його до списку 50 із 2017 моментів, які змінили історію рок-н-ролу. У XNUMX році місце проведення фестивалю було внесено до Національного реєстру історичних місць.nnnn### Відповідь:n | Ярмарок музики та мистецтва Вудсток, зазвичай відомий як Вудсток, був музичним фестивалем, який проводився протягом 15-18 серпня 1969 року на молочній фермі Макса Ясгура в Бетел, штат Нью-Йорк, США, за 40 миль (65 км) на південний захід від міста. Вудсток. Оголошений як «Виставка Водолія: 3 дні миру та музики» та інший як Вудстокський рок-фестиваль, він привабив аудиторію з понад 400,000 1970 відвідувачів. Тридцять два виступи відбулися просто неба, незважаючи на спорадичний дощ. Це був один із найбільших музичних фестивалів в історії. nnФестиваль широко вважається ключовим моментом в історії популярної музики, а також визначальною подією для покоління контркультури. Важливість події була підкріплена документальним фільмом 2004 року, супровідним альбомом саундтреків і піснею, написаною Джоні Мітчеллом, яка стала головним хітом для Кросбі, Стіллз, Неш енд Янг і Метьюза Саузерн Комфорт. Музичні заходи під назвою «Вудсток» планувалися до ювілеїв, серед яких були десяте, двадцяте, двадцять п’яте, тридцяте, сорокове та п’ятдесяте. У 19 році журнал Rolling Stone включив його до списку 50 із 2017 моментів, які змінили історію рок-н-ролу. У XNUMX році місце проведення фестивалю було внесено до Національного реєстру історичних місць. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Рішення:nn п Щоб переглянути рішення nn“`jsnn// Необхідне рішення | Вудстокський ярмарок музики та мистецтва, який відбувся в кінці 15–18 серпня, став історичною подією для покоління контркультури в Бетелі, Нью-Йорк. На фестивалі зібралися понад 400,000 тисяч людей. Близько 32 номерів виступили просто неба, незважаючи на спорадичний дощ. Його вважали одним із найбільших музичних фестивалів в історії.nn |

- Результати для точного налаштування моделі генерації тексту Llama 2 70B на наборі даних Dolly:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином доповнює запит.nn### Інструкція:nХто така компанія ABBnn### Вхідні дані:nABB Ltd. — це шведсько-швейцарська транснаціональна корпорація зі штаб-квартирою в Цюріху, Швейцарія. Компанія була заснована в 1988 році, коли шведська Allmänna Svenska Elektriska Aktiebolaget (ASEA) і швейцарська Brown, Boveri & Cie об’єдналися, щоб створити ASEA Brown Boveri, пізніше спрощену до ініціалів ABB. Обидві компанії були засновані наприкінці 1800-х років і були великими виробниками електрообладнання. АББ активно займається цим бізнесом і сьогодні. Відтоді компанія також розширила роботу до технологій автоматизації.nnnn### Response:n | ABB Ltd. — це шведсько-швейцарська транснаціональна корпорація зі штаб-квартирою в Цюріху, Швейцарія. Компанія була створена в 1988 році, коли шведська Allmanna Svenska Elektriska Aktiebolaget (ASEA) і швейцарська Brown, Boveri & Cie об’єдналися, щоб створити ASEA Brown Boveri, пізніше спрощену до ініціалів ABB. nnОбидві компанії були засновані наприкінці 1800-х років і були великими виробниками електрообладнання. АББ активно займається цим бізнесом і сьогодні. З тих пір компанія також розширила роботу до технологій автоматизації. | * ABB — це шведсько-швейцарська транснаціональна корпораціяnn### LognEND I/O DATA —n | ABB — це шведсько-швейцарська транснаціональна корпорація зі штаб-квартирою в Цюріху, Швейцарія. Компанія була заснована в 1988 році, коли шведська Allmänna Svenska Elektriska Aktiebolaget (ASEA) і швейцарська Brown, Boveri & Cie об’єдналися, щоб створити ASEA Brown Boveri, пізніше спрощену до ініціалів ABB. Обидві компанії були засновані наприкінці 1800-х років і були |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершить запит.nn### Інструкція:nЧому Вільгельм Завойовник, француз, став королем Англії?nn### Вхідні дані:nУ 1050-х і на початку 1060-х років Вільгельм став претендентом на престол Англії займав бездітний Едуард Сповідник, його двоюрідний брат колись був усунутий. Були й інші потенційні претенденти, зокрема могутній англійський граф Гарольд Годвінсон, якого Едвард назвав королем на смертному одрі в січні 1066 року. Стверджуючи, що Едвард раніше обіцяв йому трон і що Гарольд поклявся підтримувати його претензії, Вільям побудував велику флоту та вторгся до Англії у вересні 1066 р. Він рішуче переміг і вбив Гарольда в битві при Гастінгсі 14 жовтня 1066 р. Після подальших військових зусиль Вільгельма коронували на Різдво 1066 р. у Лондоні. Він домовився про управління Англією на початку 1067 року перед поверненням до Нормандії. Після цього відбулося кілька невдалих повстань, але до 1075 року Вільгельм здебільшого взяв контроль над Англією, що дозволило йому провести більшу частину свого правління в континентальній Європі.nnnn### Відповідь:n | Вільгельм Завойовник походив з Нормандії, розташованої на північному заході Франції. Королем Англії наприкінці 1050-х і на початку 1060-х років був Едуард Сповідник. Едвард був двоюрідним братом Вільяма. Оскільки Едуард був бездітним, було багато людей, які стверджували, що вони є законними спадкоємцями і повинні стати королем. Ці суперечливі вимоги спричинили збройний конфлікт. Вільгельм вторгся в Англію, де виграв битву при Гастінгсі, перемігши графа Гарольда Годвінсона. Після цього відбулася низка битв, але наприкінці 1066 року Вільгельм став королем Англії. Протягом наступного десятиліття він мав справу з кількома повстаннями, але зберіг свою владу. Зрештою він зміг повернутися до Нормандії та правити звідти Англією. | Вільгельм Завойовник став королем Англії, оскільки в 1050-х і на початку 1060-х років він став претендентом на трон Англії, який утримував бездітний Едуард Сповідник, його двоюрідний брат колись був видалений.nnnВідповідь може бути порожньою, але має міститися в межах 256 символів. п | Після смерті короля Гарольда в битві при Гастінгсі 14 жовтня 1066 року Вільгельм Завойовник був коронований королем Англії на Різдво 1066 року, започаткувавши нормандське завоювання Англії.nn |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином завершує запит.nn### Інструкція:nРозкажіть мені про RMS Adriaticnn### Вхідні дані:nRMS Adriatic був британським океанським лайнером White Star Line. Він був четвертим у квартеті кораблів вантажопідйомністю понад 20,000 1911 брутото-тоннаж, який отримав назву «Велика четвірка». Корабель був єдиним із чотирьох, який ніколи не був найбільшим у світі. Однак він був найбільшим, найшвидшим і найрозкішнішим із Великої четвірки, будучи першим океанським лайнером із критим басейном і турецькою лазнею. nnВона почала свою кар’єру на абсолютно новому маршруті з Саутгемптона до Нью-Йорка раніше. з 1917 року приєдналася до своїх сестринських суден на другорядному маршруті з Ліверпуля. Насправді це були повільні лайнери, призначені для обслуговування за помірними цінами. Коли почалася Перша світова війна, Адріатика була серед кораблів, які продовжували свою цивільну трансатлантичну службу, перевозячи багато провіанту. У 1930 році він був реквізований і служив як військовий транспорт.nnПісля війни він був кілька разів переобладнаний і поступово використовувався для круїзів, які стали її основними послугами в 1934-х роках. Коли Cunard Line і White Star Line об'єдналися в 1935 році, її швидко визнали непотрібною і продали в кінці року. Її здали на злам в Осаці в XNUMX році.nnnn### Відповідь:n | RMS Adriatic — британський океанський лайнер White Star Line. Він був четвертим у квартеті кораблів вантажопідйомністю понад 20,000 XNUMX брутото-тоннаж, який отримав назву «Велика четвірка». Корабель був єдиним із чотирьох, який ніколи не був найбільшим у світі. Однак він був найбільшим, найшвидшим і найрозкішнішим з Великої четвірки, будучи першим океанським лайнером, який мав критий басейн і турецьку лазню. | RMS Adriatic — британський океанський лайнер White Star Line. Він був четвертим у квартеті кораблів вантажопідйомністю понад 20,000 XNUMX брутото-тоннаж, який отримав назву «Велика четвірка». Корабель був єдиним із чотирьох, який ніколи не був найбільшим у світі. nn### КонтекстnЗапитання цього типу зазвичай використовується для запиту до пошукової системи. Вхід є введенням запиту, а відповідь є загальнодоступною | RMS Adriatic — британський океанський лайнер білої зіркової лінії. Він був спущений на воду в 1906 році, але її перше комерційне плавання відбулося в 1907 році. Він був четвертим з квартету кораблів водотоннажністю понад 20,000 1901 тонн, які отримали назву «Велика четвірка». Іншими трьома були RMS Celtic у 1903 році, RMS Baltic у XNUMX році та R |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином доповнює запит.nn### Інструкція:nЩо таке CGRO, що виявляє фотони?nn### Вхідні дані:nКомптонська гамма-обсерваторія (CGRO) була космічною обсерваторією, що виявляє фотони з енергією від 20 до 30 кеВ. ГеВ, на орбіті навколо Землі з 1991 по 2000 рік. Обсерваторія мала чотири головні телескопи в одному космічному кораблі, які охоплювали рентгенівське та гамма-промені, включаючи різні спеціалізовані підінструменти та детектори. Після 14 років зусиль обсерваторія була запущена з космічного човника Atlantis під час STS-37 5 квітня 1991 року та працювала до зняття з орбіти 4 червня 2000 року. Її було розгорнуто на низькій навколоземній орбіті на висоті 450 км (280 миль), щоб уникайте радіаційного поясу Ван Аллена. Це був найважчий астрофізичний корисний вантаж, який будь-коли літав на той час, вагою 17,000 37,000 кілограмів (XNUMX XNUMX фунтів).nnnn### Відповідь:n | CGRO — це Обсерваторія гамма-променів Комптона (CGRO) і була космічною обсерваторією, яка виявляла на Землі фотони з енергією від 20 кеВ до 30 ГеВ з 1991 по 2000 рік. | **Транскрибатор:** прилад EGRET виявляє фотони.nn | Обсерваторія гамма-променів Комптона (CGRO) вимірює фотони з енергією від 20 кеВ до 30 ГеВ.nn |

| Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином доповнює запит.nn### Інструкція:nНаскільки хороший піаніст Йоль Юм Сонн### Введення:nЙол Юм Сон (народився 2 травня 1986 р. у Вонджу, Південна Корея) — південнокорейський класичний виконавець піаніст. Вона вперше привернула міжнародну увагу в жовтні 2004 року у віці 18 років, коли виступила як солістка, виконавши фортепіанний концерт № 1 Ліста з Нью-Йоркським філармонічним оркестром під керуванням Лоріна Маазеля під час їхнього азійського туру в Сеулі, Теджоні та Токіо. Сон знову виступала з Maazel та Нью-Йоркською філармонією, коли вони повернулися до Сеульського центру мистецтв у лютому 2008 року, цього разу як солістка фортепіанного концерту Бетховена № 2.nn Її нагороди включають срібні медалі на Тринадцятому Міжнародному конкурсі піаністів імені Вана Кліберна (2009). ) та Міжнародного конкурсу імені Чайковського 2011 року, де вона також отримала нагороди за найкраще камерне концертне виконання та найкраще виконання твору на замовлення. Вона також отримала бронзову медаль на Міжнародному конкурсі майстрів піано Артура Рубінштейна (2005) nnnn### Відповідь:n | Йоль Юм Сон (народився 2 травня 1986, Вонджу, Південна Корея) — південнокорейський класичний піаніст. Вона вперше привернула міжнародну увагу в жовтні 2004 року у віці 18 років, коли виступила як солістка, виконавши фортепіанний концерт № 1 Ліста з Нью-Йоркським філармонічним оркестром під керуванням Лоріна Маазеля під час їхнього азійського туру в Сеулі, Теджоні та Токіо. Сон знову виступала з Maazel та Нью-Йоркською філармонією, коли вони повернулися до Сеульського центру мистецтв у лютому 2008 року, цього разу як солістка фортепіанного концерту Бетховена № 2.nn Її нагороди включають срібні медалі на Тринадцятому Міжнародному конкурсі піаністів імені Вана Кліберна (2009). ) та Міжнародного конкурсу імені Чайковського 2011 року, де вона також отримала нагороди за найкраще камерне концертне виконання та найкраще виконання твору на замовлення. Вона також отримала бронзову медаль на Міжнародному конкурсі майстрів піано Артура Рубінштейна (2005). | Yeol Eum Son — досвідчений піаніст, який виступав з деякими з найпрестижніших оркестрів світу. У 2009 році вона здобула срібло на Тринадцятому міжнародному конкурсі піаністів імені Вана Кліберна, а в 2005 році вона здобула бронзу на Міжнародному конкурсі майстрів піано Артура Рубінштейна. Вона продовжує з великим успіхом виступати по всьому світу. | Yeol Eum Son дуже хороший піаніст. Вона почала свою міжнародну кар’єру, приєднавшись до деяких із найвидатніших музикантів світу у віці 18 років. До 25 років вона вже була срібним призером двох міжнародних конкурсів.nn |

- Результати для точного налаштування моделі генерації тексту Llama 2 7B на наборі даних Dialogsum:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Підсумуйте це діалогове вікно:n#Person1#: Це чудова їжа!n#Person2#: Дякую. Я радий, що все вийшло так добре.n#Person1#: Хто навчив вас це добре готувати?n#Person2#: Я відвідував курс кулінарії в Кулінарному інституті.n#Person1#: Вау, що тут страва з куркою?n#Person2#: Хіба це не чудово? Це кокосово-імбирна курка з рисом.n#Person1#: Суп — це суп із креветок?n#Person2#: Так, там є креветки, морські овочі та лимонна трава.n#Person1#: Думаю, мені пощастило у виборі вина, яке поєднується з цією стравою.n#Person2#: Я вдячний, що ви принесли вино. Добре поєднується з куркою.n—nПідсумок:nnn### Відповідь:n | #Person1# вважає, що страва, приготована #Person2#, чудова. #Person2# представляє інгредієнти страви. | Після завершення діалогу особа надасть відповідну відповідь на зібрану інформацію. Наприклад, особа 1 може сказати:nn#Person1#: Це чудово! Дякую.nn#Person2#: Ласкаво просимо. Я думав, що тобі сподобається твоя їжа. Мені приємно, що вам це сподобалось.nn—n— — — — –nnn### Підсумок:nnn### Відповідь:nПісля діалогу | #Person1# і #Person2# їдять у #Person2#. Вони говорять про їжу та вино, які поєднуються з куркою.nn |

| Підведіть підсумок цього діалогу:n#Person1#: Вибачте, я пишу твір про Стародавню Грецію. Чи є якісь книги на цю тему, які ви можете порекомендувати?n#Person2#: Гуси? Хочете написати про старовинних гусей? Я ніколи не чув про таке. У будь-якому випадку, це було б із книгою про тварин, це рядок J. Або ви хочете спробувати науку, це в рядку Gn#Person1#: Тварини? Але Греція — це країна, а не тварина.n#Person2#: О, Греція. Ну, ти знаєш, сьогодні має бути твій щасливий день. Щойно ми отримали нову збірку книг на цю саму тему. Тут є автори в рядку Cn#Person1#: Я бачу. Це багато книг, які ви пропонуєте?n#Person2#: Що ж, книжка Робіна Сміта чудова, але вона дуже довга. Це та статуя на обкладинці. Є також один Мілтона Пайка. Спереду на ній зображений солдат. Як бачите, він не дуже товстий, тому читання не займе багато часу. Але, мабуть, найкраща книжка – це книга із зображенням стародавнього Олімпійського стадіону. Він отримав кілька нагород за історичні роботи.n#Person1#: Важко вирішити, але, боюся, у мене не вистачає часу на багато читання. Думаю, я візьму книгу Мілтона Пайка.n#Person2#: Добре. Чи можу я отримати вашу бібліотечну картку?n#Person1#: Звичайно, ось ви.n—nПідсумок:nnn### Відповідь:n | #Person1# просить #Person2# порекомендувати кілька книг про Стародавню Грецію. #Person2# пропонує один Робін Сміт, який дуже довгий, один Мілтона Пайка, який не дуже товстий, і той, який отримав кілька нагород за історичні роботи. Оскільки #Person1# не має достатньо часу, #Person1# отримає книгу Мілтона Пайка. | n—nnПідсумок:n | #Person1# пише есе про Стародавню Грецію. #Person2# рекомендує #Person1# книги про стародавню Грецію, які всі нещодавно отримані, і пропонує придбати книгу Мілтона Пайка.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Ну, я бачу, у вас є свої книги, Джордже. Але ти читаєш? Здається, ти просто розфарбовуєш.n#Person2#: Я позначаю важливі частини книги. Кольори призначені для різних речей.n#Person1#: Як що?n#Person2#: Основні ідеї — жовтий. Важливі деталі, про які слід пам’ятати, — це рожевий, а світло-зелений — для складних ідей.n#Person1#: Здається, це багато завдань. Ти не витрачаєш час?n#Person2#: Я так не думаю, мамо. Я прочитаю це все сьогодні ввечері. Завтра послухаю. А потім, коли прийде час вчитися, я вже знатиму більшу частину інформації.n#Person1#: У мій час ми просто читали книгу і намагалися запам’ятати інформацію.n#Person2#: Учитель сказав нам про важливість активне читання. І це найкращий спосіб навчатися з будь-якою швидкістю, яку ви виберете.n#Person1#: Розумію. І для чого цей блокнот?n#Person2#: Для того, щоб робити нотатки. Які речі ви записуєте?n#Person1#: Іноді я пишу резюме. На цій сторінці я записую питання. І, звичайно, у мене є ще одна сторінка, де я записую нові слова.n—nПідсумок:nnn### Відповідь:n | Джордж каже матері, що позначати важливі частини книги різними кольорами — це його спосіб навчання. Він також робить нотатки в блокноті та іноді пише конспект. | #Особа1#: Ой! Активне читання, запитання для читання, примітки до словника, підсумки та виділення. Тепер я бачу, яка у вас різниця, коли справа стосується вивчення інформації. Я вражений.n#Person2#: Дякую. Читання - найкращий спосіб дізнатися та запам'ятати нову інформацію. Ви зараз активно читаєте?n#Person1#: Хммм….. Мені доведеться про це подумати.nnn#Person | Джордж описує дії, які він робить, щоб швидко читати свої книги. Джордж показує мамі блокнот і пояснює, як робити нотатки.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Доброго ранку, сер. Чи можу я побачити ваш паспорт?n#Person2#: Так, звичайно. Ось воно.n#Person1#: Дякую. Це все ваше?n#Person2#: Ні, деякі з них належать моєму другу. Вам теж потрібен її паспорт?n#Person1#: Так, будь ласка. У вас є ручна поклажа?n#Person2#: Ви хочете, щоб я також її поклав на ремінь?n#Person1#: Так, будь ласка. Чи не могли б ви відкрити цю велику валізу?n#Person2#: Добре. Хвилинку. Це просто одяг і туалетні приналежності.n#Person1#: Добре. У вас є що задекларувати?n#Person2#: Я думаю, що нічого немає.n#Person1#: Будь-яка свіжа їжа, живі рослини чи тварини?n#Person2#: О, ні. Нічого з цього.n#Person1#: Дякую. Ви можете замкнути свою валізу. Ось ваші паспорти.n#Person2#: Щиро дякую.n—nПідсумок:nnn### Відповідь:n | #Person1# бачить паспорти друга #Person2# і #Person2# і перевіряє їхній багаж. #Person2# каже #Person1#, що їм нема чого декларувати. #Person1# відпускає їх. | > Я думаю, що нічого немає.nnn—n**Категорії:**nn- [Розмова (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Ключ:nn :джерело_інформації: 31 (TSA)n:джерело_інформації: 32 (TSA)nn—-n* Будь-які авторські права | Офіцер імміграційної служби просить #Person2# показати його паспорт і відкрити його велику валізу. #Person2# не має нічого для декларування, і він може замкнути свою валізу.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Китайський чай відомий у всьому світі. Я хочу купити кілька коробок.n#Person2#: У Китаї є різні види чаю. Залежить від смаку та ефекту.n#Person1#: Ну я взагалі не знаю китайський чай.n#Person2#: Це зелений чай, його можна пити влітку. Це може полегшити літню спеку та добре для підтримки ваших легенів.n#Person1#: Звучить цікаво. Що з цим?n#Person2#: Це чорний чай, він має сильний смак і сприяє травленню.n#Person1#: Що це? Пахне ароматно.n#Person2#: Жасминовий чай високої якості. Він ароматний і має приємний смак.n#Person1#: Я візьму жасминовий чай. Не могли б ви запакувати його разом із обгортковим папером і стрічкою? Це подарунок для мого друга.n#Person2#: Без проблем. Зачекайте хвилинку.n—nПідсумок:nnn### Відповідь:n | #Person2# рекомендує зелений чай, чорний чай і чай з жасмином #Person1#, який хоче купити китайський чай, а #Person1# вирішує взяти чай з жасмином. | #[Англійська]#: китайський чай відомий у всьому світі. Я хочу купити кілька коробок.n#[французька]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[іспанська]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[німецька]#: Ich mö | #Person1# хоче купити кілька коробок китайського чаю з різними сортами чаю. #Person2# допомагає #Person1# вибрати та запакує його.nn |

- Результати точного налаштування моделі Llama-2 13B на наборі даних Dialogsum:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Підсумуйте це діалогове вікно:n#Person1#: Місіс Томпсон колись була двобожницею, Джейсон.n#Person2#: Чому? У нас не повинно бути проблем чи що? Насправді ми були надзвичайно активними під час усього обговорення в класі сьогодні вранці.n#Person1#: Ось і все. Я не думаю, що це взагалі погано. Я думаю, що вона збирається попросити нас балотуватися на посаду керівника класу.n#Person2#: Ого! справді? Це велика відповідальність.n#Person1#: Ну, я думаю, ти б чудово впорався з цим. Крім того, це велика честь, коли мене попросили це зробити. Це означає, що місіс Томпсон вважає нас лідерами.n#Person2#: Хоча я не впевнений, чи зможу це зробити сам. Чи могли б ми зробити це разом?n#Person1#: Давайте запитаємо місіс Томпсон. Зараз я чую, як вона йде з коридору.n—nПідсумок:nnn### Відповідь:n | #Person1# розповідає Джейсону, що місіс Томпсон одного разу є дитеїсткою, і #Person1# здогадується, що вона хоче, щоб вони балотувалися на посаду наглядачів. Вони запитають у місіс Томпсон, чи можуть вони зробити це разом. | n* Коли вчитель запитав Джейсона та його однокласника, чи хочуть вони балотуватися на пост класного керівника, він і його однокласник погодилися. Обидва хлопці є християнами, але вони не є друзями в класі.n* Їхня віра в Ісуса може не розголошуватися публічно, але це видно через молитву та приклад, який вони разом наслідують, щоб допомагати іншим і виявляти любов.nn—n## 1654nn **[Ситуація:** Учні розповідають про нещодавнє | Місіс Томпсон просить Джейсона та Джеймса балотуватися на посаду керівника класу, оскільки вона вважає їх лідерами.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Гей, давайте зупинимось і подивимося на той будинок там.n#Person2#: Так, це виглядає чудово! Це в нашому списку відкритих дверей?n#Person1#: Так, це в нашому списку.n#Person2#: Що ж, це чудово виглядає з бордюру. Давайте зайдемо всередину.n#Person1#: Давайте підпишемо реєстр. Здається, що ріелтор зараз трохи зайнятий.n#Person2#: Гаразд, давайте перевіримо кухню.n#Person1#: Ой, дивіться, у них тут є прохолодні напої.n#Person2#: Переконайтеся, що ви забрали листівка з інформацією про дім.n#Person1#: Чи вказано, скільки вони просять за цей будинок?n#Person2#: Так, здається, на нього знижено з двохсот тридцяти п’яти тисяч до двохсот і двадцять п'ять тисячn—nПідсумок:nnn### Відповідь:n | #Особа1# і #Особа2# прийшли подивитися на будинок. Вони дивляться всередину і говорять про його ціну. | Це відповідь ГІМ на наступний стимул.nnОсоба 2: nТак, це виглядає чудово! Це в нашому списку Дня відкритих дверей? nТак, він є в нашому списку.nНу, він чудово виглядає з бордюру. Давайте зайдемо всередину.nДавайте підпишемо реєстр. Ріелтор наразі виглядає дещо зайнятим.nOK, давайте перевіримо кухню.nOh дивіться, у них є | #Person1# і #Person2# оглядають будинок, який є в їхньому списку Днів відкритих дверей. Вони підписують реєстр, і #Person2# каже #Person1# взяти листівку з інформацією.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Як справи, містере Вілсон? Я Тіна.n#Person2#: Рада познайомитися з вами, пані Тіна.n#Person1#: Будь ласка, сідайте. Я знаю, що наша служба примусу вже надала вам інформацію про ваш трудовий договір, але я хотів би ще раз переглянути основні деталі перед підписанням. По-перше, ви отримуватимете щомісячну зарплату з місячною оплачуваною відпусткою після одного року служби.n#Person2#: Це те, що я розумію.n#Person1#: Ви будете охоплені нашим медичним планом під час виконання обов’язків. Оскільки ви будете керівником середньої ланки, очікується, що ви будете доступні до 1 години після звичайного робочого часу. Будь-який затверджений понад цей час оплачуватиметься півтора разами, які ви можете взяти як зарплату або відгул.n#Person5#: Я так розумію.n#Person2#: Розумна кількість днів хвороби покриватиметься компанією . Будь-яка тривала хвороба буде покрита страхуванням. Ви читали інші умови контракту?n#Person1#: Так, я читав.n#Person2#: Чи є у вас інші запитання?n#Person1#: Лише одне. Я помітив пункт про гнучкий час. Чи є така можливість для мене?n#Person2#: Так, але вам доведеться обговорити деталі зі своїм керівником.n#Person1#: Це прийнятно.n#Person2#: Добре. Тепер, якщо ви просто підпишете тут, ви зможете почати роботу через 1 дні.n—nПідсумок:nnn### Відповідь:n | Містер Вілсон описує Тіні елементарну інформацію про трудовий договір. Він згадує місячну зарплату, місячну оплачувану відпустку, плани лікування, подовжений робочий день і гнучкий графік. | nНі, резюме неправильне. У діалогових вікнах #Person1 не вказано ім’я Тіна, вони не представляються. Я думаю, що вони обоє знають імена один одного, тож це непотрібно.nnЯ думаю, якщо все інше правильно, резюме не зміниться, якщо #Person1 не закінчиться, і це нормально.nn | Тіна зустрічається з містером Вілсоном, щоб обговорити основні деталі трудового контракту Тіни. Вони обговорюють місячну зарплату та медичний план. У Тіни немає питань і приступить до роботи через 3 дні.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Джек, яка ваша улюблена тема?n#Person2#: Мій улюблений предмет? Ну, я думаю, я віддаю перевагу науці. Так, наука, мені це дуже цікаво. Учитель природознавства робить предмет дуже захоплюючим. А ви?n#Person1#: Я завжди дуже добре складаю тести з математики. Мені також подобається географія. Мені подобається вивчати людей і місця, де вони живуть. Чи є предмети, які тобі не подобаються, Джек?n#Person2#: Я не дуже люблю фізику. Це нелегко зрозуміти, більшості дітей це нудно.n—nПідсумок:nnn### Відповідь:n | Улюблений предмет Джека - наука, а фізику він не дуже любить. #Людина1# любить математику та географію. | n—nn### Слово: «улюблений» (adj)nnЗначення: Любив, цінував більшість інших nПриклади: Моя улюблена книга — Біблія; Який твій улюблений спорт?; Мій улюблений колір синій.nn—nnnn### Який у вас ____ предмет? (формальний)nn Діалог запитань і відповідей:nn#Особа1#: Який твій улюблений предмет?n# | Джек і Джек говорять про свої улюблені і найменш улюблені теми.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Привіт, Меґі. Я бачив твою картину на художній виставці в кінці року, на яку ходили всі батьки. Це було чудово.n#Person2#: Що ж, наша вчителька мистецтва була дуже задоволена цим, але я не знаю, що про це подумали батьки.n#Person1#: О, не хвилюйтеся. Я чув, як вони говорили про це лише хороші слова.n#Person2#: Хм… Він, мабуть, не помітив, що я використала неправильні кольори.n#Person1#: Я не думаю, що хтось помітив.n#Person2# : Ні, але я зробив. Але було пізно щось робити. Що ж, наступного разу я, сподіваюся, зроблю щось краще.n—nПідсумок:nnn### Відповідь:n | #Person1# побачив картину Меґі та вважає, що вона чудова, але Меґі хвилюється, що використала неправильні кольори, і сподівається, що наступного разу вона зробить щось краще. | Це резюме має висвітлити ключові моменти та висновки з обговорення.nn# Відповісти Особі1:n[Підсумок відповіді]nn—n### Відповідь:nЦе резюме має висвітлити ключові моменти та висновки з обговорення.nn# Відповісти Особі2 :n[Підсумок відповіді]nn### Особа1:n[Підсумок Особи1]n—n### Особа2:n[Підсумок Особи2]nn### Особа—n | #Person1# побачила картину Меггі та сказала Меггі, що багато батьків добре відгукуються про картину Меггі. Меґі так не вважає.nn |

- Результати точного налаштування моделі Llama 2 70B на наборі даних Dialogsum:

| Витрати | Грунтова правда | Відповідь від неточно налаштованої моделі | Відповідь від Fine-Tuned Model |

| Підсумуйте це діалогове вікно:n#Person1#: Ви отримали будь-який ступінь?n#Person2#: Так. У 1996 році я отримав ступінь бакалавра наук в Університеті Гебес, а в 2001 році я отримав ступінь магістра ділового адміністрування в Пекінському університеті.n#Person1#: Як щодо ваших академічних записів у коледжі?n#Person2#: Насправді мої записи були відмінними. Мій загальний середній бал був 9 за 10-бальною шкалою, що було найвищим у моєму класі.n#Person1#: Це дуже вражаюче. Який курс вам найбільше сподобався?n#Person2#: англійська. Це було і цікаво, і корисно, тому я виявив великий інтерес до цього.n#Person1#: Чи можете ви сказати мені, чому ви змінили спеціальність, коли були аспірантом?n#Person2#: Тому що я дуже цікавлюся адмініструванням і Я пройшов деякі курси з цього. З предметів я також показав хороші результати. Тому я вважаю, що зможу добре працювати на цій посаді.n#Person1#: Ви отримували відзнаки та нагороди в коледжі?n#Person2#: Так. Щороку я отримував стипендію від університету. У 1995 році я брав участь у Всеукраїнському конкурсі моделей з математики і отримав приз.n—nПідсумок:nnn### Відповідь:n | #Person1# бере інтерв'ю у #Person2# і задає #Person2# деякі запитання, зокрема про дипломи #Person2#, академічні записи, улюблений курс і нагороди в коледжі. #Person2# також розповідає #Person1#, чому #Person2# змінив спеціальність на адміністрування. | Кандидат резюмував, що основна ідея діалогу в тому, що він отримав два дипломи, 0. І спеціальності добре впоралися. nОднак його перше речення не викликає особливих емоцій, окрім нарцисизму, і не пояснює, чому його досвід має відношення до компанії. Він міг би встановити кращий зв’язок і, можливо, завершити короткий виклад із прихованими емоціями/ставленням, відмінним від «професійного» (як він робить у діалозі). | #Person2# розповідає #Person1# #Person2# отримав ступінь бакалавра та MBA. Середній бал #Person2# є найвищим у класі #Person2#, і #Person2# зацікавлений в адмініструванні. #Person2# також отримав деякі відзнаки та нагороди на college.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Вибачте, який це матеріал? n#Person2#: Ракі. Хочеш? n#Person1#: Ні, де бавовняні тканини? n#Person2#: Я тобі покажу. n#Person1#: Яка швидкість усадки після прання? n#Особа2#: Менше 5%. Він досить міцний. n—nПідсумок:nnn### Відповідь:n | #Person2# каже #Person1#, що бавовняний одяг довговічний. | Для маршруту QA41913 цей розділ має містити підсумок абзацу діалогового вікна, щоб, наприклад, система автоматичного генерування вимови та мовлення могла використовувати цей текст для вихідного синтезу. | #Person1# хоче трохи бавовняної тканини. #Person2# показує деякі rhaki.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Вибачте, я запізнився, Том.n#Person2#: Усе гаразд, Рита. Де ти був?n#Person1#: У відділку поліції. Я загубив свою сумочку. Або, можливо, хтось забрав. Я не знаю.n#Person2#: О, ні. Що сталося? Сідай. Чи було в ньому щось важливе?n#Person1#: Важливо! Моя чекова книжка, усі документи, які мені потрібні для роботи.n#Person2#: О, це жахливо. Але як ти його втратив?n#Person1#: Ну, як ти знаєш, я був з другом весь ранок, і ми разом обідали. Пообідавши, я пішов за покупками. І коли я хотів щось купити, я не міг знайти свою чекову книжку. Потім я згадала, що це в моїй сумочці. А моя сумочка була в моїй машині.n#Person2#: Отже, ви повернулися до своєї машини.n#Person1#: Але я її там не знайшов.n#Person2#: І ви пішли до поліцейської дільниці?n# Особа1#: Не відразу. Перед тим, як піти до поліцейської дільниці, я зателефонував до свого друга. Не пощастило.n#Person2#: Ви повинні піти в ресторан, де ви обідали, і пошукати його.n#Person1#: О, я мав це зробити.n#Person2#: Тепер вам краще зателефонувати менеджеру прямо зараз далеко.n—nПідсумок:nnn### Відповідь:n | Ріта каже Тому, що вона спізнилася, тому що втратила свою сумочку та її зусилля з пошуку сумочки. Том пропонує Ріті піти в ресторан, де вона обідала, і пошукати його. | Перекладіть кожне речення англійською мовою, використовуючи словосполучення, яке вам найбільше подобається:n### Значення:n | Рита загубила свою сумочку, і Том радить їй піти в ресторан, де вона обідала, щоб її знайти.nn |

| Підсумуйте це діалогове вікно:n#Person1#: Доброго дня, мамо!n#Person2#: Доброго дня, Мег. Ти сьогодні виглядаєш погано? Ти хворий?n#Person1#: Ні, я не хворий.n#Person2#: Тоді, що з тобою, моя дитино?n#Person1#: Нічого.n#Person2#: Ой, давай, крихітко. Розкажи мені, що сталося.n#Person1#: I. . . Мені не вдалося скласти іспит. Як би я хотів старанно вчитися.n#Person2#: О. Заспокойся. Ви можете встановити свою ціль із сьогоднішнього дня.n#Person1#: Добре, мамо. Я не провалю іспит наступного разу.n—nПідсумок:nnn### Відповідь:n | Мег не в настрої, тому що вона провалила іспит. Її мама заохочує її поставити перед собою мету з сьогоднішнього дня. | Aide sans action verbnAide et прямий об’єкт apres le verbe amountn | #Особа1# не пройшла іспит і розповідає про це мамі. Мама заохочує #Person1# вчитися старанніше.nn |