Організації по всьому світу змагаються за впровадження технологій штучного інтелекту у свої програми та інструменти кібербезпеки. А більшість (65%) розробників використовувати або планувати використання ШІ під час тестування в наступні три роки. Є багато програм безпеки, які виграють від генеративного штучного інтелекту, але чи є виправлення коду одним із них?

Для багатьох команд DevSecOps генеративний штучний інтелект є святим Граалем для усунення зростаючої кількості вразливостей. Значно більше половини (66%) організацій стверджують, що їхні резерви складаються з понад 100,000 XNUMX уразливостей, а понад дві третини результатів статичного тестування безпеки додатків (SAST) залишаються відкритими через три місяці після виявлення, з 50% залишаються відкритими через 363 дні. Мрія полягає в тому, щоб розробник міг просто попросити ChatGPT «виправити цю вразливість», і години та дні, витрачені раніше на усунення вразливостей, відійдуть у минуле.

Теоретично це не зовсім божевільна ідея. Зрештою, машинне навчання роками ефективно використовувалося в інструментах кібербезпеки для автоматизації процесів і економії часу — штучний інтелект надзвичайно корисний у застосуванні до простих завдань, що повторюються. Але на практиці застосування генеративного ШІ до програм зі складним кодом має деякі недоліки. Без людського нагляду та експрес-команд команди DevSecOps можуть створити більше проблем, ніж вирішити.

Переваги та обмеження генеративного штучного інтелекту, пов’язані з кодом фіксації

Інструменти штучного інтелекту можуть бути неймовірно потужними інструментами для простого аналізу кібербезпеки з низьким рівнем ризику, моніторингу або навіть потреб у виправленні ситуації. Занепокоєння виникає, коли ставки стають непрямими. Зрештою, це питання довіри.

Дослідники та розробники все ще визначають можливості нової генеративної технології ШІ створювати складні виправлення коду. Generative AI покладається на наявну доступну інформацію для прийняття рішень. Це може бути корисно для таких речей, як переклад коду з однієї мови на іншу або виправлення відомих недоліків. Наприклад, якщо ви попросите ChatGPT «написати цей код JavaScript на Python», ви, швидше за все, отримаєте хороший результат. Використовувати його для виправлення конфігурації безпеки хмари було б корисно, оскільки відповідна документація для цього є загальнодоступною та її легко знайти, а ШІ може виконувати прості інструкції.

Однак для усунення більшості вразливостей коду потрібно діяти з урахуванням унікальних обставин і деталей, запроваджуючи більш складний сценарій для навігації ШІ. ШІ може надати «виправлення», але без перевірки йому не варто довіряти. Генеративний штучний інтелект, за визначенням, не може створити щось, про що ще не відомо, і він може відчувати галюцинації, які призводять до фальшивих результатів.

У недавньому прикладі юрист зіткнувся з серйозними наслідками після використання ChatGPT для написання судових документів, у яких цитувалися шість неіснуючих справ, винайдений інструментом ШІ. Якби ШІ галюцинував методи, яких не існує, а потім застосував ці методи для написання коду, це призвело б до втрати часу на «виправлення», яке неможливо скомпілювати. Крім того, згідно з OpenAI Офіційний документ GPT-4, нові експлойти, втечі з в’язниці та випадкові поведінки будуть виявлені з часом, і їм важко запобігти. Тому необхідно уважно поставитися до перевірки та регулярного оновлення інструментів безпеки штучного інтелекту та сторонніх рішень, щоб вони не стали ненавмисними бекдорами в систему.

Довіряти чи не довіряти?

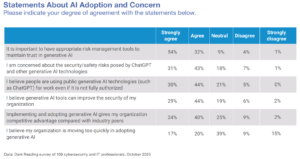

Цікаво спостерігати за швидким впровадженням генеративного штучного інтелекту на піку руху нульової довіри. Більшість інструментів кібербезпеки побудовані на ідеї, що організації ніколи не повинні довіряти, завжди перевіряти. Генеративний ШІ побудований на принципі внутрішньої довіри до інформації, наданої йому відомими та невідомими джерелами. Це зіткнення принципів виглядає як відповідна метафора для постійної боротьби, з якою стикаються організації, намагаючись знайти правильний баланс між безпекою та продуктивністю, яка зараз особливо загострюється.

Хоча генеративний штучний інтелект ще не є святим граалем, на який сподівалися команди DevSecOps, він допоможе досягти поступового прогресу в зменшенні відставання вразливостей. Наразі його можна застосувати для внесення простих виправлень. Для більш складних виправлень їм потрібно буде прийняти методологію verify-to-trust, яка використовує потужність ШІ, керуючись знаннями розробників, які написали та володіють кодом.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://www.darkreading.com/application-security/can-generative-ai-be-trusted-to-fix-your-code-

- : має

- :є

- : ні

- $UP

- 000

- 100

- 7

- a

- За

- діючий

- Додатково

- прийняти

- Прийняття

- Переваги

- після

- AI

- ВСІ

- вже

- завжди

- an

- аналіз

- та

- Інший

- додаток

- захист додатків

- застосування

- прикладної

- Застосовувати

- Застосування

- ЕСТЬ

- At

- автоматизувати

- доступний

- бекдори

- Balance

- BE

- оскільки

- ставати

- було

- корисний

- користь

- між

- побудований

- але

- by

- CAN

- можливості

- обережний

- випадків

- ChatGPT

- обставин

- цитується

- Зіткнення

- Очищення

- хмара

- Хмара безпеки

- код

- комплекс

- У складі

- Занепокоєння

- конфігурація

- Наслідки

- наслідкові

- розгляду

- може

- Суд

- Судові документи

- божевільний

- створювати

- створення

- Кібербезпека

- Днів

- рішення

- визначення

- деталі

- Виявлення

- визначення

- Розробник

- розробників

- важкий

- відкритий

- do

- документація

- мрія

- динамічний

- легко

- фактично

- кінець

- забезпечувати

- повністю

- Навіть

- приклад

- існувати

- існуючий

- досвід

- подвигів

- експрес

- Face

- облицювання

- підроблений

- тирсу

- виявлення

- результати

- пристосування

- виправляти

- недоліки

- стежити

- для

- знайдений

- від

- генеративний

- Генеративний ШІ

- отримати

- добре

- Половина

- висота

- допомога

- корисний

- сподіваючись

- ГОДИННИК

- HTML

- HTTPS

- Величезно

- людина

- ідея

- if

- in

- зростаючий

- неймовірно

- інформація

- притаманне

- інструкції

- цікавий

- в

- введення

- Винайдений

- питання

- IT

- JavaScript

- JPG

- знання

- відомий

- мова

- юрист

- вивчення

- як

- Ймовірно

- недоліки

- ll

- низький ризик

- машина

- навчання за допомогою машини

- made

- Більшість

- зробити

- багато

- Методологія

- методика

- може бути

- момент

- моніторинг

- місяців

- більше

- найбільш

- руху

- Переміщення

- Необхідність

- потреби

- ніколи

- Нові

- наступний

- не існує

- зараз

- of

- on

- ONE

- відкрити

- OpenAI

- or

- порядок

- організації

- з

- над

- Нагляд

- власний

- особливо

- Минуле

- план

- plato

- Інформація про дані Платона

- PlatoData

- Play

- влада

- потужний

- практика

- запобігати

- раніше

- принцип

- Принципи

- проблеми

- процеси

- продуктивність

- програми

- прогрес

- забезпечувати

- публічно

- Python

- Гонки

- швидко

- останній

- зниження

- регулярно

- пов'язаний

- доречний

- залишатися

- решті

- повторювані

- Повідомляється

- представляє

- вимагається

- Вимагається

- результат

- право

- s

- зберегти

- say

- сценарій

- безпеку

- побачити

- Здається,

- серйозний

- комплект

- Повинен

- простий

- просто

- SIX

- So

- Рішення

- ВИРІШИТИ

- деякі

- що в сім'ї щось

- Джерела

- відпрацьований

- Як і раніше

- боротьба

- система

- завдання

- команди

- Технології

- Технологія

- Тестування

- ніж

- Що

- Команда

- інформація

- їх

- Їх

- потім

- теорія

- Там.

- вони

- річ

- речі

- третя сторона

- це

- ті

- три

- час

- до

- інструмент

- інструменти

- Довіряйте

- Довірений

- дві третини

- Зрештою

- створеного

- невідомий

- оновлений

- використання

- використовуваний

- використання

- перевірка

- перевірити

- перевірено

- Уразливості

- вразливість

- добре відомі

- були

- коли

- який

- ВООЗ

- волі

- з

- без

- світовий

- б

- запис

- лист

- років

- ще

- Ти

- вашу

- зефірнет