Вступ

Команда комп'ютерників створила a спритніший, більш гнучкий тип моделі машинного навчання. Хитрість: він повинен періодично забувати те, що він знає. І хоча цей новий підхід не витіснить величезні моделі, які лежать в основі найбільших програм, він може розкрити більше про те, як ці програми розуміють мову.

Нове дослідження знаменує «значний прогрес у цій галузі». Джеа Квон, інженер ШІ в Інституті фундаментальних наук у Південній Кореї.

Механізми мов штучного інтелекту, які використовуються сьогодні, здебільшого працюють на основі штучні нейронні мережі. Кожен «нейрон» у мережі — це математична функція, яка отримує сигнали від інших таких нейронів, виконує певні обчислення та надсилає сигнали через кілька шарів нейронів. Спочатку потік інформації є більш-менш випадковим, але завдяки навчанню потік інформації між нейронами покращується, оскільки мережа адаптується до даних навчання. Наприклад, якщо дослідник штучного інтелекту хоче створити двомовну модель, він повинен навчати модель великою купою тексту з обох мов, що регулюватиме зв’язки між нейронами таким чином, щоб співвідносити текст однією мовою з еквівалентом. слова в ін.

Але цей навчальний процес потребує багато обчислювальної потужності. Якщо модель працює не дуже добре, або якщо потреби користувача змінюються згодом, її важко адаптувати. «Скажімо, у вас є модель зі 100 мовами, але уявіть, що жодна мова, яку ви хочете, не охоплює», — сказав Мікель Артече, співавтор нового дослідження та засновник AI-стартапу Reka. «Ви можете почати з нуля, але це не ідеально».

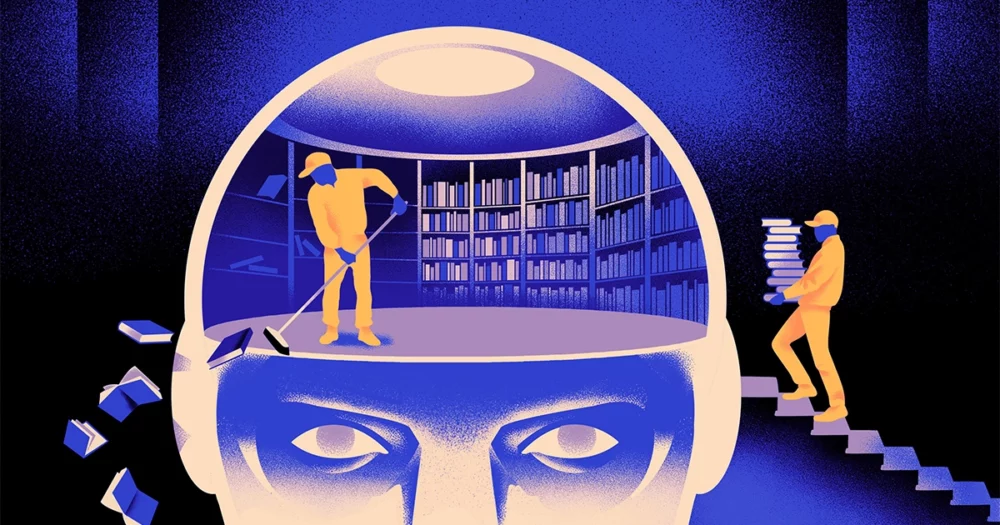

Артече та його колеги намагалися обійти ці обмеження. Кілька років назад, Artetxe та інші навчили нейронну мережу одній мові, а потім стерли те, що вона знала про будівельні блоки слів, які називаються токенами. Вони зберігаються на першому рівні нейронної мережі, який називається рівнем вбудовування. Вони залишили всі інші шари моделі в спокої. Після стирання лексем першої мови вони переналаштували модель на другу мову, яка заповнила рівень вбудовування новими лексемами з цієї мови.

Незважаючи на те, що модель містила невідповідну інформацію, перенавчання спрацювало: модель могла вивчати та обробляти нову мову. Дослідники припустили, що в той час як рівень вбудовування зберігає інформацію, специфічну для слів, які використовуються в мові, глибші рівні мережі зберігають більш абстрактну інформацію про концепції людських мов, що потім допомогло моделі вивчити другу мову.

«Ми живемо в одному світі. Ми концептуалізуємо одні й ті самі речі різними словами», — сказав він Іхонг Чен, провідний автор нещодавньої статті. «Саме тому ви маєте те саме міркування високого рівня в моделі. Яблуко – це щось солодке і соковите, а не просто слово».

Вступ

Хоча цей підхід із забуттям був ефективним способом додавання нової мови до вже навченої моделі, перенавчання все одно було вимогливим — воно вимагало багато лінгвістичних даних і потужності обробки. Чен запропонував налаштування: замість навчання, стирання шару вбудовування, а потім повторного навчання, вони повинні періодично скидати рівень вбудовування під час початкового раунду навчання. «Завдяки цьому вся модель звикає до скидання», — сказав Артече. «Це означає, що коли ви хочете розширити модель іншою мовою, це легше, тому що це те, що ви робите».

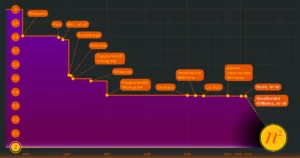

Дослідники взяли загальновживану мовну модель під назвою Roberta, навчили його, використовуючи свою техніку періодичного забування, і порівняли його з продуктивністю тієї ж моделі, коли її навчили за стандартним підходом без забування. Модель забування показала себе трохи гірше, ніж звичайна, отримавши оцінку 85.1 у порівнянні з 86.1 за одним звичайним показником точності мови. Потім вони перенавчили моделі на інші мови, використовуючи набагато менші набори даних лише з 5 мільйонів токенів замість 70 мільярдів, які вони використовували під час першого навчання. Точність стандартної моделі в середньому знизилася до 53.3, а моделі, що забуває, впала лише до 62.7.

Модель забування також виявилася набагато кращою, якщо команда наклала обмеження на обчислення під час повторного навчання. Коли дослідники скоротили тривалість навчання зі 125,000 5,000 кроків до 57.8 37.2, точність моделі забування знизилася в середньому до XNUMX, тоді як стандартна модель впала до XNUMX, що не краще, ніж випадкові припущення.

Вступ

Команда прийшла до висновку, що періодичне забування, схоже, покращує модель у вивченні мов загалом. «Оскільки [вони] постійно забувають і навчаються заново під час навчання, навчити мережу чогось нового згодом стає легше», — сказав Євген Нікішин, дослідник Mila, дослідницького центру глибокого навчання в Квебеку. Це свідчить про те, що коли мовні моделі розуміють мову, вони роблять це на глибшому рівні, ніж просто значення окремих слів.

Цей підхід схожий на те, як працює наш власний мозок. «Людська пам’ять загалом не дуже добре здатна точно зберігати великі обсяги детальної інформації. Натомість люди схильні запам’ятовувати суть нашого досвіду, абстрагуючи та екстраполюючи», – сказав Бенджамін Леві, невролог з Університету Сан-Франциско. «Увімкнення штучного інтелекту з більш схожими на людину процесами, як-от адаптивне забування, є одним із способів отримати більш гнучку продуктивність».

На додаток до того, що це може сказати про те, як працює розуміння, Artetxe сподівається, що більш гнучкі мовні моделі забування можуть також допомогти перенести останні прориви ШІ на більше мов. Хоча моделі штучного інтелекту добре володіють іспанською та англійською, двома мовами з достатньою кількістю навчальних матеріалів, моделі не так добре володіють його рідною баскською мовою, місцевою мовою північно-східної Іспанії. «Більшість моделей великих технологічних компаній не роблять цього добре», — сказав він. «Адаптація існуючих моделей до баскської — це шлях».

Чень також з нетерпінням чекає світу, де розквітне більше квітів ШІ. «Я маю на увазі ситуацію, коли світу не потрібна одна велика мовна модель. У нас так багато", - сказала вона. «Якщо є фабрика, що виготовляє мовні моделі, вам потрібна така технологія. Він має одну базову модель, яка може швидко адаптуватися до нових доменів».

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- : має

- :є

- : ні

- :де

- ][стор

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- МЕНЮ

- РЕЗЮМЕ

- точність

- точно

- пристосовувати

- адаптивний

- адаптує

- додавати

- доповнення

- просування

- після

- AI

- Моделі AI

- ВСІ

- тільки

- вже

- Також

- суми

- an

- та

- Інший

- Apple

- підхід

- додатка

- ЕСТЬ

- AS

- At

- автор

- середній

- база

- основний

- оскільки

- стає

- було

- за

- Краще

- між

- Великий

- великий техн

- найбільший

- Мільярд

- блоки

- Цвісти

- обидва

- прориви

- приносити

- Створюємо

- але

- by

- розрахунки

- званий

- CAN

- Центр

- зміна

- Чень

- обійти

- Співавтор

- колеги

- загальний

- зазвичай

- Компанії

- порівняний

- обчислювальна

- комп'ютер

- обчислення

- обчислювальна потужність

- поняття

- уклали

- Зв'язки

- містяться

- звичайний

- може

- покритий

- створювати

- створений

- Вирізати

- дані

- набори даних

- знизився

- глибокий

- глибоке навчання

- глибше

- вимогливий

- докладно

- DID

- різний

- do

- Ні

- справи

- домени

- Не знаю

- впав

- під час

- кожен

- легше

- Ефективний

- вбудовування

- інженер

- Двигуни

- англійська

- Весь

- Еквівалент

- приклад

- існуючий

- Досліди

- продовжити

- завод

- кілька

- поле

- заповнений

- Перший

- гнучкий

- потік

- для

- Вперед

- засновник

- Франциско

- від

- функція

- Загальне

- в цілому

- отримати

- GitHub

- Go

- добре

- Обробка

- Жорсткий

- Мати

- he

- допомога

- допоміг

- на вищому рівні

- його

- сподівається,

- Як

- HTTPS

- величезний

- людина

- людський

- Людей

- ідеальний

- if

- картина

- накладений

- поліпшується

- in

- індивідуальний

- інформація

- початковий

- спочатку

- замість

- Інститут

- IT

- просто

- тримати

- Дитина

- знає

- Корея

- мова

- мови

- великий

- пізніше

- останній

- шар

- шарів

- вести

- УЧИТЬСЯ

- вивчення

- залишити

- довжина

- менше

- рівень

- рівні

- як

- недоліки

- рамки

- жити

- місцевий

- ВИГЛЯДИ

- серія

- машина

- навчання за допомогою машини

- журнал

- зробити

- Робить

- багато

- Матеріали

- математичний

- значення

- засоби

- вимір

- пам'ять

- може бути

- мільйона

- модель

- Моделі

- більше

- в основному

- багато

- множинний

- повинен

- рідний

- Необхідність

- потреби

- мережу

- нервовий

- нейронної мережі

- Нейрони

- Нові

- немає

- of

- on

- ONE

- тільки

- or

- Інше

- інші

- наші

- над

- власний

- Папір

- продуктивність

- періодичний

- plato

- Інформація про дані Платона

- PlatoData

- занурився

- влада

- Харчування

- процес

- процеси

- обробка

- Обробна потужність

- програми

- Квантамагазин

- Квебек

- швидко

- випадковий

- швидше

- отримує

- отримання

- останній

- запам'ятати

- вимагається

- дослідження

- дослідник

- Дослідники

- показувати

- круглий

- пробіжки

- Зазначений

- то ж

- Сан -

- Сан Франциско

- say

- наука

- Вчені

- рахунок

- подряпати

- другий

- Здається,

- селективний

- посилає

- набори

- вона

- Повинен

- сигнали

- значний

- аналогічний

- ситуація

- менше

- So

- деякі

- що в сім'ї щось

- Південь

- South Korea

- Іспанія

- іспанська

- конкретний

- standard

- старт

- введення в експлуатацію

- заходи

- Як і раніше

- зберігати

- зберігання

- такі

- Запропонує

- солодкий

- приймає

- Навчання

- команда

- технології

- технічних компаній

- техніка

- Технологія

- як правило,

- текст

- ніж

- Що

- Команда

- інформація

- світ

- їх

- Їх

- потім

- Ці

- вони

- речі

- Мислення

- це

- хоча?

- через

- до

- сьогодні

- Жетони

- прийняли

- поїзд

- навчений

- Навчання

- трюк

- намагався

- щипати

- два

- розуміти

- розуміння

- університет

- використання

- використовуваний

- використання

- дуже

- хотіти

- хоче

- було

- шлях..

- we

- webp

- ДОБРЕ

- Що

- коли

- який

- в той час як

- чому

- з

- слово

- слова

- Work

- працював

- працює

- світ

- гірше

- б

- років

- Ти

- зефірнет