Дані користувачів: LLMs’ Vital Food

Так! RT @bryce подобається ця цитата: «Якщо ви не платите за це, ви не клієнт; ви продукт, який продається». http://bit.ly/93JYCJ

— Тім О’Райлі (@timoreilly) Вересень 2, 2010

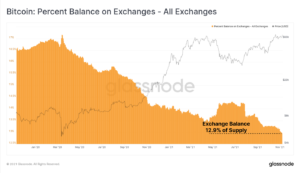

Будьте в курсі криптовалютних новин, отримуйте щоденні оновлення на свою поштову скриньку.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- : має

- :є

- : ні

- 7

- 8

- a

- здатність

- абсолют

- За

- точний

- пристосування

- адресація

- Додає

- просунутий

- назад

- погоджується

- AI

- Послуги ШІ

- Системи ШІ

- Цілі

- Alexa

- Вирівнює

- ВСІ

- дозволяє

- Також

- завжди

- Amazon

- an

- та

- Антропний

- передбачити

- будь-який

- застосовно

- ЕСТЬ

- AS

- припустити

- At

- доступний

- уникає

- знати

- заснований

- BE

- оскільки

- буття

- вважається,

- корисний

- Краще

- між

- by

- CAN

- претензій

- клієнтів

- комерційний

- зобов'язання

- зобов'язується

- Компанії

- компанія

- конкурентоспроможний

- концепція

- Турбота

- постійно

- зміст

- контекст

- безперестанку

- контроль

- Зручний

- розмови

- авторське право

- може

- вирішальне значення

- крипто

- Crypto Новини

- Поточний

- клієнт

- Клієнти

- щодня

- темно

- дані

- конфіденційність даних

- дебати

- десятиліття

- Розшифрувати

- глибокий

- глибоке навчання

- дефолт

- Захист

- надання

- залежить

- відмовляється

- спори

- різноманітність

- do

- документ

- робить

- доларів

- Не знаю

- під час

- нарахування

- край

- ефективність

- або

- зачеплення

- підвищення

- гарантує

- істотний

- етичний

- етика

- приклад

- обмін

- досвід

- обширний

- ступінь

- зовнішній

- облицювання

- для

- Колишній

- Заснований

- Безкоштовна

- від

- набирає

- породжувати

- генерується

- генерує

- генеративний

- Генеративний ШІ

- отримати

- отримання

- гіганти

- Давати

- Go

- надавати

- схопити

- Зростає

- сильно

- чесний

- честь

- Однак

- HTTP

- HTTPS

- людина

- ідеали

- if

- удосконалювати

- in

- індивідуальний

- інформація

- інтелектуальний

- інтелектуальна власність

- наміри

- Взаємодії

- внутрішній

- IP

- IT

- ЙОГО

- сам

- ключ

- мова

- великий

- останній

- закон

- вести

- УЧИТЬСЯ

- вивчення

- легальний

- Важіль

- як

- Лама

- LLM

- любов

- зробити

- Робить

- Може..

- Медіа

- Meta

- мільйони

- модель

- Моделі

- більше

- найбільш

- мереж

- нервовий

- нейронні мережі

- Нові

- новини

- отримання

- of

- on

- OpenAI

- or

- нібито

- інакше

- наші

- з

- виходи

- над

- власний

- володіє

- оплачувану

- Сторони

- партія

- моделі

- Платити

- платіж

- персонал

- Втілення

- Персоналізовані

- фотографії

- plato

- Інформація про дані Платона

- PlatoData

- політика

- потенціал

- влада

- потужний

- практики

- передбачати

- Прогнози

- переваги

- поширений

- недоторканність приватного життя

- приватний

- Вироблений

- Product

- підказок

- власність

- забезпечувати

- забезпечує

- громадськість

- суспільну довіру

- публічно

- цитувати

- racing

- RE

- Реальний світ

- отримує

- удосконалювати

- вважати

- відносний

- звільнити

- доречний

- Повідомляється

- запитів

- Дослідники

- відповідальний

- Показали

- праві

- суперників

- rt

- Райан

- s

- say

- говорить

- сцена

- обслуговування

- Послуги

- комплект

- Поділитись

- Повинен

- Скептицизм

- So

- соціальна

- соціальні медіа

- проданий

- ОРФОГРАФІЯ

- доповідач

- введення в експлуатацію

- Заява

- залишатися

- Крок

- Systems

- Тандем

- технології

- технічні гіганти

- методи

- terms

- текст

- Що

- Команда

- їх

- Їх

- Ці

- вони

- це

- Тім

- до

- сьогодні

- топ

- поїзд

- навчений

- Навчання

- прозорість

- Тенденції

- Довіряйте

- при

- розуміти

- розуміння

- Майбутні

- оновлений

- Updates

- підвищений

- завантажено

- використання

- використовуваний

- користувач

- користувачі

- використання

- Цінний

- різний

- версія

- Відео

- життєво важливий

- Голос

- обсяг

- було

- we

- були

- коли

- Чи

- який

- чому

- волі

- з

- слово

- б

- Ти

- вашу

- зефірнет