Графічні процесори є потужним інструментом для робочих навантажень машинного навчання, хоча вони не обов’язково є правильним інструментом для кожної роботи зі штучним інтелектом, за словами Майкла Бронштейна, керівника дослідження графічного навчання Twitter.

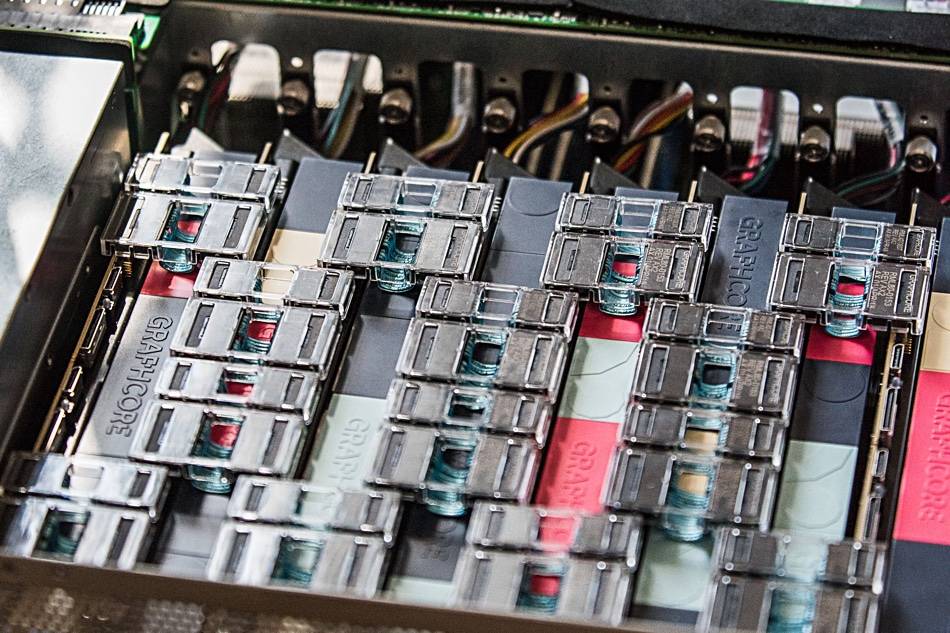

Його команда нещодавно показала, що апаратне забезпечення Graphcore AI пропонує «прискорення на порядок при порівнянні одного процесора IPU з графічним процесором Nvidia A100» у моделях мереж часових графів (TGN).

«Вибір апаратного забезпечення для реалізації моделей Graph ML є важливою проблемою, але часто нею не помічають», — йдеться в спільна стаття написаний Бронштейном разом з Емануеле Россі, дослідником МЛ у Twitter, і Даніелем Юстусом, дослідником Graphcore.

Нейронні мережі Graph пропонують засіб пошуку порядку в складних системах і зазвичай використовуються в соціальних мережах і системах рекомендацій. Однак динамічний характер цих середовищ робить ці моделі особливо складними для навчання, пояснило тріо.

Група досліджувала життєздатність IPU від Graphcore для обробки кількох моделей TGN. Початкове тестування проводилося на маленькій моделі TGN на основі ДЖОДІ Набір даних Вікіпедії, який пов’язує користувачів із змінами, які вони внесли на сторінки. Графік складався з 8,227 користувачів і 1,000 статей із загальною кількістю 9,227 вузлів. JODIE — це система прогнозування з відкритим вихідним кодом, розроблена для визначення сенсу мереж тимчасової взаємодії.

Експерименти тріо показали, що великі розміри партій призвели до погіршення перевірки та точності висновків порівняно з меншими розмірами партій.

«Пам’ять вузла та підключення графа оновлюються лише після обробки повної партії», — написало тріо. «Тому пізніші події в одній партії можуть покладатися на застарілу інформацію, оскільки вони не знають про попередні події».

Однак, використовуючи розмір партії 10, група змогла досягти оптимальної перевірки та точності висновків, але вони відзначають, що продуктивність на IPU все ще була кращою, ніж у GPU, навіть при використанні великих розмірів партії.

«При використанні пакетної сторони 10 TGN можна навчити на IPU приблизно в 11 разів швидше, і навіть із великим розміром партії 200 навчання все ще в три рази швидше на IPU», — йдеться в дописі. «Під час усіх операцій IPU більш ефективно обробляє невеликі партії».

Команда стверджує, що швидкий доступ до пам’яті та висока пропускна здатність, які пропонуються великою внутрішньопроцесорною кеш-пам’яттю SRAM Graphcore, дали IPU перевагу.

Ця перевага в продуктивності також поширилася на графічні моделі, які перевищують внутрішньопроцесорну пам’ять IPU — кожен IPU має кеш-пам’ять SRAM об’ємом 1 ГБ — що вимагає використання повільнішої пам’яті DRAM, підключеної до чіпів.

Під час тестування на графовій моделі, що складається з 261 мільйона підписок між 15.5 мільйонами користувачів Twitter, команда Бронштейна виявила, що використання DRAM для пам’яті вузла зменшило пропускну здатність у два рази.

Однак, створивши кілька підграфів на основі синтетичного набору даних, який у 10 разів перевищує розмір графіка Twitter, команда виявила, що пропускна здатність масштабується незалежно від розміру графіка. Іншими словами, зниження продуктивності було результатом використання повільнішої пам’яті, а не результатом розміру моделі.

«Використовуючи цю техніку на IPU, TGN можна застосовувати до майже довільних розмірів графів, обмежених лише обсягом доступної пам’яті хоста, зберігаючи при цьому дуже високу пропускну здатність під час навчання та висновків», — йдеться в статті.

Команда дійшла висновку, що архітектура IPU Graphcore демонструє значні переваги перед GPU у робочих навантаженнях, де доступ до обчислювальної техніки та пам’яті неоднорідний.

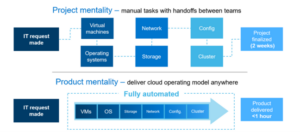

Однак ширший висновок полягає в тому, що дослідникам ML слід уважно поставитися до вибору апаратного забезпечення та не використовувати за замовчуванням графічні процесори.

«Доступність служб хмарних обчислень, що абстрагують базове обладнання, призводить до певної ліні в цьому відношенні», — написало тріо. «Ми сподіваємося, що наше дослідження приверне більше уваги до цієї важливої теми та прокладе шлях до майбутніх, більш ефективних алгоритмів і апаратних архітектур для додатків Graph ML». ®

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- Реєстр

- зефірнет