Коротко За словами американського аналітичного центру Brookings, нові правила, розроблені Європейським Союзом, спрямовані на регулювання ШІ, можуть перешкодити розробникам випускати моделі з відкритим кодом.

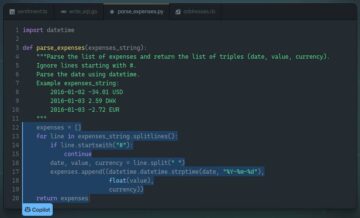

Команда запропонований Закон ЄС про штучний інтелект, який ще має бути підписаний, передбачає, що розробники з відкритим кодом мають гарантувати, що їх програмне забезпечення штучного інтелекту є точним, безпечним і прозорим щодо ризиків і використання даних у чіткій технічній документації.

Brookings стверджує, що якби приватна компанія розгорнула загальнодоступну модель або використала її в продукті, і вона якимось чином потрапила в біду через якісь непередбачені або неконтрольовані ефекти від моделі, тоді компанія, ймовірно, спробувала б звинуватити розробників відкритого коду та подати на них до суду .

Це може змусити спільноту з відкритим кодом двічі подумати про випуск свого коду, і, на жаль, означатиме, що розробкою штучного інтелекту керуватимуть приватні компанії. Власницький код складно аналізувати та створювати на ньому, а це означає, що інновації будуть перешкоджати.

Орен Етціоні, колишній генеральний директор Інституту ШІ Аллена, вважає, що розробники з відкритим кодом не повинні підпорядковуватися таким самим жорстким правилам, як інженери програмного забезпечення в приватних компаніях.

«Розробники з відкритим кодом не повинні нести такий самий тягар, як розробники комерційного програмного забезпечення. Завжди має бути так, що безкоштовне програмне забезпечення можна надавати «як є» — розглянемо випадок, коли один учень розробляє можливості ШІ; вони не можуть дозволити собі відповідати нормам ЄС і можуть бути змушені не поширювати своє програмне забезпечення, тим самим маючи негативний вплив на академічний прогрес і на відтворюваність наукових результатів», – сказав він. сказав TechCrunch.

Опубліковано нові результати MLPerf для висновків

Результати щорічного тесту висновків MLPerf, який порівнює продуктивність чіпів штучного інтелекту від різних виробників для багатьох завдань у різних конфігураціях, були опубліковані. опублікований на цьому тижні.

Майже 5,300 результатів продуктивності та 2,400 вимірювань потужності було зареєстровано цього року для висновків у центрі обробки даних і на периферійних пристроях. Тести перевіряють, наскільки швидко апаратна система здатна запускати певну модель машинного навчання. Швидкість обробки даних відображається в електронних таблицях.

Не дивно, що Nvidia знову очолює рейтинг цього року. «У своєму дебюті в галузевих стандартних тестах штучного інтелекту MLPerf графічні процесори Nvidia H100 Tensor Core встановили світові рекорди в обчисленні всіх робочих навантажень, забезпечуючи до 4.5 разів більшу продуктивність, ніж графічні процесори попереднього покоління», — йдеться у повідомленні Nvidia у блозі. «Результати демонструють, що Hopper є преміальним вибором для користувачів, яким потрібна максимальна продуктивність передових моделей ШІ».

Незважаючи на те, що в конкурсі MLPerf бере участь дедалі більше постачальників, може бути складно отримати хороше уявлення про конкурентів. Наприклад, цього року немає жодних звітів щодо чіпів TPU від Google у треку центрів обробки даних. Google, однак, здавалося ас Навчальний конкурс MLPerf на початку цього року.

Художники ШІ виявляють жахливе обличчя, що ховається за зображенням

Вірусний твіттер, опублікований цифровим художником, показує, наскільки дивними можуть бути моделі, що перетворюють текст у зображення.

Багато користувачів мережі відчували радість і розпач, експериментуючи з цими системами для створення зображень шляхом введення текстових підказок. Існують різновиди хаків для налаштування виходів моделей; одна з них, відома як «негативна підказка», дозволяє користувачам знаходити зображення, протилежне описаному в підказці.

Коли художник, який іде під іменем Supercomposite у Twitter, знайшов негативну підказку для того, що описує невинне на вигляд зображення фальшивого логотипу, вони знайшли щось справді жахливе: обличчя, схоже на жінку з привидами. Компанія Supercomposite назвала цю згенеровану штучним інтелектом жінку «Лоб», і коли вони схрещували її зображення з іншими, вони завжди виглядали як сцена з фільму жахів.

🧵: I discovered this woman, who I call Loab, in April. The AI reproduced her more easily than most celebrities. Her presence is persistent, and she haunts every image she touches. CW: Take a seat. This is a true horror story, and veers sharply macabre. pic.twitter.com/gmUlf6mZtk

— Supercomposite (@supercomposite) September 6, 2022

Суперкомпозит розповів El Reg випадкові зображення людей, створених ШІ, часто можуть з’являтися в негативних підказках. Дивна поведінка ще є інший приклад деяких дивних властивостей цих моделей, які люди тільки починають досліджувати.

Генеральний директор Сундар Пічаї каже, що в Google немає розумних чат-ботів

Сундар Пічаї заперечив заяви колишнього інженера Блейка Лемуана про те, що Google створив розумного чат-бота під час його виступу на конференції Code цього тижня.

Лемуан потрапив у заголовки газет у липні, коли він оголошений він думав, що чат-бот Google LaMDA у свідомості й може мати душу. Він був пізніше звільнили за ймовірне порушення політики конфіденційності компанії після того, як він найняв юриста для спілкування з LaMDA та оцінки її законних прав, стверджуючи, що машина сказала йому це зробити.

Більшість людей, включаючи генерального директора Google, не погоджуються з Лемуаном. «Я все ще думаю, що попереду довгий шлях. Мені здається, що я часто вступаю у філософські чи метафізичні розмови про те, що таке відчуття, а що таке свідомість», — сказав Пічаї, відповідно до Фортуни. «Ми далекі від цього, і можемо ніколи туди не дійти», — додав він.

Щоб підкреслити свою точку зору, він визнав, що голосовий помічник Google зі штучним інтелектом іноді не розуміє запити та не відповідає на них належним чином. «Хороша новина полягає в тому, що кожен, хто розмовляє з Google Assistant — хоча я вважаю, що це найкращий помічник для розмовного ШІ — ви все одно бачите, наскільки він зламаний у деяких випадках», — сказав він. ®

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- Реєстр

- зефірнет