Розуміння того, як мозок організовує та отримує доступ до просторової інформації — де ми знаходимося, що за рогом, як туди потрапити — залишається надзвичайно складним завданням. Процес включає в себе виклик цілої мережі спогадів і збережених просторових даних з десятків мільярдів нейронів, кожен з яких з’єднаний з тисячами інших. Нейробіологи визначили такі ключові елементи, як комірки сітки, нейрони, які відображають розташування. Але піти глибше буде складно: дослідники не можуть видалити та вивчити шматочки людської сірої речовини, щоб спостерігати, як засновані на місці спогади зображення, звуки та запахи протікають і з’єднуються між собою.

Штучний інтелект пропонує інший вихід. Протягом багатьох років нейробіологи використовували багато типів нейронних мереж — механізмів, які забезпечують більшість програм глибокого навчання — для моделювання роботи нейронів у мозку. У нещодавній роботі дослідники показали, що гіпокамп, структура мозку, яка має важливе значення для пам’яті, в основному є особливим видом нейронної мережі, відомої як трансформатор, прихований. Їхня нова модель відстежує просторову інформацію таким чином, що паралельно внутрішній роботі мозку. Вони досягли неймовірного успіху.

«Той факт, що ми знаємо, що ці моделі мозку еквівалентні трансформатору, означає, що наші моделі працюють набагато краще і їх легше тренувати», — сказав Джеймс Віттінгтон, когнітивний нейробіолог, який проводить свій час між Стенфордським університетом і лабораторією Тім Беренс в Оксфордському університеті.

Дослідження Віттінгтона та інших натякають на те, що трансформатори можуть значно покращити здатність моделей нейронних мереж імітувати види обчислень, які виконують клітини сітки та інші частини мозку. Такі моделі можуть підштовхнути наше розуміння того, як працюють штучні нейронні мережі, і, навіть більш імовірно, як обчислення виконуються в мозку, сказав Віттінгтон.

«Ми не намагаємося відтворити мозок», — сказав Девід Ха, комп’ютерний науковець Google Brain, який також працює над моделями трансформаторів. «Але чи можемо ми створити механізм, який зможе робити те, що робить мозок?»

Трансформери вперше з’явилися п’ять років тому як новий спосіб ШІ обробляти мову. Вони є секретним соусом у тих програмах, які захоплюють заголовки і закінчують речення, як БЕРТ і GPT-3, який може створювати переконливі тексти пісень, складати сонети Шекспіра та втілювати представників служби підтримки клієнтів.

Трансформатори працюють за допомогою механізму, який називається самоувагою, у якому кожен вхідний сигнал — слово, піксель, число в послідовності — завжди пов’язаний з усім іншим входом. (Інші нейронні мережі з’єднують вхідні дані лише з певними іншими вхідними сигналами.) Але хоча трансформатори були розроблені для мовних завдань, з тих пір вони перевершили виконання інших завдань, таких як класифікація зображень, а тепер і моделювання мозку.

У 2020 році група під керівництвом Зеп Хохрайтер, комп’ютерний науковець з Університету Йоганна Кеплера в Лінці в Австрії, використав трансформатор, щоб переоснастити потужну, давно існуючу модель пошуку пам’яті під назвою мережа Хопфілда. Ці мережі, вперше представлені 40 років тому фізиком із Прінстона Джоном Хопфілдом, дотримуються загального правила: нейрони, які одночасно активні, створюють міцні зв’язки один з одним.

Гохрайтер і його співробітники, зазначивши, що дослідники шукали кращі моделі відновлення пам’яті, побачили зв’язок між тим, як мережі Хопфілда відновлюють спогади, і тим, як трансформатори виконують увагу. Вони модернізували мережу Хопфілда, фактично перетворивши її на трансформатор. Ця зміна дозволила моделі зберігати та отримувати більше спогадів завдяки більш ефективним з’єднанням, сказав Віттінгтон. Сам Хопфілд разом із Дмитром Кротовим з MIT-IBM Watson AI Lab довів, що мережа Хопфілда на основі трансформатора є біологічно правдоподібною.

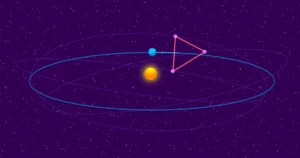

Потім Раніше цього року, Віттінгтон і Беренс допомогли ще більше налаштувати підхід Гохрейтера, модифікувавши трансформатор таким чином, що замість того, щоб розглядати спогади як лінійну послідовність — як рядок слів у реченні — він кодував їх як координати у просторі вищих вимірів. Цей «поворот», як назвали його дослідники, ще більше покращив продуктивність моделі в нейронаукових завданнях. Вони також показали, що модель була математично еквівалентна моделям шаблонів спрацьовування комірок сітки, які нейробіологи бачать у скануванні фМРТ.

«Комірки сітки мають таку захоплюючу, красиву, регулярну структуру з вражаючими візерунками, які навряд чи з’являться випадково», — сказав Касвелл Баррі, нейробіолог з Університетського коледжу Лондона. Нова робота показала, як трансформатори точно відтворюють ті моделі, що спостерігаються в гіпокампі. «Вони визнали, що трансформатор може визначити, де він знаходиться, на основі попередніх станів і того, як він переміщався, і таким чином, що введено в традиційні моделі комірок сітки».

Інші нещодавні роботи показують, що трансформатори також можуть покращити наше розуміння інших функцій мозку. Минулого року Мартін Шрімпф, обчислювальний нейробіолог з Массачусетського технологічного інституту, проаналізували 43 різні моделі нейронної мережі щоб побачити, наскільки добре вони передбачили вимірювання нейронної активності людини за даними фМРТ та електрокортикографії. Він виявив, що трансформатори є провідними, найсучаснішими нейронними мережами, які передбачають майже всі варіації зображень.

І Ха разом із колегою-інформатиком Юджін Тан, нещодавно розробив модель, яка може навмисно надсилати великі обсяги даних через трансформатор у випадковий, невпорядкований спосіб, імітуючи те, як людське тіло передає сенсорні спостереження в мозок. Їх трансформатор, як і наш мозок, міг успішно впоратися з невпорядкованим потоком інформації.

«Нейронні мережі жорстко підключені, щоб приймати певний вхід», — сказав Тан. Але в реальному житті набори даних часто швидко змінюються, і більшість штучного інтелекту не має жодного способу коригування. «Ми хотіли поекспериментувати з архітектурою, яка може дуже швидко адаптуватися».

Незважаючи на ці ознаки прогресу, Беренс вважає трансформатори лише кроком до точної моделі мозку, а не кінцем пошуків. «Тут я маю бути скептиком-нейробиологом», — сказав він. «Я не думаю, що трансформери стануть такими, як ми думаємо про мову, наприклад, у мозку, навіть якщо вони мають найкращу модель речень».

«Чи це найефективніша основа для прогнозування того, де я перебуваю і що я побачу далі? Якщо чесно, то ще зарано говорити», — сказав Баррі.

Шрімпф також зауважив, що навіть найефективніші трансформатори обмежені, вони добре працюють, наприклад, зі словами та короткими фразами, але не для більш масштабних мовних завдань, таких як розповідання історій.

«Мені здається, що ця архітектура, цей трансформатор дає вам потрібний простір для розуміння структури мозку, і його можна вдосконалити за допомогою навчання», — сказав Шрімпф. «Це хороший напрямок, але сфера надзвичайно складна».