Великі мовні моделі (LLM) зробили революцію в області обробки природної мови (NLP), покращивши такі завдання, як переклад мови, підсумовування тексту та аналіз настроїв. Однак, оскільки ці моделі продовжують зростати в розмірах і складності, моніторинг їх продуктивності та поведінки стає дедалі складнішим.

Моніторинг продуктивності та поведінки LLM є критичним завданням для забезпечення їх безпеки та ефективності. Запропонована нами архітектура забезпечує масштабоване та настроюване рішення для онлайн-моніторингу LLM, що дозволяє командам адаптувати ваше рішення для моніторингу до ваших конкретних випадків використання та вимог. Використовуючи сервіси AWS, наша архітектура забезпечує бачення в режимі реального часу поведінки LLM і дозволяє командам швидко виявляти та усувати будь-які проблеми чи аномалії.

У цій публікації ми демонструємо кілька показників для онлайн-моніторингу LLM та їх відповідну архітектуру для масштабування за допомогою таких сервісів AWS, як Amazon CloudWatch та AWS Lambda. Це пропонує настроюване рішення понад те, що можливо оцінка моделі робочих місць с Amazon Bedrock.

Огляд рішення

Перше, що слід враховувати, це те, що різні показники вимагають різних обчислень. Необхідна модульна архітектура, де кожен модуль може отримувати дані моделі та виробляти власні показники.

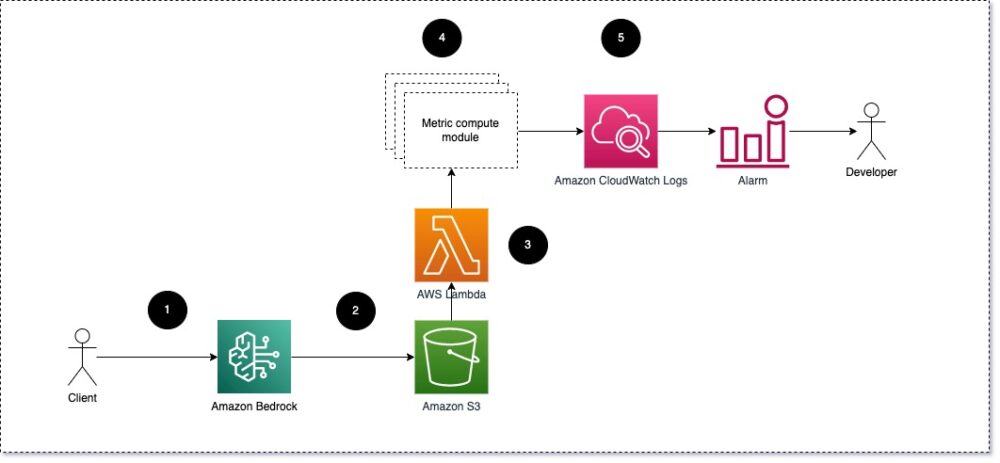

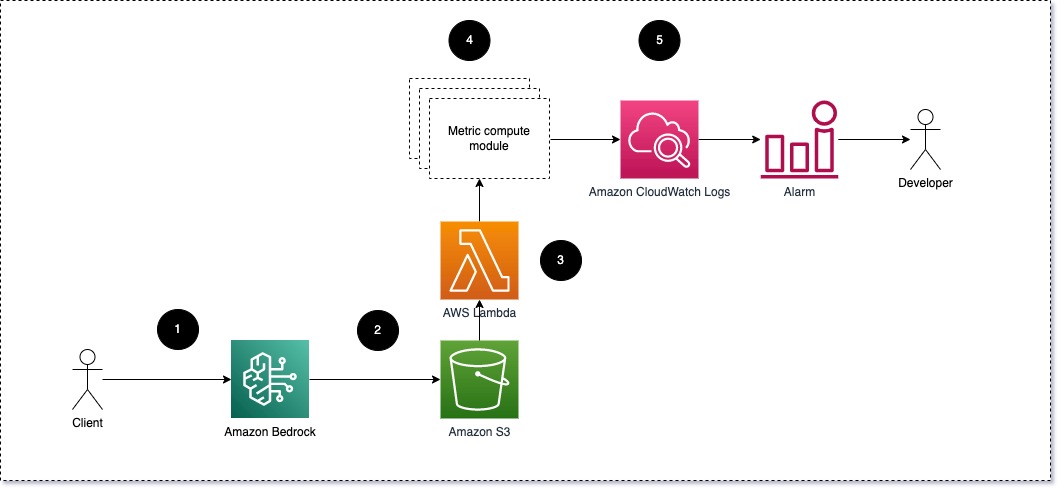

Ми пропонуємо, щоб кожен модуль приймав вхідні запити на висновок до LLM, передаючи пари підказки та завершення (відповіді) модулям метричних обчислень. Кожен модуль відповідає за обчислення власних показників щодо підказки введення та завершення (відповіді). Ці показники передаються в CloudWatch, який може агрегувати їх і працювати з сигналами CloudWatch для надсилання сповіщень про певні умови. Наступна діаграма ілюструє цю архітектуру.

Рис. 1: Модуль метричних обчислень – огляд рішення

Робочий процес включає наступні кроки:

- Користувач робить запит до Amazon Bedrock як частину програми або інтерфейсу користувача.

- Amazon Bedrock зберігає запит і завершення (відповідь) у Служба простого зберігання Amazon (Amazon S3) відповідно до конфігурації журналювання викликів.

- Файл, збережений на Amazon S3, створює подію, яка тригери лямбда-функція. Функція викликає модулі.

- Модулі публікують свої відповідні показники Показники CloudWatch.

- Сигналізація може повідомити групу розробників про несподівані значення показників.

Друге, що слід враховувати під час впровадження моніторингу LLM, – це вибір правильних показників для відстеження. Хоча існує багато потенційних показників, які ви можете використовувати для моніторингу ефективності LLM, ми пояснюємо деякі з них у цій публікації.

У наступних розділах ми висвітлюємо кілька відповідних метрик модуля та відповідну архітектуру обчислювального модуля метрики.

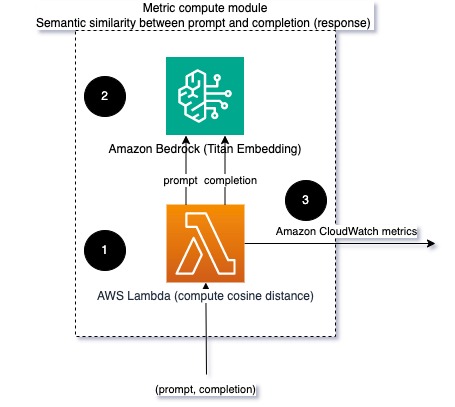

Семантична подібність між підказкою та завершенням (відповіддю)

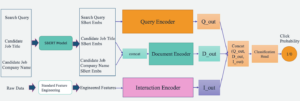

Під час запуску LLM ви можете перехопити підказку та завершення (відповідь) для кожного запиту та перетворити їх на вбудовування за допомогою моделі вбудовування. Вбудовування — це багатовимірні вектори, які представляють семантичне значення тексту. Амазонський титан надає такі моделі через Titan Embeddings. Взявши відстань, наприклад косинус, між цими двома векторами, ви можете кількісно визначити, наскільки семантично подібні підказка та завершення (відповідь). Ви можете використовувати SciPy or scikit-вчитися щоб обчислити косинусну відстань між векторами. Наступна діаграма ілюструє архітектуру цього модуля метричних обчислень.

Рис. 2: Модуль метричного обчислення – семантична подібність

Цей робочий процес включає такі основні кроки:

- Функція Lambda отримує потокове повідомлення через Амазонський кінезіс містить пару підказки та завершення (відповіді).

- Функція отримує вбудовування як для підказки, так і для завершення (відповіді) і обчислює косинусну відстань між двома векторами.

- Ця функція надсилає цю інформацію до показників CloudWatch.

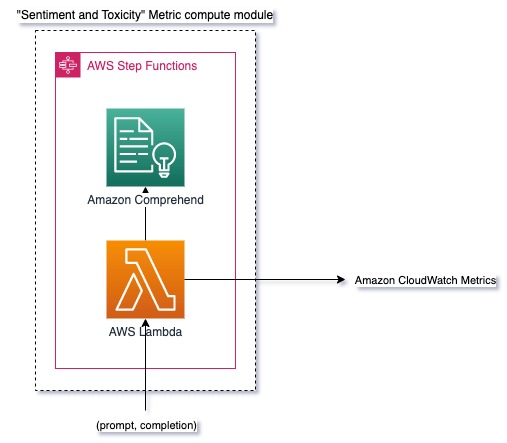

Настрій і токсичність

Моніторинг настрою дозволяє оцінити загальний тон і емоційний вплив відповідей, тоді як аналіз токсичності забезпечує важливий показник наявності образливих, неповажних або шкідливих висловлювань у результатах LLM. Слід уважно стежити за будь-якими змінами в настроях або токсичності, щоб переконатися, що модель поводиться належним чином. Наступна діаграма ілюструє модуль метричних обчислень.

Рис. 3: Модуль метричних обчислень – почуття та токсичність

Робочий процес включає наступні кроки:

- Функція Lambda отримує пару підказок і завершення (відповідь) через Amazon Kinesis.

- За допомогою оркестровки AWS Step Functions функція викликається «Амазонка» щоб виявити настрій та токсичність.

- Функція зберігає інформацію в метриках CloudWatch.

Додаткову інформацію про виявлення настрою та токсичності за допомогою Amazon Comprehend див Створіть надійний текстовий предиктор токсичності та Позначайте шкідливий вміст за допомогою виявлення токсичності Amazon Comprehend.

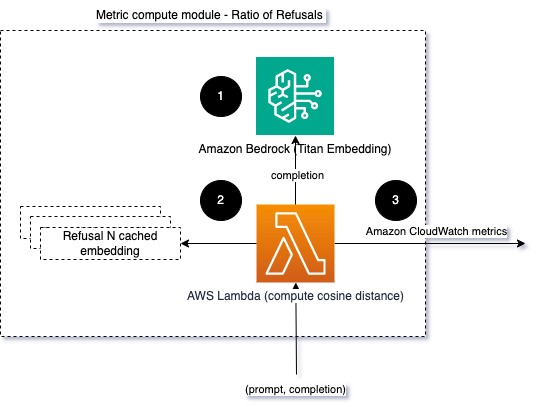

Коефіцієнт відмов

Збільшення кількості відмов, наприклад коли LLM відмовляє в завершенні через брак інформації, може означати, що або зловмисники намагаються використовувати LLM у спосіб, призначений для його джейлбрейку, або що очікування користувачів не виправдовуються, і вони отримують малоцінні відповіді. Один із способів оцінити, як часто це відбувається, — порівняти стандартні відмови від моделі LLM, що використовується, з фактичними відповідями від LLM. Наприклад, нижче наведено деякі поширені фрази відмови від Anthropic Claude v2 LLM:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

На фіксованому наборі підказок збільшення цих відмов може бути сигналом того, що модель стала надто обережною або чутливою. Слід також оцінити зворотний випадок. Це може бути сигналом того, що модель тепер більш схильна до токсичних або шкідливих розмов.

Щоб допомогти змоделювати цілісність і змоделювати відсоток відмов, ми можемо порівняти відповідь із набором відомих фраз відмови від LLM. Це може бути фактичний класифікатор, який може пояснити, чому модель відхилила запит. Ви можете взяти косинусну відстань між відповіддю та відомими відповідями на відмову з моделі, що відстежується. Наступна діаграма ілюструє цей модуль метричних обчислень.

Рис. 4: Модуль метричних обчислень – співвідношення відмов

Робочий процес складається з наступних кроків:

- Функція Lambda отримує підказку та завершення (відповідь) і отримує вбудовування відповіді за допомогою Amazon Titan.

- Ця функція обчислює косинус або евклідову відстань між відповіддю та наявними підказками про відмову, збереженими в пам’яті.

- Функція надсилає це середнє значення до показників CloudWatch.

Інший варіант - використання нечітка відповідність для простого, але менш потужного підходу до порівняння відомих відмов з результатами LLM. Зверніться до Документація на Python для прикладу.

Підсумки

Спостережливість LLM є важливою практикою для забезпечення надійного та надійного використання LLM. Моніторинг, розуміння та забезпечення точності й надійності LLM можуть допомогти вам зменшити ризики, пов’язані з цими моделями ШІ. Відстежуючи галюцинації, погані завершення (відповіді) і підказки, ви можете переконатися, що ваш LLM залишається на правильному шляху та забезпечує цінність, яку шукаєте ви та ваші користувачі. У цій публікації ми обговорили кілька показників, щоб продемонструвати приклади.

Щоб отримати додаткові відомості про оцінку моделей фундаменту, див Використовуйте SageMaker Clarify для оцінки моделей основи, і перегляньте додаткові приклади зошитів доступні в нашому репозиторії GitHub. Ви також можете дослідити способи введення в дію оцінювання LLM у масштабі Операціоналізація масштабної оцінки LLM за допомогою сервісів Amazon SageMaker Clarify і MLOps. Наостанок рекомендуємо звернутися до Оцініть великі мовні моделі на предмет якості та відповідальності щоб дізнатися більше про оцінювання LLM.

Про авторів

Бруно Кляйн є старшим інженером з машинного навчання в аналітичній практиці AWS Professional Services. Він допомагає клієнтам впроваджувати великі дані та аналітичні рішення. Поза роботою він любить проводити час із родиною, подорожувати та пробувати нову їжу.

Бруно Кляйн є старшим інженером з машинного навчання в аналітичній практиці AWS Professional Services. Він допомагає клієнтам впроваджувати великі дані та аналітичні рішення. Поза роботою він любить проводити час із родиною, подорожувати та пробувати нову їжу.

Рушабх Локханде є старшим інженером з обробки даних і ML у аналітичній практиці AWS Professional Services. Він допомагає клієнтам впроваджувати великі дані, машинне навчання та аналітичні рішення. Поза роботою він любить проводити час із родиною, читати, бігати та грати в гольф.

Рушабх Локханде є старшим інженером з обробки даних і ML у аналітичній практиці AWS Professional Services. Він допомагає клієнтам впроваджувати великі дані, машинне навчання та аналітичні рішення. Поза роботою він любить проводити час із родиною, читати, бігати та грати в гольф.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- : має

- :є

- : ні

- :де

- 1

- 100

- 143

- 32

- 455

- 7

- a

- МЕНЮ

- точність

- фактичний

- Додатковий

- адреса

- сукупність

- AI

- AI помічник

- Моделі AI

- дозволяє

- Також

- хоча

- am

- Amazon

- «Амазонка»

- Амазонський кінезіс

- Amazon SageMaker

- Amazon Web Services

- an

- аналіз

- аналітика

- та

- аномалії

- Антропний

- будь-який

- додаток

- підхід

- підходи

- архітектура

- ЕСТЬ

- AS

- Помічник

- асоційований

- At

- доступний

- середній

- AWS

- Професійні послуги AWS

- Функції кроку AWS

- поганий

- BE

- ставати

- поведінка

- буття

- між

- За

- Великий

- Великий даних

- обидва

- але

- by

- Виклики

- CAN

- не може

- випадок

- випадків

- обережний

- складні

- Вибираючи

- класифікатор

- тісно

- загальний

- порівняти

- порівняння

- завершення

- складність

- осягнути

- обчислення

- обчислення

- обчислення

- Умови

- конфігурація

- Вважати

- міркування

- складається

- зміст

- контекст

- продовжувати

- розмови

- може

- створений

- створює

- критичний

- Клієнти

- настроюється

- дані

- постачає

- демонструвати

- виявляти

- розробка

- команда розвитку

- схема

- різний

- обговорювалися

- відстань

- do

- два

- кожен

- ефективність

- або

- вбудовування

- дозволяє

- дозволяє

- займатися

- інженер

- досить

- забезпечувати

- забезпечення

- оцінювати

- оцінюється

- оцінки

- оцінка

- оцінки

- Event

- приклад

- Приклади

- існуючий

- очікування

- очікуваний

- Пояснювати

- дослідити

- сім'я

- кілька

- поле

- фіг

- філе

- в кінці кінців

- Перший

- фіксованою

- після

- харчування

- для

- фонд

- від

- функція

- Функції

- калібр

- отримує

- отримання

- GitHub

- гольф

- Рости

- Відбувається

- шкідливий

- Мати

- he

- допомога

- корисний

- допомагає

- Виділіть

- чесний

- Як

- Однак

- HTML

- HTTP

- HTTPS

- i

- ідентифікувати

- ілюструє

- Impact

- здійснювати

- реалізації

- важливо

- поліпшення

- in

- includes

- Вхідний

- Augmenter

- все більше і більше

- інформація

- вхід

- цілісність

- призначених

- інтерфейс

- в

- зворотний

- викликає

- питання

- IT

- ЙОГО

- втечу з в'язниці

- Джобс

- JPG

- ключ

- відомий

- відсутність

- мова

- великий

- УЧИТЬСЯ

- вивчення

- менше

- LLM

- шукати

- машина

- навчання за допомогою машини

- зробити

- РОБОТИ

- malicious

- багато

- значити

- сенс

- вимір

- пам'ять

- повідомлення

- зустрів

- метрика

- Метрика

- Пом'якшити

- ML

- MLOps

- модель

- Моделі

- модульний

- Модулі

- Модулі

- монітор

- контрольований

- моніторинг

- більше

- Природний

- Обробка природних мов

- необхідно

- Нові

- nlp

- Повідомлення

- зараз

- of

- наступ

- Пропозиції

- часто

- on

- ONE

- ті,

- онлайн

- варіант

- or

- оркестровка

- наші

- вихід

- виходи

- поза

- загальний

- огляд

- власний

- пара

- пар

- частина

- Пройшов

- Проходження

- для

- продуктивність

- фрази

- plato

- Інформація про дані Платона

- PlatoData

- ігри

- це можливо

- пошта

- потенціал

- потужний

- практика

- наявність

- обробка

- виробляти

- професійний

- підказок

- запропонований

- забезпечувати

- забезпечує

- Python

- якість

- швидко

- співвідношення

- читання

- реального часу

- отримує

- рекомендувати

- послатися

- відмова

- відмовив

- доречний

- надійність

- надійний

- Сховище

- представляти

- запросити

- запитів

- вимагати

- Вимога

- повага

- ті

- відповідь

- відповіді

- відповідальний

- революціонізували

- право

- ризики

- міцний

- біг

- Безпека

- мудрець

- зберігаються

- масштабовані

- шкала

- другий

- розділам

- смисловий

- послати

- посилає

- старший

- чутливий

- настрій

- Послуги

- комплект

- Зміни

- Повинен

- демонстрації

- Сигнал

- аналогічний

- простий

- Розмір

- рішення

- Рішення

- деякі

- просторовий

- конкретний

- Витрати

- standard

- Крок

- заходи

- зберігання

- просто

- потоковий

- такі

- пропонувати

- Переконайтеся

- кравець

- Приймати

- взяття

- Завдання

- завдання

- команда

- команди

- методи

- текст

- Що

- Команда

- інформація

- їх

- Їх

- Там.

- Ці

- вони

- річ

- це

- через

- час

- велетень

- до

- TONE

- трек

- Перетворення

- Переклад

- Подорож

- заслуговуючий довіри

- намагається

- два

- розуміння

- Unexpected

- використання

- використовуваний

- користувач

- Інтерфейс користувача

- користувачі

- використання

- значення

- Цінності

- через

- видимість

- шлях..

- способи

- we

- Web

- веб-сервіси

- Що

- Що таке

- коли

- в той час як

- який

- чому

- Вікіпедія

- з

- Work

- робочий

- Ти

- вашу

- зефірнет