Ви коли-небудь бачили, як дитинча газелі вчиться ходити? Оленя, яке в основному є довгоногим татом ссавця, піднімається на ноги, падає, стоїть і знову падає. Врешті-решт він стоїть достатньо довго, щоб розмахувати своїми лапами, схожими на зубочистку, у низку майже падінь… гм, кроків. Дивовижно, але через кілька хвилин після цього чарівного показу оленятко стрибає, як старий професіонал.

Що ж, тепер у нас є робота-версія цієї класичної сцени Серенгеті.

У цьому випадку оленятко — робот-собака з Каліфорнійського університету в Берклі. І він також напрочуд швидко навчається (порівняно з іншими роботами). Робот також особливий тим, що, на відміну від інших яскравих роботів, яких ви могли бачити в Інтернеті, він використовує штучний інтелект, щоб навчитися ходити.

Починаючи з спини, махаючи ногами, робот навчається перевертатися, вставати та ходити за годину. Достатньо ще десяти хвилин переслідування згортком картону, щоб навчити його витримувати та оговтатися після того, як його штовхають його працівники.

Це не вперше робот використав штучний інтелект, щоб навчитися ходити. Але в той час як попередні роботи вивчали навички шляхом проб і помилок під час незліченних ітерацій у симуляціях, бот Berkeley навчався повністю в реальному світі.

[Вбудоване вміст]

В опубліковано папір На сервері препринтів arXiv дослідники — Даніяр Хафнер, Алехандро Есконтрела та Філіп Ву — кажуть, що перенести алгоритми, навчені під час симуляції, у реальний світ непросто. Дрібні деталі та відмінності між реальним світом і симуляцією можуть збентежити новонароджених роботів. З іншого боку, навчання алгоритмів у реальному світі є непрактичним: це займе надто багато часу та зношення.

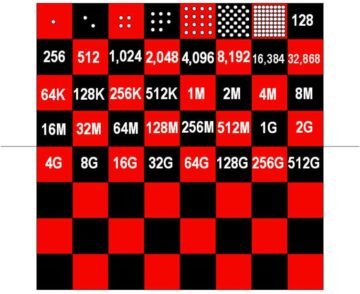

Чотири роки тому, наприклад, OpenAI продемонструвала роботу-руку з підтримкою ШІ, яка могла маніпулювати кубом. Алгоритм керування Dactyl потребував близько 100 років досвіду в моделюванні на основі 6,144 процесорів і 8 графічних процесорів Nvidia V100, щоб виконати це відносно просте завдання. Відтоді все просунулося, але проблема значною мірою залишається. Чисті алгоритми навчання з підкріпленням потребують занадто багато проб і помилок, щоб отримати навички, щоб їх можна було тренувати в реальному світі. Простіше кажучи, процес навчання зламав би дослідників та роботів, перш ніж зробити будь-який значний прогрес.

Команда Берклі вирішила цю проблему за допомогою алгоритму під назвою Dreamer. Побудова того, що називається "модель світу”, Мрійник може передбачити ймовірність того, що майбутня дія досягне своєї мети. З досвідом точність його проекцій покращується. Заздалегідь відфільтровуючи менш успішні дії, модель світу дозволяє роботу більш ефективно з’ясувати, що працює.

«Вивчення моделей світу з минулого досвіду дозволяє роботам уявити майбутні результати потенційних дій, зменшуючи кількість проб і помилок у реальному середовищі, необхідних для вивчення успішної поведінки», — пишуть дослідники. «Прогнозуючи майбутні результати, моделі світу дозволяють планувати та вивчати поведінку, враховуючи лише невелику кількість взаємодії в реальному світі».

Іншими словами, модель світу може скоротити еквівалент років навчання в симуляції до не більше ніж незручної години в реальному світі.

Цей підхід може мати ширше значення, ніж собаки-роботи. Команда також застосувала Dreamer до роботизованої руки та робота на колесах. В обох випадках вони виявили, що Dreamer дозволив їхнім роботам ефективно освоювати відповідні навички, не потребуючи часу для симуляції. Більш амбітні майбутні програми можуть включати самостійного водіння автомобілів.

Звичайно, є ще проблеми, які необхідно вирішити. Незважаючи на те, що навчання з підкріпленням автоматизує складне ручне кодування найдосконаліших роботів сьогодення, воно все одно вимагає від інженерів визначення цілей робота та того, що є успіхом — вправа, яка потребує багато часу та є відкритою для реальних середовищ. Крім того, хоча робот пережив експерименти команди тут, тривале навчання більш просунутим навичкам може виявитися занадто важким для майбутніх ботів, щоб вижити без пошкоджень. Дослідники кажуть, що може бути плідним поєднання навчання на симуляторі зі швидким навчанням у реальному світі.

Тим не менш, результати просувають штучний інтелект у робототехніці ще на один крок. Джонатан Херст, професор робототехніки в Університеті штату Орегон, вважає, що «навчання з підкріпленням стане наріжним інструментом у майбутньому керування роботами», – Dreamer. сказав MIT Technology Review.

Зображення Фото: Даніяр Хафнер / YouTube