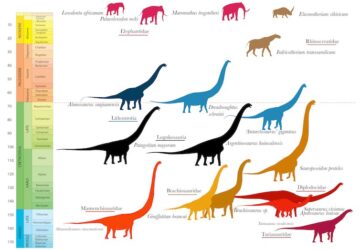

مصنوعی ذہانت ایک آنسو پر ہے۔ مشینیں بول سکتی ہیں، لکھ سکتی ہیں، گیمز کھیل سکتی ہیں، اور اصلی تصاویر، ویڈیو اور موسیقی بنا سکتی ہیں۔ لیکن جیسے جیسے AI کی صلاحیتیں بڑھی ہیں، اسی طرح اس کے الگورتھم بھی ہیں۔

ایک دہائی پہلے، مشین لرننگ الگورتھم دسیوں لاکھوں اندرونی رابطوں پر انحصار کیا۔، یا پیرامیٹرز۔ آج کے الگورتھم باقاعدگی سے سینکڑوں اربوں تک پہنچ جاتے ہیں اور یہاں تک کہ کھربوں پیرامیٹرز. محققین کا کہنا ہے کہ پیمانہ بڑھانے سے اب بھی کارکردگی میں اضافہ ہوتا ہے، اور دسیوں کھربوں پیرامیٹرز والے ماڈل مختصر ترتیب میں پہنچ سکتے ہیں۔

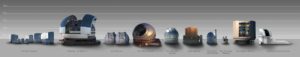

اتنے بڑے ماڈلز کو تربیت دینے کے لیے، آپ کو طاقتور کمپیوٹرز کی ضرورت ہے۔ جب کہ 2010 کی دہائی کے اوائل میں AI مٹھی بھر گرافکس پروسیسنگ یونٹس پر چلتا تھا—کمپیوٹر چپس جو متوازی پروسیسنگ میں AI کے لیے انتہائی اہم ہیں — کمپیوٹنگ کی ضروریات تیزی سے اضافہ ہوا ہےاور ٹاپ ماڈلز کو اب سینکڑوں یا ہزاروں کی ضرورت ہوتی ہے۔ اوپن اے آئی، مائیکروسافٹ, میٹا، اور دیگر کام کو سنبھالنے کے لیے سرشار سپر کمپیوٹر بنا رہے ہیں، اور ان کا کہنا ہے کہ یہ AI مشینیں کرہ ارض کی تیز ترین مشینوں میں شمار ہوتی ہیں۔

لیکن یہاں تک کہ جیسا کہ GPUs AI اسکیلنگ کے لیے اہم رہے ہیں — Nvidia's A100، مثال کے طور پر، اب بھی AI کلسٹرز میں سب سے تیز، سب سے زیادہ استعمال ہونے والی چپس میں سے ایک ہے — خاص طور پر AI کے لیے ڈیزائن کیے گئے عجیب و غریب متبادل حالیہ برسوں میں سامنے آئے ہیں۔

Cerebras ایسا ہی ایک متبادل پیش کرتا ہے۔

AI کا کھانا بنانا

رات کے کھانے کی پلیٹ کا سائز - ایک طرف سے تقریباً 8.5 انچ - کمپنی کا ویفر اسکیل انجن دنیا کی سب سے بڑی سلکان چپ، 2.6 ٹریلین ٹرانجسٹرز اور 850,000 کور ایک واحد سلیکون ویفر پر کھدائی کے ساتھ۔ ہر ویفر اسکیل انجن کمپنی کے CS-2 کمپیوٹر کے دل کا کام کرتا ہے۔

اکیلے، CS-2 ایک حیوان ہے، لیکن پچھلے سال سیریبراس نے ایک منصوبے کی نقاب کشائی کی۔ CS-2s کو MemoryX نامی ایکسٹرنل میموری سسٹم کے ساتھ جوڑنے کے لیے اور CS-2s کو جوڑنے کے لیے ایک سسٹم جسے SwarmX کہتے ہیں۔ کمپنی نے کہا کہ نئی ٹیک 192 چپس اور ٹرین ماڈلز کو جوڑ سکتی ہے جو آج کے سب سے بڑے، جدید ترین AIs سے بڑے سائز کے دو آرڈرز ہیں۔

سیریبراس کے سی ای او اور کوفاؤنڈر اینڈریو فیلڈمین نے کہا، "صنعت 1-ٹریلین پیرامیٹر ماڈلز سے آگے بڑھ رہی ہے، اور ہم اس حد کو وسعت کے دو آرڈرز سے بڑھا رہے ہیں، 120 ٹریلین پیرامیٹرز کے ساتھ دماغی پیمانے پر نیورل نیٹ ورکس کو فعال کر رہے ہیں۔"

اس وقت یہ سب نظریاتی تھا۔ لیکن گزشتہ ہفتے، کمپنی نے اعلان کیا انہوں نے 16 CS-2s کو عالمی معیار کے AI سپر کمپیوٹر سے جوڑا۔

اینڈرومیڈا سے ملو

نئی مشین، جسے اینڈرومیڈا کہا جاتا ہے، میں 13.5 ملین کور ہیں جو 16 بٹ نصف درستگی پر ایک ایکسافلوپ (ایک کوئنٹلین آپریشن فی سیکنڈ) سے زیادہ رفتار کے قابل ہیں۔ اس کے بنیادی حصے میں منفرد چپ کی وجہ سے، اینڈرومیڈا کا زیادہ روایتی CPUs اور GPUs پر چلنے والے سپر کمپیوٹرز سے آسانی سے موازنہ نہیں کیا جا سکتا، لیکن فیلڈ مین نے بتایا HPC وائر اینڈرومیڈا تقریباً ارگون نیشنل لیبارٹری کے پولارس سپر کمپیوٹر کے برابر ہے، جس کی درجہ بندی دنیا کا 17واں تیز ترین، تازہ ترین Top500 فہرست کے مطابق۔

کارکردگی کے علاوہ، اینڈرومیڈا کا تیز رفتار تعمیراتی وقت، لاگت اور نقش قدم قابل ذکر ہیں۔ ارگون پولارس کو انسٹال کرنا شروع کیا۔ 2021 کے موسم گرما میں، اور سپر کمپیوٹر تقریباً ایک سال بعد لائیو ہوا۔. اس میں 40 ریک لگتے ہیں، فائلنگ کیبنٹ نما انکلوژرز ہاؤسنگ سپر کمپیوٹر کے اجزاء۔ اس کے مقابلے میں، اینڈرومیڈا کی لاگت $35 ملین تھی جو اس کی طاقت کی ایک مشین کی معمولی قیمت تھی۔ جمع ہونے کے لیے صرف تین دن، اور محض 16 ریک استعمال کرتا ہے۔

Cerebras نے OpenAI کے بڑے لینگوئج ماڈل GPT-3 کے پانچ ورژن کے ساتھ ساتھ Eleuther AI کے اوپن سورس GPT-J اور GPT-NeoX کی تربیت دے کر سسٹم کا تجربہ کیا۔ اور سیریبراس کے مطابق، شاید سب سے اہم دریافت یہ ہے کہ اینڈرومیڈا نے اس بات کا مظاہرہ کیا جسے وہ بڑی زبان کے ماڈلز کے لیے AI ورک بوجھ کی "قریب پرفیکٹ لکیری اسکیلنگ" کہتے ہیں۔ مختصراً، اس کا مطلب ہے کہ جیسے جیسے اضافی CS-2 شامل کیے جاتے ہیں، تربیت کے اوقات متناسب طور پر کم ہوتے جاتے ہیں۔

عام طور پر، کمپنی نے کہا، جیسا کہ آپ مزید چپس شامل کرتے ہیں، کارکردگی کے فوائد کم ہوتے جاتے ہیں۔ دوسری طرف Cerebras کی WSE چپ زیادہ مؤثر طریقے سے پیمانہ ثابت ہو سکتی ہے کیونکہ اس کے 850,000 cores ایک دوسرے سے سلکان کے ایک ہی ٹکڑے پر جڑے ہوئے ہیں۔ مزید یہ کہ ہر کور میں اگلے دروازے پر میموری ماڈیول ہوتا ہے۔ ایک ساتھ لے کر، چپ کور اور میموری کے درمیان ڈیٹا کو شٹل کرنے میں صرف ہونے والے وقت کی مقدار کو کم کرتی ہے۔

"لینیئر اسکیلنگ کا مطلب ہے کہ جب آپ ایک سے دو سسٹم تک جاتے ہیں، تو آپ کے کام کو مکمل ہونے میں آدھا وقت لگتا ہے۔ یہ کمپیوٹنگ میں ایک بہت ہی غیر معمولی پراپرٹی ہے، "فیلڈمین نے بتایا HPC وائر. اور، انہوں نے کہا، یہ 16 منسلک نظاموں سے آگے بڑھ سکتا ہے۔

Cerebras کی اپنی جانچ کے علاوہ، لکیری اسکیلنگ کے نتائج بھی Argonne نیشنل لیبارٹری میں کام کے دوران ظاہر کیے گئے جہاں محققین نے CoVID-3 جینوم کے طویل سلسلے پر GPT-19-XL بڑی زبان کے الگورتھم کو تربیت دینے کے لیے اینڈرومیڈا کا استعمال کیا۔

بلاشبہ، اگرچہ یہ نظام 16 CS-2s سے آگے بڑھ سکتا ہے، لیکن یہ دیکھنا باقی ہے۔ اس کے علاوہ، ہم ابھی تک نہیں جانتے کہ Cerebras دوسرے AI چپس کے خلاف کس طرح سر جوڑ کر کارکردگی کا مظاہرہ کرتا ہے۔ AI chipmakers جیسے Nvidia اور Intel شروع ہو چکے ہیں۔ تیسری پارٹی کے باقاعدہ بینچ مارکنگ میں حصہ لینا MLperf کی پسند سے۔ سیریبراس نے ابھی حصہ لینا باقی ہے۔

خالی جگہ

پھر بھی، ایسا لگتا ہے کہ یہ نقطہ نظر سپر کمپیوٹنگ کی دنیا میں اپنی جگہ بنا رہا ہے، اور بڑی زبان میں AI کو جاری رکھنا ایک اہم معاملہ ہے۔ درحقیقت، فیلڈمین بتایا تار گزشتہ سال کہ کمپنی پہلے ہی OpenAI میں انجینئرز سے بات کر رہی تھی، جو کہ بڑی زبان کے ماڈلز میں رہنما ہے۔ (اوپن اے آئی کے بانی، سیم آلٹمین، سیریبراس میں سرمایہ کار بھی ہیں۔)

2020 میں اس کی ریلیز پر، OpenAI کے بڑے زبان کے ماڈل GPT-3 نے، کارکردگی اور سائز دونوں کے لحاظ سے گیم کو تبدیل کر دیا۔ 175 بلین پیرامیٹرز میں وزنی، یہ اس وقت کا سب سے بڑا AI ماڈل تھا اور اس نے اپنی صلاحیتوں سے محققین کو حیران کر دیا۔ تب سے، زبان کے ماڈلز کھربوں پیرامیٹرز تک پہنچ چکے ہیں، اور بڑے ماڈلز آنے والے ہو سکتے ہیں۔ افواہیں ہیں— بس اتنا ہی، اب تک — کہ OpenAI GPT-4 کو بہت دور نہیں مستقبل میں جاری کرے گا اور یہ GPT-3 سے ایک اور چھلانگ ہوگی۔ (ہمیں انتظار کرنا پڑے گا اور اس شمار پر دیکھنا پڑے گا۔)

اس نے کہا، ان کی صلاحیتوں کے باوجود، بڑے زبان کے ماڈل نہ تو کامل ہیں اور نہ ہی عالمی طور پر پسند کیے جاتے ہیں۔ ان کی خامیوں میں ایسی پیداوار شامل ہے جو غلط، متعصب اور جارحانہ ہو سکتی ہے۔ میٹا کی Galactica، سائنسی نصوص پر تربیت یافتہ، ہے ایک حالیہ مثال. ڈیٹا سیٹ کے باوجود یہ فرض کر سکتا ہے کہ کھلے انٹرنیٹ پر تربیت کے مقابلے میں زہریلا ہونے کا خطرہ کم ہے، ماڈل کو آسانی سے نقصان دہ اور غلط متن بنانے پر اکسایا گیا اور صرف تین دنوں میں اسے ختم کر دیا گیا۔ آیا محققین زبان AI کی خامیوں کو حل کر سکتے ہیں، یہ غیر یقینی ہے۔

لیکن ایسا لگتا ہے کہ اسکیلنگ اس وقت تک جاری رہے گی جب تک کہ واپسی میں کمی نہیں آتی۔ اگلی چھلانگ بالکل کونے کے آس پاس ہوسکتی ہے — اور ہمارے پاس اسے انجام دینے کے لیے پہلے سے ہی ہارڈ ویئر موجود ہو سکتا ہے۔

تصویری کریڈٹ: سیرابراس