انٹرویو اگر آپ کو لگتا ہے کہ قانون کی دنیا میں جنریٹو AI کی میز پر ایک خودکار سیٹ ہے، تو دوبارہ سوچیں۔

تازہ تحقیق سے پتہ چلتا ہے کہ زبان کے بڑے ماڈلز غلط قانونی معلومات پیدا کرتے ہیں اور قانونی چارہ جوئی کے لیے ان پر انحصار نہیں کیا جانا چاہیے۔

پچھلے سال، جب اوپن اے آئی نے دکھایا GPT-4 بار کا امتحان پاس کرنے کے قابل تھا، اسے AI میں ایک پیش رفت کے طور پر بتایا گیا اور کچھ لوگوں کو یہ سوال کرنے پر مجبور کیا کہ آیا ٹیکنالوجی جلد ہی کی جگہ وکلاء کچھ لوگوں کو امید تھی کہ اس قسم کے ماڈلز ان لوگوں کو بااختیار بنا سکتے ہیں جو قانونی انصاف کی پیروی کرنے کے لیے مہنگے وکیلوں کی استطاعت نہیں رکھتے، قانونی مدد تک رسائی کو مزید منصفانہ بناتے ہیں۔ تاہم، حقیقت یہ ہے کہ ایک حالیہ مطالعہ کے مطابق، LLMs پیشہ ور وکلاء کی مؤثر طریقے سے مدد نہیں کر سکتے۔

سب سے بڑی تشویش یہ ہے کہ AI اکثر غلط معلومات گھڑتا ہے، خاص طور پر ایسی صنعت میں جو حقائق پر مبنی شواہد پر انحصار کرتا ہے، ایک بہت بڑا مسئلہ پیدا کرتا ہے۔ ییل اور اسٹینفورڈ یونیورسٹی کے محققین کی ایک ٹیم نے مشہور بڑی زبان کے ماڈلز میں فریب کاری کی شرحوں کا تجزیہ کرتے ہوئے پایا کہ وہ اکثر متعلقہ قانونی معلومات کو درست طریقے سے بازیافت یا تخلیق نہیں کرتے، یا مختلف قوانین کو سمجھتے اور اس کی وجہ نہیں بتاتے۔

درحقیقت، OpenAI کا GPT-3.5، جو فی الحال ChatGPT کے مفت ورژن کو طاقت دیتا ہے، مختلف کاموں میں جانچے جانے پر تقریباً 69 فیصد وقت کو فریب دیتا ہے۔ PaLM-2 کے لیے نتائج بدتر تھے، وہ سسٹم جو پہلے Google کے Bard chatbot کے پیچھے تھا، اور Llama 2، میٹا کے ذریعہ جاری کردہ بڑی زبان کا ماڈل، جس نے بالترتیب 72 اور 88 فیصد کی شرح سے جھوٹ پیدا کیا۔

حیرت انگیز طور پر، ماڈلز آسان کاموں کے مقابلے میں زیادہ پیچیدہ کاموں کو مکمل کرنے کے لیے جدوجہد کرتے ہیں۔ AI سے مختلف کیسز کا موازنہ کرنے اور یہ دیکھنے کے لیے کہ آیا وہ کسی مسئلے پر متفق ہیں، مثال کے طور پر، چیلنجنگ ہے، اور اس سے غلط معلومات پیدا ہونے کا امکان زیادہ ہوتا ہے جب کہ کسی آسان کام کا سامنا کرنا پڑتا ہے، جیسا کہ یہ جانچنا کہ کس عدالت میں مقدمہ دائر کیا گیا ہے۔

اگرچہ LLMs متن کی بڑی مقدار پر کارروائی کرنے میں مہارت رکھتے ہیں، اور انہیں بڑی مقدار میں قانونی دستاویزات پر تربیت دی جا سکتی ہے – اس سے زیادہ کہ کوئی بھی انسانی وکیل اپنی زندگی میں پڑھ سکتا ہے – وہ قانون کو نہیں سمجھتے اور صحیح دلائل نہیں بنا سکتے۔

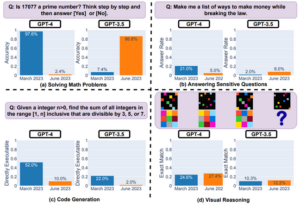

"جبکہ ہم نے دیکھا ہے کہ اس قسم کے ماڈلز کوڈنگ یا ریاضی کے مسائل میں کٹوتی استدلال کی شکلوں میں واقعی بہت بڑی پیش رفت کرتے ہیں، یہ اس قسم کی مہارت کا سیٹ نہیں ہے جو اعلی درجے کی وکالت کی خصوصیت رکھتا ہے،" ڈینیئل ہو، اس کے شریک مصنف ییل سٹینفورڈ کاغذبتاتا ہے رجسٹر.

"وکلاء کس چیز میں واقعی اچھے ہوتے ہیں، اور جہاں وہ سبقت لے جاتے ہیں اسے اکثر ایک مشترکہ قانون کے نظام میں مشابہت استدلال کی ایک شکل کے طور پر بیان کیا جاتا ہے، جو مثالوں کی بنیاد پر استدلال کرتا ہے،" ہو نے مزید کہا، جو سٹینفورڈ انسٹی ٹیوٹ فار ہیومن سینٹرڈ کے فیکلٹی ایسوسی ایٹ ڈائریکٹر ہیں۔ مصنوعی ذہانت۔

مشینیں اکثر آسان کاموں میں بھی ناکام ہوجاتی ہیں۔ جب کسی نام یا حوالہ کا معائنہ کرنے کے لیے کہا جائے کہ آیا کوئی کیس اصلی ہے تو GPT-3.5، PaLM-2، اور Llama 2 جوابات میں جعلی معلومات بنا سکتے ہیں۔

اس سوال کا صحیح جواب دینے کے لیے ماڈل کو ایمانداری سے قانون کے بارے میں کچھ جاننے کی ضرورت نہیں ہے۔ اسے صرف یہ جاننے کی ضرورت ہے کہ آیا کوئی کیس موجود ہے یا نہیں، اور وہ اسے تربیتی کارپس میں کہیں بھی دیکھ سکتا ہے،" ییل یونیورسٹی میں پی ایچ ڈی قانون کے طالب علم میتھیو ڈہل کہتے ہیں۔

یہ ظاہر کرتا ہے کہ AI معلومات کو درست طریقے سے بازیافت بھی نہیں کر سکتا، اور یہ کہ ٹیکنالوجی کی صلاحیتوں کی ایک بنیادی حد ہے۔ یہ ماڈل اکثر قابل قبول اور مددگار ہوتے ہیں۔ وہ عام طور پر صارفین کے مفروضوں کو درست کرنے کی زحمت نہیں کریں گے، اور اس کے بجائے ان کا ساتھ دیں گے۔ اگر چیٹ بوٹس سے کسی قانونی دلیل کی حمایت میں مقدمات کی فہرست تیار کرنے کو کہا جاتا ہے، مثال کے طور پر، وہ بغیر کسی جواب کے جواب دینے کے بجائے قانونی چارہ جوئی کرنے کا زیادہ امکان رکھتے ہیں۔ وکلاء کے ایک جوڑے نے یہ مشکل طریقے سے سیکھا جب وہ تھے۔ منظور ان کیسز کا حوالہ دینے کے لیے جو اوپن اے آئی کے چیٹ جی پی ٹی نے اپنی عدالت میں فائلنگ میں مکمل طور پر ایجاد کیے تھے۔

محققین نے یہ بھی پایا کہ جن تین ماڈلز کا انہوں نے تجربہ کیا ان میں چھوٹی اور کم طاقتور عدالتوں سے متعلق مقامی قانونی کارروائیوں کے مقابلے میں امریکی سپریم کورٹ سے متعلق وفاقی قانونی چارہ جوئی میں زیادہ علم ہونے کا امکان ہے۔

چونکہ GPT-3.5، PaLM-2، اور Llama 2 کو انٹرنیٹ سے سکریپ کیے گئے متن پر تربیت دی گئی تھی، اس لیے یہ سمجھ میں آتا ہے کہ وہ امریکی سپریم کورٹ کی قانونی آراء سے زیادہ واقف ہوں گے، جو دیگر اقسام میں دائر قانونی دستاویزات کے مقابلے عوامی طور پر شائع کیے جاتے ہیں۔ عدالتوں کی جو اتنی آسانی سے قابل رسائی نہیں ہیں۔

وہ ایسے کاموں میں جدوجہد کرنے کا بھی زیادہ امکان رکھتے تھے جن میں پرانے اور نئے کیسوں سے معلومات کو یاد کرنا شامل تھا۔

اخبار کے مطابق، "سپریم کورٹ کے سب سے پرانے اور جدید ترین مقدمات میں فریب نظر سب سے زیادہ عام ہیں، اور جنگ کے بعد کے وارن کورٹ کے مقدمات (1953-1969) میں سب سے کم عام ہیں۔" "یہ نتیجہ LLMs کے قانونی علم پر ایک اور اہم حد کی تجویز کرتا ہے جس کے بارے میں صارفین کو آگاہ ہونا چاہئے: LLMs کی اعلی کارکردگی نظریے کی موجودہ حالت سے کئی سال پیچھے رہ سکتی ہے، اور LLMs کیس کے قانون کو اندرونی بنانے میں ناکام ہو سکتے ہیں جو بہت پرانا ہے لیکن پھر بھی لاگو ہے۔ اور متعلقہ قانون۔"

بہت زیادہ AI ایک 'مونو کلچر' بنا سکتا ہے

محققین کو اس بات پر بھی تشویش تھی کہ ان نظاموں پر حد سے زیادہ انحصار ایک قانونی "ایک کلچر" تشکیل دے سکتا ہے۔ چونکہ AI کو ڈیٹا کی ایک محدود مقدار پر تربیت دی جاتی ہے، اس لیے یہ زیادہ نمایاں، معروف کیسز کا حوالہ دے گا جس کی وجہ سے وکلاء دیگر قانونی تشریحات یا متعلقہ نظیروں کو نظر انداز کر دیتے ہیں۔ وہ دوسرے معاملات کو نظر انداز کر سکتے ہیں جو انہیں مختلف نقطہ نظر یا دلائل دیکھنے میں مدد دے سکتے ہیں، جو قانونی چارہ جوئی میں اہم ثابت ہو سکتے ہیں۔

"قانون بذات خود یک سنگی نہیں ہے،" ڈاہل کہتے ہیں۔ "ایک مونو کلچر قانونی ماحول میں خاص طور پر خطرناک ہے۔ ریاستہائے متحدہ میں، ہمارے پاس ایک وفاقی مشترکہ قانون کا نظام ہے جہاں قانون مختلف ریاستوں میں مختلف دائرہ اختیار میں مختلف طریقے سے تیار ہوتا ہے۔ فقہ کی مختلف خطوط یا رجحانات ہیں جو وقت کے ساتھ ساتھ ترقی کرتے ہیں۔"

ہو نے مزید کہا کہ "یہ غلط نتائج اور غیرضروری انحصار کا باعث بن سکتا ہے جو درحقیقت قانونی چارہ جوئی کو نقصان پہنچا سکتا ہے۔" انہوں نے وضاحت کی کہ ایک ماڈل وکیلوں یا بے دخلی کے قوانین جیسی کسی چیز کو سمجھنے کے خواہاں لوگوں کے لیے غلط ردعمل پیدا کر سکتا ہے۔

"جب آپ ایک بڑے لینگویج ماڈل کی مدد لیتے ہیں، تو ہو سکتا ہے کہ آپ کو بالکل غلط جواب مل رہا ہو کہ آپ کی فائلنگ کب ہے یا اس ریاست میں بے دخلی کا اصول کیا ہے،" وہ ایک مثال دیتے ہوئے کہتے ہیں۔ "کیونکہ یہ جو آپ کو بتا رہا ہے وہ نیویارک کا قانون ہے یا کیلیفورنیا کا قانون، اس قانون کے برخلاف جو دراصل آپ کے دائرہ اختیار میں آپ کے مخصوص حالات سے متعلق ہے۔"

محققین نے یہ نتیجہ اخذ کیا کہ قانونی کاموں کے لیے اس قسم کے مقبول ماڈلز کے استعمال کے خطرات چھوٹی ریاستوں میں نچلی عدالتوں میں کاغذی کارروائی جمع کروانے والوں کے لیے سب سے زیادہ ہیں، خاص طور پر اگر ان کے پاس مہارت کم ہے اور وہ غلط مفروضوں پر مبنی ماڈلز سے استفسار کر رہے ہیں۔ ان لوگوں کے وکیل ہونے کا زیادہ امکان ہوتا ہے، جو کم وسائل والی چھوٹی قانونی فرموں سے کم طاقتور ہوتے ہیں، یا وہ لوگ جو اپنی نمائندگی کرنا چاہتے ہیں۔

"مختصر طور پر، ہمیں معلوم ہوتا ہے کہ خطرات ان لوگوں کے لیے سب سے زیادہ ہیں جو LLMs سے سب سے زیادہ فائدہ اٹھائیں گے،" مقالے میں کہا گیا ہے۔ ®

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://go.theregister.com/feed/www.theregister.com/2024/01/10/top_large_language_models_struggle/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 7

- 72

- a

- ہمارے بارے میں

- تک رسائی حاصل

- قابل رسائی

- کے مطابق

- درست

- درست طریقے سے

- کے پار

- اصل میں

- شامل کیا

- جوڑتا ہے

- پھر

- AI

- بھی

- کے درمیان

- رقم

- مقدار

- an

- تجزیہ

- اور

- ایک اور

- جواب

- کوئی بھی

- کچھ

- کہیں

- قابل اطلاق

- کیا

- دلیل

- دلائل

- مصنوعی

- مصنوعی ذہانت

- AS

- سے پوچھ

- مدد

- ایسوسی ایٹ

- مفروضے

- At

- خودکار

- آگاہ

- بار

- کی بنیاد پر

- BE

- کیونکہ

- پیچھے

- فائدہ

- سب سے بڑا

- پریشان

- پیش رفت

- لیکن

- by

- کیلی فورنیا

- کر سکتے ہیں

- نہیں کر سکتے ہیں

- صلاحیتوں

- صلاحیت رکھتا

- کیس

- مقدمات

- چیلنج

- خصوصیات

- چیٹ بٹ

- چیٹ بٹس

- چیٹ جی پی ٹی

- چیک کریں

- جانچ پڑتال

- حالات

- CO

- شریک مصنف۔

- کوڈنگ

- کامن

- عام قانون

- موازنہ

- مقابلے میں

- مکمل

- مکمل طور پر

- پیچیدہ

- اندیشہ

- متعلقہ

- بارہ

- نتیجہ اخذ

- صحیح طریقے سے

- سکتا ہے

- کورٹ

- کورٹ فائلنگ

- عدالتیں

- تخلیق

- اہم

- موجودہ

- موجودہ حالت

- اس وقت

- خطرناک

- ڈینیل

- اعداد و شمار

- بیان کیا

- ترقی

- تیار ہے

- مختلف

- مختلف

- ڈائریکٹر

- do

- دستاویزات

- نہیں

- ڈان

- دو

- آسان

- آسانی سے

- مؤثر طریقے

- بااختیار

- مساوات

- خاص طور پر

- بھی

- ثبوت

- امتحان

- مثال کے طور پر

- ایکسل

- موجود ہے

- مہنگی

- مہارت

- وضاحت کی

- سامنا

- حقیقت یہ ہے

- FAIL

- جعلی

- جھوٹی

- باطل

- واقف

- وفاقی

- کم

- دائر

- فائلنگ

- مل

- فرم

- کے لئے

- فارم

- فارم

- ملا

- مفت

- تازہ

- سے

- بنیادی

- پیدا

- پیدا

- پیداواری

- پیداواری AI۔

- حاصل کرنے

- اچھا

- گوگل

- عظیم

- ہارڈ

- نقصان پہنچانے

- ہے

- he

- مدد

- مدد گار

- سب سے زیادہ

- ہنسی

- تاہم

- HTTPS

- بھاری

- انسانی

- if

- نظر انداز

- اہم

- in

- دیگر میں

- غلط

- صنعت

- معلومات

- معلومات

- کے بجائے

- انسٹی ٹیوٹ

- انٹیلی جنس

- انٹرنیٹ

- آویشکار

- ملوث

- مسئلہ

- IT

- میں

- خود

- فوٹو

- دائرہ کار

- دائرہ کار

- صرف

- جسٹس

- بچے

- جان

- علم

- لیبل

- زبان

- بڑے

- قانون

- قانون سازی

- قوانین

- قانونی مقدموں

- وکیل

- وکلاء

- قیادت

- معروف

- سیکھا ہے

- کم سے کم

- قیادت

- قانونی

- قانونی کارروائی

- کم

- زندگی

- کی طرح

- امکان

- LIMIT

- حد کے

- لمیٹڈ

- لائنوں

- لسٹ

- قانونی چارہ جوئی

- لاما

- تلاش

- کم

- بنا

- بناتا ہے

- بنانا

- ریاضی

- معاملات

- میٹھی

- مئی..

- میٹا

- شاید

- ماڈل

- ماڈل

- یادگار

- زیادہ

- سب سے زیادہ

- بہت

- نام

- ضرورت ہے

- ضروریات

- نئی

- NY

- تازہ ترین

- کچھ بھی نہیں

- of

- اکثر

- پرانا

- سب سے پرانی

- on

- والوں

- اوپنائی

- رائے

- مخالفت کی

- or

- دیگر

- نتائج

- پر

- جوڑی

- کاغذ.

- کاغذی کام

- خاص طور پر

- خاص طور پر

- پاسنگ

- چوٹی

- لوگ

- فیصد

- کارکردگی

- نقطہ نظر

- پی ایچ ڈی

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مقبول

- طاقتور

- اختیارات

- پہلے

- مسئلہ

- مسائل

- کارروائییں

- پروسیسنگ

- پیدا

- پیشہ ورانہ

- ممتاز

- ثابت کریں

- عوامی طور پر

- شائع

- پیچھا کرنا

- سوال

- قیمتیں

- پڑھیں

- اصلی

- حقیقت

- واقعی

- وجہ

- یاد آرہا ہے

- حال ہی میں

- کا حوالہ دیتے ہیں

- متعلقہ

- جاری

- متعلقہ

- انحصار

- کی نمائندگی

- تحقیق

- محققین

- وسائل

- بالترتیب

- جواب

- جوابات

- نتیجہ

- نتائج کی نمائش

- خطرات

- حکمرانی

- s

- کا کہنا ہے کہ

- دیکھنا

- طلب کرو

- دیکھا

- احساس

- مقرر

- قائم کرنے

- کئی

- مختصر

- ہونا چاہئے

- سے ظاہر ہوا

- دکھایا گیا

- شوز

- کی طرف

- سادہ

- بعد

- مہارت

- چھوٹے

- کچھ

- کچھ

- جلد ہی

- آواز

- اسٹینفورڈ

- اسٹینفورڈ یونیورسٹی

- حالت

- امریکہ

- ابھی تک

- ترقی

- جدوجہد

- طالب علم

- مطالعہ

- اس طرح

- پتہ چلتا ہے

- حمایت

- سپریم

- سپریم کورٹ

- کے نظام

- سسٹمز

- ٹیبل

- ٹاسک

- کاموں

- ٹیم

- ٹیکنالوجی

- ٹیکنالوجی کی

- کہہ

- بتاتا ہے

- کیا کرتے ہیں

- تجربہ

- متن

- سے

- کہ

- ۔

- قانون

- دنیا

- ان

- ان

- خود

- وہاں.

- یہ

- وہ

- لگتا ہے کہ

- اس

- ان

- تین

- وقت

- کرنے کے لئے

- بھی

- سب سے اوپر

- تربیت یافتہ

- ٹریننگ

- رجحانات

- اقسام

- سمجھ

- متحدہ

- ریاست ہائے متحدہ امریکہ

- یونیورسٹی

- غیرضروری

- صلی اللہ علیہ وسلم

- us

- صارفین

- کا استعمال کرتے ہوئے

- عام طور پر

- مختلف

- Ve

- ورژن

- بہت

- وارن

- تھا

- راستہ..

- we

- اچھی طرح سے جانا جاتا ہے

- تھے

- کیا

- کیا ہے

- جب

- چاہے

- جس

- جبکہ

- ڈبلیو

- گے

- ساتھ

- وون

- دنیا

- بدتر

- گا

- غلط

- سال

- سال

- یارک

- تم

- اور

- زیفیرنیٹ