پچھلے ہفتے، ٹیکنالوجی انوویشن انسٹی ٹیوٹ (TII) شروع TII فالکن ایل ایل ایم، ایک اوپن سورس فاؤنڈیشنل لارج لینگوئج ماڈل (LLM)۔ کے ساتھ 1 ٹریلین ٹوکن پر تربیت دی گئی۔ ایمیزون سیج میکر، فالکن اعلی درجے کی کارکردگی کا حامل ہے (# 1 پر گلے لگانا چہرہ لیڈر بورڈ تحریر کے وقت) جبکہ دیگر LLMs جیسے llama-65B کے مقابلے نسبتاً ہلکا اور میزبانی کے لیے کم مہنگا ہونے کے باوجود۔ اس پوسٹ میں، ہم دکھاتے ہیں کہ SageMaker پر بڑے ماڈل انفرنس ڈیپ لرننگ کنٹینرز کا استعمال کرتے ہوئے زبان کی سمجھ اور خودکار تحریری مدد جیسی ایپلی کیشنز کے لیے Falcon کو کیسے تعینات کیا جائے۔

فالکن سیج میکر پر اترا ہے۔

TII ابوظہبی کے اندر اطلاق شدہ تحقیقی ادارہ ہے۔ اعلی درجے کی ٹیکنالوجی ریسرچ کونسل; سائنس دانوں، محققین اور انجینئروں کی اس کی ٹیم تبدیلی کی ٹیکنالوجیز کی دریافت اور سائنسی کامیابیوں کی ترقی کے لیے وقف ہے جو ہمارے معاشرے کو مستقبل کا ثبوت دیں گی۔ اس سال کے شروع میں، TII ایک جدید ترین، اوپن سورس LLM کو تربیت دینے کے لیے نکلا اور SageMaker کے بنیادی ڈھانچے، ٹولنگ، اور مہارت کا استعمال کرکے کام انجام دیا (اس بارے میں مزید جاننے کے لیے کہ اس ماڈل کو SageMaker پر کس طرح تربیت دی گئی تھی۔ ، کا حوالہ دیتے ہیں ٹیکنالوجی انوویشن انسٹی ٹیوٹ Amazon SageMaker پر جدید ترین Falcon LLM 40B فاؤنڈیشن ماڈل کی تربیت کرتا ہے۔)۔ اس کوشش کا نتیجہ ہے۔ TII فالکن ایل ایل ایم.

1 ٹریلین ٹوکنز پر تربیت یافتہ، فالکن کے خلاف اعلیٰ ترین کارکردگی کا حامل ہے۔ ایلیوتھر اے آئی لینگویج ماڈل ایویلیویشن ہارنس اور فی الحال نمبر 1 پر ہے۔ گلے لگانا چہرہ لیڈر بورڈ درستگی کے لیے یہ ماڈل دو مختلف سائزوں میں دستیاب ہے — Falcon-40B اور Falcon-7B — اور اسے ایپلی کیشنز میں جدید ترین کارکردگی کے لیے استعمال کیا جا سکتا ہے جیسے کہ زبان کی سمجھ، بات چیت کے تجربات، اور خودکار تحریری مدد۔ اس پوسٹ سے آپ کو اس قسم کے ڈومینز میں اعلی درستگی کا اندازہ لگانے کے لیے SageMaker پر Falcon کی تعیناتی شروع کرنے میں مدد ملے گی۔

SageMaker بڑے ماڈل کا اندازہ DLCs LLM ہوسٹنگ کو آسان بناتا ہے۔

Falcon-40B اور Falcon-7B جیسے LLMs کی میزبانی کرنا مشکل ہو سکتا ہے۔ بڑے ماڈل اکثر زیادہ درست ہوتے ہیں کیونکہ ان میں اربوں پیرامیٹرز شامل ہوتے ہیں، لیکن ان کے سائز کے نتیجے میں انفرنس میں تاخیر یا خراب تھرو پٹ بھی ہو سکتا ہے۔ LLM کی میزبانی کے لیے قابل قبول کارکردگی حاصل کرنے کے لیے مزید GPU میموری اور آپٹمائزڈ کرنل کی ضرورت پڑ سکتی ہے۔ چیزوں کو مزید پیچیدہ کرنے کے لیے، اگرچہ Falcon-7B جیسے چھوٹے ماڈلز عام طور پر ایک GPU پر فٹ ہو سکتے ہیں جیسے NVIDIA A10G مثال جو AWS G5 مثال کی اقسام کو طاقت دیتی ہے، Falcon-40B جیسے بڑے ماڈل نہیں کر سکتے۔ جب ایسا ہوتا ہے تو، اس بڑے ماڈل کو ایک سے زیادہ ٹکڑوں میں تقسیم کرنے اور متعدد GPUs کی میموری سے فائدہ اٹھانے کے لیے ٹینسر متوازی جیسی حکمت عملیوں کا استعمال کیا جانا چاہیے۔ چھوٹے ماڈلز کے لیے استعمال ہونے والے لیگیسی ہوسٹنگ حل عام طور پر اس قسم کی فعالیت پیش نہیں کرتے ہیں، جس سے مشکلات میں اضافہ ہوتا ہے۔

سیج میکر لارج ماڈل انفرنس (LMI) ڈیپ لرننگ کنٹینرز (DLCs) مدد کر سکتے ہیں۔ LMI DLCs Falcon-40B جیسے LLMs کی میزبانی کے لیے ایک مکمل اینڈ ٹو اینڈ حل ہیں۔ سامنے والے سرے پر، ان میں ایک اعلیٰ کارکردگی والا ماڈل سرور (DJL سرونگ) شامل ہے جس میں بڑے ماڈل کے تخمینہ کے لیے ڈیزائن کیا گیا ہے جس میں ٹوکن اسٹریمنگ اور خودکار ماڈل ریپلیکیشن جیسی خصوصیات شامل ہیں تاکہ تھرو پٹ کو بڑھایا جا سکے۔ پسدید پر، LMI DLCs میں متعدد اعلی کارکردگی والے ماڈل کے متوازی انجن بھی شامل ہیں، جیسے ڈیپ اسپیڈ اور فاسٹر ٹرانسفارمر، جو متعدد GPUs میں ماڈل پیرامیٹرز کو تیز اور منظم کر سکتے ہیں۔ ان انجنوں میں مقبول ٹرانسفارمر ماڈلز کے لیے آپٹمائزڈ کرنل بھی شامل ہیں، جو تین گنا زیادہ تیزی سے تخمینہ کو تیز کر سکتے ہیں۔ LMI DLCs کے ساتھ، SageMaker پر LLM ہوسٹنگ شروع کرنے کے لیے آپ کو صرف ایک کنفیگریشن فائل بنانے کی ضرورت ہے۔ SageMaker LMI DLCs کے بارے میں مزید جاننے کے لیے، رجوع کریں۔ ماڈل متوازی اور بڑے ماڈل کا اندازہ اور ہماری دستیاب تصاویر کی فہرست. آپ ہوسٹنگ کے بارے میں ہماری پچھلی پوسٹ بھی دیکھ سکتے ہیں۔ سیج میکر پر بلوم-175B LMI DLCs کا استعمال کرتے ہوئے

حل جائزہ

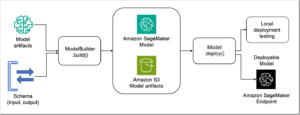

یہ پوسٹ آپ کو بتاتی ہے کہ LMI DLCs کا استعمال کرتے ہوئے SageMaker پر DeepSpeed کا استعمال کرتے ہوئے Falcon-40B کی میزبانی کیسے کی جائے۔ Falcon-40B کا تقاضا ہے کہ ہم ایک سے زیادہ A10 GPU استعمال کریں، جبکہ Falcon-7B کو صرف ایک GPU کی ضرورت ہے۔ ہم نے ایسی مثالیں بھی تیار کی ہیں جن کا حوالہ آپ ڈیپ اسپیڈ اور ایکسلریٹ دونوں کا استعمال کرتے ہوئے میزبان Falcon-40B اور Falcon-7B کا حوالہ دے سکتے ہیں۔ آپ ہمارے کوڈ کی مثالیں تلاش کر سکتے ہیں۔ GitHub کے.

یہ مثال SageMaker نوٹ بک مثالوں میں چلائی جا سکتی ہے یا ایمیزون سیج میکر اسٹوڈیو نوٹ بک LMI اور DeepSpeed کا استعمال کرتے ہوئے Falcon-40B کی میزبانی کے لیے، ہمیں ایک ml.g5.24xlarge مثال استعمال کرنے کی ضرورت ہے۔ یہ مثالیں 4x NVIDIA A10G GPU فراہم کرتی ہیں، جو ہر ایک GPU میموری کے 96 GiB کو سپورٹ کرتی ہے۔ اس کے علاوہ، میزبان 96 vCPUs اور 384 GiB میزبان میموری فراہم کرتا ہے۔ LMI کنٹینر LLMs کی میزبانی سے منسلک زیادہ تر غیر متفاوت بھاری لفٹنگ کو حل کرنے میں مدد کرے گا، بشمول ماڈل کو ڈاؤن لوڈ کرنا اور ماڈل آرٹفیکٹ کو تقسیم کرنا تاکہ اس کے پیرامیٹرز کو متعدد GPUs میں پھیلایا جا سکے۔

SageMaker مشین لرننگ (ML) مثالوں کے کوٹے اکاؤنٹس کے درمیان مختلف ہو سکتے ہیں۔ اگر آپ کو ایک غلطی موصول ہوتی ہے جس سے یہ ظاہر ہوتا ہے کہ آپ نے اس پوسٹ کی پیروی کرتے ہوئے g5.24x بڑی مثالوں کے لیے اپنے کوٹے سے تجاوز کر لیا ہے، تو آپ اس کے ذریعے حد کو بڑھا سکتے ہیں۔ سروس کوٹاس کنسول.

نوٹ بک واک تھرو

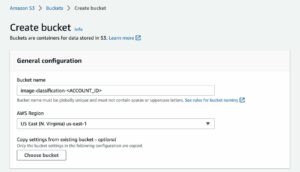

شروع کرنے کے لیے، ہم اپنی مثال کے لیے ضروری انحصار کو انسٹال اور درآمد کرکے شروع کرتے ہیں۔ ہم Boto3 SDK کے ساتھ ساتھ SageMaker SDK بھی استعمال کرتے ہیں۔ نوٹ کریں کہ ہم استعمال کرتے ہیں۔ ایمیزون سادہ اسٹوریج سروس (Amazon S3) ماڈل نمونے کو ذخیرہ کرنے کے لیے جو ہمیں SageMaker اور LMI کو استعمال کرنے کے لیے درکار ہے، اس لیے ہم اس کے مطابق S3 کا سابقہ متغیر ترتیب دیتے ہیں۔ درج ذیل کوڈ دیکھیں:

اس کے بعد ہم اپنے ماڈل کے نمونے کو ذخیرہ کرنے کے لیے اپنے ورک اسپیس کے لیے ایک مقامی فولڈر بناتے ہیں۔

ہم سب سے پہلے ایک بناتے ہیں serving.properties مقامی ڈائریکٹری میں کنفیگریشن فائل جو ہم نے بنائی ہے۔ یہ serving.properties فائل ایل ایم آئی کنٹینر اور فرنٹ اینڈ ڈی جے ایل سرونگ لائبریری کی طرف اشارہ کرتی ہے جس کا ماڈل متوازی اور انفرنس آپٹیمائزیشن انجن ہم استعمال کرنا چاہتے ہیں۔ آپ ڈیپ اسپیڈ اور ہگنگ فیس ایکسلریٹ ان دونوں کے لیے کنفیگریشن کے اختیارات تلاش کر سکتے ہیں۔ کنفیگریشنز اور سیٹنگز. یہاں، نوٹ کریں کہ ہم نے سیٹ کیا ہے۔ option.model_id پیرامیٹر اس بات کی وضاحت کرنے کے لیے کہ کون سے Hugging Face ماڈل سے کھینچنا ہے۔ SageMaker Hugging Face ماڈلز کے ساتھ کام کرنا آسان بناتا ہے، اور یہ ایک لائن آپ کو درکار ہے۔ اس کے علاوہ، ہم نے مقرر کیا option.tensor_parallel_degree 4 کی قدر تک کیونکہ ہمارے پاس ہمارے ml.g5.24xlarge مثال پر چار GPUs ہیں۔ یہ پیرامیٹر اس بات کی وضاحت کرتا ہے کہ ماڈل کے کتنے پارٹیشنز بنانے اور تقسیم کرنے ہیں۔ نوٹ کریں کہ اگر ہم نے آٹھ GPUs کے ساتھ ایک بڑی مثال استعمال کی ہوتی، جیسے ml.g5.48xlarge، اور پھر بھی 4 کی قدر سیٹ کی ہوتی ہے، تو LMI خود بخود ماڈل کی دو نقلیں بناتا (ہر ایک GPUs میں دو نقلیں پھیلی ہوئی ہیں)۔ درج ذیل کوڈ دیکھیں:

آپ تبادلہ بھی کر سکتے ہیں۔ tiiuae/falcon-40b ساتھ tiiuae/falcon-40b-instruct اگر یہ آپ کی ضروریات کو بہتر بناتا ہے۔

ہم بھی شامل ہیں a requirements.txt فائل جس کی آپ ان پیکجوں کو انسٹال کرنے کے لیے وضاحت کر سکتے ہیں جن کی آپ کو ضرورت ہے:

آخری چیز جس کی ہمیں ضرورت ہے وہ ہے۔ model.py فائل جو آپ کے ماڈل کے ساتھ استعمال کی جائے گی:

یہی ہے! اس مقام پر، ہم نے وہ تمام نمونے تیار کر لیے ہیں جن کی آپ کو ڈیپ اسپیڈ کے ساتھ Falcon-40B تعینات کرنے کی ضرورت ہوگی! ہم ڈائریکٹری کو *.tar.gz فائل میں پیک کرتے ہیں اور اسے Amazon S3 پر اپ لوڈ کرتے ہیں۔ نوٹ کریں کہ اصل ماڈل کو اس فائل میں ڈاؤن لوڈ یا پیک نہیں کیا گیا ہے۔ LMI کنٹینر آپ کے لیے Hugging Face سے براہ راست ماڈل ڈاؤن لوڈ کرے گا۔ آپ کے پاس S3 بالٹی کو نشانہ بنانے کا اختیار بھی ہے اگر آپ کسی ایسے مقام پر ماڈل کی اپنی کاپی چاہتے ہیں جو ڈاؤن لوڈ کرنے کے لیے زیادہ پرفارمنس ہو۔ LMI میں اعلی کارکردگی کے ساتھ Amazon S3 سے ڈاؤن لوڈ کرنے کی اصلاح بھی شامل ہے۔ درج ذیل کوڈ دیکھیں:

اس مقام پر جو کچھ کرنا باقی ہے وہ کنٹینر کی وضاحت کرنا ہے جسے ہم استعمال کرنا چاہتے ہیں اور ایک ماڈل آبجیکٹ بنانا چاہتے ہیں:

پھر ہم ایک اینڈ پوائنٹ کنفیگریشن بناتے ہیں اور اینڈ پوائنٹ بناتے ہیں:

کامیاب ہوسٹنگ کے لیے کنفیگریشن آئٹمز کو ذہن میں رکھنا

بڑے ماڈل ہوسٹنگ کے لیے ایک اہم بات یہ یقینی بنانا ہے کہ Hugging Face سے ماڈل ڈاؤن لوڈ کرنے کے لیے مناسب وقت ہو۔ ہمارے ٹیسٹوں میں، Falcon-40B کو مثال کے طور پر ڈاؤن لوڈ ہونے میں تقریباً 90 منٹ لگے۔ اس کی اجازت دینے کے لیے کنفیگریشنز کا ایک کلیدی سیٹ ہے۔ ContainerStartupHealthCheckTimeoutInSeconds اور ماڈل ڈیٹا ڈاؤن لوڈ ٹائم آؤٹ ان سیکنڈز. اس بات کو یقینی بنائیں کہ SageMaker اینڈ پوائنٹ کنفیگریشن میں ان میں سے ہر ایک کے لیے 3600 کی قدر ہے۔ مزید برآں، ایمیزون S3 سے اصل ماڈل کے چڑیا گھر کے بجائے LMI کنٹینرز کا استعمال کرتے ہوئے ڈاؤن لوڈ کرنا بہت آسان ہے جو خاص طور پر LLMS کے لیے بنائے گئے ہیں جو S5cmd یوٹیلیٹی استعمال کرتے ہیں، جو ماڈل ڈاؤن لوڈ کے وقت کو تقریباً 10 منٹ تک کم کر دیتا ہے۔

آپ کال کرکے اختتامی نقطہ کی حیثیت کی نگرانی کرسکتے ہیں۔ DescribeEndpoint، جو آپ کو بتائے گا جب سب کچھ مکمل ہو جائے گا۔ آپ کا اختتامی نقطہ اب تخمینہ کی درخواستوں کا جواب دینے کے لیے تیار ہے! چونکہ LMI آپ کے لیے ماڈل کی تقسیم اور آرکسٹریشن کو سنبھالتا ہے، اس لیے ہر درخواست پر ہمارے ml.g4xlarge مثال پر دستیاب تمام 5.12 GPUs کا استعمال کرتے ہوئے کارروائی کی جائے گی۔ یہ ہمیں LLMs کی میزبانی کرنے اور کارکردگی بڑھانے کی اجازت دیتا ہے اگر آپ GPU ایکسلریٹر کو افقی طور پر پیمانہ کرتے ہیں۔ درج ذیل کوڈ دیکھیں:

اگر آپ کام کر چکے ہیں اور اینڈ پوائنٹ کنفیگریشن، اینڈ پوائنٹ اور ماڈل آبجیکٹ کو حذف کرنا چاہتے ہیں تو آپ درج ذیل کمانڈز چلا سکتے ہیں:

یہ کوڈ جس کا ہم نے اس پوسٹ میں حوالہ دیا ہے اسے مکمل طور پر پایا جا سکتا ہے۔ GitHub پر نوٹ بک.

نتیجہ

SageMaker ہوسٹنگ اور LMI DLC آپ کے لیے Falcon-40B جیسے LLMs کی میزبانی کرنا آسان بناتا ہے۔ یہ ایک سے زیادہ GPUs میں ماڈلز کی میزبانی کرنے کے لیے درکار آرکیسٹریٹنگ میں غیر متفاوت ہیوی لفٹنگ کا سہارا لیتا ہے اور آپ کی ضروریات کو پورا کرنے کے لیے قابل ترتیب اختیارات فراہم کرتا ہے۔ اس کے علاوہ، ان ماڈلز کے لیے بلٹ ان سپورٹ کے ساتھ، Hugging Face ماڈلز کا استعمال بہت سیدھا ہو جاتا ہے۔

اس پوسٹ میں، ہم نے دکھایا کہ آپ ڈیپ اسپیڈ کا استعمال کرتے ہوئے Falcon-40B ماڈل کی میزبانی کے لیے SageMaker کا استعمال کیسے کر سکتے ہیں۔ اس کے علاوہ، ہم نے مثالیں فراہم کیں۔ GitHub کے ایکسلریٹ کا استعمال کرتے ہوئے Falcon-40B اور چھوٹے Falcon-7B ماڈلز کی میزبانی کرنے کے لیے۔ ہم آپ کی حوصلہ افزائی کرتے ہیں کہ LMI کے ساتھ SageMaker پر اسے آزمائیں اور آج تک بہترین کارکردگی کا مظاہرہ کرنے والے عوامی طور پر دستیاب LLM کے ساتھ کام کریں!

مصنفین کے بارے میں

جیمز پارک ایمیزون ویب سروسز میں ایک حل آرکیٹیکٹ ہے۔ وہ Amazon.com کے ساتھ AWS پر ٹکنالوجی کے حل کو ڈیزائن کرنے، بنانے اور ان کی تعیناتی کے لیے کام کرتا ہے، اور اسے AI اور مشین لرننگ میں خاص دلچسپی ہے۔ فارغ وقت میں وہ نئی ثقافتوں، نئے تجربات، اور جدید ترین ٹیکنالوجی کے رجحانات کے ساتھ اپ ٹو ڈیٹ رہنے سے لطف اندوز ہوتا ہے۔ آپ اسے اس پر تلاش کر سکتے ہیں۔ لنکڈ.

جیمز پارک ایمیزون ویب سروسز میں ایک حل آرکیٹیکٹ ہے۔ وہ Amazon.com کے ساتھ AWS پر ٹکنالوجی کے حل کو ڈیزائن کرنے، بنانے اور ان کی تعیناتی کے لیے کام کرتا ہے، اور اسے AI اور مشین لرننگ میں خاص دلچسپی ہے۔ فارغ وقت میں وہ نئی ثقافتوں، نئے تجربات، اور جدید ترین ٹیکنالوجی کے رجحانات کے ساتھ اپ ٹو ڈیٹ رہنے سے لطف اندوز ہوتا ہے۔ آپ اسے اس پر تلاش کر سکتے ہیں۔ لنکڈ.

ابھی شیوادتیہ AWS میں ایک سینئر سولیوشن آرکیٹیکٹ ہے، جو مصنوعی ذہانت، تقسیم شدہ کمپیوٹنگ، نیٹ ورکنگ اور اسٹوریج جیسے شعبوں میں AWS خدمات کو اپنانے میں سہولت فراہم کرنے کے لیے اسٹریٹجک عالمی کاروباری اداروں کے ساتھ کام کر رہا ہے۔ اس کی مہارت نیچرل لینگویج پروسیسنگ (NLP) اور کمپیوٹر ویژن کے ڈومینز میں گہری سیکھنے میں ہے۔ Abhi AWS ماحولیاتی نظام کے اندر اعلی کارکردگی والے مشین لرننگ ماڈلز کو مؤثر طریقے سے تعینات کرنے میں صارفین کی مدد کرتا ہے۔

ابھی شیوادتیہ AWS میں ایک سینئر سولیوشن آرکیٹیکٹ ہے، جو مصنوعی ذہانت، تقسیم شدہ کمپیوٹنگ، نیٹ ورکنگ اور اسٹوریج جیسے شعبوں میں AWS خدمات کو اپنانے میں سہولت فراہم کرنے کے لیے اسٹریٹجک عالمی کاروباری اداروں کے ساتھ کام کر رہا ہے۔ اس کی مہارت نیچرل لینگویج پروسیسنگ (NLP) اور کمپیوٹر ویژن کے ڈومینز میں گہری سیکھنے میں ہے۔ Abhi AWS ماحولیاتی نظام کے اندر اعلی کارکردگی والے مشین لرننگ ماڈلز کو مؤثر طریقے سے تعینات کرنے میں صارفین کی مدد کرتا ہے۔

رابرٹ وان ڈوسن ایمیزون سیج میکر کے ساتھ ایک سینئر پروڈکٹ مینیجر ہے۔ وہ بڑے ماڈل کا اندازہ جیسی ایپلی کیشنز کے لیے گہری سیکھنے کے ماڈل کی اصلاح کی رہنمائی کرتا ہے۔

رابرٹ وان ڈوسن ایمیزون سیج میکر کے ساتھ ایک سینئر پروڈکٹ مینیجر ہے۔ وہ بڑے ماڈل کا اندازہ جیسی ایپلی کیشنز کے لیے گہری سیکھنے کے ماڈل کی اصلاح کی رہنمائی کرتا ہے۔

ایوینڈرو فرانکو ایمیزون ویب سروسز پر کام کرنے والا ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وہ AWS کے صارفین کو AWS کے سب سے اوپر AI/ML سے متعلق کاروباری چیلنجوں پر قابو پانے میں مدد کرتا ہے۔ اس کے پاس ٹیکنالوجی کے ساتھ سافٹ ویئر ڈویلپمنٹ، انفراسٹرکچر، سرور لیس، مشین لرننگ تک 15 سال سے زیادہ کام ہے۔

ایوینڈرو فرانکو ایمیزون ویب سروسز پر کام کرنے والا ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وہ AWS کے صارفین کو AWS کے سب سے اوپر AI/ML سے متعلق کاروباری چیلنجوں پر قابو پانے میں مدد کرتا ہے۔ اس کے پاس ٹیکنالوجی کے ساتھ سافٹ ویئر ڈویلپمنٹ، انفراسٹرکچر، سرور لیس، مشین لرننگ تک 15 سال سے زیادہ کام ہے۔

کنگ لین AWS میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ وہ Amazon میں کئی چیلنجنگ پروڈکٹس پر کام کر رہا ہے، بشمول ہائی پرفارمنس ایم ایل انفرنس سلوشنز اور ہائی پرفارمنس لاگنگ سسٹم۔ Qing کی ٹیم نے بہت کم تاخیر کے ساتھ Amazon Advertising میں پہلا بلین پیرامیٹر ماڈل کامیابی کے ساتھ لانچ کیا۔ کنگ کو بنیادی ڈھانچے کی اصلاح اور گہری سیکھنے کی سرعت کے بارے میں گہرائی سے علم ہے۔

کنگ لین AWS میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ وہ Amazon میں کئی چیلنجنگ پروڈکٹس پر کام کر رہا ہے، بشمول ہائی پرفارمنس ایم ایل انفرنس سلوشنز اور ہائی پرفارمنس لاگنگ سسٹم۔ Qing کی ٹیم نے بہت کم تاخیر کے ساتھ Amazon Advertising میں پہلا بلین پیرامیٹر ماڈل کامیابی کے ساتھ لانچ کیا۔ کنگ کو بنیادی ڈھانچے کی اصلاح اور گہری سیکھنے کی سرعت کے بارے میں گہرائی سے علم ہے۔

فرینک لیو اے ڈبلیو ایس ڈیپ لرننگ کے لیے سافٹ ویئر انجینئر ہے۔ وہ سافٹ ویئر انجینئرز اور سائنسدانوں کے لیے جدید گہرے سیکھنے کے اوزار بنانے پر توجہ مرکوز کرتا ہے۔ اپنے فارغ وقت میں، وہ دوستوں اور خاندان کے ساتھ پیدل سفر کا لطف اٹھاتا ہے۔

فرینک لیو اے ڈبلیو ایس ڈیپ لرننگ کے لیے سافٹ ویئر انجینئر ہے۔ وہ سافٹ ویئر انجینئرز اور سائنسدانوں کے لیے جدید گہرے سیکھنے کے اوزار بنانے پر توجہ مرکوز کرتا ہے۔ اپنے فارغ وقت میں، وہ دوستوں اور خاندان کے ساتھ پیدل سفر کا لطف اٹھاتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- ای وی ایم فنانس۔ وکندریقرت مالیات کے لیے متحد انٹرفیس۔ یہاں تک رسائی حاصل کریں۔

- کوانٹم میڈیا گروپ۔ آئی آر/پی آر ایمپلیفائیڈ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/deploy-falcon-40b-with-large-model-inference-dlcs-on-amazon-sagemaker/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 1

- 10

- 100

- 13

- 14

- 15 سال

- 15٪

- 20

- 22

- 27

- 7

- 8

- 9

- a

- ہمارے بارے میں

- رفتار کو تیز تر

- ایکسلریٹر

- قابل قبول

- اس کے مطابق

- اکاؤنٹس

- درستگی

- درست

- حاصل

- کے پار

- اصل

- انہوں نے مزید کہا

- اس کے علاوہ

- اس کے علاوہ

- پتہ

- منہ بولابیٹا بنانے

- فائدہ

- اشتہار.

- کے خلاف

- AI

- AI / ML

- تمام

- کی اجازت

- کی اجازت دیتا ہے

- بھی

- اگرچہ

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- Amazon.com

- an

- اور

- کوئی بھی

- APIs

- ایپلی کیشنز

- اطلاقی

- کیا

- علاقوں

- ارد گرد

- مصنوعی

- مصنوعی ذہانت

- AS

- اسسٹنس

- مدد

- منسلک

- At

- آٹو

- آٹومیٹڈ

- خودکار

- خود کار طریقے سے

- دستیاب

- AWS

- پسدید

- BE

- کیونکہ

- ہو جاتا ہے

- رہا

- شروع کریں

- کیا جا رہا ہے

- بہتر

- کے درمیان

- اربوں

- دعوی

- جسم

- دونوں

- کامیابیاں

- تعمیر

- عمارت

- تعمیر میں

- کاروبار

- لیکن

- by

- فون

- بلا

- کر سکتے ہیں

- نہیں کر سکتے ہیں

- چیلنجوں

- چیلنج

- چیک کریں

- کوڈ

- COM

- تقابلی طور پر

- مکمل

- پر مشتمل ہے

- کمپیوٹر

- کمپیوٹر ویژن

- کمپیوٹنگ

- ترتیب

- غور

- کنٹینر

- کنٹینر

- سنوادی

- تخلیق

- بنائی

- اس وقت

- گاہکوں

- کمی

- اعداد و شمار

- تاریخ

- وقف

- گہری

- گہری سیکھنے

- وضاحت کرتا ہے

- مظاہرہ

- تعیناتی

- تعینات

- ڈیزائن

- ڈیزائن

- ترقی

- DICT

- مختلف

- مشکلات

- براہ راست

- دریافت

- تقسیم کرو

- تقسیم کئے

- تقسیم کمپیوٹنگ

- do

- ڈومینز

- کیا

- نہیں

- ڈاؤن لوڈ، اتارنا

- ہر ایک

- اس سے قبل

- آسان

- آسان

- ماحول

- مؤثر طریقے سے

- کوشش

- کی حوصلہ افزائی

- آخر

- آخر سے آخر تک

- اختتام پوائنٹ

- انجن

- انجینئر

- انجینئرز

- انجن

- کو یقینی بنانے ہے

- انٹرپرائز

- خرابی

- تشخیص

- سب کچھ

- مثال کے طور پر

- مثال کے طور پر

- حد سے تجاوز کر

- پھانسی

- مہنگی

- تجربات

- مہارت

- چہرہ

- سہولت

- خاندان

- تیز تر

- خصوصیات

- فائل

- مل

- پہلا

- فٹ

- توجہ مرکوز

- کے بعد

- کے لئے

- ملا

- فاؤنڈیشن

- چار

- دوست

- سے

- سامنے

- سامنے کے آخر میں

- فعالیت

- مزید

- عام طور پر

- جنریٹر

- حاصل

- دے دو

- گلوبل

- Go

- GPU

- GPUs

- تھا

- ہینڈل

- ہاتھوں پر

- ہوتا ہے

- ہے

- he

- بھاری

- بھاری وزن اٹھانا

- مدد

- مدد کرتا ہے

- یہاں

- ہائی

- اعلی کارکردگی

- اسے

- ان

- افقی طور پر

- میزبان

- ہوسٹنگ

- ہاؤس

- کس طرح

- کیسے

- HTML

- HTTP

- HTTPS

- if

- تصویر

- درآمد

- اہم

- درآمد

- in

- میں گہرائی

- شامل

- شامل ہیں

- سمیت

- اضافہ

- اشارہ کرتا ہے

- انفراسٹرکچر

- جدت طرازی

- جدید

- ان پٹ

- آدانوں

- انسٹال

- انسٹال کرنا

- مثال کے طور پر

- کے بجائے

- انسٹی ٹیوٹ

- انٹیلی جنس

- بات چیت

- دلچسپی

- میں

- IT

- اشیاء

- میں

- ایوب

- فوٹو

- JSON

- رکھیں

- کلیدی

- علم

- زبان

- بڑے

- بڑے

- آخری

- تاخیر

- تازہ ترین

- شروع

- لیڈز

- جانیں

- سیکھنے

- چھوڑ دیا

- کی وراست

- کم

- لائبریری

- جھوٹ ہے

- زندگی

- اٹھانے

- ہلکا پھلکا

- کی طرح

- LIMIT

- لائن

- لنکڈ

- ایل ایل ایم

- مقامی

- محل وقوع

- لاگ ان

- لو

- مشین

- مشین لرننگ

- بنا

- بناتا ہے

- انتظام

- مینیجر

- بہت سے

- یاد داشت

- برا

- منٹ

- ML

- ماڈل

- ماڈل

- کی نگرانی

- زیادہ

- بہت

- ایک سے زیادہ

- ضروری

- قدرتی

- قدرتی زبان عملیات

- ضروری

- ضرورت ہے

- ضروریات

- نیٹ ورکنگ

- نئی

- ویزا

- نوٹ بک

- اب

- NVIDIA

- اعتراض

- of

- پیش کرتے ہیں

- اکثر

- on

- ایک

- صرف

- اوپن سورس

- اصلاح کے

- اصلاح

- اختیار

- آپشنز کے بھی

- or

- آرکیسٹرا

- تنظیم

- تنظیمیں

- اصل

- OS

- دیگر

- ہمارے

- باہر

- پیداوار

- پر قابو پانے

- خود

- پیکج

- پیک۔

- پیکجوں کے

- متوازی

- پیرامیٹر

- پیرامیٹرز

- خاص طور پر

- راستہ

- کارکردگی

- ٹکڑے ٹکڑے

- پائپ لائن

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- مقبول

- پوسٹ

- اختیارات

- پیش گو

- تیار

- پچھلا

- عملدرآمد

- پروسیسنگ

- مصنوعات

- پروڈکٹ مینیجر

- حاصل

- خصوصیات

- فراہم

- فراہم

- فراہم کرتا ہے

- عوامی طور پر

- مقصد

- تیار

- وصول

- خطے

- متعلقہ

- نقل

- درخواست

- کی ضرورت

- ضرورت

- کی ضرورت ہے

- تحقیق

- محققین

- جواب

- نتیجہ

- واپسی

- کردار

- رن

- sagemaker

- پیمانے

- سائنسی

- سائنسدانوں

- sdk

- دیکھنا

- کی تلاش

- سینئر

- بے سرور

- سروسز

- خدمت

- اجلاس

- مقرر

- کئی

- سے ظاہر ہوا

- سادہ

- آسان بنانے

- صرف

- ایک

- سائز

- چھوٹے

- So

- سوسائٹی

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- سافٹ ویئر انجنیئر

- حل

- حل

- ماہر

- خاص طور پر

- پھیلانے

- شروع کریں

- شروع

- شروع

- ریاستی آرٹ

- درجہ

- ابھی تک

- ذخیرہ

- ذخیرہ

- براہ راست

- حکمت عملی

- حکمت عملیوں

- محرومی

- کامیاب

- کامیابی کے ساتھ

- اس طرح

- سوٹ

- حمایت

- تبادلہ

- کے نظام

- لے لو

- لیتا ہے

- ہدف

- ٹیم

- ٹیکنالوجی

- ٹیکنالوجی

- بتا

- ٹیسٹ

- سے

- کہ

- ۔

- ان

- تو

- وہاں.

- یہ

- وہ

- بات

- چیزیں

- اس

- اس سال

- تین

- کے ذریعے

- تھرو پٹ

- وقت

- اوقات

- کرنے کے لئے

- ٹوکن

- ٹوکن

- لیا

- اوزار

- سب سے اوپر

- مشعل

- ٹرین

- تربیت یافتہ

- ٹرینوں

- تبدیلی

- ٹرانسفارمر

- ٹرانسفارمرز

- رجحانات

- ٹریلین

- کوشش

- دو

- قسم

- اقسام

- عام طور پر

- افہام و تفہیم

- اپ لوڈ کردہ

- us

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- کا استعمال کرتے ہوئے

- کی افادیت

- قیمت

- بہت

- نقطہ نظر

- چاہتے ہیں

- تھا

- we

- ویب

- ویب خدمات

- ہفتے

- اچھا ہے

- کیا

- کیا ہے

- جب

- جبکہ

- جس

- جبکہ

- گے

- ساتھ

- کے اندر

- کام کر

- کام کرتا ہے

- بدتر

- گا

- تحریری طور پر

- سال

- سال

- تم

- اور

- زیفیرنیٹ

- چڑیا گھر