ChatGPT کے آغاز اور جنریٹو AI کی مقبولیت میں اضافے نے ان صارفین کے تصور کو اپنی گرفت میں لے لیا ہے جو اس بات کے بارے میں متجسس ہیں کہ وہ اس ٹیکنالوجی کو AWS پر نئی مصنوعات اور خدمات بنانے کے لیے کس طرح استعمال کر سکتے ہیں، جیسا کہ انٹرپرائز چیٹ بوٹس، جو زیادہ بات چیت کرتے ہیں۔ یہ پوسٹ آپ کو دکھاتی ہے کہ آپ کس طرح ایک ویب UI بنا سکتے ہیں، جسے ہم چیٹ اسٹوڈیو کہتے ہیں، گفتگو شروع کرنے اور اس میں دستیاب فاؤنڈیشن ماڈلز کے ساتھ بات چیت کرنے کے لیے ایمیزون سیج میکر جمپ اسٹارٹ جیسے Llama 2، Stable Diffusion، اور دیگر ماڈلز دستیاب ہیں۔ ایمیزون سیج میکر. اس حل کو تعینات کرنے کے بعد، صارفین تیزی سے شروع کر سکتے ہیں اور ایک ویب انٹرفیس کے باوجود بات چیت کے AI میں متعدد فاؤنڈیشن ماڈلز کی صلاحیتوں کا تجربہ کر سکتے ہیں۔

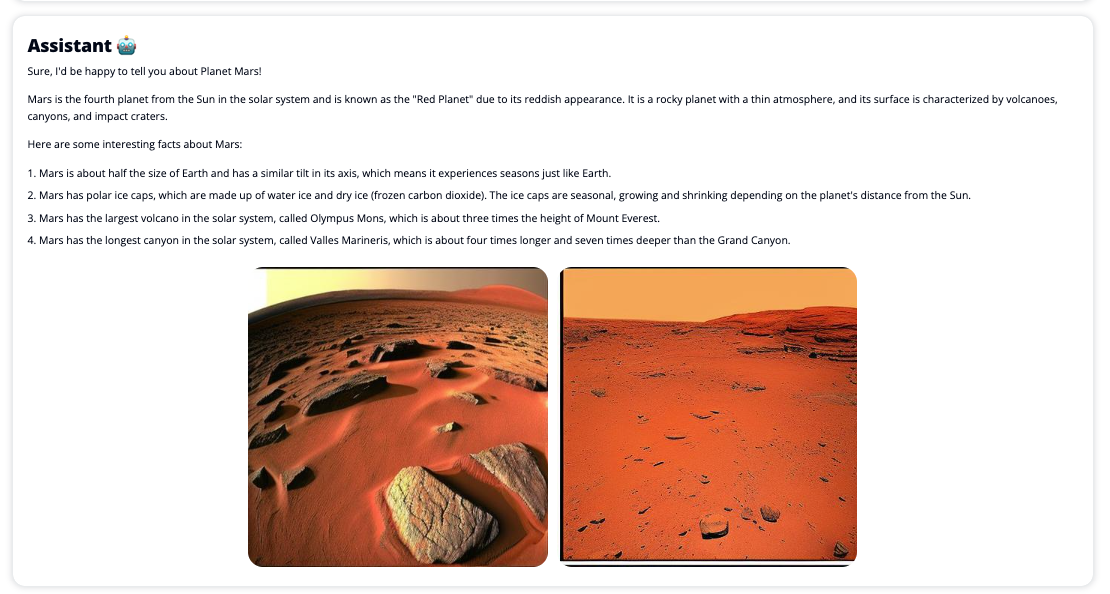

اگر صارف میڈیا کو ظاہر کرنے کی درخواست کرتا ہے تو چیٹ اسٹوڈیو متعلقہ امیجز اور ویڈیوز کا کولیج واپس کرنے کے لیے اسٹیبل ڈفیوژن ماڈل اینڈ پوائنٹ کو بھی اختیار کر سکتا ہے۔ یہ خصوصیت میڈیا کے استعمال کے ساتھ صارف کے تجربے کو بڑھانے میں مدد کر سکتی ہے جیسا کہ جواب میں اثاثوں کے ساتھ۔ یہ صرف ایک مثال ہے کہ آپ اپنے اہداف کو پورا کرنے کے لیے اضافی انضمام کے ساتھ چیٹ اسٹوڈیو کو کس طرح بہتر بنا سکتے ہیں۔

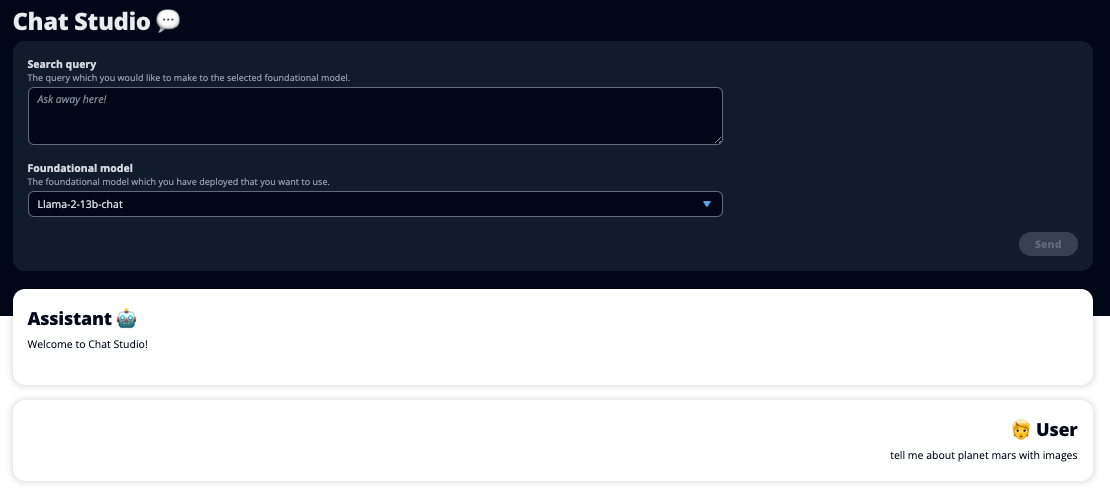

مندرجہ ذیل اسکرین شاٹس اس بات کی مثالیں دکھاتے ہیں کہ صارف کا سوال اور جواب کیسا لگتا ہے۔

بڑے زبان کے ماڈل

جنریٹو AI چیٹ بوٹس جیسے ChatGPT بڑے لینگویج ماڈلز (LLMs) کے ذریعے تقویت یافتہ ہیں، جو کہ ایک گہری سیکھنے والے نیورل نیٹ ورک پر مبنی ہیں جسے بغیر لیبل والے متن کی بڑی مقدار پر تربیت دی جا سکتی ہے۔ LLMs کا استعمال ایک بہتر بات چیت کے تجربے کی اجازت دیتا ہے جو حقیقی انسانوں کے ساتھ تعاملات کے قریب سے ملتا ہے، کنکشن کے احساس کو فروغ دیتا ہے اور صارف کی اطمینان کو بہتر بناتا ہے۔

سیج میکر فاؤنڈیشن ماڈل

2021 میں، سٹینفورڈ انسٹی ٹیوٹ فار ہیومن سینٹرڈ آرٹیفیشل انٹیلی جنس نے کچھ LLMs کو قرار دیا بنیاد ماڈل. فاؤنڈیشن ماڈلز کو عام ڈیٹا کے ایک بڑے اور وسیع سیٹ پر پہلے سے تربیت دی جاتی ہے اور ان کا مقصد ڈیجیٹل آرٹ تیار کرنے سے لے کر کثیر لسانی متن کی درجہ بندی تک وسیع پیمانے پر استعمال کے معاملات میں مزید اصلاح کی بنیاد کے طور پر کام کرنا ہے۔ یہ فاؤنڈیشن ماڈل صارفین میں مقبول ہیں کیونکہ نئے ماڈل کو شروع سے تربیت دینے میں وقت لگتا ہے اور یہ مہنگا بھی ہو سکتا ہے۔ سیج میکر جمپ سٹارٹ تیسرے فریق کے اوپن سورس اور ملکیتی فراہم کنندگان سے رکھے گئے سینکڑوں فاؤنڈیشن ماڈلز تک رسائی فراہم کرتا ہے۔

حل جائزہ

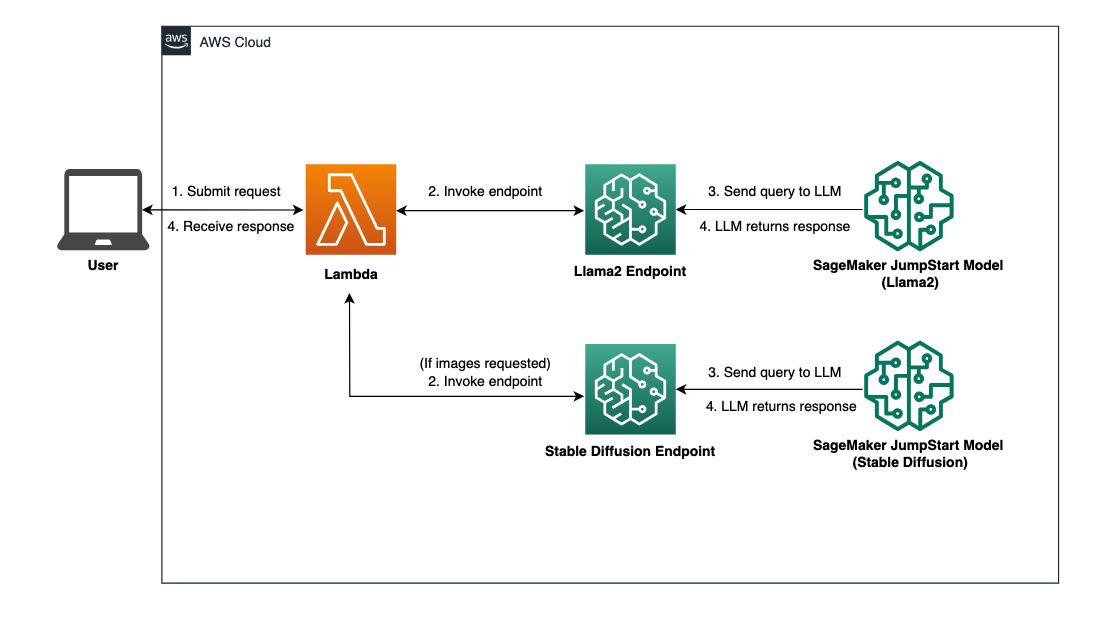

یہ پوسٹ سیج میکر کے ذریعے پہلے سے تربیت یافتہ اور کسٹم LLMs کو تعینات کرنے اور تعینات کردہ ماڈلز کے ساتھ انٹرفیس کرنے کے لیے ایک ویب UI بنانے کے لیے کم کوڈ والے ورک فلو سے گزرتی ہے۔ ہم مندرجہ ذیل اقدامات کا احاطہ کرتے ہیں:

- سیج میکر فاؤنڈیشن ماڈلز کو تعینات کریں۔

- تعینات او ڈبلیو ایس لامبڈا۔ اور AWS شناخت اور رسائی کا انتظام (IAM) کا استعمال کرتے ہوئے اجازت AWS کلاؤڈ فارمیشن.

- یوزر انٹرفیس کو ترتیب دیں اور چلائیں۔

- اختیاری طور پر، دیگر SageMaker فاؤنڈیشن ماڈل شامل کریں۔ یہ قدم اضافی فاؤنڈیشن ماڈلز کے ساتھ بات چیت کرنے کے لیے چیٹ اسٹوڈیو کی صلاحیت کو بڑھاتا ہے۔

- اختیاری طور پر، استعمال کرتے ہوئے ایپلیکیشن کو تعینات کریں۔ AWS بڑھانا. یہ مرحلہ چیٹ اسٹوڈیو کو ویب پر تعینات کرتا ہے۔

حل کے فن تعمیر کا جائزہ لینے کے لیے درج ذیل خاکہ کو دیکھیں۔

شرائط

حل کے ذریعے چلنے کے لیے، آپ کو درج ذیل شرائط کا ہونا ضروری ہے:

- An AWS اکاؤنٹ کافی IAM صارف مراعات کے ساتھ۔

npmآپ کے مقامی ماحول میں نصب۔ انسٹال کرنے کے طریقے سے متعلق ہدایات کے لیےnpm، کا حوالہ دیتے ہیں Node.js اور npm کو ڈاؤن لوڈ اور انسٹال کرنا.- متعلقہ SageMaker اینڈ پوائنٹس کے لیے 1 کا سروس کوٹہ۔ Llama 2 13b Chat کے لیے، ہم ایک ml.g5.48xlarge مثال استعمال کرتے ہیں اور Stable Diffusion 2.1 کے لیے، ہم ایک ml.p3.2xlarge مثال استعمال کرتے ہیں۔

سروس کوٹہ میں اضافے کی درخواست کرنے کے لیے، پر AWS سروس کوٹاس کنسول، پر جائیں AWS خدمات, سیج میکر۔، اور سروس کوٹہ کے لیے درخواست کریں کہ اختتامی نقطہ کے استعمال کے لیے ml.g1xlarge اور اختتامی نقطہ کے استعمال کے لیے ml.p5.48xlarge کے لیے 3.2 کی قدر بڑھا دیں۔

سروس کوٹہ کی درخواست کو منظور ہونے میں چند گھنٹے لگ سکتے ہیں، مثال کی قسم کی دستیابی پر منحصر ہے۔

سیج میکر فاؤنڈیشن ماڈلز کو تعینات کریں۔

SageMaker ایک مکمل طور پر منظم مشین لرننگ (ML) سروس ہے جو ڈیولپرز کے لیے آسانی کے ساتھ ML ماڈلز کو تیزی سے بنانے اور تربیت دینے کے لیے ہے۔ Llama 2 13b Chat اور Stable Diffusion 2.1 فاؤنڈیشن ماڈل استعمال کرنے کے لیے درج ذیل مراحل کو مکمل کریں۔ ایمیزون سیج میکر اسٹوڈیو:

- سیج میکر ڈومین بنائیں۔ ہدایات کے لیے، رجوع کریں۔ فوری سیٹ اپ کا استعمال کرتے ہوئے ایمیزون سیج میکر ڈومین پر آن بورڈ.

ایک ڈومین تمام اسٹوریج کو ترتیب دیتا ہے اور آپ کو سیج میکر تک رسائی کے لیے صارفین کو شامل کرنے کی اجازت دیتا ہے۔

- سیج میکر کنسول پر، منتخب کریں۔ سٹوڈیو نیویگیشن پین میں، پھر منتخب کریں۔ سٹوڈیو کھولیں۔.

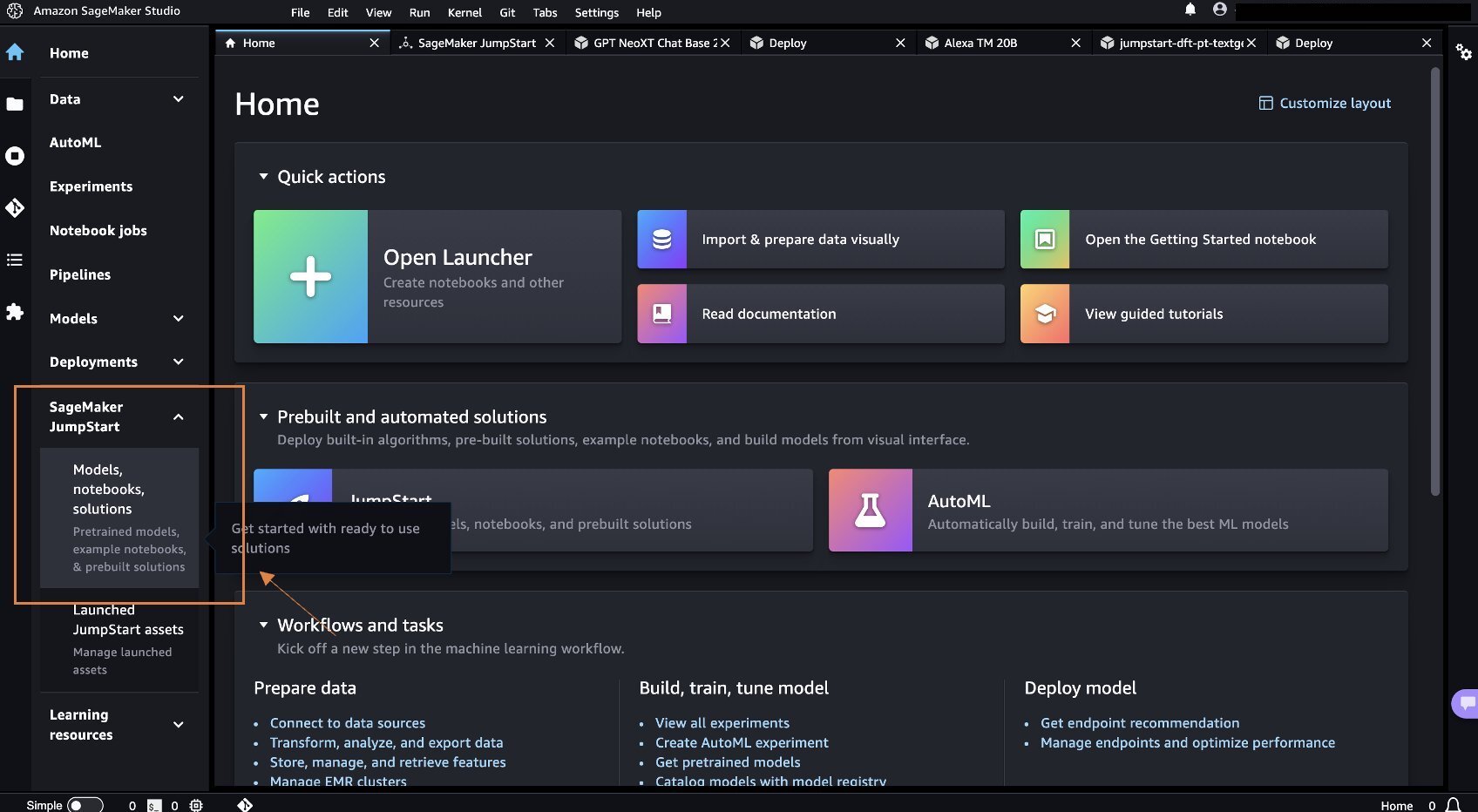

- اسٹوڈیو شروع کرنے پر، نیچے سیج میکر جمپ اسٹارٹ نیویگیشن پین میں، منتخب کریں۔ ماڈل، نوٹ بک، حل.

- سرچ بار میں، Llama 2 13b Chat تلاش کریں۔

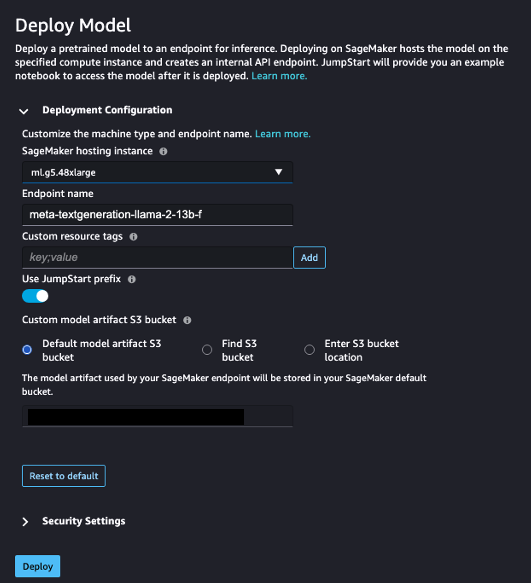

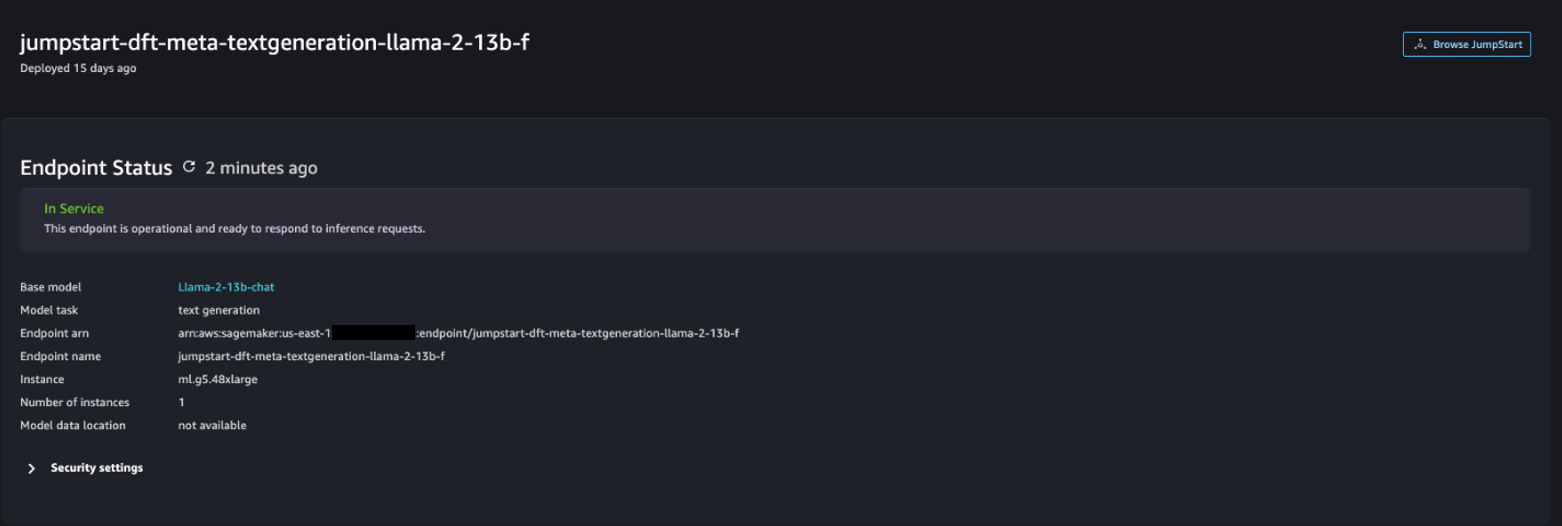

- کے تحت تعیناتی کی ترتیب، کے لئے سیج میکر ہوسٹنگ مثالمنتخب کریں ml.g5.48xlarge اور کے لئے اختتامی نقطہ کا نام، داخل کریں

meta-textgeneration-llama-2-13b-f. - میں سے انتخاب کریں تعینات کریں۔

تعیناتی کامیاب ہونے کے بعد، آپ کو دیکھنے کے قابل ہونا چاہیے۔ In Service حیثیت.

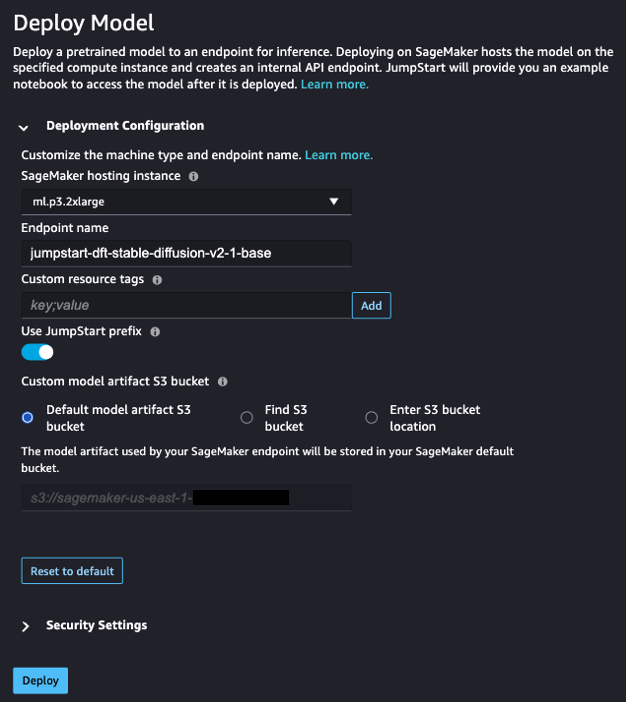

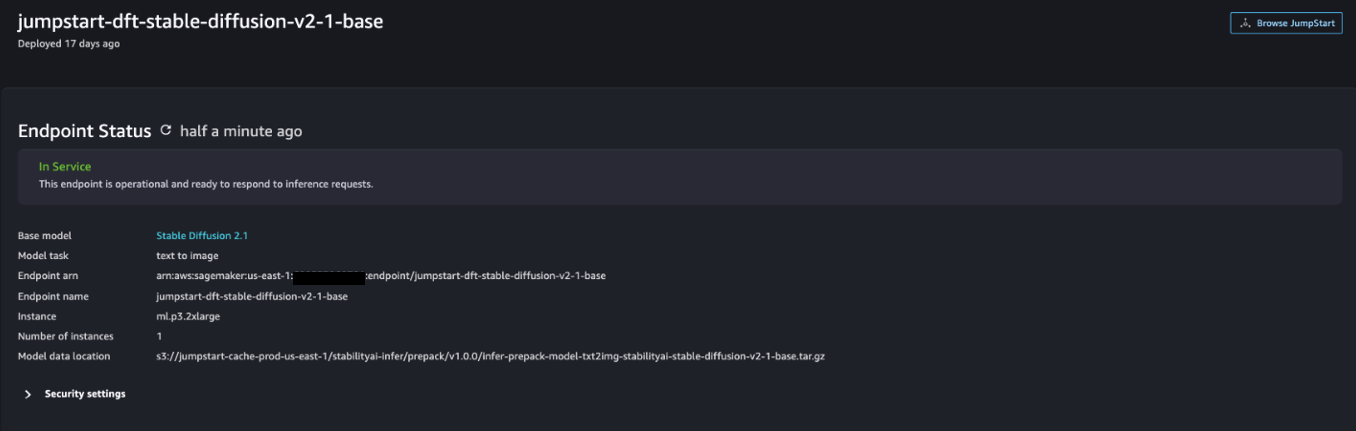

- پر ماڈل، نوٹ بک، حل صفحہ، مستحکم بازی 2.1 کے لیے تلاش کریں۔

- کے تحت تعیناتی کی ترتیب، کے لئے سیج میکر ہوسٹنگ مثالمنتخب کریں ml.p3.2xlarge اور کے لئے اختتامی نقطہ کا نام، داخل کریں

jumpstart-dft-stable-diffusion-v2-1-base. - میں سے انتخاب کریں تعینات.

تعیناتی کامیاب ہونے کے بعد، آپ کو دیکھنے کے قابل ہونا چاہیے۔ In Service حیثیت.

AWS CloudFormation کا استعمال کرتے ہوئے Lambda اور IAM کی اجازتیں متعین کریں۔

یہ سیکشن بتاتا ہے کہ آپ کس طرح ایک CloudFormation اسٹیک لانچ کر سکتے ہیں جو ایک Lambda فنکشن کو تعینات کرتا ہے جو آپ کی صارف کی درخواست پر کارروائی کرتا ہے اور SageMaker اینڈ پوائنٹ کو کال کرتا ہے جسے آپ نے تعینات کیا ہے، اور تمام ضروری IAM اجازتوں کو تعینات کرتا ہے۔ درج ذیل مراحل کو مکمل کریں:

- پر تشریف لے جائیں GitHub ذخیرہ اور CloudFormation ٹیمپلیٹ ڈاؤن لوڈ کریں (

lambda.cfn.yaml) آپ کی مقامی مشین پر۔ - CloudFormation کنسول پر، منتخب کریں۔ اسٹیک بنائیں ڈراپ ڈاؤن مینو اور منتخب کریں۔ نئے وسائل کے ساتھ (معیاری).

- پر ٹیمپلیٹ کی وضاحت کریں۔ صفحہ ، منتخب کریں ٹیمپلیٹ فائل اپ لوڈ کریں۔ اور فائل منتخب کریں.

- منتخب کیجئیے

lambda.cfn.yamlفائل جو آپ نے ڈاؤن لوڈ کی ہے، پھر منتخب کریں۔ اگلے. - پر اسٹیک کی تفصیلات بتائیں صفحہ، اسٹیک کا نام اور API کلید درج کریں جو آپ نے شرائط میں حاصل کی ہے، پھر منتخب کریں۔ اگلے.

- پر اسٹیک کے اختیارات کو ترتیب دیں۔ صفحہ، منتخب کریں اگلے.

- تبدیلیوں کا جائزہ لیں اور تسلیم کریں اور منتخب کریں۔ جمع کرائیں.

ویب UI سیٹ اپ کریں۔

یہ سیکشن ویب UI کو چلانے کے اقدامات کی وضاحت کرتا ہے (کا استعمال کرتے ہوئے تخلیق کیا گیا ہے۔ کلاؤڈ اسکیپ ڈیزائن سسٹم) آپ کی مقامی مشین پر:

- IAM کنسول پر، صارف پر جائیں۔

functionUrl. - پر حفاظتی اسناد ٹیب، منتخب کریں رسائی کلید بنائیں.

- پر کلیدی بہترین طریقوں اور متبادل تک رسائی حاصل کریں۔ صفحہ ، منتخب کریں کمانڈ لائن انٹرفیس (سی ایل آئی) اور منتخب کریں اگلے.

- پر تفصیل کا ٹیگ سیٹ کریں۔ صفحہ، منتخب کریں رسائی کلید بنائیں.

- رسائی کلید اور خفیہ رسائی کلید کو کاپی کریں۔

- میں سے انتخاب کریں کیا.

- پر تشریف لے جائیں GitHub ذخیرہ اور ڈاؤن لوڈ کریں

react-llm-chat-studioکوڈ - اپنے پسندیدہ IDE میں فولڈر لانچ کریں اور ٹرمینل کھولیں۔

- پر تشریف لے جائیں

src/configs/aws.jsonاور آپ کو حاصل کردہ رسائی کلید اور خفیہ رسائی کلید داخل کریں۔ - ٹرمینل میں درج ذیل کمانڈز درج کریں:

- اوپن http://localhost:3000 اپنے براؤزر میں اور اپنے ماڈلز کے ساتھ بات چیت شروع کریں!

چیٹ اسٹوڈیو استعمال کرنے کے لیے، ڈراپ ڈاؤن مینو پر ایک بنیادی ماڈل منتخب کریں اور ٹیکسٹ باکس میں اپنا سوال درج کریں۔ جواب کے ساتھ AI سے تیار کردہ تصاویر حاصل کرنے کے لیے، اپنے استفسار کے آخر میں "تصاویر کے ساتھ" کا جملہ شامل کریں۔

دیگر SageMaker فاؤنڈیشن ماڈل شامل کریں۔

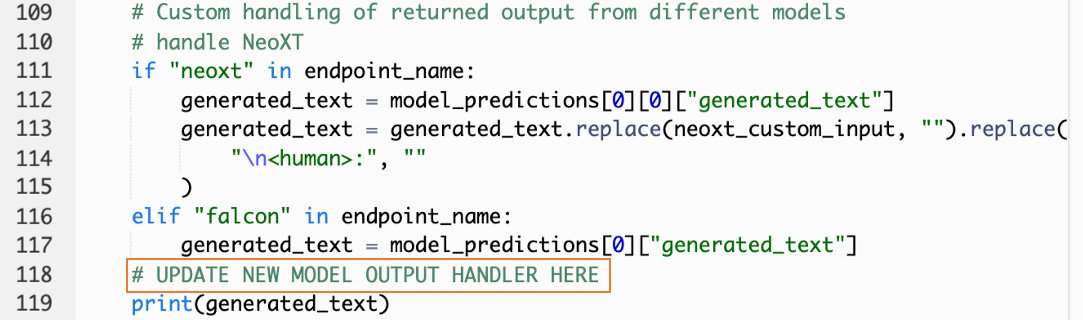

اضافی SageMaker فاؤنڈیشن ماڈلز کو شامل کرنے کے لیے آپ اس حل کی صلاحیت کو مزید بڑھا سکتے ہیں۔ چونکہ ہر ماڈل اپنے SageMaker اینڈ پوائنٹ کو استعمال کرتے وقت مختلف ان پٹ اور آؤٹ پٹ فارمیٹس کی توقع کرتا ہے، اس لیے آپ کو ماڈل کے ساتھ انٹرفیس کرنے کے لیے callSageMakerEndpoints Lambda فنکشن میں کچھ ٹرانسفارمیشن کوڈ لکھنے کی ضرورت ہوگی۔

یہ سیکشن آپ کی پسند کے ایک اضافی ماڈل کو نافذ کرنے کے لیے درکار عمومی اقدامات اور کوڈ کی تبدیلیوں کی وضاحت کرتا ہے۔ نوٹ کریں کہ مراحل 6-8 کے لیے ازگر کی زبان کا بنیادی علم درکار ہے۔

- سیج میکر اسٹوڈیو میں، اپنی پسند کا سیج میکر فاؤنڈیشن ماڈل لگائیں۔

- میں سے انتخاب کریں سیج میکر جمپ اسٹارٹ اور جمپ اسٹارٹ اثاثے شروع کریں۔.

- اپنے نئے تعینات کردہ ماڈل اینڈ پوائنٹ کا انتخاب کریں اور منتخب کریں۔ نوٹ بک کھولیں۔.

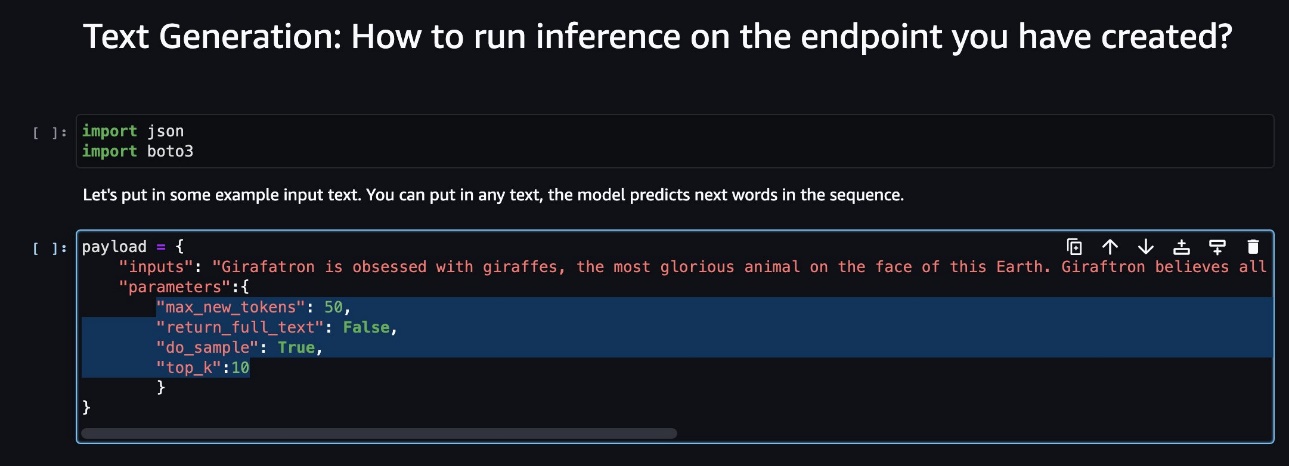

- نوٹ بک کنسول پر، پے لوڈ پیرامیٹرز تلاش کریں۔

یہ وہ فیلڈز ہیں جن کی توقع نیا ماڈل اپنے SageMaker اینڈ پوائنٹ کو استعمال کرتے وقت کرتا ہے۔ مندرجہ ذیل اسکرین شاٹ ایک مثال دکھاتا ہے۔

- لیمبڈا کنسول پر، نیویگیٹ کریں۔

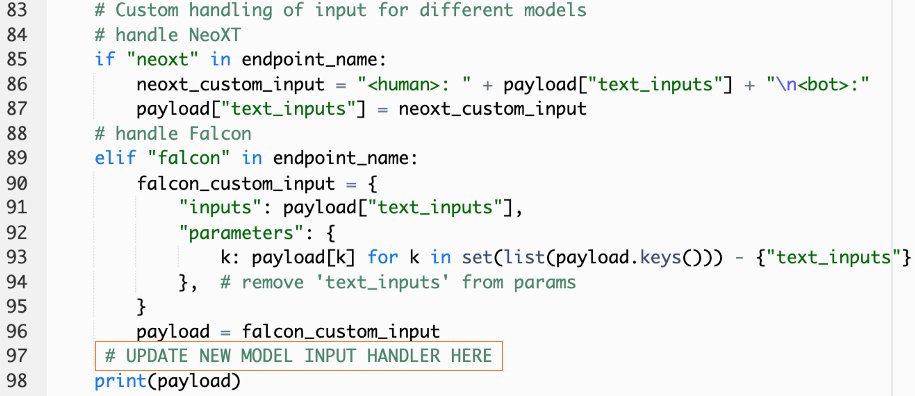

callSageMakerEndpoints. - اپنے نئے ماڈل کے لیے حسب ضرورت ان پٹ ہینڈلر شامل کریں۔

مندرجہ ذیل اسکرین شاٹ میں، ہم نے Falcon 40B Instruct BF16 اور GPT NeoXT Chat Base 20B FP16 کے لیے ان پٹ کو تبدیل کر دیا۔ آپ اپنا حسب ضرورت پیرامیٹر لاجک داخل کر سکتے ہیں جیسا کہ آپ نے کاپی کردہ پے لوڈ پیرامیٹرز کے حوالے سے ان پٹ ٹرانسفارمیشن لاجک کو شامل کرنے کے لیے اشارہ کیا ہے۔

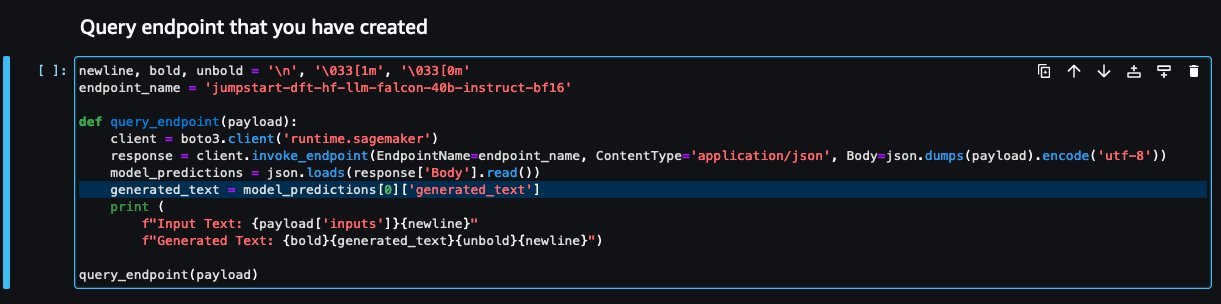

- نوٹ بک کنسول پر واپس جائیں اور تلاش کریں۔

query_endpoint.

یہ فنکشن آپ کو اندازہ دیتا ہے کہ حتمی متن کے جواب کو نکالنے کے لیے ماڈلز کے آؤٹ پٹ کو کیسے تبدیل کیا جائے۔

- میں کوڈ کے حوالے سے

query_endpointاپنے نئے ماڈل کے لیے ایک حسب ضرورت آؤٹ پٹ ہینڈلر شامل کریں۔

- میں سے انتخاب کریں تعینات کریں۔

- اپنا IDE کھولیں، لانچ کریں۔

react-llm-chat-studioکوڈ، اور تشریف لے جائیں۔src/configs/models.json. - اپنے ماڈل کا نام اور ماڈل اینڈ پوائنٹ شامل کریں، اور نیچے مرحلہ 4 سے پے لوڈ پیرامیٹرز درج کریں۔

payloadمندرجہ ذیل فارمیٹ کا استعمال کرتے ہوئے: - اپنے نئے ماڈل کے ساتھ تعامل شروع کرنے کے لیے اپنے براؤزر کو ریفریش کریں!

ایمپلیفائی کا استعمال کرتے ہوئے ایپلیکیشن کو تعینات کریں۔

Amplify ایک مکمل حل ہے جو آپ کو اپنی درخواست کو تیزی سے اور مؤثر طریقے سے تعینات کرنے کی اجازت دیتا ہے۔ یہ سیکشن چیٹ اسٹوڈیو کو ایک پر تعینات کرنے کے اقدامات کی وضاحت کرتا ہے۔ ایمیزون CloudFront اگر آپ اپنی ایپلیکیشن کو دوسرے صارفین کے ساتھ شیئر کرنا چاہتے ہیں تو Amplify کا استعمال کرتے ہوئے تقسیم۔

- پر تشریف لے جائیں

react-llm-chat-studioکوڈ فولڈر جو آپ نے پہلے بنایا تھا۔ - ٹرمینل میں درج ذیل کمانڈز درج کریں اور سیٹ اپ کی ہدایات پر عمل کریں:

- درج ذیل کمانڈ کا استعمال کرکے ایک نیا ایمپلیفائی پروجیکٹ شروع کریں۔ پروجیکٹ کا نام فراہم کریں، ڈیفالٹ کنفیگریشنز کو قبول کریں، اور منتخب کریں۔ AWS رسائی کی چابیاں جب تصدیق کا طریقہ منتخب کرنے کا اشارہ کیا جائے۔

- مندرجہ ذیل کمانڈ کا استعمال کرکے Amplify پروجیکٹ کی میزبانی کریں۔ منتخب کریں۔ ایمیزون کلاؤڈ فرنٹ اور S3 جب پلگ ان موڈ کو منتخب کرنے کا اشارہ کیا جائے۔

- آخر میں، مندرجہ ذیل کمانڈ کے ساتھ پروجیکٹ کی تعمیر اور تعیناتی کریں:

- تعیناتی کامیاب ہونے کے بعد، اپنے براؤزر میں فراہم کردہ URL کو کھولیں اور اپنے ماڈلز کے ساتھ بات چیت شروع کریں!

صاف کرو

مستقبل کے چارجز سے بچنے کے لیے، درج ذیل اقدامات مکمل کریں:

- CloudFormation اسٹیک کو حذف کریں۔ ہدایات کے لیے، رجوع کریں۔ AWS CloudFormation کنسول پر ایک اسٹیک کو حذف کرنا.

- سیج میکر جمپ اسٹارٹ اینڈ پوائنٹ کو حذف کریں۔ ہدایات کے لیے، رجوع کریں۔ اختتامی مقامات اور وسائل کو حذف کریں۔.

- سیج میکر ڈومین کو حذف کریں۔ ہدایات کے لیے، رجوع کریں۔ ایمیزون سیج میکر ڈومین کو حذف کریں۔.

نتیجہ

اس پوسٹ میں، ہم نے بتایا کہ AWS پر تعینات LLMs کے ساتھ انٹرفیس کرنے کے لیے ویب UI کیسے بنایا جائے۔

اس حل کے ساتھ، آپ اپنے LLM کے ساتھ بات چیت کر سکتے ہیں اور LLM سوالات کو جانچنے یا پوچھنے کے لیے صارف دوست انداز میں گفتگو کر سکتے ہیں، اور ضرورت پڑنے پر تصاویر اور ویڈیوز کا کولیج حاصل کر سکتے ہیں۔

آپ اس حل کو مختلف طریقوں سے بڑھا سکتے ہیں، جیسے اضافی فاؤنڈیشن ماڈلز کو مربوط کرنا، ایمیزون کیندر کے ساتھ ضم کریں۔ انٹرپرائز مواد کو سمجھنے کے لیے ML سے چلنے والی ذہین تلاش کو فعال کرنے کے لیے، اور مزید!

ہم آپ کو تجربہ کرنے کی دعوت دیتے ہیں۔ مختلف پہلے سے تربیت یافتہ LLMs AWS پر دستیاب ہیں۔، یا SageMaker میں اپنے LLMs کے اوپر بنائیں یا یہاں تک کہ بنائیں۔ ہمیں تبصرے میں اپنے سوالات اور نتائج بتائیں، اور مزہ کریں!

مصنفین کے بارے میں

جیرٹ ییو شان وی AWS پروفیشنل سروسز میں ایک ایسوسی ایٹ کلاؤڈ آرکیٹیکٹ ہے جو پورے ASEAN میں پبلک سیکٹر کا احاطہ کرتی ہے اور صارفین کو کلاؤڈ میں جدید بنانے اور ہجرت کرنے میں مدد کرنے کا وکیل ہے۔ اس نے پانچ AWS سرٹیفیکیشن حاصل کیے ہیں، اور اس نے AI پر 8ویں بین الاقوامی کانفرنس میں گریڈینٹ بوسٹنگ مشین کے ملبوسات پر ایک تحقیقی مقالہ بھی شائع کیا ہے۔ اپنے فارغ وقت میں، جیریٹ AWS میں تخلیقی AI منظر پر توجہ مرکوز کرتا ہے اور اس میں تعاون کرتا ہے۔

جیرٹ ییو شان وی AWS پروفیشنل سروسز میں ایک ایسوسی ایٹ کلاؤڈ آرکیٹیکٹ ہے جو پورے ASEAN میں پبلک سیکٹر کا احاطہ کرتی ہے اور صارفین کو کلاؤڈ میں جدید بنانے اور ہجرت کرنے میں مدد کرنے کا وکیل ہے۔ اس نے پانچ AWS سرٹیفیکیشن حاصل کیے ہیں، اور اس نے AI پر 8ویں بین الاقوامی کانفرنس میں گریڈینٹ بوسٹنگ مشین کے ملبوسات پر ایک تحقیقی مقالہ بھی شائع کیا ہے۔ اپنے فارغ وقت میں، جیریٹ AWS میں تخلیقی AI منظر پر توجہ مرکوز کرتا ہے اور اس میں تعاون کرتا ہے۔

ٹامی لم لی زین AWS میں ایک ایسوسی ایٹ کلاؤڈ آرکیٹیکٹ ہے۔ وہ صارفین کو ان کے کلاؤڈ اپنانے کے سفر میں مطلوبہ نتائج فراہم کرنے میں مدد کرنے کے لیے ٹیکنالوجی کا استعمال کرتی ہے اور AI/ML کے بارے میں پرجوش ہے۔ کام سے باہر اسے سفر کرنا، پیدل سفر کرنا اور خاندان اور دوستوں کے ساتھ وقت گزارنا پسند ہے۔

ٹامی لم لی زین AWS میں ایک ایسوسی ایٹ کلاؤڈ آرکیٹیکٹ ہے۔ وہ صارفین کو ان کے کلاؤڈ اپنانے کے سفر میں مطلوبہ نتائج فراہم کرنے میں مدد کرنے کے لیے ٹیکنالوجی کا استعمال کرتی ہے اور AI/ML کے بارے میں پرجوش ہے۔ کام سے باہر اسے سفر کرنا، پیدل سفر کرنا اور خاندان اور دوستوں کے ساتھ وقت گزارنا پسند ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- : ہے

- : ہے

- $UP

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8th

- a

- قابلیت

- ہمارے بارے میں

- قبول کریں

- تک رسائی حاصل

- تسلیم کرتے ہیں

- کے پار

- شامل کریں

- ایڈیشنل

- منہ بولابیٹا بنانے

- وکیل

- کے بعد

- AI

- AI / ML

- تمام

- کی اجازت دیتا ہے

- ساتھ

- بھی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- بڑھاؤ

- an

- اور

- اے پی آئی

- درخواست

- کی منظوری دے دی

- فن تعمیر

- کیا

- فن

- مصنوعی

- مصنوعی ذہانت

- AS

- اسین

- پوچھنا

- اثاثے

- ایسوسی ایٹ

- At

- حاصل ہوا

- کی توثیق

- دستیابی

- دستیاب

- سے اجتناب

- AWS

- AWS کلاؤڈ فارمیشن

- AWS پروفیشنل سروسز

- بار

- بیس

- کی بنیاد پر

- بنیادی

- BE

- کیونکہ

- BEST

- بہترین طریقوں

- بہتر

- اضافے کا باعث

- باکس

- وسیع

- براؤزر

- تعمیر

- by

- فون

- کالز

- کر سکتے ہیں

- حاصل کر سکتے ہیں

- صلاحیتوں

- صلاحیت

- پر قبضہ کر لیا

- مقدمات

- سرٹیفکیٹ

- تبدیلیاں

- بوجھ

- چیٹ بٹس

- چیٹ جی پی ٹی

- انتخاب

- میں سے انتخاب کریں

- درجہ بندی

- قریب سے

- بادل

- بادل اپنانا

- کوڈ

- تبصروں

- مکمل

- کانفرنس

- ترتیب

- کنکشن

- کنسول

- مواد

- معاون

- بات چیت

- سنوادی

- بات چیت AI

- اسی کے مطابق

- احاطہ

- ڈھکنے

- تخلیق

- بنائی

- تخلیق

- شوقین

- اپنی مرضی کے

- گاہکوں

- اعداد و شمار

- گہری

- گہری سیکھنے

- پہلے سے طے شدہ

- نجات

- منحصر ہے

- تعیناتی

- تعینات

- تعینات

- تعیناتی

- تعینات کرتا ہے

- تفصیل

- ڈیزائن

- مطلوبہ

- تفصیلات

- ڈویلپرز

- مختلف

- براڈ کاسٹننگ

- ڈیجیٹل

- ڈیجیٹل آرٹ

- ظاہر

- تقسیم

- ڈومین

- ڈاؤن لوڈ، اتارنا

- اس سے قبل

- کو کم

- مؤثر طریقے سے

- کو چالو کرنے کے

- آخر

- اختتام پوائنٹ

- بڑھانے کے

- افزودگی

- درج

- انٹرپرائز

- ماحولیات

- بھی

- ہر کوئی

- مثال کے طور پر

- مثال کے طور پر

- امید ہے

- مہنگی

- تجربہ

- تجربہ

- وضاحت کی

- توسیع

- توسیع

- نکالنے

- خاندان

- نمایاں کریں

- چند

- قطعات

- فائل

- فائنل

- مل

- نتائج

- پانچ

- توجہ مرکوز

- پر عمل کریں

- کے بعد

- کے لئے

- فارمیٹ

- فروغ

- فاؤنڈیشن

- بنیاد پرست

- مفت

- دوست

- سے

- مکمل طور پر

- تقریب

- مزید

- مستقبل

- جنرل

- عام معلومات

- پیدا کرنے والے

- پیداواری

- پیداواری AI۔

- حاصل

- فراہم کرتا ہے

- اہداف

- ہے

- he

- مدد

- مدد

- ان

- پکڑو

- ہوسٹنگ

- HOURS

- کس طرح

- کیسے

- HTML

- HTTP

- HTTPS

- انسان

- سینکڑوں

- خیال

- شناختی

- if

- تصاویر

- تخیل

- پر عملدرآمد

- بہتر

- in

- شامل

- اضافہ

- اشارہ کیا

- ان پٹ

- انسٹال

- نصب

- انسٹال کرنا

- مثال کے طور پر

- انسٹی ٹیوٹ

- ہدایات

- ضم

- انضمام

- انٹیلی جنس

- انٹیلجنٹ

- بات چیت

- بات چیت

- بات چیت

- انٹرفیس

- بین الاقوامی سطح پر

- میں

- مدعو

- میں

- سفر

- فوٹو

- صرف

- صرف ایک

- کلیدی

- جان

- علم

- زبان

- بڑے

- شروع

- شروع

- سیکھنے

- لی

- دو

- کی طرح

- لائن

- لاما

- ایل ایل ایم

- مقامی

- منطق

- دیکھو

- کی طرح دیکھو

- سے محبت کرتا ہے

- مشین

- مشین لرننگ

- میں کامیاب

- انداز

- مئی..

- مراد

- میڈیا

- سے ملو

- مینو

- طریقہ

- منتقلی

- ML

- موڈ

- ماڈل

- ماڈل

- جدید خطوط پر استوار

- زیادہ

- ایک سے زیادہ

- ضروری

- نام

- تشریف لے جائیں

- سمت شناسی

- ضروری

- ضرورت ہے

- نیٹ ورک

- عصبی

- عصبی نیٹ ورک

- نئی

- نئی مصنوعات

- نیا

- نوڈ

- Node.js

- براہ مہربانی نوٹ کریں

- نوٹ بک

- حاصل کی

- of

- on

- ایک

- کھول

- اوپن سورس

- آپشنز کے بھی

- or

- دیگر

- نتائج

- پیداوار

- باہر

- مجموعی جائزہ

- خود

- صفحہ

- پین

- کاغذ.

- پیرامیٹر

- پیرامیٹرز

- جذباتی

- اجازتیں

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- رابطہ بحال کرو

- مقبول

- مقبولیت

- پوسٹ

- طاقت

- طریقوں

- کو ترجیح دی

- ضروریات

- استحقاق

- عمل

- حاصل

- پیشہ ورانہ

- منصوبے

- ملکیت

- فراہم

- فراہم

- فراہم کرنے والے

- فراہم کرتا ہے

- عوامی

- شائع

- ازگر

- سوالات

- فوری

- جلدی سے

- بلند

- رینج

- اصلی

- کا حوالہ دیتے ہیں

- حوالہ

- متعلقہ

- درخواست

- درخواستوں

- ضرورت

- تحقیق

- اسی طرح

- وسائل

- جواب

- واپسی

- اضافہ

- رن

- sagemaker

- کی اطمینان

- منظر

- فیرنا

- اسکرین شاٹس

- تلاش کریں

- خفیہ

- سیکشن

- شعبے

- دیکھنا

- منتخب

- احساس

- خدمت

- سروس

- سروسز

- مقرر

- سیٹ

- سیٹ اپ

- سیکنڈ اور

- وہ

- ہونا چاہئے

- دکھائیں

- شوز

- ٹکڑا

- حل

- کچھ

- ماخذ

- خرچ کرنا۔

- مستحکم

- ڈھیر لگانا

- معیار

- اسٹینفورڈ

- شروع کریں

- شروع

- درجہ

- مرحلہ

- مراحل

- ذخیرہ

- سٹوڈیو

- اس طرح

- کافی

- لے لو

- لیتا ہے

- ٹیکنالوجی

- سانچے

- ٹرمنل

- ٹیسٹ

- متن

- متن کی درجہ بندی

- کہ

- ۔

- ان

- تو

- یہ

- وہ

- تیسری پارٹی

- اس

- اگرچہ؟

- کے ذریعے

- وقت

- کرنے کے لئے

- سب سے اوپر

- ٹرین

- تربیت یافتہ

- ٹریننگ

- تبدیل

- تبدیلی

- تبدیل

- قسم

- ui

- کے تحت

- افہام و تفہیم

- URL

- us

- استعمال

- استعمال کی شرائط

- رکن کا

- صارف کا تجربہ

- صارف مواجہ

- صارف دوست

- صارفین

- استعمال

- کا استعمال کرتے ہوئے

- قیمت

- مختلف

- ویڈیوز

- چلنا

- چلتا

- طریقوں

- we

- ویب

- ویب خدمات

- کیا

- جب

- جس

- ڈبلیو

- وسیع

- وسیع رینج

- گے

- چاہتے ہیں

- ساتھ

- کام

- کام کا بہاؤ

- لکھنا

- ہاں

- تم

- اور

- زیفیرنیٹ