بڑے لینگویج ماڈلز (LLMs) کی جسامت اور پیچیدگی پچھلے کچھ سالوں میں پھٹ گئی ہے۔ LLMs نے فطری زبان کے الفاظ کو سیکھنے اور انسانوں کی طرح ردعمل پیدا کرنے میں قابل ذکر صلاحیتوں کا مظاہرہ کیا ہے۔ بہت سے حالیہ LLMs کو ایک طاقتور تکنیک کے ساتھ ٹھیک بنایا گیا ہے جسے کہا جاتا ہے۔ ہدایات ٹیوننگ، جو ماڈل کو نئے کام انجام دینے میں مدد کرتا ہے یا فوری طور پر مخصوص فائن ٹیوننگ کے بغیر نوول پرامپٹس کے جوابات پیدا کرتا ہے۔ انسٹرکشن ٹیونڈ ماڈل متعلقہ کاموں یا تصورات کے بارے میں اپنی سمجھ کو استعمال کرتا ہے تاکہ نئے اشارے پر پیشین گوئیاں پیدا کی جاسکیں۔ چونکہ اس تکنیک میں ماڈل کے وزن کو اپ ڈیٹ کرنا شامل نہیں ہے، اس لیے یہ ایک نئے، پہلے سے نظر نہ آنے والے کام کے لیے ماڈل کو ٹھیک کرنے کے لیے درکار وقت طلب اور حسابی طور پر مہنگے عمل سے بچتا ہے۔

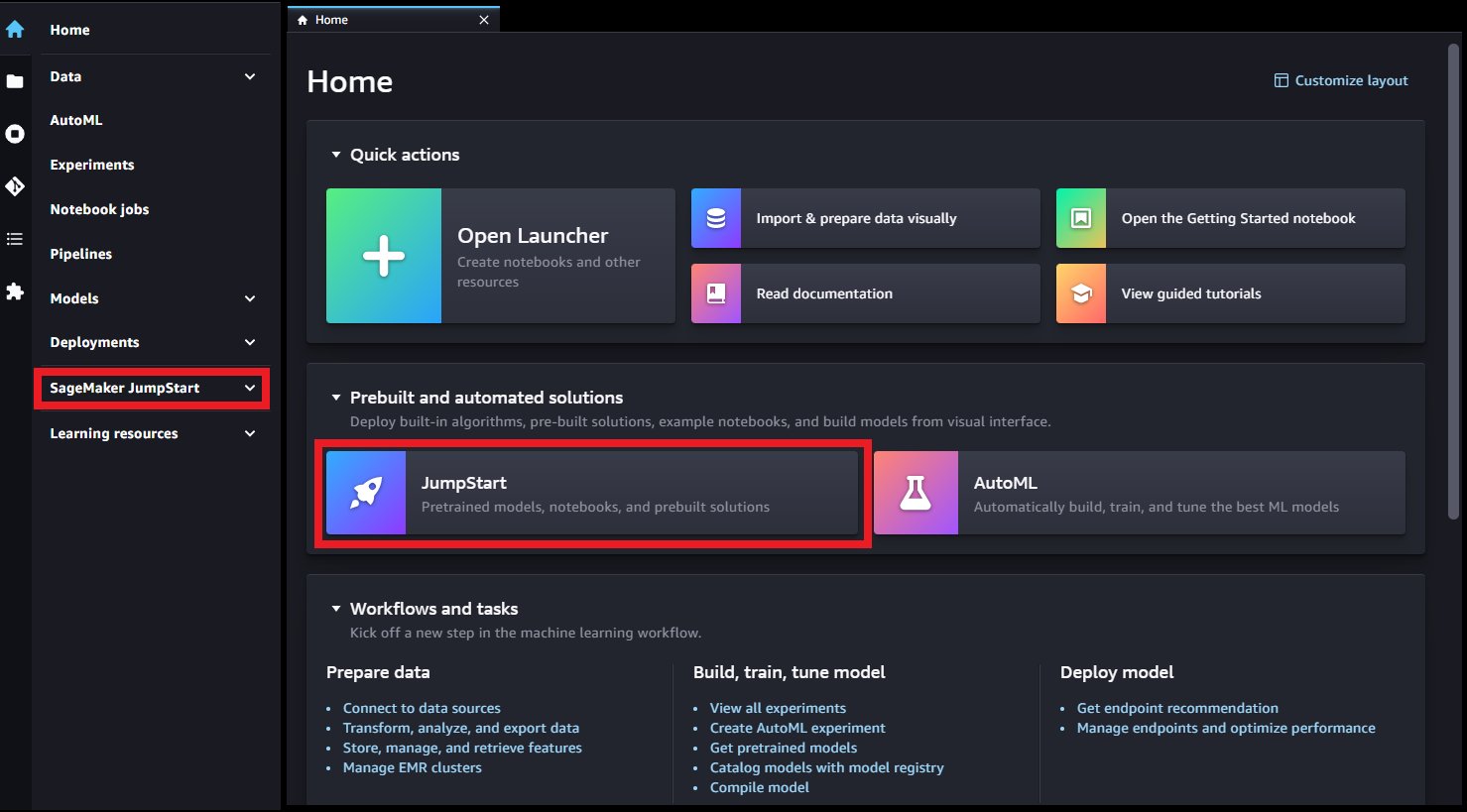

اس پوسٹ میں، ہم دکھاتے ہیں کہ آپ کس طرح سے ہدایات کے مطابق فلان T5 ماڈل تک رسائی اور تعینات کر سکتے ہیں۔ ایمیزون سیج میکر جمپ اسٹارٹ. ہم یہ بھی ظاہر کرتے ہیں کہ آپ مختلف قدرتی لینگویج پروسیسنگ (NLP) کے کاموں کو انجام دینے کے لیے Flan-T5 ماڈلز کے پرامپٹس کو کیسے انجینئر کر سکتے ہیں۔ مزید برآں، ان کاموں کو زیرو شاٹ لرننگ کے ساتھ انجام دیا جا سکتا ہے، جہاں ایک اچھی طرح سے انجینئرڈ پرامپٹ ماڈل کو مطلوبہ نتائج کی طرف رہنمائی کر سکتا ہے۔ مثال کے طور پر، متعدد انتخابی سوال فراہم کرنے پر غور کریں اور ماڈل سے دستیاب انتخاب میں سے مناسب جواب واپس کرنے کو کہیں۔ ہم درج ذیل NLP کاموں کے لیے اشارے کا احاطہ کرتے ہیں:

- متن کا خلاصہ

- عام فہم استدلال

- سوال جواب

- جذبات کی درجہ بندی

- ترجمہ

- ضمیر کی قرارداد

- مضمون پر مبنی ٹیکسٹ جنریشن

- عنوان پر مبنی خیالی مضمون

اس ڈیمو کے تمام مراحل کا کوڈ درج ذیل میں دستیاب ہے۔ نوٹ بک.

JumpStart مشین لرننگ (ML) کا مرکز ہے۔ ایمیزون سیج میکر جو 350 سے زیادہ بلٹ ان الگورتھم تک ایک کلک تک رسائی فراہم کرتا ہے۔ TensorFlow، PyTorch، Hugging Face، اور MXNet سے پہلے سے تربیت یافتہ ماڈلز؛ اور پہلے سے تعمیر شدہ حل ٹیمپلیٹس۔ جمپ سٹارٹ پہلے سے تربیت یافتہ بھی فراہم کرتا ہے۔ بنیاد ماڈل استحکام AI کی طرح مستحکم بازی متن سے تصویری ماڈل، بلوم, Cohere's بنائیں, ایمیزون کا AlexaTM اور زیادہ.

انسٹرکشن ٹیوننگ

انسٹرکشن ٹیوننگ ایک تکنیک ہے جس میں ہدایات کا استعمال کرتے ہوئے NLP کاموں کے مجموعے پر زبان کے ماڈل کو ٹھیک کرنا شامل ہے۔ اس تکنیک میں، ماڈل کو ہر کام کے لیے مخصوص ڈیٹاسیٹس کی بجائے متنی ہدایات پر عمل کرتے ہوئے کام انجام دینے کی تربیت دی جاتی ہے۔ ماڈل کو ہر کام کے لیے ان پٹ اور آؤٹ پٹ مثالوں کے ایک سیٹ کے ساتھ ٹھیک بنایا گیا ہے، جس سے ماڈل کو نئے کاموں کو عام کرنے کی اجازت ملتی ہے جن کے بارے میں واضح طور پر تربیت نہیں دی گئی ہے جب تک کہ کاموں کے لیے اشارے فراہم کیے جائیں۔ انسٹرکشن ٹیوننگ ماڈلز کی درستگی اور تاثیر کو بہتر بنانے میں مدد کرتی ہے اور ایسے حالات میں مددگار ہوتی ہے جہاں مخصوص کاموں کے لیے بڑے ڈیٹا سیٹس دستیاب نہیں ہوتے ہیں۔

مختلف کاموں، ٹیمپلیٹس اور طریقوں کا ایک مجموعہ تیار کرتے ہوئے، 2020 سے انسٹرکشن ٹیوننگ ریسرچ کا ایک ہزارہا کام انجام دیا گیا ہے۔ انسٹرکشن ٹیوننگ کے سب سے نمایاں طریقوں میں سے ایک، فنی ٹیوننگ زبان کے ماڈل (Flan)، ان عوامی طور پر دستیاب مجموعوں کو ایک Flan مجموعہ میں جمع کرتا ہے تاکہ مختلف قسم کی ہدایات پر ٹھیک ٹیونڈ ماڈل تیار کیے جا سکیں۔ اس طرح، ملٹی ٹاسک فلان ماڈلز انہی ماڈلز کے ساتھ مسابقتی ہیں جو ہر ایک مخصوص کام پر آزادانہ طور پر ٹھیک بنائے گئے ہیں اور تربیت کے دوران دیکھی گئی مخصوص ہدایات سے ہٹ کر عمومی طور پر مندرجہ ذیل ہدایات کو عام کر سکتے ہیں۔

زیرو شاٹ لرننگ

زیرو شاٹ لرننگ NLP میں پہلے سے تربیت یافتہ LLM کو ان کاموں کے جوابات پیدا کرنے کی اجازت دیتا ہے جن کے لیے اسے خاص طور پر تربیت نہیں دی گئی ہے۔ اس تکنیک میں، ماڈل کو ایک ان پٹ ٹیکسٹ اور ایک پرامپٹ فراہم کیا جاتا ہے جو قدرتی زبان میں ماڈل سے متوقع آؤٹ پٹ کو بیان کرتا ہے۔ پہلے سے تربیت یافتہ ماڈل اپنے علم کو مربوط اور متعلقہ ردعمل پیدا کرنے کے لیے استعمال کر سکتے ہیں یہاں تک کہ ان اشارے کے لیے بھی جن پر اسے خاص طور پر تربیت نہیں دی گئی ہے۔ زیرو شاٹ لرننگ NLP کاموں کی کارکردگی اور درستگی کو بہتر بناتے ہوئے درکار وقت اور ڈیٹا کو کم کر سکتی ہے۔ زیرو شاٹ لرننگ کا استعمال NLP کے مختلف کاموں میں کیا جاتا ہے، جیسے سوال کے جوابات، خلاصہ، اور ٹیکسٹ جنریشن۔

چند شاٹ سیکھنے صرف چند مثالیں فراہم کر کے نئے کاموں کو انجام دینے کے لیے ایک ماڈل کو تربیت دینا شامل ہے۔ یہ مفید ہے جہاں تربیت کے لیے محدود لیبل والا ڈیٹا دستیاب ہو۔ اگرچہ یہ پوسٹ بنیادی طور پر زیرو شاٹ لرننگ پر مرکوز ہے، حوالہ شدہ ماڈلز چند شاٹ لرننگ پرامپٹس پر ردعمل پیدا کرنے کے قابل بھی ہیں۔

Flan-T5 ماڈل

ایک مقبول انکوڈر-ڈیکوڈر ماڈل کے نام سے جانا جاتا ہے۔ T5 (ٹیکسٹ ٹو ٹیکسٹ ٹرانسفر ٹرانسفارمر) ایک ایسا ماڈل ہے جسے بعد میں فلان طریقہ کے ذریعے ٹھیک بنایا گیا فلان-ٹی5 ماڈلز کا خاندان Flan-T5 ایک انسٹرکشن ٹیونڈ ماڈل ہے اور اس وجہ سے مختلف زیرو شاٹ NLP ٹاسکس کے ساتھ ساتھ سیاق و سباق میں سیکھنے کے چند شاٹ ٹاسکس کرنے کی اہلیت رکھتا ہے۔ مناسب اشارے کے ساتھ، یہ زیرو شاٹ NLP کام انجام دے سکتا ہے جیسے کہ متن کا خلاصہ، عام فہم استدلال، فطری زبان کا اندازہ، سوال کا جواب، جملے اور جذبات کی درجہ بندی، ترجمہ، اور ضمیر حل۔ اس پوسٹ میں فراہم کردہ مثالیں Flan-T5 فیملی کے ساتھ تیار کی گئی ہیں۔

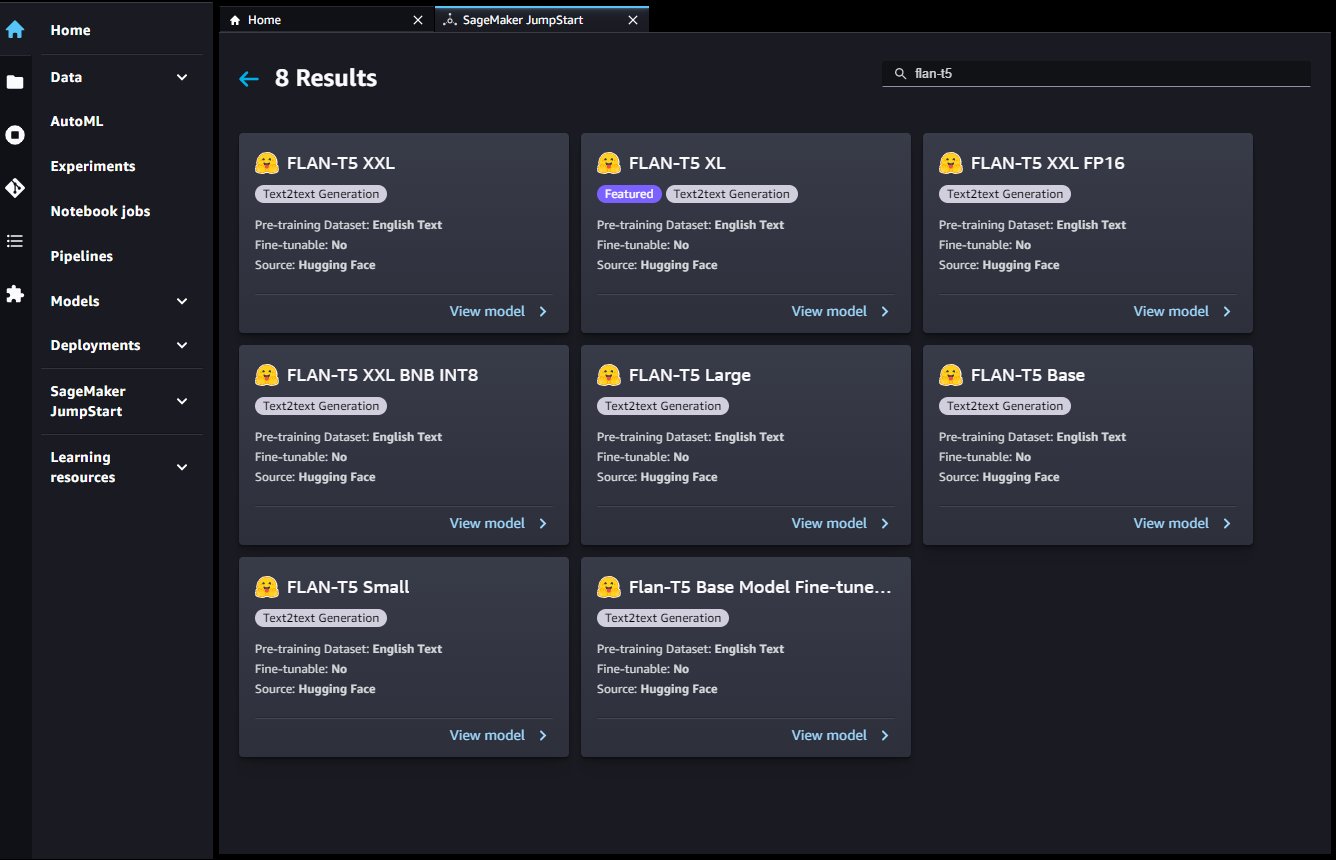

جمپ سٹارٹ اس ماڈل فیملی کے ذریعے آسان تعیناتی فراہم کرتا ہے۔ ایمیزون سیج میکر اسٹوڈیو اور SageMaker SDK۔ اس میں Flan-T5 Small، Flan-T5 Base، Flan-T5 Large، Flan-T5 XL، اور Flan-T5 XXL شامل ہیں۔ مزید برآں، جمپ سٹارٹ کوانٹائزیشن کی مختلف سطحوں پر Flan-T5 XXL کے تین ورژن فراہم کرتا ہے:

- Flan-T5 XXL - مکمل ماڈل، سنگل پریسجن فلوٹنگ پوائنٹ فارمیٹ (FP32) میں بھرا ہوا ہے۔

- Flan-T5 XXL FP16 - مکمل ماڈل کا آدھا درست فلوٹنگ پوائنٹ فارمیٹ (FP16) ورژن۔ یہ نفاذ کم GPU میموری استعمال کرتا ہے اور FP32 ورژن کے مقابلے میں تیز تر اندازہ لگاتا ہے۔

- Flan-T5 XXL BNB INT8 - مکمل ماڈل کا ایک 8 بٹ کوانٹائزڈ ورژن، GPU سیاق و سباق پر بھری ہوئی

accelerateاورbitsandbytesلائبریریاں یہ نفاذ اس LLM کو کم کمپیوٹ والے مثالوں پر رسائی فراہم کرتا ہے، جیسے سنگل-GPU ml.g5.xlarge مثال۔

Flan-T5 ماڈلز پر زیرو شاٹ NLP کاموں کے لیے فوری انجینئرنگ

فوری انجینئرنگ مطلوبہ جوابات کی طرف ماڈل کی رہنمائی کے لیے اعلیٰ معیار کے پرامپٹس بنانے سے متعلق ہے۔ مخصوص کام اور استعمال کیے جانے والے ڈیٹاسیٹ کی بنیاد پر پرامپٹس کو ڈیزائن کرنے کی ضرورت ہے۔ یہاں مقصد یہ ہے کہ ماڈل کو ضروری معلومات فراہم کی جائیں تاکہ شور کو کم کرتے ہوئے اعلیٰ معیار کے جوابات پیدا ہوں۔ اس میں مطلوبہ الفاظ، اضافی سیاق و سباق، سوالات اور بہت کچھ شامل ہو سکتا ہے۔ مثال کے طور پر، درج ذیل کوڈ دیکھیں:

ایک اچھی طرح سے ڈیزائن کیا گیا پرامپٹ ماڈل کو زیادہ تخلیقی اور عمومی بنا سکتا ہے تاکہ یہ آسانی سے نئے کاموں کے مطابق ڈھال سکے۔ اشارے مخصوص کاموں پر ڈومین کے علم کو شامل کرنے اور تشریح کو بہتر بنانے میں بھی مدد کر سکتے ہیں۔ فوری انجینئرنگ زیرو شاٹ اور چند شاٹ لرننگ ماڈلز کی کارکردگی کو بہت بہتر بنا سکتی ہے۔ اعلیٰ معیار کے پرامپٹس بنانے کے لیے ہاتھ میں کام کے بارے میں احتیاط سے غور کرنے کے ساتھ ساتھ ماڈل کی طاقتوں اور حدود کی گہری سمجھ کی ضرورت ہوتی ہے۔

فراہم کردہ میں مثال کے طور پر نوٹ بک، ہر کام کم از کم سات فوری ٹیمپلیٹس اور ماڈل آؤٹ پٹ کو کنٹرول کرنے کے لیے پیرامیٹرز کا ایک جامع سیٹ ظاہر کرتا ہے، جیسے زیادہ سے زیادہ ترتیب کی لمبائی، واپسی کی ترتیب کی تعداد، اور بیم کی تعداد۔ اس کے علاوہ، استعمال کیے جانے والے پرامپٹ ٹیمپلیٹس سے ہیں۔ Flan T5 GitHub ذخیرہ، جو فلان کلیکشن میں استعمال ہونے والے بہت سے ٹیمپلیٹس پر مشتمل ہے۔ ٹیمپلیٹس کا یہ مجموعہ اس وقت دریافت کرنے میں مددگار ہوتا ہے جب آپ خود اپنی فوری انجینئرنگ کرتے ہیں۔

مندرجہ ذیل جدول میں، Flan-T5 XXL ماڈل مختلف زیرو شاٹ NLP کاموں کے لیے ردعمل پیدا کرنے کے لیے استعمال کیا جاتا ہے۔ پہلا کالم ٹاسک دکھاتا ہے، دوسرے کالم میں ماڈل کو فراہم کردہ پرامپٹ ہوتا ہے (جہاں ٹیمپلیٹ کا متن بولڈ ہوتا ہے اور غیر بولڈ ٹیکسٹ مثال کے طور پر ان پٹ ہوتا ہے) اور تیسرا کالم ماڈل کی طرف سے جواب ہوتا ہے جب اس کے خلاف استفسار کیا جاتا ہے۔ فوری طور پر.

مثال کے طور پر خلاصہ کا کام لیں: ماڈل پرامپٹ بنانے کے لیے، آپ ٹیمپلیٹ کو جوڑ سکتے ہیں Briefly summarize this paragraph: متن کی مثال کے ساتھ جس کا آپ خلاصہ کرنا چاہتے ہیں۔ اس جدول کے تمام کاموں میں ایک ہی پے لوڈ پیرامیٹرز کا استعمال کیا گیا: max_length=150 جوابی ٹوکن کی تعداد پر بالائی حد فراہم کرنے کے لیے، no_repeat_ngram_size=5 n-gram تکرار کی حوصلہ شکنی کرنا، اور do_sample=False دہرانے کے لیے نمونے لینے کو غیر فعال کرنا۔ بعد میں مزید تفصیل سے اختتامی نقطہ سے استفسار کرتے وقت ہم دستیاب پے لوڈ پیرامیٹر کے اختیارات پر تبادلہ خیال کرتے ہیں۔

| ٹاسک | پرامپٹ (سانچہ بولڈ میں) | ماڈل آؤٹ پٹ |

| خلاصہ | اس پیراگراف کو مختصراً بیان کریں: Amazon Comprehend دستاویزات کے مواد کے بارے میں بصیرت نکالنے کے لیے قدرتی زبان کی پروسیسنگ (NLP) کا استعمال کرتا ہے۔ یہ دستاویز میں موجود ہستیوں، کلیدی فقروں، زبان، جذبات اور دیگر عام عناصر کو پہچان کر بصیرت پیدا کرتا ہے۔ دستاویزات کی ساخت کو سمجھنے کی بنیاد پر نئی مصنوعات بنانے کے لیے Amazon Comprehend کا استعمال کریں۔ مثال کے طور پر، Amazon Comprehend کا استعمال کرتے ہوئے آپ پروڈکٹس کے تذکرے کے لیے سوشل نیٹ ورکنگ فیڈز تلاش کر سکتے ہیں یا کلیدی فقروں کے لیے پوری دستاویز کے ذخیرے کو اسکین کر سکتے ہیں۔ آپ Amazon Comprehend کنسول یا Amazon Comprehend APIs کا استعمال کرتے ہوئے Amazon Comprehend دستاویز کے تجزیہ کی صلاحیتوں تک رسائی حاصل کر سکتے ہیں۔ آپ چھوٹے کام کے بوجھ کے لیے حقیقی وقت کا تجزیہ چلا سکتے ہیں یا آپ بڑے دستاویزی سیٹوں کے لیے غیر مطابقت پذیر تجزیہ جابز شروع کر سکتے ہیں۔ آپ پہلے سے تربیت یافتہ ماڈلز استعمال کر سکتے ہیں جو Amazon Comprehend فراہم کرتا ہے، یا آپ درجہ بندی اور ہستی کی شناخت کے لیے اپنے حسب ضرورت ماڈلز کو تربیت دے سکتے ہیں۔ Amazon Comprehend کی تمام خصوصیات UTF-8 ٹیکسٹ دستاویزات کو بطور ان پٹ قبول کرتی ہیں۔ اس کے علاوہ، حسب ضرورت درجہ بندی اور حسب ضرورت ہستی کی شناخت تصویری فائلوں، پی ڈی ایف فائلوں، اور ورڈ فائلوں کو بطور ان پٹ قبول کرتی ہے۔ Amazon Comprehend مخصوص خصوصیت کے لحاظ سے مختلف زبانوں میں دستاویزات کی جانچ اور تجزیہ کر سکتا ہے۔ مزید معلومات کے لیے، Amazon Comprehend میں تعاون یافتہ زبانیں دیکھیں۔ Amazon Comprehend کی زبان کی غالب صلاحیت دستاویزات کی جانچ کر سکتی ہے اور زبانوں کے بہت وسیع انتخاب کے لیے غالب زبان کا تعین کر سکتی ہے۔ |

Amazon Comprehend کی صلاحیتوں کو سمجھیں۔ |

| عام فہم استدلال یا فطری زبان کا استدلال | امریکہ کے شہر لاس اینجلس میں ورلڈ کپ کا آغاز ہو گیا ہے۔مندرجہ بالا پیراگراف کی بنیاد پر کیا ہم یہ نتیجہ اخذ کر سکتے ہیں کہ "ورلڈ کپ امریکہ میں ہو رہا ہے۔"؟nn["ہاں"، "نہیں"] | جی ہاں |

| سوال کا جواب |

سیاق و سباق کی بنیاد پر جواب: nnتازہ ترین اور جدید ترین Kindle ابھی تک آپ کو لاکھوں کتابوں اور دستاویزات پر نوٹ لینے، فہرستیں اور جرائد لکھنے اور مزید بہت کچھ کرنے دیتی ہے۔ ان قارئین کے لیے جو ہمیشہ چاہتے ہیں کہ وہ اپنی ای بکس میں لکھ سکیں، ایمیزون کا نیا کنڈل انہیں ایسا کرنے دیتا ہے۔ Kindle Scribe پڑھنے اور لکھنے کے لیے پہلا Kindle ہے اور صارفین کو اپنی کتابوں اور دستاویزات کو نوٹوں، فہرستوں اور مزید کے ساتھ اضافی کرنے کی اجازت دیتا ہے۔ یہاں وہ سب کچھ ہے جو آپ کو Kindle Scribe کے بارے میں جاننے کی ضرورت ہے، بشمول اکثر پوچھے جانے والے سوالات۔ Kindle Scribe پڑھنا اور لکھنا آسان بناتا ہے جیسا کہ آپ کاغذ پر لکھتے ہیں۔ Kindle Scribe میں 10.2 انچ، چکاچوند سے پاک اسکرین (تمام کنڈل ڈیوائسز میں سب سے بڑی)، کرکرا 300 ppi ریزولوشن، اور 35 LED فرنٹ لائٹس شامل ہیں جو خود بخود آپ کے ماحول کے مطابق ہوجاتی ہیں۔ ایڈجسٹ گرم روشنی، فونٹ کے سائز، لائن کی جگہ، اور مزید کے ساتھ اپنے تجربے کو مزید ذاتی بنائیں۔ یہ آپ کے بنیادی قلم یا پریمیم قلم کے انتخاب کے ساتھ آتا ہے، جسے آپ اسکرین پر لکھنے کے لیے استعمال کرتے ہیں جیسے آپ کاغذ پر لکھتے ہیں۔ وہ مقناطیسی طور پر آپ کے کنڈل سے بھی منسلک ہوتے ہیں اور انہیں کبھی بھی چارج کرنے کی ضرورت نہیں ہوتی ہے۔ پریمیم قلم میں ایک وقف شدہ صافی اور حسب ضرورت شارٹ کٹ بٹن شامل ہے۔ Kindle Scribe کے پاس تمام Kindle ڈیوائسز کے سب سے زیادہ سٹوریج کے اختیارات ہیں: آپ کے پڑھنے اور لکھنے کی سطح کے مطابق 8 GB، 16 GB، یا 32 GB میں سے انتخاب کریں۔nnنئے Kindle کی اہم خصوصیات کیا ہیں؟ |

10.2 انچ، چکاچوند سے پاک اسکرین |

| جملے یا جذبات کی درجہ بندی | جائزہ: اینیہ حرکت بہت عمدہ ہے اور ایک بار پھر ہمیں حیران اور خوش کرتی ہے۔n کیا یہ فلم کا جائزہ لینے والا جملہ منفی ہے یا مثبت؟اختیارات:n-مثبت این-منفی | مثبت |

| ترجمہ | میرا نام آرتھر ہے۔nn میں ترجمہ کریں۔ جرمن | میرا نام آرتھر ہے۔ |

| ضمیر کی قرارداد | ایلن نے ایک مضحکہ خیز لطیفہ سنانے پر اپنے دوست زین کو ہنسایا۔nnکون ہے۔ he کا حوالہ دیتے ہوئے؟(A)ایلن (B)Xin | ایلن |

| ایک مضمون پر مبنی عنوان کی نسل |

تازہ ترین اور جدید ترین Kindle ابھی تک آپ کو لاکھوں کتابوں اور دستاویزات پر نوٹ لینے، فہرستیں اور جرائد لکھنے اور مزید بہت کچھ کرنے دیتی ہے۔ ان قارئین کے لیے جو ہمیشہ چاہتے ہیں کہ وہ اپنی ای بکس میں لکھ سکیں، ایمیزون کا نیا کنڈل انہیں ایسا کرنے دیتا ہے۔ Kindle Scribe پڑھنے اور لکھنے کے لیے پہلا Kindle ہے اور صارفین کو اپنی کتابوں اور دستاویزات کو نوٹوں، فہرستوں اور مزید کے ساتھ اضافی کرنے کی اجازت دیتا ہے۔ یہاں وہ سب کچھ ہے جو آپ کو Kindle Scribe کے بارے میں جاننے کی ضرورت ہے، بشمول اکثر پوچھے جانے والے سوالات۔ Kindle Scribe پڑھنا اور لکھنا آسان بناتا ہے جیسا کہ آپ کاغذ پر لکھتے ہیں۔ Kindle Scribe میں 10.2 انچ، چکاچوند سے پاک اسکرین (تمام کنڈل ڈیوائسز میں سب سے بڑی)، کرکرا 300 ppi ریزولوشن، اور 35 LED فرنٹ لائٹس شامل ہیں جو خود بخود آپ کے ماحول کے مطابق ہوجاتی ہیں۔ ایڈجسٹ گرم روشنی، فونٹ کے سائز، لائن کی جگہ، اور مزید کے ساتھ اپنے تجربے کو مزید ذاتی بنائیں۔ یہ آپ کے بنیادی قلم یا پریمیم قلم کے انتخاب کے ساتھ آتا ہے، جسے آپ اسکرین پر لکھنے کے لیے استعمال کرتے ہیں جیسے آپ کاغذ پر لکھتے ہیں۔ وہ مقناطیسی طور پر آپ کے کنڈل سے بھی منسلک ہوتے ہیں اور انہیں کبھی بھی چارج کرنے کی ضرورت نہیں ہوتی ہے۔ پریمیم قلم میں ایک وقف شدہ صافی اور حسب ضرورت شارٹ کٹ بٹن شامل ہے۔ Kindle Scribe کے پاس تمام Kindle ڈیوائسز کے سب سے زیادہ سٹوریج کے اختیارات ہیں: آپ کے پڑھنے اور لکھنے کی سطح کے مطابق 8 GB، 16 GB، یا 32 GB میں سے انتخاب کریں۔ مجھے اوپر کے مضمون کے لیے ایک اچھا عنوان دیں۔. |

ہر وہ چیز جو آپ کو نئی کنڈل سکرائب کے بارے میں جاننے کی ضرورت ہے۔ |

| ایک عنوان پر مبنی خیالی مضمون کی تخلیق | عنوان:”یونیورسٹی میں نئی سہولت آ رہی ہے۔"\nایک خیالی مضمون کے اوپر دیئے گئے عنوان کو دیکھتے ہوئے، مضمون کا تصور کریں۔ | یونیورسٹی آف فلپائن (UP) اپنے کالج آف میڈیسن اینڈ ہیلتھ سائنسز (CMHS) کے لیے بیکولڈ شہر میں یونیورسٹی آف سینٹو ٹامس (یو ایس ٹی) کے کیمپس میں ایک نئی عمارت تعمیر کرنے کے لیے تیار ہے۔ سی ایم ایچ ایس کی عمارت، جو یو ایس ٹی کیمپس میں واقع ہوگی، یو ایس ٹی کیمپس میں یونیورسٹی کی جانب سے تعمیر کی جانے والی پہلی عمارت ہوگی۔ یو پی کے نائب صدر برائے انتظامیہ اور مالیات ڈاکٹر جوز ایل الکالا کے مطابق، سی ایم ایم ایس کی عمارت ملک میں اپنی نوعیت کی پہلی عمارت ہوگی۔ CMMH عمارت UST میں یوپی کی طرف سے تعمیر کردہ دوسری عمارت ہوگی۔ پہلی عمارت، جو 2008 میں مکمل ہوئی، یوپی ہے۔ |

SageMaker میں Flan-T5 انسٹرکشن ٹیونڈ ماڈلز تک رسائی حاصل کریں۔

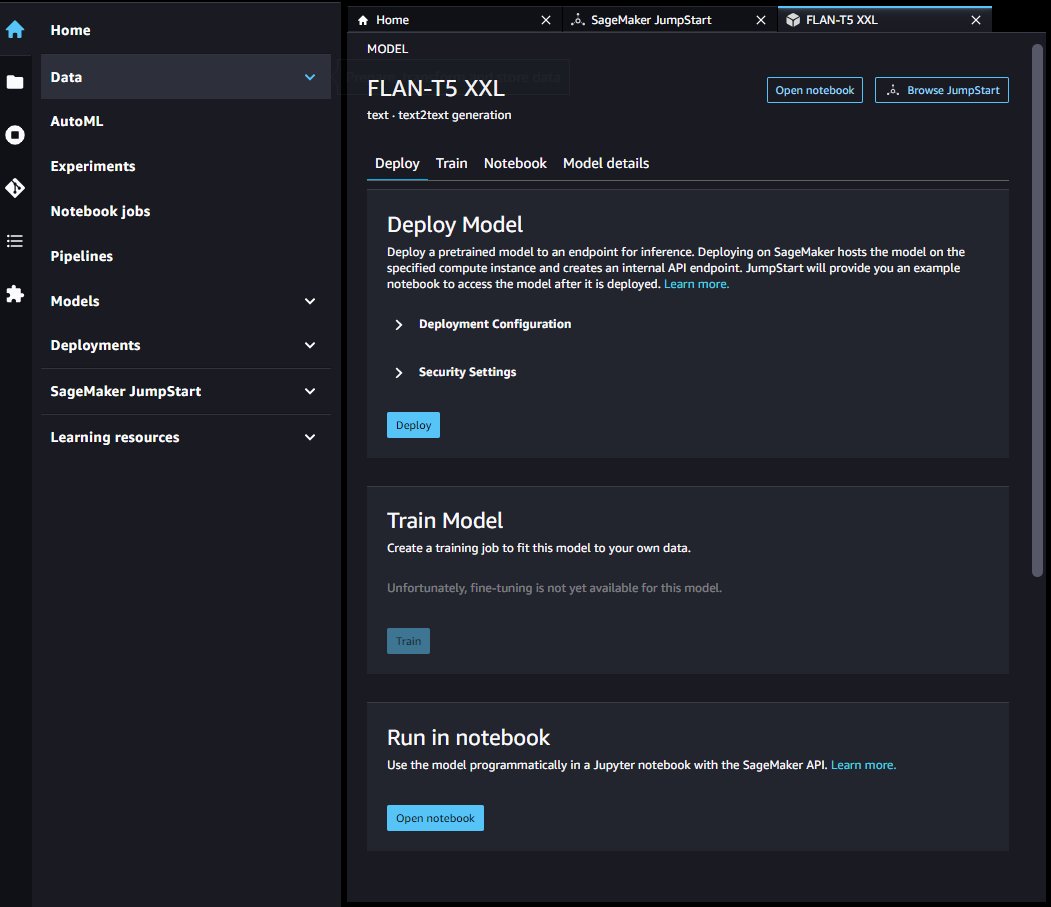

JumpStart ان ہدایات پر مبنی فلان ماڈلز کا استعمال شروع کرنے کے لیے تین راستے فراہم کرتا ہے: جمپ اسٹارٹ فاؤنڈیشن ماڈل، اسٹوڈیو، اور سیج میکر SDK۔ مندرجہ ذیل حصے اس بات کی وضاحت کرتے ہیں کہ ان میں سے ہر ایک راستہ کیسا نظر آتا ہے اور ان تک رسائی کا طریقہ بیان کرتے ہیں۔

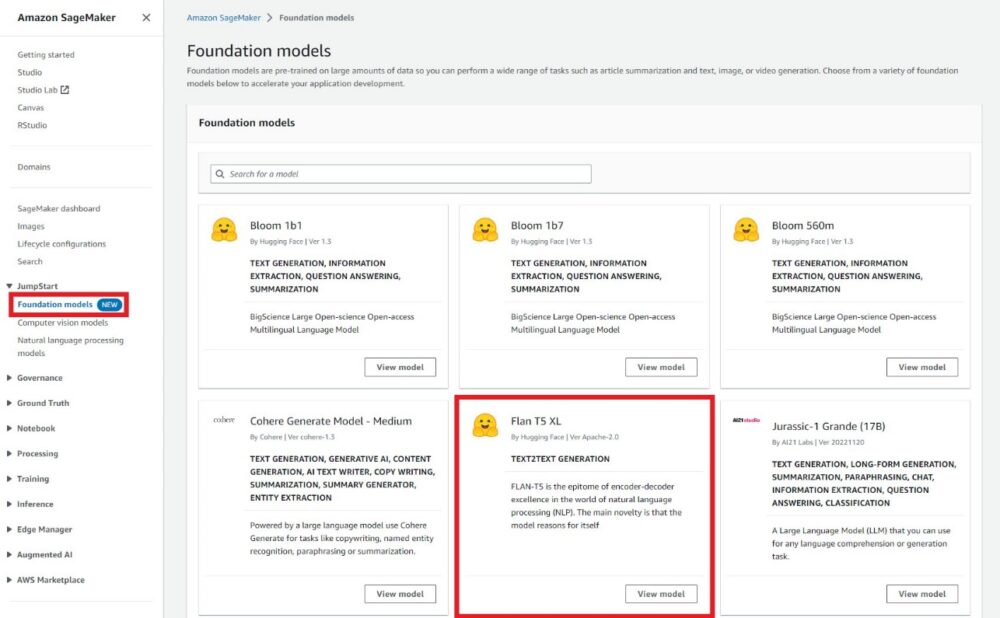

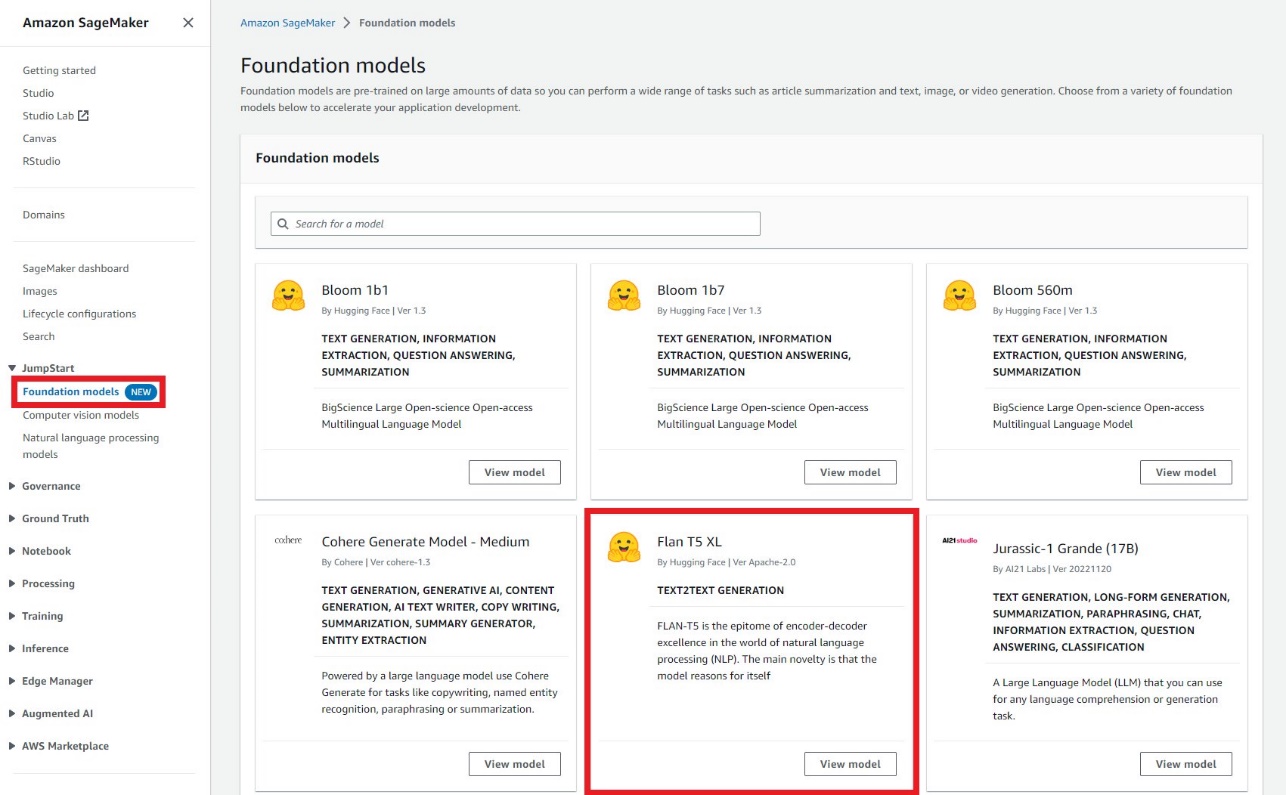

جمپ اسٹارٹ فاؤنڈیشن ماڈل

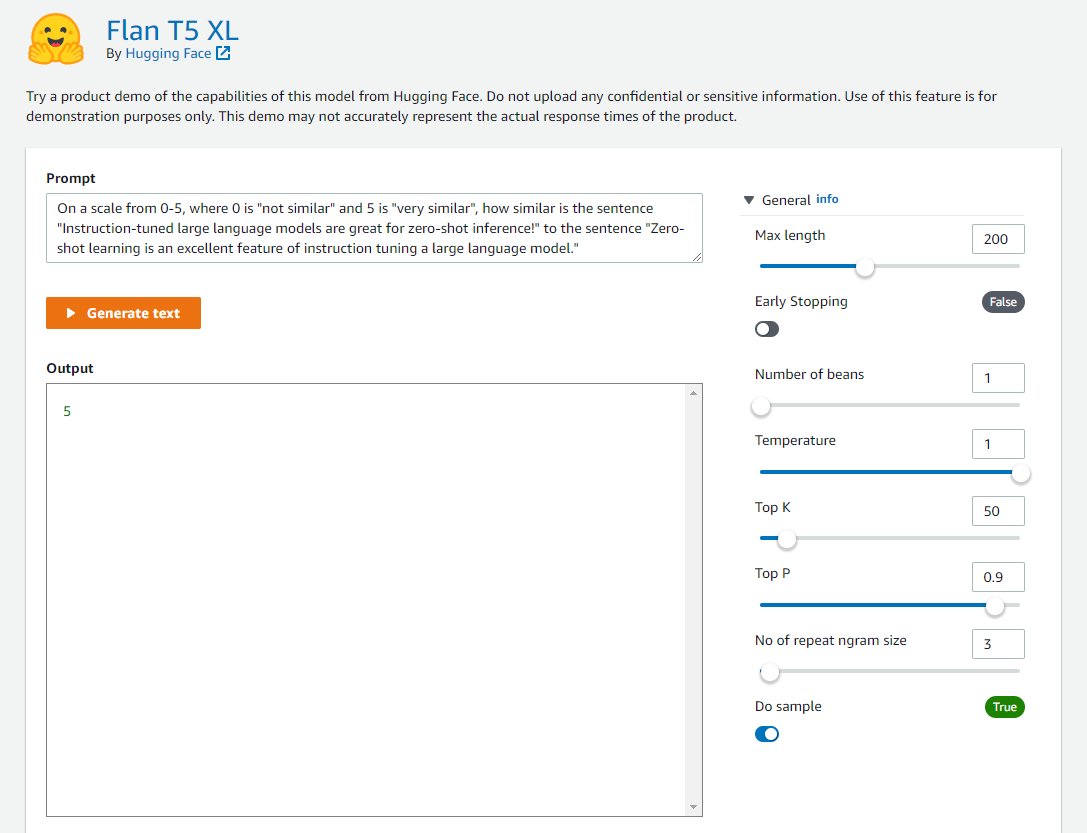

ڈویلپرز کا بصری انٹرفیس استعمال کر سکتے ہیں۔ جمپ اسٹارٹ فاؤنڈیشن ماڈل، کوڈ کی ایک لائن لکھے بغیر ہدایات کے مطابق فلان ماڈلز کو جانچنے کے لیے، SageMaker کنسول کے ذریعے رسائی حاصل کی گئی۔ یہ پلے گراؤنڈ ایک ان پٹ پرامپٹ ٹیکسٹ باکس فراہم کرتا ہے جس کے ساتھ مختلف پیرامیٹرز کے لیے کنٹرولز استعمال ہوتے ہیں جو انفرنس کے دوران استعمال ہوتے ہیں۔ یہ فیچر فی الحال گیٹڈ پیش نظارہ میں ہے، اور آپ دیکھیں گے۔ رسائی کی درخواست کریں اگر آپ کے پاس رسائی نہیں ہے تو ماڈل کے بجائے بٹن۔ جیسا کہ درج ذیل اسکرین شاٹس میں دیکھا گیا ہے، آپ SageMaker کنسول کے نیویگیشن پین میں فاؤنڈیشن ماڈلز تک رسائی حاصل کر سکتے ہیں۔ منتخب کریں۔ ماڈل دیکھیں یوزر انٹرفیس تک رسائی کے لیے Flan-T5 XL ماڈل کارڈ پر۔

آپ ماڈل کا ڈیمو آزمانے کے لیے اس لچکدار یوزر انٹرفیس کا استعمال کر سکتے ہیں۔

سیج میکر اسٹوڈیو

آپ ان ماڈلز تک کے ذریعے بھی رسائی حاصل کر سکتے ہیں۔ جمپ اسٹارٹ لینڈنگ پیج سٹوڈیو میں اس صفحہ میں دستیاب اینڈ ٹو اینڈ ایم ایل سلوشنز، پہلے سے تربیت یافتہ ماڈلز، اور مثالی نوٹ بک کی فہرست دی گئی ہے۔

آپ یوزر انٹرفیس کے ذریعے ماڈل اینڈ پوائنٹ کو تعینات کرنے کے لیے Flan-T5 ماڈل کارڈ کا انتخاب کر سکتے ہیں۔

آپ کا اختتامی نقطہ کامیابی کے ساتھ لانچ ہونے کے بعد، آپ ایک مثال Jupyter نوٹ بک لانچ کر سکتے ہیں جو یہ ظاہر کرتی ہے کہ اس اختتامی نقطہ سے استفسار کیسے کیا جائے۔

SageMaker Python SDK

آخر میں، آپ SageMaker SDK کے ذریعے پروگرام کے مطابق ایک اختتامی نقطہ تعینات کر سکتے ہیں۔ آپ کو SageMaker ماڈل ہب میں اپنے مطلوبہ ماڈل کی ماڈل ID اور تعیناتی کے لیے استعمال ہونے والی مثال کی قسم بتانے کی ضرورت ہوگی۔ ماڈل URI، جس میں inference اسکرپٹ ہوتا ہے، اور Docker کنٹینر کا URI SageMaker SDK کے ذریعے حاصل کیا جاتا ہے۔ یہ URIs جمپ سٹارٹ کے ذریعہ فراہم کیے گئے ہیں اور تعیناتی کے لیے SageMaker ماڈل آبجیکٹ کو شروع کرنے کے لیے استعمال کیا جا سکتا ہے۔ درج ذیل کوڈ دیکھیں:

اب جب کہ اختتامی نقطہ تعینات کیا گیا ہے، آپ تیار کردہ متن تیار کرنے کے لیے اختتامی نقطہ سے استفسار کر سکتے ہیں۔ مثال کے طور پر خلاصہ کے کام پر غور کریں، جہاں آپ درج ذیل متن کا خلاصہ پیش کرنا چاہتے ہیں:

اختتامی نقطہ کی درخواست کرتے وقت آپ کو یہ متن JSON پے لوڈ کے اندر فراہم کرنا چاہیے۔ اس JSON پے لوڈ میں کوئی بھی مطلوبہ انفرنس پیرامیٹرز شامل ہو سکتے ہیں جو لمبائی، نمونے لینے کی حکمت عملی، اور آؤٹ پٹ ٹوکن ترتیب کی پابندیوں کو کنٹرول کرنے میں مدد کرتے ہیں۔ جبکہ ٹرانسفارمرز لائبریری کی مکمل فہرست بیان کرتی ہے۔ دستیاب پے لوڈ پیرامیٹرز، بہت سے اہم پے لوڈ پیرامیٹرز کی وضاحت اس طرح کی گئی ہے:

- زیادہ سے زیادہ طوالت - ماڈل اس وقت تک متن تیار کرتا ہے جب تک کہ آؤٹ پٹ کی لمبائی (جس میں ان پٹ سیاق و سباق کی لمبائی شامل ہے) تک نہ پہنچ جائے۔

max_length. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - num_return_sequences - واپس آنے والے آؤٹ پٹ سیکونسز کی تعداد۔ اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔

- num_beams - لالچی تلاش میں استعمال ہونے والے شہتیروں کی تعداد۔ اگر متعین کیا جائے تو یہ اس سے بڑا یا اس کے برابر کا عدد ہونا چاہیے۔

num_return_sequences. - no_repeat_ngram_size - ماڈل اس بات کو یقینی بناتا ہے کہ الفاظ کی ترتیب

no_repeat_ngram_sizeآؤٹ پٹ ترتیب میں دہرایا نہیں جاتا ہے۔ اگر بیان کیا جائے تو یہ 1 سے بڑا مثبت عدد ہونا چاہیے۔ - درجہ حرارت - آؤٹ پٹ میں بے ترتیب پن کو کنٹرول کرتا ہے۔ زیادہ درجہ حرارت کے نتیجے میں کم امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب ہوتی ہے، اور کم درجہ حرارت کے نتیجے میں زیادہ امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب ہوتی ہے۔ اگر

temperature0 کے برابر ہے، اس کے نتیجے میں لالچی ضابطہ کشائی ہوتی ہے۔ اگر بیان کیا گیا ہے، تو یہ ایک مثبت فلوٹ ہونا چاہیے۔ - جلدی_روکنا - اگر

Trueجب تمام بیم مفروضے سٹینس ٹوکن کے اختتام پر پہنچ جاتے ہیں تو ٹیکسٹ جنریشن ختم ہو جاتی ہے۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - do_sample - اگر

True، امکان کے مطابق اگلے لفظ کا نمونہ۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - top_k - ٹیکسٹ جنریشن کے ہر مرحلے میں، صرف سے نمونہ

top_kسب سے زیادہ امکان الفاظ. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - ٹاپ_پی - ٹیکسٹ جنریشن کے ہر مرحلے میں، مجموعی امکان کے ساتھ الفاظ کے سب سے چھوٹے ممکنہ سیٹ سے نمونہ لیں۔

top_p. اگر بیان کیا گیا ہے، تو یہ 0-1 کے درمیان فلوٹ ہونا چاہیے۔ - بیج - تولیدی صلاحیت کے لیے بے ترتیب حالت کو درست کریں۔ اگر بیان کیا جائے تو یہ ایک عدد صحیح ہونا چاہیے۔

ہم ان پیرامیٹرز کے کسی بھی ذیلی سیٹ کی وضاحت کر سکتے ہیں جب کہ اختتامی نقطہ کی درخواست کریں۔ اگلا، ہم ایک مثال دکھاتے ہیں کہ ان دلائل کے ساتھ اختتامی نقطہ کو کیسے پکارا جائے:

یہ کوڈ بلاک ایک آؤٹ پٹ تسلسل کا نمونہ تیار کرتا ہے جو درج ذیل متن سے ملتا ہے۔

صاف کرو

جاری چارجز سے بچنے کے لیے، SageMaker انفرنس اینڈ پوائنٹس کو حذف کریں۔ آپ SageMaker کنسول کے ذریعے یا اسٹوڈیو نوٹ بک سے درج ذیل کمانڈز کا استعمال کرتے ہوئے اختتامی نکات کو حذف کر سکتے ہیں۔

نتیجہ

اس پوسٹ میں، ہم نے زیرو شاٹ لرننگ کے فوائد کا ایک جائزہ پیش کیا اور بتایا کہ کس طرح فوری انجینئرنگ انسٹرکشن ٹیونڈ ماڈلز کی کارکردگی کو بہتر بنا سکتی ہے۔ ہم نے یہ بھی دکھایا کہ جمپ اسٹارٹ سے ہدایات کے مطابق فلان T5 ماڈل کو آسانی سے کیسے تعینات کیا جائے اور یہ ظاہر کرنے کے لیے مثالیں فراہم کیں کہ آپ SageMaker میں Flan T5 ماڈل اینڈ پوائنٹ کا استعمال کرتے ہوئے مختلف NLP کام کیسے انجام دے سکتے ہیں۔

ہم آپ کو جمپ سٹارٹ سے فلان T5 ماڈل تعینات کرنے اور NLP استعمال کے کیسز کے لیے اپنے پرامپٹس بنانے کی ترغیب دیتے ہیں۔

جمپ اسٹارٹ کے بارے میں مزید جاننے کے لیے، درج ذیل کو چیک کریں:

مصنفین کے بارے میں

ڈاکٹر ژن ہوانگ Amazon SageMaker JumpStart اور Amazon SageMaker بلٹ ان الگورتھم کے لیے ایک اپلائیڈ سائنٹسٹ ہے۔ وہ اسکیل ایبل مشین لرننگ الگورتھم تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کی تحقیقی دلچسپیاں قدرتی لینگویج پروسیسنگ، ٹیبلر ڈیٹا پر قابل وضاحت گہرائی سے سیکھنے، اور نان پیرامیٹرک اسپیس ٹائم کلسٹرنگ کے مضبوط تجزیہ کے شعبے میں ہیں۔ انہوں نے ACL، ICDM، KDD کانفرنسز، اور رائل سٹیٹسٹیکل سوسائٹی: سیریز A جرنل میں بہت سے مقالے شائع کیے ہیں۔

ڈاکٹر ژن ہوانگ Amazon SageMaker JumpStart اور Amazon SageMaker بلٹ ان الگورتھم کے لیے ایک اپلائیڈ سائنٹسٹ ہے۔ وہ اسکیل ایبل مشین لرننگ الگورتھم تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کی تحقیقی دلچسپیاں قدرتی لینگویج پروسیسنگ، ٹیبلر ڈیٹا پر قابل وضاحت گہرائی سے سیکھنے، اور نان پیرامیٹرک اسپیس ٹائم کلسٹرنگ کے مضبوط تجزیہ کے شعبے میں ہیں۔ انہوں نے ACL، ICDM، KDD کانفرنسز، اور رائل سٹیٹسٹیکل سوسائٹی: سیریز A جرنل میں بہت سے مقالے شائع کیے ہیں۔

وویک گنگاسنی۔ ایمیزون ویب سروسز میں ایک سینئر مشین لرننگ سلوشنز آرکیٹیکٹ ہیں۔ وہ AWS پر AI/ML ایپلیکیشنز بنانے اور تعینات کرنے کے لیے مشین لرننگ اسٹارٹ اپ کے ساتھ کام کرتا ہے۔ وہ فی الحال MLOps، ML Inference اور Low-code ML کے حل فراہم کرنے پر توجہ مرکوز کر رہے ہیں۔ انہوں نے نیچرل لینگویج پروسیسنگ اور کمپیوٹر ویژن سمیت مختلف ڈومینز میں پروجیکٹس پر کام کیا ہے۔

وویک گنگاسنی۔ ایمیزون ویب سروسز میں ایک سینئر مشین لرننگ سلوشنز آرکیٹیکٹ ہیں۔ وہ AWS پر AI/ML ایپلیکیشنز بنانے اور تعینات کرنے کے لیے مشین لرننگ اسٹارٹ اپ کے ساتھ کام کرتا ہے۔ وہ فی الحال MLOps، ML Inference اور Low-code ML کے حل فراہم کرنے پر توجہ مرکوز کر رہے ہیں۔ انہوں نے نیچرل لینگویج پروسیسنگ اور کمپیوٹر ویژن سمیت مختلف ڈومینز میں پروجیکٹس پر کام کیا ہے۔

ڈاکٹر کائل الریچ کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ ایمیزون سیج میکر بلٹ ان الگورتھم ٹیم اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر کائل الریچ کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ ایمیزون سیج میکر بلٹ ان الگورتھم ٹیم اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/zero-shot-prompting-for-the-flan-t5-foundation-model-in-amazon-sagemaker-jumpstart/

- : ہے

- $UP

- 1

- 10

- 100

- 2020

- 7

- 8

- a

- ہمارے بارے میں

- اوپر

- قبول کریں

- تک رسائی حاصل

- رسائی

- رسائی پذیری

- کے مطابق

- درستگی

- اپنانے

- اس کے علاوہ

- ایڈیشنل

- سایڈست

- انتظامیہ

- کے خلاف

- مجموعات

- AI / ML

- یلگوردمز

- تمام

- اجازت دے رہا ہے

- کی اجازت دیتا ہے

- اگرچہ

- ہمیشہ

- AMA

- ایمیزون

- ایمیزون کی تعریف

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- تجزیہ

- تجزیے

- اور

- اینجلس

- جواب

- اے پی آئی

- APIs

- ایپلی کیشنز

- اطلاقی

- مناسب

- کیا

- رقبہ

- دلائل

- مضمون

- AS

- At

- منسلک کریں

- خود کار طریقے سے

- دستیاب

- AWS

- بیس

- کی بنیاد پر

- بنیادی

- Bayesian

- BE

- بیم

- کیونکہ

- کیا جا رہا ہے

- فوائد

- کے درمیان

- سے پرے

- بلاک

- bnb

- جسم

- جرات مندانہ

- کتب

- تعمیر

- عمارت

- تعمیر میں

- بٹن

- by

- کہا جاتا ہے

- کیمپس

- کر سکتے ہیں

- صلاحیتوں

- صلاحیت رکھتا

- کارڈ

- ہوشیار

- مقدمات

- CAT

- الزام عائد کیا

- بوجھ

- چیک کریں

- انتخاب

- انتخاب

- میں سے انتخاب کریں

- شہر

- درجہ بندی

- کلائنٹ

- clustering کے

- کوڈ

- مربوط

- مجموعہ

- مجموعے

- کالج

- کالم

- آنے والے

- کامن

- مقابلہ

- مکمل

- پیچیدگی

- سمجھو

- وسیع

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹر ویژن

- تصورات

- نتیجہ اخذ

- کانفرنسوں

- غور کریں

- غور

- کنسول

- تعمیر

- کنٹینر

- پر مشتمل ہے

- مواد

- سیاق و سباق

- سیاق و سباق

- کنٹرول

- کنٹرول

- آسان

- سکتا ہے

- ملک

- احاطہ

- تخلیق

- تخلیق

- تخلیقی

- کپ

- اس وقت

- اپنی مرضی کے

- مرضی کے مطابق

- اعداد و شمار

- ڈیٹاسیٹس

- ڈیلز

- ضابطہ ربائی کرنا

- وقف

- گہری

- گہری سیکھنے

- کی وضاحت

- وضاحت کرتا ہے

- ترسیل

- مظاہرہ

- demonstrated,en

- ثبوت

- منحصر ہے

- تعیناتی

- تعینات

- تعیناتی

- بیان

- بیان کیا

- ڈیزائن

- مطلوبہ

- تفصیل

- اس بات کا تعین

- ترقی

- تیار ہے

- کے الات

- مختلف

- بات چیت

- میں Docker

- دستاویز

- دستاویزات

- نہیں کرتا

- ڈومین

- ڈومینز

- غالب

- نہیں

- ڈیوک

- ڈیوک یونیورسٹی

- کے دوران

- ہر ایک

- آسانی سے

- ای بکس

- تاثیر

- کارکردگی

- عناصر

- کی حوصلہ افزائی

- آخر سے آخر تک

- اختتام پوائنٹ

- انجینئر

- انجنیئرنگ

- انگریزی

- یقینی بناتا ہے

- پوری

- اداروں

- ہستی

- ماحولیات

- برابر

- بھی

- سب کچھ

- مثال کے طور پر

- مثال کے طور پر

- توقع

- مہنگی

- تجربہ

- تلاش

- نکالنے

- چہرہ

- سہولت

- خاندان

- تیز تر

- نمایاں کریں

- خصوصیات

- چند

- فائلوں

- کی مالی اعانت

- مل

- پہلا

- درست کریں

- لچکدار

- فلوٹ

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- مندرجہ ذیل ہے

- کے لئے

- فارمیٹ

- فاؤنڈیشن

- اکثر

- دوست

- سے

- سامنے

- مکمل

- عجیب

- مزید

- مزید برآں

- متفق

- جنرل

- پیدا

- پیدا

- پیدا ہوتا ہے

- پیدا کرنے والے

- نسل

- حاصل

- GitHub کے

- مقصد

- اچھا

- GPU

- عظیم

- زیادہ سے زیادہ

- بہت

- لالچی

- رہنمائی

- ہاتھ

- ہے

- صحت

- مدد

- مدد گار

- مدد کرتا ہے

- یہاں

- اعلی معیار کی

- اعلی

- کس طرح

- کیسے

- HTML

- HTTPS

- حب

- ID

- تصویر

- خیالی

- نفاذ

- درآمد

- اہم

- کو بہتر بنانے کے

- کو بہتر بنانے کے

- in

- شامل

- شامل ہیں

- سمیت

- شامل

- آزادانہ طور پر

- معلومات

- جدید

- ان پٹ

- بصیرت

- مثال کے طور پر

- کے بجائے

- ہدایات

- مفادات

- انٹرفیس

- شامل

- IT

- میں

- نوکریاں

- جرنل

- فوٹو

- JSON

- کلیدی

- بچے

- جان

- علم

- جانا جاتا ہے

- لینڈنگ

- زبان

- زبانیں

- بڑے

- سب سے بڑا

- آخری

- شروع

- شروع

- جانیں

- سیکھنے

- قیادت

- لمبائی

- آو ہم

- سطح

- سطح

- لائبریریوں

- لائبریری

- روشنی

- کی طرح

- امکان

- LIMIT

- حدود

- لمیٹڈ

- لائن

- لسٹ

- فہرستیں

- ایل ایل ایم

- واقع ہے

- لانگ

- دیکھو

- کی طرح دیکھو

- ان

- لاس اینجلس

- مشین

- مشین لرننگ

- بنا

- بنا

- بناتا ہے

- بہت سے

- زیادہ سے زیادہ

- دوا

- یاد داشت

- ذکر ہے

- طریقہ

- طریقوں

- لاکھوں

- کم سے کم

- ML

- ایم ایل اوپس

- ماڈل

- ماڈل

- زیادہ

- سب سے زیادہ

- فلم

- نام

- قدرتی

- قدرتی زبان عملیات

- سمت شناسی

- ضروری

- ضرورت ہے

- منفی

- نیٹ ورکنگ

- نئی

- نئی مصنوعات

- تازہ ترین

- اگلے

- ویزا

- شور

- نوٹ بک

- نوٹس

- ناول

- تعداد

- اعتراض

- حاصل کی

- of

- پیشکشیں

- تجویز

- on

- ایک

- جاری

- آپشنز کے بھی

- دیگر

- پیداوار

- مجموعی جائزہ

- خود

- صفحہ

- پین

- کاغذ.

- کاغذات

- پیرامیٹر

- پیرامیٹرز

- انجام دیں

- کارکردگی

- کارکردگی کا مظاہرہ

- کارکردگی کا مظاہرہ

- ذاتی بنانا

- فلپائن

- جملے

- پزا

- مقام

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مقبول

- مثبت

- ممکن

- پوسٹ

- طاقتور

- پیپیآئ

- پیشن گوئی

- پیش گو

- پریمیم

- صدر

- پیش نظارہ

- پہلے

- بنیادی طور پر

- عمل

- عمل

- پروسیسنگ

- پیدا

- حاصل

- منصوبوں

- ممتاز

- فراہم

- فراہم

- فراہم کرتا ہے

- فراہم کرنے

- عوامی طور پر

- شائع

- ازگر

- pytorch

- سوال

- سوالات

- بے ترتیب

- بے ترتیب پن

- تک پہنچنے

- پہنچتا ہے

- پڑھیں

- قارئین

- پڑھنا

- اصل وقت

- حال ہی میں

- تسلیم

- کو کم

- متعلقہ

- متعلقہ

- قابل ذکر

- بار بار

- ذخیرہ

- ضرورت

- کی ضرورت ہے

- تحقیق

- اسی طرح

- قرارداد

- جواب

- پابندی

- نتیجہ

- نتائج کی نمائش

- واپسی

- کا جائزہ لینے کے

- مضبوط

- شاہی

- رن

- s

- sagemaker

- سیج میکر کا اندازہ

- اسی

- توسیع پذیر

- اسکین

- سائنس

- سائنسدان

- سکرین

- اسکرین شاٹس

- sdk

- تلاش کریں

- دوسری

- سیکشنز

- انتخاب

- سیمنٹ

- سینئر

- احساس

- سزا

- جذبات

- تسلسل

- سیریز

- سیریز اے

- سروس

- سروسز

- اجلاس

- مقرر

- سیٹ

- سات

- مختصر

- ہونا چاہئے

- دکھائیں

- شوز

- بعد

- ایک

- حالات

- سائز

- سائز

- چھوٹے

- So

- سماجی

- سوشل نیٹ ورکنگ

- سوسائٹی

- حل

- حل

- ہسپانوی

- مخصوص

- خاص طور پر

- مخصوص

- استحکام

- شروع کریں

- شروع

- سترٹو

- حالت

- امریکہ

- شماریات

- مرحلہ

- مراحل

- ذخیرہ

- اسٹوریج کے اختیارات

- حکمت عملی

- طاقت

- ساخت

- سٹوڈیو

- بعد میں

- کامیابی کے ساتھ

- اس طرح

- سوٹ

- مختصر

- خلاصہ

- فراہمی

- تائید

- ٹیبل

- لے لو

- لیتا ہے

- ٹاسک

- کاموں

- ٹیم

- سانچے

- سانچے

- ٹیسسرور

- ٹیسٹ

- کہ

- ۔

- علاقہ

- کے بارے میں معلومات

- فلپائن

- ان

- ان

- لہذا

- یہ

- تھرڈ

- تین

- کے ذریعے

- وقت

- وقت کا سلسلہ

- وقت لگتا

- عنوان

- کرنے کے لئے

- ٹوکن

- ٹوکن

- کی طرف

- ٹرین

- تربیت یافتہ

- ٹریننگ

- منتقل

- ٹرانسفارمرز

- ترجمہ کریں

- ترجمہ

- سچ

- افہام و تفہیم

- متحدہ

- ریاست ہائے متحدہ امریکہ

- یونیورسٹی

- اپ ڈیٹ

- استعمال کی شرائط

- رکن کا

- صارف مواجہ

- صارفین

- یو ایس ٹی

- مختلف اقسام کے

- مختلف

- ورژن

- کی طرف سے

- نائب صدر

- نقطہ نظر

- گرم

- راستہ..

- ویب

- ویب خدمات

- اچھا ہے

- کیا

- جس

- جبکہ

- ڈبلیو

- وسیع

- وسیع

- گے

- ساتھ

- کے اندر

- بغیر

- لفظ

- الفاظ

- کام کیا

- کام کرتا ہے

- دنیا

- ورلڈ کپ

- گا

- لکھنا

- تحریری طور پر

- سال

- تم

- اور

- زیفیرنیٹ

- زیرو شاٹ لرننگ