بڑے لینگوئج ماڈلز (LLMs) کے لیے ڈسٹری بیوٹیڈ ڈیپ لرننگ کے شعبے میں زبردست پیش رفت ہوئی ہے، خاص طور پر دسمبر 2022 میں ChatGPT کے اجراء کے بعد۔ LLMs اربوں یا کھربوں پیرامیٹرز کے ساتھ سائز میں بڑھتے رہتے ہیں، اور وہ اکثر ایسا نہیں کرتے۔ میموری کی حدود کی وجہ سے ایک واحد ایکسلریٹر ڈیوائس جیسے GPU یا یہاں تک کہ ایک نوڈ جیسے ml.p5.32xlarge میں فٹ کریں۔ LLMs کو تربیت دینے والے صارفین کو اکثر اپنے کام کا بوجھ سینکڑوں یا اس سے بھی ہزاروں GPUs میں تقسیم کرنا ہوتا ہے۔ اس پیمانے پر تربیت کو فعال کرنا تقسیم شدہ تربیت میں ایک چیلنج بنی ہوئی ہے، اور اتنے بڑے نظام میں موثر طریقے سے تربیت ایک اور اتنا ہی اہم مسئلہ ہے۔ پچھلے سالوں کے دوران، تقسیم شدہ تربیتی کمیونٹی نے اس طرح کے چیلنجوں سے نمٹنے کے لیے 3D متوازی (ڈیٹا متوازی، پائپ لائن متوازی، اور ٹینسر کی متوازی) اور دیگر تکنیکیں (جیسے کہ ترتیب کے متوازی اور ماہر متوازی) متعارف کروائی ہیں۔

دسمبر 2023 میں، ایمیزون نے جاری کرنے کا اعلان کیا۔ سیج میکر ماڈل متوازی لائبریری 2.0 (SMP)، جو بڑے ماڈل ٹریننگ میں جدید ترین کارکردگی کو حاصل کرتا ہے۔ سیج میکر نے ڈیٹا متوازی لائبریری تقسیم کی۔ (SMDDP)۔ یہ ریلیز 1.x سے ایک اہم اپ ڈیٹ ہے: SMP اب اوپن سورس PyTorch کے ساتھ مربوط ہے۔ مکمل طور پر شارڈ ڈیٹا متوازی (FSDP) APIs، جو آپ کو بڑے ماڈلز کو تربیت دیتے وقت ایک مانوس انٹرفیس استعمال کرنے کی اجازت دیتا ہے، اور اس کے ساتھ مطابقت رکھتا ہے۔ ٹرانسفارمر انجن (TE)، پہلی بار FSDP کے ساتھ ساتھ ٹینسر کے متوازی تکنیکوں کو کھولنا۔ ریلیز کے بارے میں مزید جاننے کے لیے، رجوع کریں۔ ایمیزون سیج میکر ماڈل متوازی لائبریری اب PyTorch FSDP ورک بوجھ کو 20٪ تک تیز کرتی ہے.

اس پوسٹ میں، ہم کارکردگی کے فوائد کو دریافت کرتے ہیں۔ ایمیزون سیج میکر (بشمول SMP اور SMDDP)، اور آپ SageMaker پر بڑے ماڈلز کو موثر طریقے سے تربیت دینے کے لیے لائبریری کا استعمال کیسے کر سکتے ہیں۔ ہم 4 مثالوں تک ml.p24d.128xlarge کلسٹرز پر بینچ مارکس کے ساتھ SageMaker کی کارکردگی کا مظاہرہ کرتے ہیں، اور Llama 16 ماڈل کے لیے bfloat2 کے ساتھ FSDP مخلوط درستگی کا مظاہرہ کرتے ہیں۔ ہم سیج میکر کے لیے قریب کی لکیری اسکیلنگ کی افادیت کے مظاہرے کے ساتھ شروع کرتے ہیں، اس کے بعد بہترین تھرو پٹ کے لیے ہر ایک خصوصیت کے تعاون کا تجزیہ کرتے ہیں، اور ٹینسر متوازی کے ذریعے 32,768 تک مختلف ترتیب کی لمبائی کے ساتھ موثر تربیت کے ساتھ اختتام کرتے ہیں۔

سیج میکر کے ساتھ قریب لکیری اسکیلنگ

LLM ماڈلز کے لیے ٹریننگ کے مجموعی وقت کو کم کرنے کے لیے، بڑے کلسٹرز (ہزاروں GPUs) کو اسکیل کرتے وقت اعلیٰ تھرو پٹ کو محفوظ رکھنا، انٹر نوڈ کمیونیکیشن اوور ہیڈ کو دیکھتے ہوئے بہت ضروری ہے۔ اس پوسٹ میں، ہم P4d مثالوں پر SMP اور SMDDP دونوں کو مدعو کرتے ہوئے مضبوط اور قریب لکیری اسکیلنگ (ایک مقررہ کل مسئلہ کے سائز کے لیے GPUs کی تعداد کو مختلف کرکے) کا مظاہرہ کرتے ہیں۔

اس سیکشن میں، ہم SMP کی قریب لکیری اسکیلنگ کی کارکردگی کا مظاہرہ کرتے ہیں۔ یہاں ہم مختلف سائز کے Llama 2 ماڈلز (7B، 13B، اور 70B پیرامیٹرز) کو 4,096 کی مقررہ ترتیب کی لمبائی کا استعمال کرتے ہوئے تربیت دیتے ہیں، اجتماعی مواصلات کے لیے SMDDP بیک اینڈ، TE فعال، 4 ملین کا عالمی بیچ سائز، 16 سے 128 p4d نوڈس کے ساتھ . مندرجہ ذیل جدول ہماری بہترین ترتیب اور تربیتی کارکردگی کا خلاصہ کرتا ہے (ماڈل TFLOPs فی سیکنڈ)۔

| ماڈل سائز | نوڈس کی تعداد | TFLOPs* | ایس ڈی پی* | ٹی پی* | بوجھ کم کرنا* | اسکیلنگ کی کارکردگی |

| 7B | 16 | 136.76 | 32 | 1 | N | 100.0٪ |

| 32 | 132.65 | 64 | 1 | N | 97.0٪ | |

| 64 | 125.31 | 64 | 1 | N | 91.6٪ | |

| 128 | 115.01 | 64 | 1 | N | 84.1٪ | |

| 13B | 16 | 141.43 | 32 | 1 | Y | 100.0٪ |

| 32 | 139.46 | 256 | 1 | N | 98.6٪ | |

| 64 | 132.17 | 128 | 1 | N | 93.5٪ | |

| 128 | 120.75 | 128 | 1 | N | 85.4٪ | |

| 70B | 32 | 154.33 | 256 | 1 | Y | 100.0٪ |

| 64 | 149.60 | 256 | 1 | N | 96.9٪ | |

| 128 | 136.52 | 64 | 2 | N | 88.5٪ |

*دئیے گئے ماڈل کے سائز، ترتیب کی لمبائی، اور نوڈس کی تعداد پر، ہم مختلف sdp، tp، اور ایکٹیویشن آف لوڈنگ کے امتزاج کو تلاش کرنے کے بعد عالمی سطح پر بہترین تھرو پٹ اور کنفیگریشن دکھاتے ہیں۔

پچھلا جدول شارڈڈ ڈیٹا متوازی (sdp) ڈگری (عام طور پر FSDP ہائبرڈ شارڈنگ کا استعمال کرتے ہوئے، اگلے حصے میں مزید تفصیلات کے ساتھ)، ٹینسر متوازی (tp) ڈگری، اور ایکٹیویشن آف لوڈنگ ویلیو تبدیلیوں، ایس ایم ڈی ڈی پی کے ساتھ مل کر ایس ایم پی کے لئے قریب لکیری اسکیلنگ کا مظاہرہ کرنا۔ مثال کے طور پر، Llama 2 ماڈل سائز 7B اور ترتیب کی لمبائی 4,096 کو دیکھتے ہوئے، مجموعی طور پر یہ بالترتیب 97.0، 91.6، اور 84.1 نوڈس پر 16%، 32%، اور 64% (128 نوڈس کے نسبت) کی اسکیلنگ افادیت حاصل کرتا ہے۔ اسکیلنگ کی افادیت مختلف ماڈل سائزوں میں مستحکم ہوتی ہے اور ماڈل کا سائز بڑا ہونے پر قدرے بڑھ جاتا ہے۔

ایس ایم پی اور ایس ایم ڈی ڈی پی دوسرے ترتیب کی لمبائی جیسے 2,048 اور 8,192 کے لئے بھی اسی طرح کی اسکیلنگ کی افادیت کا مظاہرہ کرتے ہیں۔

سیج میکر ماڈل متوازی لائبریری 2.0 کی کارکردگی: لاما 2 70B

LLM کمیونٹی میں بار بار جدید ترین کارکردگی کے اپ ڈیٹس کے ساتھ، پچھلے سالوں میں ماڈل کے سائز میں مسلسل اضافہ ہوتا رہا ہے۔ اس سیکشن میں، ہم Llama 2 ماڈل کے لیے SageMaker میں ایک فکسڈ ماڈل سائز 70B، ترتیب کی لمبائی 4,096، اور 4 ملین کے عالمی بیچ سائز کا استعمال کرتے ہوئے کارکردگی کو واضح کرتے ہیں۔ پچھلے جدول کی عالمی سطح پر بہترین ترتیب اور تھرو پٹ (ایس ایم ڈی ڈی پی بیک اینڈ کے ساتھ، عام طور پر ایف ایس ڈی پی ہائبرڈ شارڈنگ اور ٹی ای) کے ساتھ موازنہ کرنے کے لیے، درج ذیل جدول تقسیم شدہ بیک اینڈ (NCCL اور SMDDP) پر اضافی تفصیلات کے ساتھ دیگر بہترین تھرو پٹس (ممکنہ طور پر ٹینسر کے متوازی کے ساتھ) تک پھیلا ہوا ہے۔ ، FSDP شارڈنگ کی حکمت عملی (مکمل شارڈنگ اور ہائبرڈ شارڈنگ)، اور TE کو فعال کرنا یا نہیں (پہلے سے طے شدہ)۔

| ماڈل سائز | نوڈس کی تعداد | ٹی ایف ایل او پی ایس۔ | TFLOPs #3 تشکیل | بیس لائن پر TFLOPs میں بہتری | ||||||||

| . | . | NCCL مکمل شارڈنگ: #0 | SMDDP مکمل شارڈنگ: #1 | SMDDP ہائبرڈ شارڈنگ: #2 | TE کے ساتھ SMDDP ہائبرڈ شارڈنگ: #3 | ایس ڈی پی* | ٹی پی* | بوجھ کم کرنا* | #0 → #1 | #1 → #2 | #2 → #3 | #0 → #3 |

| 70B | 32 | 150.82 | 149.90 | 150.05 | 154.33 | 256 | 1 | Y | -0.6٪ | 0.1٪ | 2.9٪ | 2.3٪ |

| 64 | 144.38 | 144.38 | 145.42 | 149.60 | 256 | 1 | N | 0.0٪ | 0.7٪ | 2.9٪ | 3.6٪ | |

| 128 | 68.53 | 103.06 | 130.66 | 136.52 | 64 | 2 | N | 50.4٪ | 26.8٪ | 4.5٪ | 99.2٪ | |

*دئیے گئے ماڈل کے سائز، ترتیب کی لمبائی، اور نوڈس کی تعداد پر، ہم مختلف sdp، tp، اور ایکٹیویشن آف لوڈنگ کے امتزاج کو تلاش کرنے کے بعد عالمی سطح پر بہترین تھرو پٹ اور کنفیگریشن دکھاتے ہیں۔

SMP اور SMDDP کی تازہ ترین ریلیز متعدد خصوصیات کو سپورٹ کرتی ہے جس میں مقامی PyTorch FSDP، توسیعی اور زیادہ لچکدار ہائبرڈ شارڈنگ، ٹرانسفارمر انجن انٹیگریشن، ٹینسر کی ہم آہنگی، اور آپٹمائزڈ سبھی اجتماعی آپریشن شامل ہیں۔ یہ بہتر طور پر سمجھنے کے لیے کہ SageMaker LLMs کے لیے کس طرح موثر تقسیم شدہ تربیت حاصل کرتا ہے، ہم SMDDP اور درج ذیل SMP سے بڑھتے ہوئے تعاون کو تلاش کرتے ہیں۔ بنیادی خصوصیات:

- FSDP مکمل شارڈنگ کے ساتھ NCCL پر SMDDP اضافہ

- FSDP مکمل شارڈنگ کو ہائبرڈ شارڈنگ سے تبدیل کرنا، جس سے تھرو پٹ کو بہتر بنانے کے لیے کمیونیکیشن لاگت کم ہو جاتی ہے۔

- TE کے ساتھ تھرو پٹ کو مزید فروغ، یہاں تک کہ جب ٹینسر کا ہم آہنگی غیر فعال ہو۔

- کم وسائل کی ترتیبات پر، ایکٹیویشن آف لوڈنگ ٹریننگ کو فعال کرنے کے قابل ہو سکتی ہے جو بصورت دیگر ہائی میموری پریشر کی وجہ سے ناقابل عمل یا بہت سست ہو گی۔

FSDP مکمل شارڈنگ: NCCL پر SMDDP اضافہ

جیسا کہ پچھلے جدول میں دکھایا گیا ہے، جب ماڈلز کو FSDP کے ساتھ مکمل طور پر شارڈ کیا جاتا ہے، اگرچہ NCCL (TFLOPs #0) اور SMDDP (TFLOPs #1) تھرو پٹس کا موازنہ 32 یا 64 نوڈس پر ہوتا ہے، NCCL سے SMDDP تک 50.4% کی زبردست بہتری ہوتی ہے۔ 128 نوڈس پر۔

چھوٹے ماڈل سائز میں، ہم NCCL پر SMDDP کے ساتھ مسلسل اور نمایاں بہتری کا مشاہدہ کرتے ہیں، چھوٹے کلسٹر سائز سے شروع ہو کر، کیونکہ SMDDP مواصلت کی رکاوٹ کو مؤثر طریقے سے کم کرنے کے قابل ہے۔

مواصلاتی لاگت کو کم کرنے کے لیے FSDP ہائبرڈ شارڈنگ

SMP 1.0 میں، ہم نے لانچ کیا۔ شارڈ ڈیٹا کی ہم آہنگی، ایک تقسیم شدہ تربیتی تکنیک جو ایمیزون ان ہاؤس کے ذریعے چلتی ہے۔ ایم آئی سی ایس ٹیکنالوجی SMP 2.0 میں، ہم SMP ہائبرڈ شارڈنگ متعارف کراتے ہیں، جو ایک قابل توسیع اور زیادہ لچکدار ہائبرڈ شارڈنگ تکنیک ہے جو تمام تربیتی GPUs کے بجائے ماڈلز کو GPUs کے سب سیٹ کے درمیان شارڈنگ کرنے کی اجازت دیتی ہے، جو کہ FSDP مکمل شارڈنگ کا معاملہ ہے۔ یہ درمیانے درجے کے ماڈلز کے لیے مفید ہے جنہیں فی GPU میموری کی رکاوٹوں کو پورا کرنے کے لیے پورے کلسٹر میں شارڈ کرنے کی ضرورت نہیں ہے۔ یہ ایک سے زیادہ ماڈل ریپلیکا رکھنے والے کلسٹرز کی طرف لے جاتا ہے اور ہر GPU رن ٹائم پر کم ساتھیوں کے ساتھ بات چیت کرتا ہے۔

ایس ایم پی کی ہائبرڈ شارڈنگ ایک وسیع رینج پر موثر ماڈل شارڈنگ کو قابل بناتی ہے، جس میں سب سے چھوٹی شارڈ ڈگری سے لے کر کلسٹر سائز تک (جو مکمل شارڈنگ کے برابر ہے) تک میموری کے مسائل نہیں ہیں۔

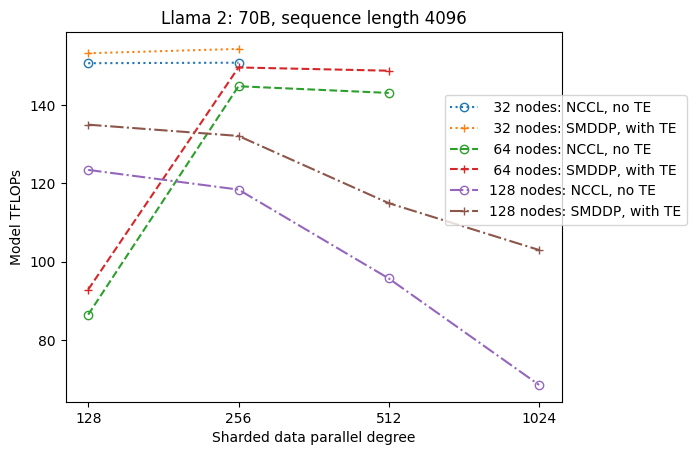

درج ذیل اعداد و شمار سادگی کے لیے tp = 1 پر sdp پر تھرو پٹ انحصار کو واضح کرتا ہے۔ اگرچہ یہ ضروری نہیں ہے کہ پچھلے جدول میں NCCL یا SMDDP مکمل شارڈنگ کے لیے بہترین ٹی پی ویلیو جیسا ہو، نمبر کافی قریب ہیں۔ یہ 128 نوڈس کے بڑے کلسٹر سائز پر مکمل شارڈنگ سے ہائبرڈ شارڈنگ پر سوئچ کرنے کی قدر کو واضح طور پر درست کرتا ہے، جو NCCL اور SMDDP دونوں پر لاگو ہوتا ہے۔ چھوٹے ماڈل سائز کے لیے، ہائبرڈ شارڈنگ کے ساتھ نمایاں بہتری چھوٹے کلسٹر سائز سے شروع ہوتی ہے، اور فرق کلسٹر سائز کے ساتھ بڑھتا ہی جاتا ہے۔

TE کے ساتھ بہتری

TE کو NVIDIA GPUs پر LLM ٹریننگ کو تیز کرنے کے لیے ڈیزائن کیا گیا ہے۔ FP8 استعمال نہ کرنے کے باوجود کیونکہ یہ p4d مثالوں پر غیر تعاون یافتہ ہے، ہمیں اب بھی p4d پر TE کے ساتھ نمایاں رفتار نظر آتی ہے۔

ایس ایم ڈی ڈی پی بیک اینڈ کے ساتھ تربیت یافتہ ایم آئی سی ایس کے اوپری حصے میں، TE تمام کلسٹر سائزز میں تھرو پٹ کے لیے ایک مستقل فروغ متعارف کراتا ہے (صرف استثناء 128 نوڈس پر مکمل شارڈنگ ہے)، یہاں تک کہ جب ٹینسر متوازی غیر فعال ہو (ٹینسر متوازی ڈگری 1 ہے)۔

چھوٹے ماڈل کے سائز یا مختلف ترتیب کی لمبائی کے لیے، TE فروغ تقریباً 3–7.6% کی حد میں، مستحکم اور غیر معمولی ہے۔

کم وسائل کی ترتیبات پر ایکٹیویشن آف لوڈنگ

کم وسائل کی ترتیبات پر (نوڈس کی ایک چھوٹی سی تعداد کے پیش نظر)، FSDP کو ایکٹیویشن چیک پوائنٹنگ فعال ہونے پر ہائی میموری پریشر (یا بدترین صورت میں میموری سے بھی باہر) کا سامنا ہو سکتا ہے۔ اس طرح کے منظرناموں کے لیے میموری کی طرف سے رکاوٹ، ایکٹیویشن آف لوڈنگ کو آن کرنا ممکنہ طور پر کارکردگی کو بہتر بنانے کا ایک آپشن ہے۔

مثال کے طور پر، جیسا کہ ہم نے پہلے دیکھا، اگرچہ Llama 2 ماڈل سائز 13B اور ترتیب کی لمبائی 4,096 ایکٹیویشن چیک پوائنٹنگ کے ساتھ کم از کم 32 نوڈس کے ساتھ بہترین طریقے سے تربیت دینے کے قابل ہے اور بغیر ایکٹیویشن آف لوڈنگ کے، یہ 16 تک محدود ہونے پر ایکٹیویشن آف لوڈنگ کے ساتھ بہترین تھرو پٹ حاصل کرتا ہے۔ نوڈس

طویل ترتیب کے ساتھ تربیت کو فعال کریں: SMP ٹینسر متوازی

طویل گفتگو اور سیاق و سباق کے لیے طویل ترتیب کی لمبائی مطلوب ہے، اور LLM کمیونٹی میں زیادہ توجہ حاصل کر رہی ہے۔ لہذا، ہم مندرجہ ذیل جدول میں مختلف طویل ترتیب کے ذریعے کی اطلاع دیتے ہیں۔ جدول SageMaker پر Llama 2 کی تربیت کے لیے بہترین تھرو پٹ دکھاتا ہے، جس میں مختلف ترتیب کی لمبائی 2,048 سے 32,768 تک ہے۔ ترتیب کی لمبائی 32,768 پر، مقامی FSDP تربیت 32 ملین کے عالمی بیچ سائز میں 4 نوڈس کے ساتھ ناقابل عمل ہے۔

| . | . | . | ٹی ایف ایل او پی ایس۔ | ||

| ماڈل سائز | تسلسل کی لمبائی | نوڈس کی تعداد | مقامی FSDP اور NCCL | SMP اور SMDDP | ایس ایم پی کی بہتری |

| 7B | 2048 | 32 | 129.25 | 138.17 | 6.9٪ |

| 4096 | 32 | 124.38 | 132.65 | 6.6٪ | |

| 8192 | 32 | 115.25 | 123.11 | 6.8٪ | |

| 16384 | 32 | 100.73 | 109.11 | 8.3٪ | |

| 32768 | 32 | N / A | 82.87 | . | |

| 13B | 2048 | 32 | 137.75 | 144.28 | 4.7٪ |

| 4096 | 32 | 133.30 | 139.46 | 4.6٪ | |

| 8192 | 32 | 125.04 | 130.08 | 4.0٪ | |

| 16384 | 32 | 111.58 | 117.01 | 4.9٪ | |

| 32768 | 32 | N / A | 92.38 | . | |

| *: زیادہ سے زیادہ | . | . | . | . | 8.3٪ |

| *: اوسط | . | . | . | . | 5.8٪ |

جب کلسٹر کا سائز بڑا ہوتا ہے اور ایک مقررہ عالمی بیچ کا سائز دیا جاتا ہے، تو کچھ ماڈل ٹریننگ مقامی PyTorch FSDP کے ساتھ نا ممکن ہو سکتی ہے، جس میں بلٹ ان پائپ لائن یا ٹینسر متوازی سپورٹ کی کمی ہوتی ہے۔ پچھلے جدول میں، عالمی بیچ سائز 4 ملین، 32 نوڈس، اور ترتیب کی لمبائی 32,768 دی گئی ہے، فی GPU مؤثر بیچ کا سائز 0.5 ہے (مثال کے طور پر، بیچ سائز 2 کے ساتھ tp = 1)، جو بصورت دیگر متعارف کرائے بغیر ناقابل عمل ہوگا۔ ٹینسر متوازی

نتیجہ

اس پوسٹ میں، ہم نے p4d مثالوں پر ایس ایم پی اور ایس ایم ڈی ڈی پی کے ساتھ موثر ایل ایل ایم ٹریننگ کا مظاہرہ کیا، جس میں متعدد کلیدی خصوصیات کو منسوب کیا گیا، جیسے NCCL پر SMDDP اضافہ، مکمل شارڈنگ کے بجائے لچکدار FSDP ہائبرڈ شارڈنگ، TE انٹیگریشن، اور ٹینسر کے ہم آہنگی کو فعال کرنا۔ طویل ترتیب کی لمبائی. مختلف ماڈلز، ماڈل کے سائز، اور ترتیب کی لمبائی کے ساتھ سیٹنگز کی ایک وسیع رینج پر جانچ کرنے کے بعد، یہ SageMaker پر 128 p4d مثالوں تک، قریب قریب لکیری اسکیلنگ کی افادیت کو ظاہر کرتا ہے۔ خلاصہ یہ کہ سیج میکر ایل ایل ایم کے محققین اور پریکٹیشنرز کے لیے ایک طاقتور ٹول ہے۔

مزید جاننے کے لیے رجوع کریں۔ سیج میکر ماڈل متوازی لائبریری v2، یا SMP ٹیم سے رابطہ کریں۔ sm-model-parallel-feedback@amazon.com.

منظوریاں

ہم رابرٹ وان ڈوسن، بین سنائیڈر، گوتم کمار، اور لوئس کوئنٹیلا کا ان کے تعمیری تاثرات اور بات چیت کے لیے شکریہ ادا کرنا چاہیں گے۔

مصنفین کے بارے میں

Xinle شیلا لیو ایمیزون سیج میکر میں ایک SDE ہے۔ اپنے فارغ وقت میں، وہ پڑھنے اور بیرونی کھیلوں سے لطف اندوز ہوتی ہے۔

سوہت کوڈگولے AWS مصنوعی ذہانت گروپ کے ساتھ ایک سافٹ ویئر ڈویلپمنٹ انجینئر ہے جو گہری سیکھنے کے فریم ورک پر کام کر رہا ہے۔ اپنے فارغ وقت میں، وہ پیدل سفر، سفر اور کھانا پکانے سے لطف اندوز ہوتا ہے۔

سوہت کوڈگولے AWS مصنوعی ذہانت گروپ کے ساتھ ایک سافٹ ویئر ڈویلپمنٹ انجینئر ہے جو گہری سیکھنے کے فریم ورک پر کام کر رہا ہے۔ اپنے فارغ وقت میں، وہ پیدل سفر، سفر اور کھانا پکانے سے لطف اندوز ہوتا ہے۔

وکٹر ژو ایمیزون ویب سروسز میں ڈسٹری بیوٹڈ ڈیپ لرننگ میں سافٹ ویئر انجینئر ہے۔ وہ SF بے ایریا کے آس پاس ہائیکنگ اور بورڈ گیمز سے لطف اندوز ہوتے ہوئے پایا جا سکتا ہے۔

وکٹر ژو ایمیزون ویب سروسز میں ڈسٹری بیوٹڈ ڈیپ لرننگ میں سافٹ ویئر انجینئر ہے۔ وہ SF بے ایریا کے آس پاس ہائیکنگ اور بورڈ گیمز سے لطف اندوز ہوتے ہوئے پایا جا سکتا ہے۔

دریا کیودر AWS میں سافٹ ویئر انجینئر کے طور پر کام کرتا ہے۔ اس کی دلچسپیوں میں گہری سیکھنے اور تقسیم شدہ تربیت کی اصلاح شامل ہے۔

دریا کیودر AWS میں سافٹ ویئر انجینئر کے طور پر کام کرتا ہے۔ اس کی دلچسپیوں میں گہری سیکھنے اور تقسیم شدہ تربیت کی اصلاح شامل ہے۔

ٹینگ سو AWS AI میں تقسیم شدہ ٹریننگ گروپ میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ اسے پڑھنے میں مزہ آتا ہے۔

ٹینگ سو AWS AI میں تقسیم شدہ ٹریننگ گروپ میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ اسے پڑھنے میں مزہ آتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/distributed-training-and-efficient-scaling-with-the-amazon-sagemaker-model-parallel-and-data-parallel-libraries/

- : ہے

- : ہے

- : نہیں

- $UP

- 1

- 120

- 16

- 160

- 2022

- 2023

- 32

- 3d

- 455

- 50

- 7

- 8

- 84

- 91

- 97

- a

- قابلیت

- ہمارے بارے میں

- رفتار کو تیز تر

- تیز رفتار

- مسرع

- حاصل کرتا ہے

- کے پار

- چالو کرنے کی

- پتہ

- کے بعد

- AI

- تمام

- کی اجازت دیتا ہے

- ساتھ

- شانہ بشانہ

- بھی

- اگرچہ

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- کے درمیان

- an

- تجزیہ

- اور

- کا اعلان کیا ہے

- ایک اور

- APIs

- قابل اطلاق

- تقریبا

- کیا

- رقبہ

- ارد گرد

- مصنوعی

- مصنوعی ذہانت

- AS

- At

- توجہ

- AWS

- پسدید

- خلیج

- BE

- کیونکہ

- رہا

- کیا جا رہا ہے

- بین

- معیارات

- فوائد

- BEST

- بہتر

- اربوں

- بورڈ

- بورڈ کھیل

- بڑھانے کے

- دونوں

- رکاوٹ

- تعمیر میں

- by

- کر سکتے ہیں

- کیس

- چیلنج

- چیلنجوں

- تبدیلیاں

- چیٹ جی پی ٹی

- واضح طور پر

- کلوز

- کلسٹر

- اجتماعی

- COM

- کے مجموعے

- بات چیت

- مواصلات

- کمیونٹی

- موازنہ

- موازنہ

- ہم آہنگ

- ترتیب

- متواتر

- رکاوٹوں

- تعمیری

- رابطہ کریں

- سیاق و سباق

- جاری

- جاری رہی

- جاری ہے

- شراکت دار

- مکالمات

- قیمت

- اہم

- گاہکوں

- اعداد و شمار

- دسمبر

- گہری

- گہری سیکھنے

- پہلے سے طے شدہ

- ڈگری

- مظاہرہ

- demonstrated,en

- مظاہرین

- مظاہرین

- انحصار

- ڈیزائن

- مطلوبہ

- کے باوجود

- تفصیلات

- ترقی

- آلہ

- فرق

- مختلف

- غیر فعال کر دیا

- بات چیت

- تقسیم کرو

- تقسیم کئے

- تقسیم کی تربیت

- نہیں

- دو

- ہر ایک

- موثر

- مؤثر طریقے

- استعداد کار

- کارکردگی

- ہنر

- مؤثر طریقے سے

- کو چالو کرنے کے

- چالو حالت میں

- کے قابل بناتا ہے

- کو فعال کرنا

- آخر

- انجن

- انجینئر

- اضافہ

- لطف اندوز

- پوری

- یکساں طور پر

- مساوی

- خاص طور پر

- بھی

- مثال کے طور پر

- رعایت

- نمائش

- تجربہ

- ماہر

- تلاش

- ایکسپلور

- توسیع

- توسیع

- اضافی

- واقف

- کی حمایت

- نمایاں کریں

- خصوصیات

- آراء

- کم

- میدان

- اعداد و شمار

- پہلا

- پہلی بار

- فٹ

- مقرر

- لچکدار

- پیچھے پیچھے

- کے بعد

- کے لئے

- ملا

- فریم ورک

- بار بار اس

- سے

- مکمل

- مکمل طور پر

- مزید

- کھیل

- جمع

- ملتا

- حاصل کرنے

- دی

- گلوبل

- عالمی سطح پر

- GPU

- GPUs

- گروپ

- بڑھائیں

- ہے

- ہونے

- he

- اس کی

- یہاں

- ہائی

- ان

- کس طرح

- HTML

- HTTPS

- بھاری

- سینکڑوں

- ہائبرڈ

- وضاحت

- وضاحت کرتا ہے

- اہم

- کو بہتر بنانے کے

- بہتری

- بہتری

- in

- شامل

- سمیت

- اضافہ

- اضافہ

- اضافہ

- کے بجائے

- ضم

- انضمام

- انٹیلی جنس

- مفادات

- انٹرفیس

- میں

- متعارف کرانے

- متعارف

- متعارف کرواتا ہے

- متعارف کرانے

- مسائل

- IT

- فوٹو

- رہتا ہے

- کلیدی

- کمر

- کمی

- زبان

- بڑے

- بڑے

- تازہ ترین

- تازہ ترین رہائی

- شروع

- لیڈز

- جانیں

- سیکھنے

- کم سے کم

- لمبائی

- لائبریریوں

- لائبریری

- کی طرح

- حدود

- لمیٹڈ

- لاما

- ایل ایل ایم

- لانگ

- لو

- کم

- یاد داشت

- شاید

- دس لاکھ

- تخفیف کریں

- مخلوط

- ML

- ماڈل

- ماڈل

- زیادہ

- ایک سے زیادہ

- ضروری

- مقامی

- ضروری ہے

- ضرورت ہے

- اگلے

- نہیں

- نوڈ

- نوڈس

- اب

- تعداد

- تعداد

- NVIDIA

- مشاہدہ

- of

- اکثر

- on

- ایک

- صرف

- کھول

- اوپن سورس

- آپریشن

- زیادہ سے زیادہ

- اصلاح کے

- اصلاح

- اختیار

- or

- حکم

- دیگر

- دوسری صورت میں

- ہمارے

- باہر

- پر

- مجموعی طور پر

- زمین کے اوپر

- متوازی

- پیرامیٹرز

- گزشتہ

- ساتھی

- فی

- کارکردگی

- پائپ لائن

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوسٹ

- ممکنہ طور پر

- طاقت

- طاقتور

- پہلے

- صحت سے متعلق

- محفوظ کر رہا ہے

- دباؤ

- پچھلا

- پہلے

- مسئلہ

- پیش رفت

- pytorch

- بہت

- رینج

- پڑھنا

- کو کم

- کم

- کا حوالہ دیتے ہیں

- رشتہ دار

- جاری

- باقی

- جواب

- رپورٹ

- محققین

- وسائل

- بالترتیب

- ROBERT

- مضبوط

- رن ٹائم

- sagemaker

- اسی

- مطمئن

- دیکھا

- پیمانے

- سکیلنگ

- منظرنامے

- ایس ڈی پی

- دوسری

- سیکشن

- دیکھنا

- تسلسل

- سروسز

- ترتیبات

- تیز

- شارڈنگ

- وہ

- دکھائیں

- دکھایا گیا

- شوز

- اہم

- اسی طرح

- سادگی

- ایک

- سائز

- سائز

- سست

- چھوٹے

- چھوٹے

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- سافٹ ویئر انجنیئر

- کچھ

- ماخذ

- وضاحتیں

- اسپورٹس

- مستحکم

- شروع کریں

- شروع

- ریاستی آرٹ

- ابھی تک

- حکمت عملیوں

- موضوع

- اس طرح

- خلاصہ

- حمایت

- کی حمایت کرتا ہے

- کے نظام

- ٹیبل

- ٹیم

- تکنیک

- تکنیک

- ٹیکنالوجی

- تجربہ

- سے

- شکریہ

- کہ

- ۔

- ان

- وہاں.

- لہذا

- وہ

- اس

- ہزاروں

- کے ذریعے

- تھرو پٹ

- وقت

- کرنے کے لئے

- مل کر

- کے آلے

- سب سے اوپر

- کل

- tp

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمر

- سفر

- زبردست

- ٹریلین

- ٹرننگ

- عام طور پر

- سمجھ

- غیر مقفل

- اپ ڈیٹ کریں

- تازہ ترین معلومات

- استعمال کی شرائط

- مفید

- کا استعمال کرتے ہوئے

- قیمت

- وین

- مختلف

- مختلف

- بہت

- we

- ویب

- ویب خدمات

- جب

- جس

- پوری

- وسیع

- وسیع رینج

- وسیع

- ساتھ

- بغیر

- کام کر

- کام کرتا ہے

- بدترین

- گا

- X

- سال

- تم

- زیفیرنیٹ