لینگویج کے بڑے ماڈلز (LLMs) نے کئی صنعتوں میں ڈویلپرز، سائنسدانوں، تکنیکی ماہرین، کاروباری افراد اور ایگزیکٹوز کی تخیل اور توجہ حاصل کر لی ہے۔ ان ماڈلز کو سوالوں کے جوابات، خلاصہ، ترجمہ، اور بہت کچھ کے لیے استعمال کیا جا سکتا ہے جیسے کہ کسٹمر سپورٹ کے لیے بات چیت کے ایجنٹ، مارکیٹنگ کے لیے مواد کی تخلیق، اور کوڈنگ اسسٹنٹس۔

حال ہی میں، میٹا جاری شعلہ 2 محققین اور تجارتی اداروں دونوں کے لیے، MosaicML سمیت دیگر LLMs کی فہرست میں شامل کرنا MPT اور فالکن. اس پوسٹ میں، ہم لاما 2 کو ٹھیک کرنے کے طریقے پر چلتے ہیں۔ AWS ٹرینیمLLM ٹریننگ کے لیے ایک مقصد سے بنایا ہوا ایکسلریٹر، تربیت کے اوقات اور اخراجات کو کم کرنے کے لیے۔ ہم کی طرف سے فراہم کردہ فائن ٹیوننگ اسکرپٹس کا جائزہ لیتے ہیں۔ AWS نیوران SDK (NeMo Megatron-LM کا استعمال کرتے ہوئے)، مختلف کنفیگریشنز جو ہم نے استعمال کیں، اور تھرو پٹ کے نتائج جو ہم نے دیکھے۔

لاما 2 ماڈل کے بارے میں

پچھلے کی طرح شعلہ 1 ماڈل اور دیگر ماڈلز جیسے GPT، Llama 2 ٹرانسفارمر کے صرف ڈیکوڈر فن تعمیر کا استعمال کرتے ہیں۔ یہ تین سائز میں آتا ہے: 7 بلین، 13 بلین، اور 70 بلین پیرامیٹرز۔ Llama 1 کے مقابلے میں، Llama 2 سیاق و سباق کی لمبائی کو 2,000 سے 4,000 تک دگنا کرتا ہے، اور گروپ شدہ سوال کی توجہ کا استعمال کرتا ہے (صرف 70B کے لیے)۔ Llama 2 پہلے سے تربیت یافتہ ماڈلز کو 2 ٹریلین ٹوکنز پر تربیت دی جاتی ہے، اور اس کے عمدہ ماڈلز کو 1 ملین سے زیادہ انسانی تشریحات پر تربیت دی گئی ہے۔

لاما 2 کی تقسیم شدہ تربیت

Llama 2 کو 2,000 اور 4,000 تسلسل کی لمبائی کے ساتھ ایڈجسٹ کرنے کے لیے، ہم نے اسکرپٹ کو استعمال کرتے ہوئے لاگو کیا NeMo Megatron ٹرینیم کے لیے جو ڈیٹا متوازی (DP)، ٹینسر متوازی (TP)، اور پائپ لائن متوازی (PP) کی حمایت کرتا ہے۔ مخصوص ہونے کے لیے، انٹی ورڈ ایمبیڈنگ، روٹری ایمبیڈنگ، RMSNorm، اور Swiglu ایکٹیویشن جیسے کچھ فیچرز کے نئے نفاذ کے ساتھ، ہم اس کا عام اسکرپٹ استعمال کرتے ہیں۔ جی پی ٹی نیوران Megatron-LM لاما 2 ٹریننگ اسکرپٹ کو سپورٹ کرنے کے لیے۔

ہمارا اعلیٰ سطحی تربیتی طریقہ کار حسب ذیل ہے: ہمارے تربیتی ماحول کے لیے، ہم NeMo فریم ورک کے تحت تقسیم شدہ تربیت اور شیڈولنگ کے لیے SLURM سسٹم کے زیر انتظام ایک کثیر المثال کلسٹر استعمال کرتے ہیں۔

سب سے پہلے، Llama 2 ماڈل اور ٹریننگ ڈیٹا سیٹس ڈاؤن لوڈ کریں اور Llama 2 ٹوکنائزر کا استعمال کرتے ہوئے ان پر پہلے سے عمل کریں۔ مثال کے طور پر، RedPajama ڈیٹاسیٹ استعمال کرنے کے لیے، درج ذیل کمانڈ کا استعمال کریں:

ماڈلز کو ڈاؤن لوڈ کرنے کی تفصیلی رہنمائی اور پری پروسیسنگ اسکرپٹ کی دلیل کے لیے، رجوع کریں۔ LlamaV2 ڈیٹاسیٹ اور ٹوکنائزر ڈاؤن لوڈ کریں۔.

اگلا، ماڈل مرتب کریں:

ماڈل کے مرتب ہونے کے بعد، تربیتی جاب کو درج ذیل اسکرپٹ کے ساتھ شروع کریں جو پہلے سے ہی بہترین کنفیگریشن اور Llama 2 (مثال کے کوڈ میں شامل) کے لیے ہائپر پیرامیٹر کے ساتھ بہتر ہے۔

آخر میں، ہم تربیت کی پیشرفت پر نظر رکھنے کے لیے TensorBoard کی نگرانی کرتے ہیں:

مکمل مثال کے کوڈ اور اسکرپٹس کے لیے جن کا ہم نے ذکر کیا ہے، Llama 7B سے رجوع کریں۔ سبق اور NeMo کوڈ مزید تفصیلی مراحل سے گزرنے کے لیے نیوران SDK میں۔

فائن ٹیوننگ کے تجربات

ہم نے نیورون 7 ماحول (PyTorch) میں OSCAR (Open Super-large Crawled ALMAnaCH coRpus) اور QNLI (سوال جواب دینے والے NLI) ڈیٹاسیٹس پر 2.12B ماڈل کو ٹھیک بنایا ہے۔ ہر 2,000 اور 4,000 ترتیب کی لمبائی کے لیے، ہم نے کچھ کنفیگریشنز کو بہتر بنایا، جیسے batchsize اور gradient_accumulation، تربیت کی کارکردگی کے لیے۔ فائن ٹیوننگ کی حکمت عملی کے طور پر، ہم نے تمام پیرامیٹرز (تقریباً 500 مراحل) کی مکمل فائن ٹیوننگ کو اپنایا، جسے طویل مراحل اور بڑے ڈیٹا سیٹس (مثال کے طور پر، 1T RedPajama) کے ساتھ پری ٹریننگ تک بڑھایا جا سکتا ہے۔ NeMo Megatron کو 4,000 کی بڑی ترتیب کی لمبائی والے ماڈلز کو کامیابی کے ساتھ ٹھیک کرنے کی اجازت دینے کے لیے ترتیب کی ہم آہنگی کو بھی فعال کیا جا سکتا ہے۔ مندرجہ ذیل جدول Llama 7B فائن ٹیوننگ تجربے کی ترتیب اور تھرو پٹ نتائج دکھاتا ہے۔ تھرو پٹ پیمانہ تقریباً لکیری طور پر ہوتا ہے کیونکہ مثالوں کی تعداد 4 تک بڑھ جاتی ہے۔

| تقسیم شدہ لائبریری | ڈیٹا سیٹ | تسلسل کی لمبائی | مثالوں کی تعداد | ٹینسر متوازی | ڈیٹا متوازی | پائپ لائن متوازی | عالمی بیچ کا سائز | تھرو پٹ (sq/s) |

| نیوران NeMo Megatron | آسکر | 4096 | 1 | 8 | 4 | 1 | 256 | 3.7 |

| . | . | 4096 | 2 | 8 | 4 | 1 | 256 | 7.4 |

| . | . | 4096 | 4 | 8 | 4 | 1 | 256 | 14.6 |

| . | کیو این ایل آئی | 4096 | 4 | 8 | 4 | 1 | 256 | 14.1 |

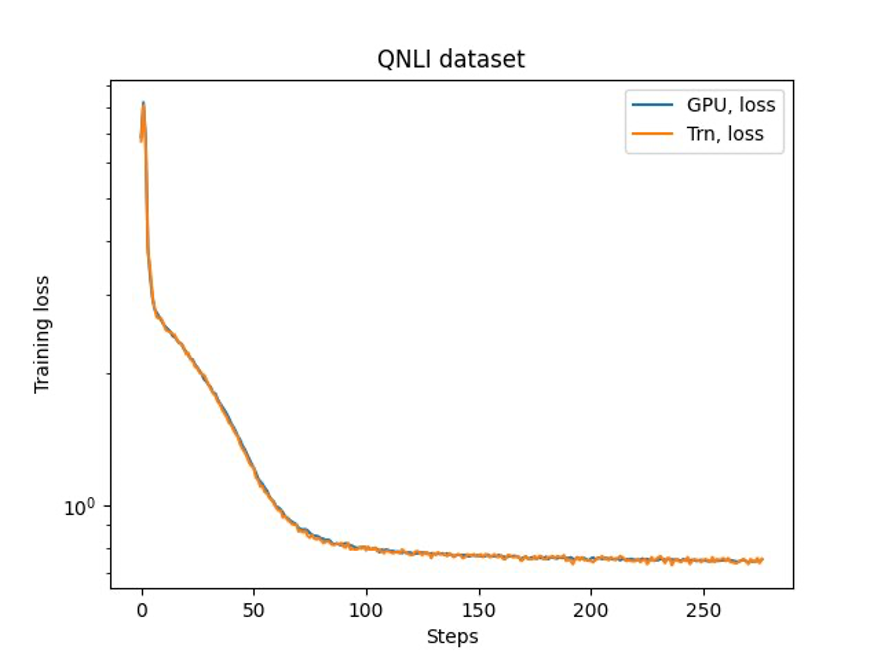

آخری مرحلہ بیس ماڈل کے ساتھ درستگی کی تصدیق کرنا ہے۔ ہم نے GPU تجربات کے لیے ایک حوالہ اسکرپٹ نافذ کیا اور GPU اور Trainium کے لیے تربیتی منحنی خطوط کی تصدیق کی جیسا کہ مندرجہ ذیل تصویر میں دکھایا گیا ہے۔ اعداد و شمار QNLI ڈیٹاسیٹ پر تربیتی مراحل کی تعداد پر نقصان کے منحنی خطوط کو واضح کرتا ہے۔ GPU (نیلا) اور bf16 کے لیے مخلوط درستگی کو ٹرینیم (اورینج) کے لیے ڈیفالٹ اسٹاکسٹک راؤنڈنگ کے ساتھ اپنایا گیا تھا۔

نتیجہ

اس پوسٹ میں، ہم نے دکھایا کہ ٹرینیئم لاما 2 کی اعلیٰ کارکردگی اور لاگت پر فائن ٹیوننگ فراہم کرتا ہے۔ ٹرینیئم کے استعمال سے متعلق مزید وسائل کے لیے تقسیم شدہ پری ٹریننگ اور NeMo Megatron کا استعمال کرتے ہوئے اپنے AI ماڈلز کو ٹھیک کرنے کے لیے، ملاحظہ کریں۔ NeMo Megatron کے لیے AWS نیوران حوالہ.

مصنفین کے بارے میں

ہاؤ چاؤ ایمیزون سیج میکر کے ساتھ ایک ریسرچ سائنٹسٹ ہے۔ اس سے پہلے، اس نے ایمیزون فراڈ ڈیٹیکٹر کے لیے فراڈ کا پتہ لگانے کے لیے مشین لرننگ کے طریقے تیار کرنے پر کام کیا۔ وہ حقیقی دنیا کے مختلف مسائل پر مشین لرننگ، آپٹیمائزیشن، اور جنریٹیو AI تکنیکوں کو لاگو کرنے کے بارے میں پرجوش ہے۔ انہوں نے نارتھ ویسٹرن یونیورسٹی سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔

ہاؤ چاؤ ایمیزون سیج میکر کے ساتھ ایک ریسرچ سائنٹسٹ ہے۔ اس سے پہلے، اس نے ایمیزون فراڈ ڈیٹیکٹر کے لیے فراڈ کا پتہ لگانے کے لیے مشین لرننگ کے طریقے تیار کرنے پر کام کیا۔ وہ حقیقی دنیا کے مختلف مسائل پر مشین لرننگ، آپٹیمائزیشن، اور جنریٹیو AI تکنیکوں کو لاگو کرنے کے بارے میں پرجوش ہے۔ انہوں نے نارتھ ویسٹرن یونیورسٹی سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔

کارتک گوپالسوامی AWS کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ AWS سے پہلے، اس نے Uber اور Walmart Labs میں ایک سائنسدان کے طور پر کام کیا جس میں مکسڈ انٹیجر آپٹیمائزیشن پر توجہ دی گئی۔ Uber میں، اس نے آن ڈیمانڈ SaaS پروڈکٹس اور مشترکہ سواریوں کے ساتھ پبلک ٹرانزٹ نیٹ ورک کو بہتر بنانے پر توجہ دی۔ والمارٹ لیبز میں، اس نے قیمتوں کے تعین اور پیکنگ کی اصلاح پر کام کیا۔ کارتھک نے نارتھ کیرولینا اسٹیٹ یونیورسٹی سے آپریشنز ریسرچ میں نابالغ کے ساتھ صنعتی اور سسٹمز انجینئرنگ میں پی ایچ ڈی کی ہے۔ اس کی تحقیق ان ماڈلز اور طریقہ کار پر مرکوز ہے جو آپریشن ریسرچ اور مشین لرننگ کو یکجا کرتے ہیں۔

کارتک گوپالسوامی AWS کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ AWS سے پہلے، اس نے Uber اور Walmart Labs میں ایک سائنسدان کے طور پر کام کیا جس میں مکسڈ انٹیجر آپٹیمائزیشن پر توجہ دی گئی۔ Uber میں، اس نے آن ڈیمانڈ SaaS پروڈکٹس اور مشترکہ سواریوں کے ساتھ پبلک ٹرانزٹ نیٹ ورک کو بہتر بنانے پر توجہ دی۔ والمارٹ لیبز میں، اس نے قیمتوں کے تعین اور پیکنگ کی اصلاح پر کام کیا۔ کارتھک نے نارتھ کیرولینا اسٹیٹ یونیورسٹی سے آپریشنز ریسرچ میں نابالغ کے ساتھ صنعتی اور سسٹمز انجینئرنگ میں پی ایچ ڈی کی ہے۔ اس کی تحقیق ان ماڈلز اور طریقہ کار پر مرکوز ہے جو آپریشن ریسرچ اور مشین لرننگ کو یکجا کرتے ہیں۔

ژن ہوانگ ایمیزون سیج میکر جمپ اسٹارٹ اور ایمیزون سیج میکر بلٹ ان الگورتھم کے سینئر اپلائیڈ سائنٹسٹ ہیں۔ وہ اسکیل ایبل مشین لرننگ الگورتھم تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کی تحقیقی دلچسپیاں قدرتی لینگویج پروسیسنگ، ٹیبلر ڈیٹا پر قابل وضاحت گہرائی سے سیکھنے، اور نان پیرامیٹرک اسپیس ٹائم کلسٹرنگ کے مضبوط تجزیہ کے شعبے میں ہیں۔ انہوں نے ACL، ICDM، KDD کانفرنسوں، اور رائل شماریاتی سوسائٹی: سیریز A میں بہت سے مقالے شائع کیے ہیں۔

ژن ہوانگ ایمیزون سیج میکر جمپ اسٹارٹ اور ایمیزون سیج میکر بلٹ ان الگورتھم کے سینئر اپلائیڈ سائنٹسٹ ہیں۔ وہ اسکیل ایبل مشین لرننگ الگورتھم تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کی تحقیقی دلچسپیاں قدرتی لینگویج پروسیسنگ، ٹیبلر ڈیٹا پر قابل وضاحت گہرائی سے سیکھنے، اور نان پیرامیٹرک اسپیس ٹائم کلسٹرنگ کے مضبوط تجزیہ کے شعبے میں ہیں۔ انہوں نے ACL، ICDM، KDD کانفرنسوں، اور رائل شماریاتی سوسائٹی: سیریز A میں بہت سے مقالے شائع کیے ہیں۔

ینگسک پارک AWS اناپورنا لیبز میں ایک سینئر اپلائیڈ سائنٹسٹ ہے، جو AI ایکسلریٹر پر فاؤنڈیشن ماڈل تیار کرنے اور تربیت دینے پر کام کر رہا ہے۔ اس سے پہلے، ڈاکٹر پارک نے AWS AI Labs میں Amazon Forecast کے لیے R&D پر ایک لیڈ سائنٹسٹ کے طور پر کام کیا۔ اس کی تحقیق مشین لرننگ، فاؤنڈیشنل ماڈلز، آپٹیمائزیشن، اور کمک سیکھنے کے درمیان تعامل میں مضمر ہے۔ انہوں نے ICLR، ICML، AISTATS، اور KDD سمیت سرفہرست مقامات پر 20 سے زیادہ ہم مرتبہ نظرثانی شدہ مقالے شائع کیے ہیں، ورکشاپ کے انعقاد اور ٹائم سیریز اور LLM ٹریننگ کے شعبے میں سبق پیش کرنے کی خدمت کے ساتھ۔ AWS میں شامل ہونے سے پہلے، انہوں نے سٹینفورڈ یونیورسٹی سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ڈگری حاصل کی۔

ینگسک پارک AWS اناپورنا لیبز میں ایک سینئر اپلائیڈ سائنٹسٹ ہے، جو AI ایکسلریٹر پر فاؤنڈیشن ماڈل تیار کرنے اور تربیت دینے پر کام کر رہا ہے۔ اس سے پہلے، ڈاکٹر پارک نے AWS AI Labs میں Amazon Forecast کے لیے R&D پر ایک لیڈ سائنٹسٹ کے طور پر کام کیا۔ اس کی تحقیق مشین لرننگ، فاؤنڈیشنل ماڈلز، آپٹیمائزیشن، اور کمک سیکھنے کے درمیان تعامل میں مضمر ہے۔ انہوں نے ICLR، ICML، AISTATS، اور KDD سمیت سرفہرست مقامات پر 20 سے زیادہ ہم مرتبہ نظرثانی شدہ مقالے شائع کیے ہیں، ورکشاپ کے انعقاد اور ٹائم سیریز اور LLM ٹریننگ کے شعبے میں سبق پیش کرنے کی خدمت کے ساتھ۔ AWS میں شامل ہونے سے پہلے، انہوں نے سٹینفورڈ یونیورسٹی سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ڈگری حاصل کی۔

ییڈا وانگ ایمیزون کی AWS AI ٹیم میں ایک پرنسپل سائنسدان ہیں۔ اس کی تحقیقی دلچسپی سسٹمز، اعلیٰ کارکردگی والے کمپیوٹنگ اور بڑے ڈیٹا اینالیٹکس میں ہے۔ وہ فی الحال گہرے سیکھنے کے نظام پر کام کرتا ہے، جس میں موثر تربیت اور اندازہ کے لیے گہری سیکھنے کے ماڈلز کو مرتب کرنے اور بہتر بنانے پر توجہ دی جاتی ہے، خاص طور پر بڑے پیمانے پر فاؤنڈیشن ماڈل۔ اس کا مشن مختلف فریم ورکس اور نچلے درجے کے ہارڈویئر پلیٹ فارمز سے اعلیٰ سطح کے ماڈلز بشمول CPUs، GPUs، اور AI ایکسلریٹرز کو جوڑنا ہے، تاکہ مختلف ماڈلز مختلف آلات پر اعلیٰ کارکردگی کے ساتھ چل سکیں۔

ییڈا وانگ ایمیزون کی AWS AI ٹیم میں ایک پرنسپل سائنسدان ہیں۔ اس کی تحقیقی دلچسپی سسٹمز، اعلیٰ کارکردگی والے کمپیوٹنگ اور بڑے ڈیٹا اینالیٹکس میں ہے۔ وہ فی الحال گہرے سیکھنے کے نظام پر کام کرتا ہے، جس میں موثر تربیت اور اندازہ کے لیے گہری سیکھنے کے ماڈلز کو مرتب کرنے اور بہتر بنانے پر توجہ دی جاتی ہے، خاص طور پر بڑے پیمانے پر فاؤنڈیشن ماڈل۔ اس کا مشن مختلف فریم ورکس اور نچلے درجے کے ہارڈویئر پلیٹ فارمز سے اعلیٰ سطح کے ماڈلز بشمول CPUs، GPUs، اور AI ایکسلریٹرز کو جوڑنا ہے، تاکہ مختلف ماڈلز مختلف آلات پر اعلیٰ کارکردگی کے ساتھ چل سکیں۔

جون (لیوک) ہوان AWS AI لیبز میں پرنسپل سائنٹسٹ ہیں۔ ڈاکٹر ہوان AI اور ڈیٹا سائنس پر کام کرتے ہیں۔ انہوں نے معروف کانفرنسوں اور جرائد میں 160 سے زیادہ ہم مرتبہ نظرثانی شدہ مقالے شائع کیے ہیں اور 11 پی ایچ ڈی طلباء کو گریجویشن کیا ہے۔ وہ 2009 میں NSF فیکلٹی ارلی کیرئیر ڈیولپمنٹ ایوارڈ کے وصول کنندہ تھے۔ AWS میں شامل ہونے سے پہلے، انہوں نے Baidu Research میں ایک ممتاز سائنسدان اور Baidu Big Data Laboratory کے سربراہ کے طور پر کام کیا۔ اس نے StylingAI Inc. کی بنیاد رکھی، جو ایک AI اسٹارٹ اپ ہے، اور 2019-2021 میں بطور CEO اور چیف سائنٹسٹ کام کیا۔ انڈسٹری میں شامل ہونے سے پہلے، وہ کنساس یونیورسٹی میں EECS ڈیپارٹمنٹ میں چارلس ای اور میری جین سپہر پروفیسر تھے۔ 2015-2018 تک، اس نے US NSF میں اس کے بڑے ڈیٹا پروگرام کے انچارج کے بطور پروگرام ڈائریکٹر کام کیا۔

جون (لیوک) ہوان AWS AI لیبز میں پرنسپل سائنٹسٹ ہیں۔ ڈاکٹر ہوان AI اور ڈیٹا سائنس پر کام کرتے ہیں۔ انہوں نے معروف کانفرنسوں اور جرائد میں 160 سے زیادہ ہم مرتبہ نظرثانی شدہ مقالے شائع کیے ہیں اور 11 پی ایچ ڈی طلباء کو گریجویشن کیا ہے۔ وہ 2009 میں NSF فیکلٹی ارلی کیرئیر ڈیولپمنٹ ایوارڈ کے وصول کنندہ تھے۔ AWS میں شامل ہونے سے پہلے، انہوں نے Baidu Research میں ایک ممتاز سائنسدان اور Baidu Big Data Laboratory کے سربراہ کے طور پر کام کیا۔ اس نے StylingAI Inc. کی بنیاد رکھی، جو ایک AI اسٹارٹ اپ ہے، اور 2019-2021 میں بطور CEO اور چیف سائنٹسٹ کام کیا۔ انڈسٹری میں شامل ہونے سے پہلے، وہ کنساس یونیورسٹی میں EECS ڈیپارٹمنٹ میں چارلس ای اور میری جین سپہر پروفیسر تھے۔ 2015-2018 تک، اس نے US NSF میں اس کے بڑے ڈیٹا پروگرام کے انچارج کے بطور پروگرام ڈائریکٹر کام کیا۔

شروتی کوپارکر AWS میں ایک سینئر پروڈکٹ مارکیٹنگ مینیجر ہے۔ وہ صارفین کو ان کی مشین لرننگ کی ضروریات کے لیے Amazon EC2 ایکسلریٹڈ کمپیوٹنگ انفراسٹرکچر کو دریافت کرنے، جانچنے اور اپنانے میں مدد کرتی ہے۔

شروتی کوپارکر AWS میں ایک سینئر پروڈکٹ مارکیٹنگ مینیجر ہے۔ وہ صارفین کو ان کی مشین لرننگ کی ضروریات کے لیے Amazon EC2 ایکسلریٹڈ کمپیوٹنگ انفراسٹرکچر کو دریافت کرنے، جانچنے اور اپنانے میں مدد کرتی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/fast-and-cost-effective-llama-2-fine-tuning-with-aws-trainium/

- : ہے

- : ہے

- $UP

- 000

- 1

- 100

- 11

- 12

- 13

- 160

- 20

- 500

- 7

- 70

- 8

- a

- ہمارے بارے میں

- تیز

- مسرع

- ایکسلریٹر

- ایڈجسٹ کریں

- درستگی

- کے پار

- چالو کرنے کی

- انہوں نے مزید کہا

- اپنانے

- اپنایا

- ایجنٹ

- AI

- اے آئی ماڈلز

- یلگوردمز

- تمام

- کی اجازت

- تقریبا

- پہلے ہی

- بھی

- ایمیزون

- ایمیزون EC2

- ایمیزون کی پیشن گوئی

- ایمیزون فراڈ ڈیٹیکٹر

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- an

- تجزیہ

- تجزیاتی

- اور

- ایپلی کیشنز

- اطلاقی

- درخواست دینا

- فن تعمیر

- کیا

- رقبہ

- دلیل

- AS

- اسسٹنٹ

- At

- توجہ

- ایوارڈ

- AWS

- بیدو

- بیس

- BE

- رہا

- اس سے پہلے

- BEST

- کے درمیان

- بگ

- بگ ڈیٹا

- ارب

- بلیو

- دونوں

- پل

- تعمیر میں

- by

- کر سکتے ہیں

- پر قبضہ کر لیا

- کیریئر کے

- سی ای او

- چارج

- چارلس

- چیف

- کلسٹر

- clustering کے

- کوڈ

- کوڈنگ

- جمع

- آتا ہے

- تجارتی

- مقابلے میں

- مکمل

- کمپیوٹنگ

- کانفرنسوں

- ترتیب

- منسلک

- مواد

- مواد کی تخلیق

- سیاق و سباق

- سنوادی

- سرمایہ کاری مؤثر

- اخراجات

- مخلوق

- اس وقت

- وکر

- گاہک

- کسٹمر سپورٹ

- گاہکوں

- اعداد و شمار

- ڈیٹا تجزیات

- ڈیٹا سائنس

- ڈیٹاسیٹس

- گہری

- گہری سیکھنے

- پہلے سے طے شدہ

- فراہم کرتا ہے

- شعبہ

- تفصیلی

- کھوج

- ڈویلپرز

- ترقی

- ترقی

- کے الات

- مختلف

- ڈائریکٹر

- جانبدار

- تقسیم کئے

- تقسیم کی تربیت

- شکست

- ڈاؤن لوڈ، اتارنا

- dr

- e

- ہر ایک

- ابتدائی

- کارکردگی

- ہنر

- سرایت کرنا

- چالو حالت میں

- انجنیئرنگ

- اداروں

- کاروباری افراد

- ماحولیات

- خاص طور پر

- اندازہ

- مثال کے طور پر

- ایگزیکٹوز

- تجربہ

- تجربات

- تلاش

- فاسٹ

- خصوصیات

- اعداد و شمار

- توجہ مرکوز

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- مندرجہ ذیل ہے

- کے لئے

- پیشن گوئی

- فاؤنڈیشن

- قائم

- فریم ورک

- فریم ورک

- دھوکہ دہی

- فراڈ کا پتہ لگانے

- سے

- مکمل

- پیداواری

- پیداواری AI۔

- GPU

- GPUs

- رہنمائی

- ہارڈ ویئر

- ہے

- he

- سر

- مدد کرتا ہے

- ہائی

- اعلی سطحی

- اعلی کارکردگی

- ان

- کی ڈگری حاصل کی

- کس طرح

- کیسے

- HTML

- HTTPS

- انسانی

- وضاحت کرتا ہے

- تخیل

- نفاذ

- عملدرآمد

- in

- انکارپوریٹڈ

- شامل

- سمیت

- اضافہ

- صنعتی

- صنعتوں

- صنعت

- انفراسٹرکچر

- دلچسپی

- مفادات

- IT

- میں

- جانے

- ایوب

- شمولیت

- فوٹو

- کینساس

- رکھیں

- تجربہ گاہیں

- لیبز

- زبان

- بڑے پیمانے پر

- بڑے

- آخری

- شروع

- قیادت

- معروف

- سیکھنے

- لمبائی

- جھوٹ ہے

- کی طرح

- لسٹ

- لاما

- ایل ایل ایم

- اب

- بند

- مشین

- مشین لرننگ

- اہم

- میں کامیاب

- مینیجر

- بہت سے

- مارکیٹنگ

- ملا

- ذکر کیا

- میٹا

- طریقوں

- طریقوں

- دس لاکھ

- معمولی

- مشن

- مخلوط

- ماڈل

- ماڈل

- کی نگرانی

- زیادہ

- قدرتی

- قدرتی زبان عملیات

- ضروریات

- نیٹ ورک

- نئی

- شمالی

- شمالی کیرولائنا

- NSF

- تعداد

- NVIDIA

- حاصل کی

- of

- on

- ڈیمانڈ

- صرف

- کھول

- آپریشنز

- اصلاح کے

- اصلاح

- اصلاح

- اورنج

- منظم کرنا

- دیگر

- ہمارے

- پر

- کاغذات

- پیرامیٹرز

- پارک

- جذباتی

- ہم مرتبہ کا جائزہ لیا

- کارکردگی

- پی ایچ ڈی

- پائپ لائن

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوسٹ

- پچھلا

- قیمتوں کا تعین

- پرنسپل

- پہلے

- مسائل

- طریقہ کار

- پروسیسنگ

- مصنوعات

- حاصل

- ٹیچر

- پروگرام

- پیش رفت

- فراہم

- عوامی

- عوامی ٹرانزٹ

- شائع

- ازگر

- pytorch

- سوال

- آر اینڈ ڈی

- حقیقی دنیا

- کو کم

- کا حوالہ دیتے ہیں

- جاری

- تحقیق

- محققین

- وسائل

- نتائج کی نمائش

- کا جائزہ لینے کے

- مضبوط

- گول

- شاہی

- رن

- ساس

- sagemaker

- دیکھا

- توسیع پذیر

- ترازو

- شیڈولنگ

- سائنس

- سائنسدان

- سائنسدانوں

- اسکرپٹ

- سکرپٹ

- sdk

- سینئر

- تسلسل

- سیریز

- سیریز اے

- سروس

- سروسز

- کئی

- مشترکہ

- وہ

- سے ظاہر ہوا

- دکھایا گیا

- شوز

- سائز

- So

- سوسائٹی

- کچھ

- مخصوص

- اسٹینفورڈ

- اسٹینفورڈ یونیورسٹی

- شروع

- حالت

- شماریات

- مرحلہ

- مراحل

- حکمت عملی

- طلباء

- کامیابی کے ساتھ

- اس طرح

- حمایت

- کی حمایت کرتا ہے

- کے نظام

- سسٹمز

- ٹیبل

- ٹیم

- تکنیک

- تکنیکی ماہرین

- سے

- کہ

- ۔

- علاقہ

- ان

- ان

- یہ

- اس

- تین

- کے ذریعے

- تھرو پٹ

- وقت

- وقت کا سلسلہ

- اوقات

- کرنے کے لئے

- مل کر

- ٹوکن

- سب سے اوپر

- tp

- ٹریک

- تربیت یافتہ

- ٹریننگ

- ٹرانزٹ

- ترجمہ

- ٹریلین

- سبق

- Uber

- کے تحت

- یونیورسٹی

- us

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- استعمال

- کا استعمال کرتے ہوئے

- مختلف

- مقامات

- اس بات کی تصدیق

- چلنا

- Walmart

- تھا

- we

- ویب

- ویب خدمات

- جس

- ساتھ

- لفظ

- کام کیا

- کام کر

- کام کرتا ہے

- ورکشاپ

- اور

- زیفیرنیٹ