GPT-J ایک اوپن سورس 6-بلین پیرامیٹر ماڈل ہے جسے Eleuther AI نے جاری کیا ہے۔ ماڈل کو تربیت دی جاتی ہے۔ ڈھیر اور زبان کی پروسیسنگ میں مختلف کام انجام دے سکتے ہیں۔ یہ متن کی درجہ بندی، ٹوکن کی درجہ بندی، ٹیکسٹ جنریشن، سوال و جواب، ہستی نکالنے، خلاصہ، جذبات کا تجزیہ، اور بہت کچھ سمیت مختلف قسم کے استعمال کے معاملات کی حمایت کر سکتا ہے۔ GPT-J بین وانگ کا استعمال کرتے ہوئے تربیت یافتہ ٹرانسفارمر ماڈل ہے۔ میش ٹرانسفارمر JAX.

اس پوسٹ میں، ہم بڑے لینگویج ماڈلز (LLMs) کو استعمال کرتے ہوئے تربیت دینے کے لیے ایک گائیڈ اور بہترین طریقہ کار پیش کرتے ہیں۔ ایمیزون سیج میکر تربیت کے وقت اور لاگت کو کم کرنے کے لیے تقسیم شدہ ماڈل متوازی لائبریری۔ آپ سیکھیں گے کہ سیج میکر پر 6-بلین پیرامیٹر GPT-J ماڈل کو کس طرح آسانی سے تربیت دی جائے۔ آخر میں، ہم SageMaker کی تقسیم شدہ ماڈل کی ہم آہنگی کی اہم خصوصیات کا اشتراک کرتے ہیں جو تربیت کے وقت کو تیز کرنے میں مدد کرتی ہیں۔

ٹرانسفارمر نیورل نیٹ ورکس

ایک ٹرانسفارمر نیورل نیٹ ورک ترتیب سے ترتیب کے کاموں کو حل کرنے کے لیے ایک مقبول ڈیپ لرننگ فن تعمیر ہے۔ یہ استعمال کرتا ہے۔ توجہ انسانی سطح کی کارکردگی کے قریب حاصل کرنے کے لیے سیکھنے کے طریقہ کار کے طور پر۔ قدرتی لینگویج پروسیسنگ (NLP) ماڈلز کی پچھلی نسلوں کے مقابلے میں فن تعمیر کی کچھ دیگر مفید خصوصیات میں تقسیم کرنے کی صلاحیت، اسکیل اور پری ٹرین شامل ہیں۔ ٹرانسفارمرز پر مبنی ماڈلز کو استعمال کے مختلف معاملات میں لاگو کیا جا سکتا ہے جب ٹیکسٹ ڈیٹا، جیسے سرچ، چیٹ بوٹس، اور بہت کچھ سے نمٹتے ہیں۔ ٹرانسفارمرز بڑے ڈیٹا سیٹس سے ذہانت حاصل کرنے کے لیے پری ٹریننگ کے تصور کا استعمال کرتے ہیں۔ پہلے سے تربیت یافتہ ٹرانسفارمرز کو آپ کے ڈیٹا سیٹس پر اس طرح استعمال کیا جا سکتا ہے یا ٹھیک بنایا جا سکتا ہے، جو آپ کے کاروبار کے لیے بہت چھوٹا اور مخصوص ہو سکتا ہے۔

سیج میکر پر گلے لگانا چہرہ

Hugging Face ایک کمپنی ہے جو کچھ مقبول ترین اوپن سورس لائبریریاں تیار کرتی ہے جو ٹرانسفارمرز کے فن تعمیر پر مبنی جدید ترین NLP ٹیکنالوجی فراہم کرتی ہے۔ گلے ملنے والا چہرہ ٹرانسفارمرز, ٹوکنائزرز، اور ڈیٹاسیٹس لائبریریاں متعدد زبانوں میں پہلے سے تربیت یافتہ ماڈلز کا استعمال کرتے ہوئے ڈاؤن لوڈ اور پیش گوئی کرنے کے لیے APIs اور ٹولز فراہم کرتی ہیں۔ سیج میکر آپ کو اس سے براہ راست Hugging Face ماڈل کا استعمال کرتے ہوئے تربیت، ٹھیک ٹیون، اور اندازہ چلانے کے قابل بناتا ہے۔ گلے لگانا چہرہ ماڈل ہب کا استعمال کرتے ہوئے گلے لگاتے ہوئے چہرے کا تخمینہ لگانے والا میں سیج میکر SDK. انضمام ڈومین کے مخصوص استعمال کے معاملات پر Hugging Face ماڈلز کو اپنی مرضی کے مطابق بنانا آسان بناتا ہے۔ پردے کے پیچھے، SageMaker SDK AWS ڈیپ لرننگ کنٹینرز (DLCs) کا استعمال کرتا ہے، جو SageMaker کی طرف سے پیش کردہ ماڈلز کی تربیت اور پیش کرنے کے لیے پہلے سے تیار کردہ Docker امیجز کا ایک سیٹ ہیں۔ DLCs کو AWS اور Hugging Face کے درمیان تعاون کے ذریعے تیار کیا گیا ہے۔ انضمام کے درمیان انضمام بھی پیش کرتا ہے۔ گلے لگانا چہرہ ٹرانسفارمر SDK اور سیج میکر نے تربیتی لائبریریاں تقسیم کیں، آپ کو اپنی تربیتی ملازمتوں کو GPUs کے کلسٹر پر پیمانہ کرنے کے قابل بنانا۔

SageMaker تقسیم شدہ ماڈل متوازی لائبریری کا جائزہ

ماڈل متوازی ایک تقسیم شدہ تربیتی حکمت عملی ہے جو گہری سیکھنے کے ماڈل کو متعدد آلات پر، اندر یا تمام مثالوں میں تقسیم کرتی ہے۔ زیادہ پرتوں اور پیرامیٹرز والے ڈیپ لرننگ (DL) ماڈل کمپیوٹر وژن اور NLP جیسے پیچیدہ کاموں میں بہتر کارکردگی کا مظاہرہ کرتے ہیں۔ تاہم، زیادہ سے زیادہ ماڈل سائز جو کہ ایک GPU کی میموری میں محفوظ کیا جا سکتا ہے محدود ہے۔ مندرجہ ذیل طریقوں سے DL ماڈلز کی تربیت کے دوران GPU میموری کی رکاوٹیں رکاوٹیں ہو سکتی ہیں۔

- وہ ماڈل کے سائز کو محدود کرتے ہیں جسے تربیت دی جا سکتی ہے کیونکہ ماڈل کی میموری فوٹ پرنٹ پیرامیٹرز کی تعداد کے تناسب سے پیمانہ ہوتی ہے۔

- وہ تربیت کے دوران فی GPU بیچ سائز کو محدود کرکے GPU کے استعمال اور تربیت کی کارکردگی کو کم کرتے ہیں۔

SageMaker میں تقسیم شدہ ماڈل کی متوازی لائبریری شامل ہے تاکہ DL ماڈلز کو بہت سارے کمپیوٹ نوڈس میں موثر طریقے سے تقسیم کرنے اور تربیت دینے میں مدد ملے، ایک ہی GPU پر ماڈل کی تربیت سے منسلک پابندیوں پر قابو پاتے ہوئے مزید برآں، لائبریری آپ کو EFA سے تعاون یافتہ آلات کا استعمال کرتے ہوئے سب سے زیادہ تقسیم شدہ تربیت حاصل کرنے کی اجازت دیتی ہے، جو کم تاخیر، زیادہ تھرو پٹ، اور OS بائی پاس کے ساتھ انٹر نوڈ مواصلات کی کارکردگی کو بہتر بناتی ہے۔

چونکہ بڑے ماڈلز جیسے GPT-J، اربوں پیرامیٹرز کے ساتھ، GPU میموری فوٹ پرنٹ رکھتا ہے جو ایک چپ سے زیادہ ہوتا ہے، اس لیے انہیں متعدد GPUs میں تقسیم کرنا ضروری ہو جاتا ہے۔ SageMaker ماڈل متوازی (SMP) لائبریری متعدد GPUs میں ماڈلز کی خودکار تقسیم کو قابل بناتی ہے۔ SageMaker ماڈل کے متوازی کے ساتھ، SageMaker آپ کی جانب سے ماڈل کی کمپیوٹ اور میموری کی ضروریات کا تجزیہ کرنے کے لیے ایک ابتدائی پروفائلنگ کا کام چلاتا ہے۔ اس معلومات کو پھر یہ فیصلہ کرنے کے لیے استعمال کیا جاتا ہے کہ ماڈل کو GPUs میں کس طرح تقسیم کیا گیا ہے، تاکہ کسی مقصد کو زیادہ سے زیادہ حاصل کیا جا سکے، جیسے کہ رفتار کو زیادہ سے زیادہ کرنا یا میموری فوٹ پرنٹ کو کم کرنا۔

یہ دستیاب GPUs کے مجموعی استعمال کو زیادہ سے زیادہ کرنے کے لیے اختیاری پائپ لائن چلانے کے شیڈولنگ کی بھی حمایت کرتا ہے۔ فارورڈ پاس کے دوران ایکٹیویشن کے پھیلاؤ اور بیکورڈ پاس کے دوران گریڈینٹ کے لیے ترتیب وار حساب کی ضرورت ہوتی ہے، جو GPU کے استعمال کی مقدار کو محدود کرتی ہے۔ SageMaker مختلف GPUs پر متوازی طور پر کارروائی کرنے کے لیے چھوٹے بیچوں کو مائیکرو بیچوں میں تقسیم کرکے پائپ لائن چلانے کے شیڈول کو استعمال کرتے ہوئے ترتیب وار کمپیوٹیشن کی رکاوٹ پر قابو پاتا ہے۔ سیج میکر ماڈل کی ہم آہنگی پائپ لائن چلانے کے دو طریقوں کی حمایت کرتی ہے:

- سادہ پائپ لائن - یہ موڈ بیکورڈ پاس شروع کرنے سے پہلے ہر مائیکرو بیچ کے لیے فارورڈ پاس کو ختم کرتا ہے۔

- انٹرلیوڈ پائپ لائن - اس موڈ میں، جب بھی ممکن ہو مائیکرو بیچوں کے پسماندہ رن کو ترجیح دی جاتی ہے۔ یہ ایکٹیویشن کے لیے استعمال ہونے والی میموری کو تیزی سے ریلیز کرنے کی اجازت دیتا ہے، اس طرح میموری کو زیادہ موثر طریقے سے استعمال کیا جا سکتا ہے۔

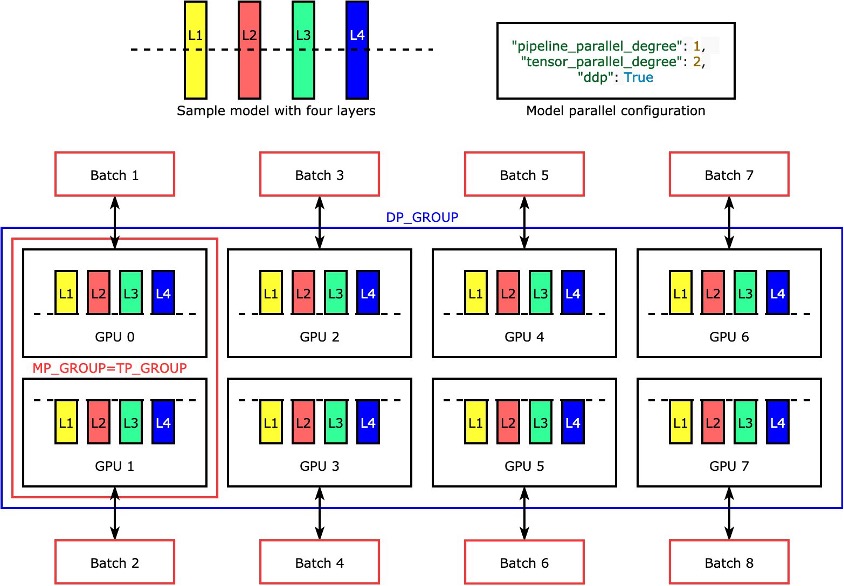

ٹینسر متوازی

انفرادی پرتیں، یاnn.Modules، ٹینسر متوازی کا استعمال کرتے ہوئے آلات میں تقسیم کیا جاتا ہے تاکہ وہ بیک وقت چل سکیں۔ اس کی سب سے آسان مثال کہ لائبریری کس طرح ماڈل کو چار تہوں کے ساتھ تقسیم کرتی ہے تاکہ دو طرفہ ٹینسر متوازی ("tensor_parallel_degree": 2) مندرجہ ذیل تصویر میں دکھایا گیا ہے۔ ہر ماڈل کی نقل کی تہوں کو دو حصوں میں تقسیم کیا جاتا ہے (نصف میں تقسیم کیا جاتا ہے) اور دو GPUs کے درمیان تقسیم کیا جاتا ہے۔ اعداد و شمار کے متوازی کی ڈگری اس مثال میں آٹھ ہے کیونکہ ماڈل متوازی ترتیب میں اضافی طور پر شامل ہے۔ "pipeline_parallel_degree": 1 اور "ddp": True. لائبریری ٹینسر سے تقسیم شدہ ماڈل کی نقلوں کے درمیان مواصلات کا انتظام کرتی ہے۔

اس خصوصیت کا فائدہ یہ ہے کہ آپ یہ منتخب کر سکتے ہیں کہ آپ کونسی پرتیں یا تہوں کے کون سے ذیلی سیٹ پر آپ ٹینسر متوازی لاگو کرنا چاہتے ہیں۔ PyTorch کے لیے ٹینسر کے متوازی اور میموری کی بچت کی دیگر خصوصیات میں گہرائی میں ڈوبنے کے لیے، اور یہ سیکھنے کے لیے کہ پائپ لائن اور ٹینسر کے متوازی کے امتزاج کو کیسے ترتیب دیا جائے، دیکھیں PyTorch کے لیے SageMaker ماڈل متوازی لائبریری کی توسیعی خصوصیات.

سیج میکر نے ڈیٹا کی ہم آہنگی کو تیز کیا۔

Sharded data parallelism ایک میموری کو بچانے والی تقسیم شدہ تربیتی تکنیک ہے جو ایک ماڈل کی تربیتی حالت (ماڈل پیرامیٹرز، گریڈیئنٹس، اور آپٹیمائزر اسٹیٹس) کو ڈیٹا کے متوازی گروپ میں GPUs میں تقسیم کرتی ہے۔

اپنے تربیتی کام کو بڑے GPU کلسٹر تک بڑھاتے وقت، آپ متعدد GPUs پر ٹریننگ سٹیٹ کو شارڈ کر کے ماڈل کے فی GPU میموری فوٹ پرنٹ کو کم کر سکتے ہیں۔ اس سے دو فائدے ملتے ہیں: آپ بڑے ماڈلز کو فٹ کر سکتے ہیں، جو بصورت دیگر معیاری ڈیٹا متوازی کے ساتھ میموری ختم ہو جائے گا، یا آپ آزاد GPU میموری کا استعمال کرتے ہوئے بیچ کا سائز بڑھا سکتے ہیں۔

معیاری ڈیٹا متوازی تکنیک ڈیٹا کے متوازی گروپ میں GPUs میں تربیتی ریاستوں کی نقل تیار کرتی ہے اور AllReduce آپریشن کی بنیاد پر گریڈینٹ ایگریگیشن کرتی ہے۔ درحقیقت، شارڈڈ ڈیٹا کی ہم آہنگی کمیونیکیشن اوور ہیڈ اور GPU میموری کی کارکردگی کے درمیان تجارت کو متعارف کراتی ہے۔ شارڈڈ ڈیٹا متوازی استعمال کرنے سے کمیونیکیشن لاگت میں اضافہ ہوتا ہے، لیکن میموری فوٹ پرنٹ فی GPU (ایکٹیویشنز کی وجہ سے میموری کے استعمال کو چھوڑ کر) شارڈڈ ڈیٹا متوازی ڈگری سے تقسیم ہوتا ہے، اس لیے بڑے ماڈلز GPU کلسٹر میں فٹ ہو سکتے ہیں۔

سیج میکر ایم آئی سی ایس کے نفاذ کے ذریعے شارڈڈ ڈیٹا کی ہم آہنگی کو نافذ کرتا ہے۔ مزید معلومات کے لیے دیکھیں AWS پر بہت بڑا ماڈل ٹریننگ کی قریبی لکیری اسکیلنگ.

کا حوالہ دیتے ہیں مشترکہ ڈیٹا متوازی اپنی تربیتی ملازمتوں میں شارڈڈ ڈیٹا کے متوازی طریقہ کو لاگو کرنے کے بارے میں مزید تفصیلات کے لیے۔

SageMaker ماڈل متوازی لائبریری کا استعمال کریں۔

SageMaker ماڈل کی متوازی لائبریری SageMaker Python SDK کے ساتھ آتی ہے۔ لائبریری کو استعمال کرنے کے لیے آپ کو SageMaker Python SDK انسٹال کرنے کی ضرورت ہے، اور یہ SageMaker نوٹ بک کرنل پر پہلے ہی انسٹال ہے۔ اپنی PyTorch ٹریننگ اسکرپٹ کو SMP لائبریری کی صلاحیتوں کو بروئے کار لانے کے لیے، آپ کو درج ذیل تبدیلیاں کرنے کی ضرورت ہے:

- سٹریٹ کو درآمد اور شروع کرکے

smpکا استعمال کرتے ہوئے لائبریریsmp.init()کال کریں۔ - ایک بار اس کے شروع ہونے کے بعد، آپ اپنے ماڈل کو اس کے ساتھ لپیٹ سکتے ہیں۔

smp.DistributedModelریپر اور واپس کا استعمال کریںDistributedModelصارف ماڈل کے بجائے اعتراض۔ - اپنی اصلاح کی حالت کے لیے، استعمال کریں۔

smp.DistributedOptimizerآپ کے ماڈل آپٹیمائزر کے ارد گرد ریپر، چالو کرناsmpآپٹیمائزر کی حالت کو بچانے اور لوڈ کرنے کے لیے۔ فارورڈ اور بیک ورڈ پاس منطق کو ایک الگ فنکشن کے طور پر خلاصہ کیا جا سکتا ہے اور a کا اضافہ کیا جا سکتا ہے۔smp.stepفنکشن کے لیے ڈیکوریٹر۔ بنیادی طور پر، فارورڈ پاس اور بیک پروپیگیشن کو فنکشن کے اندر کے ساتھ چلانے کی ضرورت ہے۔smp.stepاس کے اوپر ڈیکوریٹر رکھا۔ یہ اجازت دیتا ہے۔smpفنکشن میں ٹینسر ان پٹ کو متعدد مائیکرو بیچز میں تقسیم کرنے کے لیے جو ٹریننگ جاب شروع کرتے وقت مخصوص کیے گئے ہیں۔ - اگلا، ہم ان پٹ ٹینسرز کو موجودہ عمل کے ذریعے استعمال ہونے والے GPU میں منتقل کر سکتے ہیں۔

torch.cuda.set_deviceAPI کے بعد.to()API کال۔ - آخر میں، بیک پروپیگنڈہ کے لیے، ہم بدل دیتے ہیں۔

torch.Tensor.backwardاورtorch.autograd.backward.

درج ذیل کوڈ دیکھیں:

سیج میکر ماڈل متوازی لائبریری کی ٹینسر متوازی پیش کش کرتا ہے۔ آؤٹ آف دی باکس سپورٹ مندرجہ ذیل ہیگنگ فیس ٹرانسفارمر ماڈلز کے لیے:

- GPT-2, برٹ، اور RoBERTa (SMP لائبریری v1.7.0 اور بعد میں دستیاب)

- GPT-J (ایس ایم پی لائبریری v1.8.0 اور بعد میں دستیاب)

- GPT-Neo (SMP لائبریری v1.10.0 اور بعد میں دستیاب ہے)

SMP لائبریری کے ساتھ پرفارمنس ٹیوننگ کے لیے بہترین طریقے

بڑے ماڈلز کی تربیت کرتے وقت، درج ذیل اقدامات پر غور کریں تاکہ آپ کا ماڈل مناسب بیچ سائز کے ساتھ GPU میموری میں فٹ ہو جائے۔

- کارکردگی کے لیے اعلیٰ GPU میموری اور اعلی بینڈوتھ انٹرکنیکٹ کے ساتھ مثالیں استعمال کرنے کی سفارش کی جاتی ہے، جیسے p4d اور p4de مثالیں۔

- آپٹیمائزر سٹیٹ شارڈنگ زیادہ تر معاملات میں فعال کیا جا سکتا ہے، اور اس وقت مددگار ثابت ہو گا جب آپ کے پاس ماڈل کی ایک سے زیادہ کاپیاں ہوں (ڈیٹا متوازی فعال)۔ آپ ترتیب دے کر آپٹیمائزر اسٹیٹ شارڈنگ کو آن کر سکتے ہیں۔

"shard_optimizer_state": Trueمیںmodelparallelترتیب - استعمال ایکٹیویشن چیک پوائنٹنگ، ماڈل میں منتخب ماڈیولز کے پسماندہ پاس کے دوران کچھ تہوں کی ایکٹیویشن کو صاف کرکے اور ان کی دوبارہ گنتی کرکے میموری کے استعمال کو کم کرنے کی ایک تکنیک۔

- استعمال ایکٹیویشن آف لوڈنگ، ایک اضافی خصوصیت جو میموری کے استعمال کو مزید کم کر سکتی ہے۔ ایکٹیویشن آف لوڈنگ استعمال کرنے کے لیے سیٹ کریں۔

"offload_activations": Trueمیںmodelparallelترتیب اس وقت استعمال کریں جب ایکٹیویشن چیک پوائنٹ اور پائپ لائن کے متوازی آن ہوں اور مائیکرو بیچز کی تعداد ایک سے زیادہ ہو۔ - فعال کریں ٹینسر متوازی اور متوازی ڈگریوں میں اضافہ کریں جہاں ڈگری 2 کی طاقت ہوتی ہے۔ عام طور پر کارکردگی کی وجوہات کی بناء پر، ٹینسر کی متوازی نوڈ کے اندر تک محدود ہوتی ہے۔

ہم نے SMP لائبریری کے ساتھ SageMaker پر GPT-J کی تربیت اور ٹیوننگ کو بہتر بنانے کے لیے بہت سے تجربات کیے ہیں۔ ہم نے سیج میکر پر ایک دور کے لیے GPT-J ٹریننگ ٹائم کو 58 منٹ سے کم کر کے 10 منٹ سے کم کرنے میں کامیاب ہو گئے ہیں — ہر دور میں چھ گنا تیز ٹریننگ ٹائم۔ اس سے ابتداء، ماڈل اور ڈیٹاسیٹ ڈاؤن لوڈ ہوا۔ ایمیزون سادہ اسٹوریج سروس (Amazon S3) ایک منٹ سے بھی کم، 1 منٹ سے بھی کم ٹریسنگ ڈیوائس کے طور پر GPU کے ساتھ ٹریسنگ اور آٹو پارٹیشننگ، اور ایک ml.p8d.4xlarge مثال، FP24 درستگی، اور ایک SageMaker Hugging Face پر ٹینسر کے ہم آہنگی کا استعمال کرتے ہوئے 16 منٹ کی تربیت۔ تخمینہ لگانے والا

بہترین مشق کے طور پر تربیت کے وقت کو کم کرنے کے لیے، SageMaker پر GPT-J کو تربیت دیتے وقت، ہم درج ذیل کی سفارش کرتے ہیں:

- اپنے پہلے سے تربیت یافتہ ماڈل کو Amazon S3 پر اسٹور کریں۔

- FP16 درستگی استعمال کریں۔

- GPU کو ٹریسنگ ڈیوائس کے طور پر استعمال کریں۔

- خودکار تقسیم کا استعمال کریں، ایکٹیویشن چیک پوائنٹنگ، اور آپٹیمائزر اسٹیٹ شارڈنگ:

auto_partition: Trueshard_optimizer_state: True

- ٹینسر متوازی استعمال کریں۔

- متعدد GPUs جیسے ml.p3.16xlarge, ml.p3dn.24xlarge, ml.g5.48xlarge, ml.p4d.24xlarge، یا ml.p4de.24xlarge کے ساتھ SageMaker ٹریننگ مثال استعمال کریں۔

SMP لائبریری کے ساتھ SageMaker پر GPT-J ماڈل کی تربیت اور ٹیوننگ

ایک کام کرنے والا مرحلہ وار کوڈ نمونہ پر دستیاب ہے۔ ایمیزون سیج میکر کی مثالیں۔ عوامی ذخیرہ. پر نیویگیٹ کریں۔ training/distributed_training/pytorch/model_parallel/gpt-j فولڈر. منتخب کریں gpt-j فولڈر کھولیں اور کھولیں۔ train_gptj_smp_tensor_parallel_notebook.jpynb ٹینسر کے متوازی مثال کے لیے Jupyter نوٹ بک اور train_gptj_smp_notebook.ipynb پائپ لائن کے متوازی مثال کے لیے۔ آپ ہمارے میں کوڈ واک تھرو تلاش کر سکتے ہیں۔ ایمیزون سیج میکر ورکشاپ پر جنریٹو اے آئی.

یہ نوٹ بک آپ کو بتاتی ہے کہ سیج میکر ماڈل متوازی لائبریری کے ذریعہ فراہم کردہ ٹینسر متوازی خصوصیات کو کیسے استعمال کیا جائے۔ آپ GLUE sst16 ڈیٹاسیٹ پر ٹینسر متوازی اور پائپ لائن کے متوازی کے ساتھ GPT-J ماڈل کی FP2 ٹریننگ کو چلانے کا طریقہ سیکھیں گے۔

خلاصہ

SageMaker ماڈل متوازی لائبریری کئی افعال پیش کرتی ہے۔ آپ لاگت کو کم کر سکتے ہیں اور سیج میکر پر ایل ایل ایم کی تربیت کو تیز کر سکتے ہیں۔ آپ BERT، GPT-2، اور GPT-J کے نمونے کوڈز بھی سیکھ سکتے ہیں اور چلا سکتے ہیں۔ ایمیزون سیج میکر کی مثالیں۔ عوامی ذخیرہ. SMP لائبریری کا استعمال کرتے ہوئے LLMS کی تربیت کے لیے AWS کے بہترین طریقوں کے بارے میں مزید جاننے کے لیے، درج ذیل وسائل سے رجوع کریں:

یہ جاننے کے لیے کہ ہمارے صارفین میں سے ایک نے سیج میکر پر کم تاخیر والے GPT-J کا اندازہ کیسے حاصل کیا، ملاحظہ کریں۔ ایمیزون سیج میکر پر ڈیپ اسپیڈ کے ساتھ مینٹیم نے کم تاخیر والے GPT-J کا اندازہ کیسے حاصل کیا.

اگر آپ اپنے LLMs کی ٹائم ٹو مارکیٹ کو تیز کرنا چاہتے ہیں اور اپنی لاگت کو کم کرنا چاہتے ہیں تو SageMaker مدد کر سکتا ہے۔ ہمیں بتائیں کہ آپ کیا بناتے ہیں!

مصنفین کے بارے میں

Zmnako Awrahman، PhD، ایک پریکٹس مینیجر، ML SME، اور گلوبل کمپیٹنسی سینٹر، Amazon Web Services میں مشین لرننگ ٹیکنیکل فیلڈ کمیونٹی (TFC) کے رکن ہیں۔ وہ صارفین کو ڈیٹا اینالیٹکس اور مشین لرننگ کے ساتھ اپنے ڈیٹا سے قدر نکالنے کے لیے کلاؤڈ کی طاقت سے فائدہ اٹھانے میں مدد کرتا ہے۔

Zmnako Awrahman، PhD، ایک پریکٹس مینیجر، ML SME، اور گلوبل کمپیٹنسی سینٹر، Amazon Web Services میں مشین لرننگ ٹیکنیکل فیلڈ کمیونٹی (TFC) کے رکن ہیں۔ وہ صارفین کو ڈیٹا اینالیٹکس اور مشین لرننگ کے ساتھ اپنے ڈیٹا سے قدر نکالنے کے لیے کلاؤڈ کی طاقت سے فائدہ اٹھانے میں مدد کرتا ہے۔

روپ بینس AWS میں ایک سینئر مشین لرننگ سلوشنز آرکیٹیکٹ ہیں۔ وہ مصنوعی ذہانت اور مشین لرننگ کا استعمال کرتے ہوئے گاہکوں کو اختراع کرنے اور ان کے کاروباری مقاصد کو حاصل کرنے میں مدد کرنے کا پرجوش ہے۔ وہ گاہکوں کو تربیت دینے، بہتر بنانے اور گہرے سیکھنے کے ماڈلز کو تعینات کرنے میں مدد کرتا ہے۔

روپ بینس AWS میں ایک سینئر مشین لرننگ سلوشنز آرکیٹیکٹ ہیں۔ وہ مصنوعی ذہانت اور مشین لرننگ کا استعمال کرتے ہوئے گاہکوں کو اختراع کرنے اور ان کے کاروباری مقاصد کو حاصل کرنے میں مدد کرنے کا پرجوش ہے۔ وہ گاہکوں کو تربیت دینے، بہتر بنانے اور گہرے سیکھنے کے ماڈلز کو تعینات کرنے میں مدد کرتا ہے۔

Anastasia پچنی Tsitiridou AWS میں ایک حل آرکیٹیکٹ ہے۔ Anastasia ایمسٹرڈیم میں رہتی ہے اور اپنے کلاؤڈ سفر میں Benelux خطے میں سافٹ ویئر کے کاروبار کی حمایت کرتی ہے۔ AWS میں شامل ہونے سے پہلے، اس نے کمپیوٹر وژن میں مہارت کے ساتھ الیکٹریکل اور کمپیوٹر انجینئرنگ کی تعلیم حاصل کی۔ آج کل وہ جس چیز سے لطف اندوز ہوتی ہے وہ بہت بڑے زبان کے ماڈلز کے ساتھ کام کرنا ہے۔

Anastasia پچنی Tsitiridou AWS میں ایک حل آرکیٹیکٹ ہے۔ Anastasia ایمسٹرڈیم میں رہتی ہے اور اپنے کلاؤڈ سفر میں Benelux خطے میں سافٹ ویئر کے کاروبار کی حمایت کرتی ہے۔ AWS میں شامل ہونے سے پہلے، اس نے کمپیوٹر وژن میں مہارت کے ساتھ الیکٹریکل اور کمپیوٹر انجینئرنگ کی تعلیم حاصل کی۔ آج کل وہ جس چیز سے لطف اندوز ہوتی ہے وہ بہت بڑے زبان کے ماڈلز کے ساتھ کام کرنا ہے۔

دھول پٹیل AWS میں پرنسپل مشین لرننگ آرکیٹیکٹ ہے۔ انہوں نے تقسیم شدہ کمپیوٹنگ اور مصنوعی ذہانت سے متعلق مسائل پر بڑے اداروں سے لے کر درمیانے درجے کے اسٹارٹ اپس تک کی تنظیموں کے ساتھ کام کیا ہے۔ وہ گہری سیکھنے پر توجہ مرکوز کرتا ہے، بشمول NLP اور کمپیوٹر ویژن ڈومینز۔ وہ صارفین کو SageMaker پر اعلیٰ کارکردگی کے ماڈل کا اندازہ حاصل کرنے میں مدد کرتا ہے۔

دھول پٹیل AWS میں پرنسپل مشین لرننگ آرکیٹیکٹ ہے۔ انہوں نے تقسیم شدہ کمپیوٹنگ اور مصنوعی ذہانت سے متعلق مسائل پر بڑے اداروں سے لے کر درمیانے درجے کے اسٹارٹ اپس تک کی تنظیموں کے ساتھ کام کیا ہے۔ وہ گہری سیکھنے پر توجہ مرکوز کرتا ہے، بشمول NLP اور کمپیوٹر ویژن ڈومینز۔ وہ صارفین کو SageMaker پر اعلیٰ کارکردگی کے ماڈل کا اندازہ حاصل کرنے میں مدد کرتا ہے۔

ویلیٹا اسٹوبینیکا AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ اپنے پورے پیشہ ورانہ کیریئر کے دوران، اس نے مختلف صنعتوں جیسے بینکنگ، انشورنس، ٹیلکو، اور پبلک سیکٹر کے لیے متعدد تجزیات پر مبنی پروجیکٹس فراہم کیے ہیں۔ اعلی درجے کے شماریاتی طریقوں اور مشین لرننگ کے بارے میں اس کا علم کاروباری ذہانت کے ساتھ اچھی طرح سے ملا ہوا ہے۔ وہ گاہکوں کے لیے قدر پیدا کرنے کے لیے حالیہ AI پیش رفت لاتی ہے۔

ویلیٹا اسٹوبینیکا AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ اپنے پورے پیشہ ورانہ کیریئر کے دوران، اس نے مختلف صنعتوں جیسے بینکنگ، انشورنس، ٹیلکو، اور پبلک سیکٹر کے لیے متعدد تجزیات پر مبنی پروجیکٹس فراہم کیے ہیں۔ اعلی درجے کے شماریاتی طریقوں اور مشین لرننگ کے بارے میں اس کا علم کاروباری ذہانت کے ساتھ اچھی طرح سے ملا ہوا ہے۔ وہ گاہکوں کے لیے قدر پیدا کرنے کے لیے حالیہ AI پیش رفت لاتی ہے۔

راہول ہیلگول ایمیزون ویب سروسز میں ڈسٹری بیوٹڈ ڈیپ لرننگ میں ایک سینئر سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔

راہول ہیلگول ایمیزون ویب سروسز میں ڈسٹری بیوٹڈ ڈیپ لرننگ میں ایک سینئر سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- ای وی ایم فنانس۔ وکندریقرت مالیات کے لیے متحد انٹرفیس۔ یہاں تک رسائی حاصل کریں۔

- کوانٹم میڈیا گروپ۔ آئی آر/پی آر ایمپلیفائیڈ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/fine-tune-gpt-j-using-an-amazon-sagemaker-hugging-face-estimator-and-the-model-parallel-library/

- : ہے

- : ہے

- :کہاں

- $UP

- 1

- 10

- 100

- 15٪

- 7

- 8

- a

- کی صلاحیت

- ہمارے بارے میں

- رفتار کو تیز تر

- حاصل

- حاصل کیا

- حاصل کرتا ہے

- کے پار

- چالو کرنے کی

- ایکٹیویشنز

- دانت

- شامل کریں

- ایڈیشنل

- اس کے علاوہ

- اعلی درجے کی

- ترقی

- مجموعی

- AI

- کی اجازت دیتا ہے

- پہلے ہی

- بھی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- کے درمیان

- رقم

- ایمسٹرڈیم

- an

- تجزیہ

- تجزیاتی

- تجزیے

- اناستاسیا

- اور

- اے پی آئی

- APIs

- اطلاقی

- کا اطلاق کریں

- فن تعمیر

- کیا

- ارد گرد

- مصنوعی

- مصنوعی ذہانت

- مصنوعی انٹیلی جنس اور مشین سیکھنا

- AS

- منسلک

- At

- آٹو

- خودکار

- دستیاب

- AWS

- AWS پروفیشنل سروسز

- بینڈوڈتھ

- بینکنگ

- کی بنیاد پر

- BE

- کیونکہ

- ہو جاتا ہے

- اس سے پہلے

- کی طرف سے

- پیچھے

- پردے کے پیچھے

- بین

- فائدہ

- فوائد

- BEST

- بہترین طریقوں

- بہتر

- کے درمیان

- اربوں

- لاتا ہے

- کاروبار

- کاروبار

- لیکن

- by

- فون

- کر سکتے ہیں

- صلاحیتوں

- کیریئر کے

- مقدمات

- سینٹر

- کچھ

- تبدیلیاں

- چیٹ بٹس

- چپ

- میں سے انتخاب کریں

- درجہ بندی

- صاف کرنا

- کلوز

- بادل

- کلسٹر

- کوڈ

- کوڈ

- تعاون

- مجموعہ

- مل کر

- آتا ہے

- مواصلات

- کمیونٹی

- کمپنی کے

- مقابلے میں

- پیچیدہ

- حساب

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹر انجینئرنگ

- کمپیوٹر ویژن

- کمپیوٹنگ

- تصور

- ترتیب

- غور کریں

- رکاوٹوں

- کنٹینر

- قیمت

- اخراجات

- تخلیق

- موجودہ

- گاہکوں

- اپنی مرضی کے مطابق

- اعداد و شمار

- ڈیٹا تجزیات

- ڈیٹا سائنسدان

- ڈیٹاسیٹس

- ڈیڈیپی

- معاملہ

- فیصلہ کرنا

- گہری

- گہری سیکھنے

- ڈگری

- ڈیلیور

- تعیناتی

- تفصیلات

- ترقی یافتہ

- ترقی

- ترقی

- آلہ

- کے الات

- مختلف

- براہ راست

- تقسیم کرو

- تقسیم کئے

- تقسیم کمپیوٹنگ

- تقسیم کی تربیت

- تقسیم

- تقسیم ہوتا ہے

- میں Docker

- ڈومینز

- ڈاؤن لوڈ، اتارنا

- دو

- کے دوران

- ہر ایک

- کو کم

- آسان

- اثر

- مؤثر طریقے

- کارکردگی

- مؤثر طریقے سے

- چالو حالت میں

- کے قابل بناتا ہے

- کو فعال کرنا

- انجینئر

- انجنیئرنگ

- اداروں

- ہستی

- عہد

- ضروری

- بنیادی طور پر

- مثال کے طور پر

- سے تجاوز

- چھوڑ کر

- تجربات

- نکالنے

- چہرہ

- تیز تر

- نمایاں کریں

- خصوصیات

- میدان

- اعداد و شمار

- آخر

- مل

- فٹ

- توجہ مرکوز

- پیچھے پیچھے

- کے بعد

- فوٹ پرنٹ

- کے لئے

- آگے

- چار

- سے

- تقریب

- افعال

- مزید

- مزید برآں

- حاصل کرنا

- نسل

- نسلیں

- گلوبل

- GPU

- GPUs

- میلان

- زیادہ سے زیادہ

- گروپ

- رہنمائی

- نصف

- ہے

- he

- مدد

- مدد گار

- مدد

- مدد کرتا ہے

- اس کی

- ہائی

- اعلی کارکردگی

- اعلی

- کس طرح

- کیسے

- تاہم

- HTML

- HTTP

- HTTPS

- گلے لگانے والا چہرہ

- تصاویر

- نفاذ

- عمل

- درآمد

- in

- شامل

- شامل ہیں

- سمیت

- اضافہ

- اضافہ

- صنعتوں

- معلومات

- ابتدائی

- اختراعات

- ان پٹ

- کے اندر

- انسٹال

- نصب

- مثال کے طور پر

- کے بجائے

- انشورنس

- انضمام

- انٹیلی جنس

- میں

- متعارف کرواتا ہے

- IT

- میں

- ایوب

- نوکریاں

- شمولیت

- سفر

- فوٹو

- جان

- علم

- زبان

- زبانیں

- بڑے

- بڑے کاروباری اداروں

- بڑے

- تاخیر

- بعد

- شروع

- تہوں

- جانیں

- سیکھنے

- کم

- دو

- لیوریج

- لائبریریوں

- لائبریری

- کی طرح

- LIMIT

- لمیٹڈ

- حدود

- زندگی

- لوڈ

- منطق

- تلاش

- بند

- لو

- مشین

- مشین لرننگ

- مین

- بنا

- بناتا ہے

- میں کامیاب

- مینیجر

- انتظام کرتا ہے

- بہت سے

- زیادہ سے زیادہ

- زیادہ سے زیادہ

- زیادہ سے زیادہ

- مئی..

- مطلب

- میکانزم

- رکن

- یاد داشت

- طریقوں

- کم سے کم

- منٹ

- منٹ

- ML

- موڈ

- ماڈل

- ماڈل

- طریقوں

- ماڈیولز

- زیادہ

- سب سے زیادہ

- سب سے زیادہ مقبول

- منتقل

- بہت

- ایک سے زیادہ

- قدرتی

- قدرتی زبان عملیات

- تشریف لے جائیں

- ضرورت ہے

- ضروریات

- نیٹ ورک

- عصبی نیٹ ورک

- ویزا

- نوڈ

- نوڈس

- نوٹ بک

- تعداد

- متعدد

- اعتراض

- مقصد

- مقاصد

- حاصل

- of

- کی پیشکش کی

- تجویز

- on

- ایک

- کھول

- اوپن سورس

- آپریشن

- زیادہ سے زیادہ

- کی اصلاح کریں

- or

- حکم

- تنظیمیں

- OS

- دیگر

- دوسری صورت میں

- ہمارے

- باہر

- پیداوار

- پر

- مجموعی طور پر

- متوازی

- پیرامیٹرز

- منظور

- جذباتی

- انجام دیں

- کارکردگی

- کارکردگی کا مظاہرہ

- پائپ لائن

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مقبول

- ممکن

- پوسٹ

- طاقت

- پریکٹس

- طریقوں

- صحت سے متعلق

- پیشن گوئی

- حال (-)

- پچھلا

- پرنسپل

- پہلے

- ترجیح دی

- مسائل

- عمل

- عملدرآمد

- پروسیسنگ

- پیشہ ورانہ

- پروفائلنگ

- منصوبوں

- خصوصیات

- تناسب سے

- فراہم

- فراہم

- فراہم کرنے

- عوامی

- ازگر

- pytorch

- سوال

- تیز

- لے کر

- مناسب

- وجوہات

- حال ہی میں

- سفارش

- سفارش کی

- کو کم

- خطے

- متعلقہ

- جاری

- جاری

- کی جگہ

- نقل

- ذخیرہ

- ضروریات

- کی ضرورت ہے

- وسائل

- محدود

- پابندی

- واپسی

- واپسی

- رن

- sagemaker

- محفوظ کریں

- پیمانے

- ترازو

- سکیلنگ

- مناظر

- شیڈول

- شیڈولنگ

- سائنسدان

- sdk

- تلاش کریں

- شعبے

- دیکھنا

- منتخب

- سینئر

- جذبات

- علیحدہ

- سروسز

- خدمت

- مقرر

- قائم کرنے

- کئی

- تیز

- شارڈنگ

- سیکنڈ اور

- وہ

- دکھایا گیا

- سادہ

- ایک

- سائز

- چھوٹے

- ئیمایس

- So

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- حل

- حل

- کچھ

- مخصوص

- مخصوص

- تیزی

- تقسیم

- الگ ہوجاتا ہے

- معیار

- شروع

- سترٹو

- حالت

- ریاستی آرٹ

- امریکہ

- شماریات

- مرحلہ

- مراحل

- ذخیرہ

- ذخیرہ

- حکمت عملی

- تعلیم حاصل کی

- اس طرح

- حمایت

- کی حمایت کرتا ہے

- ہدف

- کاموں

- ٹیکنیکل

- ٹیکنالوجی

- ٹیلکو

- متن کی درجہ بندی

- سے

- کہ

- ۔

- ان

- ان

- تو

- اس طرح

- لہذا

- وہ

- اس

- کے ذریعے

- بھر میں

- تھرو پٹ

- وقت

- اوقات

- کرنے کے لئے

- ٹوکن

- لیا

- اوزار

- سراغ لگانا

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمر

- ٹرانسفارمرز

- ٹرن

- تبدیل کر دیا

- دو

- عام طور پر

- us

- استعمال

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- رکن کا

- استعمال

- کا استعمال کرتے ہوئے

- استعمال

- استعمال کرنا۔

- v1

- قیمت

- مختلف اقسام کے

- مختلف

- بہت

- نقطہ نظر

- واک تھرو

- چاہتے ہیں

- طریقوں

- we

- ویب

- ویب خدمات

- اچھا ہے

- کیا

- جب

- جب بھی

- جس

- جبکہ

- وسیع

- گے

- ساتھ

- کے اندر

- کام کیا

- کام کر

- ورکشاپ

- گا

- لپیٹو

- تم

- اور

- زیفیرنیٹ