آج، ہم یہ اعلان کرتے ہوئے پرجوش ہیں کہ میٹا کے تیار کردہ کوڈ لاما فاؤنڈیشن ماڈلز صارفین کے لیے دستیاب ہیں۔ ایمیزون سیج میکر جمپ اسٹارٹ چلانے کا اندازہ لگانے کے لیے ایک کلک کے ساتھ تعینات کرنا۔ کوڈ لاما ایک جدید ترین لارج لینگویج ماڈل (LLM) ہے جو کوڈ اور قدرتی زبان کے اشارے دونوں سے کوڈ کے بارے میں کوڈ اور قدرتی زبان پیدا کرنے کی صلاحیت رکھتا ہے۔ آپ اس ماڈل کو SageMaker JumpStart کے ساتھ آزما سکتے ہیں، جو ایک مشین لرننگ (ML) مرکز ہے جو الگورتھم، ماڈلز، اور ML حل تک رسائی فراہم کرتا ہے تاکہ آپ ML کے ساتھ تیزی سے شروعات کر سکیں۔ اس پوسٹ میں، ہم SageMaker JumpStart کے ذریعے کوڈ لاما ماڈل کو دریافت کرنے اور اسے تعینات کرنے کے طریقہ پر چلتے ہیں۔

کوڈ لاما

کوڈ لاما کی طرف سے جاری کردہ ایک ماڈل ہے۔ میٹا جو کہ Llama 2 کے اوپر بنایا گیا ہے۔ یہ جدید ترین ماڈل ڈویلپرز کے لیے پروگرامنگ کے کاموں کے لیے پیداواری صلاحیت کو بہتر بنانے کے لیے ڈیزائن کیا گیا ہے تاکہ انھیں اعلیٰ معیار کا، اچھی طرح سے دستاویزی کوڈ بنانے میں مدد مل سکے۔ ماڈلز Python، C++، Java، PHP، C#، TypeScript اور Bash میں بہترین ہیں، اور ان میں ڈویلپرز کا وقت بچانے اور سافٹ ویئر ورک فلو کو زیادہ موثر بنانے کی صلاحیت ہے۔

یہ تین قسموں میں آتا ہے، جس میں وسیع اقسام کی ایپلی کیشنز کا احاطہ کرنے کے لیے انجنیئر کیا گیا ہے: فاؤنڈیشنل ماڈل (کوڈ لاما)، ایک ازگر کا خصوصی ماڈل (کوڈ لامہ ازگر)، اور قدرتی زبان کی ہدایات کو سمجھنے کے لیے ہدایات کے بعد ایک ماڈل (کوڈ لاما انسٹرکٹ)۔ تمام کوڈ لاما ویریئنٹس چار سائز میں آتے ہیں: 7B، 13B، 34B، اور 70B پیرامیٹرز۔ 7B اور 13B بیس اور انسٹرکٹ ویریئنٹس آس پاس کے مواد کی بنیاد پر انفللنگ کو سپورٹ کرتے ہیں، انہیں کوڈ اسسٹنٹ ایپلی کیشنز کے لیے مثالی بناتے ہیں۔ ماڈلز کو Llama 2 کو بنیاد کے طور پر استعمال کرتے ہوئے ڈیزائن کیا گیا تھا اور پھر کوڈ ڈیٹا کے 500 بلین ٹوکنز پر تربیت دی گئی تھی، جس میں Python کے خصوصی ورژن کو 100 بلین ٹوکنز پر تربیت دی گئی تھی۔ کوڈ لاما ماڈلز مستحکم نسلوں کو سیاق و سباق کے 100,000 ٹوکن تک فراہم کرتے ہیں۔ تمام ماڈلز کو 16,000 ٹوکنز کی ترتیب پر تربیت دی جاتی ہے اور 100,000 ٹوکنز تک کے ان پٹ پر بہتری دکھاتے ہیں۔

ماڈل اسی کے تحت دستیاب کرایا گیا ہے۔ لاما 2 کے بطور کمیونٹی لائسنس۔

سیج میکر میں فاؤنڈیشن ماڈل

سیج میکر جمپ سٹارٹ مقبول ماڈل ہب سے ماڈلز کی ایک رینج تک رسائی فراہم کرتا ہے، بشمول ہیگنگ فیس، پائ ٹارچ ہب، اور ٹینسر فلو حب، جسے آپ سیج میکر میں اپنے ایم ایل ڈیولپمنٹ ورک فلو کے اندر استعمال کر سکتے ہیں۔ ایم ایل میں حالیہ پیشرفت نے ماڈلز کی ایک نئی کلاس کو جنم دیا ہے جس کے نام سے جانا جاتا ہے۔ بنیاد ماڈل، جو عام طور پر اربوں پیرامیٹرز پر تربیت یافتہ ہوتے ہیں اور استعمال کے معاملات کے وسیع زمرے کے مطابق ہوتے ہیں، جیسے کہ متن کا خلاصہ، ڈیجیٹل آرٹ جنریشن، اور زبان کا ترجمہ۔ چونکہ یہ ماڈلز کو تربیت دینا مہنگا ہے، اس لیے صارفین ان ماڈلز کو خود تربیت دینے کے بجائے موجودہ پہلے سے تربیت یافتہ فاؤنڈیشن ماڈلز کو استعمال کرنا چاہتے ہیں اور ضرورت کے مطابق ان کو ٹھیک کرنا چاہتے ہیں۔ سیج میکر ان ماڈلز کی کیوریٹڈ فہرست فراہم کرتا ہے جن میں سے آپ سیج میکر کنسول پر انتخاب کر سکتے ہیں۔

آپ SageMaker JumpStart کے اندر مختلف ماڈل فراہم کنندگان سے فاؤنڈیشن ماڈلز تلاش کر سکتے ہیں، جس سے آپ فاؤنڈیشن ماڈلز کے ساتھ تیزی سے شروعات کر سکتے ہیں۔ آپ مختلف کاموں یا ماڈل فراہم کنندگان کی بنیاد پر فاؤنڈیشن ماڈل تلاش کر سکتے ہیں، اور آسانی سے ماڈل کی خصوصیات اور استعمال کی شرائط کا جائزہ لے سکتے ہیں۔ آپ ٹیسٹ UI ویجیٹ کا استعمال کرتے ہوئے ان ماڈلز کو بھی آزما سکتے ہیں۔ جب آپ پیمانے پر فاؤنڈیشن ماڈل استعمال کرنا چاہتے ہیں، تو آپ SageMaker کو چھوڑے بغیر ماڈل فراہم کنندگان کی طرف سے پہلے سے بنی ہوئی نوٹ بکس کا استعمال کر کے ایسا کر سکتے ہیں۔ چونکہ ماڈلز کی میزبانی اور AWS پر تعیناتی ہوتی ہے، آپ یقین دہانی کر سکتے ہیں کہ آپ کا ڈیٹا، چاہے ماڈل کو جانچنے یا استعمال کرنے کے لیے استعمال کیا گیا ہو، تیسرے فریق کے ساتھ کبھی شیئر نہیں کیا جاتا ہے۔

سیج میکر جمپ اسٹارٹ میں کوڈ لاما ماڈل دریافت کریں۔

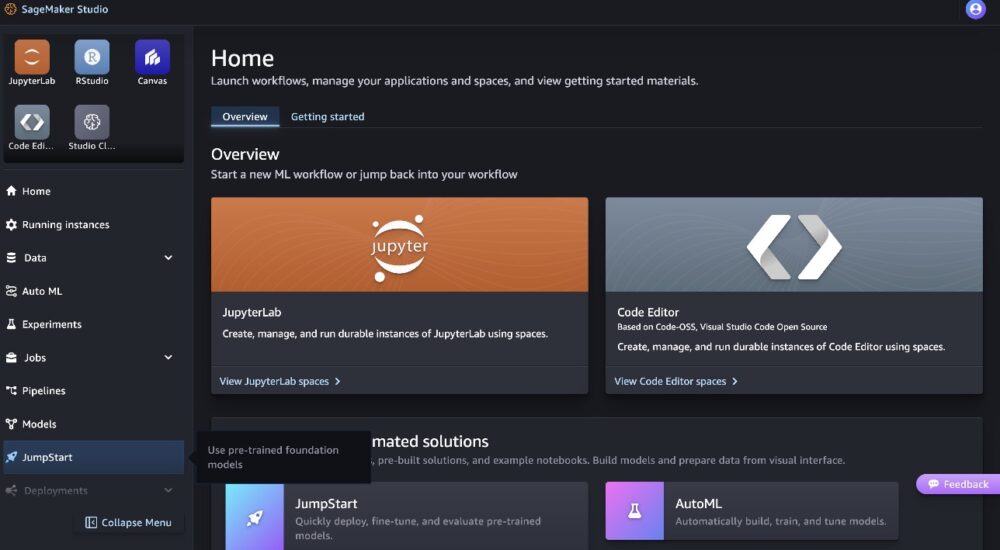

کوڈ Llama 70B ماڈل کو تعینات کرنے کے لیے، درج ذیل مراحل کو مکمل کریں۔ ایمیزون سیج میکر اسٹوڈیو:

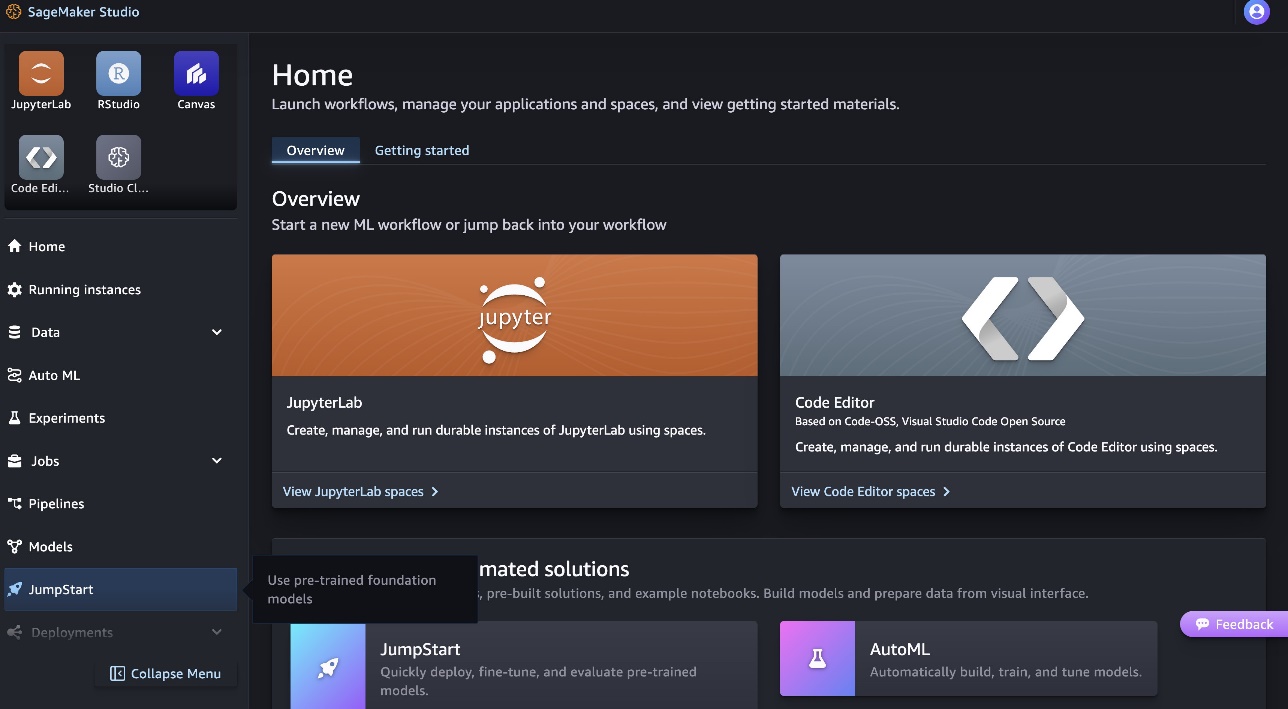

- سیج میکر اسٹوڈیو ہوم پیج پر، منتخب کریں۔ جمپ اسٹارٹ نیوی گیشن پین میں.

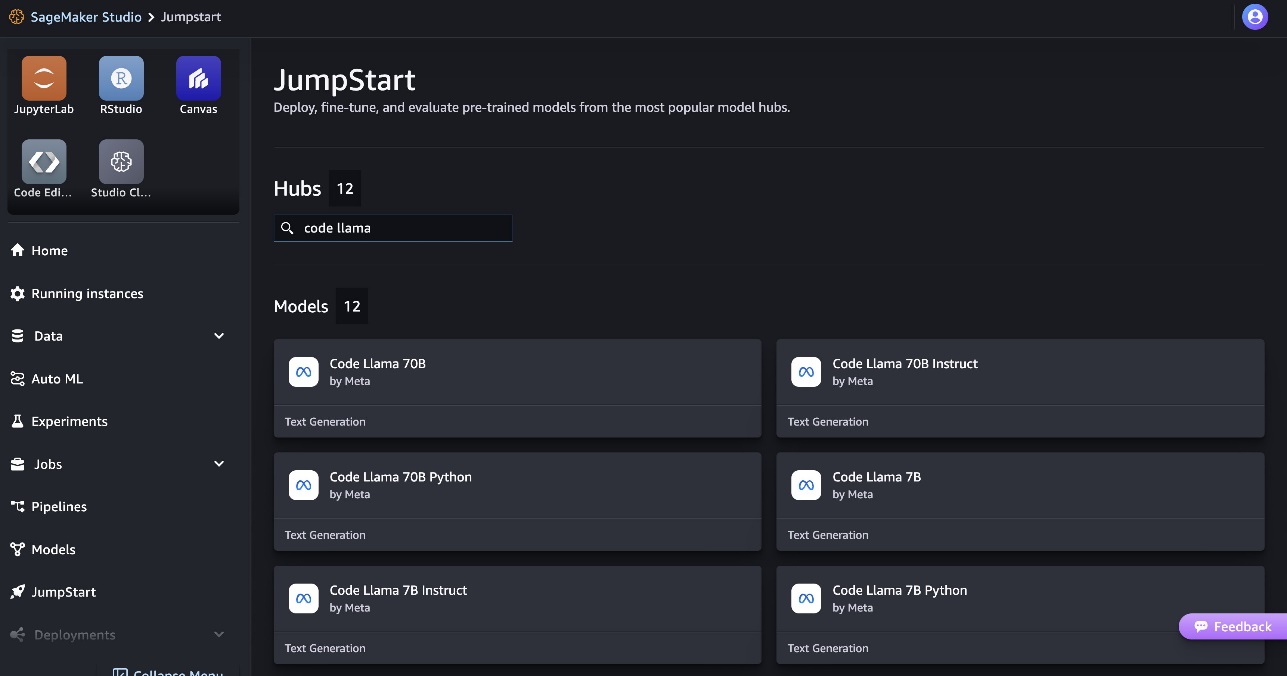

- کوڈ لاما ماڈلز تلاش کریں اور دکھائے گئے ماڈلز کی فہرست میں سے کوڈ لاما 70B ماڈل منتخب کریں۔

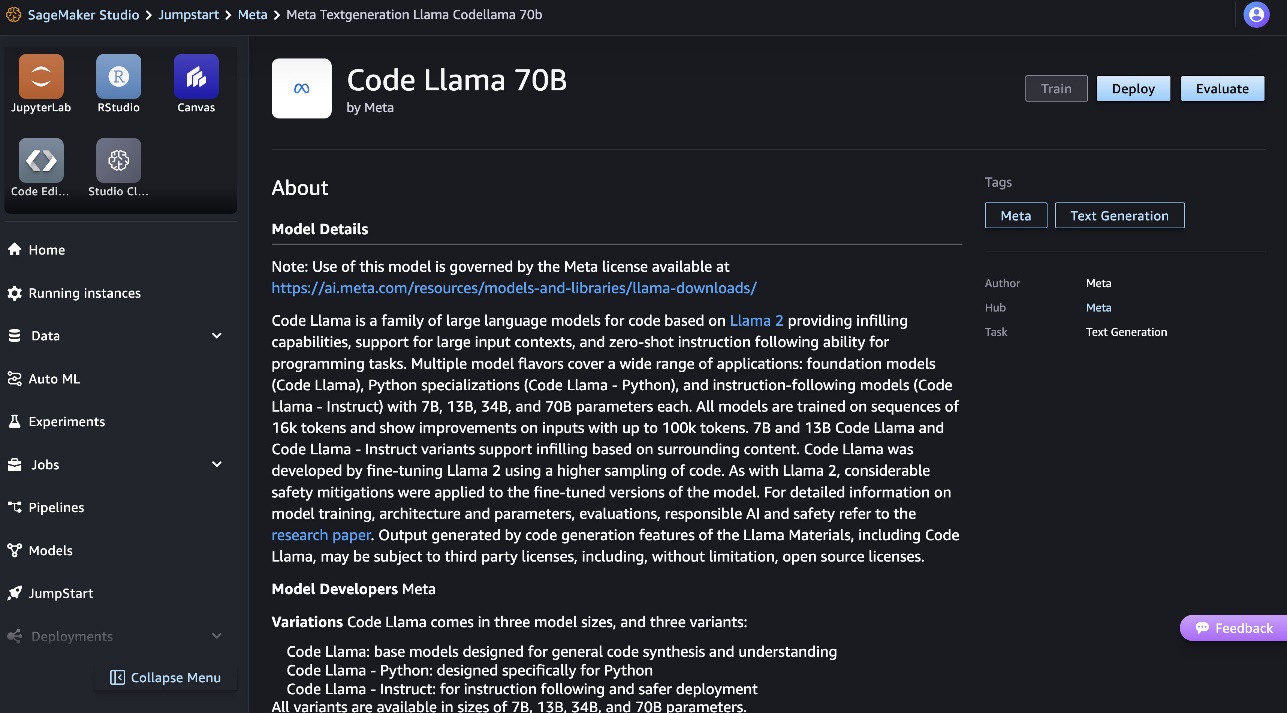

آپ کوڈ لاما 70B ماڈل کارڈ پر ماڈل کے بارے میں مزید معلومات حاصل کر سکتے ہیں۔

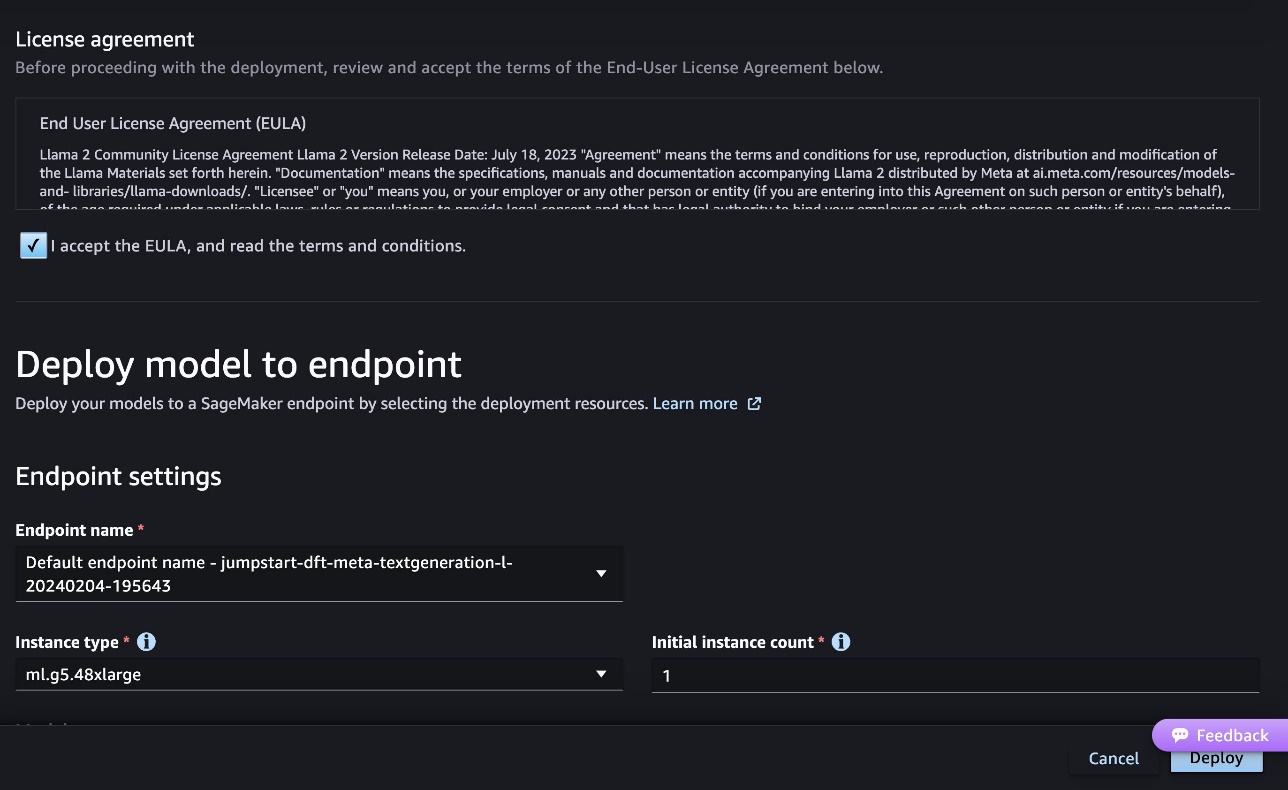

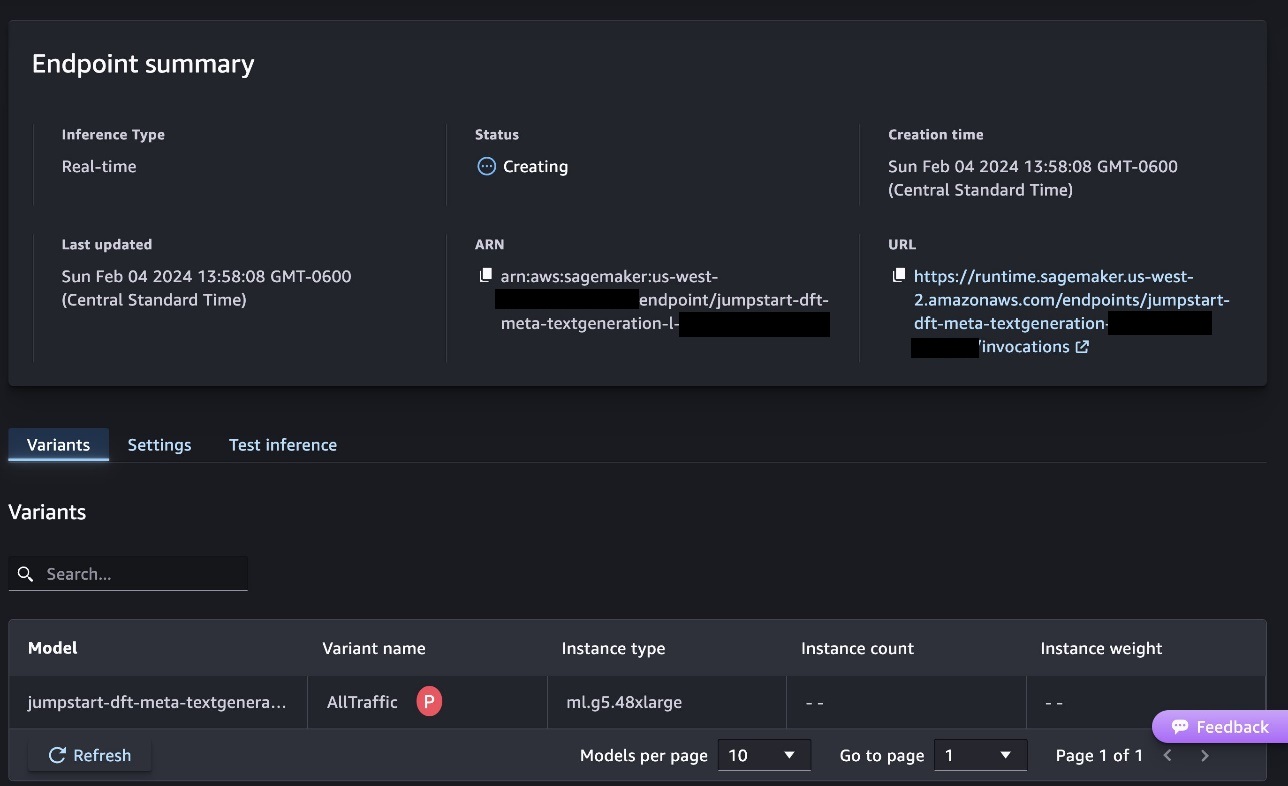

مندرجہ ذیل اسکرین شاٹ اختتامی نقطہ کی ترتیبات کو ظاہر کرتا ہے۔ آپ اختیارات کو تبدیل کر سکتے ہیں یا پہلے سے طے شدہ کو استعمال کر سکتے ہیں۔

- اینڈ یوزر لائسنس ایگریمنٹ (EULA) کو قبول کریں اور منتخب کریں۔ تعینات.

یہ اختتامی نقطہ کی تعیناتی کا عمل شروع کر دے گا، جیسا کہ درج ذیل اسکرین شاٹ میں دکھایا گیا ہے۔

SageMaker Python SDK کے ساتھ ماڈل کو متعین کریں۔

متبادل طور پر، آپ مثال نوٹ بک کے ذریعے منتخب کر کے تعینات کر سکتے ہیں۔ نوٹ بک کھولیں۔ کلاسک اسٹوڈیو کے ماڈل کی تفصیل والے صفحے کے اندر۔ مثال کی نوٹ بک اختتام سے آخر تک رہنمائی فراہم کرتی ہے کہ اندازہ کے لیے ماڈل کو کیسے تعینات کیا جائے اور وسائل کو صاف کیا جائے۔

نوٹ بک کا استعمال کرتے ہوئے تعینات کرنے کے لیے، ہم ایک مناسب ماڈل کو منتخب کرکے شروع کرتے ہیں، جس کی وضاحت کی گئی ہے۔ model_id. آپ مندرجہ ذیل کوڈ کے ساتھ SageMaker پر کسی بھی منتخب ماڈل کو تعینات کر سکتے ہیں:

یہ ماڈل کو ڈیفالٹ کنفیگریشنز کے ساتھ SageMaker پر تعینات کرتا ہے، بشمول ڈیفالٹ مثال کی قسم اور ڈیفالٹ VPC کنفیگریشنز۔ آپ ان کنفیگریشنز کو غیر ڈیفالٹ ویلیوز بتا کر تبدیل کر سکتے ہیں۔ جمپ اسٹارٹ ماڈل. نوٹ کریں کہ بطور ڈیفالٹ، accept_eula کرنے کے لئے مقرر کیا گیا ہے False. آپ کو سیٹ کرنے کی ضرورت ہے۔ accept_eula=True اختتامی نقطہ کو کامیابی سے تعینات کرنے کے لیے۔ ایسا کرنے سے، آپ صارف کے لائسنس کے معاہدے اور قابل قبول استعمال کی پالیسی کو قبول کرتے ہیں جیسا کہ پہلے ذکر کیا گیا ہے۔ آپ بھی ڈاؤن لوڈ، اتارنا لائسنس کا معاہدہ.

سیج میکر اینڈ پوائنٹ کو طلب کریں۔

اختتامی نقطہ کے تعینات ہونے کے بعد، آپ Boto3 یا SageMaker Python SDK کا استعمال کر کے اندازہ لگا سکتے ہیں۔ مندرجہ ذیل کوڈ میں، ہم SageMaker Python SDK کا استعمال کرتے ہیں تاکہ ماڈل کو اندازہ کے لیے کال کریں اور جواب پرنٹ کریں:

تقریب print_response پے لوڈ اور ماڈل ردعمل پر مشتمل ایک پے لوڈ لیتا ہے اور آؤٹ پٹ کو پرنٹ کرتا ہے۔ کوڈ لاما اندازہ لگاتے ہوئے بہت سے پیرامیٹرز کی حمایت کرتا ہے:

- زیادہ سے زیادہ طوالت - ماڈل اس وقت تک متن تیار کرتا ہے جب تک کہ آؤٹ پٹ کی لمبائی (جس میں ان پٹ سیاق و سباق کی لمبائی شامل ہے) تک نہ پہنچ جائے۔

max_length. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - max_new_tokens - ماڈل اس وقت تک متن تیار کرتا ہے جب تک کہ آؤٹ پٹ کی لمبائی (ان پٹ سیاق و سباق کی لمبائی کو چھوڑ کر) تک نہ پہنچ جائے۔

max_new_tokens. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - num_beams - یہ لالچی تلاش میں استعمال ہونے والے شہتیروں کی تعداد کی وضاحت کرتا ہے۔ اگر متعین کیا جائے تو یہ اس سے بڑا یا اس کے برابر کا عدد ہونا چاہیے۔

num_return_sequences. - no_repeat_ngram_size - ماڈل اس بات کو یقینی بناتا ہے کہ الفاظ کی ترتیب

no_repeat_ngram_sizeآؤٹ پٹ ترتیب میں دہرایا نہیں جاتا ہے۔ اگر بیان کیا جائے تو یہ 1 سے بڑا مثبت عدد ہونا چاہیے۔ - درجہ حرارت - یہ آؤٹ پٹ میں بے ترتیب پن کو کنٹرول کرتا ہے۔ اعلی

temperatureکم امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب کا نتیجہ، اور کمtemperatureزیادہ امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب کا نتیجہ۔ اگرtemperature0 ہے، اس کے نتیجے میں لالچی ضابطہ کشائی ہوتی ہے۔ اگر بیان کیا گیا ہے، تو یہ ایک مثبت فلوٹ ہونا چاہیے۔ - جلدی_روکنا - اگر

Trueجب تمام بیم مفروضے جملے کے ٹوکن کے اختتام پر پہنچ جاتے ہیں تو ٹیکسٹ جنریشن ختم ہو جاتی ہے۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - do_sample - اگر

True، ماڈل امکان کے مطابق اگلے لفظ کا نمونہ کرتا ہے۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - top_k - ٹیکسٹ جنریشن کے ہر مرحلے میں، ماڈل کے نمونے صرف سے

top_kسب سے زیادہ امکان الفاظ. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - ٹاپ_پی - ٹیکسٹ جنریشن کے ہر مرحلے میں، مجموعی امکان کے ساتھ الفاظ کے سب سے چھوٹے ممکنہ سیٹ سے ماڈل کے نمونے

top_p. اگر متعین کیا جائے تو یہ 0 اور 1 کے درمیان فلوٹ ہونا چاہیے۔ - واپسی_مکمل_متن - اگر

True، ان پٹ ٹیکسٹ آؤٹ پٹ جنریٹڈ ٹیکسٹ کا حصہ ہوگا۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ اس کی ڈیفالٹ قدر ہے۔False. - روک - اگر بیان کیا گیا ہے، تو یہ تاروں کی فہرست ہونی چاہیے۔ ٹیکسٹ جنریشن رک جاتا ہے اگر مخصوص سٹرنگز میں سے کوئی ایک تیار ہو جاتی ہے۔

اختتامی نقطہ کی درخواست کرتے ہوئے آپ ان پیرامیٹرز کے کسی بھی ذیلی سیٹ کی وضاحت کر سکتے ہیں۔ اگلا، ہم ایک مثال دکھاتے ہیں کہ ان دلائل کے ساتھ اختتامی نقطہ کو کیسے پکارا جائے۔

کوڈ کی تکمیل۔

مندرجہ ذیل مثالیں ظاہر کرتی ہیں کہ کوڈ کی تکمیل کیسے کی جائے جہاں متوقع اختتامی جواب پرامپٹ کا فطری تسلسل ہے۔

ہم پہلے درج ذیل کوڈ کو چلاتے ہیں:

ہمیں درج ذیل آؤٹ پٹ ملتا ہے:

ہماری اگلی مثال کے لیے، ہم درج ذیل کوڈ چلاتے ہیں:

ہمیں درج ذیل آؤٹ پٹ ملتا ہے:

کوڈ جنریشن

درج ذیل مثالیں کوڈ لاما کا استعمال کرتے ہوئے Python کوڈ جنریشن دکھاتی ہیں۔

ہم پہلے درج ذیل کوڈ کو چلاتے ہیں:

ہمیں درج ذیل آؤٹ پٹ ملتا ہے:

ہماری اگلی مثال کے لیے، ہم درج ذیل کوڈ چلاتے ہیں:

ہمیں درج ذیل آؤٹ پٹ ملتا ہے:

یہ Code Llama 70B کا استعمال کرتے ہوئے کوڈ سے متعلق کاموں کی کچھ مثالیں ہیں۔ آپ اس سے بھی زیادہ پیچیدہ کوڈ بنانے کے لیے ماڈل کا استعمال کر سکتے ہیں۔ ہم آپ کو اپنے کوڈ سے متعلق استعمال کے کیسز اور مثالوں کا استعمال کرتے ہوئے اسے آزمانے کی ترغیب دیتے ہیں!

صاف کرو

اختتامی نقطوں کی جانچ کرنے کے بعد، یقینی بنائیں کہ آپ نے SageMaker انفرنس اینڈ پوائنٹس اور ماڈل کو حذف کر دیا ہے تاکہ چارجز لگنے سے بچ سکیں۔ درج ذیل کوڈ کا استعمال کریں:

نتیجہ

اس پوسٹ میں، ہم نے SageMaker JumpStart پر Code Llama 70B متعارف کرایا ہے۔ کوڈ Llama 70B قدرتی زبان کے اشارے کے ساتھ ساتھ کوڈ سے کوڈ بنانے کا ایک جدید ترین ماڈل ہے۔ آپ SageMaker JumpStart میں چند آسان مراحل کے ساتھ ماڈل کو تعینات کر سکتے ہیں اور پھر اسے کوڈ سے متعلقہ کاموں کو انجام دینے کے لیے استعمال کر سکتے ہیں جیسے کوڈ جنریشن اور کوڈ انفلنگ۔ اگلے مرحلے کے طور پر، اپنے کوڈ سے متعلق استعمال کے کیسز اور ڈیٹا کے ساتھ ماڈل استعمال کرنے کی کوشش کریں۔

مصنفین کے بارے میں

ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر فاروق صابر AWS میں ایک سینئر مصنوعی ذہانت اور مشین لرننگ اسپیشلسٹ سولیوشن آرکیٹیکٹ ہیں۔ انہوں نے آسٹن کی یونیورسٹی آف ٹیکساس سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی اور ایم ایس کی ڈگریاں اور جارجیا انسٹی ٹیوٹ آف ٹیکنالوجی سے کمپیوٹر سائنس میں ایم ایس کی ڈگریاں حاصل کیں۔ اس کے پاس 15 سال سے زیادہ کام کا تجربہ ہے اور وہ کالج کے طلباء کو پڑھانا اور ان کی رہنمائی کرنا بھی پسند کرتا ہے۔ AWS میں، وہ صارفین کو ڈیٹا سائنس، مشین لرننگ، کمپیوٹر ویژن، مصنوعی ذہانت، عددی اصلاح، اور متعلقہ ڈومینز میں اپنے کاروباری مسائل کی تشکیل اور حل کرنے میں مدد کرتا ہے۔ ڈیلاس، ٹیکساس میں مقیم، وہ اور اس کا خاندان سفر کرنا اور طویل سڑک کے سفر پر جانا پسند کرتا ہے۔

ڈاکٹر فاروق صابر AWS میں ایک سینئر مصنوعی ذہانت اور مشین لرننگ اسپیشلسٹ سولیوشن آرکیٹیکٹ ہیں۔ انہوں نے آسٹن کی یونیورسٹی آف ٹیکساس سے الیکٹریکل انجینئرنگ میں پی ایچ ڈی اور ایم ایس کی ڈگریاں اور جارجیا انسٹی ٹیوٹ آف ٹیکنالوجی سے کمپیوٹر سائنس میں ایم ایس کی ڈگریاں حاصل کیں۔ اس کے پاس 15 سال سے زیادہ کام کا تجربہ ہے اور وہ کالج کے طلباء کو پڑھانا اور ان کی رہنمائی کرنا بھی پسند کرتا ہے۔ AWS میں، وہ صارفین کو ڈیٹا سائنس، مشین لرننگ، کمپیوٹر ویژن، مصنوعی ذہانت، عددی اصلاح، اور متعلقہ ڈومینز میں اپنے کاروباری مسائل کی تشکیل اور حل کرنے میں مدد کرتا ہے۔ ڈیلاس، ٹیکساس میں مقیم، وہ اور اس کا خاندان سفر کرنا اور طویل سڑک کے سفر پر جانا پسند کرتا ہے۔

جون جیت گیا۔ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ فاؤنڈیشن ماڈلز کو آسانی سے قابل دریافت اور قابل استعمال بنانے پر توجہ مرکوز کرتا ہے تاکہ صارفین کو تخلیقی AI ایپلی کیشنز بنانے میں مدد مل سکے۔ ایمیزون پر اس کے تجربے میں موبائل شاپنگ ایپلی کیشن اور آخری میل کی ترسیل بھی شامل ہے۔

جون جیت گیا۔ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ فاؤنڈیشن ماڈلز کو آسانی سے قابل دریافت اور قابل استعمال بنانے پر توجہ مرکوز کرتا ہے تاکہ صارفین کو تخلیقی AI ایپلی کیشنز بنانے میں مدد مل سکے۔ ایمیزون پر اس کے تجربے میں موبائل شاپنگ ایپلی کیشن اور آخری میل کی ترسیل بھی شامل ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15 سال

- 15٪

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- ہمارے بارے میں

- قبول کریں

- قابل قبول

- قبولیت

- تک رسائی حاصل

- ترقی

- معاہدہ

- AI

- یلگوردمز

- تمام

- بھی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- an

- اور

- اعلان کریں

- کوئی بھی

- درخواست

- ایپلی کیشنز

- اطلاقی

- مناسب

- کیا

- دلائل

- فن

- مصنوعی

- مصنوعی ذہانت

- مصنوعی انٹیلی جنس اور مشین سیکھنا

- AS

- اسسٹنٹ

- یقین دہانی کرائی

- At

- آسٹن، ٹیکساس

- دستیاب

- سے اجتناب

- AWS

- بیس

- کی بنیاد پر

- مار

- Bayesian

- BE

- بیم

- کیونکہ

- کے درمیان

- ارب

- بلین ٹوکن

- اربوں

- دونوں

- بلبلا

- تعمیر

- تعمیر

- کاروبار

- by

- C ++

- فون

- کر سکتے ہیں

- صلاحیت رکھتا

- کارڈ

- لے جانے کے

- مقدمات

- قسم

- سیل

- تبدیل

- خصوصیات

- بوجھ

- میں سے انتخاب کریں

- منتخب کریں

- طبقے

- کلاسک

- صاف

- کلک کریں

- کوڈ

- کالج

- کس طرح

- آتا ہے

- مکمل

- تکمیل

- پیچیدہ

- کمپیوٹر

- کمپیوٹر سائنس

- کمپیوٹر ویژن

- پر مشتمل ہے

- کنسول

- مواد

- سیاق و سباق

- جاری

- کنٹرول

- احاطہ

- تخلیق

- cured

- گاہکوں

- ڈلاس

- اعداد و شمار

- ڈیٹا سائنس

- ضابطہ ربائی کرنا

- پہلے سے طے شدہ

- ترسیل

- مظاہرہ

- تعیناتی

- تعینات

- تعیناتی

- تعینات کرتا ہے

- ڈیزائن

- تفصیل

- ترقی یافتہ

- ڈویلپرز

- ترقی

- مختلف

- ڈیجیٹل

- ڈیجیٹل آرٹ

- دریافت

- do

- کر

- ڈومینز

- ڈیوک

- ڈیوک یونیورسٹی

- ہر ایک

- اس سے قبل

- آسانی سے

- ہنر

- کو فعال کرنا

- کی حوصلہ افزائی

- آخر

- آخر سے آخر تک

- اختتام پوائنٹ

- انجنیئر

- انجنیئرنگ

- یقینی بناتا ہے

- برابر

- خرابی

- کا جائزہ لینے

- بھی

- مثال کے طور پر

- مثال کے طور پر

- ایکسل

- اس کے علاوہ

- بہت پرجوش

- چھوڑ کر

- موجودہ

- توقع

- مہنگی

- تجربہ

- ظالمانہ

- چہرہ

- خاندان

- چند

- مل

- پہلا

- فلوٹ

- توجہ مرکوز

- کے بعد

- کے لئے

- فاؤنڈیشن

- بنیاد پرست

- چار

- سے

- تقریب

- پیدا

- پیدا

- پیدا ہوتا ہے

- پیدا کرنے والے

- نسل

- نسلیں

- پیداواری

- پیداواری AI۔

- جارجیا

- حاصل

- دی

- Go

- زیادہ سے زیادہ

- لالچی

- رہنمائی

- ہے

- he

- مدد

- مدد

- مدد کرتا ہے

- اعلی معیار کی

- اعلی

- ان

- کی ڈگری حاصل کی

- ہوم پیج (-)

- میزبان

- میزبانی کی

- کس طرح

- کیسے

- HTTPS

- حب

- مرکز

- i

- مثالی

- if

- درآمد

- کو بہتر بنانے کے

- بہتری

- in

- شامل

- شامل ہیں

- سمیت

- اضافہ

- معلومات

- ان پٹ

- آدانوں

- مثال کے طور پر

- انسٹی ٹیوٹ

- ہدایات

- انٹیلی جنس

- مفادات

- متعارف

- IT

- اعلی درجے کا Java

- فوٹو

- جانا جاتا ہے

- کیلی

- زبان

- بڑے

- آخری

- سیکھنے

- چھوڑ کر

- لمبائی

- لائسنس

- امکان

- امکان

- پسند

- لسٹ

- لاما

- ایل ایل ایم

- لانگ

- محبت

- کم

- مشین

- مشین لرننگ

- بنا

- بنا

- بنانا

- مینیجر

- بہت سے

- ذکر کیا

- سرپرست

- میٹا

- میل

- ML

- موبائل

- ماڈل

- ماڈل

- زیادہ

- زیادہ موثر

- سب سے زیادہ

- MS

- ضروری

- قدرتی

- سمت شناسی

- ضرورت ہے

- ضرورت

- کبھی نہیں

- نئی

- اگلے

- براہ مہربانی نوٹ کریں

- نوٹ بک

- اب

- تعداد

- of

- on

- ایک

- والوں

- صرف

- اصلاح کے

- آپشنز کے بھی

- or

- ہمارے

- باہر

- پیداوار

- پر

- خود

- صفحہ

- پین

- کاغذات

- پیرامیٹرز

- حصہ

- جماعتوں

- فی

- انجام دیں

- کارکردگی کا مظاہرہ

- پی ایچ ڈی

- پی ایچ پی

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پالیسی

- مقبول

- مثبت

- ممکن

- پوسٹ

- ممکنہ

- پیش گو

- پرنٹ

- پرنٹس

- مسائل

- عمل

- عمل

- مصنوعات

- پروڈکٹ مینیجر

- پیداوری

- پروگرامنگ

- اشارہ کرتا ہے

- فراہم

- فراہم کرنے والے

- فراہم کرتا ہے

- شائع

- ازگر

- pytorch

- جلدی سے

- بے ترتیب پن

- رینج

- بلکہ

- تک پہنچنے

- پہنچتا ہے

- حال ہی میں

- متعلقہ

- جاری

- بار بار

- تحقیق

- وسائل

- جواب

- باقی

- نتائج کی نمائش

- واپسی

- ریورس

- کا جائزہ لینے کے

- اضافہ

- سڑک

- رن

- چل رہا ہے

- sagemaker

- سیج میکر کا اندازہ

- اسی

- محفوظ کریں

- توسیع پذیر

- پیمانے

- سائنس

- سائنسدان

- sdk

- تلاش کریں

- منتخب

- منتخب

- سینئر

- سزا

- تسلسل

- سیریز

- سروسز

- مقرر

- ترتیبات

- مشترکہ

- خریداری

- دکھائیں

- دکھایا گیا

- شوز

- سادہ

- سائز

- So

- سافٹ ویئر کی

- حل

- حل

- کچھ

- ماہر

- خصوصی

- مخصوص

- کی وضاحت

- مستحکم

- شروع کریں

- شروع

- ریاستی آرٹ

- مرحلہ

- مراحل

- رک جاتا ہے

- سلک

- طلباء

- سٹوڈیو

- کامیابی کے ساتھ

- اس طرح

- حمایت

- کی حمایت کرتا ہے

- اس بات کا یقین

- ارد گرد

- لیتا ہے

- کاموں

- ٹیم

- ٹیکنالوجی

- ٹیسسرور

- شرائط

- ٹیسٹ

- تجربہ

- ٹیکساس

- متن

- سے

- کہ

- ۔

- ان

- ان

- خود

- تو

- یہ

- تھرڈ

- تیسرے فریقوں

- اس

- تین

- کے ذریعے

- وقت

- وقت کا سلسلہ

- کرنے کے لئے

- ٹوکن

- ٹوکن

- سب سے اوپر

- ٹرین

- تربیت یافتہ

- ترجمہ

- سفر

- گزرنا

- سچ

- کوشش

- قسم

- ٹائپ اسکرپٹ

- عام طور پر

- ui

- کے تحت

- افہام و تفہیم

- یونیورسٹی

- جب تک

- استعمال کے قابل

- استعمال

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- رکن کا

- کا استعمال کرتے ہوئے

- قیمت

- اقدار

- مختلف اقسام کے

- ورژن

- کی طرف سے

- نقطہ نظر

- چلنا

- چاہتے ہیں

- we

- ویب

- ویب خدمات

- اچھا ہے

- تھے

- جب

- چاہے

- جس

- جبکہ

- وسیع

- ویجیٹ

- گے

- ساتھ

- کے اندر

- بغیر

- لفظ

- الفاظ

- کام

- کام کا بہاؤ

- کام کے بہاؤ

- لکھنا

- سال

- تم

- اور

- زیفیرنیٹ