مشین لرننگ (ML) ایپلی کیشنز تعینات کرنے کے لیے پیچیدہ ہیں اور اکثر ایک ہی انفرنس کی درخواست کو پورا کرنے کے لیے متعدد ML ماڈلز کی ضرورت ہوتی ہے۔ ایک عام درخواست متعدد ماڈلز میں پھیل سکتی ہے جیسے پری پروسیسنگ، ڈیٹا ٹرانسفارمیشن، ماڈل سلیکشن منطق، ماڈل ایگریگیشن، اور پوسٹ پروسیسنگ۔ اس سے سیریل انفرنس پائپ لائنز، ensembles (سکیٹر گیدر) اور بزنس لاجک ورک فلو جیسے عام ڈیزائن کے نمونوں کے ارتقاء کا باعث بنی ہے، جس کے نتیجے میں درخواست کے پورے ورک فلو کو ڈائریکٹڈ Acyclic گراف (DAG) کے طور پر محسوس کیا گیا ہے۔ تاہم، جیسا کہ ورک فلو زیادہ پیچیدہ ہوتا جاتا ہے، اس سے ان ایپلی کیشنز کے مجموعی ردعمل کے اوقات، یا تاخیر میں اضافہ ہوتا ہے جس کے نتیجے میں صارف کا مجموعی تجربہ متاثر ہوتا ہے۔ مزید برآں، اگر ان اجزاء کو مختلف مثالوں پر ہوسٹ کیا جاتا ہے، تو ان مثالوں کے درمیان اضافی نیٹ ورک لیٹنسی مجموعی تاخیر کو بڑھا دیتی ہے۔ کسٹمر سپورٹ میں ورچوئل اسسٹنٹ کے لیے مقبول ML استعمال کیس کی ایک مثال پر غور کریں۔ ایک عام درخواست میں تقریر کی شناخت، قدرتی زبان کی پروسیسنگ (NLP)، ڈائیلاگ اسٹیٹ ٹریکنگ، ڈائیلاگ پالیسی، ٹیکسٹ جنریشن، اور آخر میں ٹیکسٹ ٹو اسپیچ کے کئی مراحل سے گزرنا پڑ سکتا ہے۔ مزید برآں، صارف کے تعامل کو مزید ذاتی بنانے کے لیے، آپ جدید ترین، ٹرانسفارمر پر مبنی NLP ماڈلز بھی استعمال کر سکتے ہیں جیسے کہ برٹ, BART، اور جی پی ٹی. حتمی نتیجہ یہ ہے کہ ان ماڈلز کے لیے طویل ردعمل کا وقت اور صارفین کا ناقص تجربہ۔

مجموعی تھرو پٹ پر سمجھوتہ کیے بغیر کم ردعمل کے اوقات کو چلانے کا ایک عام نمونہ یہ ہے کہ ان ماڈلز کو ایک ہی مثال کے ساتھ اس میں شامل ہلکے پھلکے کاروباری منطق کے ساتھ ہوسٹ کیا جائے۔ ان ماڈلز کو ایک ہی مثال پر ایک یا ایک سے زیادہ کنٹینرز میں مزید سمیٹا جا سکتا ہے تاکہ چلانے کے عمل کو الگ تھلگ رکھا جا سکے اور تاخیر کو کم رکھا جا سکے۔ مزید برآں، مجموعی تاخیر کا انحصار انفرنس ایپلی کیشن لاجک، ماڈل آپٹیمائزیشنز، بنیادی انفراسٹرکچر (بشمول کمپیوٹ، اسٹوریج، اور نیٹ ورکنگ) پر بھی ہوتا ہے، اور بنیادی ویب سرور انفرنس کی درخواستیں لے رہا ہے۔ NVIDIA ٹرائٹن انفرنس سرور ایک اوپن سورس انفرنس سرونگ سافٹ ویئر ہے جس میں انتہائی کم (سنگل ڈیجٹ ملی سیکنڈ) انفرنس لیٹنسی کے ساتھ تھرو پٹ اور ہارڈ ویئر کے استعمال کو زیادہ سے زیادہ کرنے کی خصوصیات ہیں۔ اس میں ML فریم ورکس (بشمول TensorFlow، PyTorch، ONNX، XGBoost، اور NVIDIA TensorRT) اور انفراسٹرکچر بیک اینڈز بشمول GPUs، CPUs، اور AWS Inferentia. مزید برآں، ٹرائٹن انفرنس سرور کے ساتھ مربوط ہے۔ ایمیزون سیج میکر، ایک مکمل طور پر منظم اینڈ ٹو اینڈ ایم ایل سروس، بشمول ریئل ٹائم انفرنس آپشنز فراہم کرتی ہے۔ ایک اور ملٹی ماڈل ہوسٹنگ ان انفرنس آپشنز میں ایک ہی کنٹینر میں ایک کے پیچھے متعدد ماڈلز کی میزبانی کرنا شامل ہے۔ واحد اختتامی نقطہ، اور ہوسٹنگ متعدد کنٹینرز کے ساتھ متعدد ماڈل ایک اختتامی نقطہ کے پیچھے۔

نومبر 2021 میں، ہم نے اعلان کیا۔ سیج میکر پر ٹرائٹن انفرنس سرور کا انضمام. AWS نے NVIDIA کے ساتھ مل کر کام کیا تاکہ آپ کو دونوں جہانوں سے بہترین حاصل کرنے کے قابل بنایا جا سکے اور AWS پر Triton کے ساتھ ماڈل کی تعیناتی کو آسان بنایا جا سکے۔

اس پوسٹ میں، ہم SageMaker پر Triton Inference Server کا استعمال کرتے ہوئے GPUs پر پیمانے پر ٹرانسفارمر ماڈلز کی تعیناتی کے بہترین طریقوں کو دیکھتے ہیں۔ سب سے پہلے، ہم SageMaker میں لیٹنسی کے بارے میں کلیدی تصورات کے خلاصے کے ساتھ شروع کرتے ہیں، اور پرفارمنس ٹیوننگ گائیڈ لائنز کے ایک جائزہ کے ساتھ۔ اگلا، ہم ٹریٹن اور اس کی خصوصیات کا ایک جائزہ فراہم کرتے ہیں نیز SageMaker پر تعیناتی کے لیے مثالی کوڈ فراہم کرتے ہیں۔ آخر میں، ہم استعمال کرتے ہوئے لوڈ ٹیسٹ انجام دیتے ہیں۔ سیج میکر انفرنس تجویز کنندہ اور Hugging Face کے ذریعہ فراہم کردہ مقبول ٹرانسفارمر ماڈل کی لوڈ ٹیسٹنگ سے حاصل ہونے والی بصیرت اور نتائج کا خلاصہ کریں۔

آپ جائزہ لے سکتے ہیں۔ نوٹ بک ہم ماڈلز تعینات کرتے تھے اور کوڈ آن کا استعمال کرتے ہوئے آپ خود لوڈ ٹیسٹ کرتے تھے۔ GitHub کے.

SageMaker پر پیش کرنے والے ماڈل کے لیے کارکردگی کی ٹیوننگ اور اصلاح

پرفارمنس ٹیوننگ اور آپٹیمائزیشن ایک تجرباتی عمل ہے جس میں اکثر متعدد تکرار شامل ہوتے ہیں۔ ٹیون کرنے کے لیے پیرامیٹرز کی تعداد مشترکہ ہے اور کنفیگریشن پیرامیٹر ویلیوز کا سیٹ ایک دوسرے سے آزاد نہیں ہے۔ مختلف عوامل زیادہ سے زیادہ پیرامیٹر ٹیوننگ کو متاثر کرتے ہیں، بشمول پے لوڈ کا سائز، قسم، اور انفرنس ریکوسٹ فلو گراف میں ML ماڈلز کی تعداد، اسٹوریج کی قسم، کمپیوٹ مثال کی قسم، نیٹ ورک انفراسٹرکچر، ایپلیکیشن کوڈ، انفرنس سرونگ سافٹ ویئر رن ٹائم اور کنفیگریشن، اور بہت کچھ۔

اگر آپ ML ماڈلز کی تعیناتی کے لیے SageMaker استعمال کر رہے ہیں، تو آپ کو بہترین قیمت کی کارکردگی کے ساتھ ایک کمپیوٹ مثال کا انتخاب کرنا ہوگا، جو کہ ایک پیچیدہ اور تکراری عمل ہے جس میں تجربات کے ہفتوں کا وقت لگ سکتا ہے۔ سب سے پہلے، آپ کو اپنے ماڈلز کے وسائل کی ضروریات اور ان پٹ ڈیٹا کے سائز کی بنیاد پر 70 سے زیادہ اختیارات میں سے صحیح ML مثال کی قسم کا انتخاب کرنا ہوگا۔ اگلا، آپ کو منتخب مثال کی قسم کے لیے ماڈل کو بہتر بنانے کی ضرورت ہے۔ آخر میں، آپ کو لوڈ ٹیسٹ چلانے اور بہترین کارکردگی اور لاگت کے لیے کلاؤڈ کنفیگریشن کو ٹیون کرنے کے لیے انفراسٹرکچر کی فراہمی اور انتظام کرنے کی ضرورت ہے۔ یہ سب ماڈل کی تعیناتی اور مارکیٹ میں وقت میں تاخیر کر سکتا ہے۔ مزید برآں، آپ کو زیادہ سے زیادہ تعیناتی ترتیب کو منتخب کرنے کے لیے تاخیر، تھرو پٹ، اور لاگت کے درمیان تجارت کا جائزہ لینے کی ضرورت ہے۔ سیج میکر انفرنس تجویز کنندہ خود بخود صحیح کمپیوٹ مثال کی قسم، مثال کی گنتی، کنٹینر کے پیرامیٹرز، اور تخمینہ کے لیے ماڈل کی اصلاح کا انتخاب کرتا ہے تاکہ تھرو پٹ کو زیادہ سے زیادہ بنایا جا سکے، تاخیر کو کم کیا جا سکے، اور لاگت کو کم کیا جا سکے۔

سیج میکر میں اصل وقت کا اندازہ اور تاخیر

سیج میکر ریئل ٹائم اندازہ انفرنس ورک بوجھ کے لیے مثالی ہے جہاں آپ کے پاس ریئل ٹائم، انٹرایکٹو، کم تاخیر کے تقاضے ہیں۔ SageMaker انفرنس اینڈ پوائنٹس کے لیے انفرنس کی درخواست میں تاخیر کی نگرانی کے لیے عام طور پر استعمال ہونے والے چار میٹرکس ہیں۔

- کنٹینر میں تاخیر - درخواست بھیجنے میں جو وقت لگتا ہے، ماڈل کے کنٹینر سے جواب حاصل کریں، اور کنٹینر میں مکمل اندازہ لگائیں۔ یہ میٹرک ایمیزون کلاؤڈ واچ کے حصے کے طور پر دستیاب ہے۔ انووکیشن میٹرکس سیج میکر کے ذریعہ شائع کیا گیا۔

- ماڈل میں تاخیر - ایک میں تمام SageMaker کنٹینرز کے ذریعہ لیا جانے والا کل وقت انفرنس پائپ لائن. یہ میٹرک ایمیزون کلاؤڈ واچ کے حصے کے طور پر دستیاب ہے۔ انووکیشن میٹرکس سیج میکر کے ذریعہ شائع کیا گیا۔

- اوور ہیڈ لیٹنسی - سیج میکر کو درخواست موصول ہونے کے وقت سے ماپا جاتا ہے جب تک کہ وہ کلائنٹ کو جواب نہیں دیتا، ماڈل کی تاخیر کو کم کر کے۔ یہ میٹرک ایمیزون کلاؤڈ واچ کے حصے کے طور پر دستیاب ہے۔ انووکیشن میٹرکس سیج میکر کے ذریعہ شائع کیا گیا۔

- آخر سے آخر میں تاخیر - اس وقت سے ماپا جاتا ہے جب کلائنٹ تخمینہ کی درخواست بھیجتا ہے جب تک کہ اسے جواب واپس نہ ملے۔ صارفین اسے Amazon CloudWatch میں حسب ضرورت میٹرک کے طور پر شائع کر سکتے ہیں۔

درج ذیل خاکہ ان اجزاء کی وضاحت کرتا ہے۔

کنٹینر میں تاخیر کا انحصار کئی عوامل پر ہوتا ہے۔ مندرجہ ذیل سب سے اہم میں سے ہیں:

- بنیادی پروٹوکول (HTTP(s)/gRPC) جو انفرنس سرور کے ساتھ بات چیت کے لیے استعمال ہوتا ہے

- نئے TLS کنکشن بنانے سے متعلق اوور ہیڈ

- درخواست/جواب پے لوڈ کی ڈی سیریلائزیشن کا وقت

- انڈرلینگ انفرنس سرور کے ذریعہ فراہم کردہ قطار اور بیچنگ کی خصوصیات کی درخواست کریں۔

- بنیادی انفرنس سرور کے ذریعہ فراہم کردہ شیڈولنگ کی صلاحیتوں کی درخواست کریں۔

- انفرنس سرور کی بنیادی رن ٹائم کارکردگی

- ماڈل پیشن گوئی فنکشن کو کال کرنے سے پہلے پری پروسیسنگ اور پوسٹ پروسیسنگ لائبریریوں کی کارکردگی

- بنیادی ML فریم ورک پسدید کارکردگی

- ماڈل کے لیے مخصوص اور ہارڈ ویئر کے لیے مخصوص اصلاح

اس پوسٹ میں، ہم بنیادی طور پر مجموعی تھرو پٹ اور لاگت کے ساتھ ساتھ کنٹینر کی تاخیر کو بہتر بنانے پر توجہ مرکوز کرتے ہیں۔ خاص طور پر، ہم سیج میکر کنٹینر کے اندر چلنے والے پرفارمنس ٹیوننگ ٹریٹن انفرنس سرور کو تلاش کرتے ہیں۔

کیس کا جائزہ استعمال کریں۔

پروڈکشن سیٹ اپ میں NLP ماڈلز کی تعیناتی اور اسکیل کرنا کافی مشکل ہو سکتا ہے۔ NLP ماڈل اکثر سائز میں بہت بڑے ہوتے ہیں، جس میں لاکھوں ماڈل پیرامیٹرز ہوتے ہیں۔ پروڈکشن گریڈ NLP ایپلی کیشنز کی سخت کارکردگی اور اسکیل ایبلٹی کی ضروریات کو پورا کرنے کے لیے بہترین ماڈل کنفیگریشنز کی ضرورت ہے۔

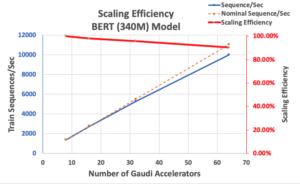

اس پوسٹ میں، ہم Triton Inference Server کنٹینر پر مبنی SageMaker ریئل ٹائم اینڈ پوائنٹ کا استعمال کرتے ہوئے NLP کے استعمال کے کیس کو بینچ مارک کرتے ہیں اور اپنے ML استعمال کے کیس کے لیے پرفارمنس ٹیوننگ آپٹیمائزیشن کی تجویز کرتے ہیں۔ ہم ایک بڑا، پہلے سے تربیت یافتہ ٹرانسفارمر پر مبنی Hugging Face استعمال کرتے ہیں۔ BERT بڑا بغیر کیس کے ماڈل، جس میں تقریباً 336 ملین ماڈل پیرامیٹرز ہیں۔ بائنری درجہ بندی کے ماڈل کے لیے استعمال ہونے والے ان پٹ جملے کو پیڈ کیا جاتا ہے اور 512 ٹوکنز کی زیادہ سے زیادہ ان پٹ ترتیب کی لمبائی تک چھوٹا کیا جاتا ہے۔ انفرنس لوڈ ٹیسٹ 500 درخواستیں فی سیکنڈ (30,000 زیادہ سے زیادہ درخواستیں فی منٹ) اور ModelLatency 0.5 سیکنڈ (500 ملی سیکنڈ) سے کم۔

درج ذیل جدول ہماری بینچ مارک کنفیگریشن کا خلاصہ کرتا ہے۔

| ماڈل کا نام | گلے لگانے والا چہرہ bert-large-uncased |

| ماڈل سائز | 1.25 GB |

| تاخیر کی ضرورت | 0.5 سیکنڈ (500 ملی سیکنڈ) |

| فی سیکنڈ دعوتیں | 500 درخواستیں (30,000 فی منٹ) |

| ان پٹ تسلسل کی لمبائی | 512 ٹوکن |

| ایم ایل ٹاسک | بائنری درجہ بندی |

NVIDIA ٹرائٹن انفرنس سرور

ٹرائٹن انفرنس سرور خاص طور پر ڈیزائن کیا گیا ہے تاکہ پروڈکشن میں ماڈلز کی توسیع پذیر، تیز رفتار اور آسان تعیناتی کو ممکن بنایا جا سکے۔ ٹریٹن مختلف قسم کے بڑے AI فریم ورکس کو سپورٹ کرتا ہے، بشمول TensorFlow، TensorRT، PyTorch، XGBoost اور ONNX۔ Python اور C++ کسٹم بیک اینڈ کے ساتھ، آپ مزید حسب ضرورت استعمال کے معاملات کے لیے اپنے انفرنس ورک بوجھ کو بھی لاگو کر سکتے ہیں۔

سب سے اہم بات، ٹرائٹن آپ کے ماڈلز کی میزبانی کے لیے ایک سادہ کنفیگریشن پر مبنی سیٹ اپ فراہم کرتا ہے، جو کارکردگی کی اصلاح کی خصوصیات کے ایک بھرپور سیٹ کو ظاہر کرتا ہے جسے آپ کوڈنگ کی تھوڑی کوشش کے ساتھ استعمال کر سکتے ہیں۔

ٹرائٹن مختلف اصلاحی تکنیکوں کے ساتھ ہارڈ ویئر کے استعمال کو زیادہ سے زیادہ کرکے انفرنس کی کارکردگی کو بڑھاتا ہے (سمورتی ماڈل رن اور ڈائنامک بیچنگ سب سے زیادہ استعمال ہوتے ہیں)۔ ڈائنامک بیچ سائز کے مختلف امتزاج سے بہترین ماڈل کنفیگریشنز تلاش کرنا اور ہم آہنگی ماڈل مثالوں کی تعداد Triton کا استعمال کرتے ہوئے کم لاگت سرونگ کے اندر حقیقی وقت کا اندازہ حاصل کرنے کی کلید ہے۔

متحرک بیچنگ

جب سرور کو متعدد آزاد درخواستوں کے ساتھ مدعو کیا جاتا ہے تو بہت سے پریکٹیشنرز ترتیب وار تخمینہ چلاتے ہیں۔ اگرچہ سیٹ اپ کرنا آسان ہے، لیکن GPU کی کمپیوٹ پاور کو استعمال کرنا عام طور پر بہترین عمل نہیں ہے۔ اس سے نمٹنے کے لیے، ٹریٹن بلٹ ان آپٹیمائزیشنز پیش کرتا ہے۔ متحرک بیچنگ سرور کی طرف سے ان آزاد انفرنس کی درخواستوں کو یکجا کرکے تھرو پٹ کو بڑھانے کے لیے متحرک طور پر ایک بڑا بیچ بنانے کے لیے۔ درج ذیل خاکہ ٹرائٹن رن ٹائم فن تعمیر کو واضح کرتا ہے۔

پچھلے فن تعمیر میں، تمام درخواستیں اصل ماڈل شیڈیولر قطاروں میں داخل ہونے سے پہلے پہلے ڈائنامک بیچر تک پہنچ جاتی ہیں تاکہ اندازہ کا انتظار کیا جا سکے۔ آپ کا استعمال کرتے ہوئے متحرک بیچنگ کے لیے اپنے پسندیدہ بیچ سائز سیٹ کر سکتے ہیں۔ ترجیحی_بیچ_سائز ماڈل کی ترتیب میں ترتیبات۔ (نوٹ کریں کہ تشکیل شدہ بیچ کا سائز سے کم ہونا ضروری ہے۔ max_batch_size ماڈل سپورٹ کرتا ہے۔) آپ کنفیگر بھی کر سکتے ہیں۔ max_queue_delay_microseconds آپ کی تاخیر کی ضروریات کی بنیاد پر بیچ میں شامل ہونے کے لیے دیگر درخواستوں کا انتظار کرنے کے لیے بیچر میں زیادہ سے زیادہ تاخیر کا وقت بتانے کے لیے۔

درج ذیل کوڈ کا ٹکڑا دکھاتا ہے کہ آپ اس خصوصیت کو ماڈل کنفیگریشن فائلوں کے ساتھ کیسے شامل کر سکتے ہیں تاکہ اصل تخمینہ کے لیے 16 کے ترجیحی بیچ سائز کے ساتھ متحرک بیچنگ سیٹ کریں۔ موجودہ ترتیبات کے ساتھ، ماڈل مثال کو فوری طور پر طلب کیا جاتا ہے جب 16 کا ترجیحی بیچ سائز پورا ہو جاتا ہے یا 100 مائیکرو سیکنڈز کی تاخیر کا وقت گزر جاتا ہے جب سے پہلی درخواست متحرک بیچر تک پہنچ جاتی ہے۔

ایک ساتھ چل رہے ماڈل

اضافی تاخیر کے بغیر ہارڈ ویئر کے استعمال کو زیادہ سے زیادہ کرنے کے لیے ٹرائٹن میں پیش کردہ ایک اور ضروری اصلاح ہے سمورتی ماڈل پر عملدرآمد، جو متعدد ماڈلز یا ایک ہی ماڈل کی متعدد کاپیوں کو متوازی طور پر چلانے کی اجازت دیتا ہے۔ یہ خصوصیت ٹرائٹن کو ایک ساتھ متعدد تخمینہ کی درخواستوں کو سنبھالنے کے قابل بناتی ہے، جو ہارڈ ویئر پر بصورت دیگر آئیڈیل کمپیوٹ پاور کو استعمال کرکے انفرنس تھرو پٹ کو بڑھاتا ہے۔

مندرجہ ذیل اعداد و شمار دکھاتا ہے کہ آپ کوڈ کی تبدیلیوں کی صرف چند لائنوں کے ساتھ مختلف ماڈل کی تعیناتی کی پالیسیوں کو آسانی سے کنفیگر کر سکتے ہیں۔ مثال کے طور پر، کنفیگریشن A (بائیں) سے پتہ چلتا ہے کہ آپ دو ماڈل مثالوں کی ایک ہی ترتیب کو نشر کر سکتے ہیں۔ bert-large-uncased تمام دستیاب GPUs کو۔ اس کے برعکس، کنفیگریشن B (درمیانی) دوسرے GPUs پر پالیسیوں کو تبدیل کیے بغیر، صرف GPU 0 کے لیے ایک مختلف کنفیگریشن دکھاتی ہے۔ آپ ایک ہی GPU پر مختلف ماڈلز کی مثالیں بھی لگا سکتے ہیں، جیسا کہ کنفیگریشن C (دائیں) میں دکھایا گیا ہے۔

کنفیگریشن C میں، کمپیوٹ مثال DistilGPT-2 ماڈل کے لیے دو سمورتی درخواستوں اور سات ہم آہنگی درخواستوں کو سنبھال سکتی ہے۔ bert-large-uncased متوازی میں ماڈل. ان اصلاحوں کے ساتھ، ہارڈ ویئر کے وسائل کو سرونگ کے عمل کے لیے بہتر طریقے سے استعمال کیا جا سکتا ہے، اس طرح تھرو پٹ کو بہتر بنایا جا سکتا ہے اور آپ کے کام کے بوجھ کے لیے بہتر لاگت کی کارکردگی فراہم کی جا سکتی ہے۔

TensorRT

NVIDIA TensorRT ہائی پرفارمنس ڈیپ لرننگ انفرنس کے لیے ایک SDK ہے جو Triton کے ساتھ بغیر کسی رکاوٹ کے کام کرتا ہے۔ TensorRT، جو کہ ہر بڑے گہرے سیکھنے کے فریم ورک کو سپورٹ کرتا ہے، اس میں ایک انفرنس آپٹیمائزر اور رن ٹائم شامل ہے جو طاقتور آپٹیمائزیشنز کے ذریعے ڈیٹا کی بڑی مقدار کے ساتھ انفرنسز کو چلانے کے لیے کم تاخیر اور زیادہ تھرو پٹ فراہم کرتا ہے۔

TensorRT غیر ضروری میموری کو آزاد کرکے اور اسے موثر طریقے سے دوبارہ استعمال کرکے میموری کے نقش کو کم سے کم کرنے کے لیے گراف کو بہتر بناتا ہے۔ مزید برآں، TensorRT تالیف ماڈل گراف کے اندر اسپارس آپریشنز کو فیوز کرتی ہے تاکہ ایک سے زیادہ چھوٹے کرنل لانچوں کے اوور ہیڈ سے بچنے کے لیے ایک بڑا دانا بنایا جا سکے۔ کرنل آٹو ٹیوننگ آپ کو اپنے ہدف کے GPU پر بہترین الگورتھم کا انتخاب کرکے ہارڈ ویئر کو مکمل طور پر استعمال کرنے میں مدد کرتی ہے۔ بہترین کارکردگی کے لیے آپ کے GPU کے استعمال کو زیادہ سے زیادہ کرنے کے لیے CUDA اسٹریمز ماڈلز کو متوازی طور پر چلانے کے قابل بناتے ہیں۔ آخری لیکن کم از کم، کوانٹائزیشن تکنیک بہترین تخمینہ کارکردگی حاصل کرنے کے لیے FP32، TF32، FP16، اور INT8 میں ماڈل کو چلانے کے لیے Tensor cores کے مخلوط-پریسیجن ایکسلریشن کو مکمل طور پر استعمال کر سکتی ہے۔

سیج میکر ہوسٹنگ پر ٹرائٹن

سیج میکر ہوسٹنگ سروسز SageMaker کی خصوصیات کا مجموعہ ہیں جن کا مقصد ماڈل کی تعیناتی اور خدمات کو آسان بنانا ہے۔ یہ مختلف استعمال کے معاملات کے لیے تیار کردہ ایم ایل ماڈلز کو آسانی سے تعینات کرنے، آٹو اسکیل، مانیٹر کرنے اور بہتر بنانے کے لیے متعدد اختیارات فراہم کرتا ہے۔ اس کا مطلب یہ ہے کہ آپ اپنی تعیناتیوں کو ہر قسم کے استعمال کے نمونوں کے لیے بہتر بنا سکتے ہیں، مستقل اور ہمیشہ بغیر سرور کے اختیارات کے ساتھ دستیاب، عارضی، طویل مدتی، یا بیچ کے تخمینہ کی ضروریات تک۔

سیج میکر ہوسٹنگ چھتری کے نیچے سیج میکر انفرنس ڈیپ لرننگ کنٹینرز (DLCs) کا سیٹ بھی ہے، جو اپنے متعلقہ معاون ایم ایل فریم ورک کے لیے مناسب ماڈل سرور سافٹ ویئر کے ساتھ پہلے سے پیک کیا جاتا ہے۔ یہ آپ کو بغیر کسی ماڈل سرور سیٹ اپ کے اعلیٰ کارکردگی کی کارکردگی حاصل کرنے کے قابل بناتا ہے، جو کہ اکثر ماڈل کی تعیناتی کا سب سے پیچیدہ تکنیکی پہلو ہوتا ہے اور عام طور پر، ڈیٹا سائنسدان کی مہارت کے سیٹ کا حصہ نہیں ہوتا ہے۔ ٹرائٹن انفرنس سرور اب ہے۔ دستیاب سیج میکر ڈیپ لرننگ کنٹینرز پر (DLC).

اختیارات کی یہ وسعت، ماڈیولرٹی، اور مختلف سرونگ فریم ورک کے استعمال میں آسانی سیج میکر اور ٹریٹن کو ایک طاقتور میچ بناتی ہے۔

بینچ مارکنگ ٹیسٹ کے نتائج کے لیے SageMaker Inference تجویز کنندہ

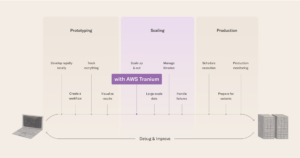

ہم اپنے تجربات کو چلانے کے لیے SageMaker Inference Recommender استعمال کرتے ہیں۔ SageMaker Inference Recommender دو قسم کی ملازمتیں پیش کرتا ہے: ڈیفالٹ اور ایڈوانسڈ، جیسا کہ مندرجہ ذیل خاکہ میں دکھایا گیا ہے۔

پہلے سے طے شدہ جاب مثال کے طور پر صرف ماڈل اور نمونہ پے لوڈ کے ساتھ بینچ مارک کے لیے سفارشات فراہم کرتا ہے۔ مثال کی سفارشات کے علاوہ، سروس رن ٹائم پیرامیٹرز بھی پیش کرتی ہے جو کارکردگی کو بہتر بناتے ہیں۔ پہلے سے طے شدہ ملازمت کی سفارشات کا مقصد مثال کی تلاش کو کم کرنا ہے۔ کچھ معاملات میں، یہ مثال کا خاندان ہو سکتا ہے، اور دوسروں میں، یہ مخصوص مثال کی اقسام ہو سکتی ہے۔ پہلے سے طے شدہ جاب کے نتائج کو پھر ایڈوانس جاب میں فیڈ کیا جاتا ہے۔

اعلی درجے کی نوکری کارکردگی کو مزید بہتر بنانے کے لیے مزید کنٹرول پیش کرتی ہے۔ یہ کنٹرولز حقیقی ماحول اور پیداواری ضروریات کی تقلید کرتے ہیں۔ ان کنٹرولز میں ٹریفک پیٹرن ہے، جس کا مقصد بینچ مارکس کے لیے درخواست کے پیٹرن کو ترتیب دینا ہے۔ آپ ٹریفک پیٹرن کے متعدد مراحل کا استعمال کرکے ریمپ یا مستحکم ٹریفک سیٹ کرسکتے ہیں۔ مثال کے طور پر، ایک ابتدائی نمبر استعمال کنندگان 1 ، سپون ریٹ 1، اور دورانیہ سیکنڈ سیکنڈ 600 کے نتیجے میں شروع میں 10 اور آخر میں 1 کے ساتھ 10 منٹ کی ریمپ ٹریفک ہو سکتی ہے۔ مزید برآں، کنٹرولز پر، MaxInvocations اور ماڈل لیٹنسی تھریشولڈز پیداوار کی حد متعین کریں، لہذا جب ایک حد سے تجاوز ہو جائے تو بینچ مارکنگ رک جاتی ہے۔

آخر میں، سفارش کی پیمائش اس میں تھرو پٹ، زیادہ سے زیادہ تھرو پٹ پر تاخیر، اور فی تخمینہ لاگت شامل ہے، لہذا ان کا موازنہ کرنا آسان ہے۔

ہم ٹریفک کے نمونوں پر اضافی کنٹرول حاصل کرنے کے لیے اپنے تجربات کو چلانے کے لیے SageMaker Inference Recommender کی اعلی درجے کی جاب کی قسم کا استعمال کرتے ہیں، اور سرونگ کنٹینر کی ترتیب کو ٹھیک بناتے ہیں۔

تجربہ سیٹ اپ

ہم اپنے استعمال کے کیس میں بیان کردہ NLP پروفائل کو بینچ مارک کرنے کے لیے SageMaker Inference Recommender کی حسب ضرورت لوڈ ٹیسٹ فیچر استعمال کرتے ہیں۔ ہم پہلے این ایل پی ماڈل اور ایم ایل ٹاسک سے متعلق درج ذیل شرائط کی وضاحت کرتے ہیں۔ SageMaker Inference Recommender اس معلومات کو انفرنس ڈوکر امیج سے کھینچنے کے لیے استعمال کرتا ہے۔ ایمیزون لچکدار کنٹینر رجسٹری (ایمیزون ای سی آر) اور ماڈل کو سیج میکر ماڈل رجسٹری کے ساتھ رجسٹر کریں۔

| ڈومین | NATURAL_LANGUAGE_PROCESSING |

| ٹاسک | FILL_MASK |

| فریم ورک | PYTORCH: 1.6.0 |

| ماڈل | bert-large-uncased |

SageMaker Inference Recommender میں ٹریفک پیٹرن کی ترتیب ہمیں حسب ضرورت لوڈ ٹیسٹ کے لیے مختلف مراحل کی وضاحت کرنے کی اجازت دیتی ہے۔ لوڈ ٹیسٹ دو ابتدائی صارفین کے ساتھ شروع ہوتا ہے اور 25 منٹ (1500 سیکنڈ) کی کل مدت کے لیے ہر منٹ میں دو نئے صارفین پیدا کرتا ہے، جیسا کہ درج ذیل کوڈ میں دکھایا گیا ہے:

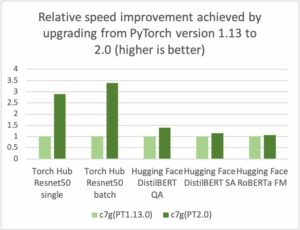

ہم دو مختلف ریاستوں میں ایک ہی ماڈل کی لوڈ ٹیسٹنگ کے ساتھ تجربہ کرتے ہیں۔ PyTorch پر مبنی تجربات معیاری، غیر تبدیل شدہ PyTorch ماڈل استعمال کرتے ہیں۔ TensorRT پر مبنی تجربات کے لیے، ہم PyTorch ماڈل کو پہلے سے TensorRT انجن میں تبدیل کر دیتے ہیں۔

ہم ان دو ماڈلز پر کارکردگی کی اصلاح کی خصوصیات کے مختلف امتزاج کا اطلاق کرتے ہیں، جن کا خلاصہ درج ذیل جدول میں کیا گیا ہے۔

| کنفیگریشن کا نام | ترتیب کی تفصیل | ماڈل ترتیب |

pt-base |

PyTorch بیس لائن | بیس PyTorch ماڈل، کوئی تبدیلی نہیں |

pt-db |

PyTorch متحرک بیچنگ کے ساتھ | dynamic_batching{} |

pt-ig |

PyTorch متعدد ماڈل مثالوں کے ساتھ | instance_group [ { count: 2 kind: KIND_GPU } ] |

pt-ig-db |

PyTorch متعدد ماڈل مثالوں اور متحرک بیچنگ کے ساتھ | dynamic_batching {},instance_group [ { count: 2 kind: KIND_GPU }] |

trt-base |

TensorRT بیس لائن | PyTorch ماڈل TensoRT کے ساتھ مرتب کیا گیا۔ trtexec کی افادیت |

trt-db |

متحرک بیچنگ کے ساتھ TensorRT | dynamic_batching{} |

trt-ig |

متعدد ماڈل مثالوں کے ساتھ TensorRT | instance_group [ { count: 2 kind: KIND_GPU }] |

trt-ig-db |

متعدد ماڈل مثالوں اور متحرک بیچنگ کے ساتھ TensorRT | dynamic_batching{},instance_group [ { count: 2 kind: KIND_GPU }] |

ٹیسٹ کے نتائج اور مشاہدات

ہم نے ایک ہی g4dn خاندان کے اندر تین مثالوں کے لیے لوڈ ٹیسٹ کیے: ml.g4dn.xlarge، ml.g4dn.2xlarge اور ml.g4dn.12xlarge۔ تمام g4dn مثال کی اقسام کو NVIDIA T4 Tensor Core GPUs، اور 2nd جنریشن Intel Cascade Lake پروسیسرز تک رسائی حاصل ہے۔ مثال کی اقسام کے انتخاب کے پیچھے منطق یہ تھی کہ دونوں مثالیں صرف ایک GPU کے ساتھ دستیاب ہوں، اور ساتھ ہی ایک سے زیادہ GPUs تک رسائی کے ساتھ ایک مثال - ml.g4dn.12xlarge کے معاملے میں چار۔ مزید برآں، ہم یہ جانچنا چاہتے تھے کہ آیا صرف ایک دستیاب GPU کے ساتھ مثال کے طور پر vCPU کی گنجائش بڑھانے سے لاگت اور کارکردگی کے تناسب میں بہتری آئے گی۔

آئیے پہلے انفرادی اصلاح کی رفتار کو دیکھیں۔ مندرجہ ذیل گراف سے پتہ چلتا ہے کہ TensorRT آپٹیمائزیشن ml.g50dn.xlarge مثال پر PyTorch میں مقامی کے مقابلے ماڈل کی تاخیر میں 4% کمی فراہم کرتی ہے۔ یہ تاخیر میں کمی ml.g4dn.12xlarge کے ملٹی GPU مثالوں پر تین گنا سے زیادہ بڑھ جاتی ہے۔ دریں اثنا، 30% تھرو پٹ بہتری دونوں صورتوں میں یکساں ہے، جس کے نتیجے میں TensorRT آپٹیمائزیشنز کو لاگو کرنے کے بعد لاگت کی بہتر کارکردگی ہوتی ہے۔

متحرک بیچنگ کے ساتھ، ہم ml.g2dn.xlarge، ml.g4dn.4xlarge اور ml.g2dn.4xlarge کے تمام تجربات پر ایک ہی ہارڈویئر فن تعمیر کا استعمال کرتے ہوئے تھرو پٹ میں 12x کے قریب بہتری حاصل کر سکتے ہیں، بغیر قابل توجہ تاخیر کے اضافے کے۔

اسی طرح، ہم آہنگی ماڈل پر عمل درآمد ہمیں ml.g3dn.xlarge مثال پر GPU کے استعمال کو زیادہ سے زیادہ کرکے اور ml.g4dn.4xlarge مثال اور ml کے ملٹی-GPU مثال دونوں پر تقریباً 2x بہتری کے ذریعے تھرو پٹ میں تقریباً 4-2x بہتری حاصل کرنے کے قابل بناتا ہے۔ g4dn.12xlarge.. یہ تھرو پٹ اضافہ تاخیر میں بغیر کسی اوور ہیڈ کے آتا ہے۔

اس سے بھی بہتر، ہم ہارڈ ویئر کے وسائل کو بھرپور طریقے سے استعمال کرتے ہوئے بہترین کارکردگی فراہم کرنے کے لیے ان تمام اصلاحات کو مربوط کر سکتے ہیں۔ درج ذیل جدول اور گراف ان نتائج کا خلاصہ کرتے ہیں جو ہم نے اپنے تجربات میں حاصل کیے ہیں۔

| کنفیگریشن کا نام | ماڈل کی اصلاح |

متحرک بیچنگ |

مثال گروپ کی تشکیل | مثال کی قسم | vCPUs | GPUs |

GPU میموری (جی بی) |

ابتدائی مثال کی گنتیہے [1] | درخواستیں فی منٹ فی مثال | ماڈل لیٹنسی | لاگت فی گھنٹہہے [2] |

| pt-base | NA | نہیں | NA | ml.g4dn.xlarge | 4 | 1 | 16 | 62 | 490 | 1500 | 45.6568 |

| pt-db | NA | جی ہاں | NA | ml.g4dn.xlarge | 4 | 1 | 16 | 57 | 529 | 1490 | 41.9748 |

| pt-ig | NA | نہیں | 2 | ml.g4dn.xlarge | 4 | 1 | 16 | 34 | 906 | 868 | 25.0376 |

| pt-ig-db | NA | جی ہاں | 2 | ml.g4dn.xlarge | 4 | 1 | 16 | 34 | 892 | 1158 | 25.0376 |

| trt بیس | TensorRT | نہیں | NA | ml.g4dn.xlarge | 4 | 1 | 16 | 47 | 643 | 742 | 34.6108 |

| trt-db | TensorRT | جی ہاں | NA | ml.g4dn.xlarge | 4 | 1 | 16 | 28 | 1078 | 814 | 20.6192 |

| trt-ig | TensorRT | نہیں | 2 | ml.g4dn.xlarge | 4 | 1 | 16 | 14 | 2202 | 1273 | 10.3096 |

| trt-db-ig | TensorRT | جی ہاں | 2 | ml.g4dn.xlarge | 4 | 1 | 16 | 10 | 3192 | 783 | 7.364 |

| pt-base | NA | نہیں | NA | ml.g4dn.2xlarge | 8 | 1 | 32 | 56 | 544 | 1500 | 52.64 |

| pt-db | NA | جی ہاں | NA | ml.g4dn.2xlarge | 8 | 1 | 32 | 59 | 517 | 1500 | 55.46 |

| pt-ig | NA | نہیں | 2 | ml.g4dn.2xlarge | 8 | 1 | 32 | 29 | 1054 | 960 | 27.26 |

| pt-ig-db | NA | جی ہاں | 2 | ml.g4dn.2xlarge | 8 | 1 | 32 | 30 | 1017 | 992 | 28.2 |

| trt بیس | TensorRT | نہیں | NA | ml.g4dn.2xlarge | 8 | 1 | 32 | 42 | 718 | 1494 | 39.48 |

| trt-db | TensorRT | جی ہاں | NA | ml.g4dn.2xlarge | 8 | 1 | 32 | 23 | 1335 | 499 | 21.62 |

| trt-ig | TensorRT | نہیں | 2 | ml.g4dn.2xlarge | 8 | 1 | 32 | 23 | 1363 | 1017 | 21.62 |

| trt-db-ig | TensorRT | جی ہاں | 2 | ml.g4dn.2xlarge | 8 | 1 | 32 | 22 | 1369 | 963 | 20.68 |

| pt-base | NA | نہیں | NA | ml.g4dn.12xlarge | 48 | 4 | 192 | 15 | 2138 | 906 | 73.35 |

| pt-db | NA | جی ہاں | NA | ml.g4dn.12xlarge | 48 | 4 | 192 | 15 | 2110 | 907 | 73.35 |

| pt-ig | NA | نہیں | 2 | ml.g4dn.12xlarge | 48 | 4 | 192 | 8 | 3862 | 651 | 39.12 |

| pt-ig-db | NA | جی ہاں | 2 | ml.g4dn.12xlarge | 48 | 4 | 192 | 8 | 3822 | 642 | 39.12 |

| trt بیس | TensorRT | نہیں | NA | ml.g4dn.12xlarge | 48 | 4 | 192 | 11 | 2892 | 279 | 53.79 |

| trt-db | TensorRT | جی ہاں | NA | ml.g4dn.12xlarge | 48 | 4 | 192 | 6 | 5356 | 278 | 29.34 |

| trt-ig | TensorRT | نہیں | 2 | ml.g4dn.12xlarge | 48 | 4 | 192 | 6 | 5210 | 328 | 29.34 |

| trt-db-ig | TensorRT | جی ہاں | 2 | ml.g4dn.12xlarge | 48 | 4 | 192 | 6 | 5235 | 439 | 29.34 |

[1] اوپر والے جدول میں ابتدائی مثالوں کی گنتی آپ کے کام کے بوجھ کے لیے تھرو پٹ اور تاخیر کی ضروریات کو برقرار رکھنے کے لیے آٹو اسکیلنگ پالیسی کے ساتھ استعمال کرنے کے لیے مثالوں کی تجویز کردہ تعداد ہے۔

[2] اوپر والے جدول میں فی گھنٹہ لاگت کا حساب ابتدائی مثال کی گنتی اور مثال کی قسم کی قیمت کی بنیاد پر لگایا گیا ہے۔

نتائج زیادہ تر اس اثر کی توثیق کرتے ہیں جس کی مختلف کارکردگی کی اصلاح کی خصوصیات سے توقع کی جاتی تھی:

- TensorRT کی تالیف تمام مثالوں کی اقسام میں سب سے زیادہ قابل اعتماد اثر رکھتی ہے۔ ڈیفالٹ PyTorch BERT ( TensorRT انجن کی کارکردگی کے مقابلے میں تقریباً 30% کی مسلسل لاگت میں کمی کے ساتھ فی منٹ لین دین میں 35–25% کا اضافہ ہوا ہے۔

pt-base)۔ TensorRT انجن کی بڑھتی ہوئی کارکردگی کو دیگر جانچ کی گئی کارکردگی ٹیوننگ خصوصیات کے ساتھ ملایا جاتا ہے اور اس کا فائدہ اٹھایا جاتا ہے۔ - ہر GPU (مثال کے گروپ) پر دو ماڈل لوڈ کرنے سے تمام پیمائش شدہ میٹرکس کو تقریباً سختی سے دوگنا کر دیا گیا۔ فی منٹ فی مثال کے طور پر درخواستوں میں تقریباً 80-90% اضافہ ہوا، جس سے 50% کی حد میں لاگت میں کمی آئی، تقریباً گویا ہم دو GPU استعمال کر رہے ہیں۔ حقیقت میں، ایمیزون کلاؤڈ واچ g4dn.2xlarge پر ہمارے تجربات کے میٹرکس (مثال کے طور پر) اس بات کی تصدیق کرتے ہیں کہ جب ہم دو ماڈلز کے ایک مثال گروپ کو تشکیل دیتے ہیں تو CPU اور GPU دونوں کا استعمال دوگنا ہوتا ہے۔

مزید کارکردگی اور لاگت کی اصلاح کے نکات

اس پوسٹ میں پیش کردہ بینچ مارک نے صرف ممکنہ خصوصیات اور تکنیکوں کی سطح کو کھرچ دیا ہے جنہیں آپ ٹریٹن کے ساتھ استعمال کر کے تخمینہ کی کارکردگی کو بہتر بنا سکتے ہیں۔ یہ ڈیٹا پری پروسیسنگ تکنیک سے لے کر ماڈل سرور پر بائنری پے لوڈز بھیجنا یا بڑے بیچوں والے پے لوڈز سے لے کر مقامی ٹریٹن خصوصیات تک، جیسے کہ درج ذیل:

- ماڈل وارم اپ, جو پہلی قیاس کی درخواست موصول ہونے سے پہلے ماڈل کو مکمل طور پر شروع کرکے ابتدائی، سست تخمینے کی درخواستوں کو روکتا ہے۔

- رسپانس کیش، جو بار بار کی گئی درخواستوں کو محفوظ کرتا ہے۔

- ماڈل جوڑنا، جو آپ کو ایک یا زیادہ ماڈلز کی پائپ لائن بنانے اور ان ماڈلز کے درمیان ان پٹ اور آؤٹ پٹ ٹینسر کا کنکشن بنانے کے قابل بناتا ہے۔ یہ ہر درخواست کے لیے پروسیسنگ کے بہاؤ میں پری پروسیسنگ اور پوسٹ پروسیسنگ کے مراحل، یا یہاں تک کہ دوسرے ماڈلز کے ساتھ اندازہ لگانے کا امکان کھولتا ہے۔

ہم مستقبل کی پوسٹ میں ان تکنیکوں اور خصوصیات کو جانچنے اور بینچ مارک کرنے کی توقع رکھتے ہیں، لہذا دیکھتے رہیں!

نتیجہ

اس پوسٹ میں، ہم نے چند پیرامیٹرز کی کھوج کی ہے جنہیں آپ Triton Inference Server کے ساتھ PyTorch BERT ماڈل پیش کرنے کے لیے اپنے SageMaker ریئل ٹائم اینڈ پوائنٹ کی کارکردگی کو زیادہ سے زیادہ کرنے کے لیے استعمال کر سکتے ہیں۔ ہم نے ان پیرامیٹرز کو ٹھیک کرنے کے لیے بینچ مارکنگ ٹیسٹ کرنے کے لیے SageMaker Inference Recommender کا استعمال کیا۔ یہ پیرامیٹرز جوہر میں TensorRT پر مبنی ماڈل آپٹیمائزیشن سے متعلق ہیں، جس کی وجہ سے جوابی اوقات میں غیر اصلاح شدہ ورژن کے مقابلے میں تقریباً 50% بہتری آئی ہے۔ مزید برآں، ماڈلز کو بیک وقت چلانے اور ٹرائٹن کی متحرک بیچنگ کے استعمال سے تھرو پٹ میں تقریباً 70 فیصد اضافہ ہوا۔ ان پیرامیٹرز کو ٹھیک کرنے سے تخمینہ لاگت میں بھی مجموعی طور پر کمی واقع ہوئی۔

صحیح اقدار کو حاصل کرنے کا بہترین طریقہ تجربہ ہے۔ تاہم، پرفارمنس ٹیوننگ اور آپٹیمائزیشن پر تجرباتی علم کی تعمیر شروع کرنے کے لیے، آپ مختلف ٹریٹن سے متعلقہ پیرامیٹرز کے امتزاج اور ML ماڈلز اور SageMaker ML مثالوں میں کارکردگی پر ان کے اثر کا مشاہدہ کر سکتے ہیں۔

SageMaker ML لائف سائیکل کے ہر مرحلے سے غیر متفاوت ہیوی لفٹنگ کو ہٹانے کے لیے ٹولز فراہم کرتا ہے، اس طرح آپ کے ماڈل کی تعیناتیوں کو مکمل طور پر بہتر بنانے کے لیے درکار تیز تجربہ اور تلاش کی سہولت فراہم کرتا ہے۔

آپ لوڈ ٹیسٹنگ اور تعیناتی کے لیے استعمال ہونے والی نوٹ بک تلاش کر سکتے ہیں۔ GitHub کے. آپ ٹرائیٹن کنفیگریشنز اور SageMaker Inference Recommender کی سیٹنگز کو اپ ڈیٹ کر سکتے ہیں تاکہ آپ کے استعمال کے معاملے میں لاگت سے موثر اور بہترین کارکردگی کا مظاہرہ کرنے والے کام کے بوجھ کو حاصل کیا جا سکے۔

مصنفین کے بارے میں

وکرم ایلنگو ورجینیا USA میں مقیم Amazon Web Services میں AI/ML ماہر حل آرکیٹیکٹ ہے۔ وکرم مالیاتی اور انشورنس انڈسٹری کے صارفین کو ڈیزائن، سوچی سمجھی قیادت کے ساتھ مشین لرننگ ایپلی کیشنز کو بڑے پیمانے پر بنانے اور تعینات کرنے میں مدد کرتا ہے۔ وہ فی الحال پورے انٹرپرائز میں قدرتی لینگویج پروسیسنگ، ذمہ دار AI، انفرنس آپٹیمائزیشن اور اسکیلنگ ایم ایل پر مرکوز ہے۔ اپنے فارغ وقت میں، وہ اپنے خاندان کے ساتھ سفر، پیدل سفر، کھانا پکانے اور کیمپنگ سے لطف اندوز ہوتا ہے۔

وکرم ایلنگو ورجینیا USA میں مقیم Amazon Web Services میں AI/ML ماہر حل آرکیٹیکٹ ہے۔ وکرم مالیاتی اور انشورنس انڈسٹری کے صارفین کو ڈیزائن، سوچی سمجھی قیادت کے ساتھ مشین لرننگ ایپلی کیشنز کو بڑے پیمانے پر بنانے اور تعینات کرنے میں مدد کرتا ہے۔ وہ فی الحال پورے انٹرپرائز میں قدرتی لینگویج پروسیسنگ، ذمہ دار AI، انفرنس آپٹیمائزیشن اور اسکیلنگ ایم ایل پر مرکوز ہے۔ اپنے فارغ وقت میں، وہ اپنے خاندان کے ساتھ سفر، پیدل سفر، کھانا پکانے اور کیمپنگ سے لطف اندوز ہوتا ہے۔

جواؤ مورا ایمیزون ویب سروسز میں ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وہ زیادہ تر NLP کے استعمال کے معاملات پر توجہ مرکوز کرتا ہے اور صارفین کو ڈیپ لرننگ ماڈل کی تربیت اور تعیناتی کو بہتر بنانے میں مدد کرتا ہے۔ وہ کم کوڈ ایم ایل سلوشنز اور ایم ایل اسپیشلائزڈ ہارڈ ویئر کا ایک فعال حامی بھی ہے۔

جواؤ مورا ایمیزون ویب سروسز میں ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وہ زیادہ تر NLP کے استعمال کے معاملات پر توجہ مرکوز کرتا ہے اور صارفین کو ڈیپ لرننگ ماڈل کی تربیت اور تعیناتی کو بہتر بنانے میں مدد کرتا ہے۔ وہ کم کوڈ ایم ایل سلوشنز اور ایم ایل اسپیشلائزڈ ہارڈ ویئر کا ایک فعال حامی بھی ہے۔

موہن گاندھی AWS میں ایک سینئر سافٹ ویئر انجینئر ہے۔ وہ پچھلے 9 سالوں سے AWS کے ساتھ ہیں اور انہوں نے مختلف AWS خدمات جیسے EMR، EFA اور RDS پر چوکیوں پر کام کیا ہے۔ فی الحال، اس کی توجہ سیج میکر انفرنس کے تجربے کو بہتر بنانے پر ہے۔ اپنے فارغ وقت میں، وہ پیدل سفر اور میراتھن چلانے سے لطف اندوز ہوتا ہے۔

موہن گاندھی AWS میں ایک سینئر سافٹ ویئر انجینئر ہے۔ وہ پچھلے 9 سالوں سے AWS کے ساتھ ہیں اور انہوں نے مختلف AWS خدمات جیسے EMR، EFA اور RDS پر چوکیوں پر کام کیا ہے۔ فی الحال، اس کی توجہ سیج میکر انفرنس کے تجربے کو بہتر بنانے پر ہے۔ اپنے فارغ وقت میں، وہ پیدل سفر اور میراتھن چلانے سے لطف اندوز ہوتا ہے۔

دھول پٹیل AWS میں پرنسپل مشین لرننگ آرکیٹیکٹ ہے۔ انہوں نے تقسیم شدہ کمپیوٹنگ اور مصنوعی ذہانت سے متعلق مسائل پر بڑے اداروں سے لے کر درمیانے درجے کے اسٹارٹ اپس تک کی تنظیموں کے ساتھ کام کیا ہے۔ وہ NLP اور کمپیوٹر ویژن ڈومینز سمیت گہری سیکھنے پر توجہ مرکوز کرتا ہے۔ وہ صارفین کو SageMaker پر اعلیٰ کارکردگی کے ماڈل کا اندازہ حاصل کرنے میں مدد کرتا ہے۔

دھول پٹیل AWS میں پرنسپل مشین لرننگ آرکیٹیکٹ ہے۔ انہوں نے تقسیم شدہ کمپیوٹنگ اور مصنوعی ذہانت سے متعلق مسائل پر بڑے اداروں سے لے کر درمیانے درجے کے اسٹارٹ اپس تک کی تنظیموں کے ساتھ کام کیا ہے۔ وہ NLP اور کمپیوٹر ویژن ڈومینز سمیت گہری سیکھنے پر توجہ مرکوز کرتا ہے۔ وہ صارفین کو SageMaker پر اعلیٰ کارکردگی کے ماڈل کا اندازہ حاصل کرنے میں مدد کرتا ہے۔

سنتوش بھوانی Amazon SageMaker Elastic Inference ٹیم کے ساتھ ایک سینئر ٹیکنیکل پروڈکٹ مینیجر ہے۔ وہ SageMaker کے صارفین کی مدد کرنے پر توجہ مرکوز کرتا ہے تاکہ ماڈل کا اندازہ اور تعیناتی کو تیز کیا جا سکے۔ اپنے فارغ وقت میں، وہ سفر کرنے، ٹینس کھیلنے، اور بہت سی پیور چائے پینے سے لطف اندوز ہوتے ہیں۔

سنتوش بھوانی Amazon SageMaker Elastic Inference ٹیم کے ساتھ ایک سینئر ٹیکنیکل پروڈکٹ مینیجر ہے۔ وہ SageMaker کے صارفین کی مدد کرنے پر توجہ مرکوز کرتا ہے تاکہ ماڈل کا اندازہ اور تعیناتی کو تیز کیا جا سکے۔ اپنے فارغ وقت میں، وہ سفر کرنے، ٹینس کھیلنے، اور بہت سی پیور چائے پینے سے لطف اندوز ہوتے ہیں۔

جیاہونگ لیو NVIDIA میں کلاؤڈ سروس پرووائیڈر ٹیم میں ایک حل آرکیٹیکٹ ہے۔ وہ مشین لرننگ اور AI سلوشنز کو اپنانے میں کلائنٹس کی مدد کرتا ہے جو NVIDIA ایکسلریٹڈ کمپیوٹنگ کو ان کی ٹریننگ اور انفرنس چیلنجز سے نمٹنے کے لیے فائدہ اٹھاتے ہیں۔ اپنے فارغ وقت میں، وہ اوریگامی، DIY پروجیکٹس، اور باسکٹ بال کھیلنا پسند کرتا ہے۔

جیاہونگ لیو NVIDIA میں کلاؤڈ سروس پرووائیڈر ٹیم میں ایک حل آرکیٹیکٹ ہے۔ وہ مشین لرننگ اور AI سلوشنز کو اپنانے میں کلائنٹس کی مدد کرتا ہے جو NVIDIA ایکسلریٹڈ کمپیوٹنگ کو ان کی ٹریننگ اور انفرنس چیلنجز سے نمٹنے کے لیے فائدہ اٹھاتے ہیں۔ اپنے فارغ وقت میں، وہ اوریگامی، DIY پروجیکٹس، اور باسکٹ بال کھیلنا پسند کرتا ہے۔

- سکے سمارٹ۔ یورپ کا بہترین بٹ کوائن اور کرپٹو ایکسچینج۔

- پلیٹو بلاک چین۔ Web3 Metaverse انٹیلی جنس۔ علم میں اضافہ۔ مفت رسائی۔

- کرپٹو ہاک۔ Altcoin ریڈار. مفت جانچ.

- ماخذ: https://aws.amazon.com/blogs/machine-learning/achieve-hyperscale-performance-for-model-serving-using-nvidia-triton-inference-server-on-amazon-sagemaker/

- "

- 000

- 10

- 100

- 2021

- 70

- 77

- 84

- 9

- ہمارے بارے میں

- رفتار کو تیز تر

- تیز

- تک رسائی حاصل

- کے پار

- فعال

- اس کے علاوہ

- ایڈیشنل

- پتہ

- اعلی درجے کی

- AI

- یلگورتم

- تمام

- اگرچہ

- ایمیزون

- ایمیزون ویب سروسز

- کے درمیان

- کا اعلان کیا ہے

- درخواست

- ایپلی کیشنز

- درخواست دینا

- مناسب

- تقریبا

- فن تعمیر

- ارد گرد

- مصنوعی

- مصنوعی ذہانت

- اسسٹنٹ

- آٹو

- دستیاب

- AWS

- باسکٹ بال

- شروع

- معیار

- BEST

- بہترین طریقوں

- تعمیر

- عمارت

- تعمیر میں

- کاروبار

- حاصل کر سکتے ہیں

- صلاحیتوں

- اہلیت

- مقدمات

- چیلنجوں

- چیلنج

- میں سے انتخاب کریں

- درجہ بندی

- کلائنٹس

- بادل

- کوڈ

- کوڈنگ

- کے مجموعے

- کس طرح

- کامن

- مقابلے میں

- مکمل طور پر

- پیچیدہ

- سمجھوتہ

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹنگ

- ترتیب

- کنکشن

- کنٹینر

- کنٹینر

- کنٹرول

- کور

- اسی کے مطابق

- سرمایہ کاری مؤثر

- سکتا ہے

- تخلیق

- تخلیق

- موجودہ

- اس وقت

- اپنی مرضی کے

- گاہک

- گاہک کا تجربہ

- کسٹمر سپورٹ

- گاہکوں

- اعداد و شمار

- تاخیر

- فراہم کرتا ہے

- انحصار کرتا ہے

- تعیناتی

- تعینات

- تعیناتی

- تعینات

- ڈیزائن

- ڈیزائن

- مختلف

- تقسیم کئے

- تقسیم کمپیوٹنگ

- ڈی آئی

- میں Docker

- ڈومینز

- دوگنا

- نیچے

- ڈرائیو

- متحرک

- آسانی سے

- اثر

- مؤثر طریقے سے

- کوشش

- کو چالو کرنے کے

- اختتام پوائنٹ

- انجن

- انجینئر

- انٹرپرائز

- ماحولیات

- جوہر

- ضروری

- اندازہ

- ارتقاء

- مثال کے طور پر

- پھانسی

- توقع ہے

- توقع

- تجربہ

- تجربہ

- کی تلاش

- تلاش

- چہرہ

- عوامل

- خاندان

- نمایاں کریں

- خصوصیات

- فیڈ

- اعداد و شمار

- آخر

- مالی

- تلاش

- پہلا

- فٹ

- بہاؤ

- توجہ مرکوز

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- فوٹ پرنٹ

- فارم

- فریم ورک

- مزید

- مستقبل

- جنرل

- نسل

- GPU

- گروپ

- ہدایات

- ہارڈ ویئر

- اونچائی

- مدد

- مدد کرتا ہے

- ہائی

- میزبانی کی

- ہوسٹنگ

- کس طرح

- HTTPS

- تصویر

- اثر

- پر عملدرآمد

- اہم

- کو بہتر بنانے کے

- شامل

- شامل ہیں

- سمیت

- اضافہ

- اضافہ

- اضافہ

- انفرادی

- صنعت

- معلومات

- انفراسٹرکچر

- ان پٹ

- بصیرت

- انشورنس

- ضم

- ضم

- انضمام

- انٹیل

- انٹیلی جنس

- بات چیت

- انٹرایکٹو

- تنہائی

- IT

- ایوب

- نوکریاں

- میں شامل

- کلیدی

- علم

- زبان

- بڑے

- بڑے

- آغاز

- قیادت

- معروف

- لیڈز

- سیکھنے

- قیادت

- لیوریج

- اٹھانے

- ہلکا پھلکا

- تھوڑا

- لوڈ

- لانگ

- مشین

- مشین لرننگ

- برقرار رکھنے کے

- اہم

- بناتا ہے

- بنانا

- انتظام

- میں کامیاب

- مینیجر

- مارکیٹ

- بڑے پیمانے پر

- میچ

- یاد داشت

- پیمائش کا معیار

- دس لاکھ

- لاکھوں

- ML

- ماڈل

- ماڈل

- کی نگرانی

- نگرانی

- زیادہ

- سب سے زیادہ

- ایک سے زیادہ

- قدرتی

- نیٹ ورک

- نیٹ ورکنگ

- نوٹ بک

- تعداد

- حاصل کی

- کی پیشکش کی

- تجویز

- کھولتا ہے

- آپریشنز

- اصلاح کے

- کی اصلاح کریں

- اصلاح

- آپشنز کے بھی

- حکم

- تنظیمیں

- دیگر

- دوسری صورت میں

- مجموعی طور پر

- خود

- پاٹرن

- کارکردگی

- کھیل

- پالیسیاں

- پالیسی

- غریب

- مقبول

- امکان

- ممکن

- طاقت

- طاقتور

- پریکٹس

- کی پیشن گوئی

- قیمت

- پرنسپل

- مسائل

- عمل

- عمل

- پروسیسنگ

- مصنوعات

- پیداوار

- پروفائل

- منصوبوں

- پروٹوکول

- فراہم

- فراہم کرتا ہے

- فراہم کرنے

- شائع

- ریمپ

- رینج

- لے کر

- تک پہنچنے

- اصل وقت

- موصول

- سفارش

- کو کم

- رجسٹر

- درخواست

- درخواستوں

- کی ضرورت

- ضرورت

- ضروریات

- وسائل

- وسائل

- جواب

- ذمہ دار

- نتائج کی نمائش

- واپسی

- کا جائزہ لینے کے

- رن

- چل رہا ہے

- اسکیل ایبلٹی

- توسیع پذیر

- پیمانے

- سکیلنگ

- sdk

- بغیر کسی رکاوٹ کے

- تلاش کریں

- سیکنڈ

- منتخب

- بے سرور

- سروس

- سروسز

- خدمت

- مقرر

- سیٹ اپ

- سادہ

- سائز

- چھوٹے

- So

- سافٹ ویئر کی

- سافٹ ویئر انجنیئر

- حل

- حل

- کچھ

- ماہر

- خاص طور پر

- اسٹیج

- معیار

- شروع کریں

- شروع ہوتا ہے

- سترٹو

- حالت

- امریکہ

- رہنا

- ذخیرہ

- حمایت

- تائید

- کی حمایت کرتا ہے

- سطح

- لینے

- ہدف

- ٹیم

- ٹیکنیکل

- تکنیک

- ٹیسٹ

- ٹیسٹنگ

- ٹیسٹ

- سوچا قیادت۔

- کے ذریعے

- وقت

- ٹوکن

- اوزار

- ٹریکنگ

- ٹریفک

- ٹریننگ

- معاملات

- سفر

- اپ ڈیٹ کریں

- us

- امریکا

- استعمال کی شرائط

- استعمال کے معاملات

- صارفین

- عام طور پر

- استعمال

- استعمال کرنا۔

- مختلف اقسام کے

- مختلف

- ورجینیا

- مجازی

- نقطہ نظر

- انتظار

- چاہتے تھے

- ویب

- ویب سرور

- ویب خدمات

- کے اندر

- بغیر

- کام کیا

- کام کرتا ہے

- دنیا کی

- گا

- سال

- پیداوار

- اپج