اربوں پیرامیٹرز کے ساتھ بڑے لینگوئج ماڈلز (LLMs) کو تربیت دینا مشکل ہو سکتا ہے۔ ماڈل فن تعمیر کو ڈیزائن کرنے کے علاوہ، محققین کو تقسیم شدہ تربیت کے لیے جدید ترین تربیتی تکنیکیں ترتیب دینے کی ضرورت ہے جیسے مخلوط صحت سے متعلق معاونت، تدریجی جمع، اور چیک پوائنٹنگ۔ بڑے ماڈلز کے ساتھ، ٹریننگ سیٹ اپ اور بھی مشکل ہوتا ہے کیونکہ سنگل ایکسلریٹر ڈیوائس میں دستیاب میموری صرف ڈیٹا کے متوازی کا استعمال کرتے ہوئے تربیت یافتہ ماڈلز کے سائز کو پابند کرتی ہے، اور ماڈل کے متوازی ٹریننگ کے استعمال کے لیے ٹریننگ کوڈ میں اضافی سطح کی ترمیم کی ضرورت ہوتی ہے۔ لائبریریاں جیسے ڈیپ اسپیڈ (PyTorch کے لیے ایک اوپن سورس ڈیپ لرننگ آپٹیمائزیشن لائبریری) ان میں سے کچھ چیلنجز کو حل کرتی ہے، اور ماڈل کی ترقی اور تربیت کو تیز کرنے میں مدد کر سکتی ہے۔

اس پوسٹ میں، ہم نے Intel Habana Gaudi کی بنیاد پر ٹریننگ ترتیب دی ہے۔ ایمیزون لچکدار کمپیوٹ کلاؤڈ (ایمیزون ای سی 2) DL1 ڈیپ اسپیڈ جیسے اسکیلنگ فریم ورک کے استعمال کے فوائد کی مثالیں اور مقدار معلوم کریں۔ ہم ایک انکوڈر قسم کے ٹرانسفارمر ماڈل (340 ملین سے 1.5 بلین پیرامیٹرز کے ساتھ BERT) کے پیمانے کے نتائج پیش کرتے ہیں۔ 1.5-بلین پیرامیٹر ماڈل کے لیے، ہم نے 82.7 ایکسلریٹروں (128 dl16x بڑی مثالوں) کا استعمال کرتے ہوئے 1.24% کی اسکیلنگ کی کارکردگی حاصل کی۔ ڈیپ اسپیڈ زیرو مرحلہ 1 کی اصلاح۔ ڈیٹا کے متوازی پیراڈائم کا استعمال کرتے ہوئے بڑے ماڈلز کو تربیت دینے کے لیے ڈیپ اسپیڈ کے ذریعے آپٹیمائزر ریاستوں کو تقسیم کیا گیا تھا۔ اس نقطہ نظر کو ڈیٹا کی ہم آہنگی کا استعمال کرتے ہوئے 5-بلین پیرامیٹر ماڈل کو تربیت دینے کے لیے بڑھایا گیا ہے۔ ہم نے کم میموری سائز اور FP16 ڈیٹا ٹائپ استعمال کرنے کے مقابلے میں تربیتی کارکردگی میں اضافہ کے لیے BF32 ڈیٹا کی قسم کا مقامی تعاون بھی استعمال کیا۔ نتیجے کے طور پر، ہم نے BERT 1-بلین پیرامیٹر ماڈل کے لیے 16 گھنٹے کے اندر پری ٹریننگ (مرحلہ 1.5) ماڈل کنورجنسی حاصل کی (ہمارا ہدف ایک دن کے اندر ایک بڑے ماڈل کو تربیت دینا تھا)۔ wikicorpus-en ڈیٹاسیٹ۔

ٹریننگ سیٹ اپ

ہم نے ایک منظم کمپیوٹ کلسٹر فراہم کیا ہے جس میں 16 dl1.24x بڑی مثالیں شامل ہیں AWS بیچ. ہم نے ایک تیار کیا۔ AWS بیچ ورکشاپ جو AWS Batch کے ساتھ تقسیم شدہ تربیتی کلسٹر قائم کرنے کے اقدامات کی وضاحت کرتا ہے۔ ہر dl1.24x بڑی مثال میں آٹھ حبانا گاڈی ایکسلریٹر ہوتے ہیں، ہر ایک 32 جی بی میموری کے ساتھ اور کارڈز کے درمیان ایک مکمل میش RoCE نیٹ ورک جس کی کل دو طرفہ انٹرکنیکٹ بینڈوتھ 700 Gbps ہے (دیکھیں ایمیزون ای سی 2 ڈی ایل 1 ڈیپ ڈائیو کی مثال دیتا ہے۔ مزید معلومات کے لیے). dl1.24xlarge کلسٹر نے بھی چار کا استعمال کیا۔ AWS لچکدار فیبرک اڈاپٹر (EFA)، نوڈس کے درمیان کل 400 Gbps آپس میں جڑے ہوئے ہیں۔

تقسیم شدہ تربیتی ورکشاپ تقسیم شدہ تربیتی کلسٹر قائم کرنے کے اقدامات کی وضاحت کرتی ہے۔ ورکشاپ AWS بیچ کا استعمال کرتے ہوئے تقسیم شدہ تربیتی سیٹ اپ کو ظاہر کرتی ہے اور خاص طور پر ملٹی نوڈ متوازی جابز کی خصوصیت کو مکمل طور پر منظم کلسٹرز پر بڑے پیمانے پر کنٹینرائزڈ ٹریننگ جابز شروع کرنے کے لیے۔ مزید خاص طور پر، ایک مکمل طور پر منظم AWS بیچ کمپیوٹ ماحول DL1 مثالوں کے ساتھ بنایا گیا ہے۔ کنٹینرز سے نکالے جاتے ہیں۔ ایمیزون لچکدار کنٹینر رجسٹری (ایمیزون ای سی آر) اور ملٹی نوڈ متوازی ملازمت کی تعریف کی بنیاد پر کلسٹر میں مثالوں میں خود بخود لانچ کیا گیا۔ ورکشاپ PyTorch اور DeepSpeed کا استعمال کرتے ہوئے BERT (340 ملین سے 1.5 بلین پیرامیٹرز) ماڈل کی ملٹی نوڈ، ملٹی-HPU ڈیٹا متوازی تربیت چلا کر اختتام پذیر ہوئی۔

ڈیپ اسپیڈ کے ساتھ BERT 1.5B پری ٹریننگ

حبانہ SynapseAI v1.5 اور v1.6 DeepSpeed ZeRO1 کی اصلاح کی حمایت کرتا ہے۔ دی ڈیپ اسپیڈ گٹ ہب ریپوزٹری کا حبانا فورک Gaudi ایکسلریٹر کو سپورٹ کرنے کے لیے ضروری ترمیمات شامل ہیں۔ تقسیم شدہ ڈیٹا متوازی (ملٹی کارڈ، ملٹی انسٹینس)، ZeRO1 آپٹیمائزیشنز، اور BF16 ڈیٹا کی اقسام کی مکمل حمایت حاصل ہے۔

یہ تمام فیچرز پر فعال ہیں۔ BERT 1.5B ماڈل ریفرنس ریپوزٹری، جو BERT کے نفاذ سے اخذ کردہ 48-پرت، 1600-پوشیدہ جہت، اور 25-ہیڈ دو طرفہ انکوڈر ماڈل متعارف کراتا ہے۔ ریپوزٹری میں بیس لائن BERT لارج ماڈل کا نفاذ بھی شامل ہے: ایک 24-پرت، 1024-پوشیدہ، 16-ہیڈ، 340-ملین پیرامیٹر نیورل نیٹ ورک فن تعمیر۔ پری ٹریننگ ماڈلنگ اسکرپٹس سے ماخوذ ہیں۔ NVIDIA گہری سیکھنے کی مثالوں کا ذخیرہ wikicorpus_en ڈیٹا کو ڈاؤن لوڈ کرنے کے لیے، خام ڈیٹا کو ٹوکنز میں پہلے سے پروسیس کریں، اور ڈیٹا کو تقسیم شدہ ڈیٹا متوازی تربیت کے لیے چھوٹے h5 ڈیٹا سیٹس میں تقسیم کریں۔ آپ DL1 مثالوں کا استعمال کرتے ہوئے اپنے ڈیٹا سیٹس کا استعمال کرتے ہوئے اپنی مرضی کے مطابق PyTorch ماڈل آرکیٹیکچرز کو تربیت دینے کے لیے اس عام نقطہ نظر کو اپنا سکتے ہیں۔

پری ٹریننگ (مرحلہ 1) اسکیلنگ کے نتائج

بڑے ماڈلز کو بڑے پیمانے پر پہلے سے تربیت دینے کے لیے، ہم نے بنیادی طور پر حل کے دو پہلوؤں پر توجہ مرکوز کی: تربیت کی کارکردگی، جیسا کہ تربیت کے وقت کے حساب سے ماپا جاتا ہے، اور مکمل طور پر متغیر حل پر پہنچنے کی لاگت کی تاثیر۔ اس کے بعد، ہم مثال کے طور پر BERT 1.5B پری ٹریننگ کے ساتھ ان دو میٹرکس میں گہرائی میں ڈوبتے ہیں۔

اسکیلنگ کی کارکردگی اور تربیت کا وقت

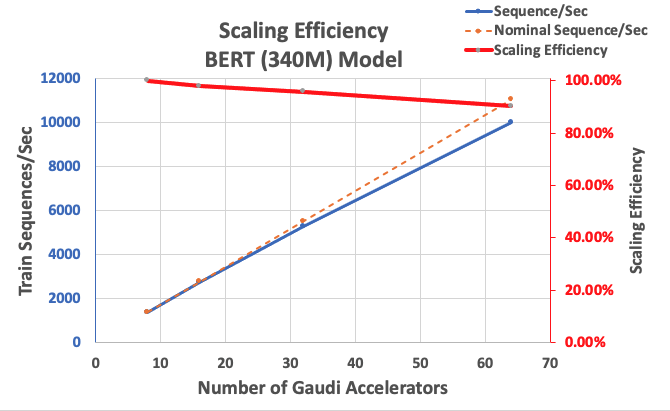

ہم اسکیل ایبلٹی کی بنیاد کے طور پر BERT Large نفاذ کی کارکردگی کی پیمائش کرکے شروع کرتے ہیں۔ مندرجہ ذیل جدول میں 1-8 dl1.24x بڑی مثالوں (فی مثال میں آٹھ ایکسلریٹر ڈیوائسز کے ساتھ) سے فی سیکنڈ کی ترتیب کے ناپے گئے تھرو پٹ کی فہرست دی گئی ہے۔ سنگل انسٹینس تھرو پٹ کو بیس لائن کے طور پر استعمال کرتے ہوئے، ہم نے متعدد مثالوں میں اسکیلنگ کی کارکردگی کی پیمائش کی، جو قیمت کی کارکردگی کی ٹریننگ میٹرک کو سمجھنے کے لیے ایک اہم لیور ہے۔

| مثالوں کی تعداد | ایکسلریٹر کی تعداد | تسلسل فی سیکنڈ | تسلسل فی سیکنڈ فی ایکسلریٹر | اسکیلنگ کی کارکردگی |

| 1 | 8 | 1,379.76 | 172.47 | 100.0٪ |

| 2 | 16 | 2,705.57 | 169.10 | 98.04٪ |

| 4 | 32 | 5,291.58 | 165.36 | 95.88٪ |

| 8 | 64 | 9,977.54 | 155.90 | 90.39٪ |

درج ذیل اعداد و شمار اسکیلنگ کی کارکردگی کو واضح کرتا ہے۔

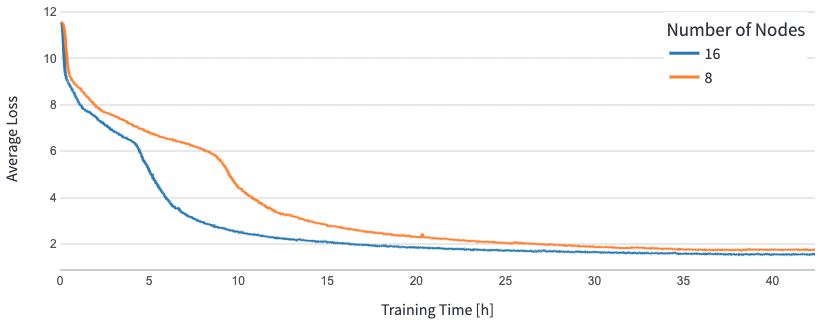

BERT 1.5B کے لیے، ہم نے کنورجنسی کی ضمانت دینے کے لیے ریفرنس ریپوزٹری میں ماڈل کے لیے ہائپر پیرامیٹر میں ترمیم کی۔ مؤثر بیچ کا سائز فی ایکسلریٹر 384 (زیادہ سے زیادہ میموری کے استعمال کے لیے) پر سیٹ کیا گیا تھا، جس میں مائیکرو بیچز فی قدم 16 اور گریڈینٹ جمع کرنے کے 24 مراحل تھے۔ 0.0015 اور 0.003 کی سیکھنے کی شرح بالترتیب 8 اور 16 نوڈس کے لیے استعمال کی گئی۔ ان کنفیگریشنز کے ساتھ، ہم نے BERT 1B کی فیز 1.5 پری ٹریننگ کو تقریباً 8 گھنٹے میں 1.24 dl64x بڑے انسٹینسز (25 ایکسلریٹروں) میں اور 15 dl16x بڑے انسٹینسز (1.24 ایکسلریٹر) میں 128 گھنٹے میں حاصل کیا۔ مندرجہ ذیل اعداد و شمار تربیتی دوروں کی تعداد کے فعل کے طور پر اوسط نقصان کو ظاہر کرتا ہے، جیسا کہ ہم ایکسلریٹروں کی تعداد کو بڑھاتے ہیں۔

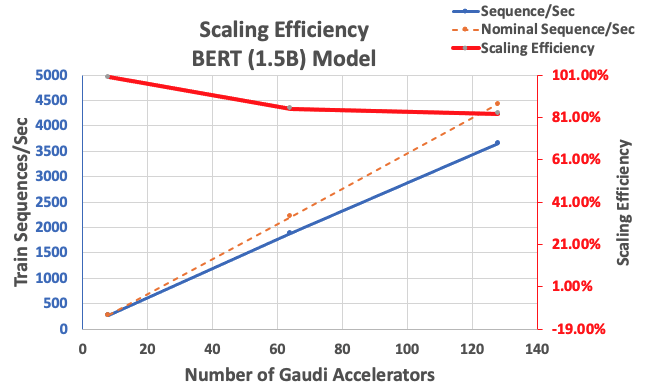

پہلے بیان کردہ کنفیگریشن کے ساتھ، ہم نے ایک ہی مثال میں 85 ایکسلریٹروں کی بیس لائن سے 64 ایکسلریٹرز کے ساتھ 83% مضبوط اسکیلنگ کی کارکردگی اور 128 ایکسلریٹر کے ساتھ 8% حاصل کی۔ مندرجہ ذیل جدول میں پیرامیٹرز کا خلاصہ کیا گیا ہے۔

| مثالوں کی تعداد | ایکسلریٹر کی تعداد | تسلسل فی سیکنڈ | تسلسل فی سیکنڈ فی ایکسلریٹر | اسکیلنگ کی کارکردگی |

| 1 | 8 | 276.66 | 34.58 | 100.0٪ |

| 8 | 64 | 1,883.63 | 29.43 | 85.1٪ |

| 16 | 128 | 3,659.15 | 28.59 | 82.7٪ |

درج ذیل اعداد و شمار اسکیلنگ کی کارکردگی کو واضح کرتا ہے۔

نتیجہ

اس پوسٹ میں، ہم نے ڈیپ اسپیڈ کے لیے حبانا SynapseAI v1.5/v1.6 کے تعاون کا جائزہ لیا اور یہ کہ یہ کس طرح Habana Gaudi accelerators پر LLM ٹریننگ کو بڑھانے میں مدد کرتا ہے۔ 1.5-بلین پیرامیٹر BERT ماڈل کی پری ٹریننگ کو 16% مضبوط اسکیلنگ کے ساتھ 128 Gaudi ایکسلریٹروں کے ایک کلسٹر پر اکٹھا ہونے میں 85 گھنٹے لگے۔ ہم آپ کو فن تعمیر پر ایک نظر ڈالنے کی ترغیب دیتے ہیں جس کا مظاہرہ کیا گیا ہے۔ AWS ورکشاپ اور DL1 مثالوں کا استعمال کرتے ہوئے اپنی مرضی کے مطابق PyTorch ماڈل آرکیٹیکچرز کی تربیت کے لیے اسے اپنانے پر غور کریں۔

مصنفین کے بارے میں

مہادیون بالاسوبرامنیم خود مختار کمپیوٹنگ کے لیے ایک پرنسپل سولیوشن آرکیٹیکٹ ہے جس کے پاس فزکس سے متاثر گہری سیکھنے، تعمیر کرنے، اور بڑے پیمانے پر صنعتی نظاموں کے لیے ڈیجیٹل جڑواں بچوں کی تعیناتی کے شعبے میں تقریباً 20 سال کا تجربہ ہے۔ مہادیون نے میساچوسٹس انسٹی ٹیوٹ آف ٹیکنالوجی سے مکینیکل انجینئرنگ میں پی ایچ ڈی کی ڈگری حاصل کی اور اس کے کریڈٹ پر 25 سے زیادہ پیٹنٹ اور اشاعتیں ہیں۔

مہادیون بالاسوبرامنیم خود مختار کمپیوٹنگ کے لیے ایک پرنسپل سولیوشن آرکیٹیکٹ ہے جس کے پاس فزکس سے متاثر گہری سیکھنے، تعمیر کرنے، اور بڑے پیمانے پر صنعتی نظاموں کے لیے ڈیجیٹل جڑواں بچوں کی تعیناتی کے شعبے میں تقریباً 20 سال کا تجربہ ہے۔ مہادیون نے میساچوسٹس انسٹی ٹیوٹ آف ٹیکنالوجی سے مکینیکل انجینئرنگ میں پی ایچ ڈی کی ڈگری حاصل کی اور اس کے کریڈٹ پر 25 سے زیادہ پیٹنٹ اور اشاعتیں ہیں۔

RJ تلاش M5 ٹیم میں ایک انجینئر ہے جو تربیت اور تخمینہ کے لیے بڑے پیمانے پر گہرے سیکھنے کے نظام کی تعمیر کی کوششوں کی رہنمائی کرتا ہے۔ کام سے باہر وہ کھانے کے مختلف پکوان دریافت کرتا ہے اور ریکٹ کھیل کھیلتا ہے۔

RJ تلاش M5 ٹیم میں ایک انجینئر ہے جو تربیت اور تخمینہ کے لیے بڑے پیمانے پر گہرے سیکھنے کے نظام کی تعمیر کی کوششوں کی رہنمائی کرتا ہے۔ کام سے باہر وہ کھانے کے مختلف پکوان دریافت کرتا ہے اور ریکٹ کھیل کھیلتا ہے۔

سندر رنگناتھن ایمیزون EC2 ٹیم میں بزنس ڈویلپمنٹ کے سربراہ، ایم ایل فریم ورکس ہیں۔ وہ AWS سروسز جیسے Amazon EKS، Amazon ECS، Elastic Fabric Adapter، AWS Batch، اور Amazon SageMaker میں بڑے پیمانے پر ML ورک بوجھ پر توجہ مرکوز کرتا ہے۔ اس کے تجربے میں NetApp، Micron Technology، Qualcomm، اور Mentor Graphics میں پروڈکٹ مینجمنٹ اور مصنوعات کی ترقی میں قائدانہ کردار شامل ہیں۔

سندر رنگناتھن ایمیزون EC2 ٹیم میں بزنس ڈویلپمنٹ کے سربراہ، ایم ایل فریم ورکس ہیں۔ وہ AWS سروسز جیسے Amazon EKS، Amazon ECS، Elastic Fabric Adapter، AWS Batch، اور Amazon SageMaker میں بڑے پیمانے پر ML ورک بوجھ پر توجہ مرکوز کرتا ہے۔ اس کے تجربے میں NetApp، Micron Technology، Qualcomm، اور Mentor Graphics میں پروڈکٹ مینجمنٹ اور مصنوعات کی ترقی میں قائدانہ کردار شامل ہیں۔

ابھینندن پٹنی ایمیزون سرچ میں ایک سینئر سافٹ ویئر انجینئر ہے۔ وہ توسیع پذیر تقسیم شدہ گہری سیکھنے کی تربیت اور حقیقی وقت کا اندازہ لگانے کے لیے نظام کی تعمیر اور ٹولنگ پر توجہ مرکوز کرتا ہے۔

ابھینندن پٹنی ایمیزون سرچ میں ایک سینئر سافٹ ویئر انجینئر ہے۔ وہ توسیع پذیر تقسیم شدہ گہری سیکھنے کی تربیت اور حقیقی وقت کا اندازہ لگانے کے لیے نظام کی تعمیر اور ٹولنگ پر توجہ مرکوز کرتا ہے۔

Pierre-Yves Aquilanti ایمیزون ویب سروسز میں فریم ورکس ایم ایل سلوشنز کے سربراہ ہیں جہاں وہ صنعت کے بہترین کلاؤڈ بیسڈ ایم ایل فریم ورکس سلوشنز تیار کرنے میں مدد کرتے ہیں۔ اس کا پس منظر ہائی پرفارمنس کمپیوٹنگ میں ہے اور AWS میں شامل ہونے سے پہلے Pierre-Yves تیل اور گیس کی صنعت میں کام کر رہے تھے۔ Pierre-Yves کا تعلق اصل میں فرانس سے ہے اور اس کے پاس پی ایچ ڈی ہے۔ للی یونیورسٹی سے کمپیوٹر سائنس میں۔

Pierre-Yves Aquilanti ایمیزون ویب سروسز میں فریم ورکس ایم ایل سلوشنز کے سربراہ ہیں جہاں وہ صنعت کے بہترین کلاؤڈ بیسڈ ایم ایل فریم ورکس سلوشنز تیار کرنے میں مدد کرتے ہیں۔ اس کا پس منظر ہائی پرفارمنس کمپیوٹنگ میں ہے اور AWS میں شامل ہونے سے پہلے Pierre-Yves تیل اور گیس کی صنعت میں کام کر رہے تھے۔ Pierre-Yves کا تعلق اصل میں فرانس سے ہے اور اس کے پاس پی ایچ ڈی ہے۔ للی یونیورسٹی سے کمپیوٹر سائنس میں۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- ای وی ایم فنانس۔ وکندریقرت مالیات کے لیے متحد انٹرفیس۔ یہاں تک رسائی حاصل کریں۔

- کوانٹم میڈیا گروپ۔ آئی آر/پی آر ایمپلیفائیڈ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/accelerate-pytorch-with-deepspeed-to-train-large-language-models-with-intel-habana-gaudi-based-dl1-ec2-instances/

- : ہے

- : ہے

- :کہاں

- $UP

- 1

- 100

- 15٪

- 16

- 20

- 20 سال

- 24

- 25

- 7

- 8

- a

- رفتار کو تیز تر

- مسرع

- ایکسلریٹر

- جمع کو

- حاصل کیا

- کے پار

- اس کے علاوہ

- ایڈیشنل

- پتہ

- اپنانے

- اپنانے

- بھی

- ایمیزون

- ایمیزون EC2

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- an

- اور

- نقطہ نظر

- تقریبا

- فن تعمیر

- کیا

- رقبہ

- آ رہا ہے

- AS

- پہلوؤں

- At

- خود کار طریقے سے

- خود مختار

- دستیاب

- اوسط

- AWS

- پس منظر

- بینڈوڈتھ

- کی بنیاد پر

- بیس لائن

- BE

- کیونکہ

- رہا

- فوائد

- BEST

- کے درمیان

- ارب

- اربوں

- عمارت

- کاروبار

- کاروبار کی ترقی

- by

- کر سکتے ہیں

- کارڈ

- چیلنجوں

- چیلنج

- بادل

- کلسٹر

- کوڈ

- مقابلے میں

- پر مشتمل

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹر سائنس

- کمپیوٹنگ

- ترتیب

- غور کریں

- کنٹینر

- کنٹینر

- پر مشتمل ہے

- تقارب

- کنورجنس

- بنائی

- کریڈٹ

- اپنی مرضی کے

- اعداد و شمار

- ڈیٹاسیٹس

- دن

- گہری

- گہری سیکھنے

- گہرے

- demonstrated,en

- تعینات

- اخذ کردہ

- بیان کیا

- ڈیزائننگ

- ترقی

- ترقی یافتہ

- ترقی

- آلہ

- کے الات

- مختلف

- ڈیجیٹل

- ڈیجیٹل جڑواں بچے

- طول و عرض

- تقسیم کئے

- تقسیم کی تربیت

- ڈاؤن لوڈ، اتارنا

- ہر ایک

- اس سے قبل

- موثر

- کارکردگی

- کوششوں

- چالو حالت میں

- کی حوصلہ افزائی

- انجینئر

- انجنیئرنگ

- ماحولیات

- زمانے

- اندازہ

- بھی

- مثال کے طور پر

- مثال کے طور پر

- تجربہ

- دریافت کرتا ہے

- کپڑے

- نمایاں کریں

- خصوصیات

- اعداد و شمار

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- کھانا

- کے لئے

- کانٹا

- چار

- فریم ورک

- فریم ورک

- فرانس

- سے

- مکمل

- مکمل طور پر

- تقریب

- گیس

- جاؤ

- GitHub کے

- گرافکس

- اس بات کی ضمانت

- he

- سر

- مدد

- مدد کرتا ہے

- ہائی

- ان

- کی ڈگری حاصل کی

- HOURS

- کس طرح

- HTML

- HTTP

- HTTPS

- وضاحت کرتا ہے

- نفاذ

- اہم

- in

- شامل ہیں

- اضافہ

- صنعتی

- صنعت

- صنعت کی

- معلومات

- مثال کے طور پر

- انسٹی ٹیوٹ

- انٹیل

- میں

- متعارف کرواتا ہے

- IT

- ایوب

- نوکریاں

- شمولیت

- فوٹو

- زبان

- بڑے

- بڑے پیمانے پر

- شروع

- شروع

- قیادت

- معروف

- سیکھنے

- سطح

- لائبریریوں

- لائبریری

- کی طرح

- فہرستیں

- ایل ایل ایم

- دیکھو

- بند

- بنیادی طور پر

- میں کامیاب

- انتظام

- میسا چوسٹس

- ماشسٹس انسٹیٹیوٹ آف ٹیکنالوجی

- زیادہ سے زیادہ

- پیمائش

- میکانی

- یاد داشت

- میش

- میٹرک۔

- پیمائش کا معیار

- مائکرون

- دس لاکھ

- مخلوط

- ML

- ماڈل

- ماڈلنگ

- ماڈل

- ترمیم

- نظر ثانی کی

- زیادہ

- ایک سے زیادہ

- مقامی

- تقریبا

- ضروری

- ضرورت ہے

- نیٹ ورک

- عصبی نیٹ ورک

- اگلے

- نوڈس

- تعداد

- حاصل کی

- of

- تیل

- on

- صرف

- اوپن سورس

- اصلاح کے

- اصل میں

- ہمارے

- باہر

- پر

- پیرا میٹر

- متوازی

- پیرامیٹرز

- خاص طور پر

- پیٹنٹ

- کارکردگی

- مرحلہ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- ادا کرتا ہے

- پوسٹ

- صحت سے متعلق

- حال (-)

- پرنسپل

- پہلے

- مصنوعات

- مصنوعات کی ترقی

- پروڈکٹ مینجمنٹ

- مطبوعات

- pytorch

- qualcomm

- قیمتیں

- خام

- اصلی

- اصل وقت

- کم

- ذخیرہ

- کی ضرورت ہے

- محققین

- بالترتیب

- نتیجہ

- نتائج کی نمائش

- کردار

- چل رہا ہے

- sagemaker

- اسکیل ایبلٹی

- توسیع پذیر

- پیمانے

- سکیلنگ

- سائنس

- سکرپٹ

- تلاش کریں

- دوسری

- دیکھنا

- سینئر

- سروسز

- مقرر

- سیٹ اپ

- شوز

- ایک

- سائز

- چھوٹے

- سافٹ ویئر کی

- سافٹ ویئر انجنیئر

- حل

- حل

- کچھ

- خاص طور پر

- اسپورٹس

- اسٹیج

- شروع کریں

- ریاستی آرٹ

- امریکہ

- مرحلہ

- مراحل

- مضبوط

- اس طرح

- حمایت

- سسٹمز

- ٹیبل

- لے لو

- ہدف

- ٹیم

- تکنیک

- ٹیکنالوجی

- کہ

- ۔

- علاقہ

- وہاں.

- یہ

- اس

- تھرو پٹ

- وقت

- کرنے کے لئے

- ٹوکن

- لیا

- کل

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمر

- پیٹ میں جڑواں بچے

- دو

- قسم

- اقسام

- سمجھ

- یونیورسٹی

- استعمال کیا جاتا ہے

- کا استعمال کرتے ہوئے

- v1

- تھا

- we

- ویب

- ویب خدمات

- تھے

- جس

- ساتھ

- کے اندر

- کام

- کام کر

- ورکشاپ

- سال

- تم

- اور

- زیفیرنیٹ