آج، ہم یہ اعلان کرتے ہوئے بہت پرجوش ہیں کہ میٹا کے تیار کردہ کوڈ لاما فاؤنڈیشن ماڈلز صارفین کے لیے دستیاب ہیں۔ ایمیزون سیج میکر جمپ اسٹارٹ چلانے کا اندازہ لگانے کے لیے ایک کلک کے ساتھ تعینات کرنا۔ کوڈ لاما ایک جدید ترین لارج لینگویج ماڈل (LLM) ہے جو کوڈ اور قدرتی زبان کے اشارے دونوں سے کوڈ کے بارے میں کوڈ اور قدرتی زبان پیدا کرنے کی صلاحیت رکھتا ہے۔ کوڈ لاما تحقیق اور تجارتی استعمال کے لیے مفت ہے۔ آپ اس ماڈل کو SageMaker JumpStart کے ساتھ آزما سکتے ہیں، جو ایک مشین لرننگ (ML) مرکز ہے جو الگورتھم، ماڈلز، اور ML حل تک رسائی فراہم کرتا ہے تاکہ آپ ML کے ساتھ تیزی سے شروعات کر سکیں۔ اس پوسٹ میں، ہم SageMaker JumpStart کے ذریعے کوڈ لاما ماڈل کو دریافت کرنے اور اسے تعینات کرنے کے طریقہ پر چلتے ہیں۔

کوڈ لاما کیا ہے؟

کوڈ لاما کی طرف سے جاری کردہ ایک ماڈل ہے۔ میٹا جو کہ Llama 2 کے اوپر بنایا گیا ہے اور ایک جدید ترین ماڈل ہے جو ڈویلپرز کے لیے پروگرامنگ کے کاموں کے لیے پیداواری صلاحیت کو بہتر بنانے کے لیے ڈیزائن کیا گیا ہے تاکہ وہ اعلیٰ معیار کا، اچھی طرح سے دستاویزی کوڈ بنانے میں مدد کر سکیں۔ ماڈلز Python، C++، Java، PHP، C#، TypeScript، اور Bash میں جدید ترین کارکردگی دکھاتے ہیں، اور ان میں ڈویلپرز کا وقت بچانے اور سافٹ ویئر ورک فلو کو مزید موثر بنانے کی صلاحیت ہے۔ یہ تین قسموں میں آتا ہے، جس میں وسیع اقسام کی ایپلی کیشنز کا احاطہ کرنے کے لیے انجنیئر کیا گیا ہے: فاؤنڈیشنل ماڈل (کوڈ لاما)، ایک ازگر کا خصوصی ماڈل (کوڈ لاما-پائیتھون)، اور قدرتی زبان کی ہدایات کو سمجھنے کے لیے ہدایات کے بعد ایک ماڈل (کوڈ للاما-انسٹرکٹ )۔ تمام کوڈ لاما ویریئنٹس تین سائزوں میں آتے ہیں: 7B، 13B، اور 34B پیرامیٹرز۔ 7B اور 13B بیس اور انسٹرکٹ ویریئنٹس آس پاس کے مواد کی بنیاد پر انفللنگ کو سپورٹ کرتے ہیں، انہیں کوڈ اسسٹنٹ ایپلی کیشنز کے لیے مثالی بناتے ہیں۔

ماڈلز کو Llama 2 کو بنیاد کے طور پر استعمال کرتے ہوئے ڈیزائن کیا گیا تھا اور پھر کوڈ ڈیٹا کے 500 بلین ٹوکنز پر تربیت دی گئی تھی، جس میں Python کے خصوصی ورژن کو 100 بلین ٹوکنز پر تربیت دی گئی تھی۔ کوڈ لاما ماڈلز مستحکم نسلوں کو سیاق و سباق کے 100,000 ٹوکن تک فراہم کرتے ہیں۔ تمام ماڈلز کو 16,000 ٹوکنز کی ترتیب پر تربیت دی جاتی ہے اور 100,000 ٹوکنز تک کے ان پٹ پر بہتری دکھاتے ہیں۔

ماڈل اسی کے تحت دستیاب کرایا گیا ہے۔ لاما 2 کے بطور کمیونٹی لائسنس۔

سیج میکر جمپ اسٹارٹ کیا ہے؟

SageMaker JumpStart کے ساتھ، ML پریکٹیشنرز بہترین کارکردگی کا مظاہرہ کرنے والے فاؤنڈیشن ماڈلز کی بڑھتی ہوئی فہرست میں سے انتخاب کر سکتے ہیں۔ ایم ایل پریکٹیشنرز فاؤنڈیشن ماڈلز کو وقف کر سکتے ہیں۔ ایمیزون سیج میکر ایک نیٹ ورک الگ تھلگ ماحول میں مثالیں اور ماڈل ٹریننگ اور تعیناتی کے لیے SageMaker کا استعمال کرتے ہوئے ماڈلز کو اپنی مرضی کے مطابق بنائیں۔

اب آپ چند کلکس کے ساتھ کوڈ لاما ماڈلز کو دریافت اور تعینات کر سکتے ہیں۔ ایمیزون سیج میکر اسٹوڈیو یا پروگرامی طور پر SageMaker Python SDK کے ذریعے، آپ کو SageMaker خصوصیات کے ساتھ ماڈل کی کارکردگی اور MLOps کنٹرول حاصل کرنے کے قابل بناتا ہے جیسے ایمیزون سیج میکر پائپ لائنز, ایمیزون سیج میکر ڈیبگر، یا کنٹینر لاگز۔ ماڈل کو AWS محفوظ ماحول میں اور آپ کے VPC کنٹرولز کے تحت تعینات کیا گیا ہے، جو ڈیٹا کی حفاظت کو یقینی بنانے میں مدد کرتا ہے۔ کوڈ لاما ماڈلز قابل دریافت ہیں اور انہیں یو ایس ایسٹ (این. ورجینیا)، یو ایس ویسٹ (اوریگون) اور یورپ (آئرلینڈ) کے علاقوں میں تعینات کیا جا سکتا ہے۔

ماڈل ویزا SageMaker SDK کو تعینات کرنے کے لیے صارفین کو EULA کو قبول کرنا چاہیے۔

ماڈلز دریافت کریں۔

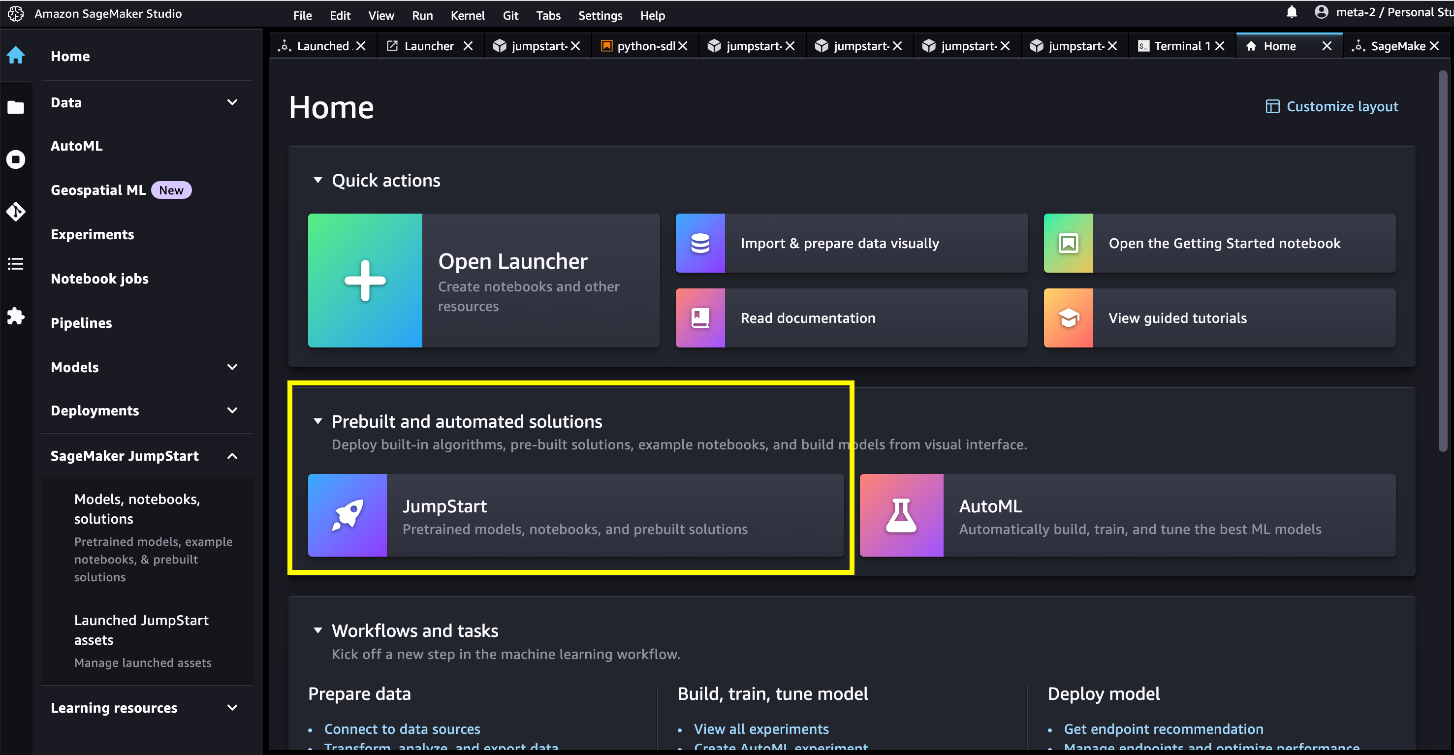

آپ SageMaker Studio UI اور SageMaker Python SDK میں SageMaker JumpStart کے ذریعے Code Llama فاؤنڈیشن ماڈلز تک رسائی حاصل کر سکتے ہیں۔ اس سیکشن میں، ہم سیج میکر اسٹوڈیو میں ماڈلز کو دریافت کرنے کا طریقہ دیکھتے ہیں۔

سیج میکر اسٹوڈیو ایک مربوط ترقیاتی ماحول (IDE) ہے جو ایک واحد ویب پر مبنی بصری انٹرفیس فراہم کرتا ہے جہاں آپ ڈیٹا کی تیاری سے لے کر اپنے ML ماڈلز کی تعمیر، تربیت، اور تعیناتی تک تمام ML ترقیاتی مراحل کو انجام دینے کے لیے مقصد کے لیے بنائے گئے ٹولز تک رسائی حاصل کر سکتے ہیں۔ شروع کرنے اور SageMaker اسٹوڈیو کو ترتیب دینے کے طریقے کے بارے میں مزید تفصیلات کے لیے، رجوع کریں۔ ایمیزون سیج میکر اسٹوڈیو.

سیج میکر اسٹوڈیو میں، آپ سیج میکر جمپ سٹارٹ تک رسائی حاصل کر سکتے ہیں، جس میں پہلے سے تربیت یافتہ ماڈل، نوٹ بکس، اور پہلے سے تیار کردہ حل شامل ہیں۔ پہلے سے تعمیر شدہ اور خودکار حل.

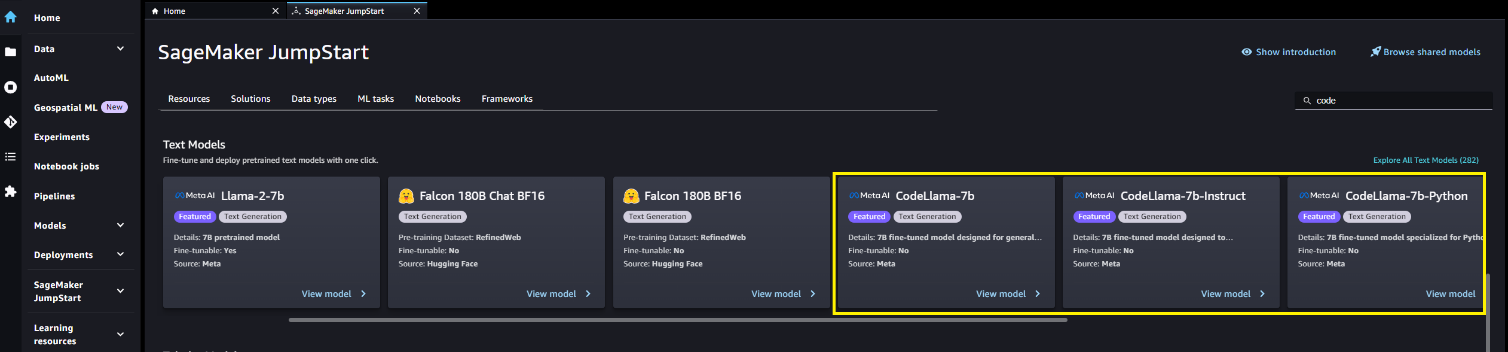

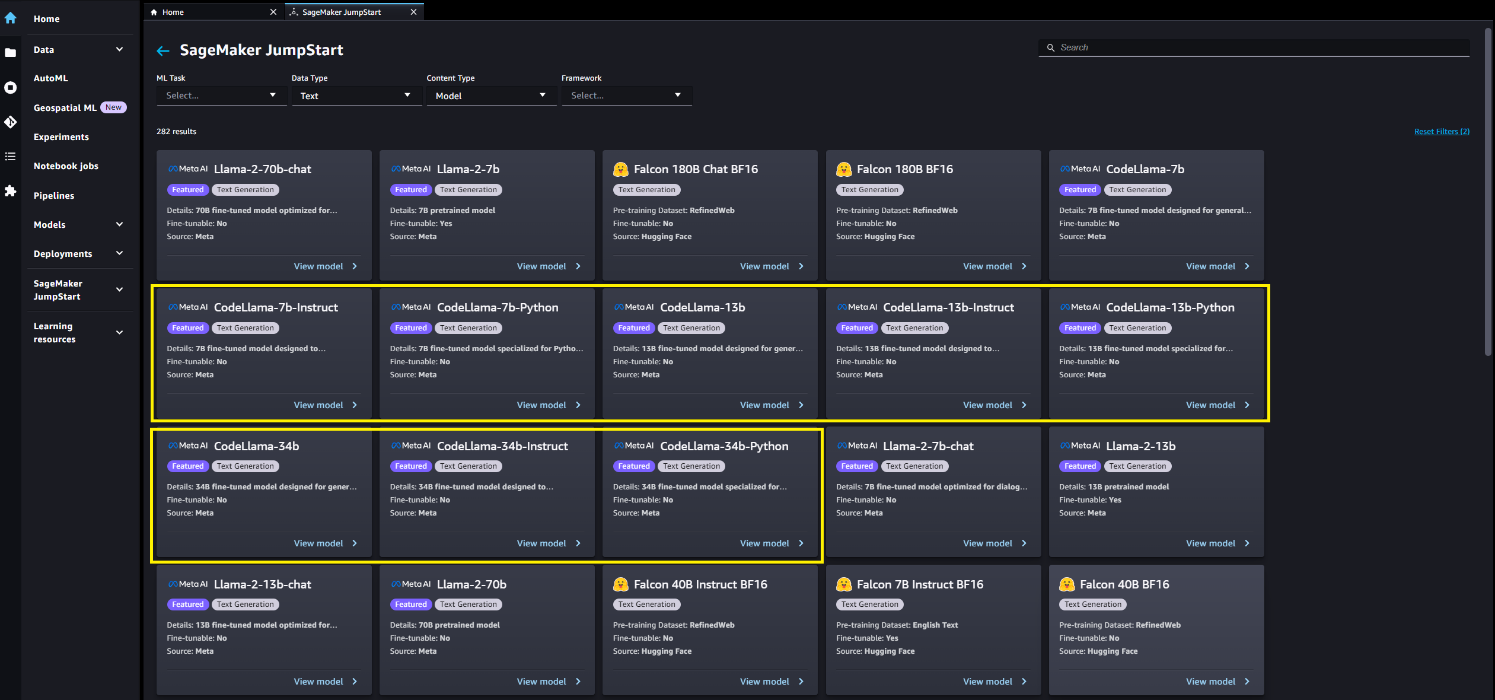

سیج میکر جمپ سٹارٹ لینڈنگ پیج پر، آپ حل، ماڈل، نوٹ بک اور دیگر وسائل کو براؤز کر سکتے ہیں۔ آپ کوڈ لاما ماڈلز میں تلاش کر سکتے ہیں۔ فاؤنڈیشن ماڈلز: ٹیکسٹ جنریشن carousel

آپ منتخب کر کے ماڈل کی دوسری قسمیں بھی تلاش کر سکتے ہیں۔ تمام ٹیکسٹ جنریشن ماڈلز کو دریافت کریں۔ یا کوڈ لاما کی تلاش۔

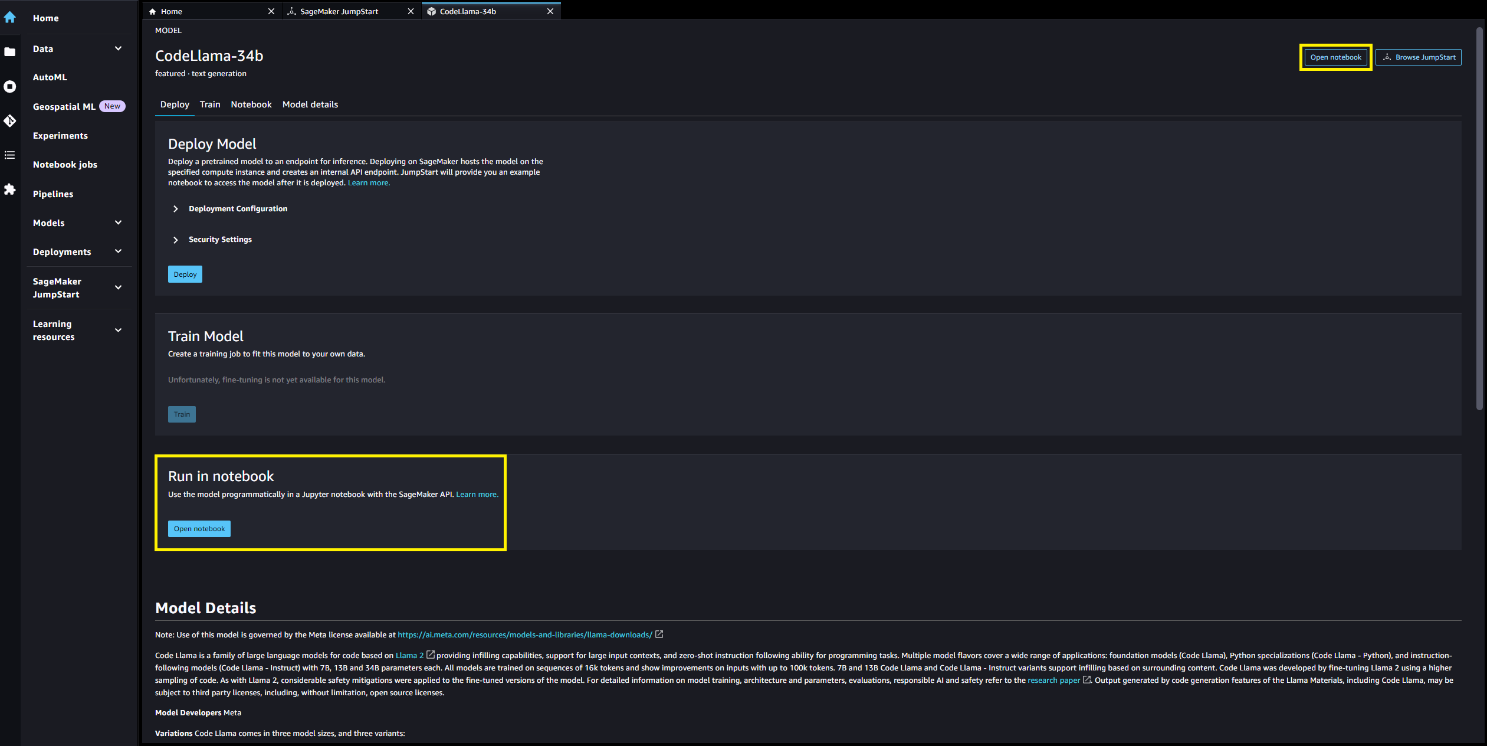

آپ ماڈل کے بارے میں تفصیلات دیکھنے کے لیے ماڈل کارڈ کا انتخاب کر سکتے ہیں جیسے کہ لائسنس، تربیت کے لیے استعمال ہونے والا ڈیٹا، اور استعمال کرنے کا طریقہ۔ آپ کو دو بٹن بھی ملیں گے، تعینات اور نوٹ بک کھولیں۔، جو آپ کو ماڈل استعمال کرنے میں مدد کرے گا۔

تعینات

جب آپ کا انتخاب کریں تعینات اور شرائط کو تسلیم کریں، تعیناتی شروع ہو جائے گی۔ متبادل طور پر، آپ مثال نوٹ بک کے ذریعے منتخب کر کے تعینات کر سکتے ہیں۔ نوٹ بک کھولیں۔. مثال کے طور پر نوٹ بک جو ماڈل کو اندازہ لگانے اور وسائل کو صاف کرنے کے طریقے کے بارے میں آخر سے آخر تک رہنمائی فراہم کرتی ہے۔

نوٹ بک کا استعمال کرتے ہوئے تعینات کرنے کے لیے، ہم ایک مناسب ماڈل کو منتخب کرکے شروع کرتے ہیں، جس کی وضاحت کی گئی ہے۔ model_id. آپ مندرجہ ذیل کوڈ کے ساتھ SageMaker پر کسی بھی منتخب ماڈل کو تعینات کر سکتے ہیں:

یہ ماڈل کو ڈیفالٹ کنفیگریشنز کے ساتھ SageMaker پر تعینات کرتا ہے، بشمول ڈیفالٹ مثال کی قسم اور ڈیفالٹ VPC کنفیگریشنز۔ آپ ان کنفیگریشنز کو غیر ڈیفالٹ ویلیوز بتا کر تبدیل کر سکتے ہیں۔ جمپ اسٹارٹ ماڈل. اس کے تعینات ہونے کے بعد، آپ SageMaker پیشن گوئی کے ذریعے تعینات اختتامی نقطہ کے خلاف تخمینہ چلا سکتے ہیں:

نوٹ کریں کہ بطور ڈیفالٹ، accept_eula کرنے کے لئے مقرر کیا گیا ہے false. آپ کو سیٹ کرنے کی ضرورت ہے۔ accept_eula=true اختتامی نقطہ کو کامیابی سے شروع کرنے کے لیے۔ ایسا کرنے سے، آپ صارف کے لائسنس کے معاہدے اور قابل قبول استعمال کی پالیسی کو قبول کرتے ہیں جیسا کہ پہلے ذکر کیا گیا ہے۔ آپ بھی ڈاؤن لوڈ، اتارنا لائسنس کا معاہدہ.

Custom_attributes EULA کو پاس کرنے کے لیے استعمال کیا جاتا ہے کلیدی/قدر کے جوڑے۔ کلید اور قدر کو = سے الگ کیا جاتا ہے اور جوڑوں کو ؛ سے الگ کیا جاتا ہے۔ اگر صارف ایک ہی کلید کو ایک سے زیادہ بار پاس کرتا ہے، تو آخری قدر رکھی جاتی ہے اور اسکرپٹ ہینڈلر کو بھیج دی جاتی ہے (اس صورت میں، مشروط منطق کے لیے استعمال کیا جاتا ہے)۔ مثال کے طور پر، اگر accept_eula=false; accept_eula=true پھر سرور کو منتقل کیا جاتا ہے۔ accept_eula=true رکھا جاتا ہے اور اسکرپٹ ہینڈلر کو دیا جاتا ہے۔

انفرنس پیرامیٹرز اختتامی نقطہ پر ٹیکسٹ جنریشن کے عمل کو کنٹرول کرتے ہیں۔ زیادہ سے زیادہ نئے ٹوکن کنٹرول سے مراد ماڈل کے ذریعہ تیار کردہ آؤٹ پٹ کا سائز ہے۔ نوٹ کریں کہ یہ الفاظ کی تعداد کے برابر نہیں ہے کیونکہ ماڈل کی الفاظ انگریزی زبان کے الفاظ کے برابر نہیں ہیں، اور ہر ٹوکن انگریزی زبان کا لفظ نہیں ہو سکتا۔ درجہ حرارت آؤٹ پٹ میں بے ترتیب پن کو کنٹرول کرتا ہے۔ اعلی درجہ حرارت کے نتیجے میں زیادہ تخلیقی اور فریب کاری پیدا ہوتی ہے۔ تمام قیاس کے پیرامیٹرز اختیاری ہیں۔

مندرجہ ذیل جدول SageMaker JumpStart میں دستیاب تمام کوڈ لاما ماڈلز کی فہرست کے ساتھ ماڈل IDs، پہلے سے طے شدہ مثال کی اقسام، اور زیادہ سے زیادہ معاون ٹوکنز (ان پٹ ٹوکنز کی تعداد اور تمام ہم آہنگی درخواستوں کے لیے تیار کردہ ٹوکنز کی تعداد) کے ساتھ ہر ایک کے لیے تعاون یافتہ ہے۔ ان ماڈلز.

| ماڈل کا نام | ماڈل کی شناخت | پہلے سے طے شدہ مثال کی قسم | زیادہ سے زیادہ تعاون یافتہ ٹوکنز |

| CodeLlama-7b | meta-textgeneration-llama-codellama-7b | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-انسٹرکٹ | meta-textgeneration-llama-codellama-7b-ہدایت | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xlarge | 10000 |

| CodeLlama-13b | meta-textgeneration-llama-codellama-13b | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-انسٹرکٹ | meta-textgeneration-llama-codellama-13b-ہدایت | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xlarge | 32000 |

| CodeLlama-34b | meta-textgeneration-llama-codellama-34b | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-انسٹرکٹ | meta-textgeneration-llama-codellama-34b-ہدایت | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xlarge | 48000 |

جب کہ کوڈ لاما ماڈلز کو 16,000 ٹوکنز کی سیاق و سباق کی لمبائی پر تربیت دی گئی تھی، ماڈلز نے اس سے بھی بڑی سیاق و سباق والی ونڈوز پر اچھی کارکردگی کی اطلاع دی ہے۔ پچھلے جدول میں زیادہ سے زیادہ تعاون یافتہ ٹوکن کالم ڈیفالٹ مثال کی قسم پر معاون سیاق و سباق کی ونڈو کی اوپری حد ہے۔ چونکہ کوڈ Llama 7B ماڈل ایک ml.g10,000xlarge مثال پر صرف 5.2 ٹوکن کو سپورٹ کر سکتا ہے، اس لیے اگر آپ کی درخواست کے لیے بڑے سیاق و سباق کی ضرورت ہو تو ہم 13B یا 34B ماڈل ورژن کو تعینات کرنے کی تجویز کرتے ہیں۔

پہلے سے طے شدہ طور پر، تمام ماڈلز کوڈ جنریشن کے کاموں کے لیے کام کرتے ہیں۔ بیس اور انسٹرکٹس ماڈل دونوں کاموں کو بھرنے کا جواب دیتے ہیں، حالانکہ بیس ماڈل میں نمونہ کے سوالات کی اکثریت کے لیے بہتر معیار کی پیداوار تھی۔ آخر میں، صرف ماڈلز کو ہدایت کے کاموں پر کام کرنے کی ہدایت کرتے ہیں۔ مندرجہ ذیل جدول واضح کرتا ہے کہ کن ماڈلز کی کارکردگی اچھی ہے (اچھی) اور معتدل کارکردگی (اعتدال پسند) مثال کے طور پر ڈیمو نوٹ بک میں سوالات۔

| . | کوڈ جنریشن | کوڈ انفلنگ | کوڈ کی ہدایات |

| CodeLlama-7b | بہتر | بہتر | N / A |

| CodeLlama-7b-انسٹرکٹ | بہتر | اعتدال پسند | بہتر |

| CodeLlama-7b-Python | بہتر | N / A | N / A |

| CodeLlama-13b | بہتر | بہتر | N / A |

| CodeLlama-13b-انسٹرکٹ | بہتر | اعتدال پسند | بہتر |

| CodeLlama-13b-Python | بہتر | N / A | N / A |

| CodeLlama-34b | بہتر | N / A | N / A |

| CodeLlama-34b-انسٹرکٹ | بہتر | N / A | بہتر |

| CodeLlama-34b-Python | بہتر | N / A | N / A |

کوڈ جنریشن

درج ذیل مثالیں CodeLlama-34b-Instruct ماڈل پر پے لوڈ پیرامیٹرز کے ساتھ چلائی گئیں۔ "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

کوڈ بھرنا

کوڈ بھرنے میں ارد گرد کے سیاق و سباق کو دیکھتے ہوئے تیار کردہ کوڈ کو واپس کرنا شامل ہے۔ یہ کوڈ جنریشن ٹاسک سے مختلف ہے کیونکہ، پریفکس کوڈ سیگمنٹ کے علاوہ، ماڈل کو کوڈ سیگمنٹ کا لاحقہ بھی فراہم کیا جاتا ہے۔ سابقہ کے آغاز کو نشان زد کرنے کے لئے فائن ٹیوننگ کے دوران خصوصی ٹوکن استعمال کیے گئے تھے (<PRE>لاحقہ کا آغاز (<SUF>) اور وسط کا آغاز (<MID>)۔ ماڈل میں ان پٹ کی ترتیب درج ذیل فارمیٹس میں سے کسی ایک میں ہونی چاہیے:

- prefix-sufix-middle -

<PRE> {prefix} <SUF>{suffix} <MID> - suffix-prefix-middle -

<PRE> <SUF>{suffix} <MID> {prefix}

درج ذیل مثالیں CodeLlama-7b ماڈل پر پے لوڈ کے ساتھ سابقہ لاحقہ درمیانی شکل کا استعمال کرتی ہیں parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

کوڈ کی ہدایات

میٹا نے کوڈ لاما کا ایک انسٹرکشن ٹیونڈ ویرینٹ بھی فراہم کیا۔ اس سیکشن میں مثال کے سوالات کا اطلاق صرف ان انسٹرکشن ٹیونڈ کوڈ لاما ماڈلز پر کیا جا سکتا ہے، جو ماڈل ID انسٹرکٹ لاحقہ والے ماڈل ہیں۔ ہدایات کے لیے کوڈ لاما فارمیٹ Llama-2-chat prompt فارمیٹ جیسا ہی ہے، جس کی ہم تفصیل میں بتاتے ہیں Llama 2 فاؤنڈیشن ماڈل اب SageMaker JumpStart میں دستیاب ہیں۔

ایک سادہ یوزر پرامپٹ مندرجہ ذیل کی طرح نظر آ سکتا ہے:

آپ درج ذیل نحو کے ساتھ سسٹم پرامپٹ بھی شامل کر سکتے ہیں۔

آخر میں، آپ ان پٹ میں تمام سابقہ صارف کے اشارے اور معاون جوابات کو شامل کر کے ماڈل کے ساتھ بات چیت کر سکتے ہیں:

یہ مثالیں CodeLlama-13b-Instruct ماڈل پر پے لوڈ پیرامیٹرز "پیرامیٹرز" کے ساتھ چلائی گئیں: {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

صاف کرو

نوٹ بک چلانے کے بعد، اس بات کو یقینی بنائیں کہ آپ نے اس عمل میں بنائے گئے تمام وسائل کو حذف کر دیا ہے تاکہ آپ کی بلنگ روک دی جائے۔ درج ذیل کوڈ کا استعمال کریں:

نتیجہ

اس پوسٹ میں، ہم نے آپ کو دکھایا کہ سیج میکر اسٹوڈیو میں کوڈ لاما ماڈلز کے ساتھ کیسے آغاز کیا جائے اور کوڈ اور قدرتی زبان دونوں سے کوڈ کے بارے میں کوڈ اور فطری زبان تیار کرنے کے لیے ماڈل کو تعینات کیا جائے۔ چونکہ فاؤنڈیشن ماڈل پہلے سے تربیت یافتہ ہیں، اس لیے وہ تربیت اور بنیادی ڈھانچے کے اخراجات کو کم کرنے میں مدد کر سکتے ہیں اور آپ کے استعمال کے معاملے کے لیے حسب ضرورت کو فعال کر سکتے ہیں۔ شروع کرنے کے لیے ابھی سیج میکر اسٹوڈیو میں سیج میکر جمپ اسٹارٹ پر جائیں۔

وسائل

مصنفین کے بارے میں

گیبریل سنائیو میٹا میں فیس بک AI ریسرچ (FAIR) ٹیم کے ریسرچ ڈائریکٹر ہیں۔ میٹا سے پہلے، گیبریل پیرس میں École Normale Supérieure میں Emmanuel Dupoux کی ٹیم میں پوسٹ ڈاکٹریٹ فیلو تھا، جو بچوں میں زبان کے حصول کے لیے ریورس انجینئرنگ پر کام کرتا تھا۔ گیبریل نے یونیورسٹی آف گرینوبل سے ریئل ٹائم اسٹریٹیجی گیمز AI میں اپلائی کی گئی Bayesian ماڈلنگ میں PhD حاصل کی۔

گیبریل سنائیو میٹا میں فیس بک AI ریسرچ (FAIR) ٹیم کے ریسرچ ڈائریکٹر ہیں۔ میٹا سے پہلے، گیبریل پیرس میں École Normale Supérieure میں Emmanuel Dupoux کی ٹیم میں پوسٹ ڈاکٹریٹ فیلو تھا، جو بچوں میں زبان کے حصول کے لیے ریورس انجینئرنگ پر کام کرتا تھا۔ گیبریل نے یونیورسٹی آف گرینوبل سے ریئل ٹائم اسٹریٹیجی گیمز AI میں اپلائی کی گئی Bayesian ماڈلنگ میں PhD حاصل کی۔

عیسیٰ جمیل میٹا میں ایک پارٹنر انجینئر RL، جنریٹو AI ہے۔

عیسیٰ جمیل میٹا میں ایک پارٹنر انجینئر RL، جنریٹو AI ہے۔

ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر آشیش کھیتان Amazon SageMaker JumpStart کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔

ڈاکٹر آشیش کھیتان Amazon SageMaker JumpStart کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔

ویویک سنگھ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ صارفین کو جنریٹو AI ایپلی کیشنز بنانے کے لیے اپنے ایم ایل سفر کو آسان بنانے اور تیز کرنے کے لیے SageMaker JumpStart کو آن بورڈ کرنے کے قابل بنانے پر توجہ مرکوز کرتا ہے۔

ویویک سنگھ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ صارفین کو جنریٹو AI ایپلی کیشنز بنانے کے لیے اپنے ایم ایل سفر کو آسان بنانے اور تیز کرنے کے لیے SageMaker JumpStart کو آن بورڈ کرنے کے قابل بنانے پر توجہ مرکوز کرتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/

- : ہے

- : ہے

- : نہیں

- :کہاں

- ][p

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- 15٪

- 16

- 24

- 28

- 30

- 36

- 500

- 7

- 700

- 8

- 9

- a

- ہمارے بارے میں

- رفتار کو تیز تر

- قبول کریں

- قابل قبول

- تک رسائی حاصل

- تسلیم کرتے ہیں

- حصول

- فعال

- شامل کریں

- اس کے علاوہ

- کے بعد

- کے خلاف

- معاہدہ

- AI

- عی تحقیق

- یلگوردمز

- تمام

- ساتھ

- بھی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- an

- اور

- اور بنیادی ڈھانچہ

- اعلان کریں

- جواب

- کوئی بھی

- درخواست

- ایپلی کیشنز

- اطلاقی

- مناسب

- کیا

- AS

- اسسٹنٹ

- At

- آٹومیٹڈ

- دستیاب

- AWS

- بیس

- کی بنیاد پر

- مار

- Bayesian

- BE

- کیونکہ

- رہا

- اس سے پہلے

- شروع کریں

- شروع

- بہتر

- کے درمیان

- بلنگ

- ارب

- بلین ٹوکن

- دونوں

- خرابی

- تعمیر

- عمارت

- تعمیر

- لیکن

- by

- C ++

- کر سکتے ہیں

- صلاحیت رکھتا

- کارڈ

- carousel

- کیس

- CD

- تبدیل

- حروف

- بچوں

- میں سے انتخاب کریں

- منتخب کریں

- طبقے

- کلک کریں

- کوڈ

- کالم

- کس طرح

- آتا ہے

- تجارتی

- کمپیوٹر

- کمپیوٹر ویژن

- سمورتی

- کانفرنسوں

- کنسول

- کنٹینر

- پر مشتمل ہے

- مواد

- سیاق و سباق

- سیاق و سباق

- کنٹرول

- کنٹرول

- سنوادی

- اخراجات

- احاطہ

- تخلیق

- بنائی

- تخلیقی

- موجودہ

- گاہکوں

- اصلاح

- اپنی مرضی کے مطابق

- اعداد و شمار

- ڈیٹا کی حفاظت

- دن

- وقف

- پہلے سے طے شدہ

- ڈیمو

- تعیناتی

- تعینات

- تعینات

- تعیناتی

- تعینات کرتا ہے

- ڈیزائن

- تفصیل

- تفصیلات

- ترقی

- ترقی یافتہ

- ڈویلپرز

- ترقی

- فرق

- مختلف

- ڈائریکٹر

- ڈائریکٹریز

- دریافت

- do

- کر

- کیا

- ڈاؤن لوڈز

- ڈیوک

- ڈیوک یونیورسٹی

- کے دوران

- ہر ایک

- اس سے قبل

- وسطی

- ہنر

- کو چالو کرنے کے

- کو فعال کرنا

- آخر

- آخر سے آخر تک

- اختتام پوائنٹ

- انجینئر

- انجنیئر

- انگریزی

- کو یقینی بنانے کے

- ماحولیات

- یورپ

- بھی

- مثال کے طور پر

- مثال کے طور پر

- اس کے علاوہ

- بہت پرجوش

- چھوڑ کر

- ظالمانہ

- مدت ملازمت میں توسیع

- فیس بک

- فیکٹری

- منصفانہ

- جھوٹی

- خصوصیات

- ساتھی

- چند

- فائلوں

- آخر

- مل

- پہلا

- توجہ مرکوز

- پیچھے پیچھے

- کے بعد

- کے لئے

- فارمیٹ

- فاؤنڈیشن

- مفت

- سے

- تقریب

- کھیل

- پیدا

- پیدا کرنے والے

- نسل

- نسلیں

- پیداواری

- پیداواری AI۔

- حاصل

- جاؤ

- دے دو

- دی

- Go

- اچھا

- ملا

- بڑھتے ہوئے

- رہنمائی

- تھا

- ہاتھ

- ہے

- he

- مدد

- مدد

- مدد کرتا ہے

- یہاں

- ہائی

- اعلی

- ان

- میزبان

- کس طرح

- کیسے

- HTML

- HTTPS

- حب

- i

- ID

- مثالی

- شناخت

- if

- ایلی نوائے

- وضاحت کرتا ہے

- درآمد

- کو بہتر بنانے کے

- بہتری

- in

- شامل

- سمیت

- انفراسٹرکچر

- ان پٹ

- آدانوں

- انسٹال

- تنصیب

- مثال کے طور پر

- ہدایات

- ضم

- بات چیت

- مفادات

- انٹرفیس

- آئر لینڈ

- الگ الگ

- IT

- میں

- اعلی درجے کا Java

- جاوا سکرپٹ

- سفر

- رکھی

- کلیدی

- چابیاں

- کیلی

- لینڈنگ

- زبان

- بڑے

- بڑے

- سب سے بڑا

- آخری

- سیکھنے

- چھوڑ دیا

- لمبائی

- دو

- لائسنس

- کی طرح

- LIMIT

- لسٹ

- فہرستیں

- لاما

- ایل ایل ایم

- مقامی

- منطق

- دیکھو

- کی طرح دیکھو

- کم

- مشین

- مشین لرننگ

- بنا

- اکثریت

- بنا

- بنانا

- مینیجر

- مینیجر

- بہت سے

- نشان

- زیادہ سے زیادہ

- مئی..

- کا مطلب ہے کہ

- ذکر کیا

- میٹا

- مشرق

- ML

- ایم ایل اوپس

- ماڈل

- ماڈلنگ

- ماڈل

- نظر ثانی کی

- مہینہ

- زیادہ

- زیادہ موثر

- ضروری

- قدرتی

- ضرورت ہے

- نیٹ ورک

- نئی

- نوڈ

- نوڈس

- کوئی بھی نہیں

- نوٹ بک

- اب

- تعداد

- of

- on

- جہاز

- ایک بار

- ایک

- صرف

- or

- حکم

- وریگن

- دیگر

- باہر

- پیداوار

- پر

- پیکج

- صفحہ

- جوڑے

- کاغذات

- پیرامیٹرز

- پیرس

- پارٹنر

- منظور

- منظور

- گزرتا ہے

- انجام دیں

- کارکردگی

- پی ایچ ڈی

- پی ایچ پی

- پنگ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پالیسی

- پوسٹ

- ممکنہ

- پیش گو

- کی تیاری

- پچھلا

- پہلے

- عمل

- عمل

- مصنوعات

- پروڈکٹ مینیجر

- پیداوری

- پروگرامنگ

- فراہم

- فراہم

- فراہم کرتا ہے

- شائع

- ازگر

- معیار

- سوالات

- جلدی سے

- بے ترتیب پن

- اصل وقت

- موصول

- سفارش

- کا حوالہ دیتے ہیں

- مراد

- خطوں

- جاری

- ہٹا

- ہٹا دیا گیا

- اطلاع دی

- ذخیرہ

- درخواستوں

- ضرورت

- تحقیق

- محقق

- وسائل

- جواب

- جوابات

- نتیجہ

- نتائج کی نمائش

- واپسی

- واپس لوٹنے

- واپسی

- ٹھیک ہے

- جڑ

- رن

- چل رہا ہے

- s

- sagemaker

- اسی

- محفوظ کریں

- توسیع پذیر

- سائنسدان

- اسکرپٹ

- sdk

- تلاش کریں

- تلاش

- سیکنڈ

- سیکشن

- محفوظ بنانے

- سیکورٹی

- حصے

- منتخب

- منتخب

- SELF

- سینئر

- سیریز

- سرور

- سروسز

- مقرر

- ہونا چاہئے

- دکھائیں

- سے ظاہر ہوا

- سادہ

- آسان بنانے

- بعد

- ایک

- سائز

- سائز

- So

- سافٹ ویئر کی

- حل

- خصوصی

- خصوصی

- مخصوص

- مخصوص

- تقسیم

- مستحکم

- شروع کریں

- شروع

- ریاستی آرٹ

- شماریات

- مراحل

- بند کر دیا

- حکمت عملی

- سلک

- سٹوڈیو

- کامیابی کے ساتھ

- اس طرح

- رقم

- حمایت

- تائید

- اس بات کا یقین

- ارد گرد

- نحو

- کے نظام

- ٹیبل

- ٹاسک

- کاموں

- ٹیم

- بتاتا ہے

- شرائط

- متن

- سے

- کہ

- ۔

- ان

- ان

- تو

- یہ

- وہ

- اس

- اگرچہ؟

- تین

- کے ذریعے

- وقت

- وقت کا سلسلہ

- کرنے کے لئے

- ٹوکن

- ٹوکن

- اوزار

- سب سے اوپر

- ٹرین

- تربیت یافتہ

- ٹریننگ

- درخت

- سچ

- کوشش

- دو

- قسم

- اقسام

- ٹائپ اسکرپٹ

- ui

- کے تحت

- افہام و تفہیم

- یونیورسٹی

- us

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- کا استعمال کرتے ہوئے

- قیمت

- اقدار

- مختلف

- مختلف اقسام کے

- ورژن

- کی طرف سے

- لنک

- ورجینیا

- ویزا

- نقطہ نظر

- دورہ

- کا دورہ کیا

- چلنا

- تھا

- راستہ..

- طریقوں

- we

- ویب

- ویب خدمات

- ویب پر مبنی ہے

- تھے

- مغربی

- کیا

- کیا ہے

- جس

- وسیع

- گے

- ونڈو

- کھڑکیاں

- ساتھ

- کے اندر

- لفظ

- الفاظ

- کام

- کام کے بہاؤ

- کام کر

- لکھنا

- تم

- اور

- زیفیرنیٹ