جی ہاں.. میں AI ایپلی کیشنز کے بارے میں بات کر رہا ہوں – ہماری بے شمار AI ایپلی کیشنز اور آنے والی ایپلی کیشنز جو انسانوں سے سرگوشی کر رہی ہیں کہ کیا کرنا ہے…. یہ کیسے کریں…لیکن سرگوشی کرنے والوں کے بارے میں نہیں جو AI چیٹ بوٹس کے ساتھ تعامل کرتے ہیں۔

کے مطابق آئی ڈی سی پیشین گوئیوں کے مطابق، عالمی AI مارکیٹ 500 تک $2024 بلین سے زیادہ تک پہنچ سکتی ہے – جو کہ 50 سے 2021% زیادہ ہے۔ اعداد و شمار کو بصیرت میں تبدیل کرنے کے لیے یہ ایک ضروری ٹول ہے تاکہ بہتر فیصلوں کی بنیاد پر کارروائی کو تیز کیا جا سکے۔ کاروباری خطرات کو کم کرنے اور اختراع کے ساتھ ROI کو بڑھانے کے لیے کوئی بھی AI کے فوائد پر بحث نہیں کر رہا ہے۔ لیکن، ہمیشہ کی طرح، ایک …لیکن… غیرجانبدار AI بات کرنے سے کہیں زیادہ آسان ہے۔

کاروبار کے لیے اہم، ان AI ماڈلز کو مرئیت اور جوابدہی کے ساتھ قابل اعتماد طریقے سے کام کرنے کی ضرورت ہے۔ بصورت دیگر، اس معاملے میں ناکامی کے سنگین نتائج ہوتے ہیں جو کسی بھی کمپنی کے نقد بہاؤ کو متاثر کرتے ہیں اور قانونی معاملات میں بھی اس کا نتیجہ ہو سکتا ہے۔ اس سے بچنے کا واحد طریقہ آٹومیشن اور شفافیت ہے ایک سوال کا جواب "کیا آپ ثابت کر سکتے ہیں کہ یہ AI ایپلیکیشن/کام کا بوجھ اخلاقی طور پر بنایا گیا ہے۔" اکا… آپ حکومت کیسے کرتے ہیں؟ اور کیا آپ ثابت کر سکتے ہیں کہ اس پر مسلسل حکومت ہو رہی ہے؟

یہ وہ جگہ ہے جہاں کمپنیاں پسند کرتی ہیں۔ IBM تنظیم کی AI سرگرمیوں کی ہدایت کاری، انتظام اور نگرانی کے مجموعی عمل کو ترتیب دینے کے لیے AI گورننس میں سرمایہ کاری کی ہے۔ بنیادی کام یہ یقینی بنانا ہے کہ تمام کاروباری اکائیاں فعال رہیں اور اخلاقی اصولوں اور ضوابط کو پورا کرنے کی صلاحیت کو مضبوط کرنے کے لیے اقدامات میں گورننس فریم ورک کو شامل کریں۔ خاص طور پر، بینکنگ اور مالیاتی خدمات جیسی ریگولیٹڈ صنعتوں کو قانونی طور پر ریگولیٹرز کو مطمئن کرنے کے لیے ثبوت فراہم کرنے کی ضرورت ہے۔

ڈیجیٹل تبدیلی کے زبردست دباؤ کی وجہ سے مالیاتی خدمات کے شعبے میں AI کا اثر و رسوخ تیزی سے بڑھ رہا ہے۔ جیسا کہ کہا گیا ہے، یہ کہا جانے سے کہیں زیادہ آسان ہے کیونکہ:

1. اعتماد کے ساتھ AI ایپس کو چلائیں:

بعض صورتوں میں، ماڈل بغیر وضاحت اور کیٹلاگ کے بنائے جاتے ہیں۔ یہ کہنے کی ضرورت نہیں ہے کہ ہر چیز کے درمیان نگرانی ختم سے آخر تک زندگی کے چکر کو ٹریک کرنے کے لیے ختم ہو جاتی ہے۔ جب کہ بینک میراثی ایپلی کیشنز کے ساتھ جدوجہد کر رہے ہیں، شفافیت اور وضاحت کی اہلیت پیدا کرنے کے لیے عمل کو خودکار بنانا مشکل ہو گیا اور اس کے نتیجے میں، ایک بلیک باکس بن گیا۔ کوئی نہیں جانتا کہ کیوں/کیسے فیصلے کیے گئے۔ پرانی ایپس کے ساتھ الجھنے والی نئی ایپس کبھی بھی دن کی روشنی نہیں دیکھتیں حالانکہ معیار اور غیر متوقع خطرات کی وجہ سے اس سے بہت بڑا ROI وابستہ ہے۔

یہ ہمیں ہمارے دوسرے نقطہ پر لے آتا ہے - ساکھ کے خطرے کا انتظام کرنا

2. مجموعی خطرے کے ساتھ ساکھ کے خطرے کا انتظام کریں۔

میں نے پوچھا ہے #chatGPT اور #بارڈ - پدما چوکا کون ہے؟ #ChatGPT جواب دینے سے انکار کر دیا یہاں تک کہ اگر میں نے سوال کو متعدد طریقوں سے تبدیل کیا۔ پھر بھی، بارڈ نے مجھے تفصیلی جواب دیا، جس میں میرا LinkedIn پروفائل بھی شامل ہے…لیکن ڈیٹا مختلف سائٹس کا ہے جہاں میرا پرانا پروفائل اب بھی اسپیکر کے بائیو کے حصے کے طور پر موجود ہے۔ اس وقت سے، میں نے ابھی تک بارڈ کھولنا ہے۔ اتنی جلدی، مجھے آف کر دیا گیا، عرف - ساکھ کا خطرہ۔ فرض کریں کہ جب میں سمجھتا ہوں کہ ڈیٹا متضاد ہو سکتا ہے تو میں ایک سادہ چیٹ بوٹ کو بند کر سکتا ہوں۔ اہم کاروبار کرنے کے لیے AI-infused ایپلیکیشن خریدنے کا فیصلہ کرنے سے پہلے میں کیسے یقینی نہیں بنا سکتا تھا؟ ساکھ کا خطرہ ایک لازمی عنصر ہے جسے بعض اوقات کمپنیاں بھول جاتی ہیں۔ اگر آپ شہرت کے خطرے کا اندازہ لگاتے ہیں، تو کوئی شخص فعال نہ ہونے کی صورت میں کاروبار پر زبردست اثر دیکھ سکتا ہے۔

پیچیدگی میں اضافہ کرنے کے لیے، تیسرا ہے…

3. ایک کمپنی AI ضوابط کو تبدیل کرنے کا کیسے جواب دے سکتی ہے؟

شہرت کے خطرے سے بچنے کے لیے، ایک کامیاب اور ذمہ دار AI ٹیم کو ہر مقامی اور عالمی ضابطے سے آگاہ ہونا چاہیے، ایک لمحے کے نوٹس کے ساتھ ٹک ٹاک ویڈیو کی طرح ڈراپ کرنا۔ اور عدم تعمیل پر بالآخر ایک تنظیم کو مجوزہ EU AI ایکٹ جیسے کام کے ارد گرد لاکھوں ڈالر جرمانے کی لاگت آسکتی ہے۔ یہ 30 ملین یورو تک ہو سکتا ہے یا کمپنی کی عالمی آمدنی کا 6% - OUCH۔

ٹھیک ہے، جانے کے وقت ہر چیز کو گلابی ہونا ضروری نہیں ہے… جب تک کہ ہم جانتے ہیں کہ کس طرح ایک خوفناک سے گلابی صورت حال کو تبدیل کرنا ہے۔

بغیر کسی تعجب کے… یہ ہمیشہ لوگ، عمل اور ٹیکنالوجی ہوتی ہے۔ لہذا سب سے پہلے، ایک کراس فنکشنل گورننگ باڈی بنائیں تاکہ اہداف کی بنیاد پر اقدامات کو تعلیم، ہدایت اور نگرانی کر سکے۔ پھر موجودہ AI ٹیکنالوجی اور عمل کو بینچ مارک کریں، خلا کو سمجھیں، پھر مستقبل کے ثبوت کے لیے تدارک کریں۔ پھر تعمیل کی ضروریات کے مطابق خودکار گورننس ورک فلو کے سیٹ پر واپس جائیں۔ آخر میں، اگر قابل قبول حد بند ہو رہی ہے تو مالکان کو آگاہ کرنے کے لیے ایک مانیٹرنگ سسٹم قائم کریں۔ ٹیکنالوجی کی طرف سے، ایک اچھی طرح سے تعمیر شدہ، اچھی طرح سے کام کرنے والا، اور اچھی طرح سے منسلک AI کے لیے متعدد بلڈنگ بلاکس کی ضرورت ہوتی ہے۔ اور یقینی بنائیں کہ اس میں کچھ یا تمام صلاحیتیں ہیں:

· متنوع تعیناتیوں میں ڈیٹا کی سالمیت

کھلے، لچکدار موجودہ ٹولز کا استعمال کریں جو AI گورننس پر عمل پیرا ہوں۔

پرائیویسی کنٹرولز کے ساتھ سیلف سروس تک رسائی کو یقینی بنائیں – ٹریک کرنے کا ایک طریقہ

· آٹومیشن اور AI گورننس کو ذہن میں رکھتے ہوئے ڈیزائن کریں۔

حسب ضرورت ورک فلو کے ذریعے متعدد اسٹیک ہولڈرز کے لیے مربوط اور حسب ضرورت بن سکتا ہے۔

ایک بار جب ہم ڈراؤنی سے روزی تک ایپ کی تبدیلی کرتے ہیں… پھر اگلا سوال یہ ہے کہ آپ کیسے ثابت کرتے ہیں…

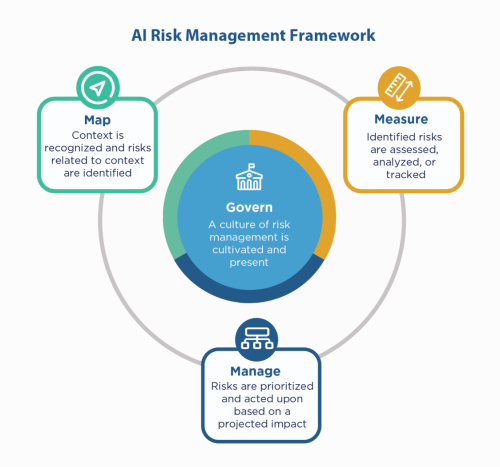

سب سے پہلے، کمپنی کے AI اصولوں پر پیچھے ہٹیں - ان کے ساتھ تعمیر کریں، اور پھر بھی آپ کو "دکھانے" کی ضرورت ہے کہ آپ تعمیل کرتے ہیں، خاص طور پر مالیاتی خدمات جیسے ریگولیٹڈ ماحول میں۔ چونکہ مالیاتی خدمات کو NIST 800-53 کے ساتھ شکایت کرنی چاہیے، اس لیے وہ دیکھ سکتے ہیں۔ NIST AI رسک مینجمنٹ فریم ورک (AI RMF). NIST نے چار خاندانوں میں کنٹرول کی تجویز پیش کی – Govern, Map, Measure, and Manage. اسے ایک رہنما عنصر کے طور پر استعمال کرتے ہوئے اور تناؤ کو دور کرنے اور نگرانی کرنے کے لیے خلا کی نشاندہی کرنے کے لیے ایپلی کیشنز کی جانچ کریں۔

IBM آپ کے ماڈلز کو پروڈکشن میں ڈالنے سے پہلے ان کی توثیق کر سکتا ہے، اور انصاف، معیار اور بڑھے ہوئے کے لیے نگرانی کی جا سکتی ہے۔ یہ ریگولیٹرز اور آڈیٹرز کی ضروریات کو پورا کرنے کے لیے ماڈل کے رویے اور پیشین گوئیوں کی وضاحت کرنے والی دستاویزات بھی فراہم کر سکتا ہے۔ یہ وضاحتیں مرئیت فراہم کر سکتی ہیں اور آڈٹ کے درد کو کم کر سکتی ہیں، اور شفافیت اور ممکنہ خطرات کا تعین کرنے کی صلاحیت میں اضافہ کر سکتی ہیں۔

ان AI سرگوشیوں کو اعتماد کے ساتھ سنیں!

#مالیاتی خدمات #ذمہ دار #اخلاقی #NISTAIRMF

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ایڈریین ایشلے کے ساتھ مستقبل کا نقشہ بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- : ہے

- $UP

- 2021

- 2024

- 7

- a

- کی صلاحیت

- ہمارے بارے میں

- قابل قبول

- تک رسائی حاصل

- احتساب

- کے پار

- ایکٹ

- عمل

- سرگرمیوں

- مان لیا

- AI

- اے آئی ایکٹ

- اے آئی گورننس

- ارف

- انتباہ

- تمام

- ہمیشہ

- اور

- جواب

- اپلی کیشن

- درخواست

- ایپلی کیشنز

- ایپس

- کیا

- ارد گرد

- AS

- منسلک

- At

- آڈٹ

- آڈیٹرز

- آٹومیٹڈ

- خودکار

- میشن

- واپس

- بینکنگ

- بینکوں

- کی بنیاد پر

- BE

- کیونکہ

- اس سے پہلے

- کیا جا رہا ہے

- معیار

- فوائد

- بہتر

- ارب

- سیاہ

- بلاکس

- جسم

- باکس

- لاتا ہے

- تعمیر

- عمارت

- تعمیر

- کاروبار

- خرید

- by

- کر سکتے ہیں

- صلاحیتوں

- کیس

- مقدمات

- کیش

- کیش فلو

- تبدیل کرنے

- چیٹ بٹ

- چیٹ بٹس

- وضاحت

- اختتامی

- کمپنیاں

- کمپنی کے

- پیچیدگی

- تعمیل

- شکایت

- سلوک

- اعتماد سے

- رابطہ قائم کریں

- نتائج

- مسلسل

- کنٹرول

- قیمت

- سکتا ہے

- تخلیق

- اہم

- موجودہ

- مرضی کے مطابق

- سائیکل

- اعداد و شمار

- بحث کرنا

- فیصلہ کرنا

- فیصلے

- کمی

- ڈیزائن

- تفصیلی

- اس بات کا تعین

- ڈیجیٹل

- ڈیجیٹل تبدیلی

- سنگین

- براہ راست

- ہدایت

- متنوع

- دستاویزات

- ڈالر

- چھوڑنا

- آسان

- تعلیم

- آخر سے آخر تک

- کو یقینی بنانے کے

- انٹرپرائز

- ماحول

- خاص طور پر

- ضروری

- اخلاقی

- EU

- یورو

- بھی

- ہر کوئی

- سب کچھ

- ثبوت

- موجودہ

- موجود ہے

- کی وضاحت

- تیزی سے

- ناکامی

- انصاف

- گر

- خاندانوں

- آخر

- مالی

- مالیاتی خدمات

- سروں

- فائن ایکسٹرا

- پہلا

- لچکدار

- بہاؤ

- کے لئے

- فریم ورک

- سے

- 2021 سے

- مستقبل

- دے دو

- گلوبل

- گورننس

- بڑھتے ہوئے

- ہے

- کس طرح

- کیسے

- HTTPS

- بھاری

- انسان

- i

- شناخت

- اثر

- in

- سمیت

- اضافہ

- اشارہ کرتا ہے

- صنعتوں

- اثر و رسوخ

- اقدامات

- جدت طرازی

- بصیرت

- اٹوٹ

- سالمیت

- بات چیت

- سرمایہ کاری کی

- IT

- میں

- ایوب

- جان

- کی وراست

- قانونی

- قانونی معاملات

- زندگی

- کی طرح

- لائن

- لنکڈ

- مقامی

- لانگ

- دیکھو

- بنا

- بنا

- انتظام

- انتظام

- مینیجنگ

- نقشہ

- مارکیٹ

- معاملات

- مئی..

- پیمائش

- سے ملو

- شاید

- دس لاکھ

- لاکھوں

- ماڈل

- ماڈل

- لمحہ

- کی نگرانی

- نگرانی کی

- نگرانی

- زیادہ

- ایک سے زیادہ

- ضروری

- ضرورت ہے

- ضرورت نہیں

- نئی

- اگلے

- نیسٹ

- مقاصد

- of

- پیش کرتے ہیں

- پرانا

- on

- ایک

- کھول

- کام

- تنظیم

- دوسری صورت میں

- مجموعی طور پر

- مالکان

- درد

- حصہ

- لوگ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- ممکن

- پیشن گوئی

- دباؤ

- پرائمری

- اصولوں پر

- کی رازداری

- چالو

- عمل

- عمل

- پیداوار

- پروفائل

- ثبوت

- مجوزہ

- ثابت کریں

- فراہم

- ڈال

- معیار

- سوال

- جلدی سے

- تک پہنچنے

- احساس

- باضابطہ

- ریگولیٹڈ صنعتیں

- ریگولیشن

- ضابطے

- ریگولیٹرز

- شہرت

- ضرورت

- ضروریات

- کی ضرورت ہے

- جواب

- ذمہ دار

- نتیجہ

- آمدنی

- رسک

- رسک مینجمنٹ

- خطرات

- ROI

- گلابی

- s

- کہا

- دوسری

- شعبے

- خود خدمت

- سروسز

- مقرر

- ہونا چاہئے

- دکھائیں

- کی طرف

- سادہ

- بعد

- سائٹس

- صورتحال

- سائز

- So

- کچھ

- چنگاری

- اسپیکر

- اسٹیک ہولڈرز

- رہنا

- ابھی تک

- حکمت عملی

- مضبوط بنانے

- کشیدگی

- جدوجہد

- کامیاب

- کے نظام

- بات کر

- ٹیم

- ٹیکنالوجی

- ٹیسٹ

- کہ

- ۔

- ان

- یہ

- تھرڈ

- حد

- کے ذریعے

- کرنے کے لئے

- کے آلے

- اوزار

- ٹریک

- تبدیلی

- شفافیت

- زبردست

- ٹرن

- تبدیل کر دیا

- آخر میں

- سمجھ

- یونٹس

- آئندہ

- us

- استعمال کی شرائط

- تصدیق کریں۔

- مختلف

- ویڈیو

- کی نمائش

- راستہ..

- طریقوں

- کیا

- جبکہ

- ڈبلیو

- ساتھ

- بغیر

- کام

- کام کے بہاؤ

- تم

- اور

- زیفیرنیٹ